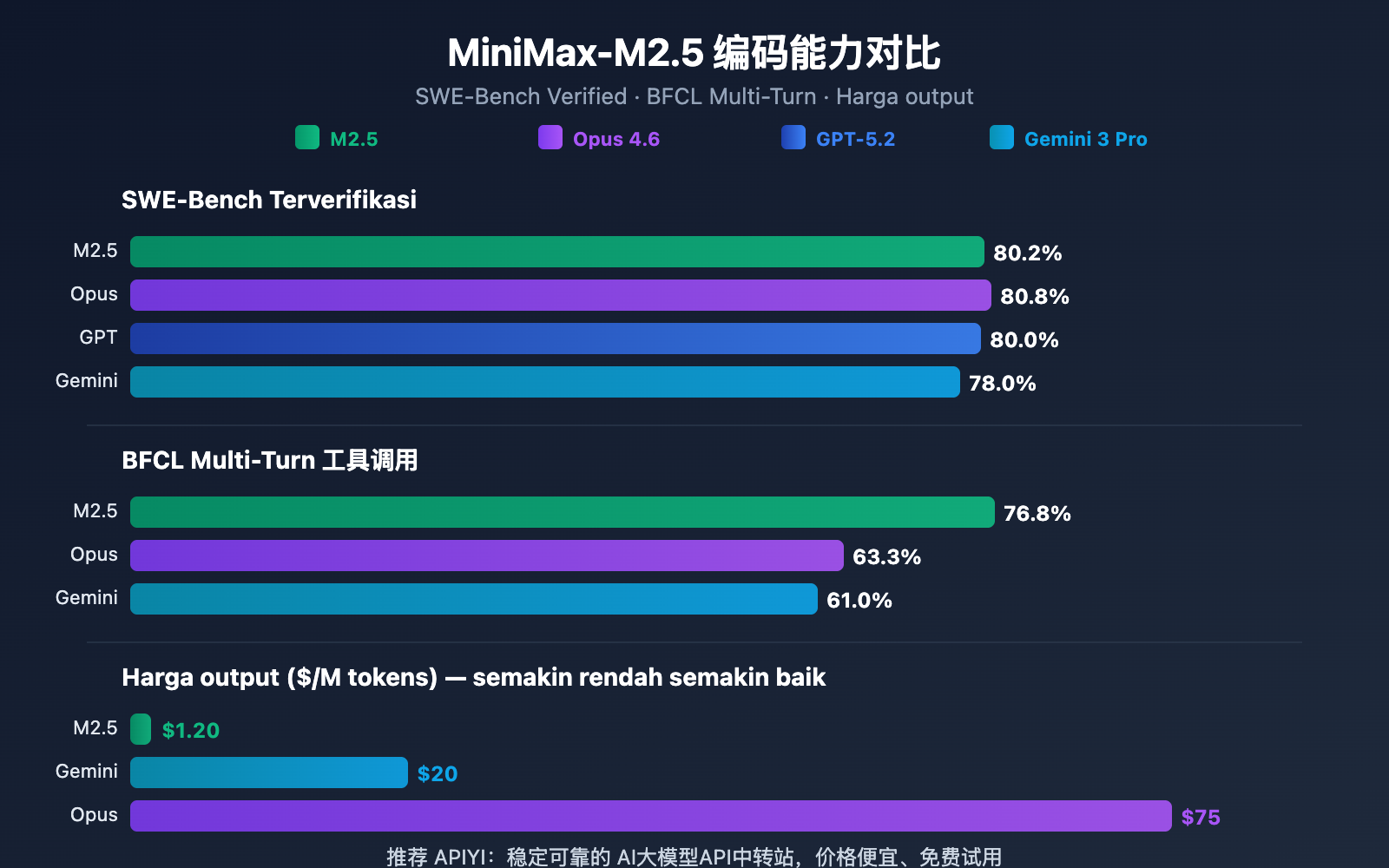

Catatan Penulis: Analisis mendalam tentang kemampuan coding, performa agent, dan metode akses API untuk dua versi MiniMax-M2.5 dan M2.5-Lightning. Skor SWE-Bench mencapai 80.2%, mendekati Opus 4.6, dengan harga hanya 1/60.

MiniMax merilis dua versi model, MiniMax-M2.5 dan M2.5-Lightning, pada 12 Februari 2026. Ini adalah model open-source pertama yang kemampuan coding-nya melampaui Claude Sonnet, dengan skor SWE-Bench Verified mencapai 80.2%, hanya selisih 0.6 poin dari Claude Opus 4.6. Saat ini, kedua model tersebut sudah tersedia di platform APIYI. Kamu bisa mengaksesnya sekarang, dan dengan mengikuti aktivitas top-up, kamu bisa mendapatkan harga 20% lebih murah dari situs resmi.

Nilai Inti: Melalui data pengujian nyata dan contoh kode dalam artikel ini, kamu akan memahami perbedaan utama antara kedua versi MiniMax-M2.5, memilih versi yang paling sesuai dengan kebutuhanmu, dan menyelesaikan integrasi API dengan cepat.

Ikhtisar Kemampuan Inti MiniMax-M2.5

| Metrik Inti | MiniMax-M2.5 Standar | MiniMax-M2.5-Lightning | Penjelasan Nilai |

|---|---|---|---|

| SWE-Bench Verified | 80.2% | 80.2% (Kemampuan sama) | Mendekati 80.8% milik Opus 4.6 |

| Kecepatan Output | ~50 TPS | ~100 TPS | Lightning 2x lebih cepat |

| Harga Output | $0.15/$1.20 per juta Token | $0.30/$2.40 per juta Token | Versi Standar hanya 1/63 dari Opus |

| Pemanggilan Tool BFCL | 76.8% | 76.8% (Kemampuan sama) | Unggul jauh dari 63.3% milik Opus |

| Context Window | 205K tokens | 205K tokens | Mendukung analisis basis kode besar |

Penjelasan Kemampuan Coding MiniMax-M2.5

MiniMax-M2.5 menggunakan arsitektur MoE (Mixture of Experts) dengan total parameter 230B, namun hanya mengaktifkan 10B parameter untuk inferensi. Desain ini memungkinkan model mempertahankan kemampuan coding mutakhir sambil menekan biaya inferensi secara signifikan.

Dalam tugas coding, M2.5 menunjukkan "Spec-writing tendency" yang unik—sebelum mulai menulis kode, ia akan melakukan dekomposisi arsitektur dan perencanaan desain proyek terlebih dahulu. Pola perilaku ini membuatnya sangat unggul dalam menangani proyek multi-file yang kompleks, dengan skor Multi-SWE-Bench 51.3%, bahkan melampaui Claude Opus 4.6 yang berada di angka 50.3%.

Model ini mendukung pengembangan full-stack dalam 10+ bahasa pemrograman, mencakup Python, Go, C/C++, TypeScript, Rust, Java, JavaScript, Kotlin, PHP, dan bahasa populer lainnya, serta mendukung proyek multi-platform seperti Web, Android, iOS, hingga Windows.

Kemampuan Agent dan Pemanggilan Tool MiniMax-M2.5

M2.5 meraih skor 76.8% dalam benchmark BFCL Multi-Turn, unggul jauh dibandingkan Claude Opus 4.6 (63.3%) dan Gemini 3 Pro (61.0%). Ini berarti dalam skenario agent yang membutuhkan percakapan multi-turn dan kolaborasi multi-tool, M2.5 adalah pilihan terkuat saat ini.

Dibandingkan dengan generasi sebelumnya (M2.1), M2.5 mengurangi putaran pemanggilan tool untuk menyelesaikan tugas agent sekitar 20%, dan kecepatan evaluasi SWE-Bench Verified meningkat sebesar 37%. Kemampuan dekomposisi tugas yang lebih efisien ini secara langsung menurunkan konsumsi Token dan biaya pemanggilan.

Perbandingan MiniMax-M2.5 Versi Standar vs Versi Lightning

Memilih versi MiniMax-M2.5 yang tepat bergantung pada skenario penggunaan spesifik Anda. Kemampuan inti dari kedua versi model ini identik; perbedaan utamanya terletak pada kecepatan inferensi dan harga.

| Dimensi Perbandingan | M2.5 Versi Standar | M2.5-Lightning | Saran Pemilihan |

|---|---|---|---|

| ID Model API | MiniMax-M2.5 |

MiniMax-M2.5-highspeed |

— |

| Kecepatan Inferensi | ~50 TPS | ~100 TPS | Pilih Lightning jika butuh respons real-time |

| Harga Input | $0.15/M tokens | $0.30/M tokens | Pilih versi Standar untuk tugas batch |

| Harga Output | $1.20/M tokens | $2.40/M tokens | Versi Standar 50% lebih murah |

| Biaya Operasional Berkelanjutan | ~$0.30/jam | ~$1.00/jam | Pilih versi Standar untuk tugas latar belakang |

| Kemampuan Coding | Sama persis | Sama persis | Tidak ada perbedaan |

| Tool Calling | Sama persis | Sama persis | Tidak ada perbedaan |

Panduan Skenario Pemilihan Versi MiniMax-M2.5

Skenario Memilih Versi Lightning (Kecepatan Tinggi):

- Integrasi asisten coding IDE, membutuhkan pelengkapan kode real-time dan saran refactoring dengan latensi rendah.

- Percakapan agen interaktif, di mana pengguna mengharapkan respons cepat untuk layanan pelanggan atau dukungan teknis.

- Aplikasi pengayaan pencarian real-time, membutuhkan umpan balik cepat untuk penjelajahan web dan pengambilan informasi.

Skenario Memilih Versi Standar:

- Review kode batch dan perbaikan otomatis di latar belakang, tidak memerlukan interaksi real-time.

- Orkestrasi tugas agen skala besar, alur kerja asinkron yang berjalan lama.

- Aplikasi dengan throughput tinggi yang sensitif terhadap anggaran, mengutamakan biaya per unit terendah.

🎯 Saran Pemilihan: Jika Anda tidak yakin versi mana yang harus dipilih, disarankan untuk menguji kedua versi secara bersamaan di platform APIYI (apiyi.com). Anda dapat beralih antara versi Standar dan Lightning dalam antarmuka yang sama; cukup ubah parameter

modeluntuk membandingkan latensi dan hasilnya dengan cepat.

Perbandingan Kemampuan Coding MiniMax-M2.5 dengan Kompetitor

| Model | SWE-Bench Verified | BFCL Multi-Turn | Harga Output/M | Jumlah Tugas per $100 |

|---|---|---|---|---|

| MiniMax-M2.5 | 80.2% | 76.8% | $1.20 | ~328 |

| MiniMax-M2.5-Lightning | 80.2% | 76.8% | $2.40 | ~164 |

| Claude Opus 4.6 | 80.8% | 63.3% | ~$75 | ~30 |

| GPT-5.2 | 80.0% | — | ~$60 | ~30 |

| Gemini 3 Pro | 78.0% | 61.0% | ~$20 | ~90 |

Berdasarkan data tersebut, MiniMax-M2.5 telah mencapai level frontier dalam kemampuan coding. Skor 80,2% pada SWE-Bench Verified hanya terpaut 0,6% lebih rendah dari Opus 4.6, namun dengan selisih harga yang mencapai lebih dari 60 kali lipat. Dalam hal kemampuan tool calling, skor BFCL 76,8% milik M2.5 bahkan unggul jauh di atas semua kompetitornya.

Bagi tim yang perlu menerapkan agen coding dalam skala besar, keunggulan biaya M2.5 berarti dengan anggaran $100 yang sama, Anda dapat menyelesaikan sekitar 328 tugas, sementara dengan Opus 4.6 hanya sekitar 30 tugas.

Catatan Perbandingan: Data uji benchmark di atas bersumber dari data resmi masing-masing model dan lembaga evaluasi pihak ketiga, Artificial Analysis. Performa aktual mungkin bervariasi tergantung pada skenario tugas spesifik; disarankan untuk melakukan pengujian skenario nyata melalui APIYI (apiyi.com).

Akses Cepat API MiniMax-M2.5

Contoh Minimalis

Berikut adalah cara termudah untuk mengakses MiniMax-M2.5 melalui platform APIYI, cukup dengan 10 baris kode:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="MiniMax-M2.5", # Ganti ke MiniMax-M2.5-Lightning untuk menggunakan versi kecepatan tinggi

messages=[{"role": "user", "content": "用 Python 实现一个 LRU 缓存"}]

)

print(response.choices[0].message.content)

Lihat kode implementasi lengkap (termasuk output streaming dan pemanggilan alat)

from openai import OpenAI

from typing import Optional

def call_minimax_m25(

prompt: str,

model: str = "MiniMax-M2.5",

system_prompt: Optional[str] = None,

max_tokens: int = 4096,

stream: bool = False

) -> str:

"""

Memanggil MiniMax-M2.5 API

Args:

prompt: Input pengguna

model: MiniMax-M2.5 atau MiniMax-M2.5-Lightning

system_prompt: Petunjuk sistem

max_tokens: Jumlah token output maksimum

stream: Apakah mengaktifkan output streaming

Returns:

Konten respons model

"""

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

try:

response = client.chat.completions.create(

model=model,

messages=messages,

max_tokens=max_tokens,

stream=stream

)

if stream:

result = ""

for chunk in response:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

result += content

print(content, end="", flush=True)

print()

return result

else:

return response.choices[0].message.content

except Exception as e:

return f"Error: {str(e)}"

# Contoh penggunaan: Tugas pengodean

result = call_minimax_m25(

prompt="重构以下代码,提升性能并添加错误处理",

model="MiniMax-M2.5-Lightning",

system_prompt="你是一个资深全栈工程师,擅长代码重构和性能优化",

stream=True

)

Saran: Dapatkan kuota pengujian gratis melalui APIYI apiyi.com untuk memvalidasi hasil pengodean MiniMax-M2.5 di proyek nyata Anda dengan cepat. Platform ini mendukung antarmuka yang kompatibel dengan OpenAI, sehingga kode yang ada hanya perlu mengubah parameter

base_urldanmodeluntuk beralih.

Analisis Arsitektur Teknis MiniMax-M2.5

Daya saing inti MiniMax-M2.5 berasal dari dua inovasi teknologi: arsitektur MoE yang efisien dan kerangka pelatihan Forge RL.

Keunggulan Arsitektur MoE MiniMax-M2.5

| Parameter Arsitektur | MiniMax-M2.5 | Model Padat Tradisional | Penjelasan Keunggulan |

|---|---|---|---|

| Total Parameter | 230B | Biasanya 70B-200B | Kapasitas pengetahuan lebih besar |

| Parameter Aktif | 10B | Sama dengan total parameter | Biaya inferensi sangat rendah |

| Efisiensi Inferensi | 50-100 TPS | 10-30 TPS | Peningkatan kecepatan 3-10 kali lipat |

| Biaya per Unit | $1.20/M output | $20-$75/M output | Pengurangan biaya 20-60 kali lipat |

Ide inti dari arsitektur MoE adalah "pembagian tugas ahli"—model berisi beberapa set jaringan ahli, dan setiap inferensi hanya mengaktifkan subset ahli yang paling relevan dengan tugas saat ini. M2.5 mencapai efek yang mendekati model padat 230B hanya dengan 10B parameter aktif, menjadikannya pilihan terkecil dan termurah di antara model Tier 1 saat ini.

Kerangka Pelatihan Forge RL MiniMax-M2.5

Teknologi kunci lainnya dari M2.5 adalah kerangka pembelajaran penguatan (Reinforcement Learning) Forge:

- Skala Lingkungan Pelatihan: Lebih dari 200.000 lingkungan pelatihan dunia nyata, mencakup basis kode, browser web, dan aplikasi perkantoran.

- Algoritma Pelatihan: CISPO (Clipped Importance Sampling Policy Optimization), dirancang khusus untuk tugas pengambilan keputusan multi-langkah.

- Efisiensi Pelatihan: Mencapai akselerasi pelatihan 40 kali lipat dibandingkan metode RL standar.

- Mekanisme Reward: Sistem reward berbasis hasil, bukan umpan balik preferensi manusia (RLHF) tradisional.

Metode pelatihan ini membuat M2.5 tampil lebih stabil dalam tugas pengodean nyata dan tugas agen (agent), serta mampu melakukan dekomposisi tugas, pemilihan alat, dan eksekusi multi-langkah secara efisien.

🎯 Saran Praktis: MiniMax-M2.5 sudah tersedia di platform APIYI apiyi.com. Disarankan bagi pengembang untuk menggunakan kuota gratis terlebih dahulu guna menguji skenario pengodean dan agen, lalu memilih versi Standar atau Lightning berdasarkan kebutuhan latensi dan hasil yang diinginkan.

Pertanyaan yang Sering Diajukan (FAQ)

Q1: Apakah ada perbedaan kemampuan antara MiniMax-M2.5 versi Standar dan versi Lightning?

Tidak ada perbedaan. Kemampuan model pada kedua versi ini benar-benar identik, dengan skor yang sama di semua pengujian benchmark seperti SWE-Bench dan BFCL. Satu-satunya perbedaan adalah kecepatan inferensi (Versi Standar 50 TPS vs Lightning 100 TPS) dan harga yang sesuai. Saat memilih, Anda cukup mempertimbangkan kebutuhan latensi dan anggaran Anda.

Q2: Apakah MiniMax-M2.5 cocok untuk menggantikan Claude Opus 4.6?

Sangat layak dipertimbangkan untuk skenario coding dan AI Agent. Skor SWE-Bench M2.5 (80,2%) hanya terpaut 0,6 poin di bawah Opus 4.6, sementara kemampuan pemanggilan alat atau tool calling (BFCL 76,8%) jauh lebih unggul. Dari segi harga, MiniMax-M2.5 versi Standar hanya 1/63 dari harga Opus. Kami menyarankan Anda melakukan pengujian perbandingan pada proyek nyata melalui APIYI apiyi.com untuk menilainya berdasarkan skenario spesifik Anda.

Q3: Bagaimana cara cepat mulai menguji MiniMax-M2.5?

Kami merekomendasikan penggunaan platform APIYI untuk akses cepat:

- Kunjungi APIYI apiyi.com dan daftar akun.

- Dapatkan API Key dan kuota pengujian gratis.

- Gunakan contoh kode dalam artikel ini, lalu ubah parameter model menjadi

MiniMax-M2.5atauMiniMax-M2.5-Lightning. - Karena antarmukanya kompatibel dengan OpenAI, proyek yang sudah ada hanya perlu mengubah

base_urlsaja.

Kesimpulan

Poin-poin utama dari MiniMax-M2.5:

- Kemampuan Coding Terdepan: Dengan skor SWE-Bench Verified 80,2% dan Multi-SWE-Bench 51,3% yang memimpin industri, ini adalah model sumber terbuka pertama yang melampaui Claude Sonnet.

- Kemampuan Agent Nomor Satu: BFCL Multi-Turn mencapai 76,8%, jauh melampaui semua kompetitor. Jumlah putaran pemanggilan alat berkurang 20% dibandingkan generasi sebelumnya.

- Efisiensi Biaya Maksimal: Harga output versi Standar hanya $1,20/M token, atau 1/63 dari harga Opus 4.6. Dengan anggaran yang sama, Anda bisa menyelesaikan tugas 10 kali lebih banyak.

- Dua Versi yang Fleksibel: Versi Standar cocok untuk pemrosesan batch dan skenario yang mengutamakan biaya, sementara versi Lightning cocok untuk interaksi real-time dan skenario dengan latensi rendah.

MiniMax-M2.5 sudah tersedia di platform APIYI dan mendukung pemanggilan antarmuka yang kompatibel dengan OpenAI. Kami merekomendasikan Anda untuk mendapatkan kuota gratis melalui APIYI apiyi.com untuk melakukan pengujian langsung. Anda hanya perlu mengubah parameter model untuk beralih dan membandingkan kedua versi tersebut.

📚 Referensi

⚠️ Catatan Format Tautan: Semua tautan luar menggunakan format

Nama Referensi: domain.comagar mudah disalin tetapi tidak dapat diklik, guna menghindari hilangnya bobot SEO.

-

Pengumuman Resmi MiniMax M2.5: Penjelasan mendalam mengenai kemampuan inti dan detail teknis M2.5

- Tautan:

minimax.io/news/minimax-m25 - Keterangan: Dokumen rilis resmi yang berisi data benchmark lengkap dan pengenalan metode pelatihan.

- Tautan:

-

Dokumentasi API MiniMax: Panduan integrasi API resmi dan spesifikasi model

- Tautan:

platform.minimax.io/docs/guides/text-generation - Keterangan: Berisi ID model, context window, contoh pemanggilan API, dan spesifikasi teknis lainnya.

- Tautan:

-

Evaluasi Artificial Analysis: Evaluasi model dan analisis performa dari pihak ketiga independen

- Tautan:

artificialanalysis.ai/models/minimax-m2-5 - Keterangan: Menyediakan peringkat benchmark standar, pengujian kecepatan aktual, dan perbandingan harga.

- Tautan:

-

MiniMax HuggingFace: Unduhan bobot (weight) model open-source

- Tautan:

huggingface.co/MiniMaxAI - Keterangan: Lisensi open-source MIT, mendukung deployment privat menggunakan vLLM/SGLang.

- Tautan:

Penulis: Tim Teknis

Diskusi Teknis: Silakan diskusikan pengalaman penggunaan MiniMax-M2.5 di kolom komentar. Untuk tutorial integrasi API model AI lainnya, kunjungi komunitas teknis APIYI apiyi.com.