作者注:深度解析 MiniMax-M2.5 和 M2.5-Lightning 兩個版本的編碼能力、智能體表現和 API 接入方法,SWE-Bench 80.2% 接近 Opus 4.6,價格僅爲 1/60

MiniMax 在 2026 年 2 月 12 日發佈了 MiniMax-M2.5 和 M2.5-Lightning 兩個模型版本。這是目前開源模型中首個在編碼能力上超越 Claude Sonnet 的模型,SWE-Bench Verified 達到 80.2%,僅比 Claude Opus 4.6 低 0.6 個百分點。目前該兩個模型已上線 APIYI 平臺,歡迎接入使用,價格方面通過參與充值活動,可做到官網 8 折。

核心價值: 通過本文的實測數據和代碼示例,你將瞭解 MiniMax-M2.5 兩個版本的核心差異,選擇最適合你場景的版本,並快速完成 API 接入。

MiniMax-M2.5 核心能力概覽

| 核心指標 | MiniMax-M2.5 標準版 | MiniMax-M2.5-Lightning | 價值說明 |

|---|---|---|---|

| SWE-Bench Verified | 80.2% | 80.2%(能力相同) | 接近 Opus 4.6 的 80.8% |

| 輸出速度 | ~50 TPS | ~100 TPS | Lightning 快 2 倍 |

| 輸出價格 | $0.15/$1.20 每百萬 Token | $0.30/$2.40 每百萬 Token | 標準版僅爲 Opus 的 1/63 |

| BFCL 工具調用 | 76.8% | 76.8%(能力相同) | 大幅領先 Opus 的 63.3% |

| 上下文窗口 | 205K tokens | 205K tokens | 支持大型代碼庫分析 |

MiniMax-M2.5 編碼能力詳解

MiniMax-M2.5 採用 MoE(Mixture of Experts)架構,總參數量 230B,但僅激活 10B 參數進行推理。這種設計使得模型在保持前沿編碼能力的同時,大幅降低了推理成本。

在編碼任務中,M2.5 展現出一種獨特的 "Spec-writing tendency"——在動手寫代碼之前,先對項目進行架構分解和設計規劃。這種行爲模式使它在處理複雜多文件項目時表現尤爲出色,Multi-SWE-Bench 得分 51.3% 甚至領先 Claude Opus 4.6 的 50.3%。

模型支持 10+ 編程語言的全棧開發,覆蓋 Python、Go、C/C++、TypeScript、Rust、Java、JavaScript、Kotlin、PHP 等主流語言,同時支持 Web、Android、iOS、Windows 等多平臺項目。

MiniMax-M2.5 智能體與工具調用能力

M2.5 在 BFCL Multi-Turn 基準測試中得分 76.8%,大幅領先 Claude Opus 4.6 的 63.3% 和 Gemini 3 Pro 的 61.0%。這意味着在需要多輪對話、多工具協作的智能體場景中,M2.5 是目前最強的選擇。

相比前代 M2.1,M2.5 完成智能體任務的工具調用輪次減少了約 20%,SWE-Bench Verified 評估速度提升了 37%。更高效的任務分解能力直接降低了 Token 消耗和調用成本。

MiniMax-M2.5 標準版與 Lightning 版本對比

選擇 MiniMax-M2.5 的哪個版本,取決於你的具體使用場景。兩個版本的模型能力完全一致,核心差異在於推理速度和定價。

| 對比維度 | M2.5 標準版 | M2.5-Lightning | 選擇建議 |

|---|---|---|---|

| API 模型 ID | MiniMax-M2.5 |

MiniMax-M2.5-highspeed |

— |

| 推理速度 | ~50 TPS | ~100 TPS | 需要實時響應選 Lightning |

| 輸入價格 | $0.15/M tokens | $0.30/M tokens | 批量任務選標準版 |

| 輸出價格 | $1.20/M tokens | $2.40/M tokens | 標準版便宜一半 |

| 持續運行成本 | ~$0.30/小時 | ~$1.00/小時 | 後臺任務選標準版 |

| 編碼能力 | 完全相同 | 完全相同 | 兩者無差異 |

| 工具調用 | 完全相同 | 完全相同 | 兩者無差異 |

MiniMax-M2.5 版本選擇場景指南

選擇 Lightning 高速版的場景:

- IDE 編碼助手集成,需要低延遲的實時代碼補全和重構建議

- 交互式智能體對話,用戶期望快速響應的客服或技術支持

- 實時搜索增強應用,需要快速反饋的網頁瀏覽和信息檢索

選擇標準版的場景:

- 後臺批量代碼審查和自動修復,不需要實時交互

- 大規模智能體任務編排,長時間運行的異步工作流

- 預算敏感的高吞吐量應用,追求最低單位成本

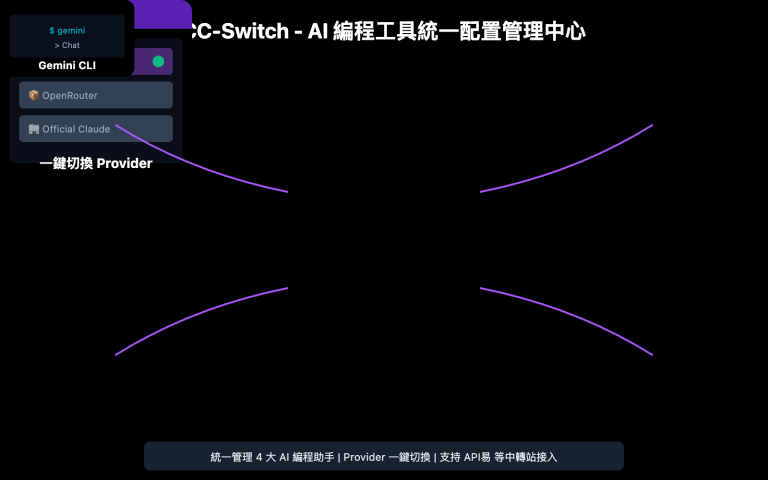

🎯 選擇建議:如果你不確定選哪個版本,建議先在 API易 apiyi.com 平臺上同時測試兩個版本。標準版和 Lightning 版本在同一接口下切換,只需修改 model 參數即可快速對比延遲和效果。

MiniMax-M2.5 與競品編碼能力對比

| 模型 | SWE-Bench Verified | BFCL Multi-Turn | 輸出價格/M | 每 $100 可完成任務數 |

|---|---|---|---|---|

| MiniMax-M2.5 | 80.2% | 76.8% | $1.20 | ~328 |

| MiniMax-M2.5-Lightning | 80.2% | 76.8% | $2.40 | ~164 |

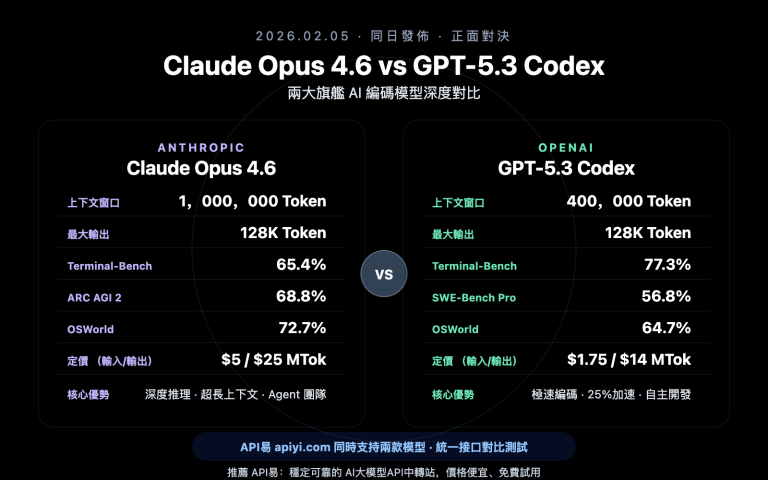

| Claude Opus 4.6 | 80.8% | 63.3% | ~$75 | ~30 |

| GPT-5.2 | 80.0% | — | ~$60 | ~30 |

| Gemini 3 Pro | 78.0% | 61.0% | ~$20 | ~90 |

從數據來看,MiniMax-M2.5 在編碼能力上已經達到前沿水平。SWE-Bench Verified 80.2% 的得分僅比 Opus 4.6 低 0.6%,但價格差距高達 60 倍以上。在工具調用能力上,M2.5 的 BFCL 76.8% 更是大幅領先所有競品。

對於需要大規模部署編碼智能體的團隊,M2.5 的成本優勢意味着同樣 $100 的預算可以完成約 328 個任務,而使用 Opus 4.6 僅能完成約 30 個。

對比說明: 以上基準測試數據來源於各模型官方公佈數據和第三方評測機構 Artificial Analysis。實際表現可能因具體任務場景有所不同,建議通過 API易 apiyi.com 進行實際場景測試驗證。

MiniMax-M2.5 API 快速接入

極簡示例

以下是通過 API易平臺接入 MiniMax-M2.5 的最簡方式,10 行代碼即可運行:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="MiniMax-M2.5", # 切換爲 MiniMax-M2.5-Lightning 可使用高速版

messages=[{"role": "user", "content": "用 Python 實現一個 LRU 緩存"}]

)

print(response.choices[0].message.content)

查看完整實現代碼(含流式輸出和工具調用)

from openai import OpenAI

from typing import Optional

def call_minimax_m25(

prompt: str,

model: str = "MiniMax-M2.5",

system_prompt: Optional[str] = None,

max_tokens: int = 4096,

stream: bool = False

) -> str:

"""

調用 MiniMax-M2.5 API

Args:

prompt: 用戶輸入

model: MiniMax-M2.5 或 MiniMax-M2.5-Lightning

system_prompt: 系統提示詞

max_tokens: 最大輸出 token 數

stream: 是否啓用流式輸出

Returns:

模型響應內容

"""

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

try:

response = client.chat.completions.create(

model=model,

messages=messages,

max_tokens=max_tokens,

stream=stream

)

if stream:

result = ""

for chunk in response:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

result += content

print(content, end="", flush=True)

print()

return result

else:

return response.choices[0].message.content

except Exception as e:

return f"Error: {str(e)}"

# 使用示例:編碼任務

result = call_minimax_m25(

prompt="重構以下代碼,提升性能並添加錯誤處理",

model="MiniMax-M2.5-Lightning",

system_prompt="你是一個資深全棧工程師,擅長代碼重構和性能優化",

stream=True

)

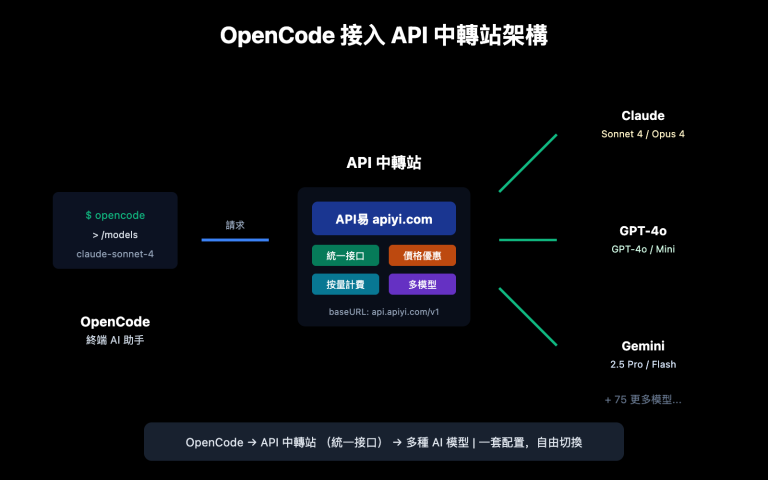

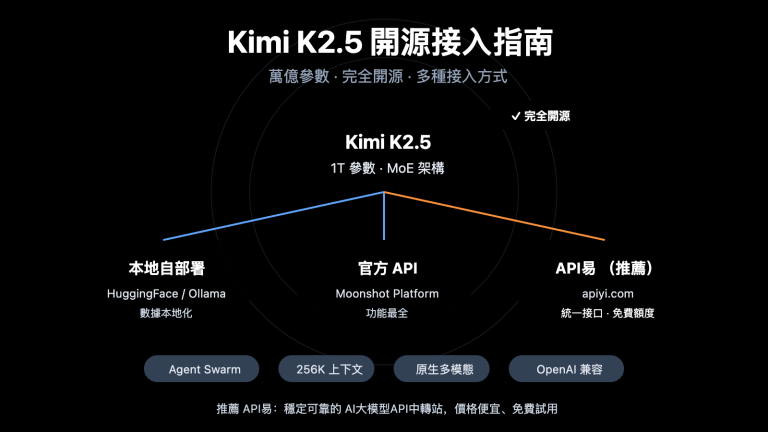

建議: 通過 API易 apiyi.com 獲取免費測試額度,快速驗證 MiniMax-M2.5 在你的實際項目中的編碼效果。平臺支持 OpenAI 兼容接口,現有代碼只需修改 base_url 和 model 參數即可切換。

MiniMax-M2.5 技術架構解析

MiniMax-M2.5 的核心競爭力來源於兩個技術創新:MoE 高效架構和 Forge RL 訓練框架。

MiniMax-M2.5 MoE 架構優勢

| 架構參數 | MiniMax-M2.5 | 傳統密集模型 | 優勢說明 |

|---|---|---|---|

| 總參數量 | 230B | 通常 70B-200B | 知識容量更大 |

| 激活參數量 | 10B | 等於總參數量 | 推理成本極低 |

| 推理效率 | 50-100 TPS | 10-30 TPS | 速度提升 3-10 倍 |

| 單位成本 | $1.20/M 輸出 | $20-$75/M 輸出 | 成本降低 20-60 倍 |

MoE 架構的核心思想是"專家分工"——模型包含多組專家網絡,每次推理只激活與當前任務最相關的專家子集。M2.5 以僅 10B 的激活參數量實現了接近 230B 密集模型的效果,這使得它成爲目前 Tier 1 模型中體積最小、成本最低的選擇。

MiniMax-M2.5 Forge RL 訓練框架

M2.5 的另一關鍵技術是 Forge 強化學習框架:

- 訓練環境規模: 超過 20 萬個真實世界訓練環境,涵蓋代碼庫、網頁瀏覽器、辦公應用

- 訓練算法: CISPO(Clipped Importance Sampling Policy Optimization),專爲多步決策任務設計

- 訓練效率: 相比標準 RL 方法實現 40 倍訓練加速

- 獎勵機制: 基於結果的獎勵系統,而非傳統的人類偏好反饋(RLHF)

這種訓練方式使得 M2.5 在真實編碼和智能體任務中表現更加穩健,能夠高效地進行任務分解、工具選擇和多步執行。

🎯 實踐建議:MiniMax-M2.5 已經在 API易 apiyi.com 平臺上線。建議開發者先使用免費額度測試編碼和智能體場景,根據實際延遲和效果需求選擇標準版或 Lightning 版本。

常見問題

Q1: MiniMax-M2.5 標準版和 Lightning 版本能力有差異嗎?

沒有差異。兩個版本的模型能力完全一致,SWE-Bench、BFCL 等所有基準測試得分相同。唯一的區別是推理速度(標準版 50 TPS vs Lightning 100 TPS)和對應的定價。選擇時只需考慮延遲需求和預算。

Q2: MiniMax-M2.5 適合替代 Claude Opus 4.6 嗎?

在編碼和智能體場景中可以考慮。M2.5 的 SWE-Bench 得分(80.2%)僅低於 Opus 4.6 0.6 個百分點,而工具調用能力(BFCL 76.8%)大幅領先。價格方面,M2.5 標準版僅爲 Opus 的 1/63。建議通過 API易 apiyi.com 在實際項目中對比測試,根據你的具體場景判斷。

Q3: 如何快速開始測試 MiniMax-M2.5?

推薦使用 API易平臺快速接入:

- 訪問 API易 apiyi.com 註冊賬號

- 獲取 API Key 和免費測試額度

- 使用本文的代碼示例,修改 model 參數爲

MiniMax-M2.5或MiniMax-M2.5-Lightning - OpenAI 兼容接口,現有項目只需修改 base_url 即可

總結

MiniMax-M2.5 的核心要點:

- 編碼能力前沿: SWE-Bench Verified 80.2%,Multi-SWE-Bench 51.3% 行業領先,是首個超越 Claude Sonnet 的開源模型

- 智能體能力第一: BFCL Multi-Turn 76.8% 大幅領先所有競品,工具調用輪次比前代減少 20%

- 極致性價比: 標準版輸出僅 $1.20/M tokens,是 Opus 4.6 的 1/63,同等預算可完成 10 倍以上任務

- 雙版本靈活選擇: 標準版適合批量和成本優先場景,Lightning 適合實時交互和低延遲場景

MiniMax-M2.5 已在 API易平臺上線,支持 OpenAI 兼容接口調用。推薦通過 API易 apiyi.com 獲取免費額度進行實測,只需修改 model 參數即可在兩個版本間切換對比。

📚 參考資料

⚠️ 鏈接格式說明: 所有外鏈使用

資料名: domain.com格式,方便複製但不可點擊跳轉,避免 SEO 權重流失。

-

MiniMax M2.5 官方公告: 詳細介紹 M2.5 的核心能力和技術細節

- 鏈接:

minimax.io/news/minimax-m25 - 說明: 官方發佈文檔,包含完整的基準測試數據和訓練方法介紹

- 鏈接:

-

MiniMax API 文檔: 官方 API 接入指南和模型規格

- 鏈接:

platform.minimax.io/docs/guides/text-generation - 說明: 包含模型 ID、上下文窗口、API 調用示例等技術規格

- 鏈接:

-

Artificial Analysis 評測: 獨立第三方模型評測和性能分析

- 鏈接:

artificialanalysis.ai/models/minimax-m2-5 - 說明: 提供標準化的基準測試排名、速度實測和價格對比

- 鏈接:

-

MiniMax HuggingFace: 開源模型權重下載

- 鏈接:

huggingface.co/MiniMaxAI - 說明: MIT 協議開源,支持 vLLM/SGLang 私有化部署

- 鏈接:

作者: 技術團隊

技術交流: 歡迎在評論區討論 MiniMax-M2.5 的使用體驗,更多 AI 模型 API 接入教程可訪問 API易 apiyi.com 技術社區