著者注:MiniMax-M2.5とM2.5-Lightningの2つのバージョンについて、コーディング能力、エージェント性能、そしてAPI連携方法を徹底解説します。SWE-Benchで80.2%を記録し、Claude Opus 4.6に迫る実力を持ちながら、価格はわずか60分の1です。

MiniMaxは2026年2月12日、MiniMax-M2.5およびM2.5-Lightningの2つのモデルバージョンをリリースしました。これは、コーディング能力においてClaude Sonnetを上回った初のオープンソースモデル(※公開モデル)であり、SWE-Bench VerifiedではClaude Opus 4.6の80.8%にわずか0.6ポイント差まで迫る80.2%を達成しました。現在、これら2つのモデルはAPIYIプラットフォームで利用可能です。チャージキャンペーンを利用することで、公式サイトの8割程度の価格で導入できます。

核心的価値: 本記事の実測データとコード例を通じて、MiniMax-M2.5の2つのバージョンの主な違いを理解し、ご自身のユースケースに最適なバージョンを選択して、迅速にAPI連携を完了させることができます。

MiniMax-M2.5 核心能力概覧

| 核心指標 | MiniMax-M2.5 標準版 | MiniMax-M2.5-Lightning | 価値の説明 |

|---|---|---|---|

| SWE-Bench Verified | 80.2% | 80.2%(能力は同等) | Opus 4.6の80.8%に匹敵 |

| 出力速度 | ~50 TPS | ~100 TPS | Lightningは2倍速 |

| 出力価格 | $0.15/$1.20 (1M Tokenあたり) | $0.30/$2.40 (1M Tokenあたり) | 標準版はOpusのわずか1/63 |

| BFCL ツール呼び出し | 76.8% | 76.8%(能力は同等) | Opusの63.3%を大幅にリード |

| コンテキストウィンドウ | 205K tokens | 205K tokens | 大規模コードベースの分析に対応 |

MiniMax-M2.5 コーディング能力の詳細

MiniMax-M2.5はMoE(Mixture of Experts)アーキテクチャを採用しており、総パラメータ数は230Bですが、推論時にアクティブになるのは10Bパラメータのみです。この設計により、最先端のコーディング能力を維持しつつ、推論コストを大幅に削減することに成功しました。

コーディングタスクにおいて、M2.5は独自の「Spec-writing tendency(仕様を先に書く傾向)」を示します。実際にコードを書き始める前に、プロジェクトのアーキテクチャ分解や設計プランニングを行います。この行動パターンにより、複雑な複数ファイルにわたるプロジェクトの処理に非常に優れており、Multi-SWE-Benchのスコアは51.3%と、Claude Opus 4.6の50.3%を上回っています。

モデルは10以上のプログラミング言語によるフルスタック開発をサポートしており、Python、Go、C/C++、TypeScript、Rust、Java、JavaScript、Kotlin、PHPなどの主要言語をカバーしています。また、Web、Android、iOS、Windowsなどのマルチプラットフォームプロジェクトにも対応しています。

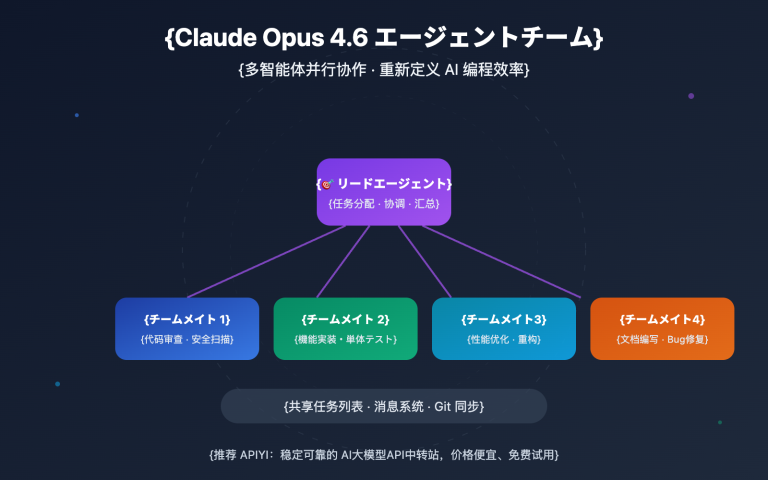

MiniMax-M2.5 エージェントとツール呼び出し能力

M2.5はBFCL Multi-Turnベンチマークで76.8%を記録し、Claude Opus 4.6の63.3%やGemini 3 Proの61.0%を大幅に引き離しました。これは、複数回の対話や複数のツール連携が必要なエージェントシナリオにおいて、M2.5が現時点で最強の選択肢であることを意味します。

前世代のM2.1と比較して、M2.5はエージェントタスク完了までのツール呼び出し回数が約20%減少し、SWE-Bench Verifiedの評価速度は37%向上しました。より効率的なタスク分解能力により、Token消費量と呼び出しコストが直接的に削減されます。

MiniMax-M2.5 標準版と Lightning 版の比較

MiniMax-M2.5 のどちらのバージョンを選択するかは、具体的な使用シーンによって決まります。両バージョンのモデル能力は完全に一致しており、主な違いは推論速度と価格設定にあります。

| 比較項目 | M2.5 標準版 | M2.5-Lightning | 選択のアドバイス |

|---|---|---|---|

| APIモデルID | MiniMax-M2.5 |

MiniMax-M2.5-highspeed |

— |

| 推論速度 | ~50 TPS | ~100 TPS | リアルタイムな応答が必要なら Lightning |

| 入力料金 | $0.15/M tokens | $0.30/M tokens | バッチ処理タスクなら標準版 |

| 出力料金 | $1.20/M tokens | $2.40/M tokens | 標準版は料金が半分 |

| 継続実行コスト | ~$0.30/時間 | ~$1.00/時間 | バックグラウンドタスクなら標準版 |

| コーディング能力 | 完全に同一 | 完全に同一 | 両者に差はなし |

| ツール呼び出し | 完全に同一 | 完全に同一 | 両者に差はなし |

MiniMax-M2.5 バージョン選択シーン別ガイド

Lightning(高速版)を選択すべきシーン:

- IDE コーディングアシスタントへの統合:低遅延でのリアルタイムなコード補完やリファクタリングの提案が必要な場合

- インタラクティブなエージェントとの対話:カスタマーサポートやテクニカルサポートなど、ユーザーが素早い応答を期待する場合

- リアルタイム検索拡張アプリケーション:迅速なフィードバックが求められるウェブブラウジングや情報検索

標準版を選択すべきシーン:

- バックグラウンドでの一括コードレビューや自動修正:リアルタイムの対話を必要としない場合

- 大規模なエージェントのタスク・オーケストレーション:長時間実行される非同期ワークフロー

- 予算に敏感な高スループットアプリケーション:ユニットコストの最小化を追求する場合

🎯 選択のアドバイス:どちらのバージョンを選ぶべきか迷っている場合は、まず APIYI(apiyi.com)プラットフォームで両方のバージョンをテストすることをお勧めします。標準版と Lightning 版は同一のインターフェースで切り替え可能で、

modelパラメータを変更するだけで遅延と効果を素早く比較できます。

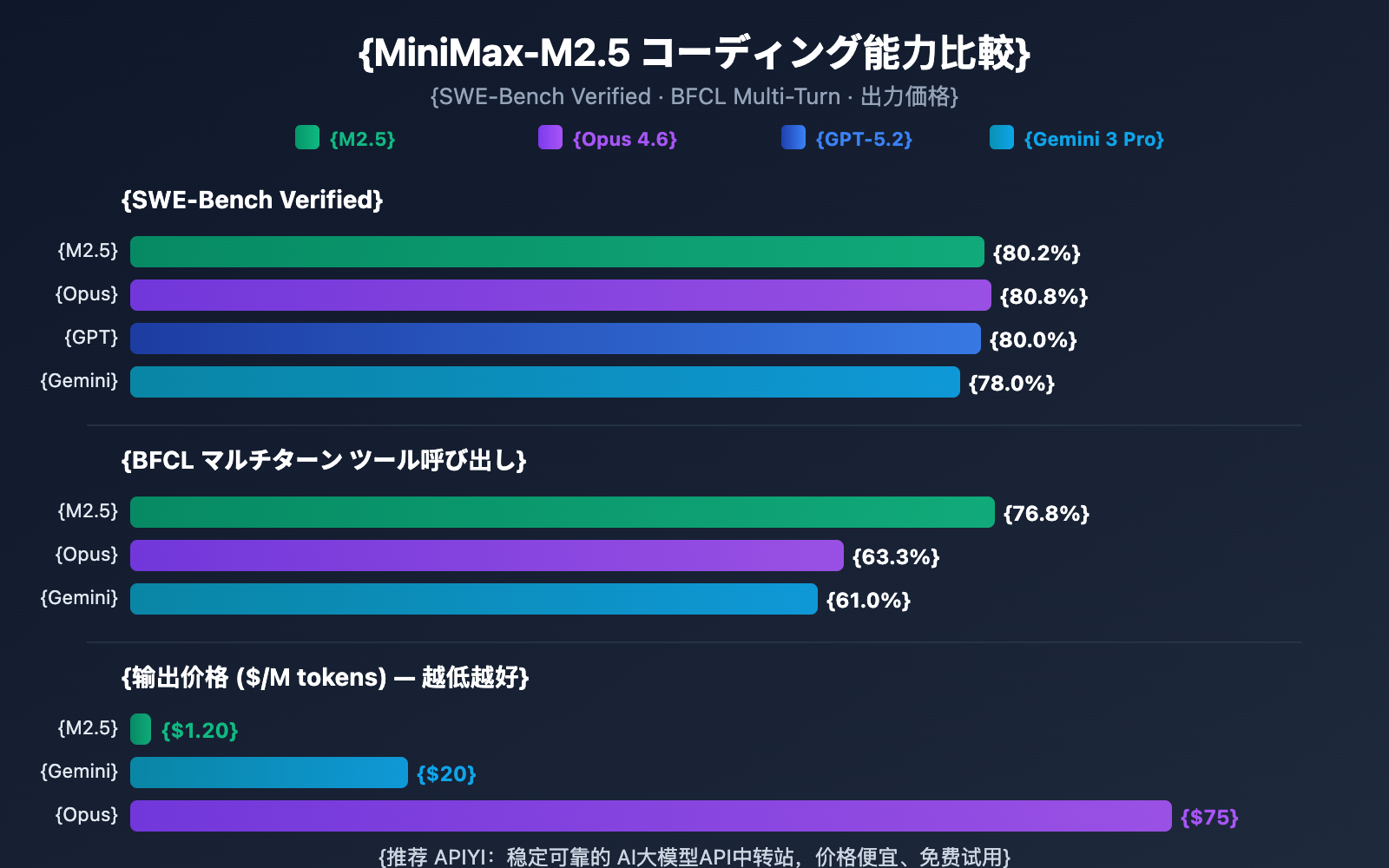

MiniMax-M2.5 と競合モデルのコーディング能力比較

| モデル | SWE-Bench Verified | BFCL Multi-Turn | 出力料金/1M tokens | $100あたりの完了可能タスク数 |

|---|---|---|---|---|

| MiniMax-M2.5 | 80.2% | 76.8% | $1.20 | ~328 |

| MiniMax-M2.5-Lightning | 80.2% | 76.8% | $2.40 | ~164 |

| Claude Opus 4.6 | 80.8% | 63.3% | ~$75 | ~30 |

| GPT-5.2 | 80.0% | — | ~$60 | ~30 |

| Gemini 3 Pro | 78.0% | 61.0% | ~$20 | ~90 |

データから見ると、MiniMax-M2.5 のコーディング能力はすでに最先端レベルに達しています。SWE-Bench Verified での 80.2% というスコアは、Opus 4.6 よりわずか 0.6% 低いだけですが、価格差は 60 倍以上に達します。また、ツール呼び出し能力においても、M2.5 の BFCL 76.8% はすべての競合モデルを大幅にリードしています。

コーディング・エージェントを大規模にデプロイする必要があるチームにとって、M2.5 のコストメリットは非常に大きく、同じ 100 ドルの予算で Opus 4.6 が約 30 タスクしか完了できないのに対し、M2.5 は約 328 タスクを完了させることが可能です。

比較に関する注記: 上記のベンチマークデータは、各モデルの公式発表データおよび第三者評価機関 Artificial Analysis に基づいています。実際のパフォーマンスは具体的なタスクやシーンによって異なる場合があるため、APIYI(apiyi.com)を通じて実際の利用シーンでテスト検証することをお勧めします。

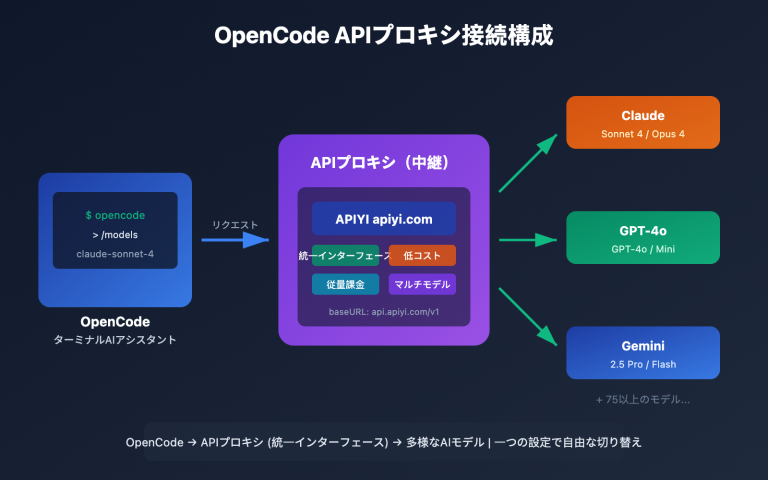

MiniMax-M2.5 API クイックアクセス

シンプルな実装例

以下は、APIYIプラットフォームを通じて MiniMax-M2.5 に接続する最も簡単な方法です。わずか10行のコードで実行可能です。

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="MiniMax-M2.5", # MiniMax-M2.5-Lightning に切り替えることで高速版を利用可能

messages=[{"role": "user", "content": "用 Python 实现一个 LRU 缓存"}]

)

print(response.choices[0].message.content)

完全な実装コードを表示(ストリーミング出力とツール呼び出しを含む)

from openai import OpenAI

from typing import Optional

def call_minimax_m25(

prompt: str,

model: str = "MiniMax-M2.5",

system_prompt: Optional[str] = None,

max_tokens: int = 4096,

stream: bool = False

) -> str:

"""

调用 MiniMax-M2.5 API

Args:

prompt: 用户输入

model: MiniMax-M2.5 或 MiniMax-M2.5-Lightning

system_prompt: 系统提示词

max_tokens: 最大输出 token 数

stream: 是否启用流式输出

Returns:

模型响应内容

"""

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

try:

response = client.chat.completions.create(

model=model,

messages=messages,

max_tokens=max_tokens,

stream=stream

)

if stream:

result = ""

for chunk in response:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

result += content

print(content, end="", flush=True)

print()

return result

else:

return response.choices[0].message.content

except Exception as e:

return f"Error: {str(e)}"

# 使用示例:编码任务

result = call_minimax_m25(

prompt="重构以下代码,提升性能并添加错误处理",

model="MiniMax-M2.5-Lightning",

system_prompt="你是一个资深全栈工程师,擅长代码重构和性能优化",

stream=True

)

アドバイス: APIYI(apiyi.com)で無料テストクレジットを取得し、実際のプロジェクトで MiniMax-M2.5 のコーディング性能を素早く検証してみてください。このプラットフォームは OpenAI 互換インターフェースをサポートしているため、既存のコードの

base_urlとmodelパラメータを変更するだけで簡単に切り替えが可能です。

MiniMax-M2.5 技術アーキテクチャ解析

MiniMax-M2.5 の核心的な競争力は、2つの技術革新から生まれています。それは、高効率な MoE(Mixture of Experts)アーキテクチャと Forge RL(強化学習)トレーニングフレームワークです。

MiniMax-M2.5 MoE アーキテクチャの優位性

| アーキテクチャ・パラメータ | MiniMax-M2.5 | 従来の密なモデル | メリットの説明 |

|---|---|---|---|

| 総パラメータ数 | 230B | 通常 70B-200B | 知識容量がより大きい |

| アクティブ・パラメータ数 | 10B | 総パラメータ数に等しい | 推論コストが極めて低い |

| 推論効率 | 50-100 TPS | 10-30 TPS | 速度が 3〜10 倍向上 |

| ユニットコスト | $1.20/1M 出力 | $20-$75/1M 出力 | コストが 20〜60 倍削減 |

MoE アーキテクチャの核心的なアイデアは「専門家の分業」です。モデルには複数の専門家ネットワークが含まれており、推論のたびに現在のタスクに最も関連性の高い専門家のサブセットのみをアクティブにします。M2.5 は、わずか 10B のアクティブ・パラメータ数で 230B の密なモデルに近い性能を実現しました。これにより、現在の Tier 1 モデルの中で最もコンパクトで低コストな選択肢となっています。

MiniMax-M2.5 Forge RL トレーニングフレームワーク

M2.5 のもう一つの重要な技術は、Forge 強化学習フレームワークです。

- トレーニング環境の規模: 20万以上の実世界のトレーニング環境(コードベース、ウェブブラウザ、オフィスアプリなど)をカバー。

- トレーニングアルゴリズム: CISPO(Clipped Importance Sampling Policy Optimization)。多段階の意思決定タスク向けに特別に設計。

- トレーニング効率: 標準的な RL 手法と比較して 40 倍のトレーニング加速を実現。

- 報酬メカニズム: 従来の人間の好みに基づくフィードバック(RLHF)ではなく、結果に基づいた報酬システムを採用。

このトレーニング手法により、M2.5 は実際のコーディングやエージェントタスクにおいてより堅牢なパフォーマンスを発揮し、タスクの分解、ツールの選択、多段階の実行を効率的に行うことができます。

🎯 実践的なアドバイス: MiniMax-M2.5 はすでに APIYI(apiyi.com)プラットフォームで利用可能です。まずは無料クレジットを使用してコーディングやエージェントのシナリオをテストし、実際の遅延や効果のニーズに応じて、標準版または Lightning 版を選択することをお勧めします。

よくある質問

Q1: MiniMax-M2.5 標準版と Lightning バージョンで能力に違いはありますか?

違いはありません。両バージョンのモデル能力は完全に一致しており、SWE-Bench や BFCL などのすべてのベンチマークテストで同じスコアを記録しています。唯一の違いは推論速度(標準版 50 TPS vs Lightning 100 TPS)とそれに対応する価格設定です。選択の際は、レイテンシの要件と予算のみを考慮してください。

Q2: MiniMax-M2.5 は Claude Opus 4.6 の代替として適していますか?

コーディングやエージェントのシナリオにおいては、十分に検討に値します。M2.5 の SWE-Bench スコア(80.2%)は Opus 4.6 にわずか 0.6 ポイント及ばないだけですが、ツール呼び出し能力(BFCL 76.8%)では大幅にリードしています。価格面では、M2.5 標準版は Opus のわずか 63 分の 1 です。APIYI (apiyi.com) を通じて実際のプロジェクトで比較テストを行い、具体的なユースケースに基づいて判断することをお勧めします。

Q3: MiniMax-M2.5 のテストを素早く開始するにはどうすればよいですか?

APIYI プラットフォームを使用して素早く導入することをお勧めします:

- APIYI (apiyi.com) にアクセスしてアカウントを登録します。

- API Key と無料テストクレジットを取得します。

- 本記事のコード例を使用し、model パラメータを

MiniMax-M2.5またはMiniMax-M2.5-Lightningに変更します。 - OpenAI 互換インターフェースのため、既存のプロジェクトでは base_url を変更するだけで対応可能です。

まとめ

MiniMax-M2.5 の主要なポイント:

- 最先端のコーディング能力: SWE-Bench Verified で 80.2%、Multi-SWE-Bench で 51.3% と業界をリードしており、Claude Sonnet を超えた初のオープンソースモデルです。

- エージェント能力でトップ: BFCL Multi-Turn で 76.8% を記録し、すべての競合製品を大幅にリード。ツール呼び出しのターン数も前世代より 20% 削減されました。

- 圧倒的なコストパフォーマンス: 標準版の出力はわずか $1.20/M tokens で、Opus 4.6 の 63 分の 1 です。同じ予算で 10 倍以上のタスクを完了できます。

- 2つのバージョンから柔軟に選択可能: 標準版はバッチ処理やコスト優先のシナリオに適しており、Lightning はリアルタイムの対話や低レイテンシのシナリオに適しています。

MiniMax-M2.5 はすでに APIYI プラットフォームでリリースされており、OpenAI 互換インターフェースでの呼び出しをサポートしています。APIYI (apiyi.com) で無料クレジットを取得して実測することをお勧めします。model パラメータを変更するだけで、2つのバージョンを簡単に切り替えて比較できます。

📚 参考文献

⚠️ リンク形式に関する説明: すべての外部リンクは「資料名: domain.com」の形式を使用しています。コピーしやすく、かつSEO評価の流出を防ぐため、クリック可能なリンクにはしていません。

-

MiniMax M2.5 公式アナウンス: M2.5のコア機能と技術的な詳細についての詳細紹介

- リンク:

minimax.io/news/minimax-m25 - 説明: 公式リリースドキュメント。完全なベンチマークデータと学習方法の紹介が含まれています。

- リンク:

-

MiniMax API ドキュメント: 公式API導入ガイドとモデル仕様

- リンク:

platform.minimax.io/docs/guides/text-generation - 説明: モデルID、コンテキストウィンドウ、API呼び出し例などの技術仕様が含まれています。

- リンク:

-

Artificial Analysis による評価: 独立した第三者機関によるモデル評価とパフォーマンス分析

- リンク:

artificialanalysis.ai/models/minimax-m2-5 - 説明: 標準化されたベンチマークランキング、実測速度、価格比較を提供しています。

- リンク:

-

MiniMax HuggingFace: オープンソースモデルの重み(Weights)のダウンロード

- リンク:

huggingface.co/MiniMaxAI - 説明: MITライセンスで公開。vLLM/SGLangによるプライベートデプロイに対応しています。

- リンク:

著者: 技術チーム

技術交流: MiniMax-M2.5の使用感について、ぜひコメント欄で議論しましょう。さらなるAIモデルのAPI連携チュートリアルについては、APIYI (apiyi.com) 技術コミュニティをご覧ください。