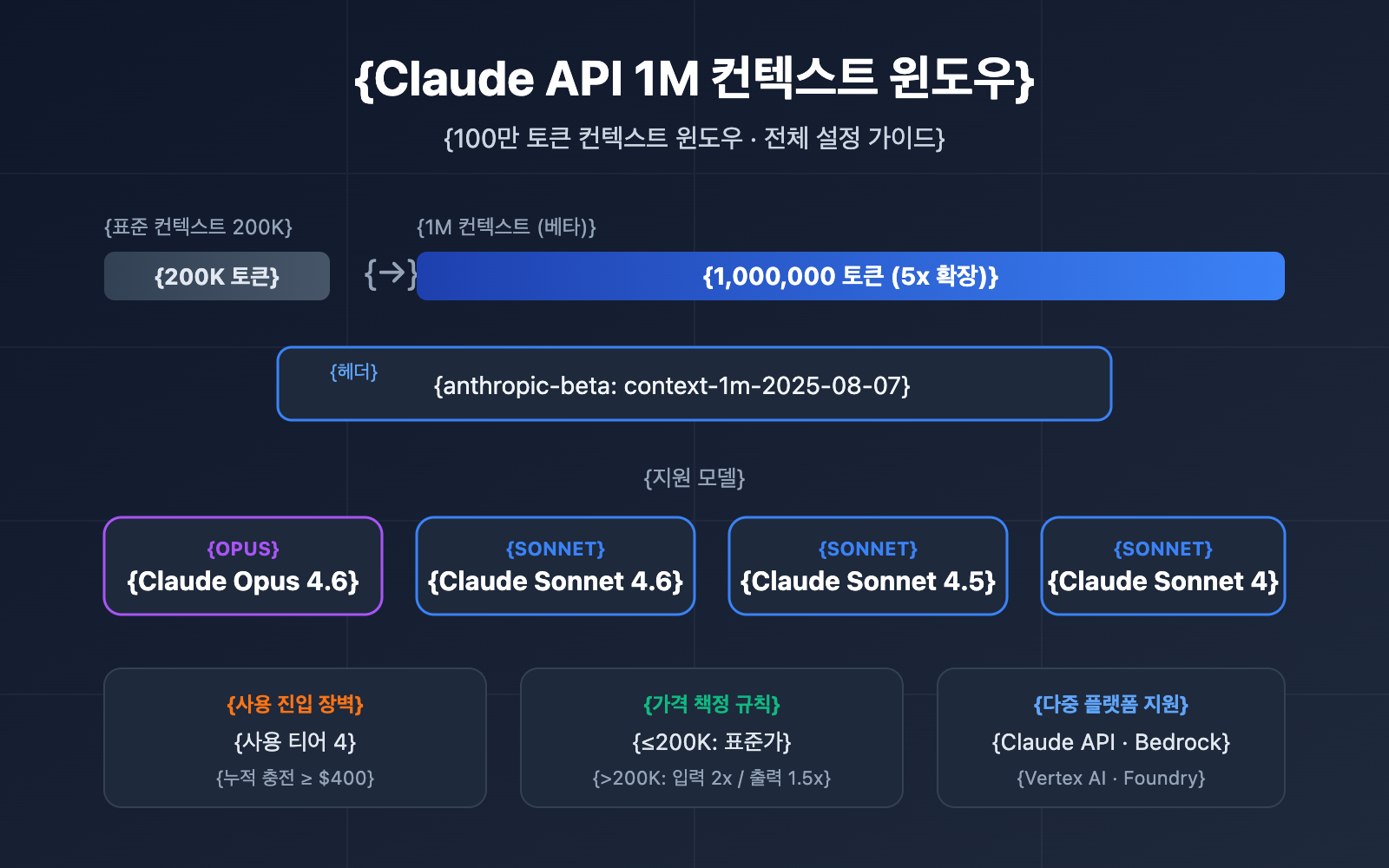

API 호출 시 20만 토큰 이상의 초장문 컨텍스트를 사용하는 방법은 점점 더 많은 개발자가 직면하는 실제 요구사항입니다. Anthropic은 Claude API 100만 토큰 컨텍스트 윈도우(1M Context Window) 기능을 출시하여, 단일 요청으로 약 75만 자의 텍스트 내용을 처리할 수 있게 했습니다. 이는 소설 '홍루몽'과 '삼국지연의' 전체를 한 번에 읽는 것과 맞맞는 양입니다.

핵심 가치: 이 글을 읽고 나면 Claude API 1M 컨텍스트 윈도우의 전체 활성화 방법과 요금 계산 규칙을 마스터하고, 5가지 실전 시나리오 코드 템플릿을 얻을 수 있습니다.

Claude API 1M 컨텍스트 윈도우 핵심 요점

상세 설정을 살펴보기 전에, 이 기능의 주요 정보를 먼저 확인해 보세요.

| 요점 | 설명 | 가치 |

|---|---|---|

| Beta 기능 | context-1m-2025-08-07 헤더를 통해 활성화 |

별도 신청 없이 헤더 추가만으로 사용 가능 |

| 지원 모델 | Opus 4.6, Sonnet 4.6, Sonnet 4.5, Sonnet 4 | 주요 모델 라인업 모두 포함 |

| 사용 자격 | Usage Tier 4 또는 별도 속도 제한 설정 필요 | 누적 $400 충전 시 Tier 4 달성 가능 |

| 요금 규칙 | 200K 토큰 초과 시 장문 컨텍스트 요금으로 자동 전환 | 입력 2배, 출력 1.5배 표준 가격 적용 |

| 멀티 플랫폼 지원 | Claude API, AWS Bedrock, Google Vertex AI, Microsoft Foundry | 플랫폼 간 동일한 경험 제공 |

Claude API 1M 컨텍스트 윈도우의 작동 원리

Claude API의 표준 컨텍스트 윈도우는 200K 토큰입니다. Beta 헤더를 통해 1M 컨텍스트 윈도우를 활성화하면, 모델은 단일 요청에서 최대 100만 개의 토큰 입력을 처리할 수 있습니다.

특히 주의할 점은 컨텍스트 윈도우에 다음 모든 내용이 포함된다는 것입니다:

- 입력 토큰: 시스템 프롬프트, 대화 기록, 현재 사용자 메시지

- 출력 토큰: 모델이 생성한 답변 내용

- 사고 토큰: Extended Thinking을 활성화한 경우, 사고 과정도 포함됨

🎯 기술 제언: Claude API의 1M 컨텍스트 윈도우는 대규모 코드베이스 분석, 장문 문서 이해 등의 시나리오에 특히 적합합니다. Claude 전 시리즈 모델의 통합 인터페이스 호출을 지원하는 APIYI (apiyi.com) 플랫폼을 통해 장문 컨텍스트 솔루션을 빠르게 검증해 보시는 것을 추천합니다.

Claude API 1M 컨텍스트 창 빠르게 시작하기

시작 전 준비 사항

1M 컨텍스트 창을 사용하기 전에 다음 조건들을 충족하는지 확인해 주세요.

| 조건 | 요구 사항 | 확인 방법 |

|---|---|---|

| Usage Tier | Tier 4 또는 사용자 정의 속도 제한 | Claude Console 접속 → Settings → Limits |

| 누적 충전 금액 | ≥ $400 (Tier 4 등급 기준) | 계정 충전 기록 확인 |

| 모델 선택 | Opus 4.6 / Sonnet 4.6 / Sonnet 4.5 / Sonnet 4 | 기타 모델은 1M 컨텍스트 미지원 |

| API 버전 | anthropic-version: 2023-06-01 |

요청 헤더(header)에 지정 |

초간단 예제

표준 API 요청에 beta 헤더 한 줄만 추가하면 1M 컨텍스트 창을 바로 사용할 수 있어요.

import anthropic

client = anthropic.Anthropic(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 통합 인터페이스 사용

)

response = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

messages=[

{"role": "user", "content": "다음 긴 문서의 핵심 논점을 분석해 주세요..."}

],

betas=["context-1m-2025-08-07"],

)

print(response.content[0].text)

cURL을 사용한 호출 방법:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [

{"role": "user", "content": "분석할 긴 문서 내용..."}

]

}'

핵심 코드 설명:

betas=["context-1m-2025-08-07"]: Python SDK 방식이며, 자동으로anthropic-beta헤더를 추가합니다.anthropic-beta: context-1m-2025-08-07: cURL 또는 HTTP 요청 시 사용하는 헤더 형식입니다.- 입력 토큰이 200K를 넘지 않으면 beta 헤더를 추가했더라도 표준 가격으로 요금이 청구됩니다.

TypeScript 전체 코드 보기

import Anthropic from "@anthropic-ai/sdk";

import * as fs from "fs";

const anthropic = new Anthropic({

apiKey: "YOUR_API_KEY",

baseURL: "https://api.apiyi.com/v1" // APIYI 통합 인터페이스 사용

});

async function analyzeLongDocument(filePath: string) {

// 대용량 파일 읽기

const document = fs.readFileSync(filePath, "utf-8");

const response = await anthropic.beta.messages.create({

model: "claude-opus-4-6",

max_tokens: 8192,

messages: [

{

role: "user",

content: `다음 문서에 대해 포괄적인 분석을 수행해 주세요:

1. 핵심 논점 요약

2. 주요 데이터 추출

3. 논리 구조 평가

4. 개선 제안 사항

문서 내용:

${document}`

}

],

betas: ["context-1m-2025-08-07"]

});

console.log(response.content[0].text);

// 토큰 사용량 확인

console.log("Input tokens:", response.usage.input_tokens);

console.log("Output tokens:", response.usage.output_tokens);

}

analyzeLongDocument("./large-report.txt");

🚀 빠른 시작: Claude 1M 컨텍스트 창을 빠르게 테스트하려면 APIYI(apiyi.com) 플랫폼을 추천해요. 이 플랫폼은 OpenAI 호환 인터페이스를 제공하여 복잡한 설정 없이 Claude의 모든 모델을 지원합니다.

Claude API 1M 컨텍스트 윈도우 요금 체계 상세 안내

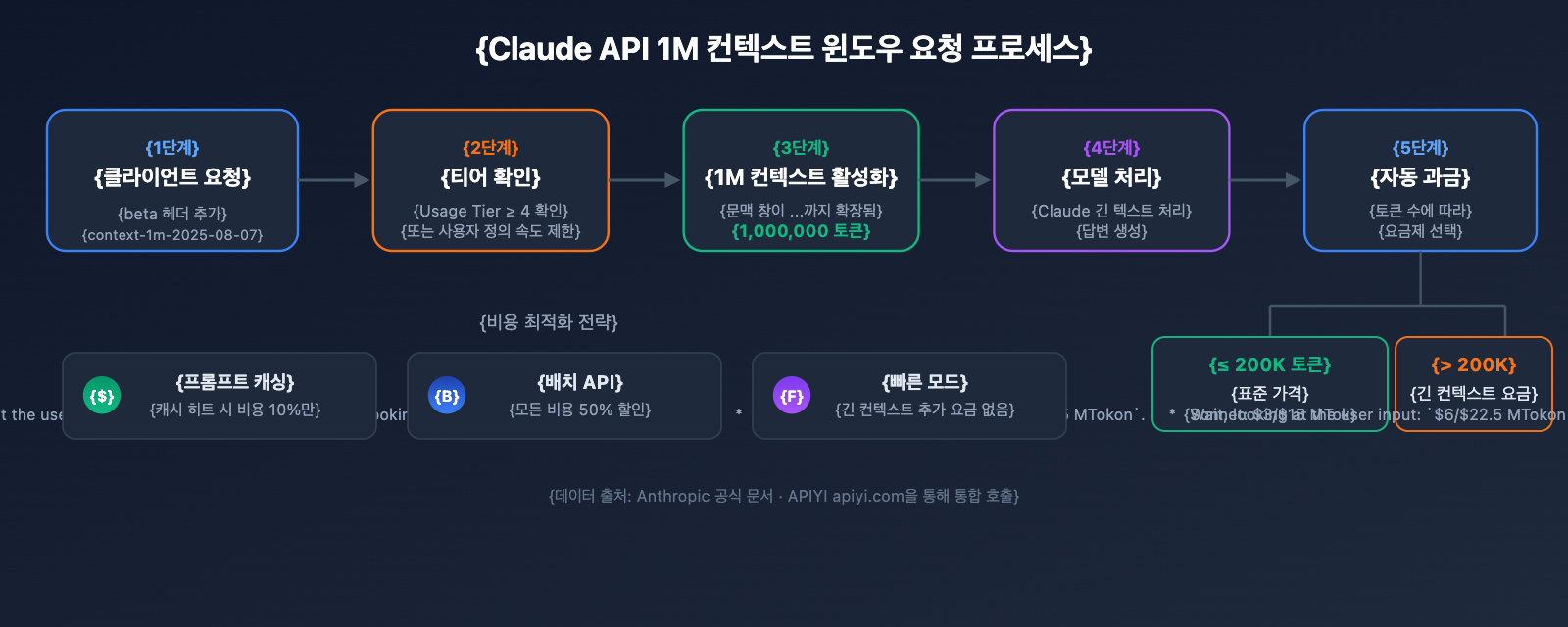

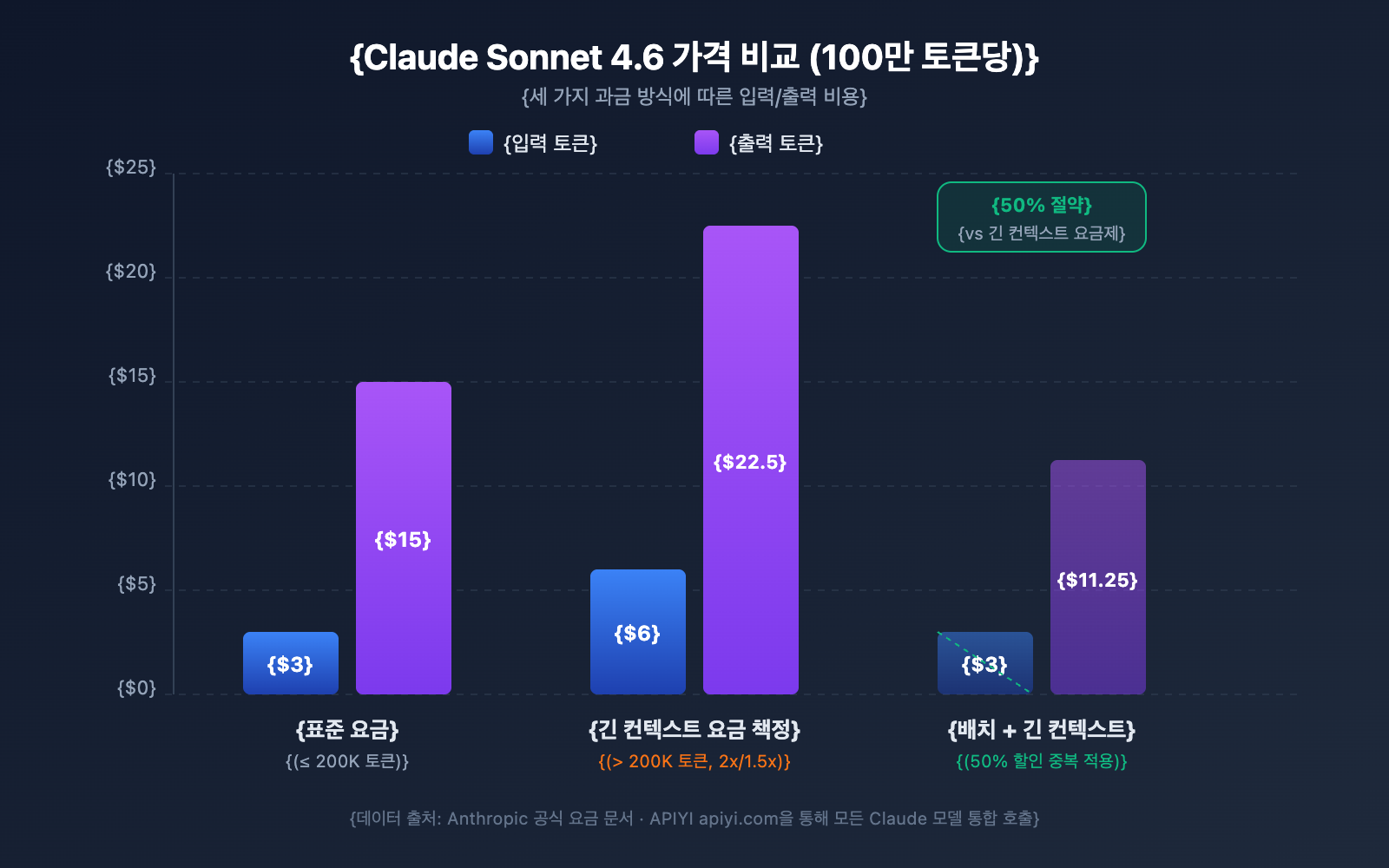

긴 컨텍스트(Long Context) 요금은 개발자들이 가장 궁금해하는 부분 중 하나죠. Claude API는 구간별 요금 정책을 채택하고 있습니다. 입력 토큰이 200K를 초과하느냐에 따라 요금 등급이 결정됩니다.

각 모델별 긴 컨텍스트 요금 비교

| 모델 | 표준 입력 (≤200K) | 긴 컨텍스트 입력 (>200K) | 표준 출력 | 긴 컨텍스트 출력 | 배율 |

|---|---|---|---|---|---|

| Claude Opus 4.6 | $5/MTok | $10/MTok | $25/MTok | $37.50/MTok | 입력 2배 / 출력 1.5배 |

| Claude Sonnet 4.6 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 입력 2배 / 출력 1.5배 |

| Claude Sonnet 4.5 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 입력 2배 / 출력 1.5배 |

| Claude Sonnet 4 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 입력 2배 / 출력 1.5배 |

MTok = 백만(Million) 토큰

요금 계산 규칙

예상치 못한 비용 발생을 피하기 위해 몇 가지 핵심 규칙을 꼭 이해해 두세요:

- 200K 임계값은 '스위치'입니다: 입력 토큰 총량이 200K를 넘는 순간, 해당 요청의 모든 토큰에 대해 긴 컨텍스트 요금이 적용됩니다. 초과분에 대해서만 할증되는 방식이 아닙니다.

- 입력 토큰 총량에는 캐시가 포함됩니다:

input_tokens+cache_creation_input_tokens+cache_read_input_tokens의 합계가 요금 등급을 결정합니다. - 출력 토큰은 등급 결정에 영향을 주지 않습니다: 출력 토큰의 양은 긴 컨텍스트 요금 적용 여부를 결정하지 않지만, 일단 적용되면 출력 요금 역시 1.5배로 계산됩니다.

- 200K 미만은 여전히 표준 요금입니다: 베타 헤더를 활성화했더라도 입력이 200K를 넘지 않는다면 표준 요금으로 청구됩니다.

비용 계산 예시

시나리오: Claude Sonnet 4.6을 사용하여 50만 토큰 분량의 긴 문서를 분석하고, 2,000 토큰의 분석 보고서를 생성하는 경우.

입력 비용: 500,000 토큰 × $6/MTok = $3.00

출력 비용: 2,000 토큰 × $22.50/MTok = $0.045

총계: $3.045

동일한 출력이지만, 입력이 15만 토큰인 경우:

입력 비용: 150,000 토큰 × $3/MTok = $0.45

출력 비용: 2,000 토큰 × $15/MTok = $0.03

총계: $0.48

비용을 아끼는 4가지 전략

| 전략 | 절감 폭 | 적용 시나리오 |

|---|---|---|

| Prompt Caching | 캐시 적중 시 비용의 10%만 청구 | 동일한 긴 문서를 반복해서 사용할 때 |

| Batch API | 모든 비용 50% 할인 | 실시간 처리가 필요 없는 대량 작업 |

| Fast Mode (Opus 4.6) | 긴 컨텍스트 추가 할증 없음 | 빠른 응답이 필요한 시나리오 |

| 입력을 200K 이내로 조절 | 2배 요금 할증 방지 | 문서를 섹션별로 나누어 처리할 수 있을 때 |

💰 비용 최적화 팁: Claude 긴 컨텍스트를 빈번하게 호출해야 하는 프로젝트라면, APIYI(apiyi.com) 플랫폼을 통해 유연한 요금 플랜을 확인해 보세요. Prompt Caching과 Batch API를 결합하면 단일 호출 비용을 70% 이상 절감할 수 있습니다.

Claude API 1M 컨텍스트 윈도우 속도 제한

1M 컨텍스트를 활성화하면, 긴 컨텍스트 요청(입력 200K 토큰 초과)은 표준 요청과 별개로 독립적인 속도 제한(Rate Limit)이 적용됩니다.

Tier 4 속도 제한

| 제한 유형 | 표준 요청 제한 | 긴 컨텍스트 요청 제한 |

|---|---|---|

| 분당 최대 입력 토큰 (ITPM) | Sonnet: 2,000,000 / Opus: 2,000,000 | 1,000,000 |

| 분당 최대 출력 토큰 (OTPM) | Sonnet: 400,000 / Opus: 400,000 | 200,000 |

| 분당 최대 요청 수 (RPM) | 4,000 | 비례하여 감소 |

주요 참고 사항:

- 긴 컨텍스트 속도 제한과 표준 속도 제한은 독립적으로 계산되며 서로 영향을 주지 않습니다.

- Prompt Caching 사용 시, 캐시가 적중된 토큰은 대부분의 모델에서 ITPM 한도에 포함되지 않습니다.

- 더 높은 긴 컨텍스트 속도 제한이 필요한 경우, Anthropic 영업 팀에 문의하여 맞춤형 한도를 신청할 수 있습니다.

Tier 4로 업그레이드하는 방법

| 등급(Tier) | 누적 충전 요구액 | 1회 최대 충전액 | 월 소비 한도 |

|---|---|---|---|

| Tier 1 | $5 | $100 | $100 |

| Tier 2 | $40 | $500 | $500 |

| Tier 3 | $200 | $1,000 | $1,000 |

| Tier 4 | $400 | $5,000 | $5,000 |

누적 충전 금액 임계치에 도달하면 별도의 심사 없이 자동으로 업그레이드됩니다.

Claude API 1M 컨텍스트 윈도우 5대 실전 활용 시나리오

시나리오 1: 대규모 코드베이스 분석

전체 프로젝트 코드를 패키징하여 Claude에게 보내 아키텍처 검토, 버그 추적 또는 리팩토링 제안을 받을 수 있습니다.

import anthropic

import os

client = anthropic.Anthropic(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1"

)

def collect_codebase(directory, extensions=(".py", ".ts", ".js")):

"""프로젝트 내 지정된 모든 유형의 소스 코드 파일을 수집합니다."""

code_content = []

for root, dirs, files in os.walk(directory):

# node_modules 등의 디렉토리는 건너뜁니다.

dirs[:] = [d for d in dirs if d not in ("node_modules", ".git", "__pycache__")]

for file in files:

if file.endswith(extensions):

filepath = os.path.join(root, file)

with open(filepath, "r", encoding="utf-8") as f:

content = f.read()

code_content.append(f"### {filepath}\n```\n{content}\n```")

return "\n\n".join(code_content)

codebase = collect_codebase("./my-project")

response = client.beta.messages.create(

model="claude-opus-4-6",

max_tokens=8192,

betas=["context-1m-2025-08-07"],

messages=[{

"role": "user",

"content": f"""다음 코드베이스에 대해 포괄적인 아키텍처 검토를 수행해 주세요:

{codebase}

다음을 분석해 주세요:

1. 전체적인 아키텍처 설계의 장단점

2. 잠재적인 보안 취약점

3. 성능 최적화 제안

4. 코드 품질 개선 포인트"""

}]

)

시나리오 2: 긴 문서 종합 분석

법률 계약서, 연구 논문집, 재무 보고서와 같은 초장문 문서를 처리합니다.

response = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

messages=[{

"role": "user",

"content": f"""다음은 회사의 지난 12개월간 재무 보고서 모음입니다 (약 40만 토큰):

{financial_reports}

다음을 완료해 주세요:

1. 분기별 핵심 재무 지표 트렌드 분석

2. 수익 구조 변화 및 원인 추론

3. 비용 관리 효과 평가

4. 다음 분기 실적 예측 및 리스크 알림"""

}]

)

시나리오 3: 다회차 긴 대화와 Extended Thinking의 결합

긴 컨텍스트에서 Extended Thinking을 활성화하여 Claude가 심층적인 추론을 수행하도록 합니다.

response = client.beta.messages.create(

model="claude-opus-4-6",

max_tokens=16384,

betas=["context-1m-2025-08-07"],

thinking={

"type": "enabled",

"budget_tokens": 10000

},

messages=[{

"role": "user",

"content": f"""다음은 복잡한 시스템의 전체 기술 문서와 소스 코드입니다:

{large_technical_document}

이 시스템의 설계 철학을 심층 분석하고 개선 방안을 제시해 주세요."""

}]

)

# Extended Thinking의 토큰은 후속 대화에서 누적되지 않습니다.

# API가 이전 회차의 thinking 블록을 자동으로 제거합니다.

시나리오 4: 프롬프트 캐싱(Prompt Caching)을 활용한 비용 절감

동일한 긴 문서에 대해 여러 번 다른 측면의 분석이 필요할 때, 프롬프트 캐싱은 비용을 크게 낮춰줍니다.

# 첫 번째 요청: 긴 문서 캐싱

response1 = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

system=[{

"type": "text",

"text": large_document,

"cache_control": {"type": "ephemeral"} # 캐시 가능으로 표시

}],

messages=[{"role": "user", "content": "이 문서의 핵심 논지를 요약해 주세요."}]

)

# 두 번째 요청: 캐시 적중, 입력 토큰 비용 90% 절감 (10%만 부과)

response2 = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

system=[{

"type": "text",

"text": large_document,

"cache_control": {"type": "ephemeral"}

}],

messages=[{"role": "user", "content": "문서 내의 모든 데이터 표를 추출해 주세요."}]

)

시나리오 5: Batch API를 이용한 긴 문서 일괄 처리

Batch API를 사용하면 긴 컨텍스트 요금에서 추가로 50% 할인을 받을 수 있습니다.

# 배치 요청 생성

batch = client.beta.messages.batches.create(

betas=["context-1m-2025-08-07"],

requests=[

{

"custom_id": "doc-analysis-1",

"params": {

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [{"role": "user", "content": f"문서 1 분석: {doc1}"}]

}

},

{

"custom_id": "doc-analysis-2",

"params": {

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [{"role": "user", "content": "문서 2 분석: {doc2}"}]

}

}

]

)

🎯 실전 팁: 실제 프로젝트에서는 먼저 APIYI(apiyi.com) 플랫폼을 통해 소규모 테스트를 진행하여 토큰 사용량과 비용이 예상과 일치하는지 확인한 후 대규모로 배포하는 것을 권장합니다. 플랫폼에서 제공하는 상세 사용량 통계 패널을 통해 비용을 정밀하게 제어할 수 있습니다.

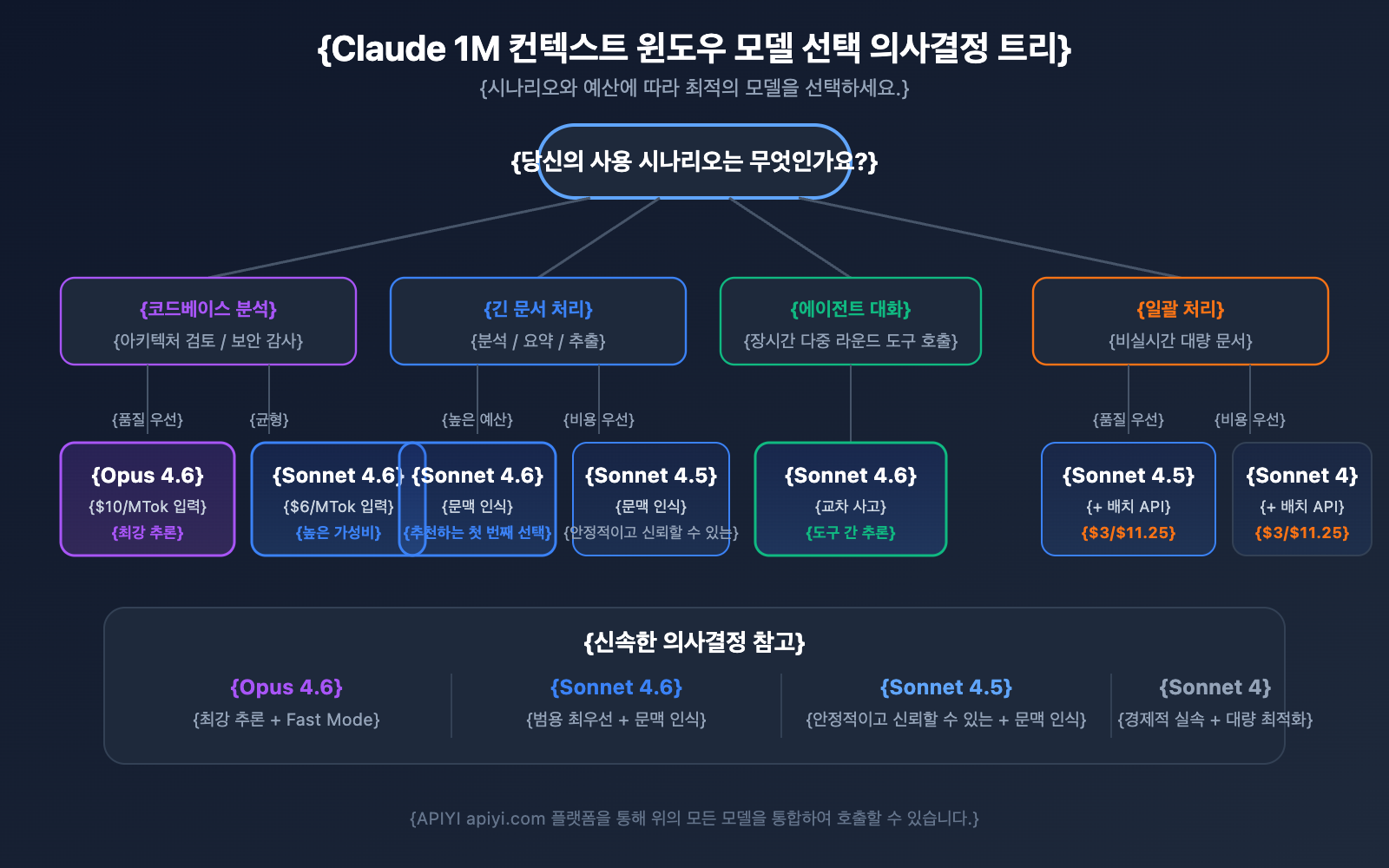

Claude API 1M 컨텍스트 윈도우 모델 선택 가이드

1M 컨텍스트를 지원하는 4가지 모델은 각각의 강점이 다르므로, 적절한 모델을 선택하면 성능과 비용 사이에서 최적의 균형을 찾을 수 있습니다.

1M 컨텍스트 지원 모델 상세 비교

| 비교 항목 | Claude Opus 4.6 | Claude Sonnet 4.6 | Claude Sonnet 4.5 | Claude Sonnet 4 |

|---|---|---|---|---|

| 지능 수준 | 최강 | 강함 | 강함 | 중상 |

| 표준 입력 가격 | $5/MTok | $3/MTok | $3/MTok | $3/MTok |

| 긴 컨텍스트 입력 가격 | $10/MTok | $6/MTok | $6/MTok | $6/MTok |

| Fast Mode | 지원 (6배 가격) | 미지원 | 미지원 | 미지원 |

| 컨텍스트 인지 | 미지원 | 지원 | 지원 | 미지원 |

| Interleaved Thinking | 지원 | 지원 | 미지원 | 지원 |

| 추천 시나리오 | 복잡한 추론, 코드 분석 | 범용 긴 문서 처리 | 다회차 에이전트 대화 | 일상적인 분석 작업 |

시나리오별 모델 선택

Claude Opus 4.6을 선택해야 하는 경우:

- 최강의 추론 능력이 필요한 복잡한 분석 작업

- 대규모 코드베이스의 아키텍처 검토 및 보안 감사

- Fast Mode(긴 컨텍스트 추가 요금 없이 빠른 응답)가 필요한 실시간 시나리오

- 예산이 충분하고 품질이 최우선인 기업용 애플리케이션

Claude Sonnet 4.6을 선택해야 하는 경우:

- 일상적인 긴 문서 분석 및 요약 추출

- 컨텍스트 인지 능력이 필요한 긴 대화

- 비용에 민감하지만 높은 품질을 요구하는 프로젝트

- 도구 호출(Tool use) 간 추론을 위해 Interleaved Thinking이 필요한 경우

Claude Sonnet 4.5 / Sonnet 4를 선택해야 하는 경우:

- 대량의 문서 일괄 처리 (Batch API와 결합하여 비용 절감)

- 구조화된 정보 추출 및 데이터 정리

- 최신 모델 기능이 굳이 필요하지 않은 안정적인 운영 환경

💡 선택 제언: 어떤 모델을 선택할지는 구체적인 애플리케이션 시나리오와 예산에 따라 달라집니다. APIYI(apiyi.com) 플랫폼을 통해 실제 테스트를 비교해 보시길 권장합니다. 이 플랫폼은 위 모든 모델에 대한 통합 인터페이스 호출을 지원하여 빠른 전환과 평가가 가능합니다.

Claude API 1M 컨텍스트 윈도우의 토큰 추정 참고

긴 컨텍스트 사용을 계획할 때, 콘텐츠 유형별 토큰 소모량을 파악하는 것이 중요합니다:

| 콘텐츠 유형 | 대략적인 토큰 수 | 1M 윈도우 수용량 |

|---|---|---|

| 영어 텍스트 | ~1 토큰 / 4자 | 약 400만 자 |

| 중국어 텍스트 | ~1 토큰 / 1.5자 | 약 150만 자 |

| Python 코드 | ~1 토큰 / 3.5자 | 약 350만 자 코드 |

| 일반 웹페이지 (10KB) | ~2,500 토큰 | 약 400개 웹페이지 |

| 대형 문서 (100KB) | ~25,000 토큰 | 약 40개 문서 |

| 연구 논문 PDF (500KB) | ~125,000 토큰 | 약 8편의 논문 |

Claude API 1M 컨텍스트 윈도우와 컨텍스트 인식

Claude Sonnet 4.6, Sonnet 4.5 그리고 Haiku 4.5는 컨텍스트 인식(Context Awareness) 능력을 갖추고 있습니다. 모델이 실시간으로 남은 컨텍스트 윈도우 용량을 추적하여, 긴 대화 속에서도 토큰 예산을 더욱 스마트하게 관리할 수 있게 되었어요.

작동 원리:

대화가 시작될 때, Claude는 전체 컨텍스트 용량 정보를 전달받습니다.

<budget:token_budget>1000000</budget:token_budget>

각 도구 호출(Tool call)이 끝난 후, 모델은 남은 용량에 대한 업데이트를 받게 됩니다.

<system_warning>Token usage: 350000/1000000; 650000 remaining</system_warning>

이러한 메커니즘 덕분에 1M 컨텍스트 윈도우 내에서 Claude는 다음과 같은 일을 할 수 있습니다.

- 정밀한 토큰 예산 관리: 대화 후반부에 갑자기 컨텍스트가 고갈되는 상황을 방지합니다.

- 합리적인 출력 길이 할당: 남은 용량에 따라 답변의 상세 수준을 조절합니다.

- 초장기 에이전트 세션 지원: 에이전트 워크플로우에서 작업이 완료될 때까지 지속적으로 임무를 수행합니다.

Claude API 1M 컨텍스트 윈도우 관리 전략: 컴팩션(Compaction)

대화 길이가 1M 컨텍스트 윈도우의 한계에 도달하면, Claude API는 대화를 지속할 수 있도록 컴팩션(Compaction, 압축) 기능을 제공합니다. 컴팩션은 서버 측 요약 메커니즘으로, 대화 초기의 내용을 핵심 요약으로 자동 압축하여 컨텍스트 공간을 확보함으로써 컨텍스트 윈도우 제한을 넘어서는 초장기 대화를 지원합니다.

현재 컴팩션 기능은 Claude Opus 4.6에서 베타 버전으로 제공되고 있습니다. 1M 컨텍스트 내에서 장시간 에이전트 작업을 실행해야 하는 개발자에게 컴팩션은 컨텍스트 관리를 위한 최우선 전략입니다.

또한, Claude API는 다음과 같은 컨텍스트 편집(Context Editing) 기능도 제공합니다.

- 도구 결과 삭제(Tool Result Clearing): 에이전트 워크플로우에서 오래된 도구 호출 결과를 삭제하여 토큰을 확보합니다.

- 사고 블록 삭제(Thinking Block Clearing): 이전 턴의 사고 과정(Thinking process) 내용을 능동적으로 삭제하여 컨텍스트 활용도를 더욱 최적화합니다.

이러한 전략들을 1M 컨텍스트 윈도우와 함께 사용하면, 초장문 컨텍스트 시나리오에서 성능과 비용의 최적의 균형을 맞출 수 있습니다.

Claude API 1M 컨텍스트 윈도우 사용 시 주의사항

실제로 1M 컨텍스트 윈도우를 사용할 때 놓치기 쉬운 몇 가지 기술적 디테일이 있습니다.

-

새 모델은 무음 자동 절단 대신 검증 오류 반환: Claude Sonnet 3.7부터는 프롬프트와 출력 토큰의 총합이 컨텍스트 윈도우를 초과할 경우, API가 내용을 몰래 자르는 대신 검증 오류(Validation Error)를 반환합니다. 요청을 보내기 전에 Token Counting API를 사용하여 토큰 수를 미리 예측해 보는 것이 좋습니다.

-

이미지 및 PDF의 토큰 소모량 유동성: 멀티모달 콘텐츠의 토큰 계산 방식은 일반 텍스트와 다릅니다. 같은 크기의 이미지라도 소모되는 토큰 양이 크게 다를 수 있으므로, 이미지를 대량으로 사용할 때는 토큰 여유분을 충분히 확보해야 합니다.

-

요청 크기 제한 (Request Size Limits): 컨텍스트 윈도우가 1M 토큰을 지원하더라도, HTTP 요청 자체에 크기 제한이 있을 수 있습니다. 초거대 텍스트를 전송할 때는 HTTP 계층의 제한 사항을 확인해야 합니다.

-

캐시 인식 속도 제한 (Cache-aware Rate Limits): 프롬프트 캐싱(Prompt Caching)을 사용할 때, 캐시 적중(Hit)된 토큰은 ITPM 속도 제한에 포함되지 않습니다. 즉, 1M 컨텍스트 시나리오에서 캐시를 적절히 활용하면 실제 처리량(Throughput)을 획기적으로 높일 수 있습니다.

자주 묻는 질문

Q1: 내 요청이 장문 컨텍스트 요금으로 청구되는지 어떻게 확인하나요?

API 응답의 usage 객체를 확인하세요. input_tokens, cache_creation_input_tokens, cache_read_input_tokens 세 필드의 합이 200,000을 초과하면 해당 요청 전체에 대해 장문 컨텍스트 가격이 적용됩니다. APIYI(apiyi.com) 플랫폼을 통해 호출할 경우, 사용량 통계 패널에서 각 요청의 요금 등급이 명확하게 표시됩니다.

Q2: 1M 컨텍스트 윈도우는 어떤 파일 형식을 지원하나요?

Claude API의 1M 컨텍스트 윈도우는 순수 텍스트, 코드, 마크다운 등 텍스트 형식뿐만 아니라 이미지와 PDF 파일도 지원합니다. 다만, 이미지와 PDF의 토큰 소모량은 일반적으로 크고 유동적이라는 점에 유의해야 합니다. 대량의 이미지와 긴 텍스트를 함께 사용할 경우 요청 크기 제한(Request Size Limits)에 걸릴 수 있으므로, APIYI(apiyi.com) 플랫폼에서 소규모 테스트를 통해 실제 토큰 소모량을 확인한 후 대규모로 사용하는 것을 권장합니다.

Q3: 확장 사고(Extended Thinking) 토큰도 1M 컨텍스트를 점유하나요?

현재 턴의 확장 사고(Extended Thinking) 토큰은 컨텍스트 윈도우에 포함됩니다. 하지만 Claude API는 이전 턴의 사고 블록(Thinking blocks)을 자동으로 분리하여 제거하므로, 이후 대화에서 누적되지 않습니다. 따라서 사고 과정이 방대한 컨텍스트 공간을 잡아먹을 걱정 없이 1M 컨텍스트 내에서 안전하게 확장 사고 기능을 사용할 수 있습니다.

Q4: Tier 4 조건을 충족하지 못하면 어떻게 하나요?

현재 1M 컨텍스트 윈도우는 Tier 4 및 사용자 정의 속도 제한이 설정된 조직에만 개방되어 있습니다. Tier 4는 누적 충전 금액이 $400에 도달하면 자동으로 업그레이드됩니다. 당장 Tier 4 도달이 어렵다면 다음과 같은 방법을 고려해 보세요. ① 입력을 200K 이내로 분할 처리하기, ② RAG(Retrieval-Augmented Generation) 방식을 사용하여 핵심 내용만 추출하기, ③ Anthropic 영업 팀에 문의하여 맞춤형 플랜 알아보기.

Q5: AWS Bedrock이나 Google Vertex AI에서는 어떻게 활성화하나요?

1M 컨텍스트 윈도우는 AWS Bedrock, Google Vertex AI, Microsoft Foundry에서도 모두 사용할 수 있습니다. 플랫폼마다 활성화 방식이 조금씩 다른데, Bedrock은 InvokeModel 요청 시 특정 파라미터를 지정하고, Vertex AI는 API 설정을 통해 가능합니다. 자세한 설정 방법은 각 플랫폼의 공식 문서를 참고해 주세요.

Claude API 1M 컨텍스트 창 베스트 프랙티스 체크리스트

실제 프로젝트에 1M 컨텍스트 창을 통합할 때, 다음의 베스트 프랙티스를 따르는 것이 좋습니다.

개발 단계

- Token Counting API로 먼저 예측하기: 실제 요청을 보내기 전에 Token Counting API를 사용하여 입력 토큰 수를 추정해 보세요. 이를 통해 긴 컨텍스트 요금이 예기치 않게 발생하는 것을 방지할 수 있습니다.

- 합리적인 max_tokens 설정:

max_tokens파라미터는 속도 제한 계산에 영향을 주지 않으므로(OTPM은 실제 출력량 기준), 출력이 중간에 잘리지 않도록 충분히 높은 값을 설정해도 괜찮습니다. - 단계별 테스트: 먼저 소규모 데이터로 프롬프트 템플릿의 효과를 검증한 후, 점진적으로 입력 규모를 늘려가며 테스트하세요.

운영 환경

- 프롬프트 캐싱(Prompt Caching) 우선 활용: 반복해서 사용하는 긴 문서의 경우, 프롬프트 캐싱을 활용하면 캐시 적중 부분의 입력 비용을 표준가의 10% 수준으로 낮출 수 있습니다. 또한 캐시된 토큰은 ITPM 속도 제한에 포함되지 않습니다.

- 비실시간 작업은 Batch API 사용: Batch API는 긴 컨텍스트 요금에서 추가로 50% 할인을 제공합니다. 두 혜택을 결합하면 비용을 표준가의 약 60% 수준까지 절감할 수 있습니다.

- usage 필드 모니터링: 매 요청 후 응답에 포함된

usage객체를 확인하고, 비용 모니터링 및 알림 메커니즘을 구축하세요. - 429 오류 재시도: 긴 컨텍스트 요청에는 독립적인 속도 제한이 적용됩니다. 429 오류가 발생하면

retry-after헤더를 확인하여 적절한 간격을 두고 재시도하세요.

비용 제어

- 200K 임계값 관리: 입력량이 200K 토큰에 근접한다면, 프롬프트를 간소화하여 요금이 2배로 뛰는 것을 방지하는 것이 현명합니다.

- 적절한 모델 선택: Sonnet 시리즈는 Opus보다 40% 저렴합니다. 일상적인 작업에는 Sonnet을 우선적으로 선택하세요.

- 캐싱을 통한 속도 제한 압박 완화: 캐시 적중률이 80%일 경우, 실제 처리량(Throughput)을 명목상 한도의 5배까지 높일 수 있습니다.

Claude API 1M 컨텍스트 창 요약

Claude API의 1M 컨텍스트 창을 통해 개발자는 이제 한 번에 약 75만 자의 방대한 내용을 처리할 수 있게 되었습니다. 이는 코드베이스 분석, 긴 문서 처리, 복잡한 대화 시나리오 등에서 강력한 힘을 발휘합니다. 핵심 요점을 다시 한번 확인해 보세요.

- 코드 한 줄로 시작:

anthropic-beta: context-1m-2025-08-07헤더만 추가하면 바로 사용할 수 있습니다. - 4종의 모델 지원: Claude Opus 4.6, Sonnet 4.6, Sonnet 4.5, Sonnet 4를 지원합니다.

- 투명한 요금 체계: 200K 토큰 초과 시 입력 비용 2배, 출력 비용 1.5배가 적용되며, 200K 미만은 기존 표준가와 동일합니다.

- 독립적인 속도 제한: 긴 컨텍스트 요청은 표준 요청 한도에 영향을 주지 않고 별도로 관리됩니다.

- 다양한 최적화 수단: 프롬프트 캐싱, Batch API, Fast Mode를 조합하여 비용을 효과적으로 낮출 수 있습니다.

지금 바로 APIYI(apiyi.com)를 통해 Claude 1M 컨텍스트 창의 강력한 기능을 체험해 보고, 여러분의 비즈니스 시나리오에 딱 맞는 최적의 활용 방안을 찾아보세요!

참고 자료

-

Anthropic 공식 문서 – Context Windows: Claude API 컨텍스트 창 기술 설명

- 링크:

platform.claude.com/docs/en/build-with-claude/context-windows

- 링크:

-

Anthropic 공식 문서 – Pricing: Claude API 전체 가격 정책 안내

- 링크:

platform.claude.com/docs/en/about-claude/pricing

- 링크:

-

Anthropic 공식 문서 – Rate Limits: 속도 제한 및 Usage Tier 안내

- 링크:

platform.claude.com/docs/en/api/rate-limits

- 링크:

📝 작성자: APIYI Team | 더 많은 AI 모델 API 사용 튜토리얼은 APIYI apiyi.com 도움말 센터를 방문해 주세요.