OpenClaw는 2026년 초 가장 핫한 오픈 소스 AI 어시스턴트 프로젝트로, GitHub 스타 수가 이미 10만 개를 넘어섰습니다. 하지만 많은 개발자가 Claude 모델을 설정할 때 ValidationException: invalid beta flag라는 당혹스러운 오류를 겪고 있죠.

이번 포스팅에서는 OpenClaw Claude API의 invalid beta flag 오류가 발생하는 근본적인 원인을 심층 분석하고, 검증된 5가지 해결 방법을 통해 여러분의 AI 어시스턴트가 다시 정상적으로 작동할 수 있도록 도와드릴게요.

OpenClaw invalid beta flag 오류 현상 분석

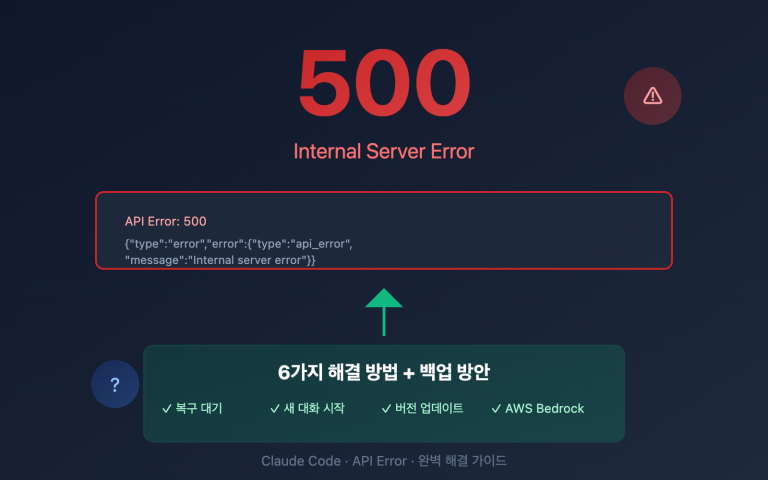

OpenClaw에서 AWS Bedrock이나 Google Vertex AI를 Claude 모델 제공자로 설정할 때 다음과 같은 오류 메시지가 나타날 수 있습니다.

{

"type": "error",

"error": {

"type": "invalid_request_error",

"message": "invalid beta flag"

}

}

OpenClaw Claude API 오류의 전형적인 사례

| 오류 시나리오 | 오류 메시지 | 영향 범위 |

|---|---|---|

| AWS Bedrock 호출 | ValidationException: invalid beta flag |

모든 Claude 모델 요청 실패 |

| Vertex AI 호출 | 400 Bad Request: invalid beta flag |

Claude Sonnet/Opus 사용 불가 |

| LiteLLM 프록시 | {"message":"invalid beta flag"} |

프록시 전달 전체 실패 |

| 1M 컨텍스트 변체 | bedrock:anthropic.claude-sonnet-4-20250514-v1:0:1m 실패 |

긴 컨텍스트 시나리오 사용 불가 |

OpenClaw 오류의 직접적인 영향

이 OpenClaw Claude invalid beta flag 오류는 다음과 같은 문제를 일으킵니다.

- AI 어시스턴트가 완전히 응답하지 않음 – OpenClaw가 Claude 관련 작업을 전혀 수행할 수 없게 됩니다.

- 메시지 플랫폼에 빈 화면 표시 – WhatsApp, Telegram 등 연결된 플랫폼에서 "(no output)"을 반환합니다.

- 대체 모델도 실패 – Vertex AI를 폴백(fallback)으로 설정해 두었더라도 동일한 오류가 발생합니다.

- 사용자 경험 저하 – 오류를 해결하기 위해 빈번한 수동 개입이 필요해집니다.

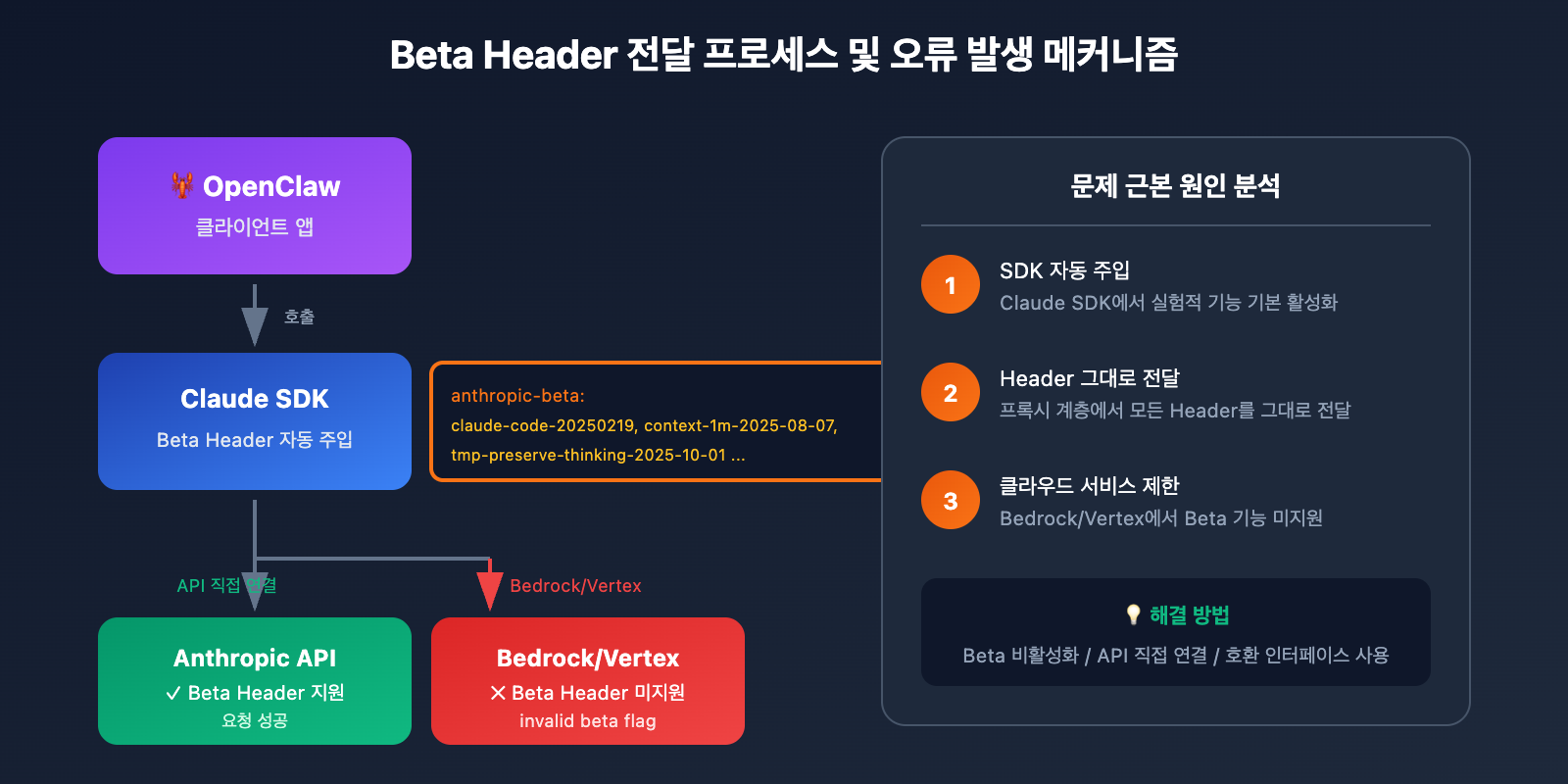

OpenClaw invalid beta flag 오류의 근본 원인

Claude API Beta Header 메커니즘

Anthropic Claude API는 anthropic-beta 요청 헤더를 통해 실험적 기능을 활성화할 수 있어요. 이러한 Beta 기능에는 다음과 같은 것들이 포함됩니다:

| Beta 식별자 | 기능 설명 | 지원 플랫폼 |

|---|---|---|

computer-use-2024-10-22 |

컴퓨터 사용 능력 | Anthropic 직접 연결 |

token-counting-2024-11-01 |

토큰 카운팅 API | Anthropic 직접 연결 |

context-1m-2025-08-07 |

1M 컨텍스트 윈도우 | Anthropic 직접 연결 |

tmp-preserve-thinking-2025-10-01 |

사고 과정 보존 | Anthropic 직접 연결 전용 |

interleaved-thinking-2025-05-14 |

교차 사고 모드 | Anthropic 직접 연결 전용 |

OpenClaw가 Beta Header를 보내는 이유

OpenClaw의 하위 의존성 라이브러리(Claude SDK, LiteLLM 등)는 요청을 보낼 때 자동으로 Beta Header를 추가해요:

anthropic-beta: claude-code-20250219,context-1m-2025-08-07,interleaved-thinking-2025-05-14,fine-grained-tool-streaming-2025-05-14,tmp-preserve-thinking-2025-10-01

AWS Bedrock 및 Vertex AI의 제한 사항

이것이 바로 OpenClaw에서 invalid beta flag 오류가 발생하는 근본적인 원인이에요.

AWS Bedrock과 Google Vertex AI는 매니지드 서비스이기 때문에, Anthropic의 Beta 기능을 지원하지 않습니다. 이러한 Beta Header가 클라우드 서비스로 전달되면, 서버 측에서는 요청을 즉시 거부하고 invalid beta flag 오류를 반환하게 됩니다.

🎯 핵심 문제: SDK에서 자동으로 주입한 Beta Header가 Bedrock/Vertex AI와 호환되지 않지만, SDK가 대상 엔드포인트에 맞춰 이 헤더들을 자동으로 필터링하지 않기 때문입니다.

OpenClaw invalid beta flag 오류를 해결하는 5가지 방법

방법 1: OpenClaw 모델 설정 수정하기 (추천)

가장 간단한 방법은 OpenClaw 설정에서 beta 기능을 명시적으로 비활성화하는 거예요.

~/.openclaw/openclaw.json 파일을 다음과 같이 수정해 보세요:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"options": {

"beta_features": []

}

}

}

}

}

OpenClaw 설정 설명:

| 설정 항목 | 역할 | 추천 값 |

|---|---|---|

beta_features |

활성화할 beta 기능 제어 | [] (빈 배열) |

extra_headers |

사용자 정의 요청 헤더 | beta 관련 설정 안 함 |

disable_streaming |

스트리밍 비활성화 | false |

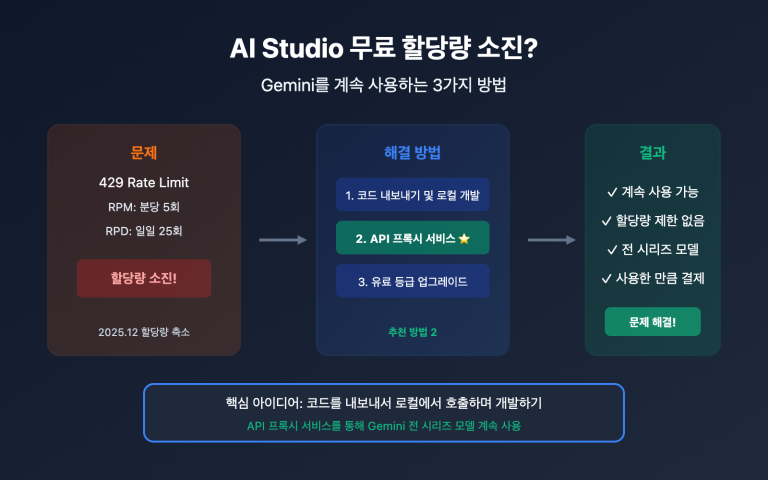

방법 2: Anthropic API 직접 연결 사용하기 (가장 안정적)

OpenClaw invalid beta flag 오류를 피하는 가장 확실한 방법은 Bedrock이나 Vertex AI를 거치지 않고 Anthropic 공식 API를 직접 사용하는 거예요.

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4"

}

}

}

}

환경 변수를 설정해 주세요:

export ANTHROPIC_API_KEY="your-anthropic-api-key"

🚀 빠른 시작: Anthropic API 키가 없다면 APIYI(apiyi.com)를 통해 테스트 크레딧을 빠르게 확보할 수 있어요. 이 플랫폼은 OpenAI 호환 인터페이스를 제공하며 Claude 전 시리즈 모델 호출을 지원합니다.

방법 3: LiteLLM에서 Beta Header 필터링 설정하기

OpenClaw의 모델 프록시로 LiteLLM을 사용하고 있다면, 헤더 필터링을 설정할 수 있어요:

# litellm_config.py

import litellm

# Bedrock으로 beta 헤더를 보내지 않도록 설정

litellm.drop_params = True

litellm.modify_params = True

# 또는 config.yaml에서 설정

# model_list:

# - model_name: claude-sonnet

# litellm_params:

# model: bedrock/anthropic.claude-3-sonnet

# drop_params: true

방법 4: 프롬프트 캐싱(Prompt Caching) 비활성화 (임시 해결책)

어떤 경우에는 OpenClaw invalid beta flag 오류가 프롬프트 캐싱 기능과 관련이 있을 수 있어요. 캐시를 비활성화하면 문제가 해결될 수도 있습니다:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"cache": {

"enabled": false

}

}

}

}

}

방법 5: 호환되는 모델 제공업체로 전환하기

클라우드 호스팅 서비스를 반드시 사용해야 하지만 OpenClaw invalid beta flag 오류를 해결하고 싶다면, OpenAI 호환 프록시 서비스를 사용하는 것도 좋은 방법이에요:

{

"models": {

"providers": [

{

"name": "apiyi",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "your-api-key",

"models": ["claude-sonnet-4", "claude-opus-4-5"]

}

]

}

}

💡 선택 가이드: OpenAI 호환 인터페이스를 사용하면 beta 헤더 문제를 완전히 피할 수 있고, OpenClaw와의 호환성도 훌륭하게 유지됩니다. APIYI(apiyi.com)는 Claude, GPT, Gemini 등 다양한 모델을 지원하는 통합 인터페이스를 제공해요.

OpenClaw 모델 설정 베스트 프랙티스

전체 설정 예시

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "openai/gpt-4o",

"options": {

"temperature": 0.7,

"max_tokens": 4096

}

},

"sandbox": {

"mode": "non-main"

}

}

},

"models": {

"providers": [

{

"name": "apiyi-claude",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"models": ["claude-sonnet-4", "claude-opus-4-5", "claude-haiku"]

}

]

}

}

OpenClaw 모델 선택 가이드

| 활용 사례 | 추천 모델 | 제공자 선택 |

|---|---|---|

| 일상적인 대화 | Claude Haiku | Anthropic 직접 연결 / APIYI |

| 코드 생성 | Claude Sonnet 4 | Anthropic 직접 연결 / APIYI |

| 복잡한 추론 | Claude Opus 4.5 | Anthropic 직접 연결 / APIYI |

| 비용 효율성 중시 | GPT-4o-mini | OpenAI / APIYI |

| 로컬 배포 | Llama 3.3 | Ollama |

OpenClaw invalid beta flag 오류 해결 프로세스

<circle cx="30" cy="60" r="8" fill="url(#blueGrad4)" />

<text x="30" y="64" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">1</text>

<text x="45" y="64" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">설정 수정하여 Beta 비활성화</text>

<circle cx="30" cy="85" r="8" fill="url(#blueGrad4)" />

<text x="30" y="89" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">2</text>

<text x="45" y="89" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Anthropic 직접 연결로 전환</text>

<circle cx="30" cy="110" r="8" fill="url(#blueGrad4)" />

<text x="30" y="114" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">3</text>

<text x="45" y="114" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">OpenAI 호환 인터페이스 사용</text>

<circle cx="30" cy="135" r="8" fill="url(#greenGrad4)" />

<text x="30" y="139" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">★</text>

<text x="45" y="139" font-family="Arial, sans-serif" font-size="10" fill="#10b981">APIYI(apiyi.com) 추천</text>

<text x="25" y="60" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• API 키가 유효한가요?</text>

<text x="25" y="80" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• 네트워크 연결이 정상인가요?</text>

<text x="25" y="100" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• 모델 이름이 정확한가요?</text>

<text x="25" y="120" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• Rate Limit에 걸렸나요?</text>

문제 해결 단계

1단계: 오류 발생 원인 확인

# OpenClaw 로그 확인

tail -f ~/.openclaw/logs/openclaw.log | grep -i "beta"

2단계: 현재 설정 확인

# 모델 설정 확인

cat ~/.openclaw/openclaw.json | jq '.agents.defaults.model'

3단계: API 연결 테스트

# curl을 사용한 테스트 (beta header 제외)

curl -X POST https://api.anthropic.com/v1/messages \

-H "Content-Type: application/json" \

-H "x-api-key: $ANTHROPIC_API_KEY" \

-H "anthropic-version: 2023-06-01" \

-d '{

"model": "claude-sonnet-4-20250514",

"max_tokens": 100,

"messages": [{"role": "user", "content": "Hello"}]

}'

4단계: 복구 결과 검증

# OpenClaw 서비스 재시작

openclaw restart

# 테스트 메시지 전송

openclaw chat "테스트 메시지"

자주 발생하는 문제 해결 결과

| 분석 결과 | 원인 분석 | 해결 방법 |

|---|---|---|

| 직접 연결 API는 성공, Bedrock은 실패 | Beta header 호환되지 않음 | 방법 1 또는 방법 2 사용 |

| 모든 요청 실패 | API 키 문제 또는 네트워크 문제 | 자격 증명 및 네트워크 확인 |

| 간헐적 실패 | Rate limit(속도 제한)일 가능성 | 호출 빈도 확인 |

| 특정 모델 실패 | 모델 ID 오류 또는 사용 불가 | 모델 이름이 정확한지 확인 |

OpenClaw Claude 호출 코드 예시

Python 직접 호출 예시 (invalid beta flag 방지)

import anthropic

# 클라이언트 생성 - 베타 기능을 활성화하지 않음

client = anthropic.Anthropic(

api_key="your-api-key",

base_url="https://api.apiyi.com/v1" # APIYI 통합 인터페이스 사용

)

# 메시지 전송 - 베타 파라미터 미사용

message = client.messages.create(

model="claude-sonnet-4-20250514",

max_tokens=1024,

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(message.content[0].text)

OpenAI SDK 호환 호출

from openai import OpenAI

# OpenAI 호환 인터페이스를 사용하여 베타 헤더 문제를 완전히 방지

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # APIYI 통합 인터페이스

)

response = client.chat.completions.create(

model="claude-sonnet-4",

messages=[

{"role": "user", "content": "Hello!"}

]

)

print(response.choices[0].message.content)

🎯 기술 제안: OpenAI 호환 인터페이스를 사용하는 것이 OpenClaw의 invalid beta flag 오류를 피하는 가장 간결한 방법이에요. APIYI(apiyi.com)에서 제공하는 통합 인터페이스는 Claude뿐만 아니라 GPT, Gemini 등 주요 모델을 모두 지원해서 여러 모델 간의 전환 테스트가 매우 편리하답니다.

OpenClaw와 각 클라우드 서비스 제공업체 간의 호환성

클라우드 서비스 베타 기능 지원 매트릭스

| 기능 | Anthropic 직접 연결 | AWS Bedrock | Vertex AI | APIYI |

|---|---|---|---|---|

| 기본 Messages API | ✅ | ✅ | ✅ | ✅ |

| Computer Use | ✅ | ❌ | ❌ | ✅ |

| Token Counting | ✅ | ❌ | ❌ | ✅ |

| Extended Thinking | ✅ | ❌ | ❌ | ✅ |

| 1M Context | ✅ | 부분 지원 | 부분 지원 | ✅ |

| 프롬프트 캐싱 | ✅ | ✅ | ✅ | ✅ |

왜 API 중계 서비스를 선택해야 할까요?

OpenClaw 사용자에게 API 중계 서비스를 사용하는 것은 다음과 같은 장점이 있어요:

- 더 나은 호환성 – 헤더 변환을 자동으로 처리하여 invalid beta flag 오류를 방지해요.

- 비용 최적화 – 일반적으로 공식 API를 직접 호출하는 것보다 더 경제적이에요.

- 편리한 전환 – 통합 인터페이스를 통해 다양한 모델 간의 전환이 쉬워요.

- 높은 안정성 – 멀티 노드 부하 분산(로드 밸런싱)을 통해 단일 장애 지점(SPOF)을 방지해요.

OpenClaw invalid beta flag 자주 묻는 질문(FAQ)

Q1: 왜 Bedrock을 사용할 때만 invalid beta flag 오류가 발생하나요?

AWS Bedrock은 Amazon의 관리형 서비스로, Claude 모델에 대한 액세스를 제공하지만 Anthropic의 베타 실험 기능은 지원하지 않아요. OpenClaw나 그 의존성 라이브러리가 자동으로 베타 헤더(beta header)를 추가하면, Bedrock은 이 요청을 거부하게 됩니다.

해결 방법: Anthropic 직접 연결 API를 사용하거나 베타 헤더를 필터링하도록 설정하세요. 국내에서 빠르게 테스트가 필요하다면, APIYI(apiyi.com)를 통해 무료 크레딧을 받아 검증해 볼 수 있습니다.

Q2: 설정을 수정했는데도 계속 오류가 나면 어떻게 하나요?

설정 캐시가 남아있거나 서비스가 제대로 재시작되지 않았을 수 있어요. 다음 단계를 따라해 보세요.

- OpenClaw 완전히 중지:

openclaw stop - 캐시 삭제:

rm -rf ~/.openclaw/cache/* - 다시 시작:

openclaw start

Q3: Bedrock과 직접 연결 API를 동시에 사용할 수 있나요?

네, 가능합니다. Anthropic 직접 연결을 기본 제공자(모든 기능 지원)로 설정하고, Bedrock을 예비용(베타 기능 미사용)으로 설정하는 것을 추천해요.

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "bedrock/anthropic.claude-3-sonnet"

}

}

}

}

Q4: OpenClaw는 어떤 모델 제공자를 지원하나요?

OpenClaw는 다음을 포함하여 12가지 이상의 모델 제공자를 지원합니다.

- 공식 직접 연결: Anthropic, OpenAI, Google Gemini, Mistral

- 클라우드 호스팅: AWS Bedrock, Google Vertex AI

- 프록시 서비스: OpenRouter, APIYI

- 로컬 배포: Ollama, LM Studio

💰 비용 최적화: 예산이 민감한 개인 개발자라면 APIYI(apiyi.com)를 통해 Claude API를 호출하는 것을 추천드려요. 이 플랫폼은 실제 사용량에 따라 비용을 지불하는 유연한 요금제를 제공하며, 월정액 부담이 없습니다.

Q5: invalid beta flag 오류가 모든 Claude 모델에 영향을 주나요?

네, 이 오류는 Bedrock이나 Vertex AI를 통해 호출되는 Claude Haiku, Sonnet, Opus 전 시리즈를 포함한 모든 Claude 모델에 영향을 미칩니다.

요약

OpenClaw Claude API의 invalid beta flag 오류가 발생하는 핵심 원인은 SDK가 자동으로 추가하는 베타 헤더가 AWS Bedrock / Vertex AI와 호환되지 않기 때문이에요. 본문에서 소개한 5가지 방법을 통해 이 문제를 효과적으로 해결할 수 있습니다.

- OpenClaw 설정 수정 – 베타 기능 비활성화

- Anthropic 직접 연결 사용 – 모든 기능과 완전 호환

- LiteLLM 필터링 설정 – 프록시 계층에서 해결

- Prompt Caching 비활성화 – 임시 우회 방안

- 호환 가능한 제공자로 교체 – OpenAI 호환 인터페이스 사용

대부분의 OpenClaw 사용자에게는 Anthropic 직접 연결 API를 사용하거나, OpenAI와 호환되는 프록시 서비스를 사용하여 이 문제를 근본적으로 피하는 것을 권장합니다. Claude 전 시리즈 모델을 지원하고 통일된 OpenAI 호환 인터페이스를 제공하는 APIYI(apiyi.com)에서 빠르게 효과를 확인해 보세요.

참고 자료

-

GitHub – OpenClaw 공식 저장소: 프로젝트 소스 코드 및 문서

- 링크:

github.com/openclaw/openclaw

- 링크:

-

GitHub – LiteLLM invalid beta flag Issue: 커뮤니티 문제 토론

- 링크:

github.com/BerriAI/litellm/issues/14043

- 링크:

-

GitHub – Cline invalid beta flag Issue: 관련 오류 보고

- 링크:

github.com/cline/cline/issues/5568

- 링크:

-

Anthropic Beta Headers 문서: 공식 베타 기능 설명

- 링크:

docs.anthropic.com/en/api/beta-headers

- 링크:

-

OpenClaw 공식 문서: 모델 설정 가이드

- 링크:

docs.openclaw.ai/concepts/model-providers

- 링크:

📝 작성자: APIYI 기술 팀

더 많은 AI 모델 API 호출 팁이 궁금하시다면, APIYI(apiyi.com)를 방문하여 기술 지원을 받아보세요.