저자 주: Nano Banana Pro가 seed 파라미터를 지원하지 않는 기술적 이유를 심층 분석하고, 만족스러운 생성 결과를 얻었을 때 이를 일괄적으로 복제할 수 있는 실질적인 대체 방안을 소개합니다.

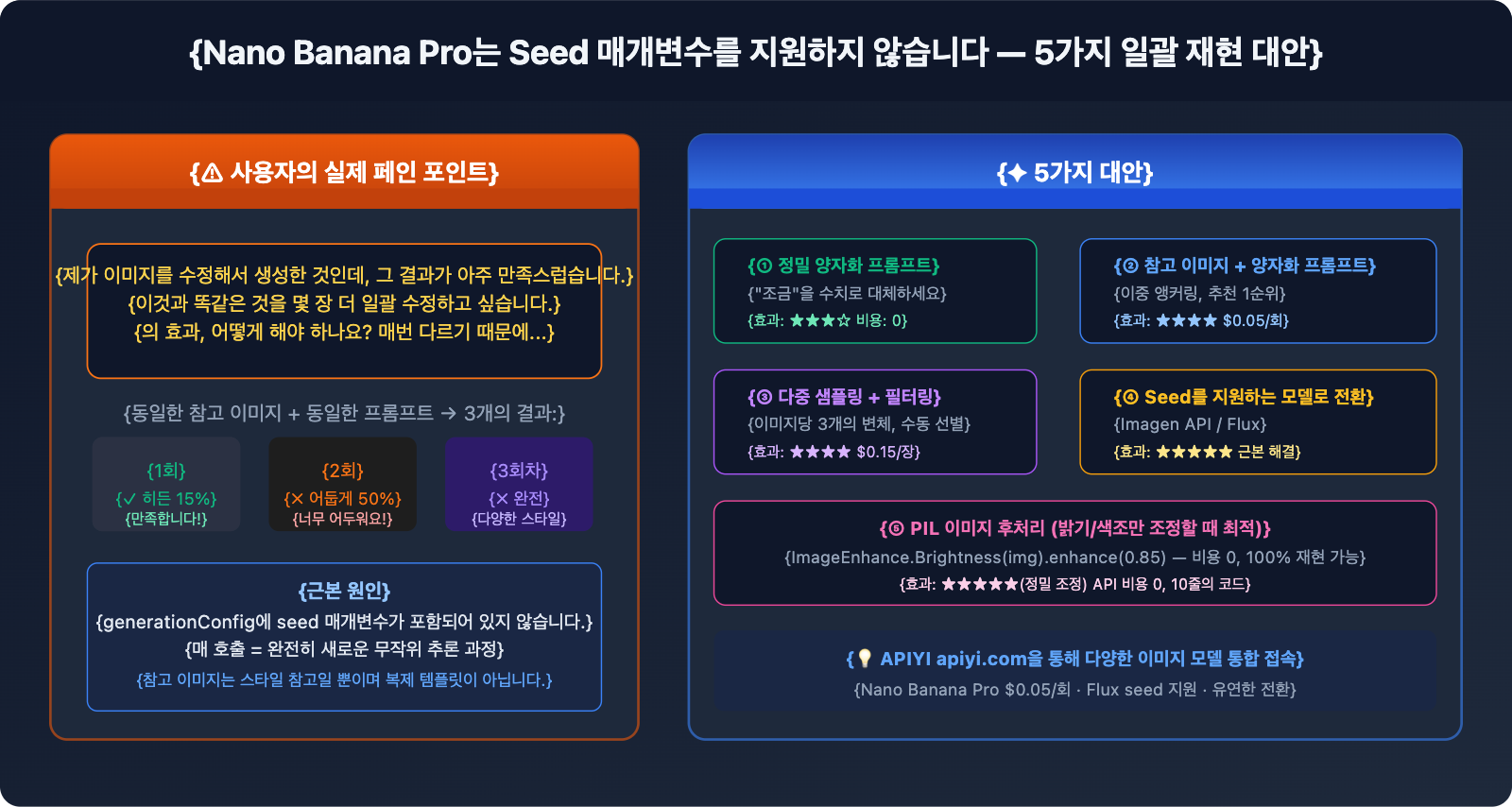

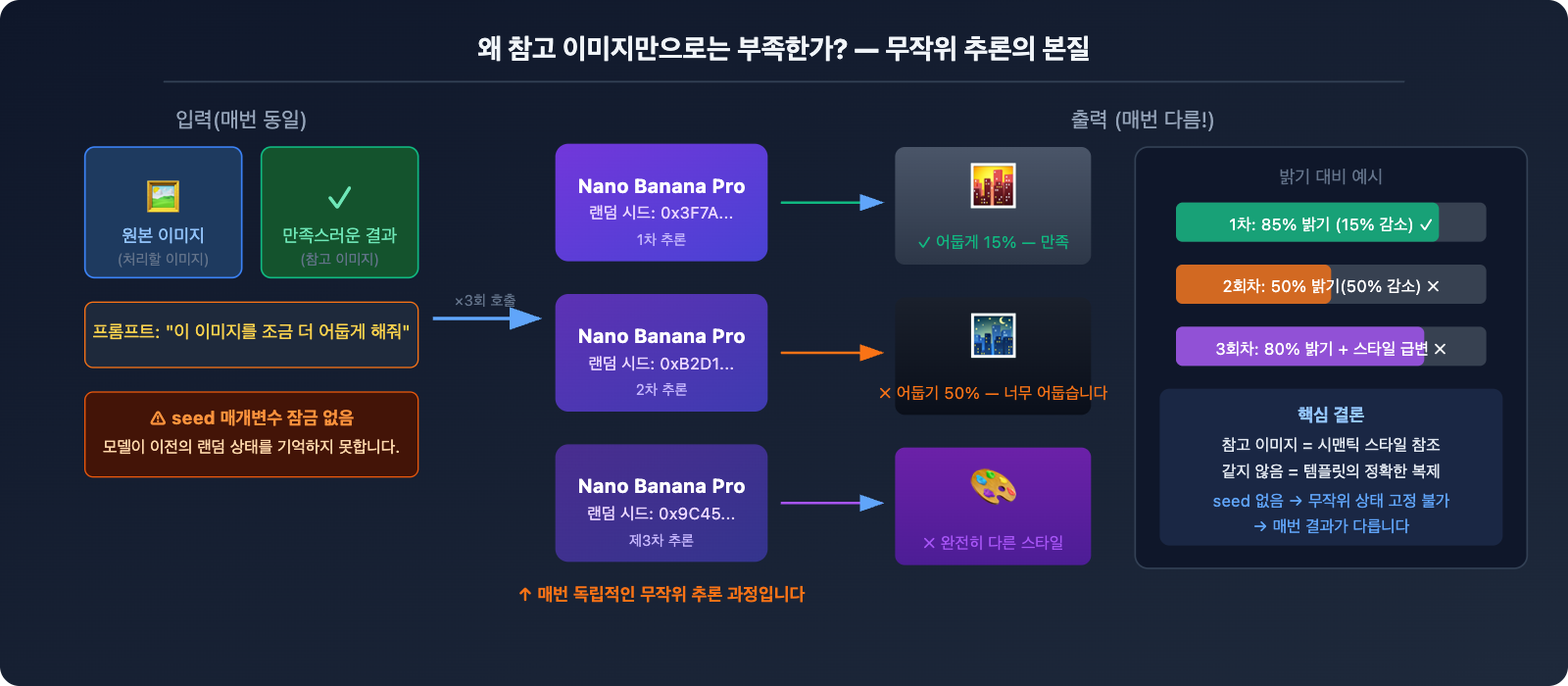

실제 사용자 피드백: "이미지 수정으로 생성한 결과가 정말 맘에 드는데, 이 효과 그대로 여러 장을 한꺼번에 만들 수는 없을까요? 매번 생성할 때마다 결과가 달라져서 고민이에요." 이는 Nano Banana Pro로 일괄 이미지 생성(Img2Img) 작업을 할 때 겪는 전형적인 고충입니다. 만족스러운 이미지를 참조 이미지로 넣어도 결과가 일치하지 않는 이유는 간단합니다. Nano Banana Pro 공식 버전이 seed 파라미터를 지원하지 않기 때문입니다. 매번 생성이 완전히 새로운 랜덤 추론 과정을 거치게 되는 것이죠.

핵심 가치: 이 글에서는 군더더기 없이 왜 seed 파라미터가 없는지, 그리고 왜 참조 이미지만으로는 부족한지 먼저 설명해 드립니다. 이어서 seed 없이도 만족스러운 효과를 최대한 복제할 수 있는 5가지 실질적인 대체 방안을 제시해 드릴게요.

먼저 확실히 알아봅시다: Nano Banana Pro에는 왜 Seed가 없을까요?

공식 파라미터 일람

Nano Banana Pro(gemini-3-pro-image-preview)의 generationConfig는 다음 파라미터들을 지원합니다:

| 파라미터명 | 역할 | 예시 값 |

|---|---|---|

responseModalities |

출력 타입 지정 | ["IMAGE"] |

resolution |

이미지 해상도 | "1K" / "2K" / "4K" |

aspectRatio |

가로세로비 | "16:9" / "1:1" / "2:3" |

candidateCount |

동시 생성 후보 수 | 1 (이미지 생성은 1로 고정) |

temperature |

텍스트 부분의 무작위성 (이미지에 영향 없음) | 1.0 (기본값 권장) |

seed 파라미터: 목록에 없으며, 공식적으로 지원하지 않습니다.

코드에서 seed를 전달하려고 하면 즉시 오류가 발생합니다:

# ❌ 오류 발생: Unknown field 'seed' in GenerationConfig

response = model.generate_content(

prompt,

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

seed=42 # ← 오류! 공식적으로 지원하지 않는 파라미터입니다.

)

)

Gemini Image API vs Imagen API: 서로 다른 두 가지 서비스

많은 분이 Google 공식 문서에서 seed 파라미터를 찾아내곤 하시는데요, 그것은 Imagen API(Vertex AI에서 제공하는 이미지 생성 서비스)에 해당하며 Nano Banana Pro와는 다릅니다.

| 비교 항목 | Nano Banana Pro | Imagen API (Vertex AI) |

|---|---|---|

| 모델 ID | gemini-3-pro-image-preview |

imagen-3.0-generate-002 |

| Seed 지원 여부 | ❌ 지원 안 함 | ✅ 지원 (seed 파라미터) |

| API 엔드포인트 | Google Generative AI | Vertex AI |

| 호출 SDK | google-generativeai |

google-cloud-aiplatform |

| 이미지 품질 | 최상급 실사 품질, 뛰어난 텍스트 렌더링 | 고품질, 다양한 스타일 |

| 가격 (APIYI) | 장당 $0.05 | 별도 가격 책정 |

결론: 만약 반드시 seed를 통한 재현성이 필요하다면 Nano Banana Pro에서 존재하지 않는 파라미터와 씨름하지 말고 Imagen API로 전환해야 합니다. APIYI 등 제3자 중계 플랫폼은 Imagen API를 지원하지 않으며, 이 API는 공식 홈페이지의 KEY로만 사용할 수 있습니다.

왜 참고 이미지로도 부족할까요?

만족스러운 생성 결과를 참고 이미지로 다시 입력하는 것이 가장 직관적인 방법처럼 보이지만, 실제 효과는 '그저 그런' 편입니다. 근본적인 이유는 다음과 같습니다.

Nano Banana Pro는 참고 이미지를 '복제용 템플릿'이 아닌 '스타일 참고'로 이해하기 때문입니다. 참고 이미지를 업로드하고 "이 이미지를 조금 더 어둡게 해줘"라고 명령하면 모델은 다음과 같이 작동합니다:

- 참고 이미지의 전체적인 스타일, 구성, 내용을 분석합니다.

- "조금 더 어둡게"라는 명령을 새로 이해합니다.

- 명령에 부합하는 새로운 이미지를 처음부터 다시 생성합니다.

이 과정에는 매번 무작위성이 개입됩니다. 그래서 "조금 더 어둡게"라는 명령이 첫 번째에는 운 좋게 만족스러운 15% 정도의 밝기 감소로 나타날 수 있지만, 두 번째에는 50%나 어두워질 수 있고, 세 번째에는 완전히 다른 스타일이 될 수도 있습니다.

5가지 대안: 가장 직접적인 방법부터 근본적인 해결책까지

방안 1: 프롬프트의 정밀한 수치화 (가장 즉각적인 효과)

문제 상황: "이미지를 조금만 더 어둡게 해줘" → 결과가 때로는 너무 어둡고, 때로는 너무 밝게 나옴

근본적인 원인은 "조금만"이라는 표현이 너무 모호하기 때문입니다. Nano Banana Pro는 "조금만"이라는 단어에 대해 매번 동일한 이해도를 보장할 수 없습니다. 해결 방법은 모호한 묘사 대신 수치를 사용하는 것입니다.

❌ 모호한 프롬프트:

"Make this image slightly darker"

"이미지를 조금만 더 어둡게 해줘"

✅ 수치화된 프롬프트:

"Apply a subtle darkening effect equivalent to reducing brightness by

approximately 15-20%. The image should feel slightly moodier but all

details must remain clearly visible. Do NOT go dark. The result should

be close to: brightness 85% of original, contrast unchanged."

자주 쓰이는 조정을 위한 수치화 작성법:

밝기 조정:

"brightness at 85% of original" (15% 감소)

"increase brightness by 10%, keep contrast" (밝기 10% 증가)

색조 조정:

"add a very subtle warm orange tint, color shift about 10%"

"slight cool blue cast, saturation unchanged"

스타일 강도:

"apply film grain texture at 20% opacity, barely noticeable"

"add very subtle vignette at corners, 15% strength"

💡 핵심 팁: 프롬프트에 "approximately X%", "not exceeding Y%", "subtle/barely noticeable"과 같은 정도를 한정하는 단어를 사용하세요. 모델에게 변화의 폭과 경계를 명확히 알려주는 것이 중요합니다.

방안 2: 만족스러운 결과 + 정밀 프롬프트 조합 (가장 추천하는 방법)

단순히 참고 이미지만 업로드하는 것은 효과가 불안정할 수 있지만, 참고 이미지 + 수치화된 프롬프트를 조합하면 효과가 훨씬 좋아집니다.

import google.generativeai as genai

import base64

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # APIYI $0.05/회

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

def apply_consistent_effect(

source_image_path: str, # 처리할 새 이미지

approved_result_path: str, # 처음 만족했던 결과물 (스타일 참고용)

effect_description: str, # 정밀하게 수치화된 효과 설명

output_path: str

) -> str:

"""

만족스러운 효과를 새 이미지에 복제

참고 이미지 + 정밀 수치화 프롬프트의 이중 고정(Anchoring) 사용

"""

# 두 이미지 읽기

with open(source_image_path, "rb") as f:

source_data = base64.b64encode(f.read()).decode()

with open(approved_result_path, "rb") as f:

approved_data = base64.b64encode(f.read()).decode()

prompt = f"""

I have two reference images:

- Image 1 (source): The new image I want to process

- Image 2 (approved result): A previous edit I was very happy with

Please apply the SAME effect from Image 2 to Image 1.

The effect is: {effect_description}

Critical instructions:

- The degree of change should match Image 2 EXACTLY

- Do not over-apply the effect

- Keep all other image properties unchanged

- If unsure about intensity, err on the side of LESS change

"""

response = model.generate_content(

[

{"inline_data": {"mime_type": "image/jpeg", "data": source_data}},

{"inline_data": {"mime_type": "image/jpeg", "data": approved_data}},

prompt

],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K",

aspect_ratio="1:1"

)

)

for part in response.candidates[0].content.parts:

if part.inline_data and part.inline_data.mime_type.startswith("image/"):

with open(output_path, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output_path

return None

# 사용 예시

result = apply_consistent_effect(

source_image_path="new_product_photo.jpg",

approved_result_path="approved_dark_edit.jpg",

effect_description="subtle darkening, brightness reduced by approximately 15-20%, "

"image should be slightly moodier but all details clearly visible",

output_path="output_consistent.png"

)

# 회당 $0.05 (APIYI apiyi.com)

🚀 실전 권장사항: 이 방법은 일관성을 "완전 랜덤"에서 "높은 확률로 예상 범위 내"로 끌어올려 주지만, 여전히 100%는 아닙니다. 한 번에 2~3개의 변체(Variant)를 동시에 생성하고(현재

candidateCount는 오류가 날 수 있으므로 여러 번 호출 권장), 사람이 가장 근접한 것을 고르는 방식을 추천합니다. APIYI의 회당 $0.05라는 저렴한 비용 덕분에 여러 번 샘플링하는 것이 부담스럽지 않습니다.

방안 3: 다중 샘플링 + 배치 필터링 (대량 작업에 적합)

현재 상황에서 가장 현실적인 방안은 각 이미지마다 3~5개의 변체를 생성하고, 사람이나 프로그램이 가장 적절한 것을 골라내는 것입니다.

import asyncio

import base64

import os

import google.generativeai as genai

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # APIYI $0.05/회

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

EFFECT_PROMPT = """

Apply subtle darkening effect:

- Brightness: approximately 85% of original (reduce by ~15%)

- Mood: slightly darker, more atmospheric

- Details: all elements must remain clearly visible

- Do NOT: make it too dark, change colors dramatically, lose details

This is a subtle, refined adjustment - less is more.

"""

async def generate_variants(image_path: str, n_variants: int = 3) -> list:

"""동일한 이미지에 대해 n개의 변체를 생성하여 필터링에 제공"""

with open(image_path, "rb") as f:

img_data = base64.b64encode(f.read()).decode()

async def one_call(i: int) -> str:

output = image_path.replace(".jpg", f"_v{i+1}.png")

loop = asyncio.get_event_loop()

try:

response = await loop.run_in_executor(None, lambda: model.generate_content(

[{"inline_data": {"mime_type": "image/jpeg", "data": img_data}},

EFFECT_PROMPT],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K"

)

))

for part in response.candidates[0].content.parts:

if part.inline_data:

with open(output, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output

except Exception as e:

print(f" 변체 {i+1} 실패: {e}")

return None

# 여러 변체를 병렬로 생성

results = await asyncio.gather(*[one_call(i) for i in range(n_variants)])

return [r for r in results if r]

async def batch_process(image_list: list, n_variants: int = 3):

"""여러 이미지를 배치 처리하며, 각 이미지당 여러 변체 생성"""

for img_path in image_list:

print(f"\n처리 중: {img_path}")

variants = await generate_variants(img_path, n_variants)

cost = len(variants) * 0.05

print(f" {len(variants)}개 변체 생성 완료, 비용 ${cost:.2f} (APIYI)")

print(f" 파일: {variants}")

print(f" → 가장 만족스러운 변체를 직접 선택해 주세요.")

# 예시: 5장의 이미지를 처리하며, 각 이미지당 3개의 변체 생성

images = ["photo_01.jpg", "photo_02.jpg", "photo_03.jpg", "photo_04.jpg", "photo_05.jpg"]

asyncio.run(batch_process(images, n_variants=3))

# 5장 × 3개 변체 = 총 15회 호출, APIYI 총 비용 $0.75

비용 추산:

| 규모 | 변체 수 | 총 호출 횟수 | APIYI 비용 |

|---|---|---|---|

| 10장 | 장당 3개 | 30회 | $1.50 |

| 50장 | 장당 3개 | 150회 | $7.50 |

| 100장 | 장당 2개 | 200회 | $10.00 |

방안 4: Seed를 지원하는 모델로 전환 (근본적인 해결)

업무상 정밀한 재현성이 반드시 필요하다면, 가장 확실한 방법은 Seed를 기본적으로 지원하는 모델로 바꾸는 것입니다.

Imagen API (Vertex AI) — Google 계열이면서 Seed를 지원합니다.

from google.cloud import aiplatform

from vertexai.preview.vision_models import ImageGenerationModel

# Imagen API는 seed 파라미터를 지원합니다.

model = ImageGenerationModel.from_pretrained("imagen-3.0-generate-002")

response = model.generate_images(

prompt="your prompt here",

seed=42, # ✅ 공식 지원!

number_of_images=1,

add_watermark=False # seed 사용 시 워터마크를 꺼야 할 수도 있습니다.

)

# 동일한 seed + 동일한 프롬프트 → 동일한 결과 (높은 재현성)

Stable Diffusion / Flux — 완벽한 Seed 생태계를 갖추고 있습니다.

# APIYI(apiyi.com)를 통해 Flux에 접속, seed 지원

import requests

response = requests.post(

"https://vip.apiyi.com/v1/images/generations",

headers={"Authorization": "Bearer YOUR_APIYI_KEY"},

json={

"model": "flux-dev", # 또는 flux-schnell

"prompt": "your prompt",

"seed": 12345, # ✅ 완벽한 seed 지원

"width": 1024,

"height": 1024

}

)

# seed 고정 → 배치 생성 시 완전히 일관된 기본 이미지 획득

방안 5: 이미지 후처리 도구 활용 (정밀도 최고, 가장 안정적)

만약 요구사항이 이미지에 고정된 밝기/색조 조정을 일괄 적용하는 것(예: 전체적으로 15% 어둡게 하기)이라면, 사실 AI 생성은 최선의 선택이 아닙니다. **이미지 후처리(Post-processing)**가 정답입니다.

from PIL import Image, ImageEnhance

import os

def batch_darken(input_dir: str, output_dir: str, brightness_factor: float = 0.85):

"""

정밀한 배치 밝기 조정

brightness_factor: 0.85 = 15% 감소, 100% 재현 가능, 랜덤성 제로

"""

os.makedirs(output_dir, exist_ok=True)

files = [f for f in os.listdir(input_dir) if f.lower().endswith(('.jpg', '.png', '.webp'))]

for filename in files:

img = Image.open(os.path.join(input_dir, filename))

enhancer = ImageEnhance.Brightness(img)

# 밝기를 정밀하게 제어, 매번 결과가 완벽히 일치함

darkened = enhancer.enhance(brightness_factor)

darkened.save(os.path.join(output_dir, filename))

print(f"✓ {filename} → 밝기 {brightness_factor*100:.0f}% 적용 완료")

# 배치 처리 실행, API 비용 0원, 100% 재현 가능

batch_darken("input_images/", "darkened_output/", brightness_factor=0.85)

적용 시나리오 비교:

| 조정 유형 | 추천 도구 | 이유 |

|---|---|---|

| 일괄 밝기/대비/채도 조정 | PIL / Photoshop 배치 처리 | 정밀함, 재현 가능, 비용 제로 |

| 일괄 색조 필터 (따뜻하게/차갑게) | PIL / LUT 필터 | 100% 일관성 |

| 복잡한 스타일 전이 (배경/피사체 교체) | Nano Banana Pro | AI의 진정한 가치가 발휘되는 영역 |

| 정밀 재현이 필요하면서 창의적 변화 포함 | Imagen API (Seed 포함) | 품질과 일관성의 균형 |

🎯 솔직한 조언: 단순히 이미지를 "15% 어둡게" 만들고 싶은 것이라면 PIL의

ImageEnhance.Brightness를 사용하세요. 비용도 들지 않고, 100% 일관되며, 코드 한 줄이면 끝납니다. AI 이미지 생성의 가치는 정밀한 파라미터 조정이 아니라, 복잡한 콘텐츠 이해와 창의적인 생성에 있습니다.

주요 AI 이미지 모델 Seed 지원 비교

| 모델 | Seed 지원 여부 | 재현 안정성 | 비고 |

|---|---|---|---|

| Nano Banana Pro | ❌ 지원 안 함 | 낮음, 매번 랜덤 생성 | 참고 이미지 + 프롬프트로 일부 개선 가능 |

| Imagen API | ✅ 공식 지원 | 높음 | 동일 Seed, 동일 프롬프트로 재현 가능 |

| Stable Diffusion | ✅ 전체 지원 | 매우 높음 | 오픈 소스 생태계, 자체 구축 또는 클라우드 |

| Flux Dev/Pro | ✅ 지원 | 높음 | 실사 느낌 강함, API 연동 가능 |

| Midjourney | ✅ --seed 파라미터 |

중간 (참고 수준) | 동일 Seed 시 스타일은 비슷하나 완전히 일치하지 않음 |

| DALL-E 3 | ❌ 지원 안 함 | 낮음 | Nano Banana Pro와 유사한 한계 |

💡 플랫폼 제안: APIYI(apiyi.com)를 통해 Nano Banana Pro, Flux, Stable Diffusion 등 여러 이미지 모델을 통합하여 사용할 수 있어요. 하나의 API Key로 여러 모델을 전환하며 사용할 수 있어, Seed 지원 여부에 따라 유연하게 모델을 선택하기 좋습니다.

자주 묻는 질문(FAQ)

Q1: Nano Banana Pro에서 ‘seed’ 효과를 “크랙(해킹)”할 수 있는 방법이 있나요?

엄밀히 말하면 진정한 의미의 크랙 방법은 없습니다. 일부 서드파티 플랫폼(예: fal.ai)은 자체 API 래퍼 계층에 seed 파라미터를 추가하기도 하지만, 이는 해당 플랫폼 계층의 무작위성을 제어할 뿐 Google 순정 Gemini 이미지 생성의 seed와는 다릅니다. 실제로 최종 이미지의 재현성에 미치는 영향은 매우 제한적입니다.

'seed 효과'에 가장 가까운 조합은 정밀하게 수치화된 프롬프트 + 만족스러운 결과물을 참조 이미지로 활용 + 여러 번 샘플링 후 선별하는 것입니다. 이 세 가지를 결합하면 일관성을 완전 무작위 상태에서 약 60~70% 확률까지 끌어올릴 수 있지만, 결코 100%가 될 수는 없습니다.

만약 워크플로우에서 재현성이 필수적이라면 Imagen API로 전환하는 것을 추천하며, APIYI(apiyi.com)를 통해 여러 서비스를 동시에 연결하여 비교 테스트해 볼 수 있습니다.

Q2: “약간 어둡게” 만드는 효과를 대량으로 재현하고 싶은데, 가장 빠른 방법은 무엇인가요?

'어둡게' 하려는 성격에 따라 다릅니다:

- 단순히 밝기/노출 조정인 경우: Python PIL의

ImageEnhance.Brightness(img).enhance(0.85)를 사용하여 배치 처리하세요. 코드 10줄이면 충분하고 비용도 제로이며 100% 일관성을 보장합니다. - 스타일, 분위기, AI 콘텐츠 생성과 관련된 경우(예: "어두운 톤이면서 배경에 시네마틱한 질감을 더하고 싶을 때"): 두 번째 방안(참조 이미지 + 수치화된 프롬프트)을 사용하세요. APIYI(apiyi.com)를 통해 대량으로 호출하면 장당 $0.05의 저렴한 비용으로 2~3개의 변체를 생성한 후 가장 적절한 것을 수동으로 선택할 수 있습니다.

Q3: Nano Banana Pro가 나중에 seed 파라미터를 지원하게 될까요?

현재 공식적인 발표는 없습니다. Google의 제품 로드맵을 보면, Imagen API는 정밀하고 제어 가능한 이미지 생성(seed 포함)을 위한 서비스인 반면, Gemini 이미지 생성은 '고품질 창의적 생성'에 더 치중하고 있습니다. 두 서비스의 포지셔닝이 다르기 때문에 향후 Nano Banana Pro에 seed가 추가될 가능성은 있지만 확신할 수는 없습니다.

Google AI 공식 블로그(blog.google/technology/google-deepmind)와 Gemini API 변경 로그(ai.google.dev/gemini-api/docs/changelog)를 통해 최신 동향을 확인하실 수 있습니다. 업데이트가 있다면 저희도 APIYI(apiyi.com)에 관련 가이드를 가장 빠르게 게시하겠습니다.

요약

Nano Banana Pro가 seed 파라미터를 지원하지 않는다는 사실을 직시하고, 상황에 맞춰 다음 5가지 대안을 선택해 보세요.

- 정밀하게 수치화된 프롬프트: "조금만" 같은 모호한 표현 대신 수치를 사용하면 즉각적인 효과를 볼 수 있습니다.

- 참조 이미지 + 수치화된 프롬프트: 두 장의 이미지(원본 + 만족스러운 결과)를 입력하여 재현하고자 하는 효과의 정도를 정밀하게 묘사합니다.

- 여러 번 샘플링 후 선별: 이미지당 2~3개의 변체를 생성합니다. APIYI는 회당 $0.05로 비용 부담이 적으므로, 여러 개를 만들어 가장 가까운 것을 고르는 전략이 유효합니다.

- Imagen API / Flux로 전환: 비즈니스상 재현성이 필수 조건이라면 seed를 기본적으로 지원하는 모델로 교체합니다.

- PIL 후처리: 단순히 밝기나 색조를 고정적으로 조정하는 것이라면 AI는 최적의 도구가 아닙니다. PIL을 사용하는 것이 훨씬 정확합니다.

모든 상황에 통하는 만능 열쇠는 없습니다. 현재 상황에 가장 적합한 방안을 선택하세요. APIYI(apiyi.com) 플랫폼에서는 회당 $0.05라는 저렴한 비용 덕분에 '여러 번 시도 후 선별'하는 전략이 충분히 경제적입니다. 이는 공식 홈페이지 가격($0.24/회)보다 5배나 저렴한 수준입니다.

참고 자료

-

Google Gemini API 이미지 생성 파라미터 문서

- 링크:

ai.google.dev/gemini-api/docs/image-generation - 설명: generationConfig 공식 지원 파라미터 목록으로, seed 필드가 없음을 확인할 수 있습니다.

- 링크:

-

Vertex AI Imagen API 문서 (seed 지원 포함)

- 링크:

cloud.google.com/vertex-ai/generative-ai/docs/image/generate-images - 설명: Imagen API의 seed 파라미터 사용 방법 및 제한 사항에 대한 설명입니다.

- 링크:

-

Gemini Python SDK GitHub Issue #536

- 링크:

github.com/google-gemini/deprecated-generative-ai-python/issues/536 - 설명: Gemini 이미지 생성에서 seed 파라미터가 지원되지 않음을 확인하는 커뮤니티 논의 내용입니다.

- 링크:

-

APIYI 플랫폼 멀티 모델 연동

- 링크:

docs.apiyi.com - 설명: Nano Banana Pro / Imagen / Flux 통합 연동 가이드입니다.

- 링크:

작성자: 기술 팀

기술 교류: 비슷한 대량 생성 일관성 문제를 겪고 계신가요? 댓글창에서 함께 이야기 나눠봐요. 더 많은 AI 이미지 생성 실전 노하우는 APIYI(apiyi.com) 기술 커뮤니티에서 확인하실 수 있습니다.