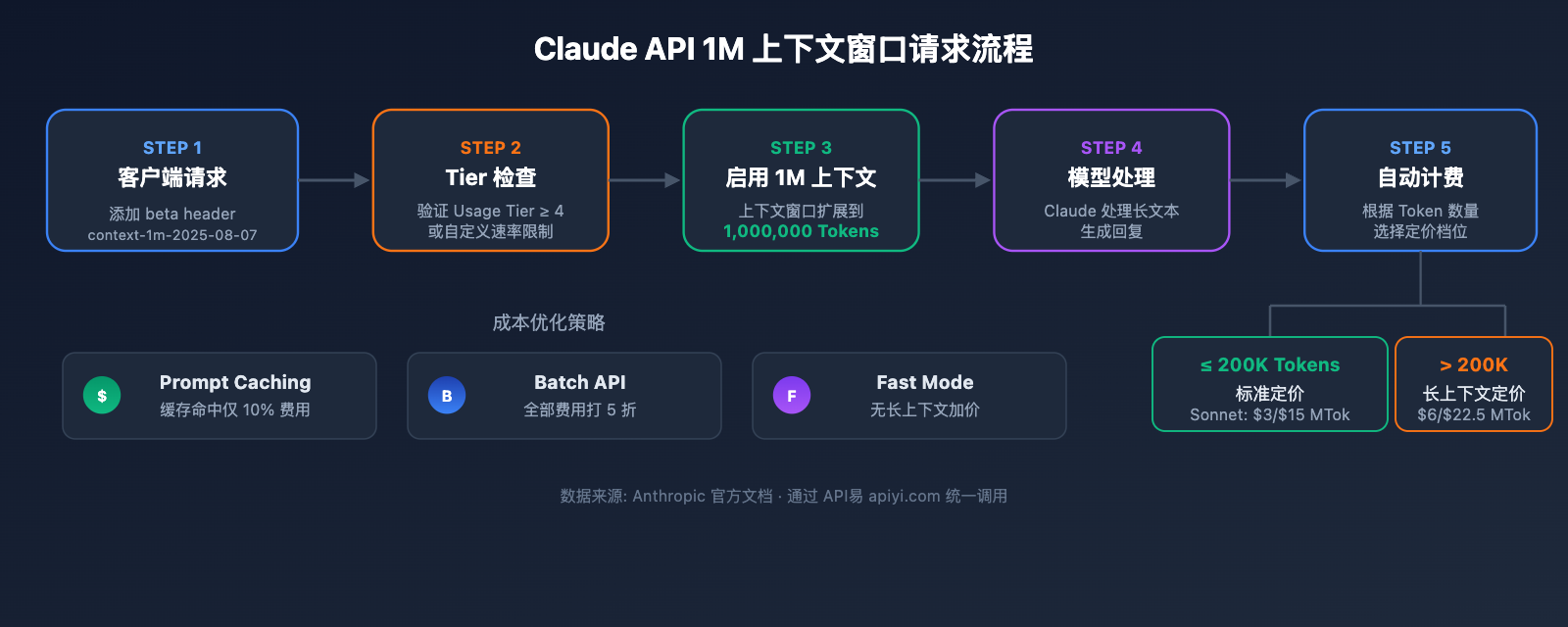

如何在 API 调用中使用超过 20 万 Token 的超长上下文,是越来越多开发者面临的真实需求。Anthropic 推出了 Claude API 100 万 Token 上下文窗口(1M Context Window)功能,让单次请求可以处理约 75 万字的文本内容——相当于一次性读完整部《红楼梦》加《三国演义》。

核心价值: 读完本文,你将掌握 Claude API 1M 上下文窗口的完整开启方法,了解定价计算规则,并获得 5 种实战场景的代码模板。

Claude API 1M 上下文窗口核心要点

在深入配置细节之前,先了解这个功能的关键信息。

| 要点 | 说明 | 价值 |

|---|---|---|

| Beta 功能 | 通过 context-1m-2025-08-07 header 开启 |

无需额外申请,添加 header 即可 |

| 支持模型 | Opus 4.6、Sonnet 4.6、Sonnet 4.5、Sonnet 4 | 覆盖主力模型系列 |

| 使用门槛 | 需要 Usage Tier 4 或自定义速率限制 | 累计充值 $400 即可达到 Tier 4 |

| 定价规则 | 超过 200K Token 后自动切换长上下文定价 | 输入 2 倍、输出 1.5 倍标准价格 |

| 多平台支持 | Claude API、AWS Bedrock、Google Vertex AI、Microsoft Foundry | 跨平台统一体验 |

Claude API 1M 上下文窗口的工作原理

Claude API 的标准上下文窗口为 200K Token。当你通过 beta header 开启 1M 上下文窗口后,模型可以在单次请求中处理最多 100 万个 Token 的输入内容。

需要特别注意的是,上下文窗口包含了所有内容:

- 输入 Token: 系统提示词、对话历史、当前用户消息

- 输出 Token: 模型生成的回复内容

- 思考 Token: 如果启用了 Extended Thinking,思考过程也会计入

🎯 技术建议: Claude API 的 1M 上下文窗口特别适合处理大规模代码库分析、长文档理解等场景。我们建议通过 API易 apiyi.com 平台快速验证长上下文方案,该平台支持 Claude 全系列模型的统一接口调用。

Claude API 1M 上下文窗口快速上手

开启前提条件

在使用 1M 上下文窗口之前,确认你满足以下条件:

| 条件 | 要求 | 检查方式 |

|---|---|---|

| Usage Tier | Tier 4 或自定义速率限制 | 登录 Claude Console → Settings → Limits |

| 累计充值 | ≥ $400(达到 Tier 4 门槛) | 查看账户充值记录 |

| 模型选择 | Opus 4.6 / Sonnet 4.6 / Sonnet 4.5 / Sonnet 4 | 其他模型不支持 1M 上下文 |

| API 版本 | anthropic-version: 2023-06-01 |

请求 header 中指定 |

极简示例

只需在标准 API 请求中添加一行 beta header,即可解锁 1M 上下文窗口:

import anthropic

client = anthropic.Anthropic(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 统一接口

)

response = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

messages=[

{"role": "user", "content": "请分析以下长文档的核心论点..."}

],

betas=["context-1m-2025-08-07"],

)

print(response.content[0].text)

使用 cURL 的等效调用:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [

{"role": "user", "content": "分析这份长文档..."}

]

}'

关键代码说明:

betas=["context-1m-2025-08-07"]: Python SDK 的写法,自动添加anthropic-betaheaderanthropic-beta: context-1m-2025-08-07: cURL / HTTP 请求的 header 写法- 当输入 Token 不超过 200K 时,即使添加了 beta header,也按标准价格计费

查看 TypeScript 完整代码

import Anthropic from "@anthropic-ai/sdk";

import * as fs from "fs";

const anthropic = new Anthropic({

apiKey: "YOUR_API_KEY",

baseURL: "https://api.apiyi.com/v1" // 使用 API易 统一接口

});

async function analyzeLongDocument(filePath: string) {

// 读取大文件

const document = fs.readFileSync(filePath, "utf-8");

const response = await anthropic.beta.messages.create({

model: "claude-opus-4-6",

max_tokens: 8192,

messages: [

{

role: "user",

content: `请对以下文档进行全面分析,包括:

1. 核心论点摘要

2. 关键数据提取

3. 逻辑结构评估

4. 改进建议

文档内容:

${document}`

}

],

betas: ["context-1m-2025-08-07"]

});

console.log(response.content[0].text);

// 检查 Token 使用情况

console.log("Input tokens:", response.usage.input_tokens);

console.log("Output tokens:", response.usage.output_tokens);

}

analyzeLongDocument("./large-report.txt");

🚀 快速开始: 推荐使用 API易 apiyi.com 平台快速测试 Claude 1M 上下文窗口。该平台提供 OpenAI 兼容接口,无需复杂配置,支持 Claude 全系列模型。

Claude API 1M 上下文窗口定价详解

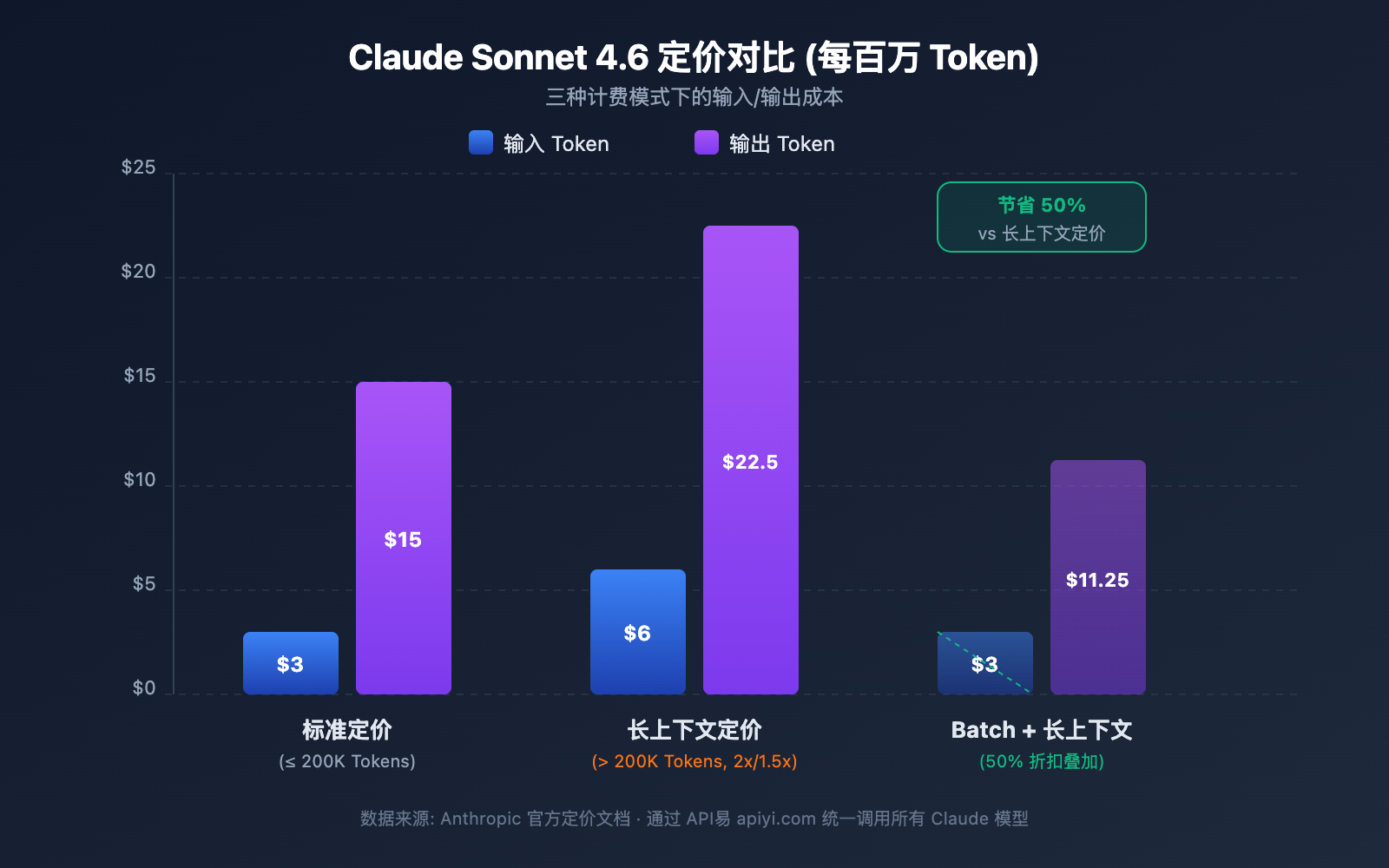

长上下文的定价是开发者最关心的问题之一。Claude API 采用了分段计费策略——输入 Token 是否超过 200K 决定了你的计费档位。

各模型长上下文定价对比

| 模型 | 标准输入 (≤200K) | 长上下文输入 (>200K) | 标准输出 | 长上下文输出 | 倍率 |

|---|---|---|---|---|---|

| Claude Opus 4.6 | $5/MTok | $10/MTok | $25/MTok | $37.50/MTok | 输入 2x / 输出 1.5x |

| Claude Sonnet 4.6 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 输入 2x / 输出 1.5x |

| Claude Sonnet 4.5 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 输入 2x / 输出 1.5x |

| Claude Sonnet 4 | $3/MTok | $6/MTok | $15/MTok | $22.50/MTok | 输入 2x / 输出 1.5x |

MTok = 百万 Token

定价计算规则

理解几个关键规则,避免费用超预期:

- 200K 阈值是开关: 一旦输入 Token 总量超过 200K,整个请求的所有 Token 都按长上下文价格计费,而不是只对超出部分加价

- 输入 Token 总量包含缓存:

input_tokens+cache_creation_input_tokens+cache_read_input_tokens的总和决定定价档位 - 输出 Token 不影响档位: 输出 Token 数量不影响是否触发长上下文定价,但一旦触发,输出也按 1.5 倍计费

- 低于 200K 仍按标准价: 即使你开启了 beta header,只要输入不超过 200K,就按标准价计费

费用实例计算

场景: 使用 Claude Sonnet 4.6 分析一份 50 万 Token 的长文档,生成 2000 Token 的分析报告。

输入费用: 500,000 Token × $6/MTok = $3.00

输出费用: 2,000 Token × $22.50/MTok = $0.045

总计: $3.045

同样的输出,如果输入只有 15 万 Token:

输入费用: 150,000 Token × $3/MTok = $0.45

输出费用: 2,000 Token × $15/MTok = $0.03

总计: $0.48

4 种省钱策略

| 策略 | 节省幅度 | 适用场景 |

|---|---|---|

| Prompt Caching | 缓存命中仅收 10% 费用 | 重复使用相同长文档 |

| Batch API | 所有费用打 5 折 | 非实时批量处理任务 |

| Fast Mode (Opus 4.6) | 无额外长上下文加价 | 需要快速响应的场景 |

| 控制输入在 200K 以内 | 避免 2x 定价 | 可以分段处理的文档 |

💰 成本优化: 对于需要频繁调用 Claude 长上下文的项目,可以通过 API易 apiyi.com 平台获取灵活的计费方案。结合 Prompt Caching 和 Batch API,单次调用成本可降低 70% 以上。

Claude API 1M 上下文窗口速率限制

开启 1M 上下文后,长上下文请求(输入超过 200K Token)有独立的速率限制,与标准请求的限额分开计算。

Tier 4 速率限制

| 限制类型 | 标准请求限制 | 长上下文请求限制 |

|---|---|---|

| 最大输入 Token/分钟 (ITPM) | Sonnet: 2,000,000 / Opus: 2,000,000 | 1,000,000 |

| 最大输出 Token/分钟 (OTPM) | Sonnet: 400,000 / Opus: 400,000 | 200,000 |

| 最大请求数/分钟 (RPM) | 4,000 | 按比例降低 |

重要说明:

- 长上下文速率限制与标准速率限制独立计算,互不影响

- 使用 Prompt Caching 时,缓存命中的 Token 不计入 ITPM 限额(大多数模型)

- 如果需要更高的长上下文速率限制,可以联系 Anthropic 销售团队申请自定义限额

如何升级到 Tier 4

| Tier | 累计充值要求 | 单次最大充值 | 月消费上限 |

|---|---|---|---|

| Tier 1 | $5 | $100 | $100 |

| Tier 2 | $40 | $500 | $500 |

| Tier 3 | $200 | $1,000 | $1,000 |

| Tier 4 | $400 | $5,000 | $5,000 |

达到累计充值门槛后会自动升级,无需人工审核。

Claude API 1M 上下文窗口 5 大实战场景

场景 1: 大型代码库分析

将整个项目代码打包发送给 Claude,进行架构审查、Bug 排查或重构建议。

import anthropic

import os

client = anthropic.Anthropic(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1"

)

def collect_codebase(directory, extensions=(".py", ".ts", ".js")):

"""收集项目中所有指定类型的源代码文件"""

code_content = []

for root, dirs, files in os.walk(directory):

# 跳过 node_modules 等目录

dirs[:] = [d for d in dirs if d not in ("node_modules", ".git", "__pycache__")]

for file in files:

if file.endswith(extensions):

filepath = os.path.join(root, file)

with open(filepath, "r", encoding="utf-8") as f:

content = f.read()

code_content.append(f"### {filepath}\n```\n{content}\n```")

return "\n\n".join(code_content)

codebase = collect_codebase("./my-project")

response = client.beta.messages.create(

model="claude-opus-4-6",

max_tokens=8192,

betas=["context-1m-2025-08-07"],

messages=[{

"role": "user",

"content": f"""请对以下代码库进行全面架构审查:

{codebase}

请分析:

1. 整体架构设计的优缺点

2. 潜在的安全漏洞

3. 性能优化建议

4. 代码质量改进点"""

}]

)

场景 2: 长文档综合分析

处理法律合同、研究论文集、财报等超长文档。

response = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

messages=[{

"role": "user",

"content": f"""以下是公司过去 12 个月的财务报告合集(约 40 万 Token):

{financial_reports}

请完成:

1. 各季度核心财务指标趋势分析

2. 收入结构变化及原因推断

3. 成本控制效果评估

4. 下季度业绩预测及风险提示"""

}]

)

场景 3: 多轮长对话与 Extended Thinking 结合

在长上下文中开启 Extended Thinking,让 Claude 进行深度推理:

response = client.beta.messages.create(

model="claude-opus-4-6",

max_tokens=16384,

betas=["context-1m-2025-08-07"],

thinking={

"type": "enabled",

"budget_tokens": 10000

},

messages=[{

"role": "user",

"content": f"""以下是一个复杂系统的完整技术文档和源代码:

{large_technical_document}

请深度分析这个系统的设计哲学,并给出改进方案。"""

}]

)

# Extended Thinking 的 token 不会在后续对话中累积

# API 会自动剥离之前轮次的 thinking blocks

场景 4: 使用 Prompt Caching 降低长上下文成本

当你需要对同一份长文档进行多次不同维度的分析时,Prompt Caching 可以大幅降低成本:

# 第一次请求: 缓存长文档

response1 = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

system=[{

"type": "text",

"text": large_document,

"cache_control": {"type": "ephemeral"} # 标记为可缓存

}],

messages=[{"role": "user", "content": "总结这份文档的核心论点"}]

)

# 第二次请求: 缓存命中,输入 Token 仅收 10% 费用

response2 = client.beta.messages.create(

model="claude-sonnet-4-6",

max_tokens=4096,

betas=["context-1m-2025-08-07"],

system=[{

"type": "text",

"text": large_document,

"cache_control": {"type": "ephemeral"}

}],

messages=[{"role": "user", "content": "提取文档中的所有数据表格"}]

)

场景 5: Batch API 批量处理长文档

使用 Batch API 可以在长上下文定价的基础上再打 5 折:

# 创建批量请求

batch = client.beta.messages.batches.create(

betas=["context-1m-2025-08-07"],

requests=[

{

"custom_id": "doc-analysis-1",

"params": {

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [{"role": "user", "content": f"分析文档1: {doc1}"}]

}

},

{

"custom_id": "doc-analysis-2",

"params": {

"model": "claude-sonnet-4-6",

"max_tokens": 4096,

"messages": [{"role": "user", "content": "分析文档2: {doc2}"}]

}

}

]

)

🎯 实战建议: 在实际项目中,我们建议先通过 API易 apiyi.com 平台进行小规模测试,确认 Token 用量和成本符合预期后,再进行大规模部署。平台提供详细的用量统计面板,便于精确控制成本。

Claude API 1M 上下文窗口模型选择建议

4 款支持 1M 上下文的模型各有侧重,选择合适的模型能在效果和成本之间找到最佳平衡。

支持 1M 上下文的模型详细对比

| 对比维度 | Claude Opus 4.6 | Claude Sonnet 4.6 | Claude Sonnet 4.5 | Claude Sonnet 4 |

|---|---|---|---|---|

| 智能水平 | 最强 | 强 | 强 | 中上 |

| 标准输入价格 | $5/MTok | $3/MTok | $3/MTok | $3/MTok |

| 长上下文输入价格 | $10/MTok | $6/MTok | $6/MTok | $6/MTok |

| Fast Mode | 支持 (6x 定价) | 不支持 | 不支持 | 不支持 |

| 上下文感知 | 不支持 | 支持 | 支持 | 不支持 |

| Interleaved Thinking | 支持 | 支持 | 不支持 | 支持 |

| 推荐场景 | 复杂推理、代码分析 | 通用长文档处理 | 多轮代理会话 | 日常分析任务 |

按场景选择模型

选 Claude Opus 4.6 的场景:

- 需要最强推理能力的复杂分析任务

- 大型代码库的架构审查和安全审计

- 需要 Fast Mode(快速响应且无长上下文加价)的实时场景

- 预算充足、质量优先的企业级应用

选 Claude Sonnet 4.6 的场景:

- 日常长文档分析和摘要提取

- 需要上下文感知能力的长对话

- 成本敏感但对质量有较高要求的项目

- 需要 Interleaved Thinking 进行工具调用间推理

选 Claude Sonnet 4.5 / Sonnet 4 的场景:

- 批量文档处理(配合 Batch API 降低成本)

- 结构化信息提取和数据整理

- 不需要最新模型特性的稳定生产环境

💡 选择建议: 选择哪个模型主要取决于您的具体应用场景和预算。我们建议通过 API易 apiyi.com 平台进行实际测试对比,该平台支持上述所有模型的统一接口调用,便于快速切换和评估。

Claude API 1M 上下文窗口的 Token 估算参考

在规划长上下文使用时,了解不同内容类型的 Token 消耗非常重要:

| 内容类型 | 大致 Token 数量 | 1M 窗口可容纳量 |

|---|---|---|

| 英文文本 | ~1 Token / 4 字符 | 约 300 万英文字符 |

| 中文文本 | ~1 Token / 1.5 字符 | 约 75 万中文字符 |

| Python 代码 | ~1 Token / 3.5 字符 | 约 250 万字符代码 |

| 普通网页 (10KB) | ~2,500 Token | 约 400 个网页 |

| 大型文档 (100KB) | ~25,000 Token | 约 40 份文档 |

| 研究论文 PDF (500KB) | ~125,000 Token | 约 8 篇论文 |

Claude API 1M 上下文窗口与上下文感知

Claude Sonnet 4.6、Sonnet 4.5 和 Haiku 4.5 具备 Context Awareness(上下文感知) 能力。模型能够实时追踪剩余的上下文窗口容量,在长对话中更智能地管理 Token 预算。

工作原理:

对话开始时,Claude 会收到总上下文容量信息:

<budget:token_budget>1000000</budget:token_budget>

每次工具调用后,模型会收到剩余容量更新:

<system_warning>Token usage: 350000/1000000; 650000 remaining</system_warning>

这意味着在 1M 上下文窗口中,Claude 能够:

- 精确管理 Token 预算: 不会在对话后期突然耗尽上下文

- 合理分配输出长度: 根据剩余容量调整回复的详细程度

- 支持超长代理会话: 在 Agent 工作流中持续执行任务直到完成

Claude API 1M 上下文窗口管理策略: Compaction

当对话长度接近 1M 上下文窗口的极限时,Claude API 提供了 Compaction(压缩) 功能来延续对话。Compaction 是一种服务端摘要机制,会自动将对话早期的内容压缩成精简摘要,释放上下文空间,从而支持超越上下文窗口限制的超长对话。

目前 Compaction 功能在 Claude Opus 4.6 上以 Beta 形式提供。对于需要在 1M 上下文中运行长时间 Agent 任务的开发者,Compaction 是管理上下文的首选策略。

此外,Claude API 还提供了 Context Editing(上下文编辑) 能力,包括:

- Tool Result Clearing: 在 Agent 工作流中清除旧的工具调用结果,释放 Token

- Thinking Block Clearing: 主动清除之前轮次的思考内容,进一步优化上下文利用率

这些策略可以和 1M 上下文窗口配合使用,让你在超长上下文场景中获得最佳的性能和成本平衡。

Claude API 1M 上下文窗口中的注意事项

在实际使用 1M 上下文窗口时,有几个容易被忽略的技术细节:

-

新模型返回验证错误而非静默截断: 从 Claude Sonnet 3.7 开始,当 prompt 和输出 Token 总量超过上下文窗口时,API 会返回验证错误,而不是悄悄截断内容。建议在发送请求前使用 Token Counting API 预估 Token 数量。

-

图片和 PDF 的 Token 消耗不固定: 多模态内容的 Token 计算与纯文本不同,相同大小的图片可能消耗差异很大的 Token 数量。在大量使用图片时要预留充足的 Token 裕量。

-

请求大小限制 (Request Size Limits): 即使上下文窗口支持 1M Token,HTTP 请求本身也有大小限制。当发送超大文本时,需要关注 HTTP 层面的限制。

-

缓存感知的速率限制: 使用 Prompt Caching 时,缓存命中的 Token 不计入 ITPM 速率限制。这意味着在 1M 上下文场景中,合理利用缓存可以显著提升实际吞吐量。

常见问题

Q1: 如何确认我的请求是否被按长上下文定价计费?

检查 API 响应中的 usage 对象。将 input_tokens、cache_creation_input_tokens 和 cache_read_input_tokens 三个字段相加,如果总和超过 200,000,则整个请求按长上下文价格计费。通过 API易 apiyi.com 平台调用时,用量统计面板会清晰标注每次请求的计费档位。

Q2: 1M 上下文窗口支持哪些文件类型?

Claude API 的 1M 上下文窗口支持纯文本、代码、Markdown 等文本格式,也支持图片和 PDF 文件。但需要注意,图片和 PDF 的 Token 消耗通常较大且不固定。当大量图片与长文本组合使用时,可能会触及请求大小限制(Request Size Limits)。建议在 API易 apiyi.com 平台先进行小规模测试,确认实际 Token 消耗后再大规模使用。

Q3: Extended Thinking 的 Token 会占用 1M 上下文吗?

当前轮次的 Extended Thinking Token 会计入上下文窗口。但 Claude API 会自动剥离之前轮次的 thinking blocks,不会在后续对话中累积。这意味着你可以在 1M 上下文中安全使用 Extended Thinking,不用担心思考过程吃掉大量上下文空间。

Q4: 不满足 Tier 4 条件怎么办?

目前 1M 上下文窗口仅对 Tier 4 及自定义速率限制的组织开放。达到 Tier 4 只需累计充值 $400,充值后自动升级。如果你暂时无法达到 Tier 4,可以考虑: ① 通过分段处理将输入控制在 200K 以内; ② 使用 Retrieval-Augmented Generation (RAG) 方案提取关键内容; ③ 联系 Anthropic 销售团队了解自定义方案。

Q5: AWS Bedrock 和 Google Vertex AI 上如何开启?

1M 上下文窗口在 AWS Bedrock、Google Vertex AI 和 Microsoft Foundry 上均可使用。不同平台的开启方式略有不同——Bedrock 通过在 InvokeModel 请求中指定相应参数,Vertex AI 通过 API 配置。具体配置方式请参考各平台的官方文档。

Claude API 1M 上下文窗口最佳实践清单

在实际项目中整合 1M 上下文窗口,建议遵循以下最佳实践:

开发阶段

- 先用 Token Counting API 预估: 在发送实际请求前,先用 Token Counting API 估算输入 Token 数量,避免意外触发长上下文定价

- 设置合理的 max_tokens:

max_tokens参数不影响速率限制计算(OTPM 按实际输出计算),可以设置较高的值确保输出不被截断 - 分段测试: 先用小规模数据验证 prompt 模板效果,再逐步增大输入规模

生产环境

- 优先使用 Prompt Caching: 对于重复使用的长文档,Prompt Caching 可以将缓存命中部分的输入费用降到标准价的 10%,同时缓存命中的 Token 不计入 ITPM 速率限制

- 非实时任务用 Batch API: Batch API 可在长上下文定价基础上再打 5 折,两者叠加后费用仅为标准价的约 60%

- 监控 usage 字段: 每次请求后检查响应中的

usage对象,建立费用监控告警机制 - 429 错误重试: 长上下文请求有独立速率限制,遇到 429 错误时检查

retry-afterheader 进行合理重试

成本控制

- 控制 200K 阈值: 如果输入接近 200K,考虑精简 prompt 以避免触发 2x 定价

- 选择合适的模型: Sonnet 系列比 Opus 便宜 40%,日常任务优先选 Sonnet

- 利用缓存降低速率限制压力: 80% 缓存命中率下,实际吞吐量可达名义限额的 5 倍

Claude API 1M 上下文窗口总结

Claude API 的 1M 上下文窗口让开发者能够一次性处理约 75 万字的内容,为代码库分析、长文档处理、复杂对话等场景提供了强大能力。核心要点回顾:

- 一行代码开启: 添加

anthropic-beta: context-1m-2025-08-07header 即可 - 4 款模型支持: Claude Opus 4.6、Sonnet 4.6、Sonnet 4.5、Sonnet 4

- 透明定价: 超过 200K Token 后输入 2 倍、输出 1.5 倍,低于 200K 仍按标准价

- 独立速率限制: 长上下文请求不影响标准请求的额度

- 多种优化手段: Prompt Caching、Batch API、Fast Mode 可叠加降低成本

推荐通过 API易 apiyi.com 快速体验 Claude 1M 上下文窗口的能力,结合实际业务场景找到最佳实践方案。

参考资料

-

Anthropic 官方文档 – Context Windows: Claude API 上下文窗口技术说明

- 链接:

platform.claude.com/docs/en/build-with-claude/context-windows

- 链接:

-

Anthropic 官方文档 – Pricing: Claude API 完整定价说明

- 链接:

platform.claude.com/docs/en/about-claude/pricing

- 链接:

-

Anthropic 官方文档 – Rate Limits: 速率限制和 Usage Tier 说明

- 链接:

platform.claude.com/docs/en/api/rate-limits

- 链接:

📝 作者: APIYI Team | 更多 AI 模型 API 使用教程,请访问 API易 apiyi.com 帮助中心