站长注:深度剖析GPT-4o-mini API调用中常见的HTTP 500错误,特别是Content-Length不匹配问题,提供完整的原因分析和解决方案,帮助开发者高效稳定地接入大模型。

当开发者首次接入GPT-4o-mini等大型语言模型API时,可能会遇到各种技术层面的挑战。其中一个常见但又较为棘手的问题是HTTP 500错误,特别是与Content-Length相关的错误。本文将深入分析这类错误的成因,并提供全面的解决方案,帮助您在项目中稳定高效地使用GPT-4o-mini等大模型API。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

专业解决API调用错误问题,提供稳定可靠的GPT-4o-mini等全系列模型接入服务

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

GPT-4o-mini错误分析背景介绍

OpenAI的GPT-4o-mini是一款性价比极高的大型语言模型,提供了接近GPT-4o的能力,但价格更为经济实惠。然而,在实际开发过程中,开发者可能会遇到类似以下的错误:

respErr is not nil: &{Error:{Message:http: wrote more than the declared Content-Length LocalizedMessage:Unknown error Type:shell_api_error Param: Code:copy_response_body_failed} StatusCode:500}

这类错误通常发生在HTTP通信层面,而非模型本身的逻辑问题,其背后可能隐藏着多种技术因素。理解并解决这些问题对于构建稳定可靠的AI应用至关重要。

Content-Length错误技术详解

错误本质分析

这个错误的核心在于HTTP响应处理过程中出现了内容长度不匹配的情况。具体来说:

- HTTP协议规范:HTTP响应头中的Content-Length字段声明了响应体的字节大小

- 数据不一致:实际传输的数据量超过了预先声明的Content-Length值

- 安全机制触发:HTTP客户端检测到不一致后主动中断连接,抛出错误

这种错误的HTTP状态码为500(内部服务器错误),表明问题出在服务器端,而非客户端请求格式不正确导致的400系列错误。

错误代码解构

从错误信息可以提取关键细节:

copy_response_body_failed:表明在复制或处理HTTP响应体时失败http: wrote more than the declared Content-Length:明确指出实际内容超过了声明的长度shell_api_error:指示错误发生在API处理管道的底层组件中

GPT-4o-mini调用错误的可能原因

1. 服务器负载与资源约束

当OpenAI的服务器负载过高时,可能出现以下情况:

- 资源分配不足:导致响应处理不完整或不准确

- 任务队列拥塞:使部分请求处理超时或被截断

- 动态扩缩容影响:服务器集群扩容过程中可能产生短暂的不稳定状态

实际案例:在模型新发布后的高峰期,或在特定时间段(如美国工作时间)往往更容易遇到此类问题。

2. 网络传输干扰

网络层面的因素也可能导致Content-Length不匹配:

- 数据包损坏:网络传输过程中的数据包错误或损坏

- 中间件修改:代理服务器、负载均衡器或防火墙可能修改响应

- 网络抖动:不稳定的网络连接导致数据传输中断或重组

这类问题在跨国请求时更为常见,特别是当数据需要通过多个网络节点传输时。

3. API限制与配额约束

OpenAI对API调用有多种限制,可能间接导致此类错误:

- 速率限制:如果请求频率过高,服务器可能提前终止响应

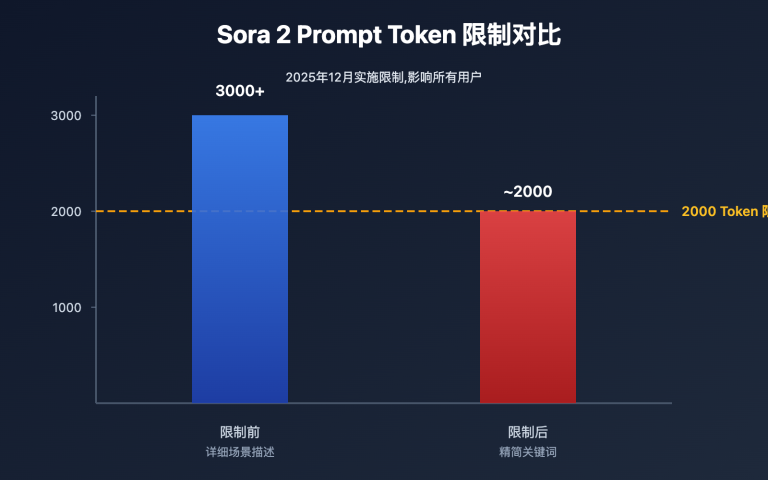

- 令牌限制:生成的内容接近或超过限制时可能导致响应被截断

- 并发请求限制:并发请求数超限可能影响响应的完整性

4. 客户端实现问题

在客户端环境中,以下因素可能触发Content-Length错误:

- HTTP客户端库Bug:某些HTTP客户端库在处理大型响应或流式响应时存在缺陷

- 超时设置不当:客户端超时设置过短,无法完成完整响应接收

- 内存约束:客户端内存不足以处理大型响应

- 连接池管理:复用的HTTP连接可能存在状态残留问题

GPT-4o-mini错误排查与解决方案

立即可行的应对策略

当遇到Content-Length错误时,以下方法可立即尝试:

1. 请求重试机制

import time

import random

import requests

def call_gpt4o_mini_with_retry(prompt, max_retries=5):

"""带指数退避重试的GPT-4o-mini API调用"""

url = "https://vip.apiyi.com/v1/chat/completions" # API易平台优化后的Endpoint

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gpt-4o-mini",

"messages": [{"role": "user", "content": prompt}],

"max_tokens": 2000

}

for attempt in range(max_retries):

try:

response = requests.post(url, json=data, headers=headers, timeout=30)

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

if "Content-Length" in str(e) or response.status_code == 500:

# 指数退避策略

wait_time = (2 ** attempt) + random.uniform(0, 1)

print(f"遇到Content-Length错误,{wait_time:.2f}秒后重试(尝试 {attempt+1}/{max_retries})")

time.sleep(wait_time)

continue

else:

# 其他错误直接抛出

raise

raise Exception(f"在{max_retries}次尝试后仍然失败")

2. 请求简化

减小请求复杂度,尤其是在处理以下情况时:

- 长文本输入:将长文本分割成多个独立请求处理

- 复杂指令:简化提示词,去除不必要的上下文

- 多轮对话:适当减少历史消息的数量或内容长度

3. 调整请求参数

# 优化的请求参数

optimized_params = {

"model": "gpt-4o-mini",

"messages": [{"role": "user", "content": prompt}],

"max_tokens": 1000, # 减小生成内容长度

"temperature": 0.7, # 降低随机性可能有助于减少异常响应

"request_timeout": 60, # 延长超时时间

"stream": False # 非流式响应通常更稳定

}

系统级优化方案

对于生产环境中需要高稳定性的应用,建议采取以下系统级优化:

1. 健壮的错误处理架构

def robust_api_call(prompt, model="gpt-4o-mini"):

"""健壮的API调用函数"""

try:

# 主要API调用

result = primary_api_call(prompt, model)

return result, None

except ContentLengthError as e:

# 记录特定错误

log_error("Content-Length error encountered", e)

# 尝试备用调用方法

try:

result = fallback_api_call(prompt, model)

return result, "Used fallback method"

except Exception as fallback_error:

# 降级处理

return graceful_degradation(prompt), f"Fallback failed: {str(fallback_error)}"

except Exception as e:

# 处理其他API错误

log_error("General API error", e)

return graceful_degradation(prompt), str(e)

2. 多级容错设计

构建多级容错机制,确保服务的连续性:

- 错误分类处理:对不同类型的错误实施不同的处理策略

- 备用端点:配置多个API端点,在主要端点失败时切换

- 模型降级方案:准备备用模型,在主模型不可用时自动切换

- 本地缓存:对频繁请求的内容实施缓存,减少API依赖

3. 监控与预警系统

实施全面的监控系统,及时发现并解决问题:

- 错误率监控:追踪API调用错误率,设置阈值报警

- 响应时间跟踪:监控响应时间变化,识别潜在问题

- 依赖健康检查:定期检查API服务可用性

- 用户体验指标:关注终端用户体验指标,而非仅关注技术指标

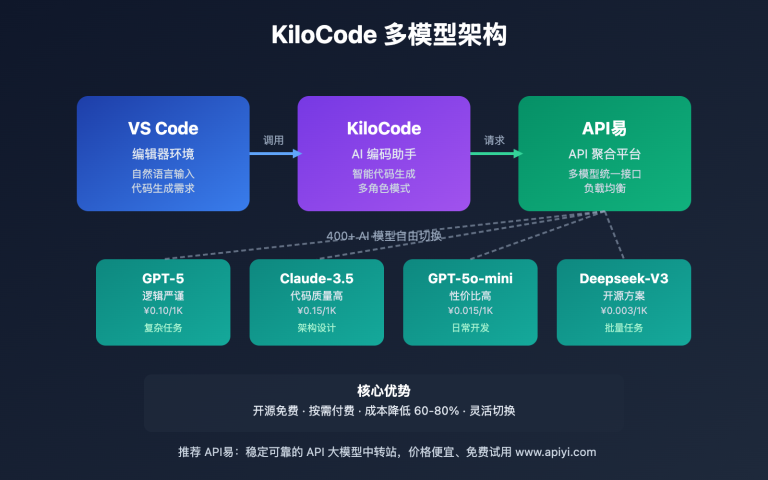

API易平台解决方案优势

API易平台针对GPT-4o-mini等大模型的调用错误,提供了一系列优化方案:

1. 稳定性优化

- 多通道备份:通过多个渠道接入OpenAI官方API,确保服务可用性

- 智能负载均衡:根据实时监控数据,将请求分配到最优服务节点

- 流量削峰填谷:平滑处理请求高峰,减少API拒绝率

- 自动故障转移:当检测到特定端点不稳定时,自动切换到备用端点

2. 专业错误处理

API易平台针对Content-Length等常见错误实施了专业处理:

- 请求预处理:对请求进行验证和优化,减少错误概率

- 响应后处理:对响应内容进行验证和修复,处理不完整或异常的响应

- 自动重试策略:针对不同类型的错误,实施智能重试策略

- 错误翻译优化:将复杂的技术错误翻译为易理解的信息和建议

3. 增强的API接口

# 使用API易平台优化后的接口调用GPT-4o-mini

import requests

def call_apiyi_gpt4o_mini(prompt):

url = "https://vip.apiyi.com/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {APIYI_API_KEY}"

}

data = {

"model": "gpt-4o-mini",

"messages": [{"role": "user", "content": prompt}],

"max_tokens": 2000

}

response = requests.post(url, json=data, headers=headers)

return response.json()

# API易返回结果更加可靠,并包含详细的请求状态信息

4. 完善的开发者工具

API易平台提供一系列工具,帮助开发者更高效地集成和调试:

- Cherry Studio:无代码可视化调试和测试API的工具

- 请求记录与回放:详细记录API请求历史,支持问题分析和重现

- 参数优化建议:基于使用模式自动提供参数优化建议

- 全中文文档:详细的中文接口文档和故障排查指南

GPT-4o-mini常见问题与最佳实践

调用GPT-4o-mini时如何避免Content-Length错误?

避免此类错误的最佳实践包括:

- 实施渐进式退避重试:使用指数退避算法,而非简单的固定间隔重试

- 优化请求大小:控制输入和预期输出的大小,避免超大请求

- 使用稳定的HTTP客户端:选择成熟且经过广泛测试的HTTP客户端库

- 合理设置超时参数:为复杂请求设置更长的超时时间

- 考虑流式响应:对于大型响应,使用流式API可能更为稳定

GPT-4o-mini与其他模型相比,稳定性如何?

GPT-4o-mini的稳定性分析:

- 与GPT-4o比较:GPT-4o-mini通常有更小的响应大小,因此相对更少遇到Content-Length错误

- 与GPT-3.5比较:虽然GPT-3.5更成熟,但GPT-4o-mini在大多数情况下稳定性相当

- 与Gemini系列比较:不同模型架构可能有不同的错误模式,建议根据具体应用选择

如何判断是否应该切换到其他模型?

考虑切换模型的指标:

- 错误率:如果GPT-4o-mini的错误率超过2%,可考虑尝试其他模型

- 响应时间:如果平均响应时间显著高于预期,可能需要评估替代方案

- 成本效益:综合考虑模型性能、稳定性和价格因素

- 特定能力需求:某些特定任务可能在其他模型上表现更佳

为什么选择API易平台解决GPT-4o-mini调用问题

1. 专业的错误处理能力

API易平台拥有丰富的大模型API调用经验,特别针对Content-Length等技术错误进行了优化:

- 错误模式识别:能够识别和分类常见错误模式

- 预防性措施:在请求前应用多种优化策略减少错误

- 实时监控:持续监控API性能和错误率,主动调整配置

2. 稳定可靠的基础设施

- 多区域部署:分布式服务架构,确保高可用性

- 网络优化:针对中国网络环境优化的路由策略

- 资源弹性:自动扩展资源以应对需求波动

- 冗余保障:关键组件采用冗余设计,避免单点故障

3. 经济高效的使用成本

- 智能路由:自动选择最稳定且成本最优的服务路径

- 缓存策略:对适当请求实施缓存,减少重复调用

- 批量处理:支持请求批处理,降低单次调用成本

- 使用建议:提供成本优化建议,帮助开发者降低开支

4. 本地化支持与服务

- 中文技术支持:提供专业的中文技术支持

- 开发者社区:活跃的开发者社区,分享经验和解决方案

- 定制化咨询:针对特定应用场景提供专业建议

- 培训资源:提供中文培训材料和最佳实践指南

总结

GPT-4o-mini的Content-Length错误虽然看起来技术性很强,但通过本文介绍的分析方法和解决方案,开发者可以构建更稳定可靠的AI应用。从简单的重试策略到完整的系统架构设计,从单一错误处理到综合优化方案,每一步都能帮助您提升应用的质量和用户体验。

API易平台通过专业的技术优化和服务支持,为中国开发者提供了稳定、高效使用GPT-4o-mini等大模型的通道。无论是个人开发者还是企业应用,都能从中获益,避免技术障碍,专注于创造真正的业务价值。

遇到Content-Length错误不必担忧,它通常是可以通过适当的技术手段解决的临时性问题。通过持续学习和实践,加上合适的平台支持,您完全可以构建稳定可靠的AI应用,充分发挥GPT-4o-mini的强大能力。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

解决GPT-4o-mini等大模型的调用难题,提供更稳定可靠的技术服务

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。