站长注:详细介绍如何在开源AI代理框架OpenManus中配置接入Claude和Deepseek API,实现多模型能力整合,提升AI代理的智能水平。

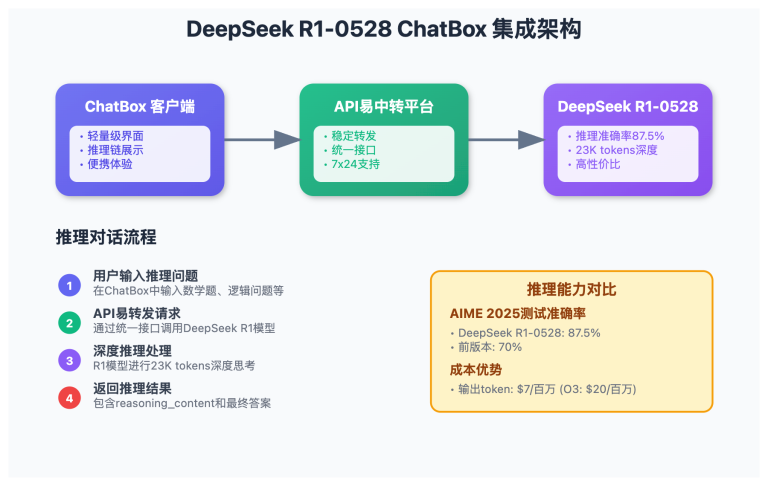

随着Manus 的爆火和一码难求,OpenManus作为MetaGPT社区推出的开源替代方案,提供了灵活且可定制的AI代理开发框架。本文将详细介绍如何通过API易平台在OpenManus中接入Claude和Deepseek这两款强大的大模型API,让你的AI代理同时具备Claude的混合推理能力和Deepseek的中文优化特性。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Claude、Deepseek等全系列模型,让AI代理开发更简单

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

OpenManus 背景介绍

什么是OpenManus?

OpenManus是一个由MetaGPT社区开发的开源AI代理框架,旨在提供Manus AI的社区驱动替代方案。它允许开发者创建能够基于用户指令执行任务的AI代理,具有以下核心特点:

- 开源灵活性:完全开源的代码库,允许开发者自由定制和扩展

- API优先设计:易于与其他工具和服务集成

- 成本效益:免费使用,无隐藏费用

- 社区支持:活跃的贡献者和插件生态系统

OpenManus利用大型语言模型(如GPT-4o)作为其核心推理引擎,但其模块化设计允许开发者轻松替换底层模型,这正是我们今天要探讨的主题。

为什么要接入多种模型?

在AI代理开发中,不同的大模型各有所长:

- Claude模型优势:

- 混合推理系统,能在标准思维和扩展思维间切换

- 卓越的编程和推理能力

- 强大的上下文理解能力

- 思考过程可视化(思维推理模式)

- Deepseek模型优势:

- 中文优化,对中文内容理解更准确

- 强大的代码生成和理解能力

- 推理能力出色,特别是deepseek-reasoner版本

- 成本效益高,性价比优势明显

通过在OpenManus中集成多种模型,你可以根据不同任务的需求灵活切换,充分发挥各个模型的优势,构建更智能、更全面的AI代理系统。

OpenManus接入多模型API步骤

1. 环境准备

首先,我们需要设置OpenManus的开发环境:

- 创建Conda环境:

conda create -n open_manus python=3.12 conda activate open_manus - 克隆OpenManus仓库:

git clone https://github.com/mannaandpoem/OpenManus.git cd OpenManus - 安装依赖:

pip install -r requirements.txt

2. 获取API易密钥

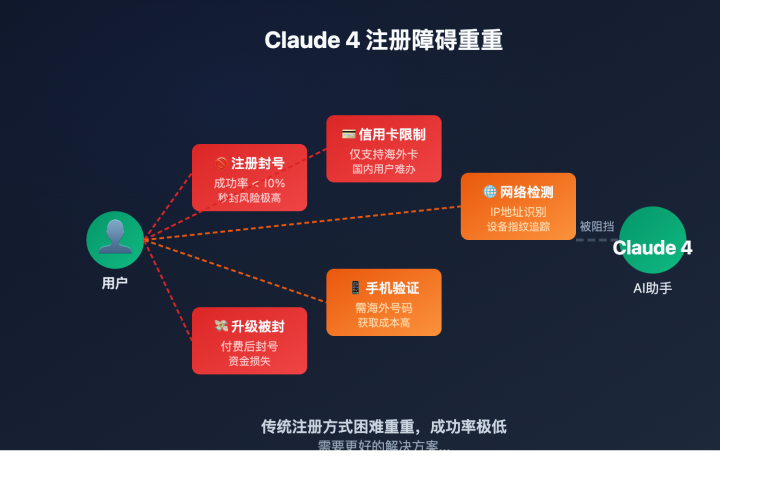

在接入Claude和Deepseek API之前,我们需要获取API易平台的密钥:

- 注册API易账号:

- 访问API易注册页面

- 完成注册并登录

- 在后台的【令牌】栏目,获取API密钥

- 确认模型可用性:

- 在API易后台查看可用模型列表

- 确认Claude和Deepseek模型状态

- 了解各模型的价格和特点

3. 配置OpenManus接入多模型

OpenManus使用TOML格式的配置文件来管理设置。我们需要修改配置文件以支持Claude和Deepseek模型:

- 创建配置文件:

cp config/config.example.toml config/config.toml - 编辑配置文件:

使用你喜欢的文本编辑器打开config/config.toml,我们将添加多模型支持。

方法一:使用OpenAI兼容接口(推荐)

API易提供与OpenAI完全兼容的接口,这使得我们可以通过简单修改配置来支持Claude和Deepseek模型:

[llm]

# 默认模型配置

model = "gpt-4o"

base_url = "https://vip.apiyi.com/v1"

api_key = "你的API易密钥" # 替换为你的实际密钥

max_tokens = 4096

temperature = 0.0

# Claude模型配置

[llm.claude]

model = "claude-3-7-sonnet-20250219" # 或使用 claude-3-7-sonnet-20250219-thinking 思维推理版本

base_url = "https://vip.apiyi.com/v1"

api_key = "你的API易密钥" # 替换为你的实际密钥

max_tokens = 4096

temperature = 0.0

# Deepseek模型配置

[llm.deepseek]

model = "deepseek-chat" # 或使用 deepseek-reasoner 推理增强版本

base_url = "https://vip.apiyi.com/v1"

api_key = "你的API易密钥" # 替换为你的实际密钥

max_tokens = 4096

temperature = 0.0

方法二:使用模型特定的SDK(可选)

如果你希望使用模型原生SDK,可以安装相应的包并配置如下:

# 安装Claude SDK

pip install anthropic

# 安装OpenAI SDK(用于Deepseek)

pip install openai

然后修改配置文件:

[llm]

# 默认模型配置

provider = "openai"

model = "gpt-4o"

base_url = "https://vip.apiyi.com/v1"

api_key = "你的API易密钥"

max_tokens = 4096

temperature = 0.0

# Claude模型配置

[llm.claude]

provider = "anthropic"

model = "claude-3-7-sonnet-20250219"

api_key = "你的API易密钥"

max_tokens = 4096

temperature = 0.0

# Deepseek模型配置

[llm.deepseek]

provider = "openai"

model = "deepseek-chat"

base_url = "https://vip.apiyi.com/v1"

api_key = "你的API易密钥"

max_tokens = 4096

temperature = 0.0

4. 修改OpenManus代码支持多模型

为了让OpenManus能够灵活切换不同的模型,我们需要修改代码。以下是一个简化的示例,展示如何在OpenManus中实现模型切换功能:

- 创建模型管理器:

在项目根目录下创建一个新文件model_manager.py:

import os

import toml

from openai import OpenAI

import anthropic

class ModelManager:

def __init__(self, config_path="config/config.toml"):

self.config = toml.load(config_path)

self.current_model = "default"

self.clients = {}

self._initialize_clients()

def _initialize_clients(self):

# 初始化默认模型

default_config = self.config["llm"]

self.clients["default"] = self._create_client(default_config)

# 初始化其他模型

for model_name, model_config in self.config.get("llm", {}).items():

if isinstance(model_config, dict):

self.clients[model_name] = self._create_client(model_config)

def _create_client(self, config):

provider = config.get("provider", "openai")

if provider == "anthropic":

return {

"client": anthropic.Anthropic(api_key=config["api_key"]),

"config": config,

"provider": "anthropic"

}

else: # 默认使用OpenAI兼容接口

return {

"client": OpenAI(

api_key=config["api_key"],

base_url=config.get("base_url", "https://api.openai.com/v1")

),

"config": config,

"provider": "openai"

}

def switch_model(self, model_name):

if model_name in self.clients:

self.current_model = model_name

return True

return False

def get_current_client(self):

return self.clients[self.current_model]

def get_completion(self, messages, **kwargs):

client_data = self.get_current_client()

client = client_data["client"]

config = client_data["config"]

provider = client_data["provider"]

# 合并配置和传入的参数

params = {

"model": config["model"],

"max_tokens": config.get("max_tokens", 4096),

"temperature": config.get("temperature", 0.0)

}

params.update(kwargs)

if provider == "anthropic":

# 转换消息格式为Anthropic格式

anthropic_messages = []

for msg in messages:

anthropic_messages.append({

"role": msg["role"],

"content": msg["content"]

})

response = client.messages.create(

messages=anthropic_messages,

model=params["model"],

max_tokens=params["max_tokens"],

temperature=params["temperature"]

)

return response.content.text

else:

# 使用OpenAI兼容接口

response = client.chat.completions.create(

messages=messages,

model=params["model"],

max_tokens=params["max_tokens"],

temperature=params["temperature"]

)

return response.choices.message.content

- 集成到OpenManus主程序:

修改OpenManus的主程序文件(通常是main.py或类似文件),引入我们的模型管理器:

from model_manager import ModelManager

# 初始化模型管理器

model_manager = ModelManager()

# 在需要使用LLM的地方

def process_user_input(user_input):

# 检查是否是模型切换命令

if user_input.startswith("/model "):

model_name = user_input.split(" ").strip()

if model_manager.switch_model(model_name):

return f"已切换到 {model_name} 模型"

else:

return f"模型 {model_name} 不可用,请检查配置"

# 正常的对话处理

messages = [{"role": "user", "content": user_input}]

response = model_manager.get_completion(messages)

return response

# 主循环

def main():

print("欢迎使用OpenManus多模型版本!")

print("可用命令:")

print(" /model default - 切换到默认模型")

print(" /model claude - 切换到Claude模型")

print(" /model deepseek - 切换到Deepseek模型")

while True:

user_input = input("\n请输入指令: ")

if user_input.lower() in ["exit", "quit", "/exit", "/quit"]:

break

response = process_user_input(user_input)

print(f"\n{response}")

if __name__ == "__main__":

main()

5. 运行OpenManus

完成上述配置和代码修改后,你可以运行OpenManus并测试多模型功能:

python main.py

现在,你可以使用以下命令在不同模型之间切换:

/model default– 切换到默认模型(GPT-4o)/model claude– 切换到Claude模型/model deepseek– 切换到Deepseek模型

多模型应用场景

1. 智能客服系统

在构建智能客服系统时,可以根据不同类型的查询选择最适合的模型:

- 一般问题:使用Deepseek-chat处理日常简单查询,响应速度快,成本低

- 技术支持:使用Claude处理复杂的技术问题,利用其强大的推理能力

- 中文用户:对中文用户自动切换到Deepseek模型,提供更自然的交流体验

2. 内容创作助手

内容创作助手可以根据不同的创作需求选择合适的模型:

- 创意构思:使用Claude的思维推理模式,获取详细的思考过程

- 中文写作:使用Deepseek优化中文内容生成

- 多语言翻译:根据语言对选择最适合的模型

3. 编程开发助手

在编程开发场景中,不同模型各有所长:

- 算法设计:使用Claude的思维推理模式,获得详细的算法设计思路

- 代码生成:使用Deepseek生成高质量代码

- 代码解释:根据代码语言和复杂度选择合适的模型

多模型集成最佳实践

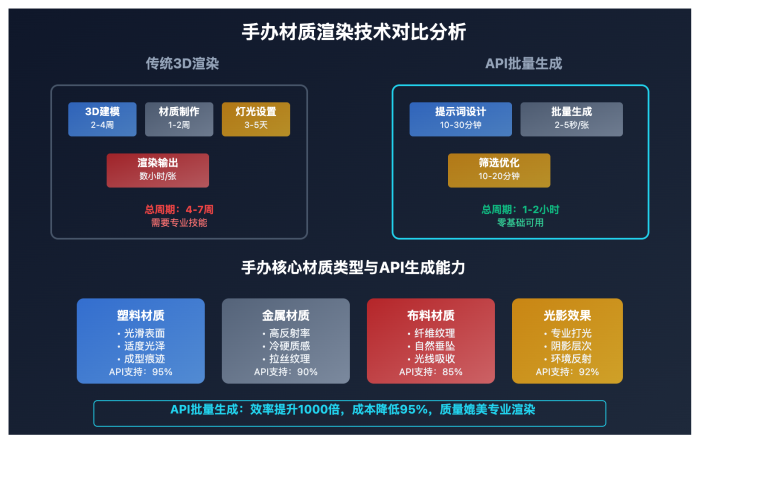

1. 模型选择策略

为了最大化多模型集成的效益,建议采用以下策略:

- 任务导向选择:

- 简单对话和信息查询 → Deepseek-chat

- 复杂推理和问题解决 → Claude思维推理模式

- 代码生成和分析 → 根据语言选择Deepseek或Claude

- 语言导向选择:

- 中文内容处理 → Deepseek

- 英文内容处理 → Claude

- 多语言混合 → 根据主要语言选择

- 成本导向选择:

- 高频简单任务 → Deepseek(成本较低)

- 关键复杂任务 → Claude(质量优先)

2. 提示词优化

针对不同模型,提示词设计也应有所不同:

- Claude提示词优化:

请使用扩展思维模式分析以下问题... 请详细解释你的思考过程... - Deepseek提示词优化:

请用专业且准确的中文回答以下问题... 请生成高质量的代码,并解释关键部分...

3. 上下文管理

在多模型系统中,上下文管理尤为重要:

- 上下文传递:切换模型时,确保关键上下文信息被正确传递

- 上下文压缩:定期总结长对话,减少token消耗

- 上下文分离:为不同类型的任务维护独立的上下文

4. 错误处理与回退机制

健壮的多模型系统应具备完善的错误处理机制:

def get_model_response(prompt, model_name="default"):

try:

# 尝试使用指定模型

model_manager.switch_model(model_name)

return model_manager.get_completion([{"role": "user", "content": prompt}])

except Exception as e:

print(f"模型 {model_name} 调用失败: {e}")

# 回退到默认模型

model_manager.switch_model("default")

return model_manager.get_completion([{"role": "user", "content": prompt}])

常见问题解答

Q1:如何判断应该使用哪个模型?

A:可以基于以下因素选择模型:

- 任务复杂度:简单任务用Deepseek,复杂推理用Claude

- 语言需求:中文优先考虑Deepseek,英文可选Claude

- 成本考虑:预算有限时优先使用Deepseek

- 特殊能力需求:需要看到思考过程时选择Claude思维推理模式

你也可以实现自动模型选择,通过分析用户输入的内容和意图,自动选择最合适的模型。

Q2:如何处理模型之间的风格差异?

A:不同模型的回答风格可能有所不同,可以通过以下方法统一体验:

- 使用统一的系统提示词设定一致的回答风格

- 实现后处理函数,统一格式化不同模型的输出

- 在UI层面明确标识当前使用的模型,设置用户预期

Q3:如何优化多模型系统的成本?

A:控制多模型系统成本的策略包括:

- 为高频简单任务使用Deepseek等成本较低的模型

- 实现缓存机制,对常见问题的回答进行缓存

- 优化提示词,减少不必要的token消耗

- 设置合理的max_tokens限制,避免生成过长回答

- 实现用量监控,及时发现异常使用情况

Q4:如何处理模型API的限流问题?

A:API易平台提供稳定的API访问,但仍建议实现以下机制:

- 实现请求队列和重试机制

- 在高峰期实施请求节流

- 监控API调用状态,及时切换到可用模型

- 实现本地缓存,减少重复请求

Q5:如何评估不同模型的表现?

A:可以通过以下方法评估模型表现:

- 设计标准测试集,比较不同模型的回答质量

- 收集用户反馈,了解实际使用体验

- 监控关键指标,如响应时间、成功率、token消耗等

- 进行A/B测试,比较不同模型在特定场景下的表现

为什么选择API易接入多模型

1. 统一接口优势

API易平台提供统一的OpenAI兼容接口,使得接入多种模型变得简单:

- 代码复用:使用相同的代码结构调用不同模型

- 无缝切换:轻松在不同模型间切换,无需修改大量代码

- 简化维护:统一的接口减少了维护多套代码的负担

2. 稳定可靠的供给

API易确保稳定的模型供应:

- 多渠道资源:即使官方渠道暂时不可用,仍能提供服务

- 全球可访问:不受地区限制,全球用户均可使用

- 容量保障:足够的资源池确保高峰期稳定服务

3. 成本优势

通过API易使用多模型具有明显的成本优势:

- 统一计费:所有模型在一个平台统一计费,方便管理

- 透明定价:清晰的价格结构,无隐藏费用

- 灵活充值:支持小额起充,适合个人开发者和小团队

4. 技术支持

API易提供专业的技术支持:

- 中文支持:提供中文技术文档和支持服务

- 问题解决:快速响应API使用中的问题

- 最佳实践:提供各类模型的使用建议和最佳实践

总结:打造智能多模型AI代理

通过在OpenManus中集成Claude和Deepseek API,你可以构建一个更加智能、灵活的AI代理系统,能够根据不同任务的需求自动或手动切换最合适的模型。这种多模型集成方案充分发挥了各个模型的优势,同时通过API易平台的统一接口,大大简化了开发和维护工作。

无论你是构建个人助手、企业应用还是研究项目,这种多模型集成方案都能为你提供更强大、更全面的AI能力。现在,通过API易平台,这一前沿技术已对所有开发者开放,让我们一起探索AI代理的无限可能!

欢迎免费试用 API易,体验多模型集成的强大能力 www.apiyi.com

加站长个人微信:8765058,获取更多API使用技巧与优惠。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI API 使用经验和最新动态。