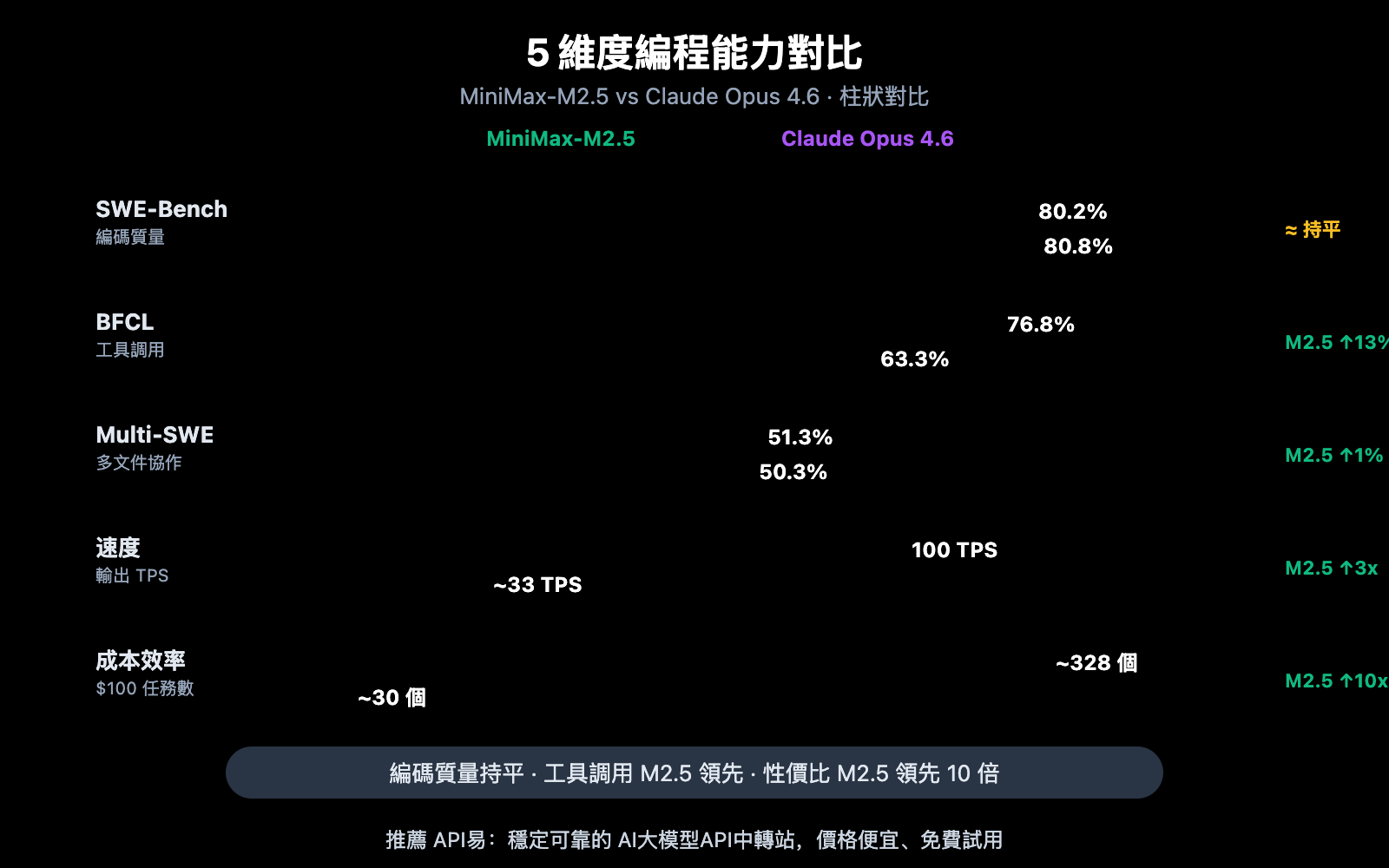

作者注:從 SWE-Bench、Multi-SWE-Bench、BFCL 工具調用、編碼速度和價格 5 個維度深度對比 MiniMax-M2.5 和 Claude Opus 4.6 的編程能力差異

選擇 AI 編程助手一直是開發者關注的核心問題。本文從 5 個關鍵維度對比 MiniMax-M2.5 和 Claude Opus 4.6 的編程能力,幫助你在性能和成本之間做出最優選擇。

核心價值: 看完本文,你將清楚瞭解這兩個模型在真實編碼場景中的能力邊界,明確在什麼場景下選擇誰更划算。

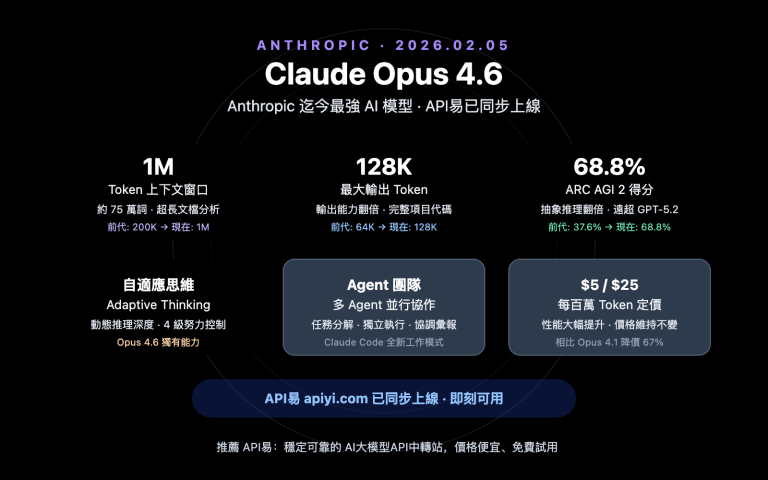

MiniMax-M2.5 與 Claude Opus 4.6 編程能力核心差異

| 對比維度 | MiniMax-M2.5 | Claude Opus 4.6 | 差距分析 |

|---|---|---|---|

| SWE-Bench Verified | 80.2% | 80.8% | Opus 僅領先 0.6% |

| Multi-SWE-Bench | 51.3% | 50.3% | M2.5 反超 1.0% |

| BFCL 工具調用 | 76.8% | 63.3% | M2.5 領先 13.5% |

| 輸出速度 | 50-100 TPS | ~33 TPS | M2.5 最高快 3 倍 |

| 輸出價格 | $1.20/M tokens | $25/M tokens | M2.5 便宜約 20 倍 |

MiniMax-M2.5 對比 Opus 4.6 編碼基準解讀

從 SWE-Bench Verified 這個最受行業認可的編碼基準來看,兩者差距極小——MiniMax-M2.5 的 80.2% 僅落後 Claude Opus 4.6 的 80.8% 共 0.6 個百分點。SWE-Bench Verified 測試的是模型在真實 GitHub Pull Request 中修復 Bug 和實現功能的能力,這是最接近真實開發場景的評測。

更值得關注的是 Multi-SWE-Bench 這個多文件複雜項目基準:MiniMax-M2.5 以 51.3% 的得分反超 Opus 4.6 的 50.3%。這意味着在處理需要跨多個文件協調修改的複雜工程任務時,M2.5 表現更穩定。

MiniMax 官方數據顯示,M2.5 在公司內部已有 80% 的新提交代碼由 M2.5 生成,30% 的日常任務由 M2.5 完成,這從實際應用層面驗證了其編碼能力。

MiniMax-M2.5 與 Opus 4.6 在工具調用上的差距

兩個模型在編程領域最大的能力分野出現在工具調用上。BFCL Multi-Turn 基準測試中,MiniMax-M2.5 得分 76.8%,而 Claude Opus 4.6 爲 63.3%,差距高達 13.5 個百分點。

這項差距在智能體編程場景中影響巨大——當模型需要讀取文件、執行命令、調用 API、解析輸出並循環迭代時,工具調用能力直接決定了任務完成的效率和準確性。M2.5 完成同類任務的工具調用輪次比前代 M2.1 減少了 20%,每次調用都更精準。

不過,Claude Opus 4.6 在 MCP Atlas(大規模工具協調)中達到 62.7% 的行業領先水平,在需要同時協調大量工具的超複雜場景下仍有優勢。

MiniMax-M2.5 對比 Opus 4.6 編碼速度與效率

編程不僅看準確率,速度和效率同樣關鍵。尤其在智能體編程場景中,模型需要多輪迭代完成任務,速度直接影響開發體驗和總成本。

| 效率指標 | MiniMax-M2.5 | Claude Opus 4.6 | 優勢方 |

|---|---|---|---|

| 輸出速度(標準版) | ~50 TPS | ~33 TPS | M2.5 快 1.5 倍 |

| 輸出速度(Lightning) | ~100 TPS | ~33 TPS | M2.5 快 3 倍 |

| SWE-Bench 單任務耗時 | 22.8 分鐘 | 22.9 分鐘 | 基本持平 |

| SWE-Bench 單任務成本 | ~$0.15 | ~$3.00 | M2.5 便宜 20 倍 |

| 平均 Token 消耗/任務 | 3.52M tokens | 更高 | M2.5 更省 Token |

| 工具調用輪次優化 | 比 M2.1 少 20% | — | M2.5 更高效 |

MiniMax-M2.5 編碼速度優勢分析

MiniMax-M2.5 在 SWE-Bench Verified 評估中的單任務平均耗時爲 22.8 分鐘,與 Claude Opus 4.6 的 22.9 分鐘幾乎一致。但背後的成本結構完全不同。

M2.5 完成一個 SWE-Bench 任務的成本約爲 $0.15,而 Opus 4.6 約爲 $3.00——這意味着同樣的編碼質量,M2.5 的成本僅爲 Opus 的 1/20。對於需要持續運行編碼智能體的團隊,這個差距會被放大爲每月數千甚至數萬美元的成本節約。

MiniMax-M2.5 的高效率來源於 MoE 架構(230B 總參數僅激活 10B)和 Forge RL 訓練框架帶來的任務分解優化。模型在編碼時會先進行 "Spec-writing"——架構設計和任務分解,然後高效執行,而非盲目試錯。

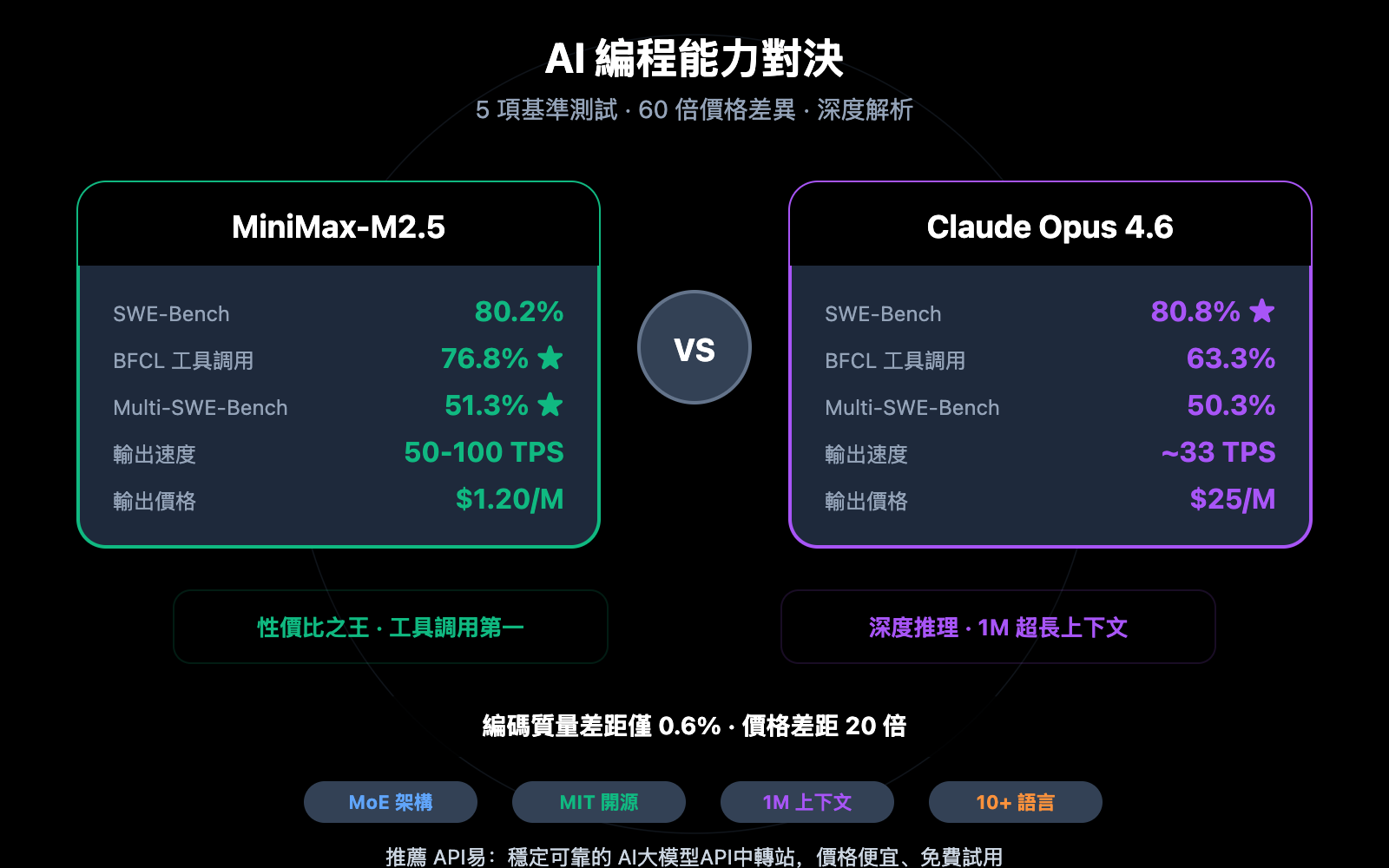

Claude Opus 4.6 編碼能力的獨特優勢

儘管在成本效率上不佔優,Claude Opus 4.6 有其不可替代的優勢:

- Terminal-Bench 2.0: 65.4%,在終端環境下的複雜編碼任務表現業界領先

- OSWorld: 72.7%,智能體計算機操作能力遠超競品

- MCP Atlas: 62.7%,大規模工具協調能力行業第一

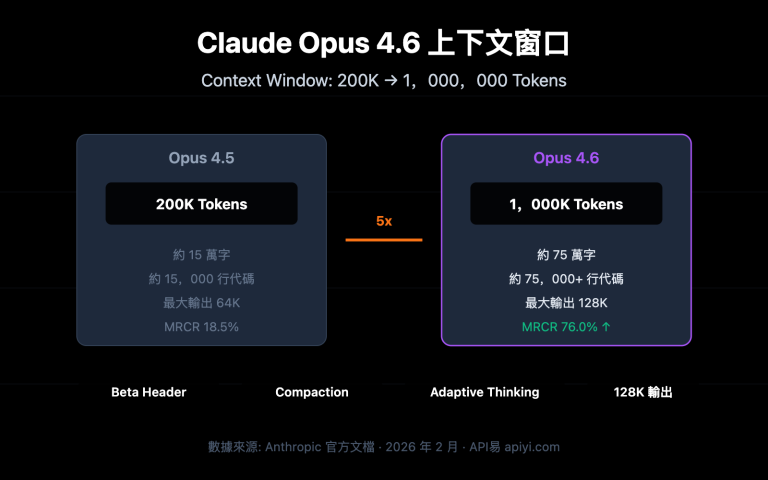

- 1M 上下文窗口: Beta 版支持 100 萬 Token 上下文,處理超大型代碼庫時不需要分段

- Adaptive Thinking: 支持 4 級思考力度(low/medium/high/max),可按需調節推理深度

在需要深度推理、超長代碼上下文理解或極端複雜的系統級任務中,Opus 4.6 仍然是目前最強的選擇。

🎯 選擇建議: 兩個模型各有所長,建議通過 API易 apiyi.com 平臺實際測試對比。平臺同時支持 MiniMax-M2.5 和 Claude Opus 4.6,統一接口調用,只需切換 model 參數即可快速驗證。

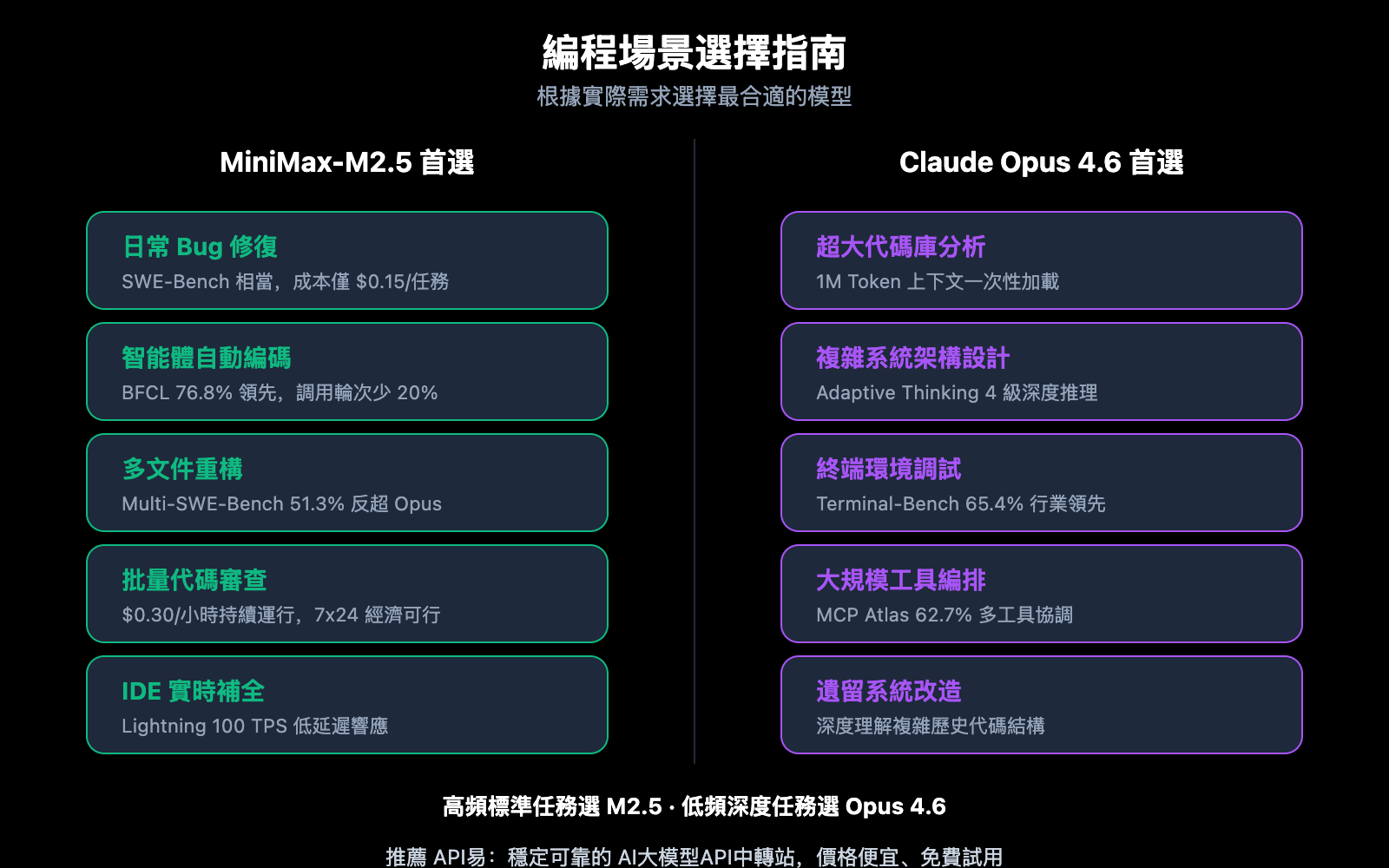

MiniMax-M2.5 與 Opus 4.6 編程場景對比推薦

| 編程場景 | 推薦模型 | 推薦理由 |

|---|---|---|

| 日常 Bug 修復 | MiniMax-M2.5 | SWE-Bench 相當,成本低 20 倍 |

| 多文件重構 | MiniMax-M2.5 | Multi-SWE-Bench 領先 1% |

| 智能體自動編碼 | MiniMax-M2.5 | BFCL 領先 13.5%,每任務 $0.15 |

| 批量代碼審查 | MiniMax-M2.5 | 高吞吐低成本,標準版 $0.30/小時 |

| IDE 實時代碼補全 | MiniMax-M2.5 Lightning | 100 TPS 低延遲 |

| 超大代碼庫分析 | Claude Opus 4.6 | 1M Token 上下文窗口 |

| 複雜系統架構設計 | Claude Opus 4.6 | Adaptive Thinking 深度推理 |

| 終端環境複雜操作 | Claude Opus 4.6 | Terminal-Bench 65.4% 領先 |

| 大規模工具編排 | Claude Opus 4.6 | MCP Atlas 62.7% 領先 |

MiniMax-M2.5 最佳編程場景

MiniMax-M2.5 的優勢集中在"高頻、標準化、成本敏感"的編程任務:

- CI/CD 自動修復: 持續運行的智能體監控和修復流水線,$0.30/小時的成本使 7×24 運行經濟可行

- PR Review Bot: 自動審查 Pull Request,BFCL 76.8% 確保多輪工具交互精準

- 多語言全棧開發: 支持 10+ 編程語言(Python、Go、Rust、TypeScript、Java 等),覆蓋 Web/Android/iOS/Windows

- 批量代碼遷移: 利用 Multi-SWE-Bench 51.3% 的多文件協作能力處理大規模重構

Claude Opus 4.6 最佳編程場景

Claude Opus 4.6 的優勢集中在"低頻、高複雜度、深度推理"的編程任務:

- 架構決策輔助: 利用 Adaptive Thinking(max 模式)進行深度技術方案分析

- 遺留系統改造: 1M Token 上下文一次性加載整個大型代碼庫

- 系統級調試: Terminal-Bench 65.4% 在終端環境下定位和解決複雜系統問題

- 多工具編排平臺: MCP Atlas 62.7% 協調 IDE、Git、CI/CD、監控等多工具協同

對比說明: 以上場景推薦基於基準測試數據和實際開發者反饋。不同項目的實際效果可能有所差異,建議通過 API易 apiyi.com 進行實際場景驗證。

MiniMax-M2.5 對比 Opus 4.6 編程成本全面對比

對於開發團隊來說,AI 編程助手的長期成本是決策的關鍵因素。

| 成本場景 | MiniMax-M2.5 標準版 | MiniMax-M2.5 Lightning | Claude Opus 4.6 |

|---|---|---|---|

| 輸入價格/M tokens | $0.15 | $0.30 | $5.00 |

| 輸出價格/M tokens | $1.20 | $2.40 | $25.00 |

| 單個 SWE-Bench 任務 | ~$0.15 | ~$0.30 | ~$3.00 |

| 持續運行 1 小時 | $0.30 | $1.00 | ~$30+ |

| 每月全天候運行 | ~$216 | ~$720 | ~$21,600+ |

| $100 預算完成任務數 | ~328 個 | ~164 個 | ~30 個 |

以一箇中等規模的開發團隊爲例:如果每天需要處理 50 個編碼任務(Bug 修復、代碼審查、功能實現),使用 MiniMax-M2.5 標準版月成本約 $225,Lightning 版約 $450,而 Claude Opus 4.6 則需要約 $4,500。三者完成任務的質量在 SWE-Bench 層面幾乎相同。

🎯 成本建議: 對於大多數標準編程任務,MiniMax-M2.5 的性價比優勢明顯。建議通過 API易 apiyi.com 平臺實際測試後選擇,平臺支持靈活切換模型,無需更改代碼架構。參與充值活動還可享受更優惠的價格。

MiniMax-M2.5 對比 Opus 4.6 編程快速接入

以下代碼展示如何通過統一接口在兩個模型之間快速切換對比:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# 測試 MiniMax-M2.5

m25_response = client.chat.completions.create(

model="MiniMax-M2.5",

messages=[{"role": "user", "content": "用 Go 實現一個併發安全的 LRU 緩存"}]

)

# 測試 Claude Opus 4.6 - 只需切換 model 參數

opus_response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[{"role": "user", "content": "用 Go 實現一個併發安全的 LRU 緩存"}]

)

查看完整對比測試代碼

from openai import OpenAI

import time

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

def benchmark_model(model_name: str, prompt: str) -> dict:

"""

對單個模型進行編碼能力測試

Args:

model_name: 模型 ID

prompt: 編碼任務提示詞

Returns:

包含響應內容、耗時的字典

"""

start = time.time()

response = client.chat.completions.create(

model=model_name,

messages=[

{"role": "system", "content": "你是一位資深軟件工程師"},

{"role": "user", "content": prompt}

],

max_tokens=4096

)

elapsed = time.time() - start

return {

"model": model_name,

"content": response.choices[0].message.content,

"tokens": response.usage.completion_tokens,

"time": round(elapsed, 2)

}

# 編碼任務

task = "重構以下函數,使其支持併發安全、超時控制和優雅降級"

# 對比測試

models = ["MiniMax-M2.5", "MiniMax-M2.5-Lightning", "claude-opus-4-6-20250205"]

for m in models:

result = benchmark_model(m, task)

print(f"[{result['model']}] {result['tokens']} tokens in {result['time']}s")

建議: 通過 API易 apiyi.com 一個 API Key 即可同時訪問 MiniMax-M2.5 和 Claude Opus 4.6,快速對比兩者在你的實際編碼場景中的表現差異。

常見問題

Q1: MiniMax-M2.5 能完全替代 Claude Opus 4.6 做編程嗎?

不能完全替代,但在大部分場景下可以。SWE-Bench 差距僅 0.6%,Multi-SWE-Bench M2.5 還領先 1%,日常 Bug 修復、代碼審查、功能實現等標準任務兩者幾乎無差異。但在超大代碼庫分析(需要 1M 上下文)、複雜系統級調試(Terminal-Bench)等場景下,Opus 4.6 仍有優勢。建議根據實際場景混合使用。

Q2: 爲什麼 M2.5 的 BFCL 遠高於 Opus 4.6,但編碼得分接近?

BFCL 測試的是多輪工具調用能力(Function Calling),而 SWE-Bench 測試的是端到端編碼能力。Opus 4.6 雖然單輪工具調用不如 M2.5 精準,但其強大的深度推理能力彌補了工具調用效率的不足,最終在整體編碼質量上保持接近。不過,在智能體自動編程場景中,M2.5 的高 BFCL 分數意味着更少的調用輪次和更低的總成本。

Q3: 如何快速對比兩個模型的編程效果?

推薦通過 API易 apiyi.com 進行對比測試:

- 註冊賬號並獲取 API Key

- 使用本文的代碼示例,對同一編碼任務分別調用兩個模型

- 對比生成代碼的質量、響應速度和 Token 消耗

- 統一的 OpenAI 兼容接口,切換模型只需修改 model 參數

總結

MiniMax-M2.5 對比 Claude Opus 4.6 編程能力的核心結論:

- 編碼質量幾乎持平: SWE-Bench 80.2% vs 80.8%,差距 0.6%;Multi-SWE-Bench M2.5 反超 1%

- 工具調用 M2.5 大幅領先: BFCL 76.8% vs 63.3%,智能體編程場景首選 M2.5

- 成本差距懸殊: M2.5 單任務 $0.15 vs Opus $3.00,同等預算可完成 10 倍以上任務

- Opus 4.6 在深度任務中不可替代: 1M 上下文、Terminal-Bench、MCP Atlas 等場景仍有優勢

對於大多數日常編程任務,MiniMax-M2.5 提供了接近 Opus 4.6 的編碼質量和遠優於 Opus 的性價比。建議通過 API易 apiyi.com 在實際項目中對比驗證,平臺支持兩個模型的統一接口調用,還可參與充值活動享受優惠。

📚 參考資料

⚠️ 鏈接格式說明: 所有外鏈使用

資料名: domain.com格式,方便複製但不可點擊跳轉,避免 SEO 權重流失。

-

MiniMax M2.5 官方公告: M2.5 核心能力和編碼基準測試詳情

- 鏈接:

minimax.io/news/minimax-m25 - 說明: 包含 SWE-Bench、Multi-SWE-Bench、BFCL 等完整數據

- 鏈接:

-

Claude Opus 4.6 官方發佈: Anthropic 發佈的 Opus 4.6 技術細節

- 鏈接:

anthropic.com/news/claude-opus-4-6 - 說明: Terminal-Bench、MCP Atlas、Adaptive Thinking 等能力說明

- 鏈接:

-

OpenHands M2.5 評測: 獨立開發者平臺對 M2.5 的實際編碼評測

- 鏈接:

openhands.dev/blog/minimax-m2-5-open-weights-models-catch-up-to-claude - 說明: 首個超越 Claude Sonnet 的開源模型實測分析

- 鏈接:

-

VentureBeat 深度對比: M2.5 與 Opus 4.6 的性價比分析

- 鏈接:

venturebeat.com/technology/minimaxs-new-open-m2-5-and-m2-5-lightning-near-state-of-the-art-while - 說明: 從企業視角分析兩者的成本效益差異

- 鏈接:

-

Vellum Opus 4.6 基準分析: Claude Opus 4.6 全面基準測試解讀

- 鏈接:

vellum.ai/blog/claude-opus-4-6-benchmarks - 說明: Terminal-Bench、SWE-Bench 等核心編碼基準詳細分析

- 鏈接:

作者: APIYI Team

技術交流: 歡迎在評論區分享你的模型對比測試結果,更多 AI 編程模型接入教程可訪問 API易 apiyi.com 技術社區