想一次性分析整個代碼倉庫或處理數百頁技術文檔,卻總被上下文窗口限制卡住?Claude Opus 4.6 帶來了 100 萬 Token 的超大上下文窗口,這是 Opus 系列模型的首次突破——相當於一次性處理約 75 萬字的文本內容。

核心價值: 讀完本文,你將學會如何開啓 Claude 4.6 的 1M Token 上下文窗口、理解長上下文定價策略,並掌握 5 大高價值實戰應用場景。

Claude 4.6 上下文窗口核心參數一覽

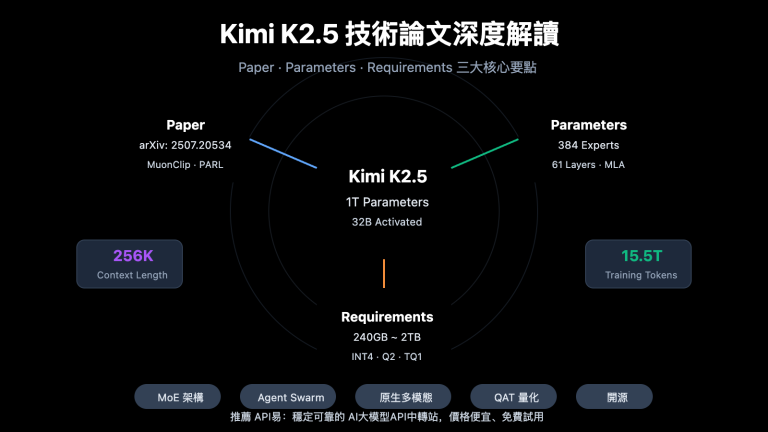

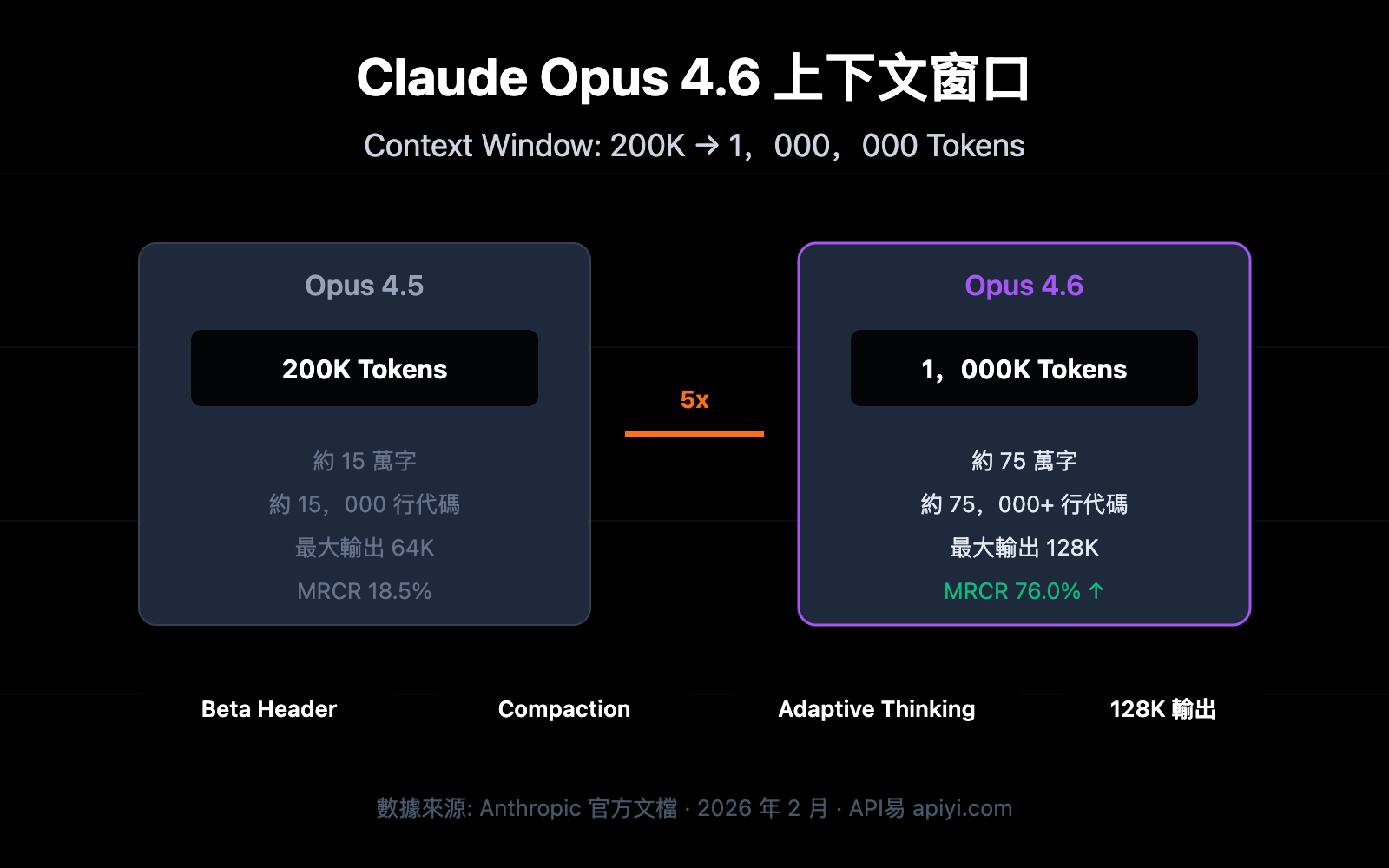

Claude Opus 4.6 於 2026 年 2 月 5 日發佈,最引人注目的升級就是上下文窗口的大幅擴展。以下是核心參數:

| 參數項 | Claude Opus 4.6 | 上一代 Opus 4.5 | 提升幅度 |

|---|---|---|---|

| 默認上下文窗口 | 200K Token | 200K Token | 持平 |

| Beta 擴展窗口 | 1,000K (1M) Token | 不支持 | 首次支持 |

| 最大輸出 Token | 128K Token | 64K Token | 2 倍提升 |

| MRCR v2 基準 (1M) | 76.0% | 18.5% | 約 4 倍提升 |

| MRCR v2 基準 (256K) | 93.0% | — | 極高準確率 |

| 推薦思維模式 | Adaptive Thinking | — | 新增特性 |

🎯 關鍵信息: Claude Opus 4.6 的 1M 上下文窗口目前處於 Beta 階段,需要通過特定 API Header 開啓。默認情況下仍使用 200K 上下文窗口。通過 API易 apiyi.com 平臺可以快速測試不同上下文長度下的模型表現。

Claude 4.6 上下文窗口的 3 個關鍵突破

突破一:Opus 系列首次支持 1M 上下文

在 Claude Opus 4.6 之前,100 萬 Token 上下文窗口僅對 Sonnet 系列模型(Sonnet 4 和 Sonnet 4.5)開放。Opus 4.6 是首個支持 1M 上下文的 Opus 旗艦模型,這意味着你可以將 Opus 的強大推理能力與超大上下文結合使用。

具體來說,1M Token 大約等於:

| 內容類型 | 可容納量 | 典型場景 |

|---|---|---|

| 純文本 | 約 75 萬字 | 完整技術文檔庫 |

| 代碼 | 約 75,000+ 行 | 完整代碼倉庫 |

| PDF 文檔 | 數十份研究論文 | 批量文獻綜述 |

| 對話記錄 | 數百輪對話 | 超長會話保持 |

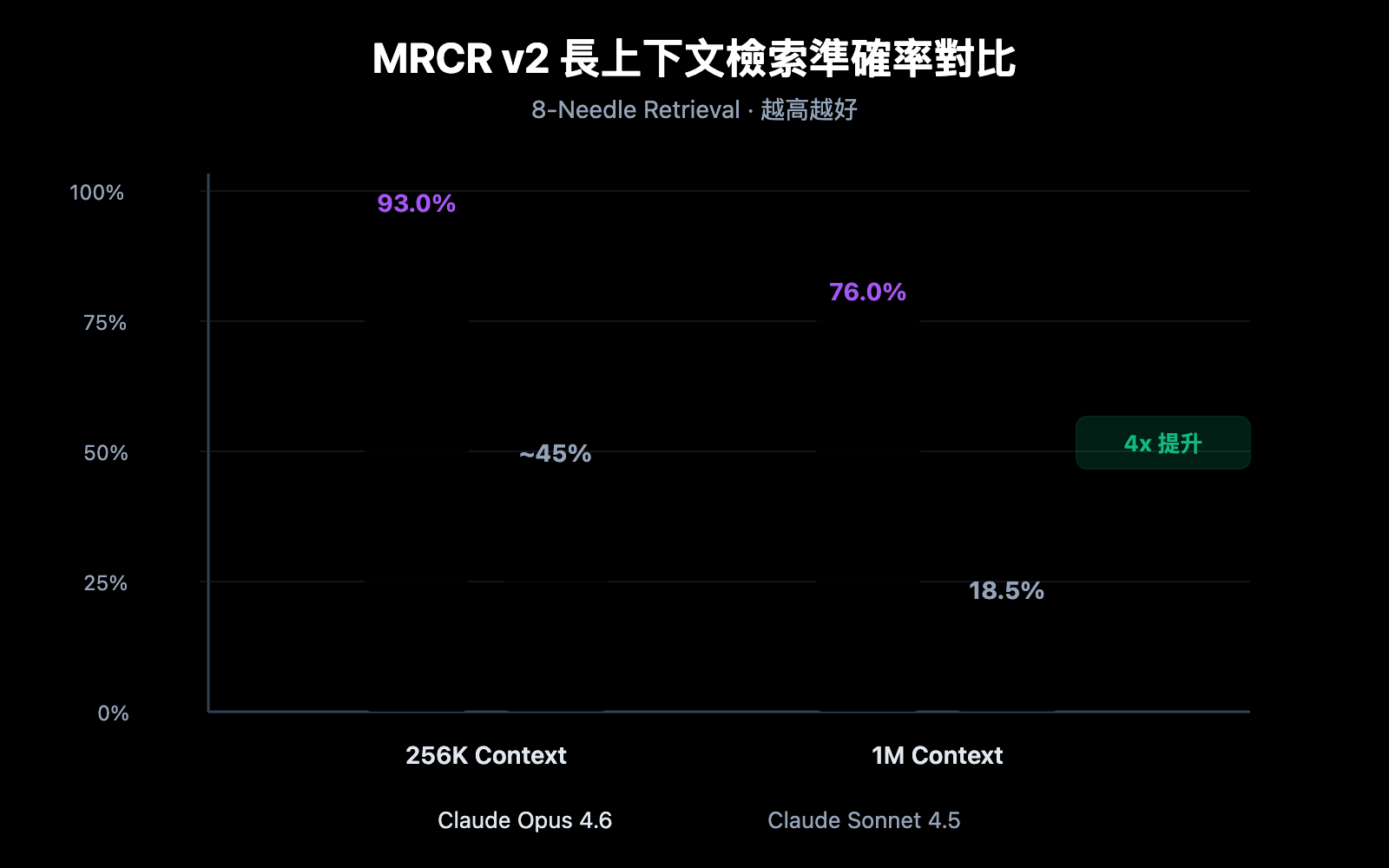

突破二:長上下文檢索準確率飆升

上下文窗口大是一回事,能不能在大窗口中準確找到信息是另一回事。Claude Opus 4.6 在 MRCR v2(Multi-needle Retrieval with Contextual Reasoning)基準測試中表現驚人:

- 256K Token 上下文: 準確率達到 93.0%

- 1M Token 上下文 (8 針): 準確率達到 76.0%

MRCR v2 是一個"大海撈針"式測試——將 8 條關鍵信息藏在 100 萬 Token 的文本中,要求模型全部找出。Claude Opus 4.6 的 76% 準確率相比 Sonnet 4.5 的 18.5% 有質的飛躍,可靠性提升約 4-9 倍。

突破三:Compaction 機制實現無限對話

Claude Opus 4.6 引入了 Compaction(上下文壓縮)機制,這是一項服務端自動上下文摘要功能:

- 當對話接近上下文窗口上限時,API 自動總結較早的對話內容

- 無需手動管理上下文、不需要滑動窗口或截斷策略

- 理論上支持無限長度的對話

這對 Agent 工作流特別有價值——涉及大量工具調用和長推理鏈的場景中,Compaction 可以顯著降低維護對話狀態的開銷。

Claude 4.6 上下文窗口開啓方法

第一步:確認賬戶資格

1M Token 上下文窗口目前爲 Beta 功能,僅對以下用戶開放:

- Usage Tier 4 及以上的組織

- 擁有自定義速率限制的組織

你可以在 Anthropic Console 中查看當前的 Usage Tier 等級。

第二步:添加 Beta Header

要啓用 1M 上下文窗口,需要在 API 請求中添加特定的 Beta Header:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 通過 API易 統一接口調用

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "分析以下完整代碼倉庫..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

如果你直接使用 Anthropic SDK,對應的 curl 請求如下:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "你的超長文本內容..."}

]

}'

🚀 快速開始: 推薦使用 API易 apiyi.com 平臺快速測試 Claude Opus 4.6 的長上下文能力。平臺提供統一的 API 接口,無需分別對接多家服務商,5 分鐘即可完成集成。

第三步:驗證上下文窗口

發送請求後,可以通過返回的 usage 字段確認實際使用的 Token 數量:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

如果 input_tokens 超過 200,000 而請求成功,說明 1M 上下文窗口已正確啓用。

查看完整 Python 代碼示例(含 Token 統計)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # API易 統一接口

)

# 讀取大型代碼倉庫文件

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"輸入內容長度: {len(codebase_content)} 字符")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "你是一個資深代碼審查專家,請分析整個代碼倉庫。"

},

{

"role": "user",

"content": f"請分析以下代碼倉庫的架構設計和潛在問題:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"輸入 Token: {response.usage.prompt_tokens}")

print(f"輸出 Token: {response.usage.completion_tokens}")

print(f"\n分析結果:\n{response.choices[0].message.content}")

Claude 4.6 上下文窗口定價詳解

使用 1M 上下文窗口涉及分層定價機制。當請求 Token 超過 200K 時,自動切換到長上下文定價:

| 定價層級 | 輸入價格 (每百萬 Token) | 輸出價格 (每百萬 Token) | 適用範圍 |

|---|---|---|---|

| 標準定價 | $5.00 | $25.00 | ≤ 200K Token |

| 長上下文定價 | $10.00 | $37.50 | > 200K Token |

| 價格倍率 | 2x | 1.5x | 自動應用 |

定價計算示例

假設你發送了一個 500K Token 的長文本分析請求,輸出 4,000 Token:

- 輸入費用: 500K × ($10.00 / 1M) = $5.00

- 輸出費用: 4K × ($37.50 / 1M) = $0.15

- 單次請求總費用: $5.15

💰 成本優化建議: 對於需要頻繁使用長上下文的項目,可以通過 API易 apiyi.com 平臺調用 Claude Opus 4.6 API。平臺提供靈活的計費方式和更優惠的價格,幫助中小團隊有效控制成本。

善用 Context Caching 降低成本

如果你的應用場景涉及重複查詢同一批文檔(如"與文檔對話"類應用),可以利用 Context Caching 功能:

- 首次上傳文檔按標準價格計費

- 後續基於緩存內容的查詢享受折扣價

- 適合批量文檔分析、知識庫問答等高頻場景

Claude 4.6 上下文窗口成本控制最佳實踐

| 優化策略 | 說明 | 預計節省 |

|---|---|---|

| 按需使用 1M | 僅在確實需要超長上下文時啓用 Beta Header | 避免 2x 輸入溢價 |

| Context Caching | 對重複查詢的文檔使用緩存 | 40-60% 輸入成本 |

| 預過濾輸入 | 上傳前去除無關內容(註釋、空行等) | 10-30% Token 消耗 |

| 分層策略 | 簡單任務用 Sonnet,複雜任務用 Opus | 整體成本降低 50%+ |

| 輸出長度控制 | 設置合理的 max_tokens 避免冗餘輸出 | 減少輸出費用 |

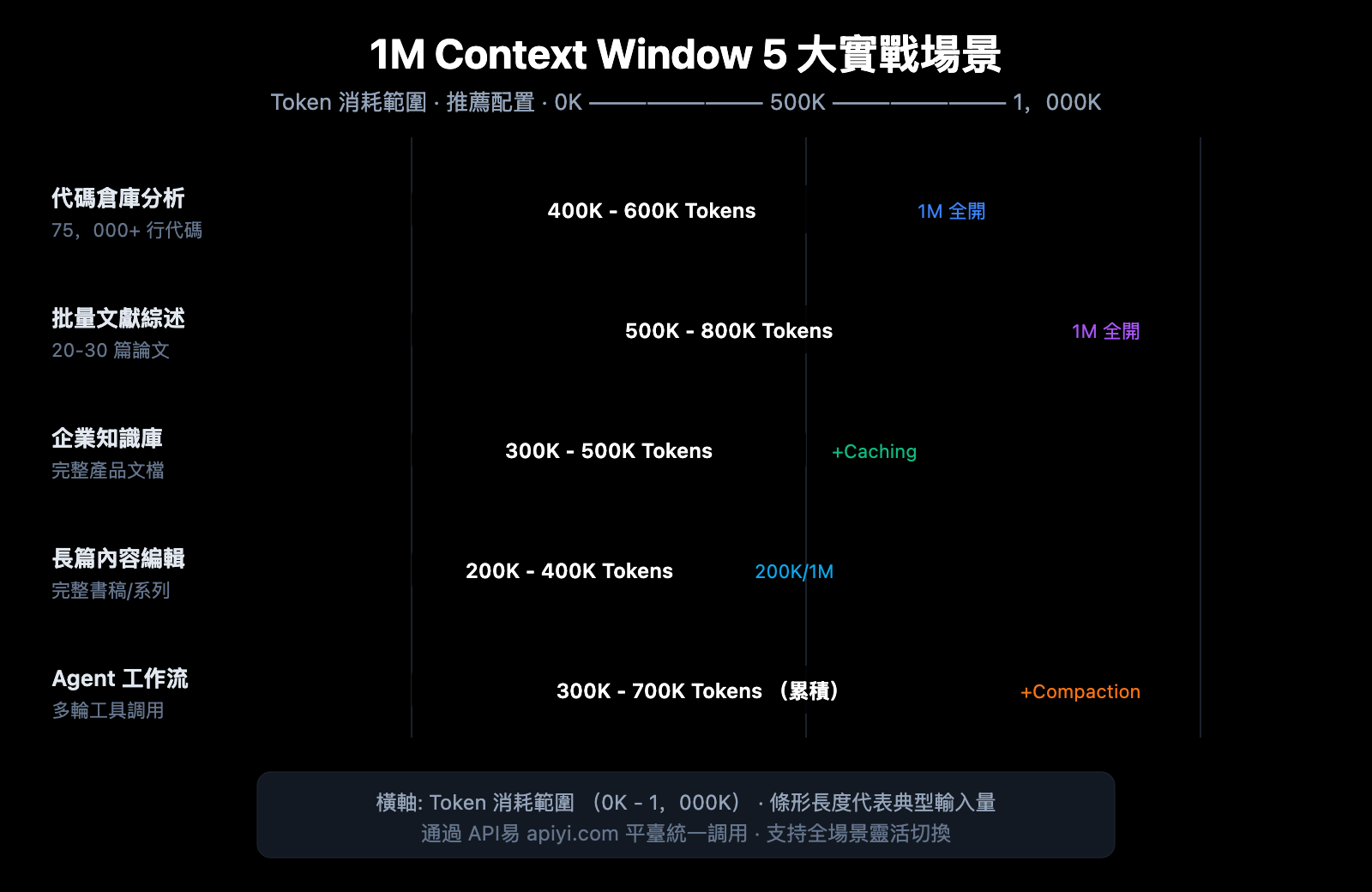

Claude 4.6 上下文窗口 5 大實戰場景

場景一:全代碼倉庫分析

輸入規模: 5-7.5 萬行代碼 (約 400K-600K Token)

這是 1M 上下文窗口最直接的受益場景。將整個項目的源代碼一次性提交給 Claude Opus 4.6,可以實現:

- 全局架構審查:識別跨模塊的設計問題

- 依賴關係分析:找出循環依賴和過度耦合

- 安全漏洞掃描:在完整上下文中發現跨文件的安全風險

- 重構建議:基於全局理解給出重構方案

過去處理大型代碼倉庫時,開發者不得不將代碼分成多個片段逐步分析,導致模型無法理解跨文件的依賴關係。現在,你可以直接將整個 monorepo 的核心代碼一次性提交,讓 Claude 像一個真正理解全局的架構師一樣給出建議。

場景二:批量文獻綜述

輸入規模: 20-30 篇論文 (約 500K-800K Token)

研究人員可以一次性輸入數十篇相關論文,讓 Claude 進行:

- 交叉引用分析:識別論文間的引用關係和觀點衝突

- 研究趨勢總結:從大量文獻中提取方法論演進

- Gap 分析:發現現有研究的空白領域

- 元分析輔助:橫向對比不同研究的實驗設計和結果

對於科研工作者來說,手動閱讀 30 篇論文可能需要數週時間。藉助 1M 上下文窗口,可以在幾分鐘內完成初步篩選和關鍵信息提取,極大加速文獻調研效率。

場景三:企業知識庫問答

輸入規模: 完整產品文檔庫 (約 300K-500K Token)

將企業內部文檔全量載入上下文,實現:

- 精確回答:基於完整文檔庫給出準確答案

- 跨文檔關聯:發現不同文檔間的信息關聯

- 實時更新:無需預處理向量化,直接使用最新文檔

- 多文檔推理:綜合多份技術文檔回答複雜問題

相比傳統的 RAG(檢索增強生成)方案,全量上下文方案省去了向量化、索引構建和檢索調優的工程開銷。對於文檔量在 1M Token 以內的中小型知識庫,直接使用長上下文是更簡單高效的方案。

場景四:長篇內容創作與編輯

輸入規模: 完整書稿或系列文章 (約 200K-400K Token)

- 一致性審查:確保長篇內容前後邏輯一致

- 風格統一:在完整上下文中保持語言風格一致

- 結構優化:基於全文理解提出章節調整建議

- 術語規範:在全書範圍內統一專業術語的使用

例如,一本 20 萬字的技術書籍約佔 300K Token,完全可以在一次請求中讓 Claude 審閱全稿並指出前後矛盾的地方。

場景五:複雜 Agent 工作流

輸入規模: 多輪工具調用記錄 (累積 300K-700K Token)

配合 Claude 4.6 的 Agent Teams 功能:

- 長鏈推理:在複雜多步任務中保持完整推理鏈

- 工具調用記憶:記住所有歷史工具調用結果

- 結合 Compaction:超長工作流自動壓縮上下文

- 多 Agent 協作:在 Agent Teams 中共享上下文信息

Agent 工作流是 Claude Opus 4.6 的核心使用場景之一。在執行復雜任務時(如自動化代碼審查、數據分析流水線),Agent 可能需要調用數十次工具,每次調用的輸入和輸出都會累積在上下文中。1M 窗口確保了即使在長時間運行的任務中,Agent 也不會"遺忘"早期的關鍵信息。

🎯 實戰建議: 以上 5 大場景均可通過 API易 apiyi.com 平臺快速驗證效果。平臺支持 Claude Opus 4.6 在內的多種主流模型,提供統一的接口調用體驗,便於在不同場景間靈活切換。

Claude 4.6 上下文窗口與競品對比

瞭解 Claude Opus 4.6 在長上下文領域的競爭力,有助於你做出更合理的技術選型:

| 模型 | 上下文窗口 | 最大輸出 | 長上下文檢索表現 | 定價 (輸入/輸出) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

可以看出,Claude Opus 4.6 在長上下文檢索準確率方面具有明顯優勢。雖然定價較高,但在需要精確檢索和複雜推理的場景中,其可靠性遠超競品。

💡 選擇建議: 選擇哪個模型主要取決於您的具體場景需求。如果優先考慮長上下文下的推理質量,Claude Opus 4.6 是目前的最優選擇。我們建議通過 API易 apiyi.com 平臺進行實際測試對比,該平臺支持以上多種主流模型的統一接口調用,便於快速切換和評估。

Claude 4.6 上下文窗口 Compaction 配置

Compaction 是 Claude Opus 4.6 新增的服務端上下文壓縮功能,可以讓對話理論上無限延續。

工作原理

- API 監測每輪對話的 Token 使用量

- 當輸入 Token 超過設定閾值時,自動觸發摘要

- 模型生成

<summary>標籤包裹的對話摘要 - 摘要替換早期對話內容,釋放上下文空間

配置方法

在 API 請求中添加 compaction_control 參數:

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # 觸發閾值

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Compaction 與 1M 上下文的配合策略

| 策略 | 上下文窗口 | Compaction | 適用場景 |

|---|---|---|---|

| 超大單次分析 | 1M (全開) | 關閉 | 代碼審查、文獻綜述 |

| 長期對話 | 200K (默認) | 開啓 | 客服、助手、Agent |

| 混合模式 | 1M + Compaction | 開啓 | 超複雜 Agent 工作流 |

常見問題

Q1: Claude 4.6 的上下文窗口默認就是 1M 嗎?

不是。Claude Opus 4.6 的默認上下文窗口仍然是 200K Token,與上一代 Opus 4.5 相同。要使用 1M Token 上下文窗口,需要在 API 請求中添加 anthropic-beta: context-1m-2025-08-07 Header。此外,你的組織需要達到 Usage Tier 4 或擁有自定義速率限制。通過 API易 apiyi.com 平臺調用時,可以方便地在請求中添加此 Header。

Q2: 使用 1M 上下文窗口會額外收費嗎?

是的,存在分層定價。當請求超過 200K Token 時,輸入價格從 $5/M 升至 $10/M(2 倍),輸出價格從 $25/M 升至 $37.50/M(1.5 倍)。對於預算敏感的項目,建議通過 API易 apiyi.com 平臺獲取更優惠的價格方案。

Q3: 1M 上下文中能準確找到特定信息嗎?

Claude Opus 4.6 在 MRCR v2 基準測試中表現優異。在 1M Token 上下文中隱藏 8 條關鍵信息的測試場景下,準確率達到 76%,是 Sonnet 4.5(18.5%)的約 4 倍。在 256K 上下文中,準確率更是高達 93%。這意味着 Claude Opus 4.6 是目前長上下文檢索最可靠的模型之一。

Q4: Compaction 會影響回答質量嗎?

Compaction 通過智能摘要來壓縮早期對話內容,在大多數場景下不會顯著影響回答質量。但對於需要精確引用早期對話細節的場景,建議關閉 Compaction 並直接使用 1M 上下文窗口。在 Agent 工作流中,Compaction 可以顯著提升效率,推薦開啓。

Q5: 哪些 Claude 模型支持 1M 上下文?

目前支持 1M Token 上下文窗口的 Claude 模型有 3 個:Claude Opus 4.6、Claude Sonnet 4.5 和 Claude Sonnet 4。其中 Opus 4.6 的長上下文檢索準確率遠高於 Sonnet 系列。其他模型如 Claude Haiku 系列目前不支持 1M 上下文。

總結

Claude Opus 4.6 的 1M Token 上下文窗口是一次重要的能力升級,將 Opus 旗艦模型的強大推理能力與超大上下文結合,開啓了全代碼倉庫分析、批量文獻綜述、企業知識庫問答等高價值應用場景。

核心要點回顧:

- 默認 200K,Beta 擴展至 1M: 需要添加

anthropic-beta: context-1m-2025-08-07Header - 長上下文檢索準確率行業領先: MRCR v2 基準 76%(1M)/ 93%(256K)

- 分層定價: 超過 200K 部分輸入價格 2x、輸出價格 1.5x

- Compaction 支持無限對話: 服務端自動上下文壓縮,適合 Agent 工作流

- 3 款模型支持: Opus 4.6、Sonnet 4.5、Sonnet 4

推薦通過 API易 apiyi.com 快速體驗 Claude Opus 4.6 的長上下文能力,平臺支持統一接口調用多種主流 AI 模型,助力開發者高效完成技術驗證和產品集成。

本文由 APIYI Team 撰寫,專注 AI 大模型技術分享。更多教程和 API 使用指南,請訪問 API易幫助中心: help.apiyi.com

參考資料

-

Anthropic 官方博客 – Introducing Claude Opus 4.6

- 鏈接:

anthropic.com/news/claude-opus-4-6 - 說明: Claude Opus 4.6 發佈公告和核心特性介紹

- 鏈接:

-

Claude API 文檔 – Context Windows

- 鏈接:

platform.claude.com/docs/en/build-with-claude/context-windows - 說明: 上下文窗口配置和使用指南

- 鏈接:

-

Claude API 文檔 – Compaction

- 鏈接:

platform.claude.com/docs/en/build-with-claude/compaction - 說明: Compaction 上下文壓縮功能詳解

- 鏈接:

-

Claude API 文檔 – Pricing

- 鏈接:

platform.claude.com/docs/en/about-claude/pricing - 說明: 模型定價和長上下文定價說明

- 鏈接: