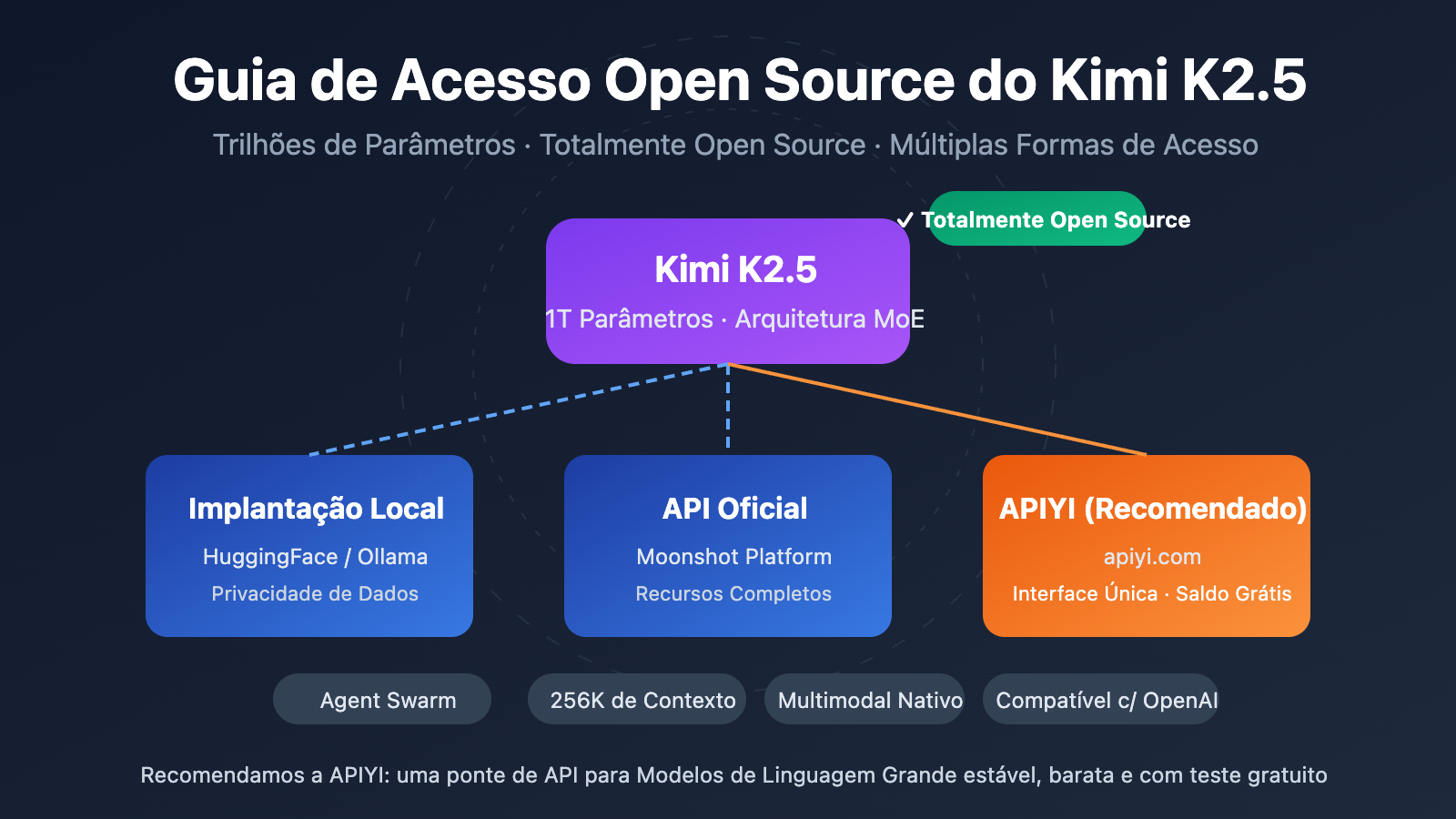

Nota do autor: O Kimi K2.5 já está totalmente em código aberto. Este artigo detalha a licença de código aberto, o download do modelo, os métodos de acesso à API e fornece um exemplo de código completo para chamar rapidamente o Kimi K2.5 através da APIYI.

O Kimi K2.5 é open source? Esta é a pergunta que mais preocupa muitos desenvolvedores recentemente. A boa notícia é que a Moonshot AI lançou oficialmente e abriu totalmente o código do Kimi K2.5 em 26 de janeiro de 2026, incluindo o código e os pesos do modelo, sob a licença Modified MIT License.

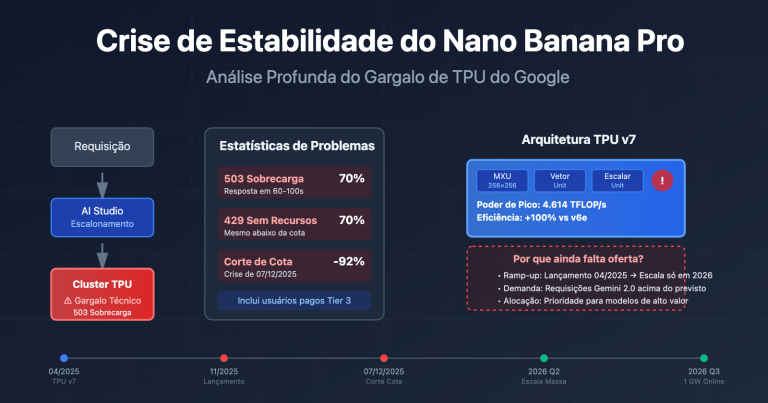

Valor Central: Ao ler este artigo, você entenderá os detalhes do código aberto do Kimi K2.5 e dominará 3 formas de acesso — autohospedagem, API oficial e plataformas de terceiros (como a APIYI apiyi.com) — para usar rapidamente este Modelo de Linguagem Grande Agente multimodal de trilhões de parâmetros em seu projeto.

Pontos Chave do Código Aberto do Kimi K2.5

| Ponto Chave | Descrição | Benefícios para o Desenvolvedor |

|---|---|---|

| Totalmente Open Source | Código + Pesos abertos, Licença MIT Modificada | Uso comercial, implantação local e ajuste fino (fine-tuning) |

| MoE de Trilhões de Parâmetros | 1T de parâmetros totais, 32B ativos | Desempenho comparável a modelos fechados, com custo menor |

| Multimodal Nativo | Suporte para compreensão de imagens, vídeos e documentos | Um único modelo cobre diversos tipos de entrada |

| Agent Swarm | Até 100 sub-agentes paralelos | Eficiência em tarefas complexas aumentada em 4,5 vezes |

| Compatível com OpenAI | Formato de API totalmente compatível com OpenAI | Migração de código existente com custo quase zero |

Detalhes da Licença Open Source do Kimi K2.5

O Kimi K2.5 utiliza a licença Modified MIT License, o que significa:

- Uso Comercial: Permitido o uso em produtos comerciais sem a necessidade de pagar taxas de licenciamento.

- Modificação e Distribuição: Você pode modificar o modelo e distribuí-lo novamente.

- Implantação Local: Suporte total para implantação privada, onde os dados não saem do ambiente local.

- Ajuste Fino (Fine-tuning): É possível realizar o ajuste fino em domínios específicos baseando-se nos pesos de código aberto.

Diferente das licenças restritivas da série LLaMA, a licença do Kimi K2.5 é mais amigável para os desenvolvedores, sendo ideal para cenários de aplicações empresariais.

Onde Obter Recursos do Kimi K2.5

Os pesos do modelo e o código podem ser obtidos através dos seguintes canais:

| Recurso | Endereço | Descrição |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

Pesos oficiais, suporte para transformers 4.57.1+ |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

Imagem de implantação otimizada |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

Espelho local (China), download mais rápido |

| Ollama | ollama.com/library/kimi-k2.5 |

Execução local em um clique |

Existem três formas principais de integrar o Kimi K2.5: implantação própria (self-hosting), API oficial e plataformas de terceiros. Para a maioria dos desenvolvedores, recomendamos o acesso via API, pois permite validar os resultados rapidamente sem a necessidade de recursos de GPU.

Exemplo Minimalista

Abaixo está o código mais simples para chamar o Kimi K2.5 através da plataforma APIYI, rodando em apenas 10 linhas:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # Obtenha em apiyi.com

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "Explique os princípios básicos da computação quântica"}]

)

print(response.choices[0].message.content)

Ver código completo do modo Thinking do Kimi K2.5

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

Chama a API do Kimi K2.5

Argumentos:

prompt: entrada do usuário

thinking_mode: se deve ativar o modo de pensamento (raciocínio profundo)

system_prompt: comando do sistema

max_tokens: número máximo de tokens de saída

Retorna:

Um dicionário contendo o processo de raciocínio e a resposta final

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# Configura o modo de raciocínio

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# Exemplo de uso - Modo Thinking

result = call_kimi_k25(

prompt="Qual é maior: 9.11 ou 9.9? Pense com cuidado",

thinking_mode=True

)

print(f"Processo de raciocínio: {result['reasoning']}")

print(f"Resposta final: {result['content']}")

Sugestão: Obtenha créditos de teste gratuitos através da APIYI (apiyi.com) para validar rapidamente a capacidade de raciocínio do Kimi K2.5. A plataforma já disponibiliza o Kimi K2.5 com suporte aos modos Thinking e Instant.

Comparativo de Soluções de Integração do Kimi K2.5

| Solução | Principais Características | Cenários de Uso | Considerações de Custo |

|---|---|---|---|

| Implantação Própria | Dados locais, controle total | Empresas com dados sensíveis | Exige 48GB+ de VRAM (INT4) |

| API Oficial | Desempenho estável, funções completas | Cenários padrão de desenvolvimento e teste | $0.60/M entrada, $3/M saída |

| APIYI | Interface única, troca entre modelos | Validação rápida, sensibilidade a custos | Pagamento por uso, créditos grátis para novos usuários |

Detalhes dos Três Métodos de Integração do Kimi K2.5

Método 1: Implantação Própria Local

Adequado para empresas com recursos de GPU e alta exigência de privacidade de dados. Recomendamos o uso de vLLM ou SGLang para a implantação:

# Implantação em um clique via Ollama (exige 48GB+ de VRAM)

ollama run kimi-k2.5

Método 2: API Oficial

Integre através da plataforma oficial da Moonshot para ter suporte às funções mais recentes:

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

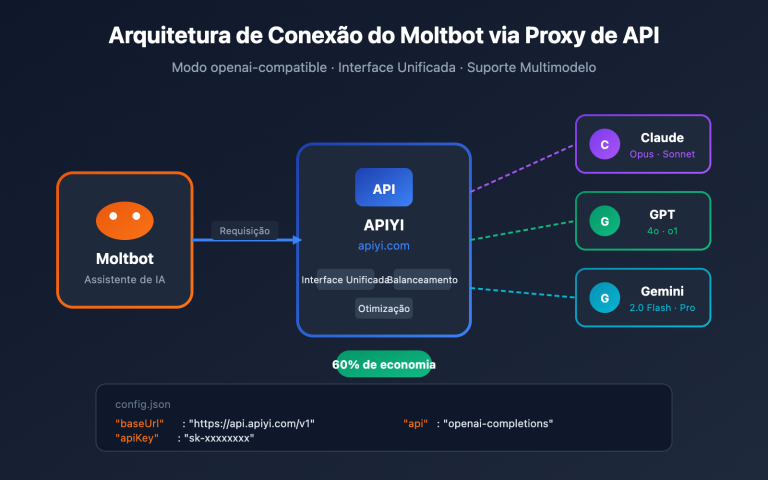

Método 3: Acesso via Plataforma APIYI (Recomendado)

O Kimi K2.5 já está disponível na APIYI (apiyi.com), oferecendo as seguintes vantagens:

- Interface compatível com o formato OpenAI, custo zero de aprendizado.

- Suporte para alternância e comparação rápida com modelos como GPT-4o e Claude.

- Créditos de teste gratuitos para novos usuários.

- Acesso estável e confiável, sem necessidade de proxy.

Dica de integração: Recomendamos validar as funcionalidades e avaliar os resultados primeiro através da APIYI (apiyi.com). Após definir o que melhor se adapta ao seu cenário de negócio, considere a solução de implantação própria.

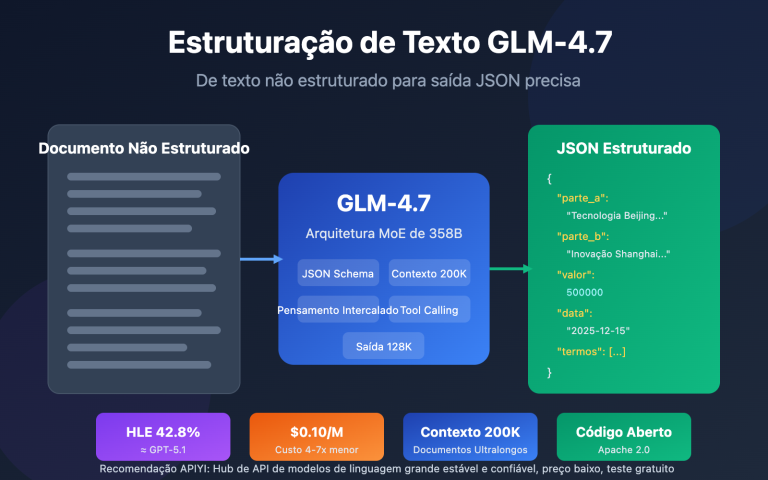

Comparação de custos de API: Kimi K2.5 vs. Concorrentes

| Modelo | Preço de Entrada | Preço de Saída | Custo por requisição única (5K output) | Comparação |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | Referência |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | 38% mais caro |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | 444% mais caro |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | 81% mais caro |

O Kimi K2.5 oferece um desempenho próximo ou até superior a alguns modelos de código fechado, custando apenas cerca de 1/5 do Claude Opus 4.5. É, atualmente, um dos modelos de trilhões de parâmetros com o melhor custo-benefício do mercado.

Perguntas Frequentes

Q1: O Kimi K2.5 é de código aberto? Pode ser usado comercialmente?

Sim, o Kimi K2.5 foi totalmente aberto em 26 de janeiro de 2026, sob a licença Modified MIT License. Tanto o código quanto os pesos do modelo estão disponíveis gratuitamente, suportando uso comercial, modificação e distribuição.

Q2: Qual a diferença entre o modo Thinking e o modo Instant do Kimi K2.5?

O modo Thinking retorna um processo de raciocínio detalhado (reasoning_content), sendo ideal para problemas complexos; o modo Instant fornece a resposta diretamente, com um tempo de resposta mais rápido. Recomendamos usar o modo Thinking para problemas de matemática e lógica, e o modo Instant para conversas cotidianas.

Q3: Como testar rapidamente a integração do Kimi K2.5?

Recomendamos o uso de uma plataforma de agregação de APIs que suporte múltiplos modelos para realizar seus testes:

- Acesse o APIYI (apiyi.com) e crie uma conta.

- Obtenha sua API Key e o saldo gratuito.

- Utilize os exemplos de código deste artigo, configurando o

base_urlparahttps://vip.apiyi.com/v1. - Basta preencher o nome do modelo como

kimi-k2.5para começar a chamá-lo.

Resumo

Pontos centrais para o acesso ao Kimi K2.5 de código aberto:

- Totalmente Open Source: O Kimi K2.5 utiliza a Modified MIT License, permitindo o uso comercial tanto do código quanto dos pesos (weights).

- Múltiplas Formas de Acesso: Suporte para auto-hospedagem (self-hosting), API oficial e plataformas de terceiros — escolha a que melhor atende às suas necessidades.

- Excelente Custo-Benefício: Um Modelo de Linguagem Grande com trilhões de parâmetros, custando apenas 1/5 do Claude Opus 4.5.

O Kimi K2.5 já está disponível no APIYI (apiyi.com). Novos usuários podem obter créditos gratuitos; recomendamos usar a plataforma para validar rapidamente a performance do modelo e avaliar se ele é adequado para o seu cenário de negócio.

Referências

⚠️ Nota sobre o formato dos links: Todos os links externos utilizam o formato

Nome: domain.com. Eles foram formatados assim para facilitar a cópia, mas não são clicáveis, evitando a perda de relevância para SEO.

-

HuggingFace Model Card do Kimi K2.5: Pesos oficiais do modelo e documentação técnica.

- Link:

huggingface.co/moonshotai/Kimi-K2.5 - Descrição: Obtenha os pesos do modelo, guias de implantação e exemplos de uso da API.

- Link:

-

Relatório Técnico do Kimi K2.5: Detalhes sobre a arquitetura do modelo e métodos de treinamento.

- Link:

kimi.com/blog/kimi-k2-5.html - Descrição: Entenda os detalhes técnicos principais, como Agent Swarm e a arquitetura MoE.

- Link:

-

Plataforma Aberta da Moonshot: Documentação oficial da API e SDK.

- Link:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - Descrição: Guia oficial de integração, incluindo informações sobre preços e limites de taxa (rate limits).

- Link:

-

Ollama Kimi K2.5: Solução para implantação local com um clique.

- Link:

ollama.com/library/kimi-k2.5 - Descrição: Ideal para testes locais e cenários de implantação em pequena escala.

- Link:

Autor: Equipe Técnica

Troca de Conhecimento: Sinta-se à vontade para discutir sua experiência com o Kimi K2.5 nos comentários. Para mais comparações de modelos e tutoriais, visite a comunidade técnica do APIYI em apiyi.com.