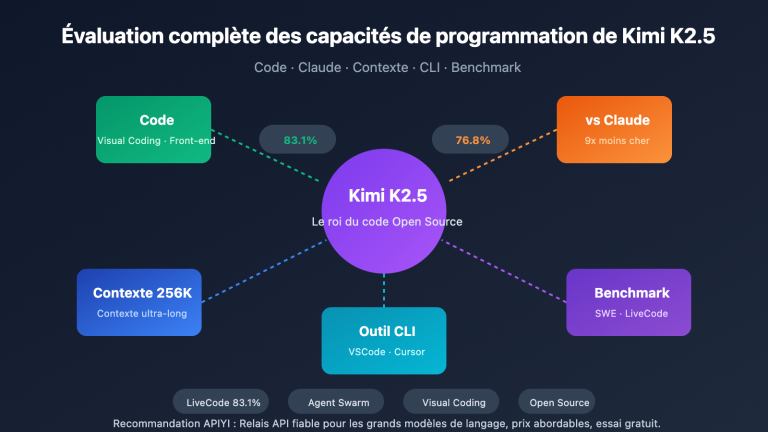

Note de l'auteur : Kimi K2.5 est désormais entièrement open source. Cet article détaille la licence open source, le téléchargement du modèle, les méthodes d'accès à l'API, et fournit un exemple de code complet pour appeler rapidement Kimi K2.5 via APIYI.

Kimi K2.5 est-il open source ? C'est la question que se posent de nombreux développeurs ces derniers temps. Bonne nouvelle : Moonshot AI a officiellement publié et entièrement ouvert le code de Kimi K2.5 le 26 janvier 2026, incluant le code et les poids du modèle, sous licence Modified MIT.

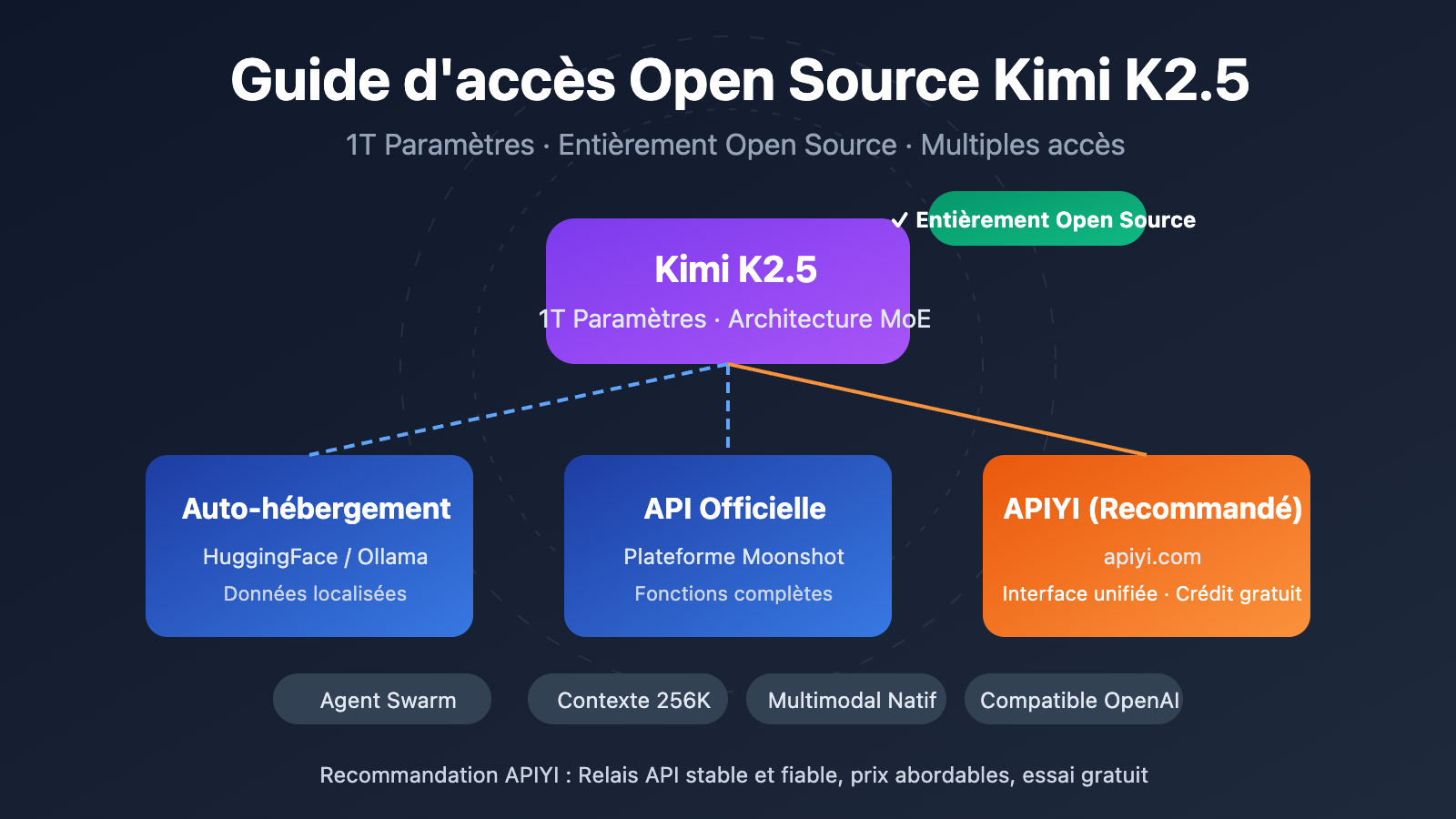

Valeur ajoutée : En lisant cet article, vous découvrirez les détails de l'open source de Kimi K2.5 et maîtriserez 3 modes d'accès — auto-hébergement, API officielle, et plateformes tierces (comme APIYI apiyi.com) — pour intégrer rapidement ce modèle Agent multimodal aux mille milliards de paramètres dans vos projets.

Points clés de l'open source de Kimi K2.5

| Point clé | Description | Bénéfice développeur |

|---|---|---|

| Entièrement Open Source | Code + poids ouverts, Licence Modified MIT | Commercialisable, auto-hébergement, fine-tuning |

| MoE 1T Paramètres | 1000 milliards au total, 32B activés | Performance haut de gamme, coût réduit |

| Multimodal Natif | Supporte images, vidéos, documents | Un seul modèle pour tous types d'entrées |

| Agent Swarm | Jusqu'à 100 sous-agents en parallèle | Efficacité sur tâches complexes x 4,5 |

| Compatible OpenAI | Format API identique à OpenAI | Migration de code sans effort |

Détails de la licence open source de Kimi K2.5

Kimi K2.5 utilise la licence Modified MIT License, ce qui implique :

- Usage commercial : Autorisé dans des produits commerciaux sans frais de licence.

- Modification et distribution : Vous pouvez modifier le modèle et le redistribuer.

- Déploiement local : Support complet du déploiement privé, les données restent en local.

- Fine-tuning : Possibilité de réaliser des entraînements spécifiques sur les poids ouverts.

Contrairement aux licences restrictives de la série LLaMA, la licence de Kimi K2.5 est plus conviviale pour les développeurs, convenant parfaitement aux applications d'entreprise.

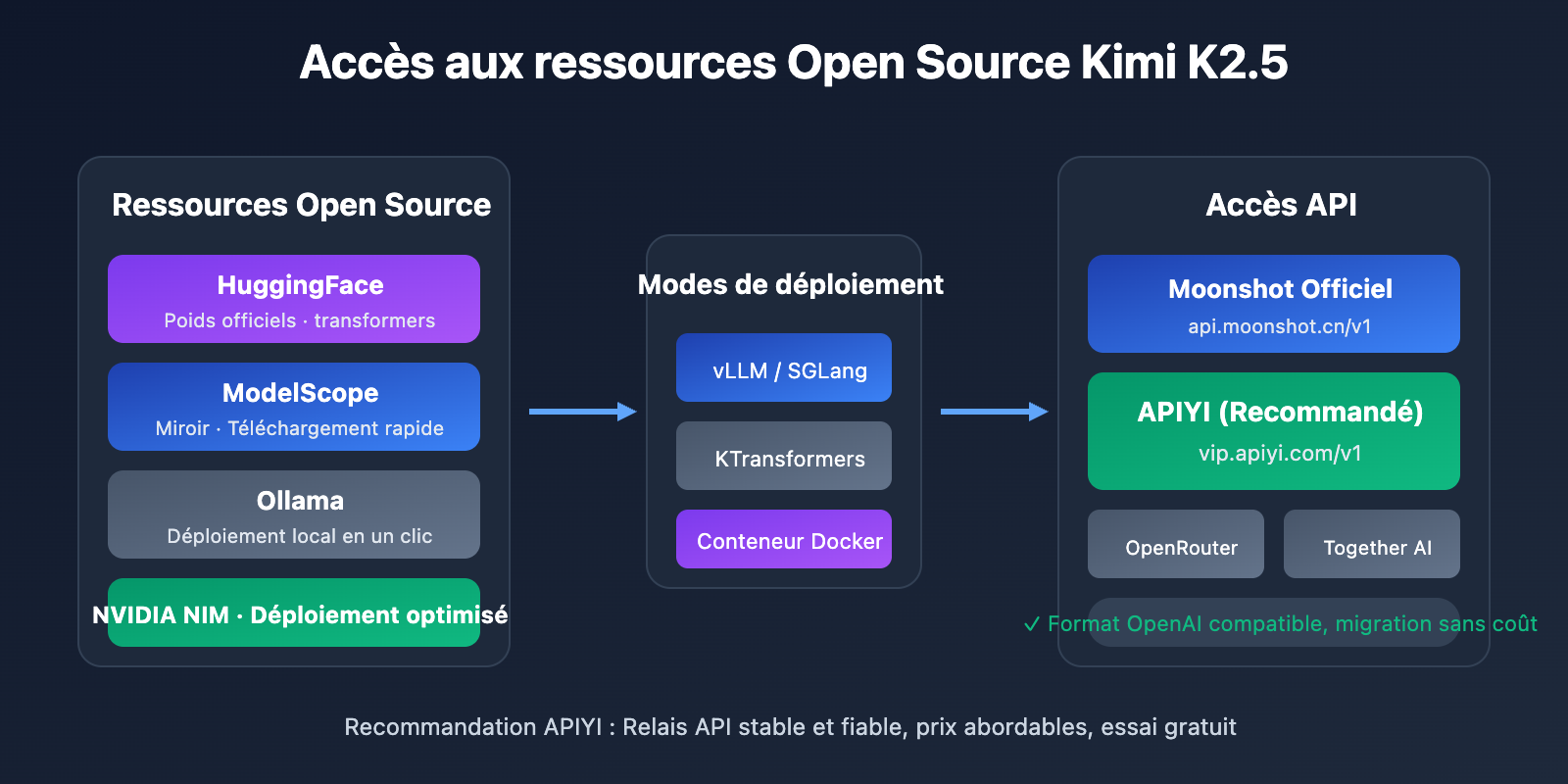

Où trouver les ressources open source Kimi K2.5

Les poids et le code du modèle sont disponibles via les canaux suivants :

| Ressource | Adresse | Description |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

Poids officiels, support transformers 4.57.1+ |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

Images de déploiement optimisées |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

Miroir domestique (Chine), téléchargement rapide |

| Ollama | ollama.com/library/kimi-k2.5 |

Exécution locale en un clic |

Démarrage rapide avec l'intégration de Kimi K2.5

Il existe principalement trois façons d'intégrer Kimi K2.5 : l'auto-hébergement, l'API officielle et les plateformes tierces. Pour la plupart des développeurs, nous recommandons l'accès via API, qui permet de valider rapidement les résultats sans avoir besoin de ressources GPU.

Exemple minimaliste

Voici le code le plus simple pour appeler Kimi K2.5 via la plateforme APIYI, prêt à l'emploi en 10 lignes :

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # À obtenir sur apiyi.com

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "Explique les principes de base de l'informatique quantique"}]

)

print(response.choices[0].message.content)

Voir le code complet du mode Thinking de Kimi K2.5

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

Appeler l'API Kimi K2.5

Args:

prompt: Entrée utilisateur

thinking_mode: Activer ou non le mode réflexion (raisonnement profond)

system_prompt: Invite système

max_tokens: Nombre maximum de tokens en sortie

Returns:

Dictionnaire contenant le processus de raisonnement et la réponse finale

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# Configurer le mode de raisonnement

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# Exemple d'utilisation - Mode Thinking

result = call_kimi_k25(

prompt="Lequel est le plus grand entre 9.11 et 9.9 ? Réfléchis bien",

thinking_mode=True

)

print(f"Processus de raisonnement: {result['reasoning']}")

print(f"Réponse finale: {result['content']}")

Conseil : Obtenez des crédits de test gratuits sur APIYI (apiyi.com) pour vérifier rapidement les capacités de raisonnement de Kimi K2.5. La plateforme a déjà mis en ligne Kimi K2.5, prenant en charge les modes Thinking et Instant.

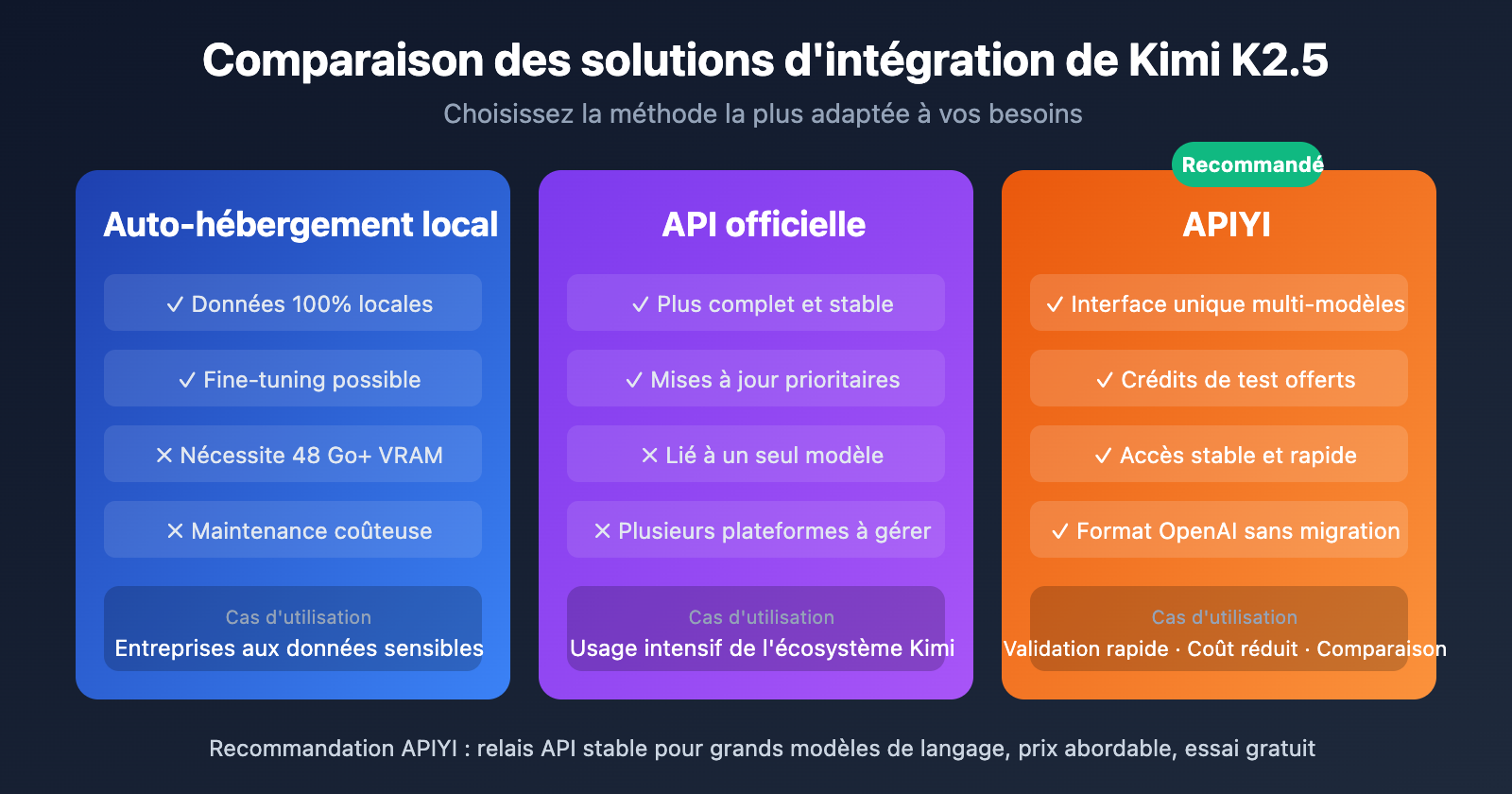

Comparaison des solutions d'intégration de Kimi K2.5

| Solution | Caractéristiques clés | Cas d'utilisation | Considérations de coût |

|---|---|---|---|

| Auto-hébergement | Données locales, contrôle total | Entreprises aux données sensibles | Nécessite 48 Go+ de VRAM (INT4) |

| API officielle | Performance stable, fonctions complètes | Scénarios standard de dév/test | 0,60 $/M entrée, 3 $/M sortie |

| APIYI | Interface unifiée, basculement multi-modèles | Validation rapide, budget limité | Paiement à l'usage, crédits gratuits |

Détails des trois méthodes d'accès à Kimi K2.5

Méthode 1 : Auto-hébergement local

Idéal pour les entreprises disposant de ressources GPU et ayant des exigences élevées en matière de confidentialité des données. Nous recommandons d'utiliser vLLM ou SGLang pour le déploiement :

# Déploiement en un clic avec Ollama (nécessite 48 Go+ de VRAM)

ollama run kimi-k2.5

Méthode 2 : API officielle

Accès via la plateforme officielle de Moonshot pour bénéficier des dernières fonctionnalités :

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

Méthode 3 : Accès via la plateforme APIYI (Recommandé)

Kimi K2.5 est déjà disponible sur APIYI (apiyi.com), offrant les avantages suivants :

- Interface unifiée au format OpenAI, aucun coût d'apprentissage.

- Basculement et comparaison rapides avec des modèles comme GPT-4o, Claude, etc.

- Crédits de test gratuits offerts aux nouveaux utilisateurs.

- Accès stable et rapide, sans besoin de proxy.

Conseil d'intégration : Il est recommandé de commencer par valider les fonctionnalités et d'évaluer les résultats via APIYI (apiyi.com). Une fois que la solution est confirmée pour votre cas d'usage, vous pourrez envisager l'auto-hébergement.

Comparaison des coûts d'API : Kimi K2.5 vs. Concurrents

| Modèle | Prix d'entrée (Input) | Prix de sortie (Output) | Coût par requête (5k tokens de sortie) | Comparaison |

|---|---|---|---|---|

| Kimi K2.5 | 0,60 $/M | 3,00 $/M | ~0,0138 $ | Référence |

| GPT-5.2 | 0,90 $/M | 3,80 $/M | ~0,0190 $ | +38 % |

| Claude Opus 4.5 | 5,00 $/M | 15,00 $/M | ~0,0750 $ | +444 % |

| Gemini 3 Pro | 1,25 $/M | 5,00 $/M | ~0,0250 $ | +81 % |

Tout en offrant des performances proches, voire supérieures, à certains modèles propriétaires, le coût de Kimi K2.5 n'est que d'environ 1/5 de celui de Claude Opus 4.5, ce qui en fait l'un des grands modèles de langage à mille milliards de paramètres offrant le meilleur rapport qualité-prix actuellement.

Foire Aux Questions (FAQ)

Q1 : Kimi K2.5 est-il open-source ? Est-il utilisable à des fins commerciales ?

Oui, Kimi K2.5 a été entièrement rendu open-source le 26 janvier 2026, sous licence MIT modifiée. Le code et les poids du modèle sont accessibles gratuitement, autorisant l'utilisation commerciale, la modification et la distribution.

Q2 : Quelle est la différence entre le mode Thinking et le mode Instant de Kimi K2.5 ?

Le mode Thinking renvoie un processus de raisonnement détaillé (reasoning_content), idéal pour les questions complexes. Le mode Instant donne une réponse directe avec une réactivité accrue. Nous recommandons le mode Thinking pour les problèmes mathématiques ou logiques, et le mode Instant pour les conversations quotidiennes.

Q3 : Comment tester rapidement l’intégration de Kimi K2.5 ?

Nous recommandons d'utiliser une plateforme d'agrégation d'API prenant en charge plusieurs modèles pour vos tests :

- Rendez-vous sur APIYI (apiyi.com) pour créer un compte.

- Obtenez votre clé API et vos crédits gratuits.

- Utilisez les exemples de code de cet article en configurant le

base_urlsurhttps://vip.apiyi.com/v1. - Indiquez

kimi-k2.5comme nom de modèle pour lancer l'appel.

Résumé

Points clés de l'accès open source à Kimi K2.5 :

- Entièrement Open Source : Kimi K2.5 utilise une licence MIT modifiée, le code et les poids sont autorisés pour un usage commercial.

- Plusieurs modes d'accès : Supporte l'auto-hébergement, l'API officielle et les plateformes tierces. À choisir selon vos besoins.

- Rapport qualité-prix exceptionnel : Un modèle de mille milliards de paramètres pour seulement 1/5ème du coût de Claude Opus 4.5.

Kimi K2.5 est déjà disponible sur APIYI (apiyi.com). Les nouveaux utilisateurs peuvent obtenir des crédits gratuits. Nous vous conseillons d'utiliser la plateforme pour tester rapidement les performances du modèle et évaluer s'il convient à vos besoins métier.

Ressources complémentaires

⚠️ Note sur le format des liens : Tous les liens externes utilisent le format

Nom : domain.com. Ils sont faciles à copier mais non cliquables pour éviter la perte de score SEO.

-

Fiche de modèle Kimi K2.5 sur HuggingFace : Poids officiels et documentation technique.

- Lien :

huggingface.co/moonshotai/Kimi-K2.5 - Description : Accès aux poids du modèle, guides de déploiement et exemples d'utilisation de l'API.

- Lien :

-

Rapport technique Kimi K2.5 : Détails sur l'architecture du modèle et la méthode d'entraînement.

- Lien :

kimi.com/blog/kimi-k2-5.html - Description : Pour tout savoir sur l'Agent Swarm, l'architecture MoE et autres détails techniques fondamentaux.

- Lien :

-

Plateforme ouverte Moonshot : Documentation API officielle et SDK.

- Lien :

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - Description : Guide de démarrage officiel, incluant les tarifs et les limites de requêtes.

- Lien :

-

Ollama Kimi K2.5 : Solution de déploiement local en un clic.

- Lien :

ollama.com/library/kimi-k2.5 - Description : Idéal pour les tests en local et les scénarios de déploiement à petite échelle.

- Lien :

Auteur : Équipe technique

Échanges techniques : N'hésitez pas à discuter de votre expérience avec Kimi K2.5 dans la section commentaires. Pour plus de comparatifs de modèles et de tutoriels, rendez-vous sur la communauté technique APIYI (apiyi.com).