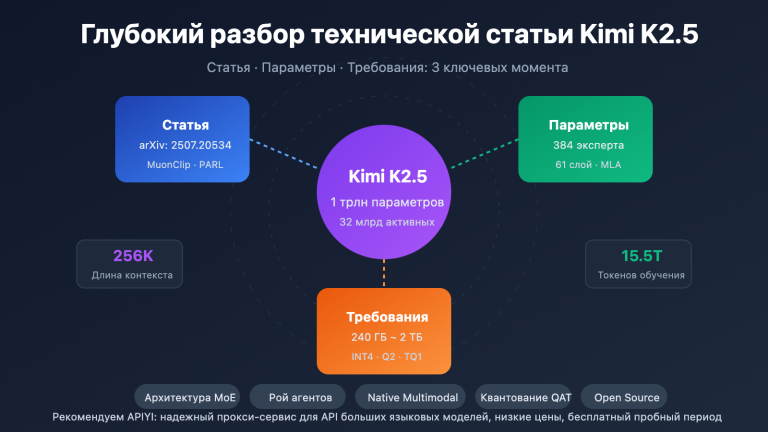

Примечание автора: Kimi K2.5 теперь полностью открыта. В этой статье мы подробно разберем лицензию, способы загрузки модели и методы подключения по API, а также предоставим готовый код для быстрого вызова Kimi K2.5 через APIYI.

Открыт ли исходный код Kimi K2.5? Это главный вопрос, который волнует разработчиков в последнее время. У нас отличные новости: 26 января 2026 года компания Moonshot AI официально представила и полностью открыла Kimi K2.5. Это включает в себя как код, так и веса модели под лицензией Modified MIT License.

Основная ценность: прочитав эту статью, вы узнаете все детали релиза и освоите 3 способа интеграции — self-hosting, официальный API и сторонние платформы (например, APIYI apiyi.com), чтобы быстро внедрить эту мультимодальную Agent-модель с триллионом параметров в свой проект.

Ключевые моменты релиза Kimi K2.5

| Параметр | Описание | Выгода для разработчика |

|---|---|---|

| Полный Open Source | Открыты и код, и веса (Modified MIT License) | Можно использовать в коммерции, развертывать локально и дообучать |

| MoE на 1T параметров | Общее число — 1T, активных — 32B | Производительность как у закрытых моделей при меньших затратах |

| Нативная мультимодальность | Поддержка изображений, видео и документов | Одна модель для всех типов входных данных |

| Agent Swarm | До 100 параллельных дочерних агентов | Эффективность в сложных задачах выше в 4.5 раза |

| Совместимость с OpenAI | Формат API полностью совпадает с OpenAI | Миграция существующего кода почти с нулевыми затратами |

Подробно о лицензии Kimi K2.5

Kimi K2.5 использует лицензию Modified MIT License, что означает:

- Коммерческое использование: разрешено в коммерческих продуктах без лицензионных отчислений.

- Модификация и распространение: вы можете изменять модель и распространять её.

- Локальное развертывание: полная поддержка приватной установки, данные не покидают ваш контур.

- Тонкая настройка (Fine-tuning): можно проводить дообучение на специфических данных поверх открытых весов.

В отличие от ограничительных лицензий серии LLaMA, условия Kimi K2.5 гораздо дружелюбнее к разработчикам и отлично подходят для корпоративного сегмента.

Где взять ресурсы Kimi K2.5

Веса модели и код доступны в следующих источниках:

| Ресурс | Ссылка | Описание |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

Официальные веса, поддержка transformers 4.57.1+ |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

Оптимизированные образы для развертывания |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

Зеркало в Китае для быстрой загрузки |

| Ollama | ollama.com/library/kimi-k2.5 |

Запуск локально одной командой |

Быстрый старт: подключение Kimi K2.5

Подключить Kimi K2.5 можно тремя основными способами: локальное развертывание, официальный API и сторонние платформы. Большинству разработчиков мы рекомендуем подключение через API: это позволяет быстро проверить модель в деле, не тратясь на дорогие GPU.

Простейший пример

Вот минимальный код для вызова Kimi K2.5 через платформу APIYI. Всего 10 строк — и всё работает:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # Получите на apiyi.com

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "Объясни принципы квантовых вычислений простыми словами"}]

)

print(response.choices[0].message.content)

Посмотреть полный код для режима Kimi K2.5 Thinking

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

Вызов Kimi K2.5 API

Args:

prompt: Ввод пользователя

thinking_mode: Включить ли режим размышления (глубокие рассуждения)

system_prompt: Системный промпт

max_tokens: Максимальное количество токенов на выходе

Returns:

Словарь с процессом рассуждения и финальным ответом

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# Настройка режима рассуждения

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# Пример использования — режим Thinking

result = call_kimi_k25(

prompt="Что больше: 9.11 или 9.9? Подумай хорошенько",

thinking_mode=True

)

print(f"Ход мыслей: {result['reasoning']}")

print(f"Итоговый ответ: {result['content']}")

Совет: Воспользуйтесь бесплатным тестовым балансом на APIYI (apiyi.com), чтобы быстро оценить возможности рассуждения Kimi K2.5. Платформа уже поддерживает Kimi K2.5 в двух режимах: Thinking (глубокий) и Instant (быстрый).

Сравнение вариантов подключения Kimi K2.5

| Вариант | Ключевые особенности | Когда выбирать | Затраты |

|---|---|---|---|

| Self-hosted | Данные под полным контролем | Корпоративные системы с секретными данными | Нужно 48ГБ+ VRAM (для INT4) |

| Официальный API | Стабильность и полный функционал | Стандартная разработка и тесты | $0.60 за 1M токенов (вход), $3 за 1M (выход) |

| APIYI | Единый интерфейс, переключение между моделями | Быстрая проверка, экономия бюджета | Оплата по факту, бесплатный бонус новичкам |

Подробный разбор трех способов подключения

Способ 1: Локальное развертывание

Подходит для компаний с собственными GPU-ресурсами и жесткими требованиями к приватности. Для деплоя рекомендуем использовать vLLM или SGLang:

# Развертывание в один клик через Ollama (требуется 48ГБ+ видеопамяти)

ollama run kimi-k2.5

Способ 2: Официальный API

Подключение напрямую через платформу Moonshot для получения доступа к самым последним фишкам:

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

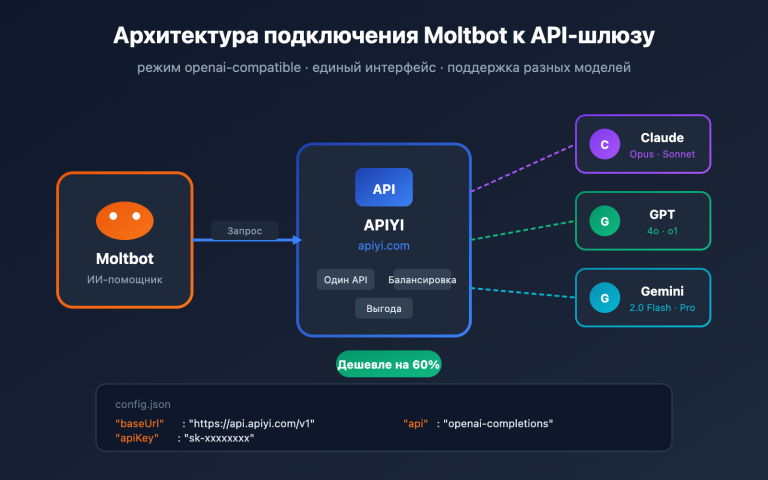

Способ 3: Подключение через платформу APIYI (Рекомендуем)

Kimi K2.5 уже доступен на APIYI (apiyi.com), и вот почему это удобно:

- Единый интерфейс в формате OpenAI — переучиваться не нужно.

- Возможность быстро сравнить результаты с GPT-4o, Claude и другими моделями.

- Бесплатный тестовый баланс для новых пользователей.

- Стабильный доступ без необходимости настраивать сложные прокси.

Рекомендация: Начните с APIYI (apiyi.com), чтобы оценить возможности модели и её эффективность для ваших задач. Переходить на собственное развертывание стоит только тогда, когда вы точно уверены, что модель вам подходит.

Сравнение стоимости API Kimi K2.5 с конкурентами

| Модель | Цена за вход (1M) | Цена за выход (1M) | Стоимость запроса (5K вых.) | Сравнение |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | База |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | Дороже на 38% |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | Дороже на 444% |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | Дороже на 81% |

При производительности, которая вплотную приближается к топовым закрытым моделям (а в чем-то и превосходит их), Kimi K2.5 обходится примерно в 5 раз дешевле, чем Claude Opus 4.5. На сегодняшний день это одна из самых выгодных моделей с триллионом параметров по соотношению цены и качества.

Часто задаваемые вопросы

Q1: Открыт ли исходный код Kimi K2.5? Можно ли использовать её в коммерческих целях?

Да, Kimi K2.5 стала полностью Open Source 26 января 2026 года под лицензией Modified MIT. И код, и веса модели доступны совершенно бесплатно. Вы можете свободно использовать её в коммерческих проектах, модифицировать и распространять.

Q2: В чем разница между режимами Thinking и Instant в Kimi K2.5?

Режим Thinking (Рассуждение) выдает подробную цепочку мыслей (reasoning_content), что отлично подходит для решения сложных задач. Режим Instant (Мгновенный) сразу дает готовый ответ, поэтому он быстрее. Совет такой: для математики и логики включайте Thinking, а для обычного чата хватит и Instant.

Q3: Как быстро проверить Kimi K2.5 в деле?

Проще всего протестировать модель через агрегаторы API, которые поддерживают сразу много нейронок:

- Зайдите на сайт APIYI (apiyi.com) и создайте аккаунт.

- Получите API-ключ и приветственные бонусы.

- Возьмите пример кода из этой статьи и просто поменяйте

base_urlнаhttps://vip.apiyi.com/v1. - В поле модели впишите

kimi-k2.5— и готово!

Итоги

Ключевые моменты по интеграции Kimi K2.5:

- Полностью открытый исходный код: Kimi K2.5 использует модифицированную лицензию MIT (Modified MIT License) — код и веса модели доступны для коммерческого использования.

- Несколько способов подключения: поддержка самодеплоя (self-hosted), официального API и сторонних платформ. Выбирайте вариант, исходя из ваших потребностей.

- Высокая экономическая эффективность: модель с триллионом параметров стоит всего 1/5 от цены Claude Opus 4.5.

Kimi K2.5 уже доступна на APIYI (apiyi.com). Новые пользователи могут получить приветственные бонусы. Рекомендуем протестировать возможности модели на платформе, чтобы оценить, насколько она подходит для ваших бизнес-задач.

Справочные материалы

⚠️ Примечание по формату ссылок: Все внешние ссылки указаны в формате

Название: domain.com. Это удобно для копирования, но ссылки не являются гиперссылками, чтобы избежать потери SEO-веса.

-

Карточка модели Kimi K2.5 на HuggingFace: официальные веса и документация

- Ссылка:

huggingface.co/moonshotai/Kimi-K2.5 - Описание: здесь можно найти веса модели, руководства по развертыванию и примеры использования API.

- Ссылка:

-

Технический отчет Kimi K2.5: подробности об архитектуре и методах обучения

- Ссылка:

kimi.com/blog/kimi-k2-5.html - Описание: узнайте больше об Agent Swarm, архитектуре MoE и других ключевых технологиях.

- Ссылка:

-

Открытая платформа Moonshot: официальная документация API и SDK

- Ссылка:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - Описание: официальное руководство по интеграции, информация о ценах и лимитах (rate limits).

- Ссылка:

-

Ollama Kimi K2.5: решение для быстрого локального развертывания

- Ссылка:

ollama.com/library/kimi-k2.5 - Описание: отлично подходит для локальных тестов и небольших сценариев использования.

- Ссылка:

Автор: Техническая команда

Общение: Делитесь своим опытом использования Kimi K2.5 в комментариях. Еще больше сравнений моделей и обучающих гайдов ищите в техническом сообществе APIYI на apiyi.com