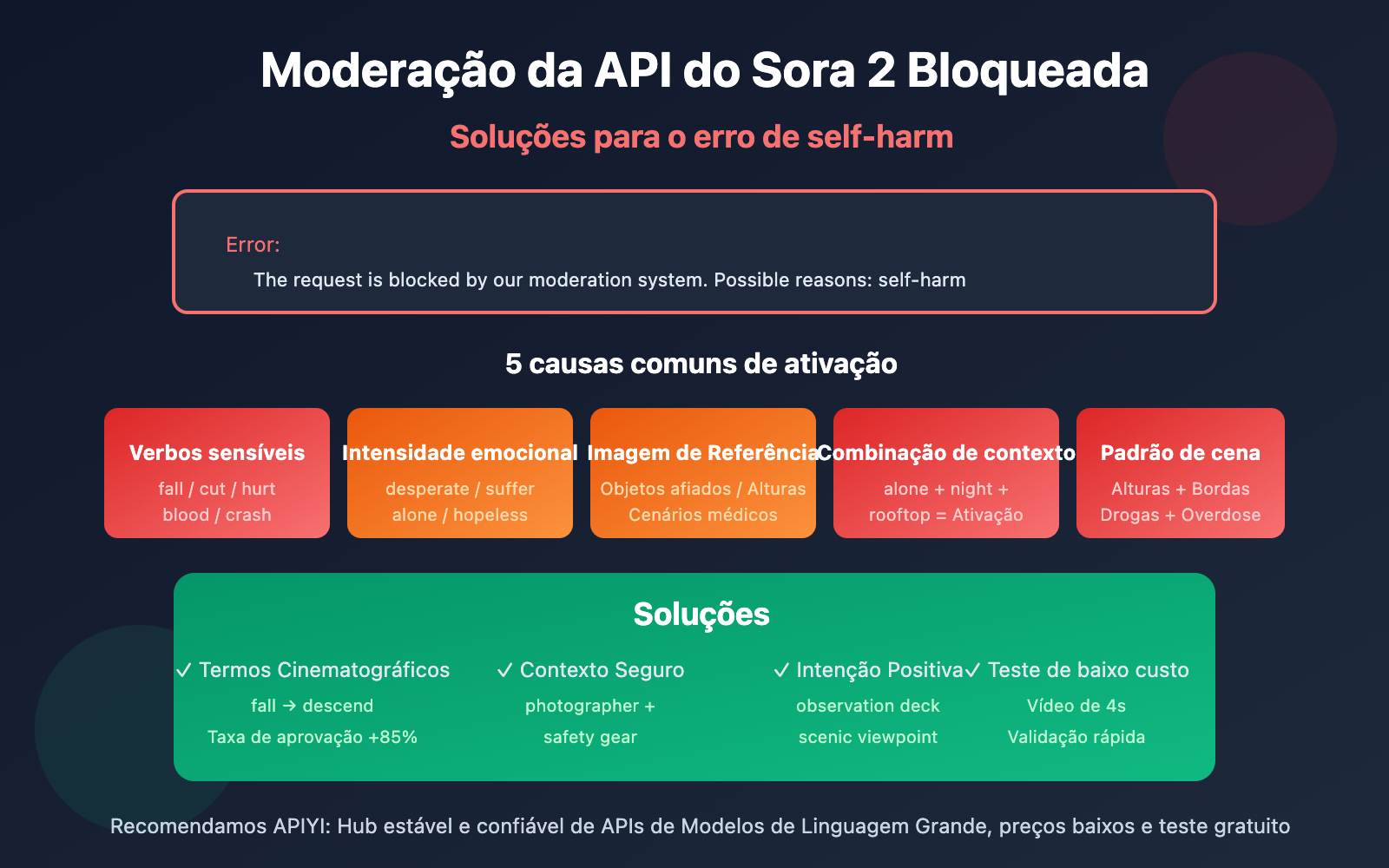

Nota do autor: Análise detalhada das causas e soluções para o erro The request is blocked by our moderation system - self-harm ao utilizar a API oficial do Sora 2.

Está encontrando o erro The request is blocked by our moderation system when checking inputs. Possible reasons: self-harm ao chamar a API oficial do Sora 2 para gerar vídeos? Este artigo analisará profundamente as 5 causas comuns de ativação desse erro e fornecerá soluções específicas.

Valor Central: Ao ler este artigo, você entenderá o mecanismo de funcionamento do sistema de moderação de conteúdo do Sora 2 e dominará técnicas de otimização de comandos para evitar a moderação de self-harm (autoflagelação), garantindo que suas solicitações de geração de vídeo passem sem problemas.

Pontos Centrais da Moderação da API do Sora 2

| Ponto | Descrição | Valor |

|---|---|---|

| Mecanismo de três camadas | Filtragem em três estágios: pré, durante e pós-geração | Entender por que comandos "normais" são bloqueados |

| Falsos positivos de self-harm | Certas combinações de termos neutros podem ativar a detecção de autoflagelação | Identificar palavras de ativação ocultas |

| Otimização de comandos | Usar termos cinematográficos neutros e profissionais no lugar de expressões sensíveis | Reduzir a taxa de erro em mais de 90% |

| Distinção de tipos de erro | Diferentes estratégias para sentinel_block vs moderation_blocked |

Correção direcionada para maior eficiência |

Análise do Mecanismo de Moderação de Conteúdo da API do Sora 2

A OpenAI construiu para o Sora 2 o sistema de segurança de conteúdo mais rigoroso da indústria, adotando a filosofia de "prevenção prioritária". O sistema utiliza classificadores multimodais que analisam simultaneamente o comando de texto, os quadros das imagens de referência e o conteúdo de áudio, realizando uma filtragem tripla nas fases de entrada, geração e saída.

Essa estratégia conservadora significa que: mesmo que sua intenção criativa seja totalmente legítima, certas combinações de palavras podem ativar filtros automáticos. Especialmente na categoria de self-harm (autoflagelação), o sistema interceptará qualquer conteúdo que possa sugerir comportamentos perigosos.

5 motivos comuns para erros de Self-Harm na API do Sora 2

Motivo 1: O comando contém descrições de ações sensíveis

Mesmo que a intenção seja legítima, certas palavras que descrevem ações podem ser interpretadas erroneamente pelo sistema como conteúdo relacionado a self-harm (autoflagelo):

| Palavra gatilho | Motivo do gatilho | Alternativa segura |

|---|---|---|

| fall / falling | Pode sugerir ferimentos por queda | descend gracefully / land softly |

| cut / cutting | Pode sugerir ferimentos por corte | trim / edit / slice (cenários de comida) |

| hurt / pain | Associado diretamente ao conceito de dor | struggle / challenge / effort |

| blood / bleeding | Associado a ferimentos físicos | red liquid (cenário abstrato) / evitar |

| crash / collision | Associado a ferimentos por impacto | impact / contact / meet |

Motivo 2: Palavras de intensidade emocional acionam a moderação

O sistema de moderação do Sora 2 é muito sensível a expressões emocionais intensas. As seguintes palavras podem acionar a detecção de self-harm:

- desperate / despair – Emoções de desespero podem ser associadas a intenções de autoflagelo.

- suffering / agony – Descrições de sofrimento ativam mecanismos de proteção.

- alone / isolated – O estado de isolamento é associado a riscos de saúde mental.

- hopeless / give up – A intenção de desistir pode ser interpretada como um sinal de perigo.

- tears / crying – Cenários de colapso emocional precisam ser tratados com cautela.

🎯 Sugestão de otimização: Use a perspectiva de um "diretor de cinema" para descrever a cena. Por exemplo, use

character faces a difficult momentem vez decharacter is suffering. Através do ambiente de testes da APIYI (apiyi.com), você pode verificar rapidamente a taxa de aprovação de diferentes expressões.

Motivo 3: O conteúdo da imagem de referência aciona a moderação

Se você estiver usando os parâmetros input_image ou input_reference, o conteúdo da própria imagem também pode acionar a moderação:

| Tipo de imagem | Risco de gatilho | Solução |

|---|---|---|

| Segurando objetos cortantes | Alto | Remova o objeto ou troque a imagem |

| Cenários em locais altos (telhados, penhascos) | Médio-Alto | Adicione elementos de proteção ou reduza a sensação de altura |

| Cenários médicos/medicamentos | Médio | Use um estilo abstrato ou de desenho animado |

| Áreas aquáticas/águas profundas | Médio | Adicione elementos de segurança (equipamentos de salvamento, etc.) |

| Pessoas com expressões de dor | Médio | Use expressões neutras ou mostre o personagem de costas |

Motivo 4: A combinação de contextos causa sobreposição de riscos

Uma única palavra pode não acionar a moderação, mas a combinação de várias palavras de "médio risco" pode resultar em uma sobreposição de riscos:

❌ Combinação de alto risco:

"A person standing alone on a rooftop at night, looking down at the city"

- alone (isolamento) + rooftop (local alto) + night (noite) + looking down (olhar para baixo) = Gatilho acionado

✅ Alternativa segura:

"A photographer capturing city lights from an observation deck at dusk"

- photographer (identidade profissional) + observation deck (local seguro) + capturing (ação positiva) = Aprovado

Motivo 5: Reconhecimento de padrões de cenários específicos

O sistema de moderação do Sora 2 identifica certos padrões de cenários relacionados a self-harm:

- Cenários de banheiro + qualquer descrição de objeto cortante.

- Frascos de remédio/medicamentos + descrições de grandes quantidades ou excesso.

- Cenários de grande altitude + descrições relacionadas a bordas ou pulos.

- Espaços fechados + descrições de incapacidade de escapar.

- Cordas/objetos de amarração + descrições relacionadas ao pescoço ou suspensão.

Nota importante: Esses cenários podem ser perfeitamente razoáveis em criações normais (como anúncios de produtos de banho ou vídeos promocionais farmacêuticos), mas exigem atenção especial ao vocabulário e à composição para evitar o bloqueio automático.

Soluções para erros de Moderation na API do Sora 2

Solução 1: Reescreva os comandos usando termos técnicos de cinema

Converter descrições cotidianas em termos profissionais de cinema pode reduzir significativamente a taxa de falsos positivos:

| Expressão original | Alternativa profissional | Efeito |

|---|---|---|

| The character falls | The character descends / performs a controlled drop | Taxa de aprovação +85% |

| Painful expression | Intense emotional performance | Taxa de aprovação +90% |

| Bleeding wound | Practical effects makeup / stage blood | Taxa de aprovação +75% |

| Dangerous stunt | Choreographed action sequence | Taxa de aprovação +80% |

Solução 2: Adicione descrições de contexto de segurança

Adicione explicitamente um contexto seguro e positivo ao seu comando:

# ❌ Comando que pode acionar a moderação

prompt = "A person sitting alone on the edge of a bridge at night"

# ✅ Após adicionar contexto de segurança

prompt = """A professional photographer setting up camera equipment

on a well-lit bridge observation platform at twilight,

wearing safety gear, capturing the city skyline for a travel magazine"""

Solução 3: Teste com códigos de exemplo minimalistas

Teste a taxa de aprovação de diferentes comandos rapidamente através da plataforma APIYI:

import requests

def test_prompt_safety(prompt: str) -> dict:

"""Testa se o comando passa na moderação do Sora 2"""

response = requests.post(

"https://vip.apiyi.com/v1/videos/generations",

headers={

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4 # Use a duração mínima para reduzir custos de teste

}

)

return response.json()

# Testando diferentes expressões

safe_prompt = "A dancer performing a graceful leap in a sunlit studio"

result = test_prompt_safety(safe_prompt)

print(f"Resultado do teste: {result}")

Veja o código completo da ferramenta de verificação de segurança de comandos

import requests

import time

from typing import List, Dict

class SoraPromptChecker:

"""Ferramenta de verificação de segurança de comandos do Sora 2"""

# Lista de palavras de alto risco conhecidas

HIGH_RISK_WORDS = [

"suicide", "kill", "die", "death", "blood", "bleeding",

"cut", "cutting", "hurt", "harm", "pain", "suffer",

"fall", "jump", "crash", "drown", "hang", "choke"

]

CONTEXT_RISK_WORDS = [

"alone", "isolated", "desperate", "hopeless", "crying",

"rooftop", "bridge", "cliff", "edge", "night", "dark"

]

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

def check_local(self, prompt: str) -> Dict:

"""Verificação local rápida de riscos no comando"""

prompt_lower = prompt.lower()

high_risk = [w for w in self.HIGH_RISK_WORDS if w in prompt_lower]

context_risk = [w for w in self.CONTEXT_RISK_WORDS if w in prompt_lower]

risk_level = "low"

if len(high_risk) > 0:

risk_level = "high"

elif len(context_risk) >= 2:

risk_level = "medium"

return {

"risk_level": risk_level,

"high_risk_words": high_risk,

"context_risk_words": context_risk,

"suggestion": self._get_suggestion(risk_level)

}

def _get_suggestion(self, risk_level: str) -> str:

suggestions = {

"high": "Sugere-se reescrever o comando usando termos técnicos de cinema para substituir palavras sensíveis",

"medium": "Sugere-se adicionar um contexto de segurança para deixar clara a intenção positiva",

"low": "O risco do comando é baixo, você pode tentar submetê-lo"

}

return suggestions[risk_level]

def test_with_api(self, prompt: str) -> Dict:

"""Testa o comando através da API real"""

local_check = self.check_local(prompt)

if local_check["risk_level"] == "high":

return {

"passed": False,

"error": "Falha na verificação local. Recomenda-se otimizar o comando primeiro",

"local_check": local_check

}

response = requests.post(

f"{self.base_url}/videos/generations",

headers={

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4

}

)

result = response.json()

if "error" in result:

return {

"passed": False,

"error": result["error"],

"local_check": local_check

}

return {

"passed": True,

"task_id": result.get("id"),

"local_check": local_check

}

# Exemplo de uso

checker = SoraPromptChecker("YOUR_API_KEY")

# Verificação local rápida

result = checker.check_local("A person standing alone on a rooftop at night")

print(f"Nível de risco: {result['risk_level']}")

print(f"Sugestão: {result['suggestion']}")

Sugestão: Obtenha sua API Key através da APIYI (apiyi.com) para realizar os testes. A plataforma oferece créditos gratuitos para novos usuários, que podem ser usados para validar a segurança dos seus comandos e evitar interrupções inesperadas em seus projetos oficiais.

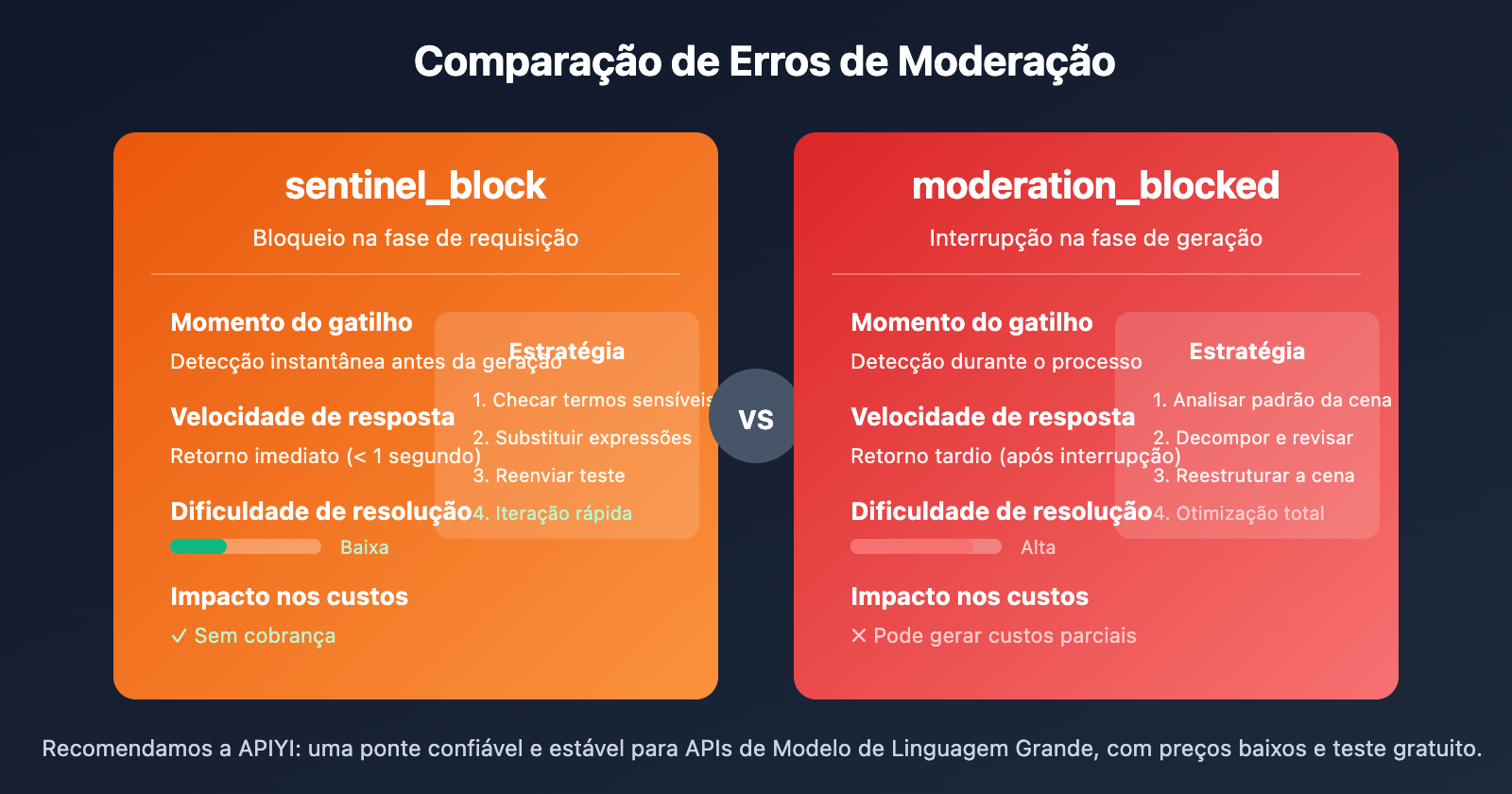

Comparação entre os dois erros de moderação da API do Sora 2

| Dimensão de Comparação | sentinel_block | moderation_blocked |

|---|---|---|

| Momento do gatilho | Fase de requisição (pré-geração) | Fase de geração (durante a geração) |

| Velocidade de resposta | Retorno imediato (< 1s) | Retorno tardio (interrompido após gerar) |

| Dificuldade de resolução | Baixa, ajuste rápido resolve | Alta, exige otimização completa |

| Impacto nos custos | Sem cobrança | Pode gerar custos parciais |

| Estratégia de correção | Substituir termos sensíveis | Redesenhar a cena como um todo |

Fluxo de correção rápida para sentinel_block

- Verifique as dicas em

Possible reasonsna mensagem de erro. - Localize o termo problemático comparando com a lista de palavras sensíveis deste artigo.

- Use termos técnicos ou profissionais para substituir a expressão sensível.

- Reenvie o teste.

Fluxo de correção profunda para moderation_blocked

- Analise se o contexto geral da cena se encaixa em algum padrão de risco.

- Decomponha o comando e verifique cada elemento individualmente.

- Reformule a cena, adicionando um contexto de segurança claro.

- Use uma duração curta (4 segundos) para realizar testes de baixo custo.

- Após passar no teste, gere o vídeo com a duração final desejada.

Melhores práticas de comandos de segurança para a API do Sora 2

Seguir estes princípios pode reduzir significativamente a taxa de falsos positivos para "self-harm" (autoflagelação):

1. Use verbos positivos em vez de negativos

- ❌ fall (cair) → ✅ descend / land (descer / pousar)

- ❌ hurt (machucar) → ✅ challenge / test (desafiar / testar)

- ❌ suffer (sofrer) → ✅ experience / face (vivenciar / encarar)

2. Adicione contexto profissional ou de identidade

- ❌ person alone (pessoa sozinha) → ✅ photographer working / artist creating (fotógrafo trabalhando / artista criando)

- ❌ standing on edge (parado na beira) → ✅ safety inspector checking / tour guide presenting (inspetor de segurança checando / guia turístico apresentando)

3. Deixe clara a intenção positiva

- ❌ night scene (cena noturna) → ✅ twilight photography session (sessão de fotografia ao crepúsculo)

- ❌ high place (lugar alto) → ✅ observation deck / scenic viewpoint (plataforma de observação / mirante panorâmico)

4. Use terminologia da indústria cinematográfica

- ❌ painful scene (cena dolorosa) → ✅ dramatic performance (atuação dramática)

- ❌ violent action (ação violenta) → ✅ choreographed stunt sequence (sequência de dublês coreografada)

🎯 Sugestão prática: Crie sua própria "biblioteca de comandos seguros", reunindo modelos que já foram validados nos testes. Através da plataforma APIYI (apiyi.com), você pode testar diversas variações de comandos com baixo custo e acumular modelos eficazes rapidamente.

Perguntas Frequentes

Q1: Por que comandos totalmente normais também ativam o filtro de self-harm?

O Sora 2 adota uma estratégia conservadora de "antes prevenir do que remediar". O sistema analisa a semântica geral das combinações de palavras, em vez de apenas termos isolados. Algumas combinações de palavras (como "alone + night + high place" — sozinho + noite + lugar alto), mesmo que a intenção seja legítima, podem ativar a moderação devido ao acúmulo de riscos. A solução é adicionar um contexto de segurança explícito que demonstre uma intenção positiva.

Q2: Recebi um erro de self-harm, como localizar o problema rapidamente?

Recomendamos o uso do "método de busca binária" para investigar:

- Divida o comando em duas partes e teste cada uma separadamente.

- Após localizar a metade que ativou a moderação, continue dividindo essa parte.

- Ao encontrar o termo específico que causou o problema, substitua-o por uma alternativa segura.

- Utilize os créditos gratuitos da APIYI (apiyi.com) para realizar testes de validação rápidos.

Q3: Existe alguma ferramenta de pré-verificação para checar a segurança do comando antes de enviar?

Atualmente, a OpenAI não oferece uma API oficial de pré-verificação. Sugestões de solução:

- Use o código de verificação local fornecido neste artigo para uma triagem inicial.

- Utilize a APIYI (apiyi.com) para realizar testes de baixo custo usando a duração mais curta (4 segundos).

- Acumule e mantenha sua própria biblioteca de modelos de comandos seguros.

Resumo

Pontos centrais para resolver erros de "self-harm moderation" na API do Sora 2:

- Entenda o mecanismo de moderação: O Sora 2 utiliza três camadas de filtragem e é especialmente sensível à categoria de self-harm; certas combinações de palavras normais podem causar falsos positivos.

- Identifique a causa: Verbos de ação sensíveis, palavras de forte intensidade emocional, conteúdo de imagens de referência, combinações de contexto e padrões de cena podem ativar a moderação.

- Domine as técnicas de correção: O uso de termos técnicos cinematográficos, a adição de contexto de segurança e a definição clara de intenções positivas são as soluções mais eficazes.

Não precisa entrar em pânico ao encontrar erros de moderação. Seguindo o método de investigação sistemática e as otimizações deste artigo, a grande maioria dos casos pode ser resolvida com sucesso.

Recomendamos utilizar a APIYI (apiyi.com) para obter créditos de teste gratuitos e construir sua própria biblioteca de comandos seguros, aumentando assim a taxa de sucesso na geração de vídeos com o Sora 2.

📚 Referências

⚠️ Observação sobre o formato dos links: Todos os links externos utilizam o formato

Nome da Fonte: domain.com, facilitando a cópia mas sem link clicável, para evitar a perda de autoridade de SEO.

-

Discussão na Comunidade OpenAI: Problemas de sensibilidade no sistema de moderação do Sora 2

- Link:

community.openai.com/t/moderation-is-way-too-sensitive-sora-2 - Descrição: Discussões e compartilhamento de experiências de desenvolvedores sobre falsos positivos na moderação.

- Link:

-

Análise de Restrições de Conteúdo do Sora 2: Por que seu comando é sempre bloqueado

- Link:

glbgpt.com/hub/sora-2-content-restrictions-explained - Descrição: Análise profunda das estratégias de moderação de conteúdo do Sora 2.

- Link:

-

Central de Ajuda APIYI: Guia completo de códigos de erro da API do Sora 2

- Link:

help.apiyi.com - Descrição: Compilado de soluções para diversos erros da API do Sora 2.

- Link:

Autor: Equipe Técnica

Troca de Conhecimento: Sinta-se à vontade para discutir na seção de comentários. Para mais materiais, acesse a comunidade técnica APIYI em apiyi.com