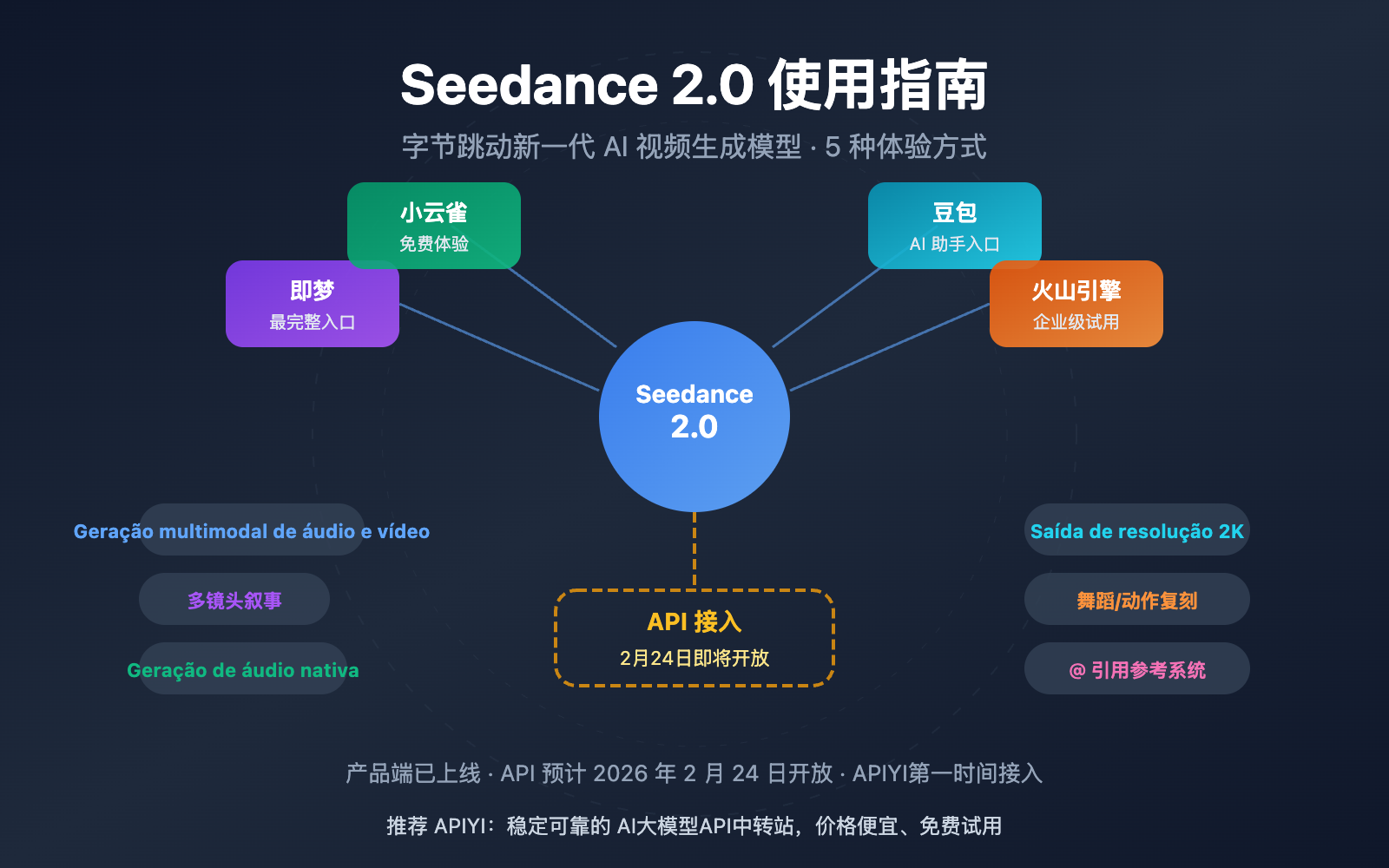

Nota do autor: Guia detalhado de como usar o Seedance 2.0, cobrindo pontos de entrada como Jimeng, Lark, Doubao e Volcengine, além de previsões de tempo de acesso à API e preços, ajudando você a ser um dos primeiros a usar o modelo de vídeo de IA mais potente da ByteDance.

Como usar o Seedance 2.0? Essa é a pergunta que todos estão fazendo no momento. A ByteDance lançou oficialmente o modelo de geração de vídeo Seedance 2.0 em 12 de fevereiro de 2026. Com sua arquitetura de geração conjunta de áudio e vídeo multimodal e capacidade narrativa multicâmera, o modelo rapidamente se tornou um dos assuntos mais comentados nas redes sociais globais. Este artigo apresentará detalhadamente todas as formas de usar o Seedance 2.0 para que você possa começar rapidamente.

Valor central: Ao ler este artigo, você dominará os 5 pontos de entrada do Seedance 2.0, suas principais funcionalidades, bem como os prazos mais recentes para acesso à API e informações de preço.

Visão Geral das Funcionalidades do Seedance 2.0

Antes de mergulharmos em como usar o Seedance 2.0, vamos conhecer rapidamente suas capacidades principais:

| Funcionalidade | Descrição Detalhada | Melhoria vs. Versão Anterior |

|---|---|---|

| Entrada Multimodal | Suporta texto, imagem, áudio e vídeo como entrada | Nova entrada de áudio |

| Narrativa Multicâmera | Gera vídeos contínuos com múltiplas cenas, mantendo consistência de personagem e estilo | Nova funcionalidade |

| Geração de Áudio Nativa | Gera automaticamente efeitos sonoros e música de fundo sincronizados com a imagem | Nova funcionalidade |

| Saída em Resolução 2K | Suporta saída de nível de produção até 1080p | Resolução dobrada |

| Replicação de Dança/Movimento | Carregue um vídeo de referência para copiar com precisão movimentos de câmera e coreografias | Precisão significativamente aumentada |

Detalhamento da Arquitetura Técnica do Seedance 2.0

O Seedance 2.0 utiliza uma arquitetura Dual-Branch Diffusion Transformer, que é a chave para alcançar a geração conjunta multimodal. Essa arquitetura processa de forma unificada sinais de texto, imagem, áudio e vídeo, permitindo que o modelo produza áudio perfeitamente sincronizado com a imagem enquanto gera o vídeo.

Em termos de qualidade de vídeo, a velocidade de geração do Seedance 2.0 é cerca de 30% superior à de concorrentes similares (como o Kling AI). Ele suporta durações de vídeo de 4 a 15 segundos, cobrindo várias proporções de tela, como 16:9, 9:16, 4:3, 3:4, 21:9 e 1:1. A consistência de rostos, roupas, textos e cenários teve uma melhoria notável em relação à geração anterior, resolvendo de forma eficaz problemas comuns em vídeos de IA, como o "desvio" de personagens e mudanças bruscas de estilo.

Como usar o Seedance 2.0: 5 formas detalhadas de experimentá-lo

O Seedance 2.0 já foi lançado oficialmente, mas a API ainda não está aberta ao público geral. Abaixo, detalhamos todas as formas disponíveis atualmente para você utilizar o Seedance 2.0:

1. Jimeng (即梦) — A experiência mais completa

O Jimeng é a plataforma de criação com IA da ByteDance e o primeiro canal a disponibilizar o Seedance 2.0, oferecendo o conjunto de funções mais robusto.

Passo a passo:

- Acesse a plataforma Jimeng:

jimeng.jianying.com - Faça login usando sua conta do Douyin (TikTok chinês)

- Entre na seção "Gerar" (生成) e selecione "Geração de Vídeo" (视频生成)

- Nas opções de modelo, selecione Seedance 2.0

- Insira o comando de texto ou faça o upload de materiais de referência para começar a gerar

Custos: O Jimeng funciona com um sistema de assinatura. Novos usuários costumam ter ofertas de teste (como 1 yuan por 7 dias). O Seedance 2.0 é uma funcionalidade para membros pagos.

🎯 Dica de uso: O Jimeng é, no momento, a plataforma mais completa para testar o Seedance 2.0. Se você precisar de chamadas via API em lote futuramente, fique atento aos avisos de lançamento no APIYI (apiyi.com); integraremos o modelo assim que a API for liberada.

2. Xiao Yunque (小云雀) — Acesso gratuito para testes

O Xiao Yunque é outro aplicativo da ByteDance que oferece a oportunidade de testar o Seedance 2.0 gratuitamente.

Passo a passo:

- Baixe o app Xiao Yunque

- Ao fazer o login, você ganha 3 oportunidades gratuitas de geração de vídeo com o Seedance 2.0

- O app também distribui 120 pontos diariamente, permitindo continuar a experiência de forma recorrente

Público-alvo: Usuários que querem testar o Seedance 2.0 de graça, ideal para conhecer a qualidade dos resultados.

3. Doubao (豆包) — Assistente de IA integrado

O Doubao é o assistente de IA multifuncional da ByteDance e também já integrou a capacidade de geração de vídeo do Seedance 2.0.

Passo a passo:

- Baixe o app Doubao ou acesse a versão web

- Escolha a função de geração de vídeo na interface de conversa

- Selecione o modelo Seedance 2.0 para criar seus conteúdos

4. Volcengine — Teste para empresas

A Volcengine (火山引擎) é a plataforma de serviços em nuvem da ByteDance, oferecendo um console de teste do Seedance 2.0 voltado para o setor corporativo.

| Plataforma | Como acessar | Características | API disponível? |

|---|---|---|---|

| Volcengine | Console volcengine.com |

Focado em empresas na China | Ainda não, previsão para 24 de fevereiro |

| BytePlus | Console byteplus.com |

Focado em empresas internacionais | Ainda não, previsão para 24 de fevereiro |

Nota: Atualmente, a Volcengine e a BytePlus oferecem apenas a interface de teste no console (Workplace), sem liberar o acesso aos endpoints da API por enquanto.

5. Acesso via API — A escolha dos desenvolvedores (Em breve)

Para desenvolvedores e empresas que precisam de chamadas programáticas ao Seedance 2.0, a API é a forma de acesso mais importante.

Cronograma de lançamento da API:

| Data | Evento | Descrição |

|---|---|---|

| 12 de fevereiro de 2026 | Lançamento oficial do Seedance 2.0 | Disponível nos produtos finais |

| 24 de fevereiro de 2026 | Previsão de abertura da API oficial | Via Volcengine/BytePlus |

| Imediatamente após a abertura | Lançamento simultâneo na plataforma APIYI | Preço aprox. 10% menor que o oficial |

🎯 Dica para desenvolvedores: A API do Seedance 2.0 deve ser aberta oficialmente em 24 de fevereiro de 2026. O APIYI (apiyi.com) disponibilizará o serviço de acesso à API do Seedance 2.0 assim que possível, com preços cerca de 10% mais baratos que o site oficial e interface unificada compatível com o formato da OpenAI, facilitando a integração rápida. Fique ligado.

Dicas de uso e melhores práticas para o Seedance 2.0

Dominar as técnicas abaixo pode melhorar significativamente os resultados das suas gerações:

Dicas de escrita de comandos para o Seedance 2.0

Sugestões para Texto-para-Vídeo (Text-to-Video):

- Descreva a cena detalhadamente, incluindo personagens, ações, ambiente e iluminação.

- Especifique o movimento da câmera (zoom, pan, tilt, acompanhamento, etc.).

- Defina o estilo visual (textura cinematográfica, estilo documentário, anime, etc.).

- Indique o tempo e o ritmo (ex: "avanço lento", "cortes rápidos").

Exemplo de comando:

Uma jovem mulher vestindo um vestido branco dança suavemente sob cerejeiras em flor,

a câmera faz um zoom lento de um plano aberto para um plano médio,

luz natural suave vindo da esquerda, pétalas caindo com o vento,

visual cinematográfico, profundidade de campo rasa, qualidade 4K.

Dicas para usar vídeos de referência

O sistema de menção "@" do Seedance 2.0 é uma vantagem única. Você pode fazer o upload de vídeos de referência para controlar:

- Referência de Câmera: Suba um vídeo com o movimento de câmera que você gosta e o modelo irá replicá-lo com precisão.

- Coreografia: Suba um vídeo de dança e o modelo conseguirá gerar um novo conteúdo sincronizado com o ritmo e os passos.

- Referência de Estilo: Use imagens ou vídeos para manter uma identidade visual consistente.

🎯 Dica avançada: Em cenários de entrada multimodal, use a menção "@" para atribuir papéis claros a cada material de referência (ex: @referência_de_câmera, @referência_de_personagem) para obter um controle mais refinado. Quando a API for aberta, o APIYI (apiyi.com) também suportará essas capacidades multimodais completas.

Seedance 2.0 vs. Concorrentes

| Dimensão de Comparação | Seedance 2.0 | Sora 2 | Kling 3.0 |

|---|---|---|---|

| Desenvolvedor | ByteDance | OpenAI | Kuaishou |

| Resolução Máxima | 2K (1080p) | 1080p | 4K/60fps |

| Duração do Vídeo | 4-15 segundos | Até 25 segundos | 5-10 segundos |

| Áudio Nativo | ✅ Suportado | ❌ Não suportado | ❌ Não suportado |

| Narrativa Multicâmera | ✅ Suportado | ✅ Storyboard | ❌ Não suportado |

| Entrada de Vídeo de Referência | ✅ Multimodal @ Referência | ❌ Limitado | ✅ Suportado |

| Simulação Física | Boa | Excelente | Boa |

| Movimento Humano | Ótimo | Bom | Excelente |

| Preço Estimado da API | $0.10-0.80/minuto | Mais alto | Médio |

Nota de comparação: Cada modelo tem seus pontos fortes. O Seedance 2.0 lidera em áudio nativo e referências multimodais; o Sora 2 é o mais forte em simulação física e vídeos longos; já o Kling 3.0 se destaca na resolução e nos movimentos humanos. Recomendamos escolher de acordo com o seu cenário específico. Através do APIYI (apiyi.com), você pode comparar e testar facilmente vários modelos de geração de vídeo.

Perguntas Frequentes

Q1: Onde posso usar o Seedance 2.0? Quais são os canais de acesso atuais?

Atualmente, o Seedance 2.0 pode ser experimentado através dos seguintes canais: Jimeng (即梦), Xiao Yunque, Doubao e outros aplicativos oficiais da ByteDance. Usuários corporativos também podem testar através do console da Volcengine e BytePlus. A previsão é que a API seja aberta em 24 de fevereiro de 2026.

Q2: Quando a API do Seedance 2.0 será lançada e qual será o preço?

A API do Seedance 2.0 está prevista para ser lançada oficialmente em 24 de fevereiro de 2026 através da Volcengine (火山引擎) e BytePlus. O preço oficial estimado é de US$ 0,10 a US$ 0,80 por minuto (dependendo da resolução). A APIYI (apiyi.com) disponibilizará o acesso assim que for lançado, com preços cerca de 10% mais baratos que o site oficial.

Q3: O Seedance 2.0 é gratuito?

O Seedance 2.0 não é totalmente gratuito. Na plataforma Jimeng, é necessária uma assinatura paga (novos usuários podem testar por 7 dias por 1 yuan); o Xiao Yunque oferece 3 oportunidades de teste gratuito e 120 pontos diários. O acesso via API será cobrado conforme o uso.

Q4: Como usar a versão internacional do Seedance 2.0? Como usuários fora da China podem experimentar?

Atualmente, o Seedance 2.0 oferece a experiência completa principalmente através da versão chinesa da plataforma Jimeng. As versões internacionais Dreamina (dreamina.capcut.com) e Pippit ainda não lançaram o Seedance 2.0. Usuários no exterior podem acompanhar as atualizações da plataforma BytePlus ou aguardar a abertura da API para acessar via APIYI (apiyi.com).

Notas de Uso do Seedance 2.0

Ao usar o Seedance 2.0, é importante prestar atenção aos seguintes pontos:

- Função de clonagem de voz suspensa: A função "gerar voz a partir de foto" lançada com o Seedance 2.0 foi suspensa pela ByteDance em menos de 48 horas devido a controvérsias sobre deepfake. Ela voltará ao ar após a implementação de um mecanismo de verificação de identidade.

- Conformidade de conteúdo: O conteúdo gerado deve estar em conformidade com as leis e regulamentos relevantes, evitando a criação de conteúdos que envolvam violação de direitos autorais ou controvérsias éticas.

- Requisitos de conta: A plataforma Jimeng requer login com uma conta do Douyin, o que envolve a verificação de um número de telefone da China continental.

Resumo

Pontos principais sobre como usar o Seedance 2.0:

- Experimente agora: Você já pode usar o Seedance 2.0 através dos apps oficiais da ByteDance, como Jimeng (即梦), Xiao Yunque (小云雀) e Doubao (豆包).

- Teste empresarial: Volcengine e BytePlus oferecem uma interface de console para testes, mas a API ainda não está aberta ao público geral.

- Acesso via API: A previsão de abertura é 24 de fevereiro de 2026, quando será possível realizar chamadas de forma programática.

- Vantagens principais: Geração de áudio nativa + narrativa multicâmera + citações @ multimodais; três diferenciais que colocam o modelo à frente da concorrência.

Recomendamos acompanhar a APIYI (apiyi.com) para receber notificações sobre o lançamento da API do Seedance 2.0. A plataforma oferecerá o serviço com cerca de 10% de desconto em relação ao preço oficial, utilizando uma interface unificada compatível com o formato da OpenAI, o que facilita a integração rápida para desenvolvedores.

📚 Referências

-

Página oficial de apresentação do Seedance 2.0: Detalhes do modelo publicados pela equipe Seed da ByteDance.

- Link:

seed.bytedance.com/en/seedance2_0 - Descrição: Contém especificações técnicas completas e introdução das funcionalidades.

- Link:

-

Plataforma de criação Jimeng AI: Porta de entrada para a primeira experiência com o Seedance 2.0.

- Link:

jimeng.jianying.com - Descrição: Atualmente é a plataforma com as funcionalidades mais completas para utilizar o Seedance 2.0.

- Link:

-

Blog oficial de lançamento do Seedance 2.0: Anúncio de lançamento da equipe Seed da ByteDance.

- Link:

seed.bytedance.com/en/blog/official-launch-of-seedance-2-0 - Descrição: Inclui a data de lançamento, destaques de funcionalidades e outras informações oficiais.

- Link:

Autor: Equipe Técnica

Troca de Conhecimento: Sinta-se à vontade para discutir sua experiência com o Seedance 2.0 na seção de comentários. Para mais notícias sobre modelos de geração de vídeo por IA, visite a comunidade técnica APIYI (apiyi.com).