저자 주: Kimi K2.5가 완전 오픈소스로 공개되었습니다. 이 글에서는 오픈소스 라이선스, 모델 다운로드, API 연동 방법을 자세히 설명하며, APIYI를 통해 Kimi K2.5를 빠르게 호출할 수 있는 전체 코드 예제를 제공합니다.

Kimi K2.5가 오픈소스인가요? 이는 최근 많은 개발자분이 가장 궁금해하는 질문입니다. 기쁜 소식은, Moonshot AI(月之暗面)가 2026년 1월 26일 공식 발표를 통해 Kimi K2.5를 완전 오픈소스화했다는 점입니다. 코드와 모델 가중치를 모두 포함하며, Modified MIT License를 채택했습니다.

핵심 가치: 이 글을 읽고 나면 Kimi K2.5의 오픈소스 세부 사항을 이해하고, 자체 배포, 공식 API, 제3자 플랫폼(예: APIYI apiyi.com) 등 3가지 연동 방식을 마스터하여 프로젝트에 이 1조 파라미터급 멀티모달 에이전트 모델을 빠르게 적용할 수 있게 됩니다.

Kimi K2.5 오픈소스 핵심 요점

| 요점 | 설명 | 개발자 혜택 |

|---|---|---|

| 완전 오픈소스 | 코드 + 가중치 모두 공개, Modified MIT License | 상업적 이용 가능, 로컬 배포 및 미세 조정 가능 |

| 1조 파라미터 MoE | 총 1T 파라미터, 활성화 파라미터 32B | 폐쇄형 모델에 필적하는 성능, 더 낮은 비용 |

| 네이티브 멀티모달 | 이미지, 비디오, 문서 이해 지원 | 하나의 모델로 다양한 입력 유형 처리 |

| Agent Swarm | 최대 100개 병렬 서브 에이전트 지원 | 복잡한 작업 효율성 4.5배 향상 |

| OpenAI 호환 | API 포맷이 OpenAI와 완벽하게 호환 | 기존 코드에서 거의 비용 없이 이전 가능 |

Kimi K2.5 오픈소스 라이선스 상세 설명

Kimi K2.5는 Modified MIT License를 채택했습니다. 이는 다음을 의미합니다:

- 상업적 이용: 상업적 제품에서 사용할 수 있으며, 별도의 라이선스 비용을 지불할 필요가 없습니다.

- 수정 및 배포: 모델을 수정하고 다시 배포할 수 있습니다.

- 로컬 배포: 프라이빗 배포를 완벽하게 지원하여 데이터가 외부로 유출되지 않게 할 수 있습니다.

- 미세 조정(Fine-tuning) 학습: 오픈소스 가중치를 기반으로 특정 도메인에 맞게 미세 조정을 진행할 수 있습니다.

LLaMA 시리즈의 제한적인 라이선스와 달리, Kimi K2.5의 라이선스는 개발자에게 훨씬 우호적이며 특히 기업용 애플리케이션 시나리오에 적합합니다.

Kimi K2.5 오픈소스 리소스 획득 방법

모델 가중치와 코드는 다음 채널을 통해 획득할 수 있습니다:

| 리소스 | 주소 | 설명 |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

공식 가중치, transformers 4.57.1+ 지원 |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

최적화된 배포 이미지 |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

빠른 다운로드를 위한 미러 사이트 |

| Ollama | ollama.com/library/kimi-k2.5 |

클릭 한 번으로 로컬 실행 가능 |

Kimi K2.5 연동 가이드

Kimi K2.5에 접속하는 방법은 크게 자체 배포, 공식 API, 제3자 플랫폼 세 가지가 있어요. 대부분의 개발자분들께는 GPU 리소스 없이도 빠르게 효과를 검증할 수 있는 API 연동 방식을 추천합니다.

초간단 예제

다음은 APIYI 플랫폼을 통해 Kimi K2.5를 호출하는 가장 간단한 코드예요. 단 10줄이면 실행할 수 있습니다.

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # apiyi.com에서 발급

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "解释量子计算的基本原理"}]

)

print(response.choices[0].message.content)

Kimi K2.5 Thinking 모드 전체 코드 보기

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

调用 Kimi K2.5 API

Args:

prompt: 用户输入

thinking_mode: 是否启用思维模式(深度推理)

system_prompt: 系统提示词

max_tokens: 最大输出 token 数

Returns:

包含推理过程和最终答案的字典

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# 配置推理模式

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# 使用示例 - Thinking 模式

result = call_kimi_k25(

prompt="9.11 和 9.9 哪个更大?请仔细思考",

thinking_mode=True

)

print(f"推理过程: {result['reasoning']}")

print(f"最终答案: {result['content']}")

권장 사항: APIYI(apiyi.com)에서 무료 테스트 크레딧을 받아 Kimi K2.5의 추론 능력을 빠르게 확인해 보세요. 플랫폼에 이미 Kimi K2.5가 출시되었으며, Thinking(사고) 모드와 Instant(즉시) 모드를 모두 지원합니다.

Kimi K2.5 연동 방안 비교

| 방안 | 핵심 특징 | 활용 사례 | 비용 고려 사항 |

|---|---|---|---|

| 자체 배포 | 데이터 로컬화, 완전 제어 가능 | 데이터에 민감한 기업 환경 | 48GB+ VRAM 필요 (INT4) |

| 공식 API | 안정적인 성능, 완전한 기능 | 표준 개발 및 테스트 환경 | 입력 $0.60/M, 출력 $3/M |

| APIYI | 통합 인터페이스, 모델 전환 용이 | 빠른 검증, 비용 민감한 경우 | 종량제, 신규 사용자 무료 크레딧 |

Kimi K2.5 연동 세 가지 방식 상세 설명

방식 1: 로컬 자체 배포

GPU 리소스가 충분하고 데이터 프라이버시 요구가 높은 기업에 적합합니다. vLLM 또는 SGLang을 이용한 배포를 권장합니다.

# Ollama를 이용한 원클릭 배포 (48GB+ VRAM 필요)

ollama run kimi-k2.5

방식 2: 공식 API

Moonshot 공식 플랫폼을 통해 연동하여 최신 기능 지원을 받을 수 있습니다.

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

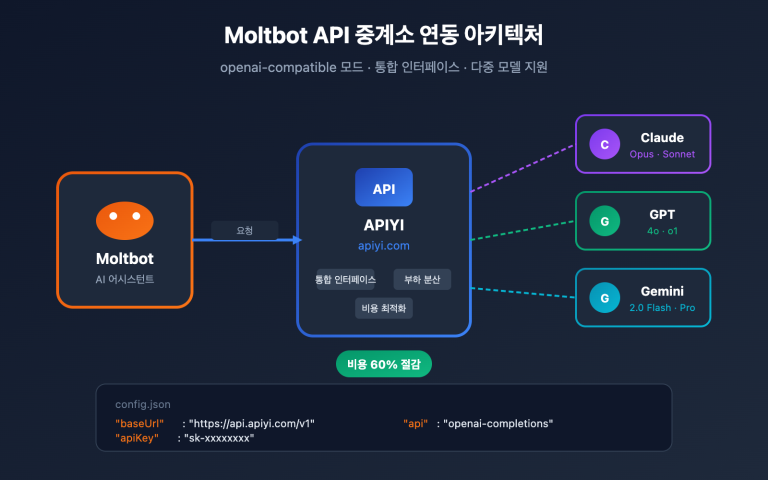

방식 3: APIYI 플랫폼 연동 (추천)

Kimi K2.5는 이미 APIYI(apiyi.com)에 출시되어 있으며, 다음과 같은 장점을 제공합니다.

- OpenAI 규격의 통합 인터페이스로 학습 비용 제로

- GPT-4o, Claude 등 다른 모델과 빠른 전환 및 비교 가능

- 신규 사용자에게 무료 테스트 크레딧 증정

- 안정적인 접속 환경 제공 및 별도 대리 서버 불필요

연동 팁: 먼저 APIYI(apiyi.com)를 통해 기능 검증과 효과 평가를 진행한 후, 비즈니스 상황에 맞춰 자체 배포 여부를 결정하시는 것이 효율적입니다.

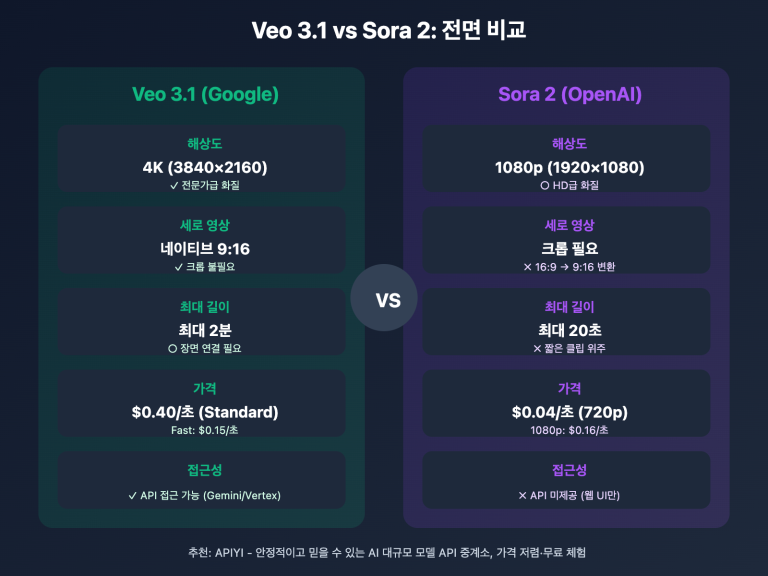

Kimi K2.5 및 경쟁사 API 비용 비교

| 모델 | 입력 가격 | 출력 가격 | 단회 요청 비용 (5K 출력) | 비교 |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | 기준 |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | 38% 비쌈 |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | 444% 비쌈 |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | 81% 비쌈 |

Kimi K2.5는 일부 폐쇄형 모델에 근접하거나 심지어 능가하는 성능을 보이면서도, 비용은 Claude Opus 4.5의 약 1/5 수준에 불과해요. 현재 가성비가 가장 뛰어난 조 단위 매개변수 모델 중 하나라고 할 수 있습니다.

자주 묻는 질문 (FAQ)

Q1: Kimi K2.5는 오픈 소스인가요? 상업적 이용이 가능한가요?

네, Kimi K2.5는 2026년 1월 26일에 완전히 오픈 소스로 공개되었으며, Modified MIT License를 따릅니다. 코드와 모델 가중치 모두 무료로 얻을 수 있으며 상업적 이용, 수정 및 배포를 지원해요.

Q2: Kimi K2.5의 Thinking 모드와 Instant 모드의 차이점은 무엇인가요?

Thinking 모드는 상세한 추론 과정(reasoning_content)을 반환하므로 복잡한 문제에 적합합니다. 반면 Instant 모드는 답변을 즉시 제공하여 응답 속도가 더 빠르죠. 수학이나 논리 문제는 Thinking 모드를, 일상적인 대화는 Instant 모드를 사용하시는 것을 추천드려요.

Q3: Kimi K2.5 연동 효과를 빠르게 테스트하려면 어떻게 해야 하나요?

여러 모델을 지원하는 API 통합 플랫폼을 사용하여 테스트해보시는 것을 추천합니다.

- APIYI(apiyi.com)에 접속하여 계정을 생성하세요.

- API Key와 무료 크레딧을 받으세요.

- 본문의 코드 예시를 사용하여

base_url을https://vip.apiyi.com/v1로 설정합니다. - 모델명에

kimi-k2.5를 입력하면 바로 호출할 수 있습니다.

요약

Kimi K2.5 오픈소스 연동의 핵심 요약:

- 완전 오픈소스: Kimi K2.5는 Modified MIT License를 채택하여 코드와 가중치 모두 상업적 이용이 가능해요.

- 다양한 연동 방식: 자체 배포, 공식 API, 서드파티 플랫폼의 세 가지 방식을 지원하므로 필요에 따라 선택할 수 있습니다.

- 압도적인 가성비: 조 단위 파라미터 모델임에도 비용은 Claude Opus 4.5의 5분의 1 수준이에요.

Kimi K2.5는 이미 APIYI apiyi.com에 출시되었어요. 신규 사용자는 무료 크레딧을 받을 수 있으니, 플랫폼을 통해 모델 성능을 빠르게 검증하고 여러분의 비즈니스 시나리오에 적합한지 평가해 보시는 걸 추천합니다.

참고 자료

⚠️ 링크 형식 안내: 모든 외부 링크는 복사하기 쉽지만 SEO 점수 유실을 방지하기 위해

자료명: domain.com형식을 사용하며, 클릭하여 이동할 수 없습니다.

-

Kimi K2.5 HuggingFace 모델 카드: 공식 모델 가중치 및 기술 문서

- 링크:

huggingface.co/moonshotai/Kimi-K2.5 - 설명: 모델 가중치, 배포 가이드 및 API 사용 예시 확인

- 링크:

-

Kimi K2.5 기술 보고서: 상세 모델 아키텍처 및 학습 방법

- 링크:

kimi.com/blog/kimi-k2-5.html - 설명: Agent Swarm, MoE 아키텍처 등 핵심 기술 세부 사항 파악

- 링크:

-

Moonshot 오픈 플랫폼: 공식 API 문서 및 SDK

- 링크:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - 설명: 공식 연동 가이드, 가격 정책 및 속도 제한 설명 포함

- 링크:

-

Ollama Kimi K2.5: 로컬 원클릭 배포 솔루션

- 링크:

ollama.com/library/kimi-k2.5 - 설명: 로컬 테스트 및 소규모 배포 시나리오에 적합

- 링크:

작성자: 기술 팀

기술 교류: 댓글창에서 Kimi K2.5 사용 경험을 자유롭게 나누어 주세요. 더 많은 모델 비교와 튜토리얼은 APIYI apiyi.com 기술 커뮤니티에서 확인하실 수 있습니다.