O OpenClaw é o projeto de assistente de IA de código aberto mais popular do início de 2026, com mais de 100 mil estrelas no GitHub. No entanto, muitos desenvolvedores encontraram um erro confuso ao configurar o modelo Claude: ValidationException: invalid beta flag.

Este artigo analisará profundamente a causa raiz desse erro invalid beta flag na API do Claude com o OpenClaw e fornecerá 5 soluções comprovadas para ajudar você a normalizar o funcionamento do seu assistente de IA rapidamente.

Análise do erro "invalid beta flag" no OpenClaw

Ao configurar o AWS Bedrock ou o Google Vertex AI como provedores do modelo Claude no OpenClaw, você pode se deparar com a seguinte mensagem de erro:

{

"type": "error",

"error": {

"type": "invalid_request_error",

"message": "invalid beta flag"

}

}

Manifestações típicas do erro na API Claude do OpenClaw

| Cenário de Erro | Mensagem de Erro | Impacto |

|---|---|---|

| Chamada AWS Bedrock | ValidationException: invalid beta flag |

Falha em todas as requisições do modelo Claude |

| Chamada Vertex AI | 400 Bad Request: invalid beta flag |

Claude Sonnet/Opus indisponível |

| Proxy LiteLLM | {"message":"invalid beta flag"} |

Todas as solicitações do proxy falharam |

| Variante de Contexto 1M | bedrock:anthropic.claude-sonnet-4-20250514-v1:0:1m falhou |

Cenários de contexto longo indisponíveis |

Impactos diretos do erro no OpenClaw

Este erro "invalid beta flag" no OpenClaw causa:

- Assistente de IA totalmente sem resposta – O OpenClaw não consegue completar nenhuma tarefa relacionada ao Claude.

- Plataformas de mensagens exibem conteúdo vazio – WhatsApp, Telegram e outras plataformas retornam "(no output)".

- Modelos de backup também falham – Se o Vertex AI estiver configurado como fallback, ele também apresentará o erro.

- Experiência do usuário seriamente prejudicada – Exige intervenção manual frequente.

Causa raiz do erro "invalid beta flag" no OpenClaw

Mecanismo de Beta Header da API Claude

A API Claude da Anthropic permite habilitar funções experimentais através do cabeçalho de requisição anthropic-beta. Esses recursos beta incluem:

| Identificador Beta | Descrição da funcionalidade | Plataformas suportadas |

|---|---|---|

computer-use-2024-10-22 |

Capacidade de uso do computador | Anthropic Direto |

token-counting-2024-11-01 |

API de contagem de tokens | Anthropic Direto |

context-1m-2025-08-07 |

Janela de contexto de 1M | Anthropic Direto |

tmp-preserve-thinking-2025-10-01 |

Retenção do processo de pensamento | Apenas Anthropic Direto |

interleaved-thinking-2025-05-14 |

Modo de pensamento intercalado | Apenas Anthropic Direto |

Por que o OpenClaw envia o Beta Header?

As dependências subjacentes do OpenClaw (como Claude SDK, LiteLLM, etc.) anexam automaticamente cabeçalhos beta ao enviar requisições:

anthropic-beta: claude-code-20250219,context-1m-2025-08-07,interleaved-thinking-2025-05-14,fine-grained-tool-streaming-2025-05-14,tmp-preserve-thinking-2025-10-01

Limitações do AWS Bedrock e Vertex AI

Esta é a causa raiz do erro "invalid beta flag" no OpenClaw:

O AWS Bedrock e o Google Vertex AI, como serviços gerenciados, não suportam as funções beta da Anthropic. Quando esses cabeçalhos beta são repassados para os serviços de nuvem, o servidor rejeita a requisição imediatamente e retorna o erro invalid beta flag.

🎯 Problema central: Os cabeçalhos beta injetados automaticamente pelo SDK são incompatíveis com o Bedrock/Vertex AI, mas o SDK não filtra esses cabeçalhos automaticamente com base no endpoint de destino.

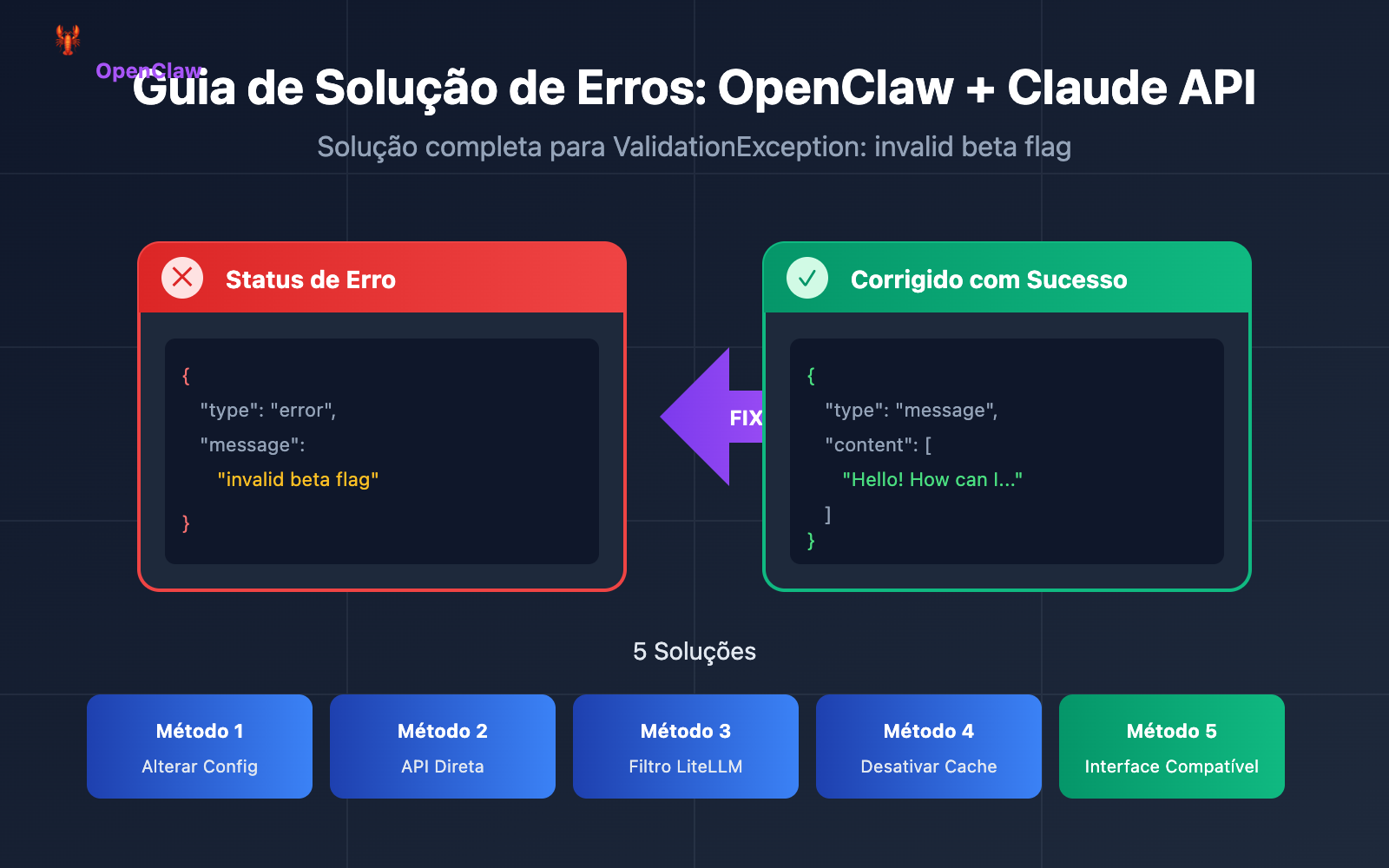

5 formas de resolver o erro "invalid beta flag" no OpenClaw

Método 1: Modificar a configuração do modelo no OpenClaw (Recomendado)

A maneira mais simples é desativar explicitamente as funcionalidades beta na configuração do OpenClaw.

Edite o arquivo ~/.openclaw/openclaw.json:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"options": {

"beta_features": []

}

}

}

}

}

Explicação da configuração do OpenClaw:

| Item de Configuração | Função | Valor Recomendado |

|---|---|---|

beta_features |

Controla as funcionalidades beta ativadas | [] (array vazio) |

extra_headers |

Headers personalizados da requisição | Não definir nada relacionado a beta |

disable_streaming |

Desativa a transmissão via streaming | false |

Método 2: Usar a API direta da Anthropic (Mais estável)

A maneira mais confiável de evitar o erro "invalid beta flag" no OpenClaw é usar diretamente a API oficial da Anthropic, em vez de passar pelo Bedrock ou Vertex AI.

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4"

}

}

}

}

Configure a variável de ambiente:

export ANTHROPIC_API_KEY="sua-chave-api-anthropic"

🚀 Início Rápido: Se você não tem uma chave de API da Anthropic, pode obter créditos de teste rapidamente através do APIYI (apiyi.com). A plataforma oferece uma interface compatível com OpenAI e suporte para toda a linha de modelos Claude.

Método 3: Configurar o LiteLLM para filtrar o Beta Header

Se você utiliza o LiteLLM como proxy para os modelos do OpenClaw, pode configurar a filtragem de headers:

# litellm_config.py

import litellm

# Configuração para não enviar o beta header para o Bedrock

litellm.drop_params = True

litellm.modify_params = True

# Ou configure no arquivo config.yaml

# model_list:

# - model_name: claude-sonnet

# litellm_params:

# model: bedrock/anthropic.claude-3-sonnet

# drop_params: true

Método 4: Desativar o Prompt Caching (Solução temporária)

Em alguns casos, o erro "invalid beta flag" no OpenClaw está relacionado à funcionalidade de prompt caching. Desativar o cache pode resolver o problema:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"cache": {

"enabled": false

}

}

}

}

}

Método 5: Mudar para um provedor de modelos compatível

Se você precisa usar serviços de nuvem gerenciados, mas quer evitar o erro "invalid beta flag" no OpenClaw, considere usar um serviço de proxy compatível com OpenAI:

{

"models": {

"providers": [

{

"name": "apiyi",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "sua-chave-api",

"models": ["claude-sonnet-4", "claude-opus-4-5"]

}

]

}

}

💡 Sugestão de escolha: Usar uma interface compatível com OpenAI elimina completamente os problemas de beta header, mantendo uma excelente compatibilidade com o OpenClaw. O APIYI (apiyi.com) oferece essa interface unificada, com suporte para Claude, GPT, Gemini e outros modelos.

Melhores Práticas de Configuração do Modelo OpenClaw

Exemplo de Configuração Completa

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "openai/gpt-4o",

"options": {

"temperature": 0.7,

"max_tokens": 4096

}

},

"sandbox": {

"mode": "non-main"

}

}

},

"models": {

"providers": [

{

"name": "apiyi-claude",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"models": ["claude-sonnet-4", "claude-opus-4-5", "claude-haiku"]

}

]

}

}

Sugestões de Escolha de Modelo para o OpenClaw

| Cenário de Uso | Modelo Recomendado | Escolha do Provedor |

|---|---|---|

| Conversas Diárias | Claude Haiku | Conexão Direta Anthropic / APIYI |

| Geração de Código | Claude Sonnet 4 | Conexão Direta Anthropic / APIYI |

| Raciocínio Complexo | Claude Opus 4.5 | Conexão Direta Anthropic / APIYI |

| Sensível a Custos | GPT-4o-mini | OpenAI / APIYI |

| Implantação Local | Llama 3.3 | Ollama |

Fluxo de Resolução de Erros "invalid beta flag" no OpenClaw

<circle cx="30" cy="60" r="8" fill="url(#blueGrad4)" />

<text x="30" y="64" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">1</text>

<text x="45" y="64" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Alterar config para desativar Beta</text>

<circle cx="30" cy="85" r="8" fill="url(#blueGrad4)" />

<text x="30" y="89" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">2</text>

<text x="45" y="89" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Mudar para Conexão Direta Anthropic</text>

<circle cx="30" cy="110" r="8" fill="url(#blueGrad4)" />

<text x="30" y="114" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">3</text>

<text x="45" y="114" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Usar interface compatível com OpenAI</text>

<circle cx="30" cy="135" r="8" fill="url(#greenGrad4)" />

<text x="30" y="139" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">★</text>

<text x="45" y="139" font-family="Arial, sans-serif" font-size="10" fill="#10b981">Recomendado: APIYI apiyi.com</text>

<text x="25" y="60" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• A API Key é válida?</text>

<text x="25" y="80" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• A conexão de rede está normal?</text>

<text x="25" y="100" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• O nome do modelo está correto?</text>

<text x="25" y="120" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• Atingiu o Rate Limit?</text>

Passos para Resolução

Passo 1: Confirmar a origem do erro

# Verificar logs do OpenClaw

tail -f ~/.openclaw/logs/openclaw.log | grep -i "beta"

Passo 2: Verificar a configuração atual

# Verificar configuração do modelo

cat ~/.openclaw/openclaw.json | jq '.agents.defaults.model'

Passo 3: Testar a conectividade da API

# Testar com curl (sem o beta header)

curl -X POST https://api.anthropic.com/v1/messages \

-H "Content-Type: application/json" \

-H "x-api-key: $ANTHROPIC_API_KEY" \

-H "anthropic-version: 2023-06-01" \

-d '{

"model": "claude-sonnet-4-20250514",

"max_tokens": 100,

"messages": [{"role": "user", "content": "Hello"}]

}'

Passo 4: Validar o resultado da correção

# Reiniciar o serviço OpenClaw

openclaw restart

# Enviar mensagem de teste

openclaw chat "Mensagem de teste"

Resultados Comuns de Diagnóstico

| Resultado | Análise da Causa | Solução |

|---|---|---|

| API Direta funciona, Bedrock falha | Incompatibilidade de Beta header | Usar Método 1 ou Método 2 |

| Todas as requisições falham | Problema na API Key ou na rede | Verificar credenciais e rede |

| Falhas intermitentes | Pode ser rate limit | Verificar frequência de chamadas |

| Falha em modelo específico | ID do modelo incorreto ou indisponível | Confirmar se o nome do modelo está correto |

Exemplos de código para chamadas do Claude no OpenClaw

Exemplo de chamada direta em Python (evitando o erro "invalid beta flag")

import anthropic

# Criando o cliente - sem ativar nenhuma funcionalidade beta

client = anthropic.Anthropic(

api_key="your-api-key",

base_url="https://api.apiyi.com/v1" # Usando a interface unificada da APIYI

)

# Enviando a mensagem - sem usar parâmetros beta

message = client.messages.create(

model="claude-sonnet-4-20250514",

max_tokens=1024,

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(message.content[0].text)

Chamada compatível com o SDK da OpenAI

from openai import OpenAI

# Usando a interface compatível com OpenAI para evitar totalmente problemas de header beta

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # Interface unificada da APIYI

)

response = client.chat.completions.create(

model="claude-sonnet-4",

messages=[

{"role": "user", "content": "Hello!"}

]

)

print(response.choices[0].message.content)

🎯 Sugestão técnica: Usar a interface compatível com OpenAI é a solução mais simples para evitar o erro

invalid beta flagno OpenClaw. A interface unificada fornecida pela APIYI (apiyi.com) não é apenas compatível com o Claude, mas também suporta modelos principais como GPT e Gemini, facilitando a troca entre modelos durante os testes.

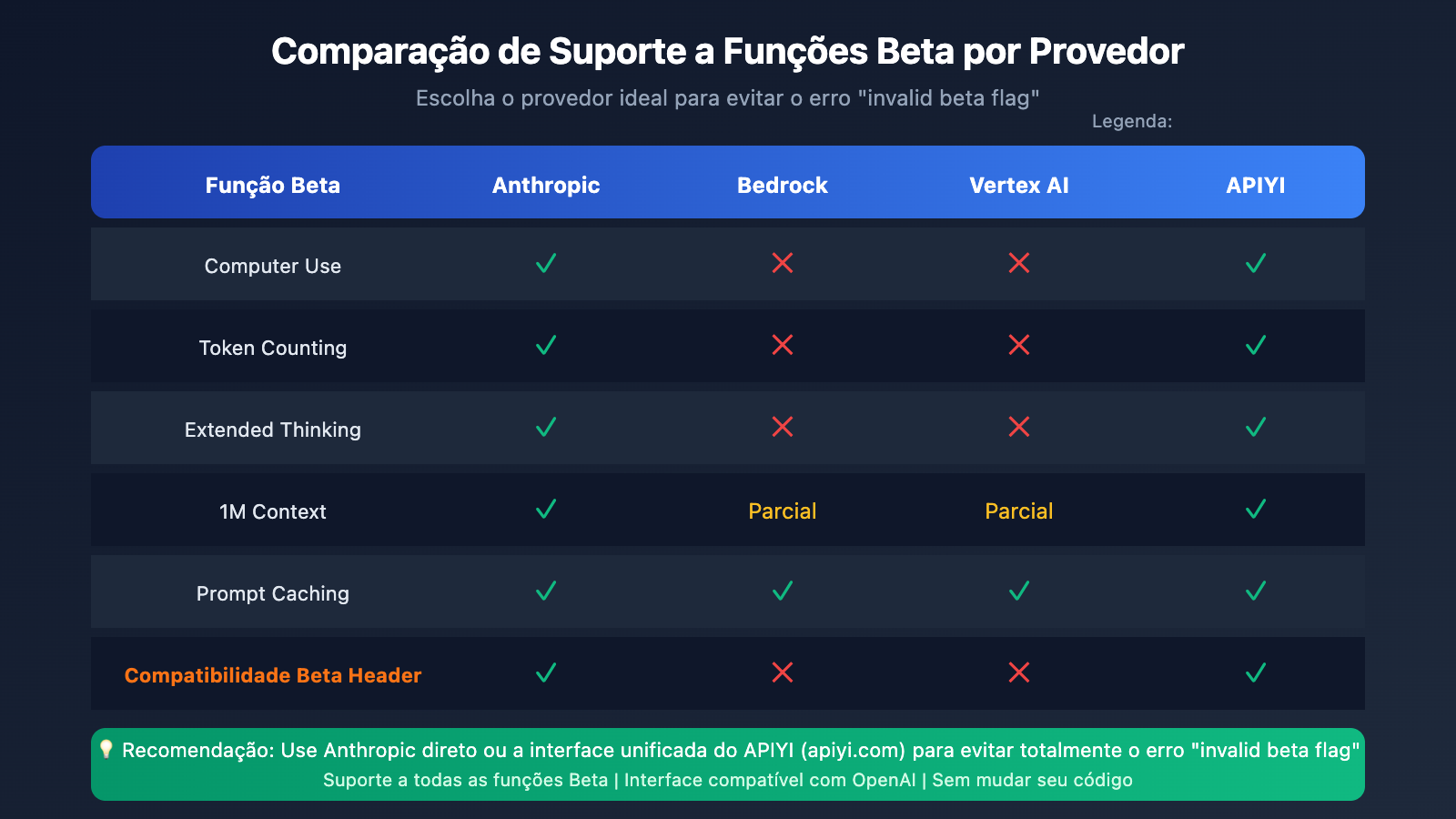

Compatibilidade do OpenClaw com diferentes provedores de nuvem

Matriz de suporte para funcionalidades Beta em serviços de nuvem

| Funcionalidade | Conexão direta Anthropic | AWS Bedrock | Vertex AI | APIYI |

|---|---|---|---|---|

| API de Mensagens básica | ✅ | ✅ | ✅ | ✅ |

| Computer Use | ✅ | ❌ | ❌ | ✅ |

| Contagem de Tokens | ✅ | ❌ | ❌ | ✅ |

| Raciocínio Estendido (Extended Thinking) | ✅ | ❌ | ❌ | ✅ |

| Contexto de 1M | ✅ | Parcial | Parcial | ✅ |

| Cache de Comandos (Prompt Caching) | ✅ | ✅ | ✅ | ✅ |

Por que escolher um serviço de intermediação (proxy) de API

Para usuários do OpenClaw, utilizar um serviço de intermediação de API oferece as seguintes vantagens:

- Melhor compatibilidade – Processamento automático de conversão de headers, evitando o erro

invalid beta flag. - Melhor custo-benefício – Geralmente mais econômico do que chamar as APIs oficiais diretamente.

- Troca facilitada – Interface unificada, permitindo alternar facilmente entre diferentes modelos de linguagem grandes.

- Alta estabilidade – Balanceamento de carga em múltiplos nós, evitando falhas em pontos únicos.

Perguntas Frequentes (FAQ) sobre o erro invalid beta flag no OpenClaw

Q1: Por que o erro invalid beta flag só ocorre ao usar o Bedrock?

O AWS Bedrock é um serviço gerenciado da Amazon que oferece acesso aos modelos Claude, mas não suporta as funcionalidades experimentais (beta) da Anthropic. Quando o OpenClaw ou suas bibliotecas dependentes anexam automaticamente um cabeçalho (header) de beta, o Bedrock rejeita essas solicitações.

Solução: Use a API direta da Anthropic ou configure a filtragem de headers beta. Se precisar testar rapidamente no Brasil ou em outras regiões, você pode obter créditos gratuitos através da APIYI (apiyi.com) para realizar a validação.

Q2: O que fazer se o erro persistir após alterar a configuração?

Isso pode ser causado por cache de configuração ou porque o serviço não foi reiniciado. Siga estes passos:

- Pare completamente o OpenClaw:

openclaw stop - Limpe o cache:

rm -rf ~/.openclaw/cache/* - Reinicie:

openclaw start

Q3: Posso usar o Bedrock e a API direta ao mesmo tempo?

Sim. Recomendamos definir a conexão direta da Anthropic como provedor principal (suporta todas as funções) e o Bedrock como reserva (sem usar funções beta):

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "bedrock/anthropic.claude-3-sonnet"

}

}

}

}

Q4: Quais provedores de modelo o OpenClaw suporta?

O OpenClaw suporta mais de 12 provedores de modelos, incluindo:

- Conexão Direta Oficial: Anthropic, OpenAI, Google Gemini, Mistral

- Hospedagem em Nuvem: AWS Bedrock, Google Vertex AI

- Serviços de Proxy: OpenRouter, APIYI

- Implantação Local: Ollama, LM Studio

💰 Otimização de Custos: Para desenvolvedores independentes atentos ao orçamento, sugerimos chamar a API do Claude via APIYI (apiyi.com). A plataforma oferece faturamento flexível, pague apenas pelo que usar, sem mensalidades mínimas.

Q5: O erro invalid beta flag afeta todos os modelos Claude?

Sim, esse erro afeta todos os modelos Claude chamados via Bedrock ou Vertex AI, incluindo as séries Claude Haiku, Sonnet e Opus.

Resumo

A causa principal do erro "OpenClaw Claude API invalid beta flag" é a incompatibilidade entre os headers beta anexados automaticamente pelo SDK e o AWS Bedrock / Vertex AI. Através dos 5 métodos apresentados neste artigo, você pode resolver o problema de forma eficaz:

- Alterar a configuração do OpenClaw – Desativar funções beta.

- Usar conexão direta da Anthropic – Totalmente compatível com todos os recursos.

- Configurar filtragem no LiteLLM – Resolvido na camada de proxy.

- Desativar Prompt Caching – Solução temporária de contorno.

- Mudar para um provedor compatível – Usar interfaces compatíveis com OpenAI.

Para a maioria dos usuários do OpenClaw, recomendamos usar a API direta da Anthropic ou um serviço de proxy compatível com OpenAI para evitar esse problema definitivamente. Recomendamos verificar os resultados rapidamente via APIYI (apiyi.com), que suporta toda a linha de modelos Claude com uma interface unificada compatível com OpenAI.

Referências

-

GitHub – Repositório Oficial OpenClaw: Código-fonte e documentação

- Link:

github.com/openclaw/openclaw

- Link:

-

GitHub – LiteLLM invalid beta flag Issue: Discussão da comunidade

- Link:

github.com/BerriAI/litellm/issues/14043

- Link:

-

GitHub – Cline invalid beta flag Issue: Relatórios de erros relacionados

- Link:

github.com/cline/cline/issues/5568

- Link:

-

Documentação de Beta Headers da Anthropic: Explicação oficial das funções beta

- Link:

docs.anthropic.com/en/api/beta-headers

- Link:

-

Documentação Oficial OpenClaw: Guia de configuração de modelos

- Link:

docs.openclaw.ai/concepts/model-providers

- Link:

📝 Autor: Equipe Técnica APIYI

Para saber mais dicas sobre chamadas de API de modelos de IA, visite APIYI (apiyi.com) para suporte técnico.