"Olá, tenho uma conta no Google AI Studio, mas o limite gratuito está esgotado. Quero continuar criando modelos no AI Studio, mas minha conta gratuita não recarrega. Como recarregar minha conta do Google ou existe outra forma de continuar usando?"

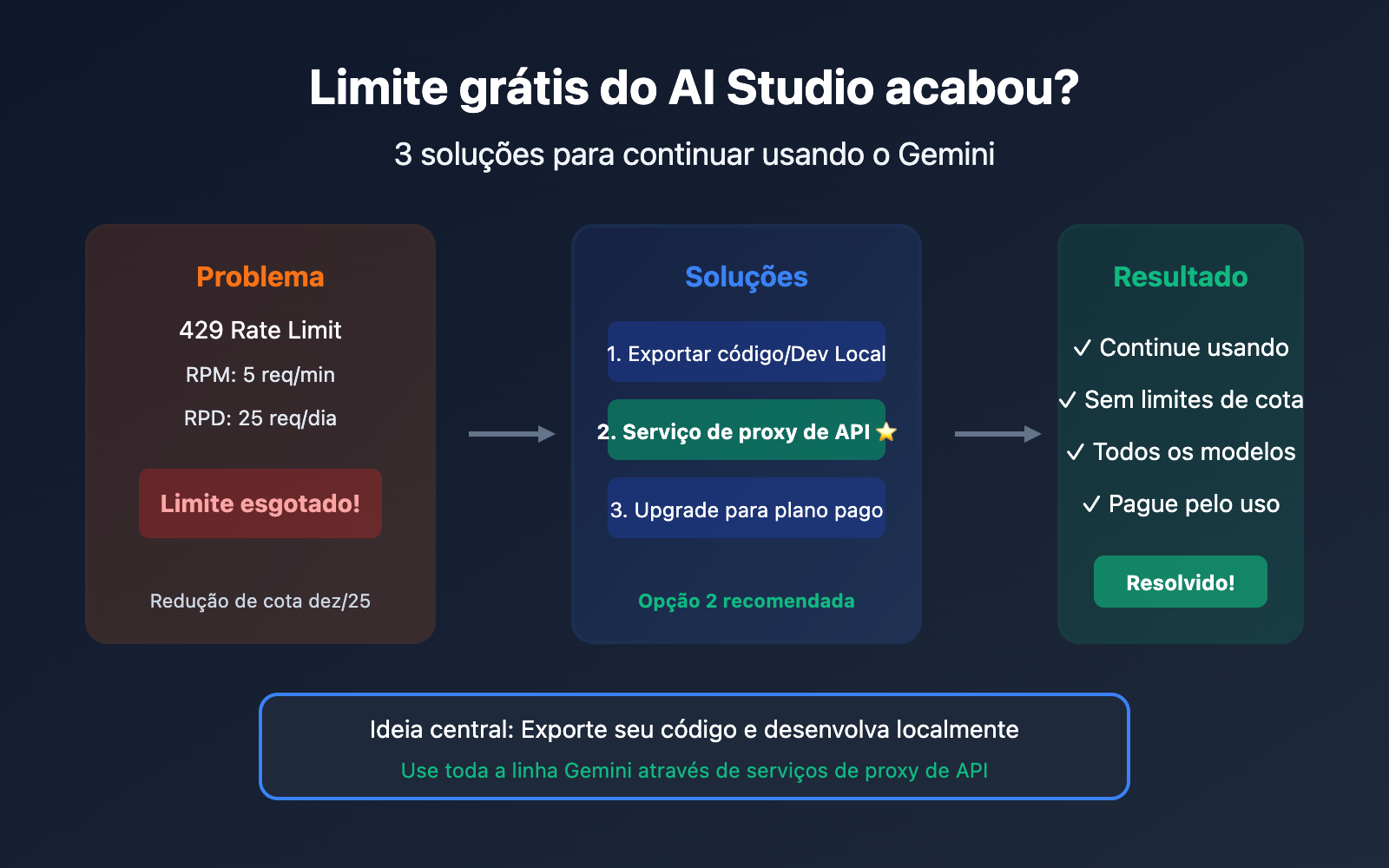

Essa é uma dúvida que recebemos todos os dias. Os limites gratuitos do Google AI Studio são realmente restritos e, em dezembro de 2025, o Google reduziu drasticamente as cotas do nível gratuito.

A boa notícia é: você não precisa recarregar sua conta do Google para continuar usando toda a linha de modelos Gemini.

A ideia central é simples: exporte seu código e faça as chamadas de desenvolvimento localmente.

Este artigo apresentará detalhadamente 3 soluções para ajudar você a continuar usando o Gemini após esgotar o limite gratuito.

Entenda os limites de cota do AI Studio

Cotas atuais do nível gratuito (2026)

Em 7 de dezembro de 2025, o Google fez ajustes importantes nas cotas da API Gemini para desenvolvedores, e muitos aplicativos começaram a apresentar o erro 429 repentinamente:

| Modelo | RPM (Grátis) | RPD (Grátis) | RPM (Pago) |

|---|---|---|---|

| Gemini 1.5 Pro | 5 | 25 | 1.000 |

| Gemini 1.5 Flash | 15 | 500 | 2.000 |

| Gemini 2.0 Flash | 15 | 1.500 | 4.000 |

Obs: RPM = Requisições por minuto, RPD = Requisições por dia.

Por que os limites se esgotam de repente

| Causa | Explicação |

|---|---|

| Excesso de RPM | Muitas requisições em um curto intervalo de tempo |

| Excesso de RPD | O total de requisições diárias atingiu o limite |

| Excesso de TPM | Contextos longos consomem muitos Tokens |

| Redução de cota | Restrições mais severas após o ajuste de dez/2025 |

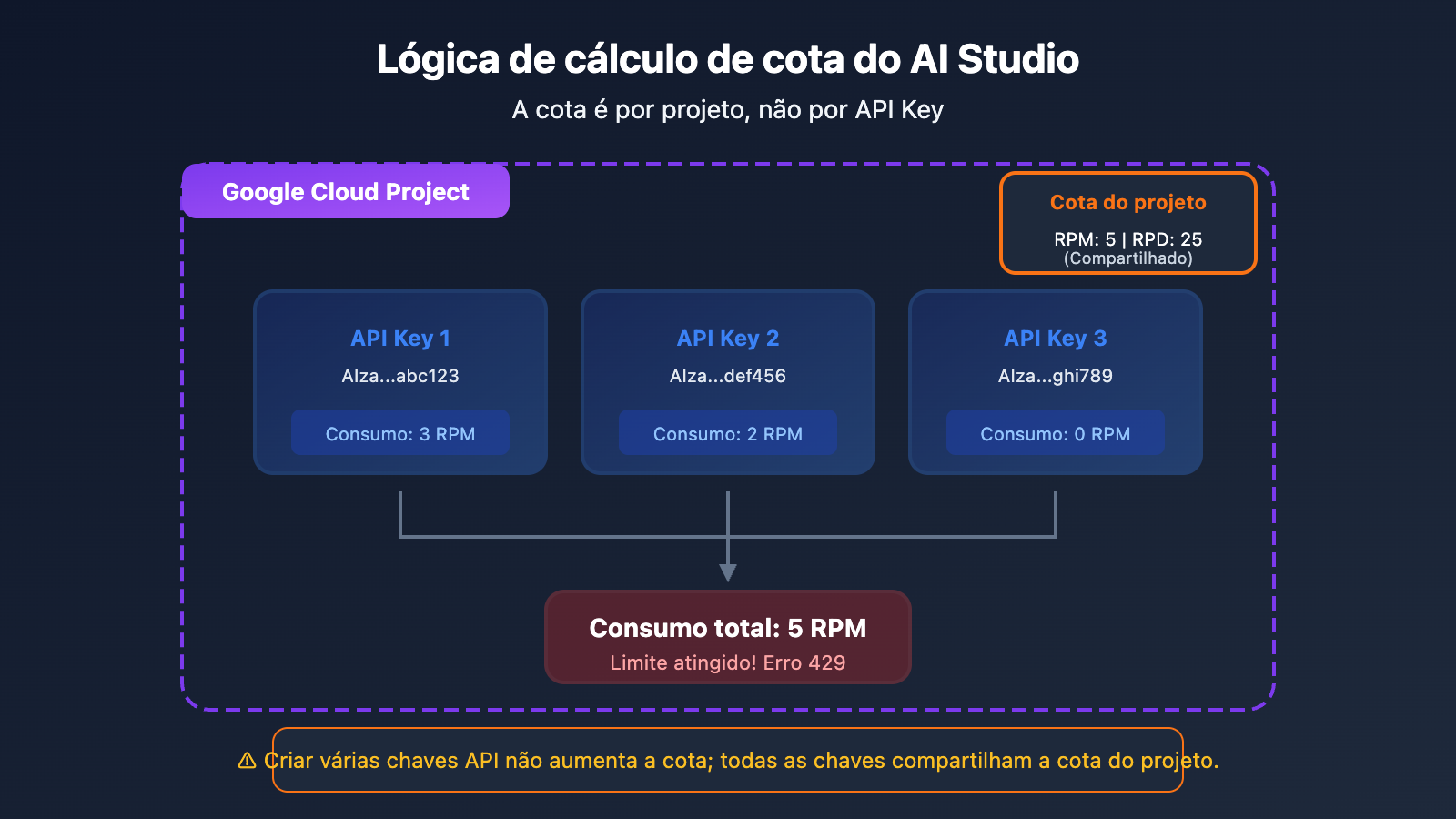

Aviso importante: vários API Keys não aumentam a cota

Muitos usuários acham que criar várias chaves de API garante mais cota, mas na verdade:

A cota é calculada por projeto (Project), não por API Key. Criar vários API Keys no mesmo projeto não aumentará sua cota de forma alguma.

Solução 1: Exportar o código para desenvolvimento local (Recomendado)

Ideia central

A essência do AI Studio é ser uma ferramenta visual de depuração de comandos. Os modelos que você cria e os comandos que depura no AI Studio podem ser exportados como código e utilizados em seu ambiente local usando sua própria chave de API.

Passo a passo

Passo 1: Finalize a depuração do comando no AI Studio

Utilize a cota gratuita do AI Studio para ajustar seu comando, configurações de parâmetros, etc.

Passo 2: Exportar o código

O AI Studio oferece várias formas de exportação:

- Baixar ZIP: Exporta o pacote de código completo para o seu computador.

- Enviar para o GitHub: Envia diretamente para o seu repositório de código.

- Copiar trechos de código: Copia o código em Python, JavaScript ou curl.

Passo 3: Configurar a Chave de API localmente

# Definir variável de ambiente (recomendado)

export GEMINI_API_KEY="sua-chave-api-aqui"

# Ou

export GOOGLE_API_KEY="sua-chave-api-aqui"

Passo 4: Executar localmente

import google.generativeai as genai

import os

# Lê automaticamente a Chave de API das variáveis de ambiente

genai.configure(api_key=os.environ.get("GEMINI_API_KEY"))

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Olá, por favor, apresente-se")

print(response.text)

Observações

| Item | Descrição |

|---|---|

| Segurança da API Key | Não escreva a API Key diretamente no código do cliente (hardcoding) |

| Variáveis de Ambiente | Use GEMINI_API_KEY ou GOOGLE_API_KEY |

| Cotas ainda limitadas | As chamadas locais ainda estão sujeitas aos limites de cota do nível gratuito |

🎯 Dica técnica: Após exportar o código, se a cota gratuita ainda não for suficiente, você pode considerar o uso de provedores de API de terceiros, como o APIYI (apiyi.com). Essas plataformas oferecem cotas maiores e formas de cobrança mais flexíveis.

Solução 2: Usar um serviço de proxy de API de terceiros (Melhor opção)

O que é um serviço de proxy de API

Os provedores de proxy de API agregam várias chaves de API e recursos de conta para oferecer uma interface de API unificada. Você só precisa:

- Se registrar na plataforma de proxy para obter uma API Key.

- Alterar o endereço da API no seu código para o endereço do proxy.

- Continuar usando, sem se preocupar com problemas de cota.

Por que escolher um proxy de API

| Vantagem | Descrição |

|---|---|

| Sem ansiedade com cotas | O provedor gerencia as cotas, você apenas usa |

| Suporte a toda a linha de modelos | Cobertura total para Gemini Pro, Flash, Nano Banana, etc. |

| Formato compatível com OpenAI | Não é necessário alterar a estrutura do código existente |

| Pagamento por uso | Pague apenas pelo que usar, sem mensalidades |

| Mais estável | Balanceamento de carga em múltiplos nós para evitar limites de tráfego em um único ponto |

Exemplo de migração de código

Antes da migração (Chamada direta à API do Google):

import google.generativeai as genai

genai.configure(api_key="SUA_GOOGLE_API_KEY")

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Hello")

Depois da migração (Usando proxy de API):

import openai

client = openai.OpenAI(

api_key="SUA_CHAVE_APIYI",

base_url="https://api.apiyi.com/v1" # Interface unificada do APIYI

)

response = client.chat.completions.create(

model="gemini-2.0-flash",

messages=[{"role": "user", "content": "Hello"}]

)

print(response.choices[0].message.content)

Lista de modelos suportados

| Série do Modelo | Modelos Específicos | Descrição |

|---|---|---|

| Gemini 2.5 | gemini-2.5-pro, gemini-2.5-flash | Modelo multimodal mais recente |

| Gemini 2.0 | gemini-2.0-flash, gemini-2.0-flash-thinking | Modelo de inferência rápida |

| Gemini 3 | gemini-3-pro-image-preview | Modelo de geração de imagens |

| Nano Banana | nano-banana-pro | Geração de imagens nativa |

💡 Início Rápido: Recomendamos usar a plataforma APIYI (apiyi.com) para um acesso rápido. A plataforma suporta toda a série de modelos Gemini, oferece formato compatível com OpenAI e permite completar a migração em apenas 5 minutos.

Opção 3: Upgrade para o nível pago do Google

Comparação de cotas dos níveis pagos

Se você deseja continuar usando os serviços oficiais do Google, pode considerar fazer o upgrade para um nível pago:

| Nível | Condição de ativação | Gemini 2.5 Pro RPM | Gemini 2.5 Flash RPM |

|---|---|---|---|

| Grátis | Padrão | 5 | 15 |

| Nível 1 | Ativar faturamento | 150 | 1.000 |

| Nível 2 | Gasto de $50+ | 500 | 2.000 |

| Nível 3 | Gasto de $500+ | 1.000 | 4.000 |

Passos para o upgrade

- Faça login no Google Cloud Console

- Crie ou selecione um projeto

- Ative o Billing (vincule um cartão de crédito)

- Verifique a alteração das cotas no AI Studio

Problemas do nível pago

| Problema | Descrição |

|---|---|

| Exige cartão de crédito internacional | Pode ser difícil de conseguir para alguns usuários |

| Exige conta no Google Cloud | A configuração é relativamente complexa |

| Limite mínimo de gasto | O upgrade para níveis superiores exige atingir metas de consumo |

| Ainda há limites de cota | O limite apenas aumenta, não se torna ilimitado |

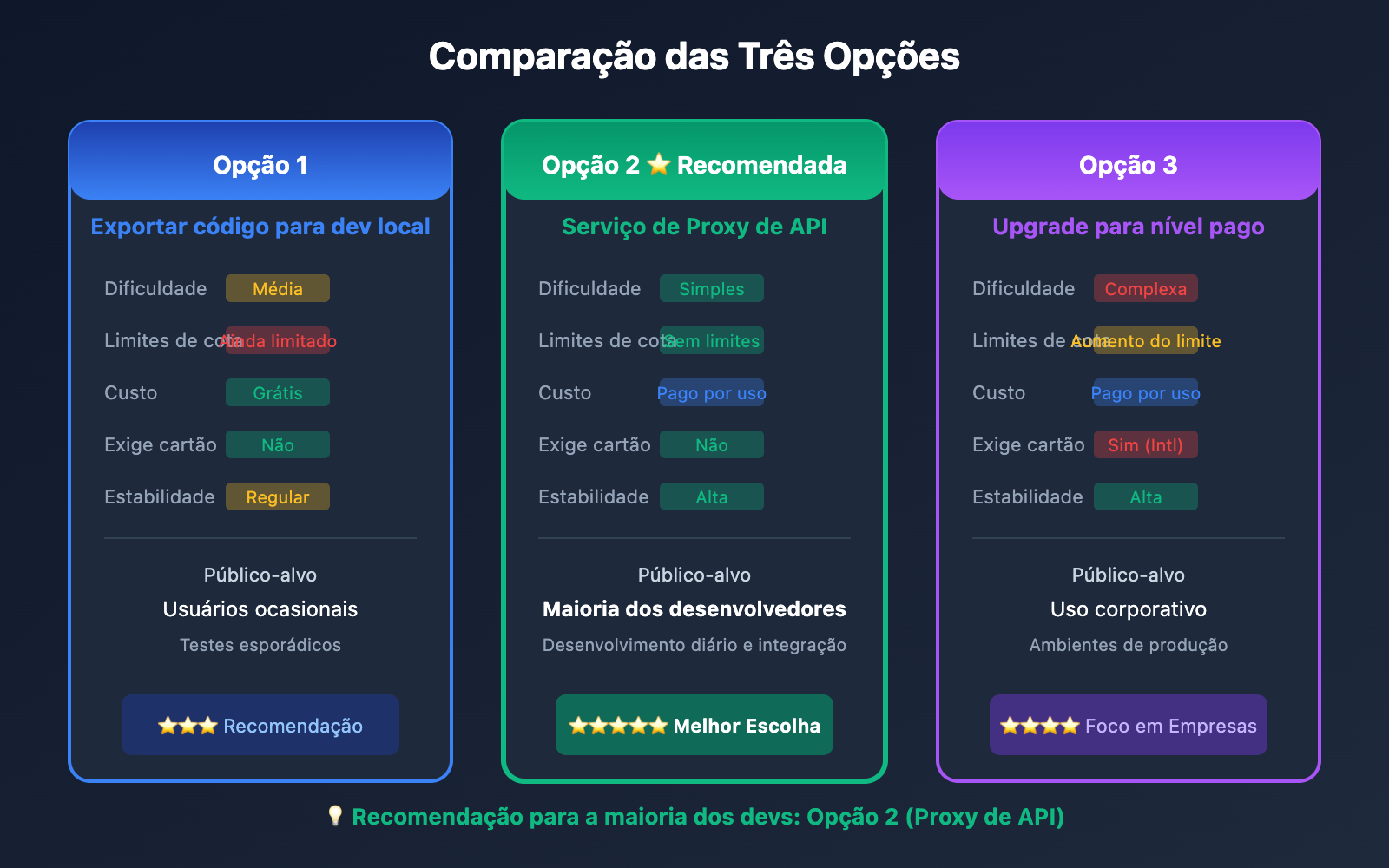

Comparação das três opções

| Dimensão de Comparação | Exportar para Dev Local | Serviço de Proxy de API | Upgrade para Nível Pago |

|---|---|---|---|

| Dificuldade de Configuração | Média | Simples | Complexa |

| Limites de Cota | Ainda limitado | Sem limites | Aumento do limite |

| Custo | Grátis (limitado) | Pago por uso | Pago por uso |

| Exige Cartão de Crédito | Não | Não | Sim (Cartão Intl) |

| Estabilidade | Regular | Alta | Alta |

| Cenário de Uso | Uso leve | Recomendado para a maioria | Necessidades corporativas |

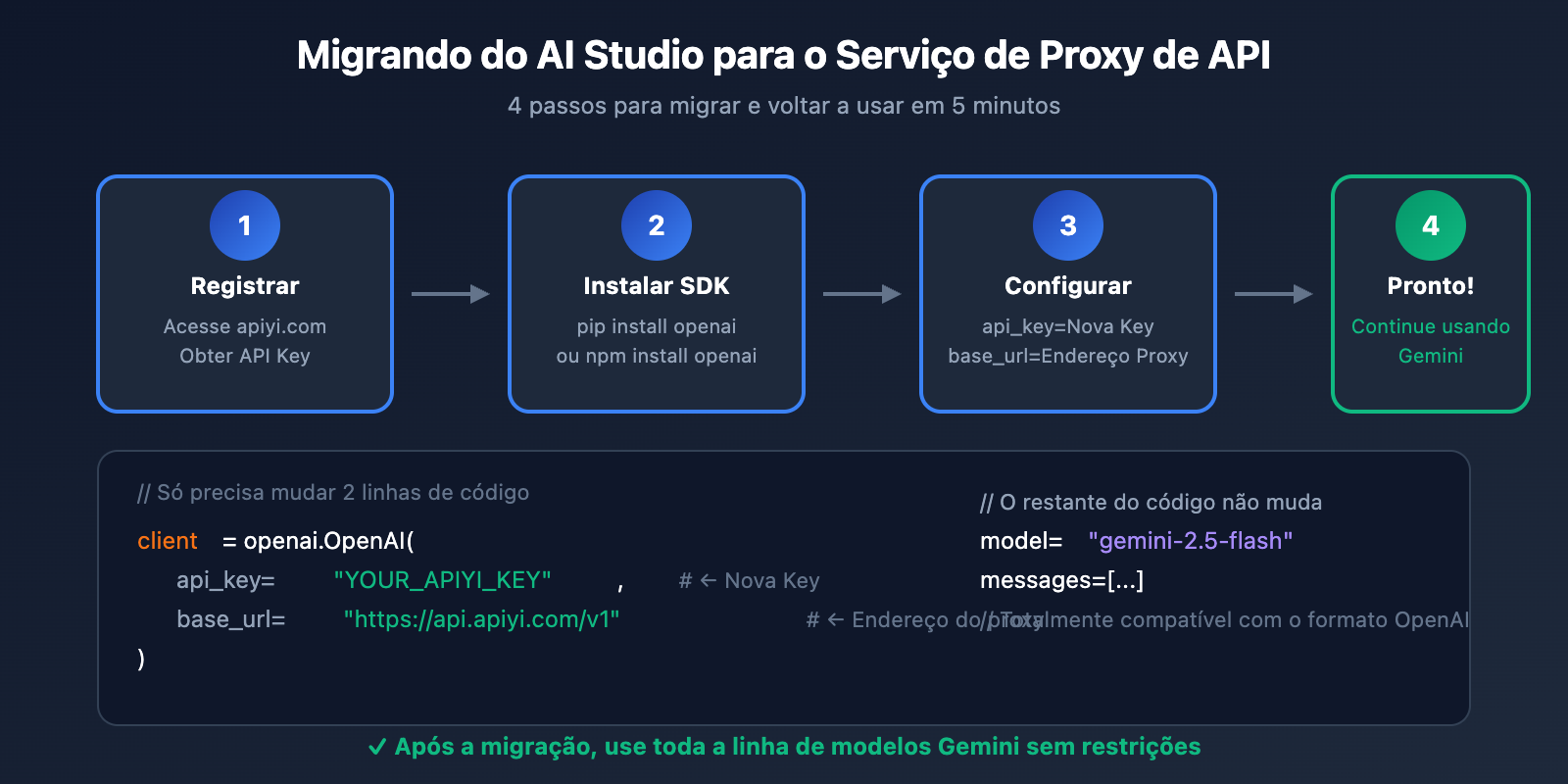

Tutorial detalhado: Migrando do AI Studio para um Proxy de API

Passo 1: Registrar uma conta na plataforma de proxy de API

Acesse a APIYI em apiyi.com, registre sua conta e obtenha sua API Key.

Passo 2: Instalar o SDK da OpenAI

# Python

pip install openai

# Node.js

npm install openai

Passo 3: Modificar a configuração do código

Exemplo em Python:

import openai

# Configurar o proxy de API

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # Interface unificada da APIYI

)

# Chamar o modelo Gemini

def chat_with_gemini(prompt):

response = client.chat.completions.create(

model="gemini-2.5-flash", # Outros modelos Gemini também estão disponíveis

messages=[

{"role": "user", "content": prompt}

],

temperature=0.7,

max_tokens=2048

)

return response.choices[0].message.content

# Exemplo de uso

result = chat_with_gemini("Escreva um algoritmo de quicksort em Python")

print(result)

Exemplo em Node.js:

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: 'YOUR_APIYI_KEY',

baseURL: 'https://api.apiyi.com/v1'

});

async function chatWithGemini(prompt) {

const response = await client.chat.completions.create({

model: 'gemini-2.5-flash',

messages: [

{ role: 'user', content: prompt }

]

});

return response.choices[0].message.content;

}

// Exemplo de uso

const result = await chatWithGemini('Explique o que é aprendizado de máquina');

console.log(result);

Passo 4: Teste e validação

# Testar conexão

try:

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": "Olá, testando conexão"}],

max_tokens=50

)

print("Conexão bem-sucedida:", response.choices[0].message.content)

except Exception as e:

print("Falha na conexão:", e)

Migração de modelos de geração de imagens

Geração de imagens no AI Studio

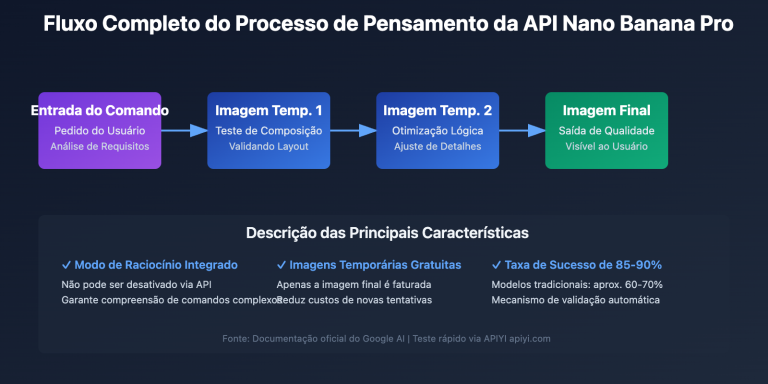

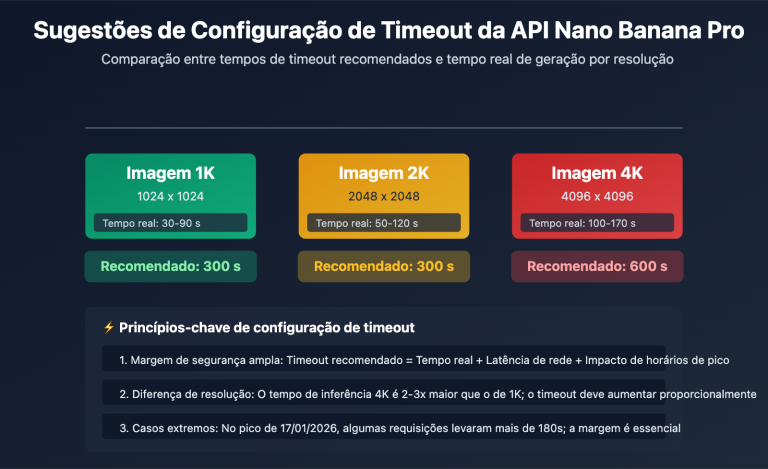

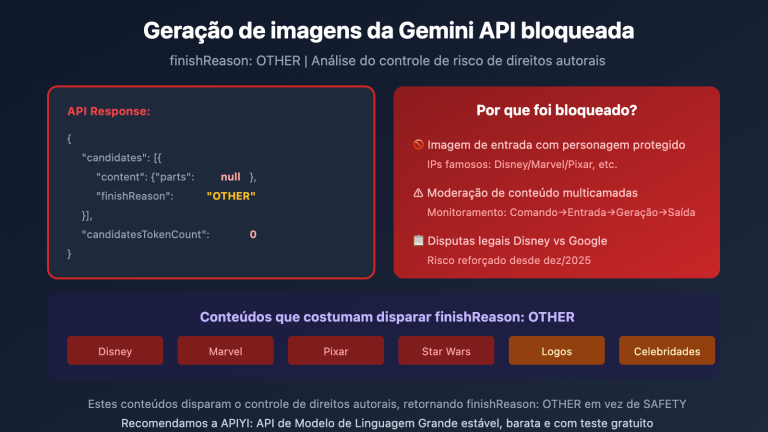

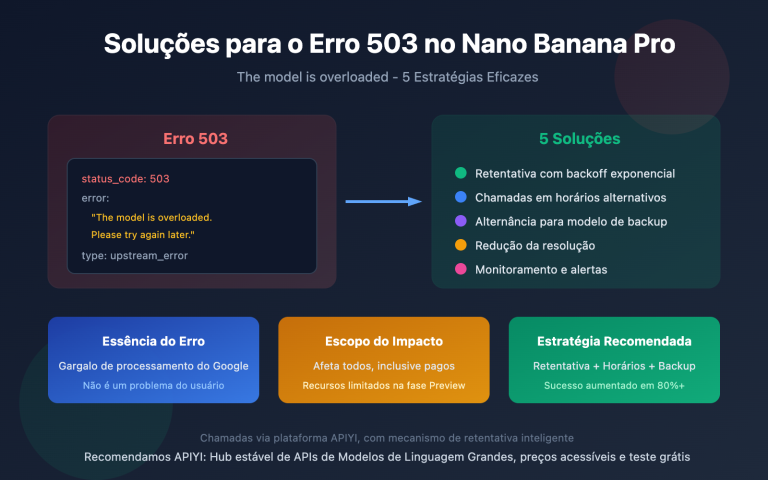

Se você usa a função de geração de imagens do Gemini (Nano Banana Pro) no AI Studio, também pode continuar usando através do proxy de API:

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1"

)

# Geração de imagem

response = client.images.generate(

model="nano-banana-pro",

prompt="Um gato laranja fofo tirando uma soneca ao sol, estilo fotográfico realista",

size="1024x1024",

quality="hd"

)

image_url = response.data[0].url

print(f"Imagem gerada: {image_url}")

Chat Multimodal (Texto e Imagem)

import base64

def encode_image(image_path):

with open(image_path, "rb") as f:

return base64.b64encode(f.read()).decode()

image_base64 = encode_image("exemplo.jpg")

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "Descreva o conteúdo desta imagem"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{image_base64}"

}

}

]

}

]

)

print(response.choices[0].message.content)

💰 Otimização de Custos: Para necessidades de geração de imagem, a plataforma APIYI (apiyi.com) oferece métodos de cobrança flexíveis e suporta vários modelos como Nano Banana Pro, DALL-E e Stable Diffusion, permitindo que você escolha a melhor opção conforme sua demanda.

Tratamento de Erros Comuns

Erro 1: 429 Too Many Requests

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10))

def call_api_with_retry(prompt):

return client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": prompt}]

)

Erro 2: API Key Inválida

# Verificar a configuração da API Key

import os

api_key = os.environ.get("APIYI_KEY")

if not api_key:

raise ValueError("Por favor, configure a variável de ambiente APIYI_KEY")

client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

Erro 3: Modelo Inexistente

# Confirmar se o nome do modelo está correto

SUPPORTED_MODELS = [

"gemini-2.5-pro",

"gemini-2.5-flash",

"gemini-2.0-flash",

"nano-banana-pro"

]

model_name = "gemini-2.5-flash"

if model_name not in SUPPORTED_MODELS:

print(f"Aviso: {model_name} pode não estar na lista de suportados")

Perguntas Frequentes (FAQ)

Q1: Quando o limite gratuito do AI Studio é resetado?

- RPM (Requisições por minuto): Janela deslizante, reseta a cada minuto.

- RPD (Requisições por dia): Reseta à meia-noite no horário do Pacífico.

- TPM (Tokens por minuto): Janela deslizante, reseta a cada minuto.

Se você precisar usar com urgência, recomendamos fazer as chamadas através da plataforma APIYI (apiyi.com), sem precisar esperar o reset da cota.

Q2: É seguro usar um proxy de API?

Sim, desde que você escolha um provedor de proxy de API confiável. Os principais pontos de atenção são:

- Escolha provedores com boa reputação.

- Nunca deixe sua API Key exposta diretamente no código (hardcoded).

- Use variáveis de ambiente para gerenciar suas chaves.

Q3: Qual é o preço de um proxy de API?

A maioria dos serviços de proxy de API adota o modelo de pagamento por uso (pay-as-you-go), e geralmente os valores são mais competitivos que os preços oficiais. A plataforma APIYI (apiyi.com) oferece um modelo de precificação transparente, que você pode consultar diretamente no site.

Q4: O código precisa de grandes mudanças após a migração?

Se você estiver usando um proxy de API compatível com o formato da OpenAI, as mudanças no código serão mínimas:

- Basta alterar o

api_keye obase_url. - O nome do modelo pode precisar de um ajuste.

- O restante da lógica do seu código permanece igual.

Q5: Posso usar vários serviços de API ao mesmo tempo?

Com certeza! Você pode escolher diferentes serviços para diferentes cenários:

- Use o limite gratuito do AI Studio para testes leves.

- Use serviços de proxy de API para o desenvolvimento diário.

- Use serviços oficiais pagos para demandas muito específicas ou críticas.

Resumo

Quando o limite gratuito do Google AI Studio se esgota, você tem 3 opções:

| Plano | Público-alvo | Ação principal |

|---|---|---|

| Exportar para dev local | Usuários ocasionais | Exportar o código e fazer as chamadas localmente |

| Serviço de Proxy de API | Maioria dos desenvolvedores | Alterar a base_url e continuar usando |

| Upgrade para nível pago | Demandas corporativas | Vincular cartão de crédito e aumentar a cota |

Sugestões fundamentais:

- Não adicione créditos à sua conta do Google (a menos que você tenha um cartão internacional e precise de serviços de nível empresarial).

- Exporte seu código para o seu ambiente local.

- Use um serviço de proxy de API para continuar chamando os modelos Gemini.

- Resumo em uma frase: Exporte seu código e realize o desenvolvimento através de chamadas locais.

Recomendamos o APIYI (apiyi.com) para retomar o uso do Gemini rapidamente. A plataforma suporta toda a linha de modelos Gemini, oferece formato compatível com OpenAI e o custo de migração é extremamente baixo.

Leitura complementar:

- Limites de taxa da API Gemini: ai.google.dev/gemini-api/docs/rate-limits

- Modo de construção do AI Studio: ai.google.dev/gemini-api/docs/aistudio-build-mode

- Guia de uso da API Key: ai.google.dev/gemini-api/docs/api-key

📝 Autor: Equipe Técnica APIYI | Especialistas em integração e otimização de APIs de Modelos de Linguagem Grandes

🔗 Intercâmbio Técnico: Acesse APIYI (apiyi.com) para obter suporte em chamadas de toda a linha de modelos Gemini.