OpenClaw 是 2026 年初最火的開源 AI 助手項目,GitHub 星標已超過 10 萬。然而,許多開發者在配置 Claude 模型時遇到了一個令人困惑的錯誤:ValidationException: invalid beta flag。

本文將深入分析這個 OpenClaw Claude API invalid beta flag 錯誤的根本原因,並提供 5 種經過驗證的解決方案,幫助你快速恢復 AI 助手的正常工作。

OpenClaw invalid beta flag 錯誤現象分析

當你在 OpenClaw 中配置 AWS Bedrock 或 Google Vertex AI 作爲 Claude 模型提供商時,可能會遇到以下錯誤信息:

{

"type": "error",

"error": {

"type": "invalid_request_error",

"message": "invalid beta flag"

}

}

OpenClaw Claude API 錯誤的典型表現

| 錯誤場景 | 錯誤信息 | 影響範圍 |

|---|---|---|

| AWS Bedrock 調用 | ValidationException: invalid beta flag |

所有 Claude 模型請求失敗 |

| Vertex AI 調用 | 400 Bad Request: invalid beta flag |

Claude Sonnet/Opus 不可用 |

| LiteLLM 代理 | {"message":"invalid beta flag"} |

代理轉發全部失敗 |

| 1M 上下文變體 | bedrock:anthropic.claude-sonnet-4-20250514-v1:0:1m 失敗 |

長上下文場景不可用 |

OpenClaw 錯誤的直接影響

這個 OpenClaw Claude invalid beta flag 錯誤會導致:

- AI 助手完全無響應 – OpenClaw 無法完成任何 Claude 相關任務

- 消息平臺顯示空白 – WhatsApp、Telegram 等平臺返回 "(no output)"

- 備用模型同樣失敗 – 如果 Vertex AI 作爲 fallback,同樣會報錯

- 用戶體驗嚴重受損 – 需要頻繁手動干預

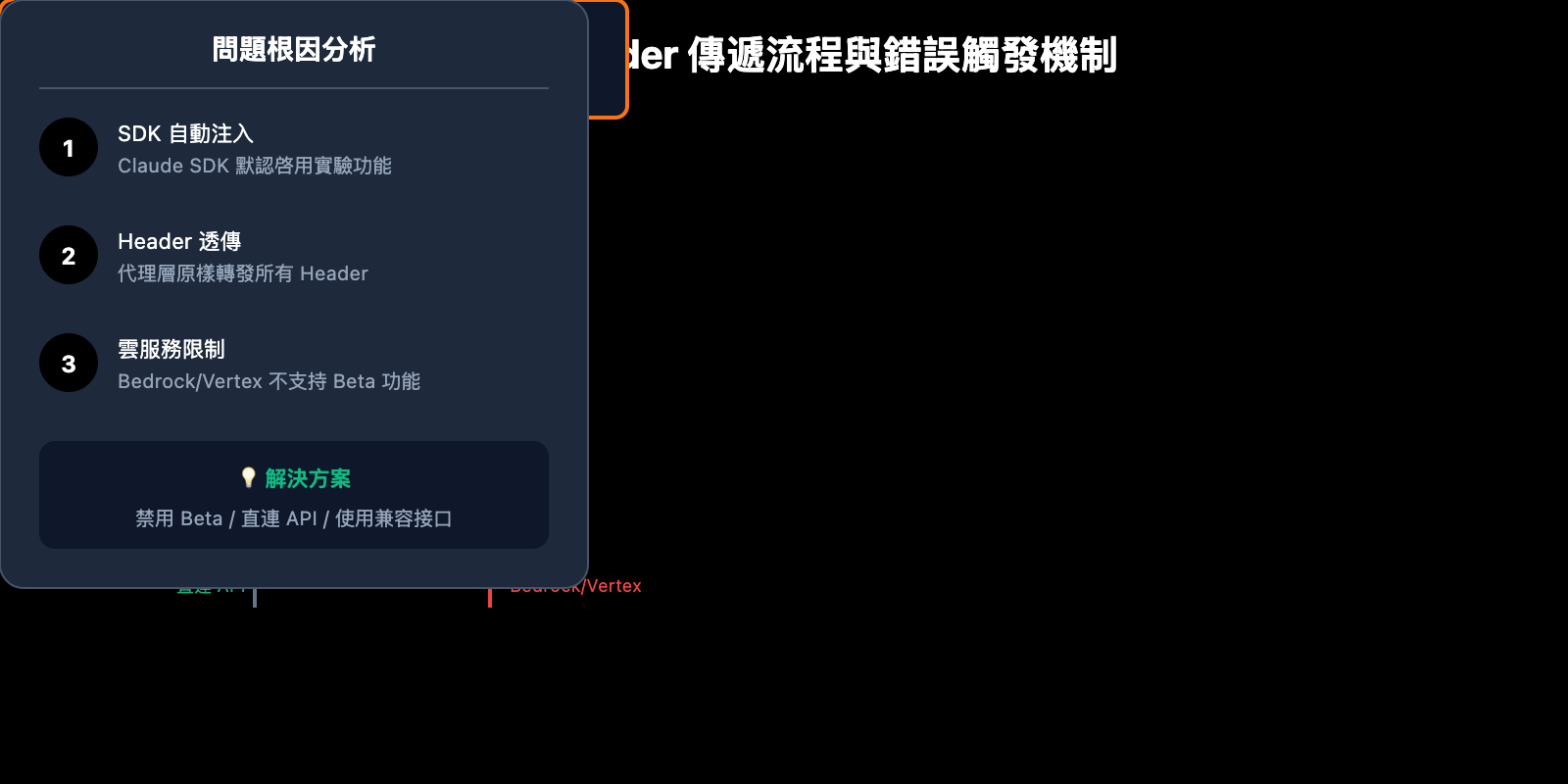

OpenClaw invalid beta flag 錯誤根本原因

Claude API Beta Header 機制

Anthropic Claude API 支持通過 anthropic-beta 請求頭啓用實驗性功能。這些 beta 功能包括:

| Beta 標識 | 功能描述 | 支持平臺 |

|---|---|---|

computer-use-2024-10-22 |

計算機使用能力 | Anthropic 直連 |

token-counting-2024-11-01 |

Token 計數 API | Anthropic 直連 |

context-1m-2025-08-07 |

1M 上下文窗口 | Anthropic 直連 |

tmp-preserve-thinking-2025-10-01 |

思考過程保留 | 僅 Anthropic 直連 |

interleaved-thinking-2025-05-14 |

交錯思考模式 | 僅 Anthropic 直連 |

OpenClaw 爲什麼會發送 Beta Header

OpenClaw 的底層依賴 (如 Claude SDK、LiteLLM 等) 在發送請求時會自動附加 beta header:

anthropic-beta: claude-code-20250219,context-1m-2025-08-07,interleaved-thinking-2025-05-14,fine-grained-tool-streaming-2025-05-14,tmp-preserve-thinking-2025-10-01

AWS Bedrock 和 Vertex AI 的限制

這就是 OpenClaw invalid beta flag 錯誤的根本原因:

AWS Bedrock 和 Google Vertex AI 作爲託管服務,不支持 Anthropic 的 beta 功能。當這些 beta header 被傳遞到雲服務時,服務端會直接拒絕請求並返回 invalid beta flag 錯誤。

🎯 核心問題: SDK 自動注入的 beta header 對 Bedrock/Vertex AI 不兼容,但 SDK 沒有根據目標端點自動過濾這些 header。

5 種解決 OpenClaw invalid beta flag 的方法

方法一: 修改 OpenClaw 模型配置 (推薦)

最簡單的方法是在 OpenClaw 配置中顯式禁用 beta 功能。

編輯 ~/.openclaw/openclaw.json:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"options": {

"beta_features": []

}

}

}

}

}

OpenClaw 配置說明:

| 配置項 | 作用 | 推薦值 |

|---|---|---|

beta_features |

控制啓用的 beta 功能 | [] (空數組) |

extra_headers |

自定義請求頭 | 不設置 beta 相關 |

disable_streaming |

禁用流式傳輸 | false |

方法二: 使用 Anthropic 直連 API (最穩定)

避免 OpenClaw invalid beta flag 錯誤最可靠的方法是直接使用 Anthropic 官方 API,而不是通過 Bedrock 或 Vertex AI。

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4"

}

}

}

}

設置環境變量:

export ANTHROPIC_API_KEY="your-anthropic-api-key"

🚀 快速開始: 如果你沒有 Anthropic API Key,可以通過 API易 apiyi.com 快速獲取測試額度,該平臺提供 OpenAI 兼容接口,支持 Claude 全系列模型調用。

方法三: 配置 LiteLLM 過濾 Beta Header

如果你使用 LiteLLM 作爲 OpenClaw 的模型代理,可以配置 header 過濾:

# litellm_config.py

import litellm

# 配置不發送 beta header 到 Bedrock

litellm.drop_params = True

litellm.modify_params = True

# 或者在 config.yaml 中配置

# model_list:

# - model_name: claude-sonnet

# litellm_params:

# model: bedrock/anthropic.claude-3-sonnet

# drop_params: true

方法四: 禁用 Prompt Caching (臨時方案)

部分情況下,OpenClaw invalid beta flag 錯誤與 prompt caching 功能相關。禁用緩存可能解決問題:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"cache": {

"enabled": false

}

}

}

}

}

方法五: 切換到兼容模型提供商

如果你必須使用雲託管服務但又需要避免 OpenClaw invalid beta flag 錯誤,可以考慮使用 OpenAI 兼容的代理服務:

{

"models": {

"providers": [

{

"name": "apiyi",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "your-api-key",

"models": ["claude-sonnet-4", "claude-opus-4-5"]

}

]

}

}

💡 選擇建議: 使用 OpenAI 兼容接口可以完全避免 beta header 問題,同時保持與 OpenClaw 的良好兼容性。API易 apiyi.com 提供這種統一接口,支持 Claude、GPT、Gemini 等多種模型。

OpenClaw 模型配置最佳實踐

完整配置示例

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "openai/gpt-4o",

"options": {

"temperature": 0.7,

"max_tokens": 4096

}

},

"sandbox": {

"mode": "non-main"

}

}

},

"models": {

"providers": [

{

"name": "apiyi-claude",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"models": ["claude-sonnet-4", "claude-opus-4-5", "claude-haiku"]

}

]

}

}

OpenClaw 模型選擇建議

| 使用場景 | 推薦模型 | 提供商選擇 |

|---|---|---|

| 日常對話 | Claude Haiku | Anthropic 直連 / API易 |

| 代碼生成 | Claude Sonnet 4 | Anthropic 直連 / API易 |

| 複雜推理 | Claude Opus 4.5 | Anthropic 直連 / API易 |

| 成本敏感 | GPT-4o-mini | OpenAI / API易 |

| 本地部署 | Llama 3.3 | Ollama |

OpenClaw invalid beta flag 錯誤排查流程

排查步驟

第一步: 確認錯誤來源

# 查看 OpenClaw 日誌

tail -f ~/.openclaw/logs/openclaw.log | grep -i "beta"

第二步: 檢查當前配置

# 查看模型配置

cat ~/.openclaw/openclaw.json | jq '.agents.defaults.model'

第三步: 測試 API 連通性

# 使用 curl 測試 (不帶 beta header)

curl -X POST https://api.anthropic.com/v1/messages \

-H "Content-Type: application/json" \

-H "x-api-key: $ANTHROPIC_API_KEY" \

-H "anthropic-version: 2023-06-01" \

-d '{

"model": "claude-sonnet-4-20250514",

"max_tokens": 100,

"messages": [{"role": "user", "content": "Hello"}]

}'

第四步: 驗證修復效果

# 重啓 OpenClaw 服務

openclaw restart

# 發送測試消息

openclaw chat "測試消息"

常見排查結果

| 排查結果 | 原因分析 | 解決方案 |

|---|---|---|

| 直連 API 成功,Bedrock 失敗 | Beta header 不兼容 | 使用方法一或方法二 |

| 所有請求都失敗 | API Key 問題或網絡問題 | 檢查憑證和網絡 |

| 間歇性失敗 | 可能是 rate limit | 檢查調用頻率 |

| 特定模型失敗 | 模型 ID 錯誤或不可用 | 確認模型名稱正確 |

OpenClaw Claude 調用代碼示例

Python 直接調用示例 (避免 invalid beta flag)

import anthropic

# 創建客戶端 - 不啓用任何 beta 功能

client = anthropic.Anthropic(

api_key="your-api-key",

base_url="https://api.apiyi.com/v1" # 使用 API易 統一接口

)

# 發送消息 - 不使用 beta 參數

message = client.messages.create(

model="claude-sonnet-4-20250514",

max_tokens=1024,

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(message.content[0].text)

OpenAI SDK 兼容調用

from openai import OpenAI

# 使用 OpenAI 兼容接口完全避免 beta header 問題

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # API易 統一接口

)

response = client.chat.completions.create(

model="claude-sonnet-4",

messages=[

{"role": "user", "content": "Hello!"}

]

)

print(response.choices[0].message.content)

🎯 技術建議: 使用 OpenAI 兼容接口是避免 OpenClaw invalid beta flag 錯誤最簡潔的方案。API易 apiyi.com 提供的統一接口不僅兼容 Claude,還支持 GPT、Gemini 等主流模型,便於在不同模型間切換測試。

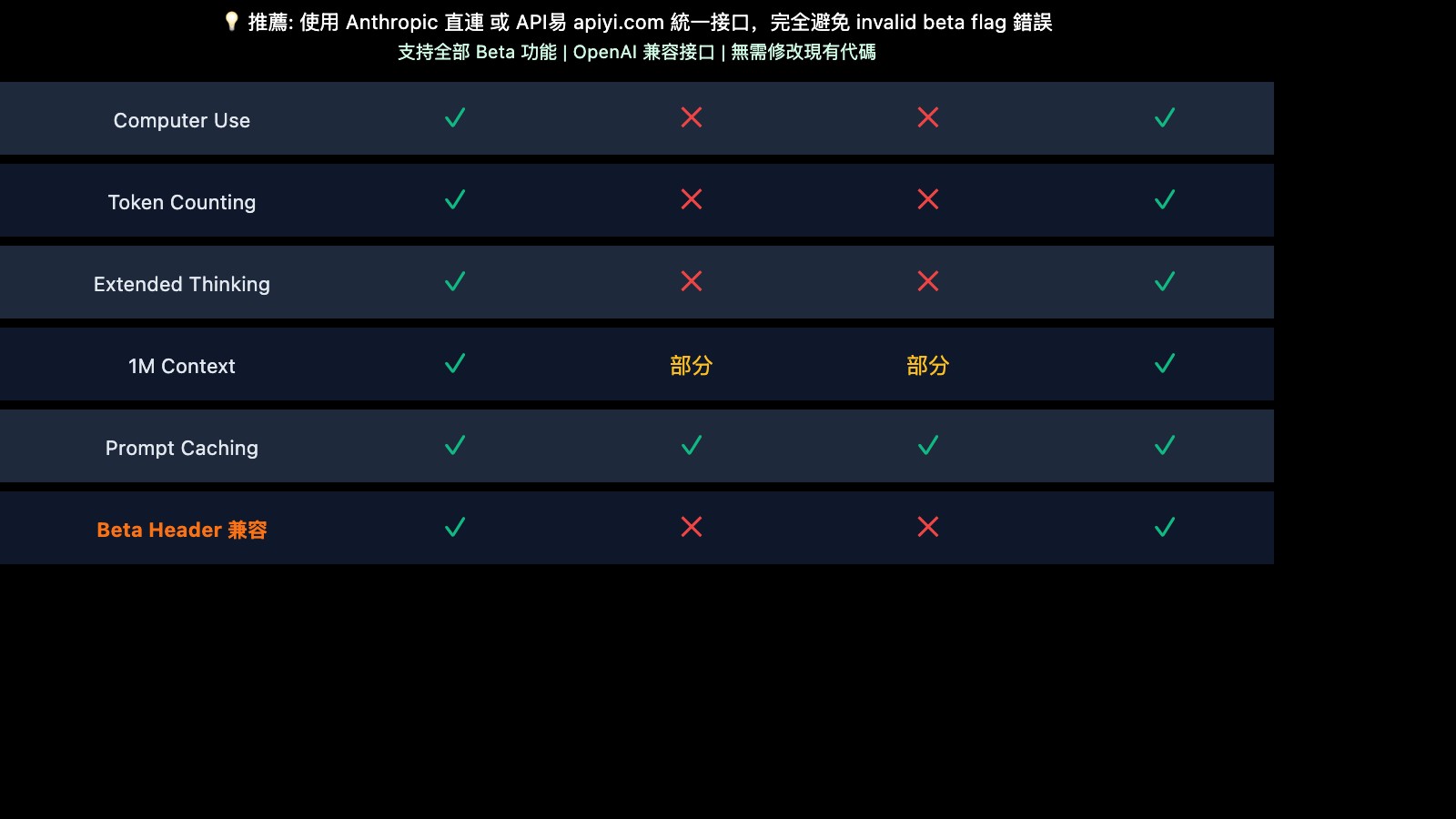

OpenClaw 與各雲服務商的兼容性

雲服務 Beta 功能支持矩陣

| 功能 | Anthropic 直連 | AWS Bedrock | Vertex AI | API易 |

|---|---|---|---|---|

| 基礎 Messages API | ✅ | ✅ | ✅ | ✅ |

| Computer Use | ✅ | ❌ | ❌ | ✅ |

| Token Counting | ✅ | ❌ | ❌ | ✅ |

| Extended Thinking | ✅ | ❌ | ❌ | ✅ |

| 1M Context | ✅ | 部分 | 部分 | ✅ |

| Prompt Caching | ✅ | ✅ | ✅ | ✅ |

爲什麼選擇 API 中轉服務

對於 OpenClaw 用戶來說,使用 API 中轉服務有以下優勢:

- 兼容性更好 – 自動處理 header 轉換,避免 invalid beta flag

- 成本更優 – 通常比直接調用官方 API 更經濟

- 切換方便 – 統一接口,輕鬆在不同模型間切換

- 穩定性高 – 多節點負載均衡,避免單點故障

OpenClaw invalid beta flag 常見問題 FAQ

Q1: 爲什麼只有使用 Bedrock 時才報 invalid beta flag 錯誤?

AWS Bedrock 是 Amazon 的託管服務,它提供 Claude 模型訪問但不支持 Anthropic 的 beta 實驗功能。當 OpenClaw 或其依賴庫自動附加 beta header 時,Bedrock 會拒絕這些請求。

解決方案: 使用 Anthropic 直連 API 或配置過濾 beta header。如果需要在國內快速測試,可以通過 API易 apiyi.com 獲取免費額度進行驗證。

Q2: 修改配置後還是報錯怎麼辦?

可能是配置緩存或服務未重啓導致。請按以下步驟操作:

- 完全停止 OpenClaw:

openclaw stop - 清除緩存:

rm -rf ~/.openclaw/cache/* - 重新啓動:

openclaw start

Q3: 能否同時使用 Bedrock 和直連 API?

可以。建議將 Anthropic 直連設爲主要提供商 (支持全部功能),Bedrock 作爲備用 (不使用 beta 功能):

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "bedrock/anthropic.claude-3-sonnet"

}

}

}

}

Q4: OpenClaw 支持哪些模型提供商?

OpenClaw 支持 12+ 種模型提供商,包括:

- 官方直連: Anthropic、OpenAI、Google Gemini、Mistral

- 雲託管: AWS Bedrock、Google Vertex AI

- 代理服務: OpenRouter、API易

- 本地部署: Ollama、LM Studio

💰 成本優化: 對於預算敏感的個人開發者,建議通過 API易 apiyi.com 調用 Claude API。該平臺提供靈活的計費方式,按實際使用量付費,無月費門檻。

Q5: invalid beta flag 錯誤會影響所有 Claude 模型嗎?

是的,這個錯誤會影響所有通過 Bedrock 或 Vertex AI 調用的 Claude 模型,包括 Claude Haiku、Sonnet 和 Opus 全系列。

總結

OpenClaw Claude API invalid beta flag 錯誤的核心原因是 SDK 自動附加的 beta header 與 AWS Bedrock / Vertex AI 不兼容。通過本文介紹的 5 種方法,你可以有效解決這個問題:

- 修改 OpenClaw 配置 – 禁用 beta 功能

- 使用 Anthropic 直連 – 完全兼容所有功能

- 配置 LiteLLM 過濾 – 代理層面解決

- 禁用 Prompt Caching – 臨時繞過方案

- 切換兼容提供商 – 使用 OpenAI 兼容接口

對於大多數 OpenClaw 用戶,我們建議使用 Anthropic 直連 API 或 OpenAI 兼容的代理服務來徹底避免這個問題。推薦通過 API易 apiyi.com 快速驗證效果,該平臺支持 Claude 全系列模型,提供統一的 OpenAI 兼容接口。

參考資料

-

GitHub – OpenClaw 官方倉庫: 項目源碼和文檔

- 鏈接:

github.com/openclaw/openclaw

- 鏈接:

-

GitHub – LiteLLM invalid beta flag Issue: 社區問題討論

- 鏈接:

github.com/BerriAI/litellm/issues/14043

- 鏈接:

-

GitHub – Cline invalid beta flag Issue: 相關錯誤報告

- 鏈接:

github.com/cline/cline/issues/5568

- 鏈接:

-

Anthropic Beta Headers 文檔: 官方 beta 功能說明

- 鏈接:

docs.anthropic.com/en/api/beta-headers

- 鏈接:

-

OpenClaw 官方文檔: 模型配置指南

- 鏈接:

docs.openclaw.ai/concepts/model-providers

- 鏈接:

📝 作者: APIYI 技術團隊

如需瞭解更多 AI 模型 API 調用技巧,歡迎訪問 API易 apiyi.com 獲取技術支持