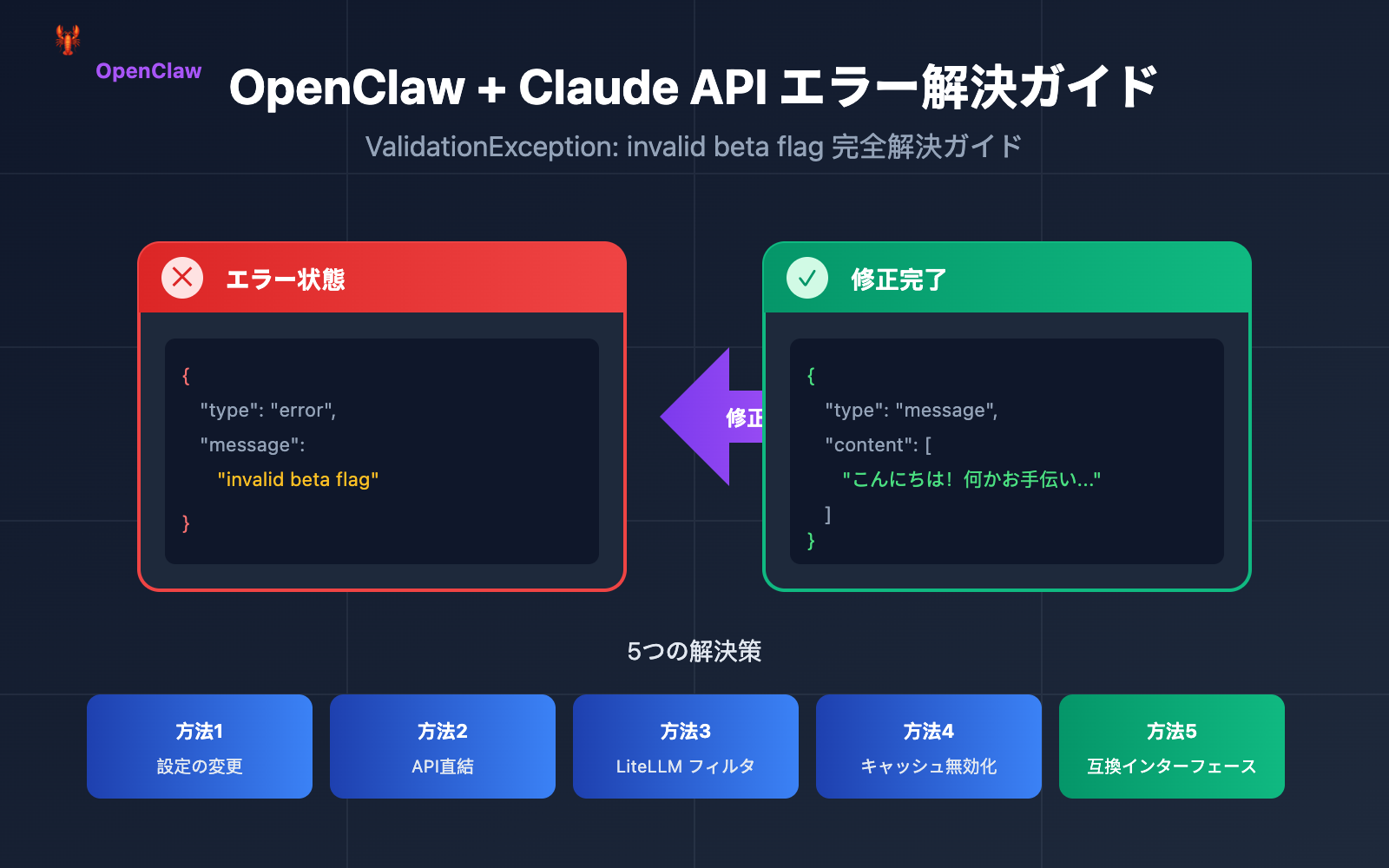

OpenClawは2026年初頭に最も注目されているオープンソースAIアシスタントプロジェクトであり、GitHubのスター数はすでに10万を超えています。しかし、多くの開発者がClaudeモデルの設定時に「ValidationException: invalid beta flag」という困惑するエラーに直面しています。

本記事では、このOpenClaw Claude APIにおける「invalid beta flag」エラーの根本原因を深く分析し、AIアシスタントを正常な状態に素早く復旧させるための、検証済みの5つの解決策を提供します。

OpenClaw invalid beta flag エラー現象の分析

OpenClawでClaudeモデルのプロバイダーとしてAWS BedrockやGoogle Vertex AIを設定している場合、以下のようなエラーメッセージが表示されることがあります。

{

"type": "error",

"error": {

"type": "invalid_request_error",

"message": "invalid beta flag"

}

}

OpenClaw Claude APIエラーの典型的な例

| エラーの発生シーン | エラーメッセージ | 影響範囲 |

|---|---|---|

| AWS Bedrockの呼び出し | ValidationException: invalid beta flag |

すべてのClaudeモデルのリクエストが失敗 |

| Vertex AIの呼び出し | 400 Bad Request: invalid beta flag |

Claude Sonnet/Opusが利用不可 |

| LiteLLMプロキシ | {"message":"invalid beta flag"} |

プロキシ転送がすべて失敗 |

| 1Mコンテキストのバリアント | bedrock:anthropic.claude-sonnet-4-20250514-v1:0:1m 失敗 |

長文コンテキストのシナリオが利用不可 |

OpenClawエラーによる直接的な影響

このOpenClaw Claude 「invalid beta flag」エラーは、以下の問題を引き起こします:

- AIアシスタントが完全に無反応になる – OpenClawがClaude関連のタスクを一切実行できなくなります。

- メッセージプラットフォームに空白が表示される – WhatsAppやTelegramなどのプラットフォームで「(no output)」が返されます。

- 代替モデルも同様に失敗する – Vertex AIをフォールバックとして使用している場合も、同様にエラーが発生します。

- ユーザーエクスペリエンスが著しく損なわれる – 頻繁な手動介入が必要になります。

OpenClawの「invalid beta flag」エラーの根本原因

Claude API Beta Header メカニズム

Anthropic Claude APIは、anthropic-beta リクエストヘッダーを通じて実験的な機能を有効にすることをサポートしています。これらのBeta機能には以下が含まれます:

| Beta識別子 | 機能説明 | 対応プラットフォーム |

|---|---|---|

computer-use-2024-10-22 |

コンピュータ操作機能 | Anthropic直結 |

token-counting-2024-11-01 |

トークンカウントAPI | Anthropic直結 |

context-1m-2025-08-07 |

1Mコンテキストウィンドウ | Anthropic直結 |

tmp-preserve-thinking-2025-10-01 |

思考プロセスの保持 | Anthropic直結のみ |

interleaved-thinking-2025-05-14 |

インターリーブ思考モード | Anthropic直結のみ |

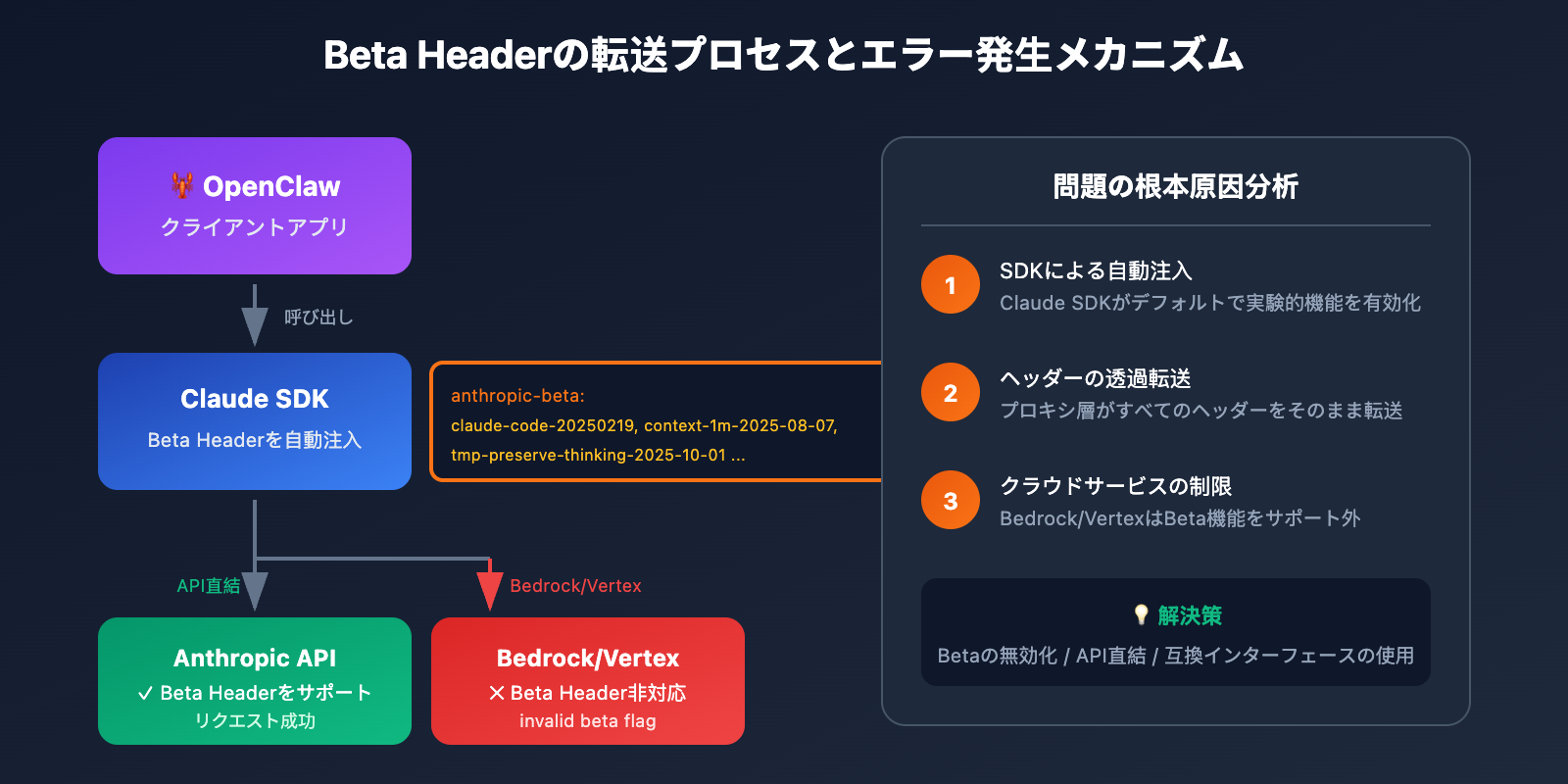

なぜOpenClawはBeta Headerを送信するのか

OpenClawの基盤となる依存ライブラリ(Claude SDKやLiteLLMなど)は、リクエスト送信時に自動的にBeta Headerを付与します:

anthropic-beta: claude-code-20250219,context-1m-2025-08-07,interleaved-thinking-2025-05-14,fine-grained-tool-streaming-2025-05-14,tmp-preserve-thinking-2025-10-01

AWS Bedrock および Vertex AI の制限

これこそが、OpenClawで「invalid beta flag」エラーが発生する根本的な原因です:

AWS BedrockやGoogle Vertex AIはマネージドサービスであるため、AnthropicのBeta機能をサポートしていません。これらのBeta Headerがクラウドサービスに渡されると、サーバー側はリクエストを拒否し、invalid beta flag エラーを返します。

🎯 核心となる問題: SDKによって自動注入されたBeta HeaderがBedrock/Vertex AIと互換性がないにもかかわらず、SDKが送信先のエンドポイントに応じてこれらのヘッダーを自動的にフィルタリングしていないことにあります。

OpenClaw の invalid beta flag エラーを解決する5つの方法

方法1: OpenClaw のモデル設定を変更する(推奨)

最も簡単な方法は、OpenClaw の設定で beta 機能を明示的に無効にすることです。

~/.openclaw/openclaw.json を編集します:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"options": {

"beta_features": []

}

}

}

}

}

OpenClaw 設定の説明:

| 設定項目 | 役割 | 推奨値 |

|---|---|---|

beta_features |

有効にする beta 機能の制御 | [] (空の配列) |

extra_headers |

カスタムリクエストヘッダー | beta 関連を設定しない |

disable_streaming |

ストリーミングを無効化 | false |

方法2: Anthropic 直結 API を使用する(最も安定)

OpenClaw の invalid beta flag エラーを回避する最も信頼性の高い方法は、Bedrock や Vertex AI を介さず、Anthropic 公式 API を直接使用することです。

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4"

}

}

}

}

環境変数を設定します:

export ANTHROPIC_API_KEY="your-anthropic-api-key"

🚀 クイックスタート: Anthropic の API キーをお持ちでない場合は、APIYI(apiyi.com)を通じてテスト用クレジットを素早く取得できます。このプラットフォームは OpenAI 互換インターフェースを提供しており、Claude シリーズ全モデルの呼び出しに対応しています。

方法3: LiteLLM で Beta Header をフィルタリングするよう設定する

OpenClaw のモデルプロキシとして LiteLLM を使用している場合は、ヘッダーのフィルタリングを設定できます:

# litellm_config.py

import litellm

# Bedrock に beta ヘッダーを送信しないように設定

litellm.drop_params = True

litellm.modify_params = True

# または config.yaml で設定

# model_list:

# - model_name: claude-sonnet

# litellm_params:

# model: bedrock/anthropic.claude-3-sonnet

# drop_params: true

方法4: Prompt Caching を無効にする(一時的な解決策)

一部のケースでは、OpenClaw の invalid beta flag エラーはプロンプトキャッシュ機能に関連しています。キャッシュを無効にすることで問題が解決する可能性があります:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"cache": {

"enabled": false

}

}

}

}

}

方法5: 互換性のあるモデルプロバイダーに切り替える

クラウドホスティングサービスを使用しつつ、OpenClaw の invalid beta flag エラーを回避する必要がある場合は、OpenAI 互換のプロキシサービスの使用を検討してください:

{

"models": {

"providers": [

{

"name": "apiyi",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "your-api-key",

"models": ["claude-sonnet-4", "claude-opus-4-5"]

}

]

}

}

💡 選択のアドバイス: OpenAI 互換インターフェースを使用することで、beta ヘッダーの問題を完全に回避しつつ、OpenClaw との良好な互換性を維持できます。APIYI(apiyi.com)はこのような統合インターフェースを提供しており、Claude、GPT、Gemini など多様なモデルをサポートしています。

OpenClaw モデル設定のベストプラクティス

設定例の全文

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "openai/gpt-4o",

"options": {

"temperature": 0.7,

"max_tokens": 4096

}

},

"sandbox": {

"mode": "non-main"

}

}

},

"models": {

"providers": [

{

"name": "apiyi-claude",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"models": ["claude-sonnet-4", "claude-opus-4-5", "claude-haiku"]

}

]

}

}

OpenClaw モデル選択のアドバイス

| 利用シーン | 推奨モデル | プロバイダーの選択 |

|---|---|---|

| 日常的な対話 | Claude Haiku | Anthropic 直接接続 / APIYI |

| コード生成 | Claude Sonnet 4 | Anthropic 直接接続 / APIYI |

| 複雑な推論 | Claude Opus 4.5 | Anthropic 直接接続 / APIYI |

| コスト重視 | GPT-4o-mini | OpenAI / APIYI |

| ローカルデプロイ | Llama 3.3 | Ollama |

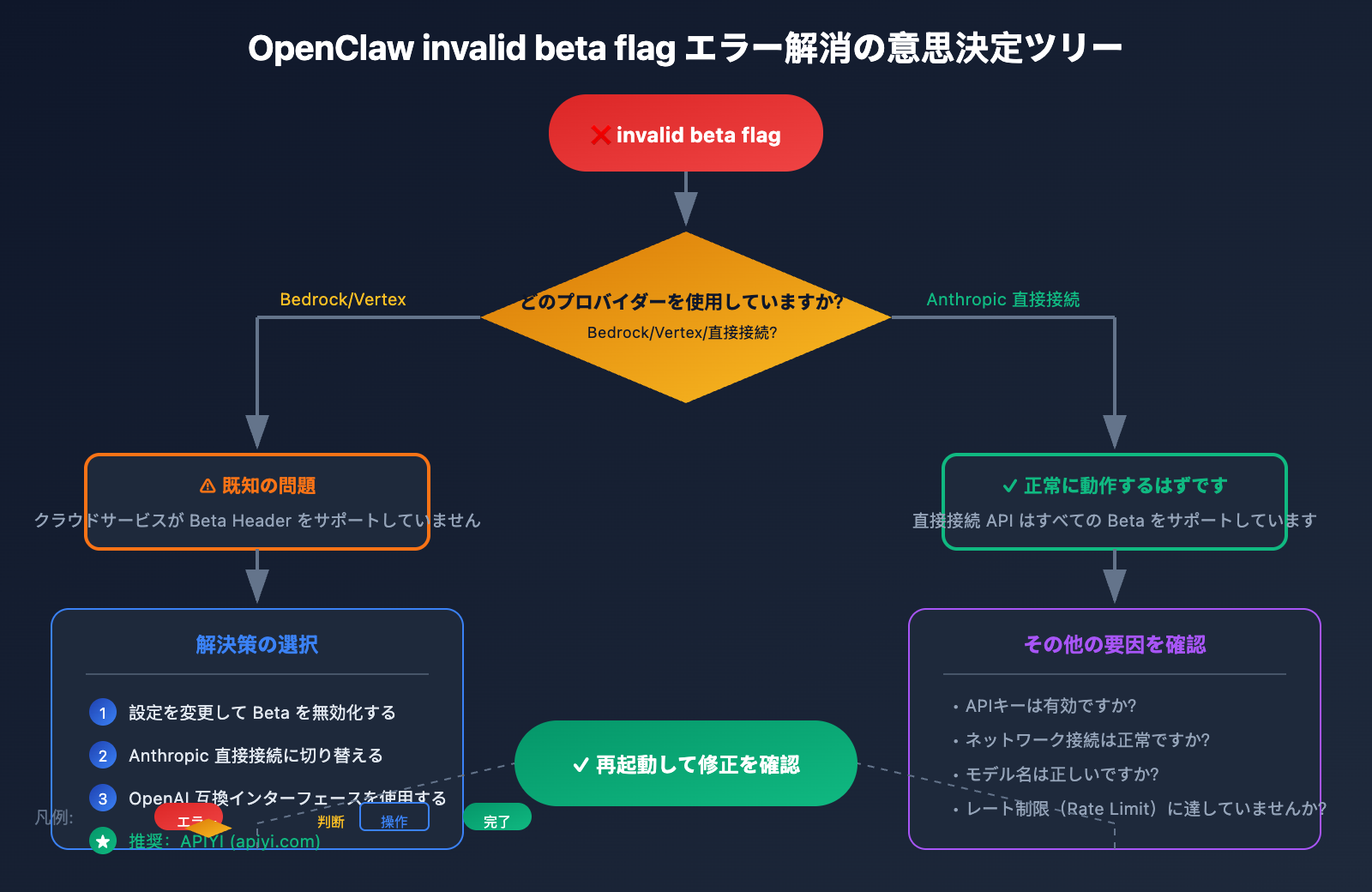

OpenClaw invalid beta flag エラー解消の手順

排查手順

ステップ1:エラーの原因を確認する

# OpenClaw のログを確認

tail -f ~/.openclaw/logs/openclaw.log | grep -i "beta"

ステップ2:現在の設定を確認する

# モデル設定を確認

cat ~/.openclaw/openclaw.json | jq '.agents.defaults.model'

ステップ3:APIの接続性をテストする

# curl を使用してテスト (beta header なし)

curl -X POST https://api.anthropic.com/v1/messages \

-H "Content-Type: application/json" \

-H "x-api-key: $ANTHROPIC_API_KEY" \

-H "anthropic-version: 2023-06-01" \

-d '{

"model": "claude-sonnet-4-20250514",

"max_tokens": 100,

"messages": [{"role": "user", "content": "Hello"}]

}'

ステップ4:修正結果を検証する

# OpenClaw サービスを再起動

openclaw restart

# テストメッセージを送信

openclaw chat "テストメッセージ"

よくある診断結果

| 診断結果 | 原因の分析 | 解決策 |

|---|---|---|

| 直接接続 API は成功、Bedrock は失敗 | Beta header の不互換 | 方法1または方法2を使用 |

| すべてのリクエストが失敗 | APIキーの問題またはネットワークの問題 | 認証情報とネットワークを確認 |

| 断続的な失敗 | レート制限(rate limit)の可能性 | 呼び出し頻度を確認 |

| 特定のモデルが失敗 | モデルIDが正しくない、または利用不可 | モデル名が正しいか確認 |

OpenClaw Claude 呼び出しコード例

Python 直接呼び出しの例(invalid beta flag を回避)

import anthropic

# クライアントの作成 - beta 機能は有効にしない

client = anthropic.Anthropic(

api_key="your-api-key",

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェースを使用

)

# メッセージの送信 - beta パラメータは使用しない

message = client.messages.create(

model="claude-sonnet-4-20250514",

max_tokens=1024,

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(message.content[0].text)

OpenAI SDK 互換呼び出し

from openai import OpenAI

# OpenAI 互換インターフェースを使用して beta header の問題を完全に回避

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェース

)

response = client.chat.completions.create(

model="claude-sonnet-4",

messages=[

{"role": "user", "content": "Hello!"}

]

)

print(response.choices[0].message.content)

🎯 テクニカルアドバイス: OpenAI 互換インターフェースを使用することが、OpenClaw の invalid beta flag エラーを回避する最もシンプルな方法です。APIYI (apiyi.com) が提供する統合インターフェースは、Claude だけでなく GPT や Gemini などの主要な大規模言語モデルにも対応しており、モデル間の切り替えテストも容易に行えます。

OpenClaw と各クラウドプロバイダーの互換性

クラウドサービス Beta 機能サポートマトリックス

| 機能 | Anthropic 直結 | AWS Bedrock | Vertex AI | APIYI |

|---|---|---|---|---|

| 基本 Messages API | ✅ | ✅ | ✅ | ✅ |

| Computer Use | ✅ | ❌ | ❌ | ✅ |

| トークンカウント | ✅ | ❌ | ❌ | ✅ |

| Extended Thinking | ✅ | ❌ | ❌ | ✅ |

| 1M コンテキスト | ✅ | 一部対応 | 一部対応 | ✅ |

| プロンプトキャッシュ | ✅ | ✅ | ✅ | ✅ |

なぜ API 中継サービスを選ぶのか

OpenClaw ユーザーにとって、API 中継サービス(プロキシ)を利用することには以下のメリットがあります:

- 互換性の向上 – ヘッダー変換を自動処理し、invalid beta flag エラーを回避します。

- コストの最適化 – 通常、公式 API を直接呼び出すよりも経済的です。

- 切り替えが容易 – 統合インターフェースにより、異なるモデル間での切り替えがスムーズです。

- 高い安定性 – マルチノードによる負荷分散により、単一障害点を回避します。

OpenClaw invalid beta flag よくある質問 FAQ

Q1: なぜ Bedrock を使用している時だけ invalid beta flag エラーが発生するのですか?

AWS Bedrock は Amazon のマネージドサービスであり、Claude モデルへのアクセスを提供していますが、Anthropic のベータ(試験的)機能には対応していません。OpenClaw やその依存ライブラリが自動的にベータヘッダー(beta header)を付与すると、Bedrock はこれらのリクエストを拒否します。

解決策: Anthropic 直連 API を使用するか、ベータヘッダーをフィルタリングするように設定してください。日本国内から迅速にテストしたい場合は、APIYI(apiyi.com)で無料クレジットを取得して検証することをお勧めします。

Q2: 設定を変更してもエラーが消えない場合はどうすればよいですか?

設定のキャッシュが残っているか、サービスが正常に再起動されていない可能性があります。以下の手順を試してください:

- OpenClaw を完全に停止する:

openclaw stop - キャッシュを削除する:

rm -rf ~/.openclaw/cache/* - 再起動する:

openclaw start

Q3: Bedrock と直連 API を併用することはできますか?

はい、可能です。Anthropic 直連をメインプロバイダー(全機能を利用可能)に設定し、Bedrock をバックアップ(ベータ機能を使用しない設定)として構成することをお勧めします。

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "bedrock/anthropic.claude-3-sonnet"

}

}

}

}

Q4: OpenClaw はどのようなモデルプロバイダーに対応していますか?

OpenClaw は、以下を含む 12 種類以上のプロバイダーをサポートしています:

- 公式直連: Anthropic、OpenAI、Google Gemini、Mistral

- クラウドホスティング: AWS Bedrock、Google Vertex AI

- プロキシサービス: OpenRouter、APIYI

- ローカルデプロイ: Ollama、LM Studio

💰 コスト最適化: 予算を抑えたい個人開発者の方は、APIYI(apiyi.com)経由で Claude API を呼び出すことをお勧めします。このプラットフォームは柔軟な従量課金制を採用しており、月額料金のハードルなく利用できます。

Q5: invalid beta flag エラーはすべての Claude モデルに影響しますか?

はい、このエラーは Bedrock または Vertex AI を介して呼び出されるすべての Claude モデル(Claude Haiku、Sonnet、Opus の全シリーズ)に影響します。

まとめ

OpenClaw Claude API の invalid beta flag エラーの根本的な原因は、SDK が自動的に付与するベータヘッダーと AWS Bedrock / Vertex AI との互換性がないことにあります。本記事で紹介した 5 つの方法で、この問題を効果的に解決できます:

- OpenClaw 設定の変更 – ベータ機能を無効化する

- Anthropic 直連の使用 – すべての機能と完全な互換性を確保

- LiteLLM フィルタリングの設定 – プロキシ層で解決

- Prompt Caching の無効化 – 一時的な回避策

- 互換プロバイダーへの切り替え – OpenAI 互換インターフェースを使用

ほとんどの OpenClaw ユーザーにとって、Anthropic 直連 API または OpenAI 互換のプロキシサービスを使用することが、この問題を根本から避けるための最良の方法です。Claude 全シリーズに対応し、統一された OpenAI 互換インターフェースを提供する APIYI(apiyi.com)で、迅速に効果を検証することをお勧めします。

参考文献

-

GitHub – OpenClaw 公式リポジトリ: プロジェクトのソースコードとドキュメント

- リンク:

github.com/openclaw/openclaw

- リンク:

-

GitHub – LiteLLM invalid beta flag Issue: コミュニティでの議論

- リンク:

github.com/BerriAI/litellm/issues/14043

- リンク:

-

GitHub – Cline invalid beta flag Issue: 関連するエラー報告

- リンク:

github.com/cline/cline/issues/5568

- リンク:

-

Anthropic Beta Headers ドキュメント: 公式のベータ機能説明

- リンク:

docs.anthropic.com/en/api/beta-headers

- リンク:

-

OpenClaw 公式ドキュメント: モデル設定ガイド

- リンク:

docs.openclaw.ai/concepts/model-providers

- リンク:

📝 著者: APIYI 技術チーム

AI モデルの API 呼び出しに関するさらなるテクニックについては、APIYI(apiyi.com)の技術サポートをご覧ください。