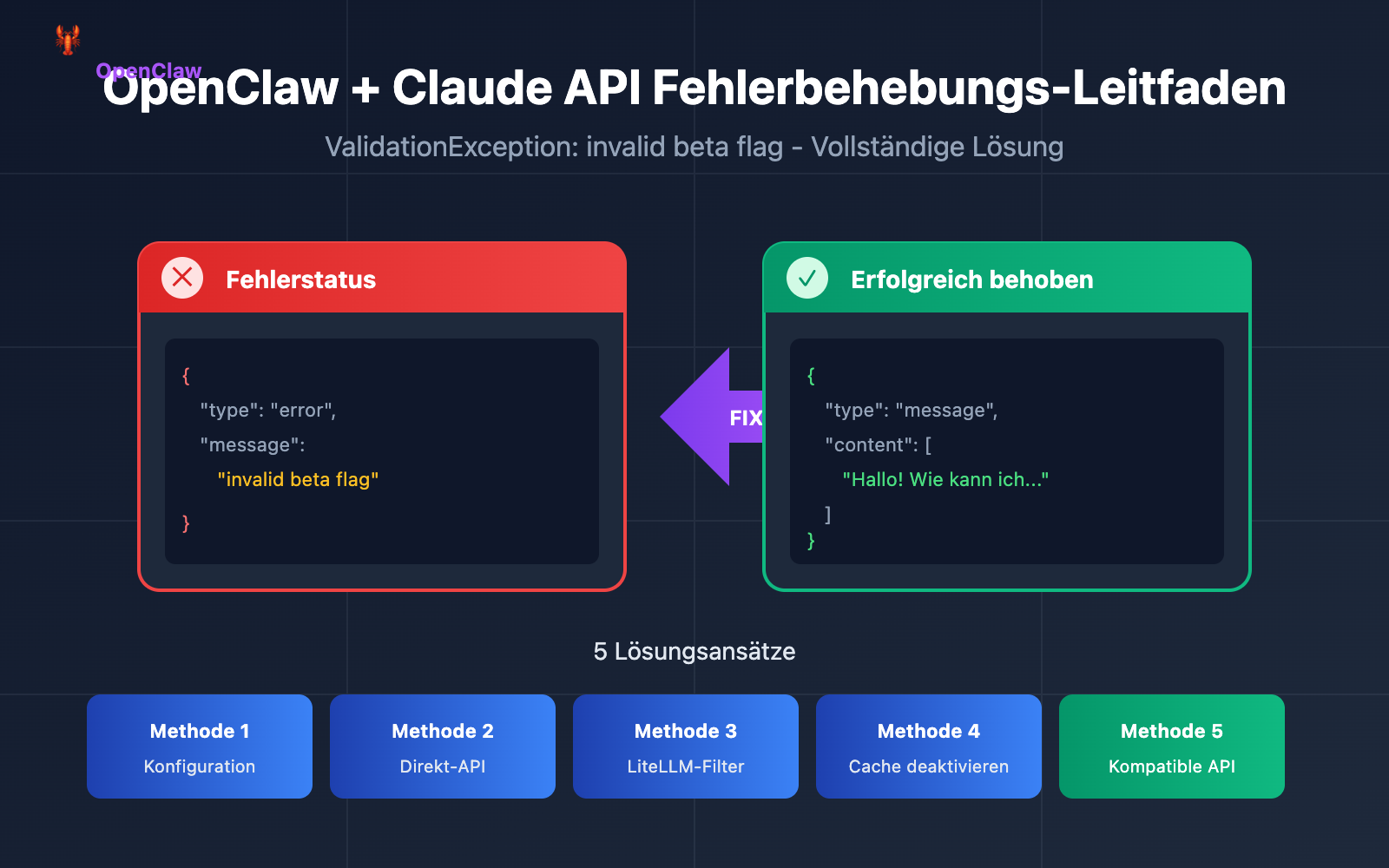

OpenClaw ist das angesagteste Open-Source-KI-Assistentenprojekt Anfang 2026, mit bereits über 100.000 Sternen auf GitHub. Viele Entwickler stoßen jedoch bei der Konfiguration von Claude-Modellen auf einen verwirrenden Fehler: ValidationException: invalid beta flag.

In diesem Artikel analysieren wir die Ursache des Fehlers "OpenClaw Claude API invalid beta flag" im Detail und bieten 5 bewährte Lösungen an, damit Ihr KI-Assistent schnell wieder einsatzbereit ist.

Analyse des Fehlers „invalid beta flag“ in OpenClaw

Wenn Sie AWS Bedrock oder Google Vertex AI als Claude-Modellanbieter in OpenClaw konfigurieren, kann die folgende Fehlermeldung auftreten:

{

"type": "error",

"error": {

"type": "invalid_request_error",

"message": "invalid beta flag"

}

}

Typische Symptome des OpenClaw Claude API-Fehlers

| Fehlerszenario | Fehlermeldung | Auswirkungen |

|---|---|---|

| AWS Bedrock Aufruf | ValidationException: invalid beta flag |

Alle Claude-Modellanfragen schlagen fehl |

| Vertex AI Aufruf | 400 Bad Request: invalid beta flag |

Claude Sonnet/Opus nicht verfügbar |

| LiteLLM Proxy | {"message":"invalid beta flag"} |

Proxy-Weiterleitung schlägt komplett fehl |

| 1M Kontext-Variante | bedrock:anthropic.claude-sonnet-4-20250514-v1:0:1m fehlgeschlagen |

Szenarien mit langem Kontext nicht nutzbar |

Direkte Auswirkungen des OpenClaw-Fehlers

Dieser OpenClaw Claude „invalid beta flag“-Fehler führt zu:

- KI-Assistent reagiert überhaupt nicht – OpenClaw kann keine Claude-bezogenen Aufgaben abschließen.

- Nachrichtenplattformen zeigen Leere an – WhatsApp, Telegram usw. geben „(no output)“ zurück.

- Fallback-Modelle schlagen ebenfalls fehl – Wenn Vertex AI als Fallback dient, tritt derselbe Fehler auf.

- Benutzererfahrung stark beeinträchtigt – Häufiges manuelles Eingreifen ist erforderlich.

Ursachenanalyse des OpenClaw-Fehlers „invalid beta flag“

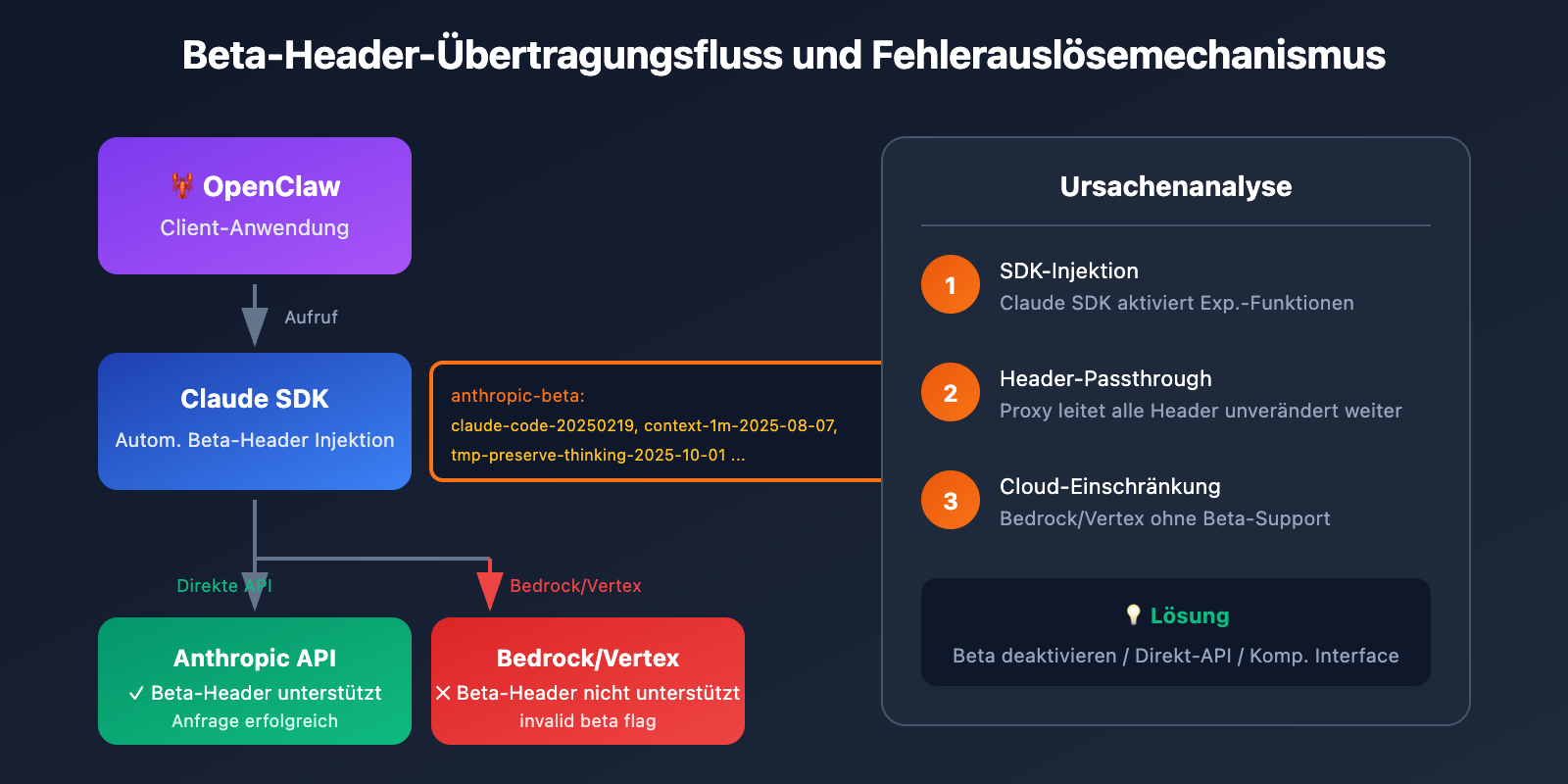

Mechanismus der Claude API Beta-Header

Die Anthropic Claude API ermöglicht die Aktivierung experimenteller Funktionen über den anthropic-beta Request-Header. Zu diesen Beta-Funktionen gehören:

| Beta-Flag | Funktionsbeschreibung | Unterstützte Plattformen |

|---|---|---|

computer-use-2024-10-22 |

Computer-Use-Fähigkeit | Anthropic Direktverbindung |

token-counting-2024-11-01 |

Token-Zähl-API | Anthropic Direktverbindung |

context-1m-2025-08-07 |

1M Kontextfenster | Anthropic Direktverbindung |

tmp-preserve-thinking-2025-10-01 |

Erhaltung des Denkprozesses | Nur Anthropic Direktverbindung |

interleaved-thinking-2025-05-14 |

Interleaved Thinking Modus | Nur Anthropic Direktverbindung |

Warum OpenClaw Beta-Header sendet

Die zugrunde liegenden Abhängigkeiten von OpenClaw (wie das Claude SDK, LiteLLM usw.) fügen beim Senden von Anfragen automatisch Beta-Header hinzu:

anthropic-beta: claude-code-20250219,context-1m-2025-08-07,interleaved-thinking-2025-05-14,fine-grained-tool-streaming-2025-05-14,tmp-preserve-thinking-2025-10-01

Einschränkungen von AWS Bedrock und Vertex AI

Dies ist die eigentliche Ursache für den OpenClaw-Fehler „invalid beta flag“:

AWS Bedrock und Google Vertex AI unterstützen als Managed Services keine Beta-Funktionen von Anthropic. Wenn diese Beta-Header an die Cloud-Dienste übermittelt werden, lehnt der Server die Anfrage direkt ab und gibt den Fehler invalid beta flag zurück.

🎯 Kernproblem: Die vom SDK automatisch injizierten Beta-Header sind nicht kompatibel mit Bedrock/Vertex AI, aber das SDK filtert diese Header nicht automatisch basierend auf dem Ziel-Endpunkt.

5 Wege zur Behebung des Fehlers „OpenClaw invalid beta flag“

Methode 1: OpenClaw-Modellkonfiguration anpassen (Empfohlen)

Der einfachste Weg besteht darin, Beta-Funktionen in der OpenClaw-Konfiguration explizit zu deaktivieren.

Bearbeiten Sie die Datei ~/.openclaw/openclaw.json:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"options": {

"beta_features": []

}

}

}

}

}

Erläuterung der OpenClaw-Konfiguration:

| Konfigurationspunkt | Funktion | Empfohlener Wert |

|---|---|---|

beta_features |

Steuert die aktivierten Beta-Funktionen | [] (leeres Array) |

extra_headers |

Benutzerdefinierte Request-Header | Keine Beta-Bezüge setzen |

disable_streaming |

Deaktiviert das Streaming | false |

Methode 2: Direkte Anthropic API verwenden (Am stabilsten)

Die zuverlässigste Methode, um den Fehler „OpenClaw invalid beta flag“ zu vermeiden, ist die direkte Nutzung der offiziellen Anthropic API anstelle des Umwegs über Bedrock oder Vertex AI.

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4"

}

}

}

}

Umgebungsvariable setzen:

export ANTHROPIC_API_KEY="ihr-anthropic-api-key"

🚀 Schnellstart: Wenn Sie keinen Anthropic API-Key haben, können Sie über APIYI (apiyi.com) schnell Testguthaben erhalten. Die Plattform bietet eine OpenAI-kompatible Schnittstelle und unterstützt die gesamte Claude-Modellserie.

Methode 3: LiteLLM zur Filterung von Beta-Headern konfigurieren

Falls Sie LiteLLM als Modell-Proxy für OpenClaw verwenden, können Sie eine Header-Filterung konfigurieren:

# litellm_config.py

import litellm

# Konfiguration, um keine Beta-Header an Bedrock zu senden

litellm.drop_params = True

litellm.modify_params = True

# Oder in der config.yaml konfigurieren

# model_list:

# - model_name: claude-sonnet

# litellm_params:

# model: bedrock/anthropic.claude-3-sonnet

# drop_params: true

Methode 4: Prompt Caching deaktivieren (Temporäre Lösung)

In einigen Fällen hängt der Fehler „OpenClaw invalid beta flag“ mit der Prompt-Caching-Funktion zusammen. Das Deaktivieren des Caches kann das Problem lösen:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"cache": {

"enabled": false

}

}

}

}

}

Methode 5: Wechsel zu einem kompatiblen Modellanbieter

Wenn Sie Cloud-Hosting-Dienste nutzen müssen, aber den Fehler „OpenClaw invalid beta flag“ vermeiden wollen, können Sie einen OpenAI-kompatiblen Proxy-Dienst in Betracht ziehen:

{

"models": {

"providers": [

{

"name": "apiyi",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "ihr-api-key",

"models": ["claude-sonnet-4", "claude-opus-4-5"]

}

]

}

}

💡 Empfehlung zur Auswahl: Die Verwendung einer OpenAI-kompatiblen Schnittstelle vermeidet Beta-Header-Probleme vollständig und gewährleistet gleichzeitig eine gute Kompatibilität mit OpenClaw. APIYI (apiyi.com) bietet eine solche einheitliche Schnittstelle und unterstützt verschiedene Modelle wie Claude, GPT und Gemini.

OpenClaw Modellkonfiguration Best Practices

Vollständiges Konfigurationsbeispiel

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "openai/gpt-4o",

"options": {

"temperature": 0.7,

"max_tokens": 4096

}

},

"sandbox": {

"mode": "non-main"

}

}

},

"models": {

"providers": [

{

"name": "apiyi-claude",

"type": "openai",

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "${APIYI_API_KEY}",

"models": ["claude-sonnet-4", "claude-opus-4-5", "claude-haiku"]

}

]

}

}

Empfehlungen zur Modellauswahl für OpenClaw

| Anwendungsszenario | Empfohlenes Modell | Provider-Auswahl |

|---|---|---|

| Alltägliche Konversation | Claude Haiku | Anthropic Direkt / APIYI |

| Codegenerierung | Claude Sonnet 4 | Anthropic Direkt / APIYI |

| Komplexe logische Schlussfolgerungen | Claude Opus 4.5 | Anthropic Direkt / APIYI |

| Kostensensibel | GPT-4o-mini | OpenAI / APIYI |

| Lokale Bereitstellung | Llama 3.3 | Ollama |

Fehlerbehebungsprozess für OpenClaw "invalid beta flag"

<circle cx="30" cy="60" r="8" fill="url(#blueGrad4)" />

<text x="30" y="64" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">1</text>

<text x="45" y="64" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Konfiguration ändern, Beta deaktivieren</text>

<circle cx="30" cy="85" r="8" fill="url(#blueGrad4)" />

<text x="30" y="89" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">2</text>

<text x="45" y="89" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">Zu Anthropic Direktverbindung wechseln</text>

<circle cx="30" cy="110" r="8" fill="url(#blueGrad4)" />

<text x="30" y="114" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">3</text>

<text x="45" y="114" font-family="Arial, sans-serif" font-size="10" fill="#e2e8f0">OpenAI-kompatible Schnittstelle nutzen</text>

<circle cx="30" cy="135" r="8" fill="url(#greenGrad4)" />

<text x="30" y="139" text-anchor="middle" font-family="Arial" font-size="9" fill="#fff">★</text>

<text x="45" y="139" font-family="Arial, sans-serif" font-size="10" fill="#10b981">Empfohlen: APIYI apiyi.com</text>

<text x="25" y="60" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• API-Key gültig?</text>

<text x="25" y="80" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• Netzwerkverbindung okay?</text>

<text x="25" y="100" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• Modellname korrekt?</text>

<text x="25" y="120" font-family="Arial, sans-serif" font-size="10" fill="#94a3b8">• Rate Limit erreicht?</text>

Schritte zur Fehlerbehebung

Schritt 1: Fehlerquelle bestätigen

# OpenClaw-Logs einsehen

tail -f ~/.openclaw/logs/openclaw.log | grep -i "beta"

Schritt 2: Aktuelle Konfiguration prüfen

# Modellkonfiguration anzeigen

cat ~/.openclaw/openclaw.json | jq '.agents.defaults.model'

Schritt 3: API-Konnektivität testen

# Test mit curl (ohne Beta-Header)

curl -X POST https://api.anthropic.com/v1/messages \

-H "Content-Type: application/json" \

-H "x-api-key: $ANTHROPIC_API_KEY" \

-H "anthropic-version: 2023-06-01" \

-d '{

"model": "claude-sonnet-4-20250514",

"max_tokens": 100,

"messages": [{"role": "user", "content": "Hello"}]

}'

Schritt 4: Reparatur verifizieren

# OpenClaw-Dienst neu starten

openclaw restart

# Testnachricht senden

openclaw chat "Testnachricht"

Häufige Ergebnisse der Fehlerbehebung

| Ergebnis | Ursachenanalyse | Lösung |

|---|---|---|

| Direkt-API erfolgreich, Bedrock fehlgeschlagen | Beta-Header inkompatibel | Methode 1 oder 2 anwenden |

| Alle Anfragen fehlgeschlagen | Problem mit API-Key oder Netzwerk | Anmeldedaten und Netzwerk prüfen |

| Sporadische Fehler | Mögliches Rate Limit | Aufruffrequenz prüfen |

| Bestimmtes Modell fehlgeschlagen | Modell-ID falsch oder nicht verfügbar | Korrekten Modellnamen bestätigen |

OpenClaw Claude Code-Beispiele

Python Direktaufruf-Beispiel (Vermeidung von invalid beta flag)

import anthropic

# Client erstellen - keine Beta-Funktionen aktivieren

client = anthropic.Anthropic(

api_key="your-api-key",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI verwenden

)

# Nachricht senden - ohne Beta-Parameter

message = client.messages.create(

model="claude-sonnet-4-20250514",

max_tokens=1024,

messages=[

{"role": "user", "content": "Hello, Claude!"}

]

)

print(message.content[0].text)

OpenAI SDK kompatibler Aufruf

from openai import OpenAI

# OpenAI-kompatible Schnittstelle verwenden, um Beta-Header-Probleme vollständig zu vermeiden

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI

)

response = client.chat.completions.create(

model="claude-sonnet-4",

messages=[

{"role": "user", "content": "Hello!"}

]

)

print(response.choices[0].message.content)

🎯 Technischer Hinweis: Die Verwendung der OpenAI-kompatiblen Schnittstelle ist die einfachste Lösung, um den OpenClaw "invalid beta flag"-Fehler zu vermeiden. Die von APIYI (apiyi.com) bereitgestellte einheitliche Schnittstelle ist nicht nur mit Claude kompatibel, sondern unterstützt auch GPT, Gemini und andere gängige Modelle, was den Wechsel und das Testen zwischen verschiedenen Modellen erleichtert.

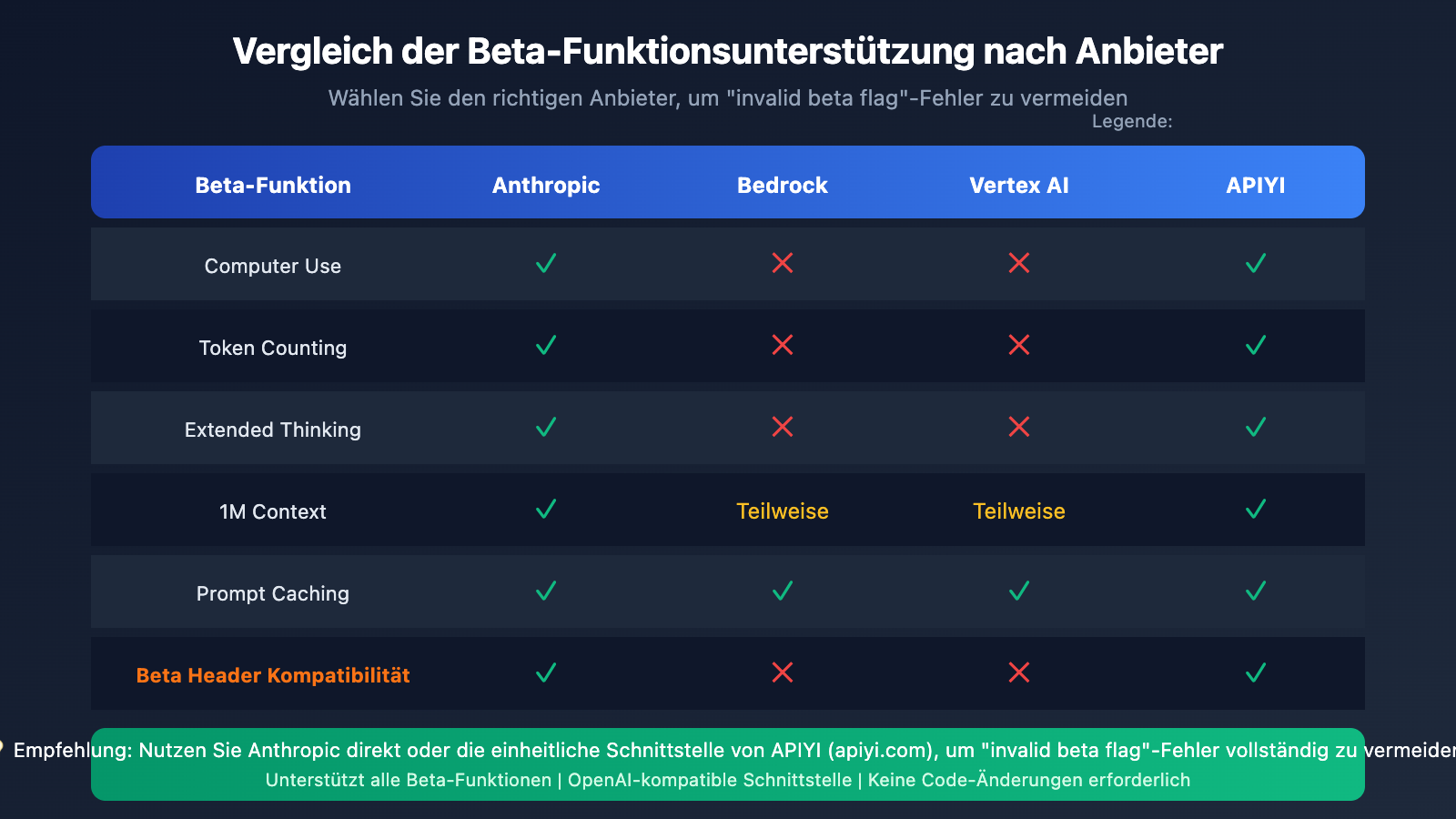

Kompatibilität von OpenClaw mit verschiedenen Cloud-Anbietern

Support-Matrix für Cloud-Service-Beta-Funktionen

| Funktion | Anthropic Direktverbindung | AWS Bedrock | Vertex AI | APIYI |

|---|---|---|---|---|

| Basis Messages API | ✅ | ✅ | ✅ | ✅ |

| Computer Use | ✅ | ❌ | ❌ | ✅ |

| Token Counting | ✅ | ❌ | ❌ | ✅ |

| Extended Thinking | ✅ | ❌ | ❌ | ✅ |

| 1M Context | ✅ | Teilweise | Teilweise | ✅ |

| Prompt Caching | ✅ | ✅ | ✅ | ✅ |

Warum ein API-Relay-Service die richtige Wahl ist

Für OpenClaw-Nutzer bietet die Verwendung eines API-Relay-Services folgende Vorteile:

- Bessere Kompatibilität – Automatische Header-Konvertierung zur Vermeidung von "invalid beta flag".

- Kosteneffizienter – In der Regel wirtschaftlicher als der direkte Aufruf der offiziellen API.

- Einfacher Wechsel – Einheitliche Schnittstelle für den problemlosen Wechsel zwischen verschiedenen Modellen.

- Hohe Stabilität – Lastverteilung über mehrere Knoten zur Vermeidung von Single-Point-of-Failure.

OpenClaw invalid beta flag Häufig gestellte Fragen (FAQ)

Q1: Warum tritt der Fehler "invalid beta flag" nur bei der Verwendung von Bedrock auf?

AWS Bedrock ist ein verwalteter Service von Amazon, der zwar Zugriff auf Claude-Modelle bietet, aber die experimentellen Beta-Funktionen von Anthropic nicht unterstützt. Wenn OpenClaw oder die zugrunde liegenden Bibliotheken automatisch Beta-Header mitsenden, lehnt Bedrock diese Anfragen ab.

Lösung: Verwenden Sie die Anthropic-Direkt-API oder konfigurieren Sie eine Filterung für Beta-Header. Wenn Sie Tests schnell durchführen möchten, können Sie über APIYI (apiyi.com) Gratis-Guthaben zur Verifizierung erhalten.

Q2: Was tun, wenn der Fehler nach der Änderung der Konfiguration weiterhin besteht?

Möglicherweise liegt dies am Konfigurations-Cache oder daran, dass der Dienst nicht neu gestartet wurde. Bitte führen Sie folgende Schritte aus:

- OpenClaw vollständig stoppen:

openclaw stop - Cache löschen:

rm -rf ~/.openclaw/cache/* - Neu starten:

openclaw start

Q3: Können Bedrock und die Direkt-API gleichzeitig verwendet werden?

Ja. Es wird empfohlen, die Anthropic-Direktverbindung als Hauptanbieter festzulegen (unterstützt alle Funktionen) und Bedrock als Fallback (ohne Beta-Funktionen) zu nutzen:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "bedrock/anthropic.claude-3-sonnet"

}

}

}

}

Q4: Welche Modellanbieter unterstützt OpenClaw?

OpenClaw unterstützt mehr als 12 Modellanbieter, darunter:

- Offizielle Direktverbindungen: Anthropic, OpenAI, Google Gemini, Mistral

- Cloud-Hosting: AWS Bedrock, Google Vertex AI

- Proxy-Dienste: OpenRouter, APIYI

- Lokale Bereitstellung: Ollama, LM Studio

💰 Kostenoptimierung: Für budgetbewusste Einzelentwickler empfiehlt es sich, die Claude-API über APIYI (apiyi.com) aufzurufen. Die Plattform bietet flexible Abrechnungsmodelle (Pay-as-you-go) ohne monatliche Grundgebühr.

Q5: Betrifft der Fehler "invalid beta flag" alle Claude-Modelle?

Ja, dieser Fehler betrifft alle Claude-Modelle, die über Bedrock oder Vertex AI aufgerufen werden, einschließlich der gesamten Claude Haiku-, Sonnet- und Opus-Serie.

Zusammenfassung

Die Hauptursache für den OpenClaw Claude API "invalid beta flag"-Fehler ist, dass die vom SDK automatisch angehängten Beta-Header nicht mit AWS Bedrock / Vertex AI kompatibel sind. Mit den in diesem Artikel vorgestellten 5 Methoden können Sie dieses Problem effektiv lösen:

- OpenClaw-Konfiguration anpassen – Beta-Funktionen deaktivieren

- Anthropic-Direktverbindung nutzen – Volle Kompatibilität mit allen Funktionen

- LiteLLM-Filterung konfigurieren – Lösung auf Proxy-Ebene

- Prompt Caching deaktivieren – Temporäre Umgehungslösung

- Zu einem kompatiblen Anbieter wechseln – OpenAI-kompatible Schnittstellen nutzen

Für die meisten OpenClaw-Nutzer empfehlen wir die Verwendung der Anthropic-Direkt-API oder eines OpenAI-kompatiblen Proxy-Dienstes, um dieses Problem dauerhaft zu vermeiden. Wir empfehlen einen schnellen Test über APIYI (apiyi.com), da die Plattform die gesamte Claude-Modellserie unterstützt und eine einheitliche OpenAI-kompatible Schnittstelle bietet.

Referenzen

-

GitHub – OpenClaw Offizielles Repository: Projektquellcode und Dokumentation

- Link:

github.com/openclaw/openclaw

- Link:

-

GitHub – LiteLLM invalid beta flag Issue: Diskussion in der Community

- Link:

github.com/BerriAI/litellm/issues/14043

- Link:

-

GitHub – Cline invalid beta flag Issue: Relevante Fehlermeldungen

- Link:

github.com/cline/cline/issues/5568

- Link:

-

Anthropic Beta Headers Dokumentation: Offizielle Erläuterung der Beta-Funktionen

- Link:

docs.anthropic.com/en/api/beta-headers

- Link:

-

OpenClaw Offizielle Dokumentation: Leitfaden zur Modellkonfiguration

- Link:

docs.openclaw.ai/concepts/model-providers

- Link:

📝 Autor: APIYI Technical Team

Für weitere Tipps zum Aufruf von KI-Modell-APIs besuchen Sie APIYI (apiyi.com) für technischen Support.