Quer analisar um repositório inteiro de código ou processar centenas de páginas de documentação técnica de uma só vez, mas sempre acaba travado pelo limite da janela de contexto? O Claude Opus 4.6 traz uma janela de contexto gigante de 1 milhão de tokens, o primeiro grande salto da série Opus — o equivalente a processar cerca de 750 mil palavras de uma só vez.

Valor central: Ao ler este artigo, você aprenderá como ativar a janela de contexto de 1M de tokens do Claude 4.6, entenderá a estratégia de preços para contextos longos e dominará 5 cenários práticos de alto valor.

Visão Geral dos Parâmetros da Janela de Contexto do Claude 4.6

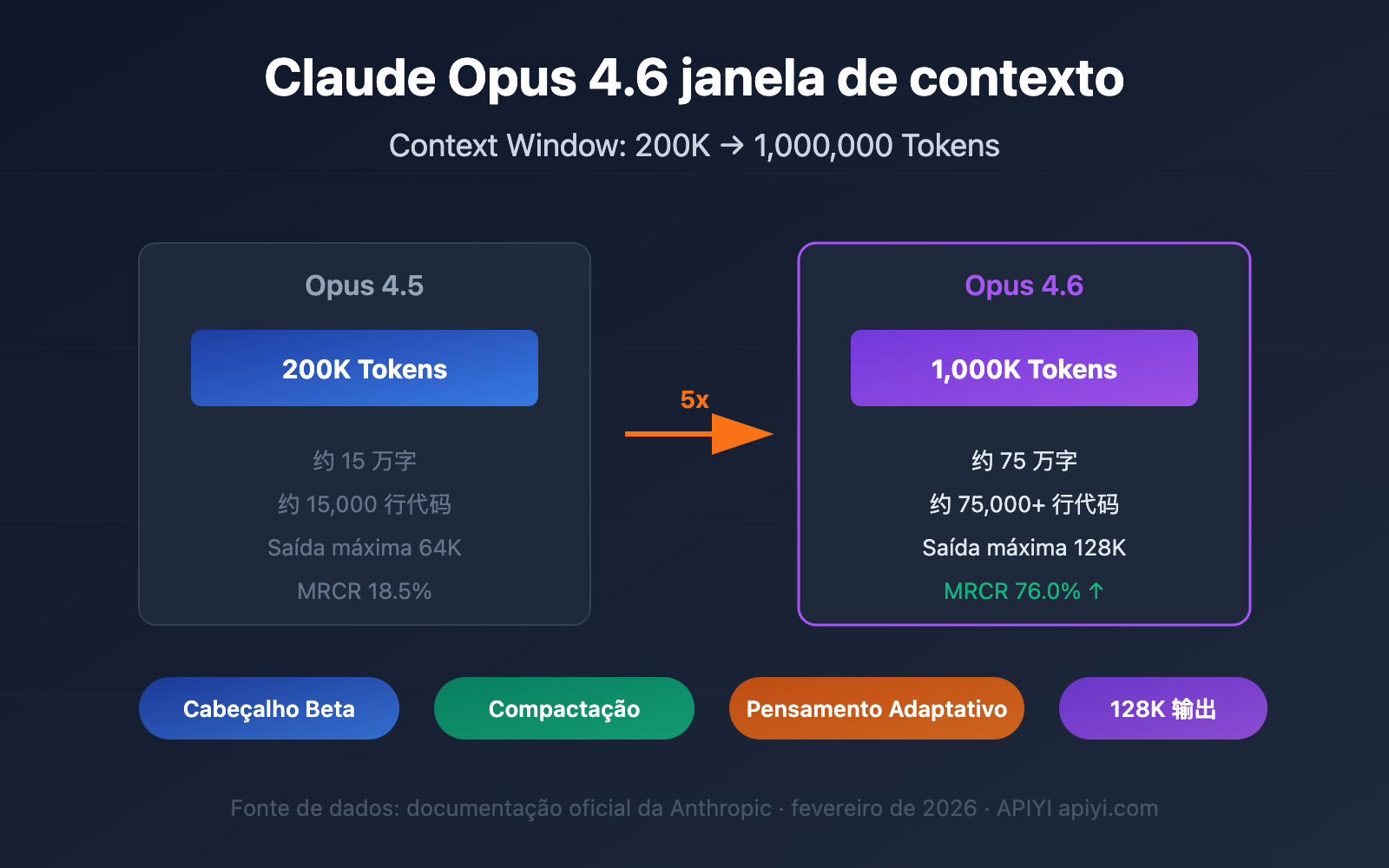

O Claude Opus 4.6 foi lançado em 5 de fevereiro de 2026, e o upgrade mais impressionante é a expansão massiva da janela de contexto. Confira os parâmetros principais:

| Parâmetro | Claude Opus 4.6 | Geração Anterior Opus 4.5 | Melhoria |

|---|---|---|---|

| Janela de Contexto Padrão | 200K Tokens | 200K Tokens | Sem alteração |

| Janela Estendida (Beta) | 1.000K (1M) Tokens | Não suportado | Primeiro suporte |

| Saída Máxima de Tokens | 128K Tokens | 64K Tokens | Aumento de 2x |

| Benchmark MRCR v2 (1M) | 76.0% | 18.5% | Aprox. 4x superior |

| Benchmark MRCR v2 (256K) | 93.0% | — | Precisão altíssima |

| Modo de Pensamento Recomendado | Adaptive Thinking | — | Novo recurso |

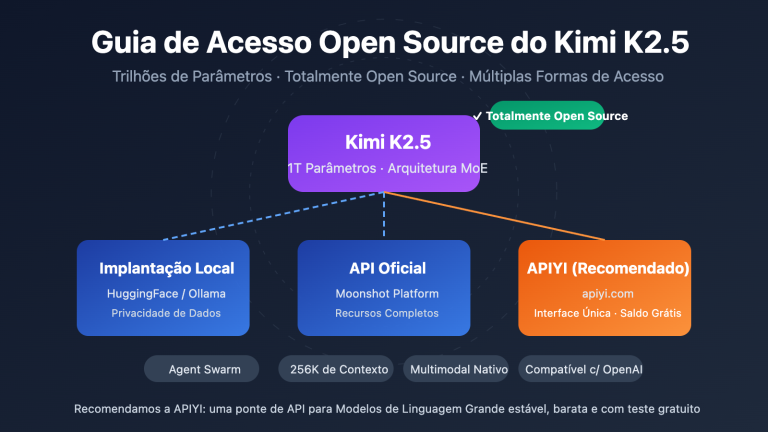

🎯 Informação chave: A janela de contexto de 1M do Claude Opus 4.6 está atualmente em fase Beta e precisa ser ativada via um Header de API específico. Por padrão, ele ainda utiliza a janela de 200K. Através da plataforma APIYI (apiyi.com), você pode testar rapidamente o desempenho do modelo em diferentes comprimentos de contexto.

3 avanços cruciais na janela de contexto do Claude 4.6

Avanço 1: Série Opus suporta 1M de contexto pela primeira vez

Antes do Claude Opus 4.6, a janela de contexto de 1 milhão de tokens estava disponível apenas para os modelos da série Sonnet (Sonnet 4 e Sonnet 4.5). O Opus 4.6 é o primeiro modelo flagship da linha Opus a suportar 1M de contexto, o que significa que agora você pode combinar a poderosa capacidade de raciocínio do Opus com uma janela de contexto gigantesca.

Para se ter uma ideia, 1M de tokens equivale a aproximadamente:

| Tipo de Conteúdo | Capacidade | Cenário Típico |

|---|---|---|

| Texto simples | Cerca de 750 mil palavras | Biblioteca completa de documentação técnica |

| Código | Cerca de 75.000+ linhas | Repositório de código completo |

| Documentos PDF | Dezenas de artigos de pesquisa | Revisão bibliográfica em lote |

| Histórico de diálogo | Centenas de rodadas de conversa | Manutenção de sessões ultra-longas |

Avanço 2: Acurácia de recuperação em contextos longos dispara

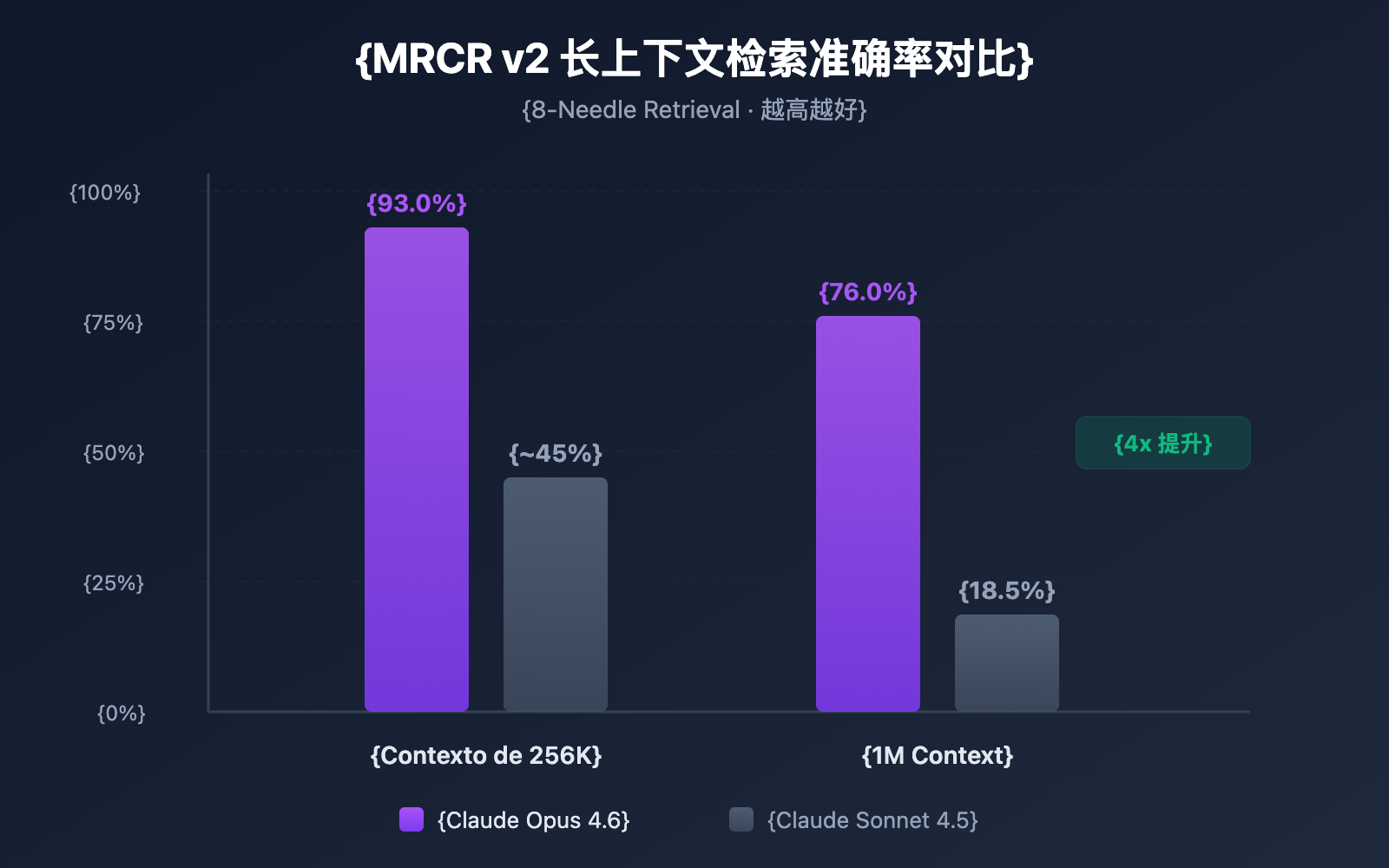

Ter uma janela de contexto grande é uma coisa; conseguir encontrar informações nela com precisão é outra bem diferente. O Claude Opus 4.6 apresentou um desempenho impressionante no benchmark MRCR v2 (Multi-needle Retrieval with Contextual Reasoning):

- Contexto de 256K Tokens: Acurácia de 93,0%

- Contexto de 1M Tokens (8 agulhas): Acurácia de 76,0%

O MRCR v2 é um teste do tipo "agulha no palheiro" — onde 8 informações cruciais são escondidas em um texto de 1 milhão de tokens, e o modelo deve encontrar todas. A acurácia de 76% do Claude Opus 4.6 representa um salto qualitativo em relação aos 18,5% do Sonnet 4.5, elevando a confiabilidade em cerca de 4 a 9 vezes.

Avanço 3: Mecanismo de Compaction permite diálogos infinitos

O Claude Opus 4.6 introduziu o mecanismo de Compaction (compressão de contexto), que é uma função de resumo automático de contexto no lado do servidor:

- Quando o diálogo se aproxima do limite da janela de contexto, a API resume automaticamente as partes mais antigas da conversa.

- Não há necessidade de gerenciar o contexto manualmente, nem de usar janelas deslizantes ou estratégias de truncamento.

- Teoricamente, suporta diálogos de duração infinita.

Isso é especialmente valioso para fluxos de trabalho de Agentes — em cenários que envolvem muitas chamadas de ferramentas e longas cadeias de raciocínio, o Compaction pode reduzir significativamente o custo de manutenção do estado da conversa.

Como ativar a janela de contexto no Claude 4.6

Passo 1: Confirmar elegibilidade da conta

A janela de contexto de 1M de tokens é atualmente um recurso Beta, disponível apenas para:

- Organizações no Usage Tier 4 ou superior.

- Organizações com limites de taxa personalizados (custom rate limits).

Você pode verificar seu nível atual de Usage Tier no Anthropic Console.

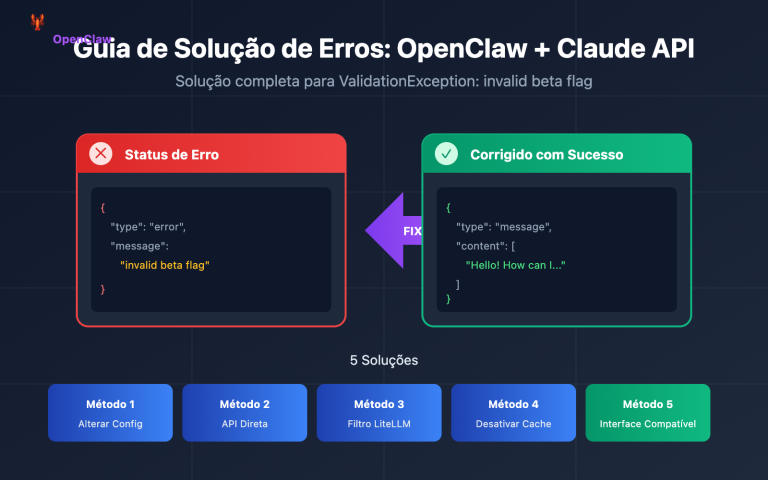

Passo 2: Adicionar Header Beta

Para habilitar a janela de 1M de contexto, é necessário adicionar um Header Beta específico na requisição da API:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Chamada via interface unificada da APIYI

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "Analisar o seguinte repositório de código completo..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

Se você estiver usando o SDK da Anthropic diretamente, a requisição curl correspondente seria:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "Seu conteúdo de texto ultra-longo..."}

]

}'

🚀 Início Rápido: Recomendamos usar a plataforma APIYI (apiyi.com) para testar rapidamente a capacidade de contexto longo do Claude Opus 4.6. A plataforma oferece uma interface de API unificada, eliminando a necessidade de lidar com vários provedores separadamente, permitindo a integração em apenas 5 minutos.

Passo 3: Validar a janela de contexto

Após enviar a requisição, você pode confirmar a quantidade real de tokens utilizados através do campo usage retornado:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

Se o input_tokens ultrapassar 200.000 e a requisição for bem-sucedida, significa que a janela de contexto de 1M foi ativada corretamente.

Ver exemplo completo de código Python (com contagem de tokens)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interface unificada APIYI

)

# Lendo arquivos de um grande repositório de código

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"Comprimento do conteúdo de entrada: {len(codebase_content)} caracteres")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "Você é um especialista em revisão de código. Por favor, analise todo o repositório."

},

{

"role": "user",

"content": f"Por favor, analise o design da arquitetura e potenciais problemas do seguinte repositório:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"Tokens de entrada: {response.usage.prompt_tokens}")

print(f"Tokens de saída: {response.usage.completion_tokens}")

print(f"\nResultado da análise:\n{response.choices[0].message.content}")

Detalhes de Preços da Janela de Contexto do Claude 4.6

O uso da janela de contexto de 1M envolve um mecanismo de preços por níveis. Quando a solicitação excede 200K tokens, o sistema muda automaticamente para o preço de contexto longo:

| Nível de Preço | Preço de Entrada (por milhão de tokens) | Preço de Saída (por milhão de tokens) | Abrangência |

|---|---|---|---|

| Preço Padrão | $5.00 | $25.00 | ≤ 200K Tokens |

| Preço de Contexto Longo | $10.00 | $37.50 | > 200K Tokens |

| Multiplicador de Preço | 2x | 1.5x | Aplicado automaticamente |

Exemplo de Cálculo de Preço

Suponha que você envie uma solicitação de análise de texto longo de 500K tokens, com uma saída de 4.000 tokens:

- Custo de entrada: 500K × ($10.00 / 1M) = $5.00

- Custo de saída: 4K × ($37.50 / 1M) = $0.15

- Custo total por solicitação: $5.15

💰 Dica de Otimização de Custos: Para projetos que exigem o uso frequente de contextos longos, você pode chamar a API do Claude Opus 4.6 através da plataforma APIYI (apiyi.com). A plataforma oferece métodos de faturamento flexíveis e preços mais vantajosos, ajudando equipes de pequeno e médio porte a controlar os custos de forma eficaz.

Aproveite o Context Caching para Reduzir Custos

Se o seu cenário de aplicação envolve consultas repetidas ao mesmo conjunto de documentos (como apps de "conversa com documentos"), você pode utilizar a função de Context Caching:

- O primeiro upload do documento é cobrado pelo preço padrão.

- As consultas subsequentes baseadas no conteúdo em cache desfrutam de um preço com desconto.

- Ideal para cenários de alta frequência, como análise de documentos em lote e Q&A de bases de conhecimento.

Melhores Práticas de Controle de Custos para a Janela de Contexto do Claude 4.6

| Estratégia de Otimização | Descrição | Economia Estimada |

|---|---|---|

| Use 1M sob demanda | Ative o Beta Header apenas quando realmente precisar de um contexto extra longo | Evita o ágio de 2x na entrada |

| Context Caching | Use cache para documentos consultados repetidamente | 40-60% no custo de entrada |

| Pré-filtragem de entrada | Remova conteúdo irrelevante (comentários, linhas vazias, etc.) antes do upload | 10-30% no consumo de tokens |

| Estratégia em camadas | Use o Sonnet para tarefas simples e o Opus para tarefas complexas | Redução de custo total em 50%+ |

| Controle de comprimento de saída | Defina um max_tokens razoável para evitar saídas redundantes |

Reduz custos de saída |

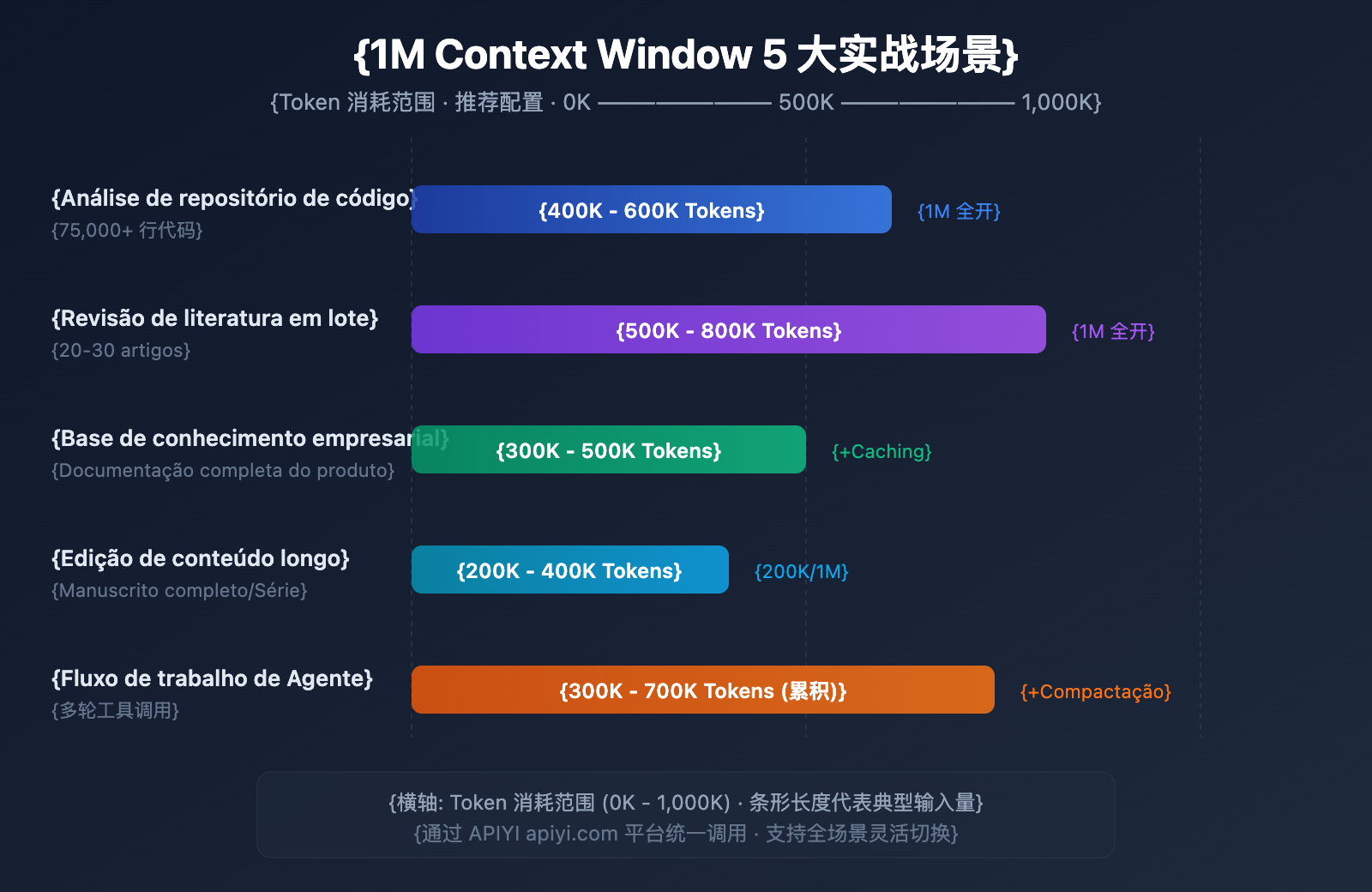

5 Principais Cenários Reais da Janela de Contexto do Claude 4.6

Cenário 1: Análise de Repositório de Código Completo

Escala de entrada: 50-75 mil linhas de código (aprox. 400K-600K Tokens)

Este é o cenário que mais se beneficia diretamente da janela de contexto de 1M. Ao enviar todo o código-fonte do projeto de uma vez para o Claude Opus 4.6, você pode realizar:

- Revisão de arquitetura global: Identificar problemas de design entre diferentes módulos.

- Análise de dependências: Encontrar dependências circulares e acoplamento excessivo.

- Varredura de vulnerabilidades: Descobrir riscos de segurança que cruzam múltiplos arquivos no contexto completo.

- Sugestões de refatoração: Oferecer planos de refatoração baseados em uma compreensão global.

Antigamente, ao lidar com grandes repositórios, os desenvolvedores tinham que dividir o código em fragmentos, o que impedia o modelo de entender as dependências entre arquivos. Agora, você pode enviar o núcleo de um monorepo inteiro e deixar o Claude dar sugestões como um arquiteto que realmente entende o todo.

Cenário 2: Revisão Bibliográfica em Lote

Escala de entrada: 20-30 artigos científicos (aprox. 500K-800K Tokens)

Pesquisadores podem inserir dezenas de artigos relacionados de uma só vez para que o Claude realize:

- Análise de citações cruzadas: Identificar relações de citação e conflitos de opinião entre os artigos.

- Resumo de tendências de pesquisa: Extrair a evolução metodológica de uma vasta literatura.

- Análise de lacunas (Gap Analysis): Descobrir áreas ainda não exploradas pelas pesquisas atuais.

- Auxílio em meta-análise: Comparar horizontalmente o design experimental e os resultados de diferentes estudos.

Para um acadêmico, ler manualmente 30 artigos pode levar semanas. Com a janela de contexto de 1M, é possível concluir a triagem inicial e a extração de informações cruciais em poucos minutos, acelerando drasticamente a eficiência da pesquisa bibliográfica.

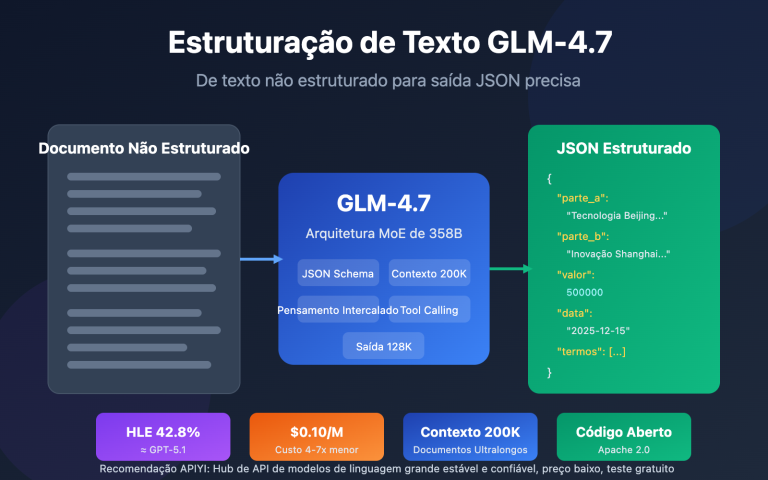

Cenário 3: Q&A de Base de Conhecimento Corporativa

Escala de entrada: Biblioteca completa de documentação de produto (aprox. 300K-500K Tokens)

Carregue toda a documentação interna da empresa no contexto para obter:

- Respostas precisas: Respostas baseadas na biblioteca completa de documentos.

- Associação entre documentos: Descobrir conexões de informações entre diferentes manuais.

- Atualização em tempo real: Sem necessidade de pré-processamento de vetorização, use os documentos mais recentes diretamente.

- Raciocínio multidocumento: Responder a perguntas complexas sintetizando várias especificações técnicas.

Comparado às soluções tradicionais de RAG (Geração Aumentada por Recuperação), a solução de contexto total elimina os custos de engenharia de vetorização, construção de índices e ajuste de recuperação. Para bases de conhecimento de pequeno e médio porte (até 1M de tokens), usar o contexto longo diretamente é mais simples e eficiente.

Cenário 4: Criação e Edição de Conteúdo de Longo Formato

Escala de entrada: Manuscrito completo ou série de artigos (aprox. 200K-400K Tokens)

- Revisão de consistência: Garantir que a lógica do conteúdo longo seja consistente do início ao fim.

- Unificação de estilo: Manter o estilo de linguagem uniforme em todo o texto.

- Otimização estrutural: Sugerir ajustes de capítulos baseados na compreensão do texto integral.

- Padronização de termos: Unificar o uso de termos técnicos em todo o livro.

Por exemplo, um livro técnico de 200 mil palavras ocupa cerca de 300K tokens, o que permite ao Claude revisar o manuscrito completo em uma única solicitação e apontar contradições internas.

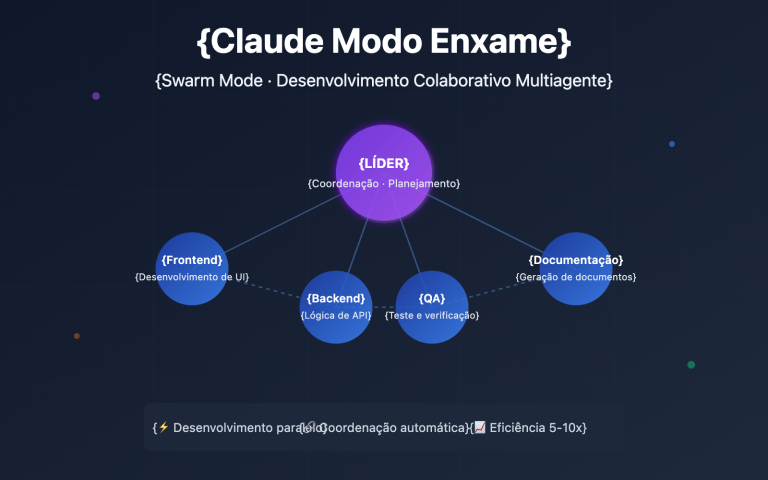

Cenário 5: Fluxos de Trabalho de Agents Complexos

Escala de entrada: Registros de múltiplas rodadas de chamadas de ferramentas (acumulado de 300K-700K Tokens)

Em conjunto com a função de Agent Teams do Claude 4.6:

- Raciocínio de longa cadeia: Manter a cadeia de raciocínio completa em tarefas complexas de várias etapas.

- Memória de chamadas de ferramentas: Lembrar os resultados de todas as chamadas de ferramentas históricas.

- Integração com Compaction: Compressão automática de contexto em fluxos de trabalho ultra-longos.

- Colaboração multi-Agent: Compartilhar informações de contexto entre diferentes equipes de Agents.

Os fluxos de trabalho de Agents são um dos principais cenários de uso do Claude Opus 4.6. Ao executar tarefas complexas (como revisão automatizada de código ou pipelines de análise de dados), um Agent pode precisar chamar ferramentas dezenas de vezes, e cada entrada e saída se acumula no contexto. A janela de 1M garante que, mesmo em tarefas de longa duração, o Agent não "esqueça" informações cruciais do início do processo.

🎯 Sugestão Prática: Todos os 5 cenários acima podem ser validados rapidamente através da plataforma APIYI (apiyi.com). A plataforma suporta diversos modelos de ponta, incluindo o Claude Opus 4.6, oferecendo uma experiência de interface unificada para alternar facilmente entre diferentes casos de uso.

Claude 4.6: Janela de Contexto e Comparação com Concorrentes

Entender a competitividade do Claude Opus 4.6 no campo de contextos longos ajuda você a fazer escolhas técnicas mais assertivas:

| Modelo | Janela de Contexto | Saída Máxima | Desempenho de Recuperação (Contexto Longo) | Preço (Entrada/Saída) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

Como podemos ver, o Claude Opus 4.6 tem uma vantagem clara na precisão de recuperação em contextos longos. Embora o preço seja mais elevado, sua confiabilidade supera de longe a dos concorrentes em cenários que exigem recuperação precisa e raciocínio complexo.

💡 Sugestão de escolha: A decisão de qual modelo usar depende principalmente das necessidades do seu cenário específico. Se a prioridade for a qualidade do raciocínio em contextos longos, o Claude Opus 4.6 é a melhor escolha no momento. Recomendamos realizar testes práticos comparativos através da plataforma APIYI (apiyi.com), que suporta chamadas de interface unificada para vários modelos populares, facilitando a troca rápida e a avaliação.

Configuração de Compaction na Janela de Contexto do Claude 4.6

O Compaction é um novo recurso de compressão de contexto no lado do servidor do Claude Opus 4.6, que permite que as conversas continuem, teoricamente, de forma infinita.

Como funciona

- A API monitora o uso de tokens em cada rodada da conversa.

- Quando os tokens de entrada excedem o limite definido, um resumo é acionado automaticamente.

- O modelo gera um resumo da conversa envolvido pela tag

<summary>. - O resumo substitui o conteúdo inicial da conversa, liberando espaço no contexto.

Método de configuração

Adicione o parâmetro compaction_control na requisição da API:

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # Limite de ativação

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Estratégias para combinar Compaction com Janela de 1M

| Estratégia | Janela de Contexto | Compaction | Cenários Aplicáveis |

|---|---|---|---|

| Análise única massiva | 1M (Totalmente aberto) | Desativado | Revisão de código, revisão de literatura |

| Conversas de longo prazo | 200K (Padrão) | Ativado | Atendimento ao cliente, assistentes, agentes |

| Modo híbrido | 1M + Compaction | Ativado | Fluxos de trabalho de agentes ultra complexos |

Perguntas Frequentes

Q1: A janela de contexto do Claude 4.6 é de 1M por padrão?

Não. A janela de contexto padrão do Claude Opus 4.6 ainda é de 200K Tokens, a mesma da geração anterior Opus 4.5. Para utilizar a janela de contexto de 1M Tokens, é necessário adicionar o header anthropic-beta: context-1m-2025-08-07 na requisição da API. Além disso, sua organização precisa atingir o Usage Tier 4 ou possuir limites de taxa personalizados. Ao fazer chamadas através da plataforma APIYI (apiyi.com), você pode adicionar este header facilmente na sua requisição.

Q2: Existe cobrança adicional ao usar a janela de contexto de 1M?

Sim, existe uma precificação em camadas. Quando a requisição excede 200K Tokens, o preço de entrada (input) sobe de $5/M para $10/M (2x), e o preço de saída (output) sobe de $25/M para $37,50/M (1,5x). Para projetos sensíveis ao orçamento, recomendamos consultar os planos de preços mais vantajosos na plataforma APIYI (apiyi.com).

Q3: É possível encontrar informações específicas com precisão em um contexto de 1M?

O Claude Opus 4.6 apresentou um desempenho excelente no benchmark MRCR v2. Em cenários de teste onde 8 informações cruciais foram ocultadas em um contexto de 1M de Tokens, a taxa de acerto foi de 76%, cerca de 4 vezes superior à do Sonnet 4.5 (18,5%). Em um contexto de 256K, a precisão chega a impressionantes 93%. Isso significa que o Claude Opus 4.6 é atualmente um dos modelos mais confiáveis para recuperação em contextos longos.

Q4: O recurso de Compaction afeta a qualidade das respostas?

O Compaction utiliza resumos inteligentes para comprimir o conteúdo inicial da conversa e, na maioria dos cenários, não afeta significativamente a qualidade das respostas. No entanto, para casos que exigem citações precisas de detalhes do início da conversa, recomendamos desativar o Compaction e usar diretamente a janela de contexto de 1M. Em fluxos de trabalho de Agentes, o Compaction pode aumentar consideravelmente a eficiência, sendo altamente recomendado.

Q5: Quais modelos Claude suportam o contexto de 1M?

Atualmente, três modelos Claude suportam a janela de contexto de 1M de Tokens: Claude Opus 4.6, Claude Sonnet 4.5 e Claude Sonnet 4. Entre eles, a precisão de recuperação em contexto longo do Opus 4.6 é muito superior à da série Sonnet. Outros modelos, como a série Claude Haiku, ainda não suportam o contexto de 1M.

Resumo

A janela de contexto de 1M de Tokens do Claude Opus 4.6 representa uma atualização de capacidade crucial, unindo o poderoso raciocínio do modelo flagship Opus com um contexto massivo. Isso abre portas para aplicações de alto valor, como análise de repositórios de código completos, revisões bibliográficas em lote e sistemas de perguntas e respostas sobre bases de conhecimento corporativas.

Recapitulação dos pontos principais:

- Padrão 200K, Beta expandido para 1M: Requer a inclusão do header

anthropic-beta: context-1m-2025-08-07. - Precisão de recuperação líder do setor: 76% no benchmark MRCR v2 (1M) / 93% (256K).

- Precificação em camadas: O que exceder 200K tem custo de entrada 2x e saída 1,5x.

- Suporte a Compaction para conversas infinitas: Compressão automática de contexto no lado do servidor, ideal para fluxos de Agentes.

- 3 modelos compatíveis: Opus 4.6, Sonnet 4.5 e Sonnet 4.

Recomendamos utilizar a APIYI (apiyi.com) para experimentar rapidamente as capacidades de contexto longo do Claude Opus 4.6. A plataforma suporta chamadas via interface unificada para diversos modelos de IA líderes, ajudando desenvolvedores a concluir validações técnicas e integrações de produtos com eficiência.

Este artigo foi escrito pelo Time APIYI, focado no compartilhamento de tecnologia de Modelos de Linguagem Grande (LLM). Para mais tutoriais e guias de uso de API, visite a Central de Ajuda da APIYI: help.apiyi.com

Referências

-

Blog Oficial da Anthropic – Apresentando o Claude Opus 4.6

- Link:

anthropic.com/news/claude-opus-4-6 - Descrição: Anúncio de lançamento do Claude Opus 4.6 e introdução às suas principais funcionalidades.

- Link:

-

Documentação da API do Claude – Janelas de Contexto (Context Windows)

- Link:

platform.claude.com/docs/en/build-with-claude/context-windows - Descrição: Guia de configuração e uso da janela de contexto.

- Link:

-

Documentação da API do Claude – Compactação (Compaction)

- Link:

platform.claude.com/docs/en/build-with-claude/compaction - Descrição: Detalhes sobre a funcionalidade de compactação de contexto (Compaction).

- Link:

-

Documentação da API do Claude – Preços (Pricing)

- Link:

platform.claude.com/docs/en/about-claude/pricing - Descrição: Tabela de preços do modelo e informações sobre cobrança de contextos longos.

- Link: