想一次性分析整个代码仓库或处理数百页技术文档,却总被上下文窗口限制卡住?Claude Opus 4.6 带来了 100 万 Token 的超大上下文窗口,这是 Opus 系列模型的首次突破——相当于一次性处理约 75 万字的文本内容。

核心价值: 读完本文,你将学会如何开启 Claude 4.6 的 1M Token 上下文窗口、理解长上下文定价策略,并掌握 5 大高价值实战应用场景。

Claude 4.6 上下文窗口核心参数一览

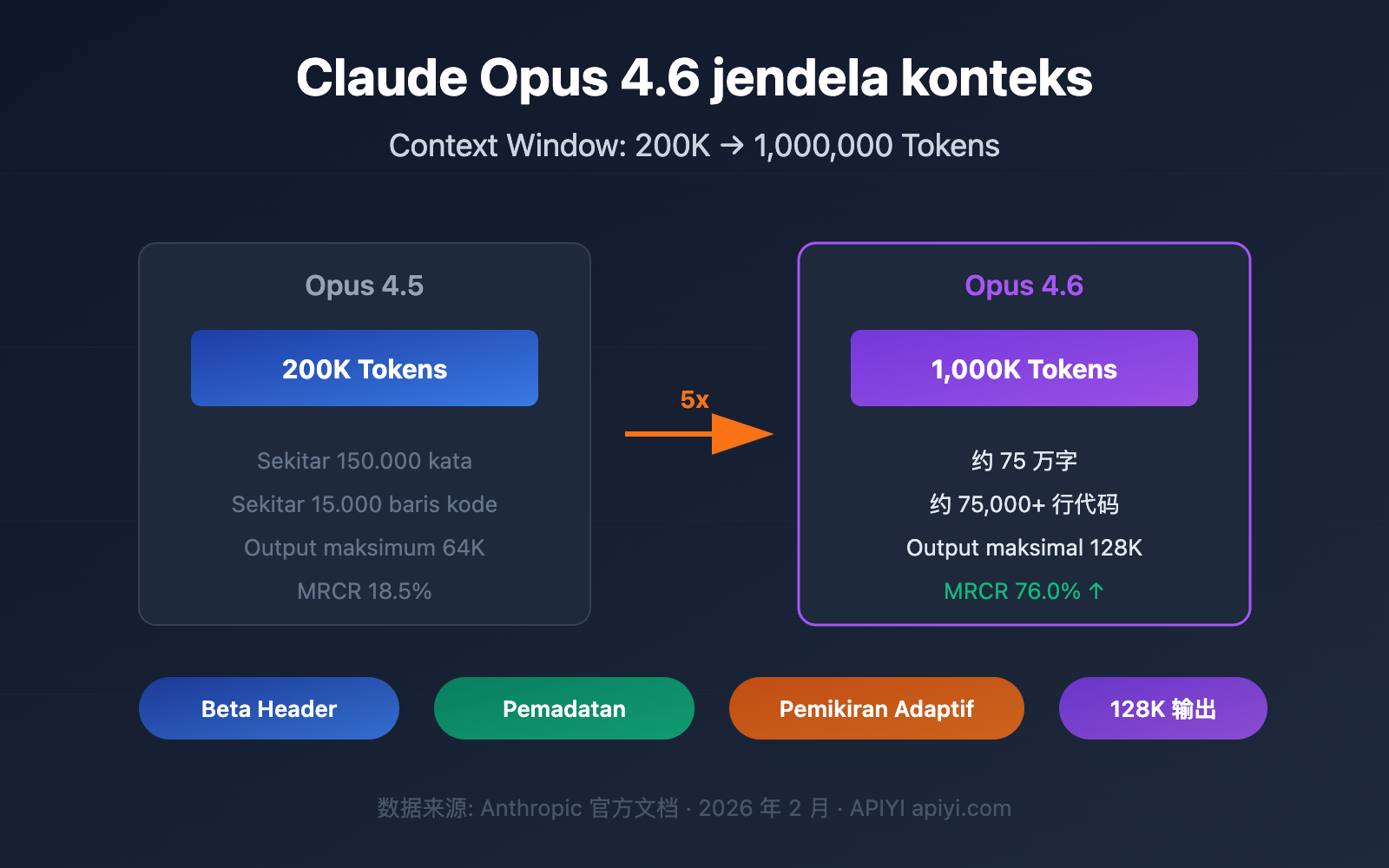

Claude Opus 4.6 于 2026 年 2 月 5 日发布,最引人注目的升级就是上下文窗口的大幅扩展。以下是核心参数:

| 参数项 | Claude Opus 4.6 | 上一代 Opus 4.5 | 提升幅度 |

|---|---|---|---|

| 默认上下文窗口 | 200K Token | 200K Token | 持平 |

| Beta 扩展窗口 | 1,000K (1M) Token | 不支持 | 首次支持 |

| 最大输出 Token | 128K Token | 64K Token | 2 倍提升 |

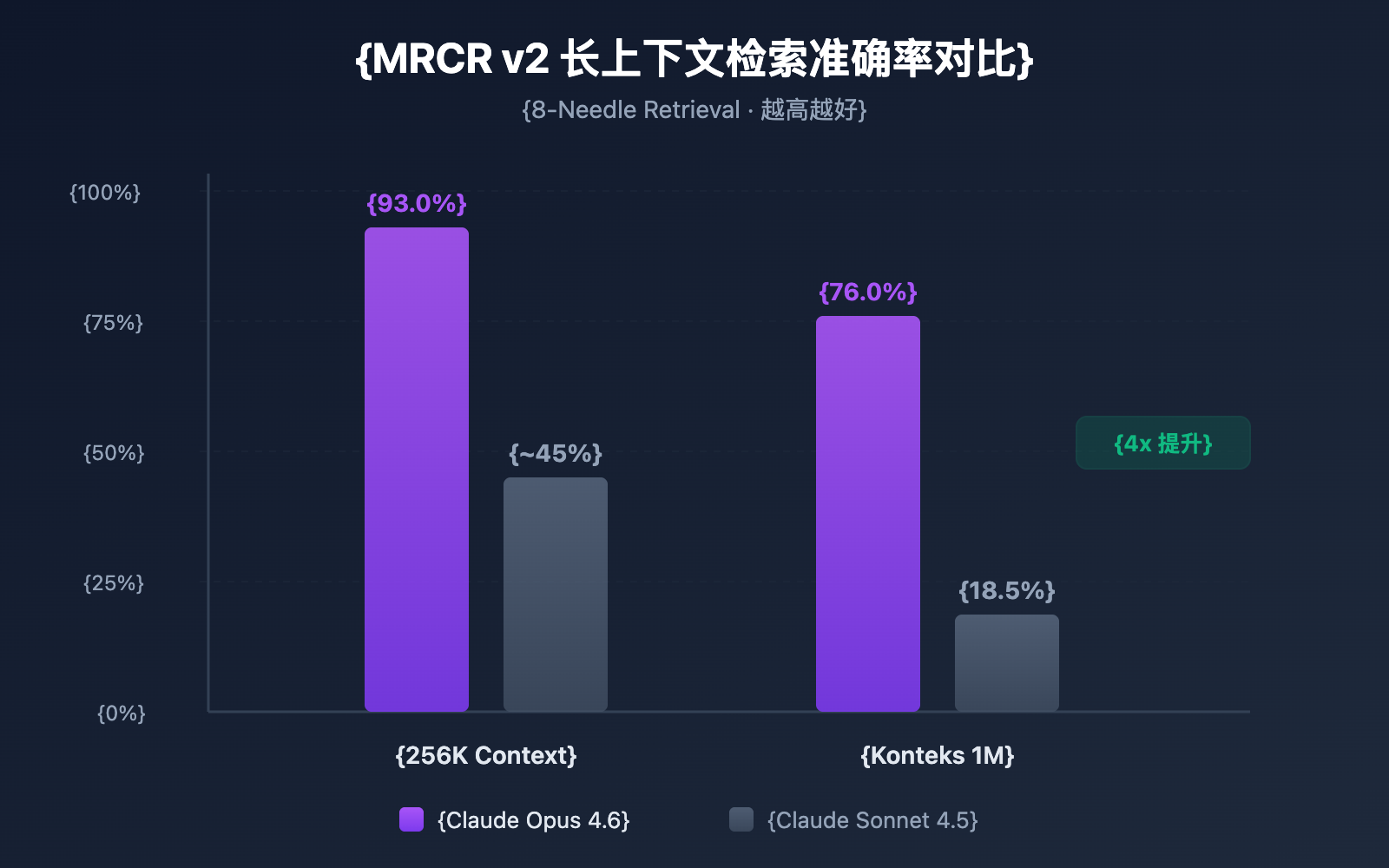

| MRCR v2 基准 (1M) | 76.0% | 18.5% | 约 4 倍提升 |

| MRCR v2 基准 (256K) | 93.0% | — | 极高准确率 |

| 推荐思维模式 | Adaptive Thinking | — | 新增特性 |

🎯 关键信息: Claude Opus 4.6 的 1M 上下文窗口目前处于 Beta 阶段,需要通过特定 API Header 开启。默认情况下仍使用 200K 上下文窗口。通过 APIYI apiyi.com 平台可以快速测试不同上下文长度下的模型表现。

3 Terobosan Kunci Jendela Konteks Claude 4.6

Terobosan 1: Seri Opus Mendukung 1M Konteks untuk Pertama Kalinya

Sebelum Claude Opus 4.6, jendela konteks 1 juta Token hanya tersedia untuk seri model Sonnet (Sonnet 4 dan Sonnet 4.5). Opus 4.6 adalah model unggulan Opus pertama yang mendukung konteks 1M, yang berarti kamu bisa menggabungkan kemampuan penalaran Opus yang kuat dengan konteks yang sangat besar.

Secara spesifik, 1M Token kira-kira setara dengan:

| Jenis Konten | Kapasitas | Skenario Tipikal |

|---|---|---|

| Teks Murni | Sekitar 750.000 kata | Seluruh pustaka dokumentasi teknis |

| Kode | Sekitar 75.000+ baris | Repositori kode lengkap |

| Dokumen PDF | Puluhan makalah penelitian | Tinjauan pustaka massal |

| Catatan Percakapan | Ratusan putaran dialog | Pemeliharaan sesi super panjang |

Terobosan 2: Akurasi Pengambilan Konteks Panjang Melonjak Tajam

Memiliki jendela konteks yang besar adalah satu hal, tetapi bisa menemukan informasi secara akurat di dalam jendela besar tersebut adalah hal lain. Claude Opus 4.6 menunjukkan performa luar biasa dalam tolok ukur MRCR v2 (Multi-needle Retrieval with Contextual Reasoning):

- Konteks 256K Token: Akurasi mencapai 93,0%

- Konteks 1M Token (8 jarum): Akurasi mencapai 76,0%

MRCR v2 adalah pengujian tipe "mencari jarum dalam tumpukan jerami" — menyembunyikan 8 informasi kunci di dalam teks 1 juta Token dan meminta model untuk menemukan semuanya. Akurasi 76% dari Claude Opus 4.6 merupakan lompatan besar dibandingkan 18,5% milik Sonnet 4.5, dengan peningkatan keandalan sekitar 4-9 kali lipat.

Terobosan 3: Mekanisme Compaction Mewujudkan Percakapan Tanpa Batas

Claude Opus 4.6 memperkenalkan mekanisme Compaction (kompresi konteks), yaitu fitur ringkasan konteks otomatis di sisi server:

- Saat percakapan mendekati batas jendela konteks, API secara otomatis meringkas konten percakapan yang lebih lama.

- Tidak perlu mengelola konteks secara manual, tidak perlu strategi jendela geser (sliding window) atau pemotongan (truncation).

- Secara teoritis mendukung percakapan dengan panjang tak terbatas.

Ini sangat berharga untuk alur kerja Agent — dalam skenario yang melibatkan banyak pemanggilan alat (tool calls) dan rantai penalaran yang panjang, Compaction dapat secara signifikan mengurangi biaya pemeliharaan status percakapan.

Cara Mengaktifkan Jendela Konteks Claude 4.6

Langkah 1: Konfirmasi Kualifikasi Akun

Jendela konteks 1M Token saat ini merupakan fitur Beta dan hanya terbuka untuk pengguna berikut:

- Organisasi dengan Usage Tier 4 ke atas

- Organisasi yang memiliki batas kecepatan kustom (custom rate limits)

Kamu bisa memeriksa level Usage Tier saat ini di Anthropic Console.

Langkah 2: Tambahkan Beta Header

Untuk mengaktifkan jendela konteks 1M, kamu perlu menambahkan Beta Header tertentu dalam permintaan API:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Memanggil melalui antarmuka terpadu APIYI

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "Analisis repositori kode lengkap berikut..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

Jika kamu menggunakan Anthropic SDK secara langsung, permintaan curl yang sesuai adalah sebagai berikut:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "Konten teks super panjang kamu..."}

]

}'

🚀 Mulai Cepat: Direkomendasikan menggunakan platform APIYI (apiyi.com) untuk menguji kemampuan konteks panjang Claude Opus 4.6 dengan cepat. Platform ini menyediakan antarmuka API terpadu, sehingga tidak perlu menghubungkan banyak penyedia layanan secara terpisah, integrasi selesai dalam 5 menit.

Langkah 3: Verifikasi Jendela Konteks

Setelah mengirimkan permintaan, kamu bisa mengonfirmasi jumlah Token yang sebenarnya digunakan melalui kolom usage yang dikembalikan:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

Jika input_tokens melebihi 200.000 dan permintaan berhasil, itu berarti jendela konteks 1M telah diaktifkan dengan benar.

Lihat Contoh Kode Python Lengkap (Termasuk Statistik Token)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Antarmuka terpadu APIYI

)

# Membaca file repositori kode besar

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"Panjang konten input: {len(codebase_content)} karakter")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "Anda adalah pakar peninjau kode senior, harap analisis seluruh repositori kode."

},

{

"role": "user",

"content": f"Harap analisis desain arsitektur dan potensi masalah dari repositori kode berikut:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"Token Input: {response.usage.prompt_tokens}")

print(f"Token Output: {response.usage.completion_tokens}")

print(f"\nHasil Analisis:\n{response.choices[0].message.content}")

Detail Harga Jendela Konteks Claude 4.6

Penggunaan jendela konteks 1M melibatkan mekanisme harga bertingkat. Saat permintaan Token melebihi 200K, sistem akan otomatis beralih ke harga konteks panjang (long context pricing):

| Tingkat Harga | Harga Input (per juta Token) | Harga Output (per juta Token) | Cakupan Berlaku |

|---|---|---|---|

| Harga Standar | $5.00 | $25.00 | ≤ 200K Token |

| Harga Konteks Panjang | $10.00 | $37.50 | > 200K Token |

| Kelipatan Harga | 2x | 1.5x | Otomatis diterapkan |

Contoh Perhitungan Harga

Misalkan Anda mengirim permintaan analisis teks panjang sebesar 500K Token, dengan output 4.000 Token:

- Biaya Input: 500K × ($10.00 / 1M) = $5.00

- Biaya Output: 4K × ($37.50 / 1M) = $0.15

- Total Biaya per Permintaan: $5.15

💰 Saran Optimasi Biaya: Untuk proyek yang membutuhkan penggunaan konteks panjang secara sering, Anda dapat memanggil API Claude Opus 4.6 melalui platform APIYI apiyi.com. Platform ini menawarkan metode penagihan yang fleksibel dan harga yang lebih kompetitif, membantu tim kecil dan menengah mengontrol biaya secara efektif.

Manfaatkan Context Caching untuk Mengurangi Biaya

Jika skenario aplikasi Anda melibatkan kueri berulang pada kumpulan dokumen yang sama (seperti aplikasi "chat dengan dokumen"), Anda dapat memanfaatkan fitur Context Caching:

- Unggahan dokumen pertama kali dikenakan biaya harga standar

- Kueri berikutnya berdasarkan konten cache akan mendapatkan harga diskon

- Cocok untuk analisis dokumen massal, tanya jawab basis pengetahuan, dan skenario frekuensi tinggi lainnya

Praktik Terbaik Kontrol Biaya Jendela Konteks Claude 4.6

| Strategi Optimasi | Keterangan | Estimasi Penghematan |

|---|---|---|

| Gunakan 1M Sesuai Kebutuhan | Aktifkan Beta Header hanya saat benar-benar butuh konteks sangat panjang | Hindari premi input 2x |

| Context Caching | Gunakan cache untuk dokumen yang dikueri berulang | 40-60% biaya input |

| Pra-filter Input | Hapus konten tidak relevan (komentar, baris kosong, dll) sebelum unggah | 10-30% konsumsi Token |

| Strategi Bertingkat | Tugas sederhana pakai Sonnet, tugas kompleks pakai Opus | Total biaya turun 50%+ |

| Kontrol Panjang Output | Atur max_tokens yang wajar untuk menghindari output berlebihan |

Mengurangi biaya output |

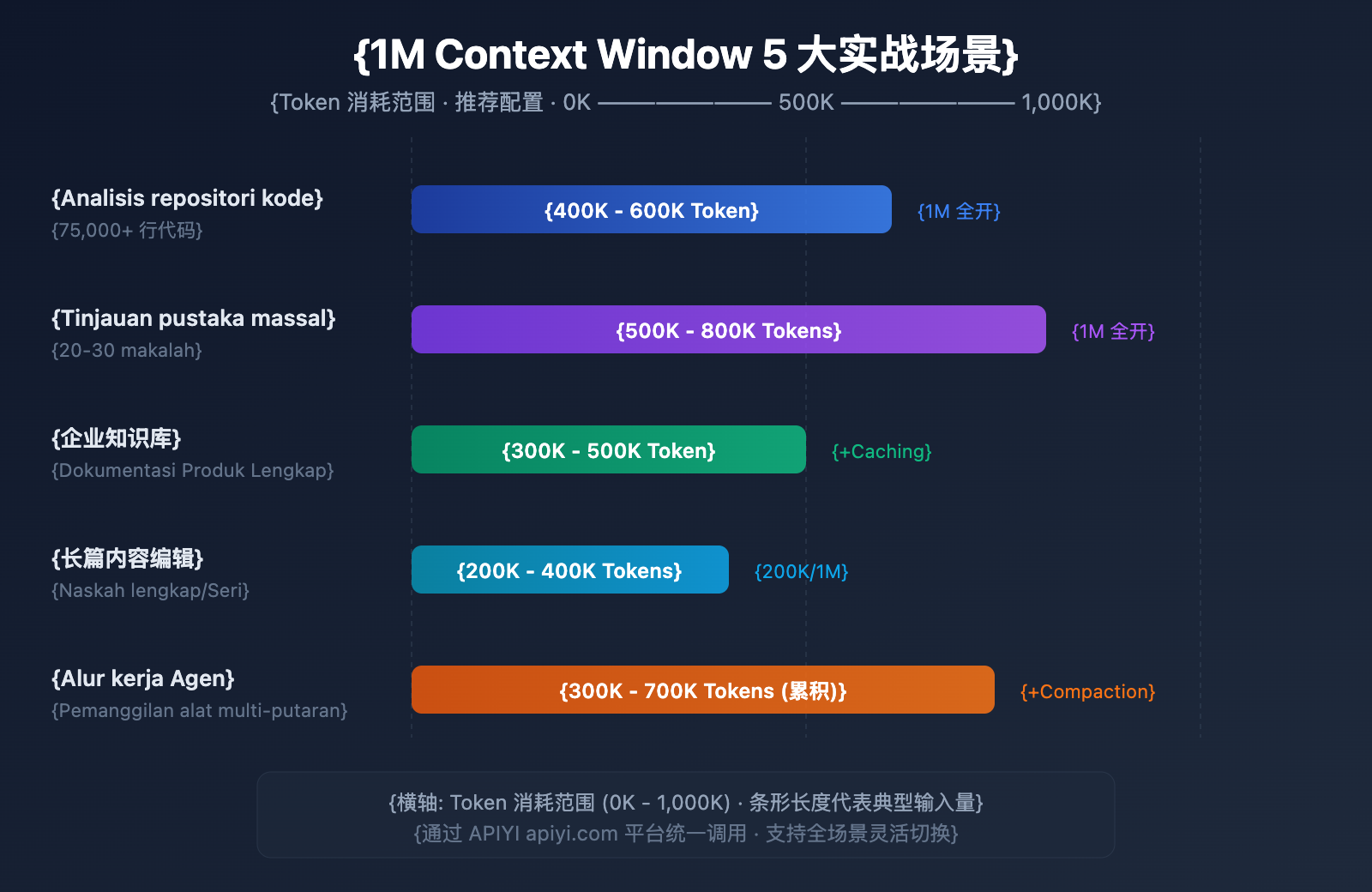

5 Skenario Praktis Jendela Konteks Claude 4.6

Skenario 1: Analisis Seluruh Repositori Kode

Skala Input: 5-7,5 ribu baris kode (sekitar 400K-600K Token)

Ini adalah skenario yang paling diuntungkan dari jendela konteks 1M. Dengan mengirimkan seluruh kode sumber proyek sekaligus ke Claude Opus 4.6, Anda dapat melakukan:

- Tinjauan arsitektur global: Mengidentifikasi masalah desain lintas modul.

- Analisis ketergantungan: Menemukan ketergantungan melingkar dan kopling yang berlebihan.

- Pemindaian celah keamanan: Menemukan risiko keamanan lintas file dalam konteks yang lengkap.

- Saran refactoring: Memberikan solusi refactoring berdasarkan pemahaman menyeluruh terhadap sistem.

Dulu, saat menangani repositori kode besar, pengembang harus membagi kode menjadi beberapa bagian untuk dianalisis secara bertahap, yang mengakibatkan model tidak dapat memahami ketergantungan lintas file. Sekarang, Anda dapat langsung mengirimkan kode inti dari monorepo secara keseluruhan, membiarkan Claude memberikan saran layaknya seorang arsitek yang benar-benar memahami gambaran besarnya.

Skenario 2: Tinjauan Literatur Massal

Skala Input: 20-30 makalah penelitian (sekitar 500K-800K Token)

Peneliti dapat memasukkan puluhan makalah terkait sekaligus, membiarkan Claude melakukan:

- Analisis referensi silang: Mengidentifikasi hubungan kutipan dan konflik pendapat antar makalah.

- Ringkasan tren penelitian: Mengekstrak evolusi metodologi dari literatur dalam jumlah besar.

- Analisis Gap: Menemukan area kosong dalam penelitian yang ada.

- Bantuan meta-analisis: Membandingkan desain eksperimen dan hasil dari berbagai penelitian secara horizontal.

Bagi para peneliti, membaca 30 makalah secara manual bisa memakan waktu berminggu-minggu. Dengan bantuan jendela konteks 1M, penyaringan awal dan ekstraksi informasi kunci dapat diselesaikan dalam hitungan menit, sangat mempercepat efisiensi riset literatur.

Skenario 3: Basis Pengetahuan Perusahaan

Skala Input: Dokumentasi produk lengkap (sekitar 300K-500K Token)

Memuat seluruh dokumen internal perusahaan ke dalam konteks untuk mencapai:

- Jawaban presisi: Memberikan jawaban akurat berdasarkan seluruh basis dokumen.

- Korelasi lintas dokumen: Menemukan hubungan informasi di antara dokumen yang berbeda.

- Pembaruan real-time: Tidak perlu prapemrosesan vektorisasi, langsung gunakan dokumen terbaru.

- Penalaran multi-dokumen: Menjawab pertanyaan kompleks dengan mensintesis beberapa dokumen teknis.

Dibandingkan dengan solusi RAG (Retrieval-Augmented Generation) tradisional, solusi konteks penuh menghemat biaya teknis untuk vektorisasi, pembuatan indeks, dan penyetelan pengambilan (retrieval tuning). Untuk basis pengetahuan skala kecil hingga menengah dengan jumlah dokumen di bawah 1M Token, menggunakan konteks panjang secara langsung adalah solusi yang lebih sederhana dan efisien.

Skenario 4: Pembuatan dan Pengeditan Konten Panjang

Skala Input: Naskah buku lengkap atau seri artikel (sekitar 200K-400K Token)

- Tinjauan konsistensi: Memastikan logika konten panjang tetap konsisten dari awal hingga akhir.

- Penyatuan gaya: Menjaga gaya bahasa tetap konsisten dalam konteks yang lengkap.

- Optimasi struktur: Memberikan saran penyesuaian bab berdasarkan pemahaman seluruh teks.

- Standardisasi istilah: Menyeragamkan penggunaan istilah profesional di seluruh buku.

Sebagai contoh, sebuah buku teknis dengan 200 ribu kata setara dengan sekitar 300K Token, yang sepenuhnya dapat ditinjau oleh Claude dalam satu permintaan untuk menunjukkan bagian-bagian yang kontradiktif atau tidak konsisten.

Skenario 5: Alur Kerja Agent yang Kompleks

Skala Input: Riwayat pemanggilan alat multi-putaran (akumulasi 300K-700K Token)

Bekerja sama dengan fitur Agent Teams dari Claude 4.6:

- Penalaran rantai panjang: Mempertahankan rantai penalaran yang lengkap dalam tugas multi-langkah yang kompleks.

- Memori pemanggilan alat: Mengingat semua hasil pemanggilan alat historis.

- Kombinasi dengan Compaction: Mengompresi konteks secara otomatis untuk alur kerja yang sangat panjang.

- Kolaborasi multi-Agent: Berbagi informasi konteks di dalam Agent Teams.

Alur kerja Agent adalah salah satu skenario penggunaan inti Claude Opus 4.6. Saat menjalankan tugas kompleks (seperti tinjauan kode otomatis atau pipa analisis data), Agent mungkin perlu memanggil alat puluhan kali, di mana input dan output dari setiap pemanggilan akan terakumulasi dalam konteks. Jendela 1M memastikan bahwa bahkan dalam tugas yang berjalan lama, Agent tidak akan "melupakan" informasi kunci dari tahap awal.

🎯 Saran Praktis: Kelima skenario di atas dapat diverifikasi efektivitasnya dengan cepat melalui platform APIYI apiyi.com. Platform ini mendukung berbagai Model Bahasa Besar utama termasuk Claude Opus 4.6, menyediakan pengalaman pemanggilan antarmuka yang seragam, sehingga memudahkan peralihan fleksibel antar skenario yang berbeda.

Perbandingan Jendela Konteks Claude 4.6 dengan Kompetitor

Memahami daya saing Claude Opus 4.6 di bidang konteks panjang akan membantu Anda membuat pilihan teknis yang lebih tepat:

| Model | Jendela Konteks | Output Maksimum | Performa Pengambilan Konteks Panjang | Harga (Input/Output) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

Terlihat bahwa Claude Opus 4.6 memiliki keunggulan nyata dalam akurasi pengambilan konteks panjang. Meskipun harganya lebih tinggi, keandalannya jauh melampaui kompetitor dalam skenario yang membutuhkan pengambilan data presisi dan penalaran kompleks.

💡 Saran Pemilihan: Model mana yang dipilih sangat bergantung pada kebutuhan skenario spesifik Anda. Jika Anda memprioritaskan kualitas penalaran dalam konteks panjang, Claude Opus 4.6 adalah pilihan terbaik saat ini. Kami menyarankan untuk melakukan pengujian praktis melalui platform APIYI apiyi.com, yang mendukung pemanggilan antarmuka terpadu untuk berbagai model populer di atas, sehingga memudahkan peralihan dan evaluasi cepat.

Konfigurasi Compaction Jendela Konteks Claude 4.6

Compaction adalah fitur kompresi konteks sisi server yang baru ditambahkan pada Claude Opus 4.6, yang secara teoritis memungkinkan percakapan berlanjut tanpa batas.

Cara Kerja

- API memantau penggunaan Token di setiap putaran percakapan.

- Saat Token input melebihi ambang batas yang ditentukan, ringkasan akan dipicu secara otomatis.

- Model menghasilkan ringkasan percakapan yang dibungkus dalam tag

<summary>. - Ringkasan menggantikan konten percakapan awal untuk membebaskan ruang konteks.

Metode Konfigurasi

Tambahkan parameter compaction_control dalam permintaan API:

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # Ambang batas pemicu

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Strategi Kombinasi Compaction dengan Konteks 1M

| Strategi | Jendela Konteks | Compaction | Skenario Penggunaan |

|---|---|---|---|

| Analisis Sekali Jalan Skala Besar | 1M (Aktif Penuh) | Nonaktif | Tinjauan kode, tinjauan pustaka |

| Percakapan Jangka Panjang | 200K (Default) | Aktif | Layanan pelanggan, asisten, Agent |

| Mode Campuran | 1M + Compaction | Aktif | Alur kerja Agent yang sangat kompleks |

Pertanyaan Umum

Q1: Apakah jendela konteks Claude 4.6 secara default adalah 1M?

Tidak. Jendela konteks default Claude Opus 4.6 masih 200K Token, sama dengan generasi sebelumnya Opus 4.5. Untuk menggunakan jendela konteks 1M Token, kamu perlu menambahkan Header anthropic-beta: context-1m-2025-08-07 dalam permintaan API. Selain itu, organisasi kamu harus mencapai Usage Tier 4 atau memiliki batas kecepatan (rate limit) khusus. Saat memanggil melalui platform APIYI (apiyi.com), kamu bisa dengan mudah menambahkan Header ini dalam permintaan.

Q2: Apakah ada biaya tambahan untuk menggunakan jendela konteks 1M?

Ya, ada penetapan harga bertingkat. Ketika permintaan melebihi 200K Token, harga input naik dari $5/M menjadi $10/M (2 kali lipat), dan harga output naik dari $25/M menjadi $37.50/M (1,5 kali lipat). Untuk proyek yang sensitif terhadap anggaran, disarankan untuk mendapatkan paket harga yang lebih menguntungkan melalui platform APIYI (apiyi.com).

Q3: Bisakah informasi spesifik ditemukan secara akurat dalam konteks 1M?

Claude Opus 4.6 menunjukkan performa luar biasa dalam benchmark MRCR v2. Dalam skenario pengujian yang menyembunyikan 8 informasi kunci dalam konteks 1M Token, tingkat akurasinya mencapai 76%, sekitar 4 kali lipat dari Sonnet 4.5 (18,5%). Dalam konteks 256K, akurasinya bahkan mencapai 93%. Ini berarti Claude Opus 4.6 adalah salah satu model paling andal untuk pengambilan informasi dalam konteks panjang (long context retrieval) saat ini.

Q4: Apakah Compaction akan memengaruhi kualitas jawaban?

Compaction bekerja dengan meringkas konten percakapan awal secara cerdas, sehingga dalam kebanyakan skenario tidak akan memengaruhi kualitas jawaban secara signifikan. Namun, untuk skenario yang membutuhkan kutipan detail dari percakapan awal secara presisi, disarankan untuk menonaktifkan Compaction dan langsung menggunakan jendela konteks 1M. Dalam alur kerja Agent, Compaction dapat meningkatkan efisiensi secara signifikan, jadi sangat direkomendasikan untuk diaktifkan.

Q5: Model Claude mana saja yang mendukung konteks 1M?

Saat ini ada 3 model Claude yang mendukung jendela konteks 1M Token: Claude Opus 4.6, Claude Sonnet 4.5, dan Claude Sonnet 4. Di antaranya, akurasi pengambilan konteks panjang Opus 4.6 jauh lebih tinggi daripada seri Sonnet. Model lain seperti seri Claude Haiku saat ini belum mendukung konteks 1M.

Ringkasan

Jendela konteks 1M Token pada Claude Opus 4.6 merupakan peningkatan kemampuan yang penting, menggabungkan kemampuan penalaran yang kuat dari model unggulan Opus dengan konteks super besar. Ini membuka berbagai skenario aplikasi bernilai tinggi seperti analisis seluruh repositori kode, tinjauan pustaka massal, hingga tanya jawab basis pengetahuan perusahaan.

Tinjauan poin-poin utama:

- Default 200K, Beta diperluas hingga 1M: Perlu menambahkan Header

anthropic-beta: context-1m-2025-08-07 - Akurasi pengambilan konteks panjang terdepan di industri: Benchmark MRCR v2 mencapai 76% (1M) / 93% (256K)

- Penetapan harga bertingkat: Bagian yang melebihi 200K dikenakan harga input 2x dan harga output 1,5x

- Dukungan Compaction untuk percakapan tanpa batas: Kompresi konteks otomatis di sisi server, cocok untuk alur kerja Agent

- Didukung oleh 3 model: Opus 4.6, Sonnet 4.5, Sonnet 4

Kami merekomendasikan untuk mencoba kemampuan konteks panjang Claude Opus 4.6 dengan cepat melalui APIYI (apiyi.com). Platform ini mendukung pemanggilan berbagai Model Bahasa Besar populer melalui satu antarmuka terpadu, membantu pengembang menyelesaikan verifikasi teknis dan integrasi produk secara efisien.

Artikel ini ditulis oleh Tim APIYI, yang berfokus pada berbagi teknologi Model Bahasa Besar AI. Untuk tutorial lebih lanjut dan panduan penggunaan API, silakan kunjungi Pusat Bantuan APIYI: help.apiyi.com

Referensi

-

Blog Resmi Anthropic – Memperkenalkan Claude Opus 4.6

- Tautan:

anthropic.com/news/claude-opus-4-6 - Deskripsi: Pengumuman rilis Claude Opus 4.6 dan pengenalan fitur-fitur utamanya

- Tautan:

-

Dokumentasi API Claude – Context Windows

- Tautan:

platform.claude.com/docs/en/build-with-claude/context-windows - Deskripsi: Panduan konfigurasi dan penggunaan context window

- Tautan:

-

Dokumentasi API Claude – Compaction

- Tautan:

platform.claude.com/docs/en/build-with-claude/compaction - Deskripsi: Penjelasan mendalam tentang fitur kompresi konteks (Compaction)

- Tautan:

-

Dokumentasi API Claude – Harga

- Tautan:

platform.claude.com/docs/en/about-claude/pricing - Deskripsi: Penjelasan mengenai harga model dan harga untuk konteks panjang

- Tautan: