¿Quieres analizar un repositorio de código completo o procesar cientos de páginas de documentación técnica de una sola vez, pero siempre te quedas corto por el límite de la ventana de contexto? Claude Opus 4.6 trae una ventana de contexto masiva de 1 millón de tokens, el primer gran salto de la serie Opus: equivale a procesar unas 750,000 palabras de texto en una sola pasada.

Valor principal: Al terminar de leer este artículo, aprenderás a activar la ventana de contexto de 1M de tokens de Claude 4.6, entenderás la estrategia de precios para contextos largos y dominarás 5 aplicaciones prácticas de alto valor.

Resumen de parámetros clave de la ventana de contexto de Claude 4.6

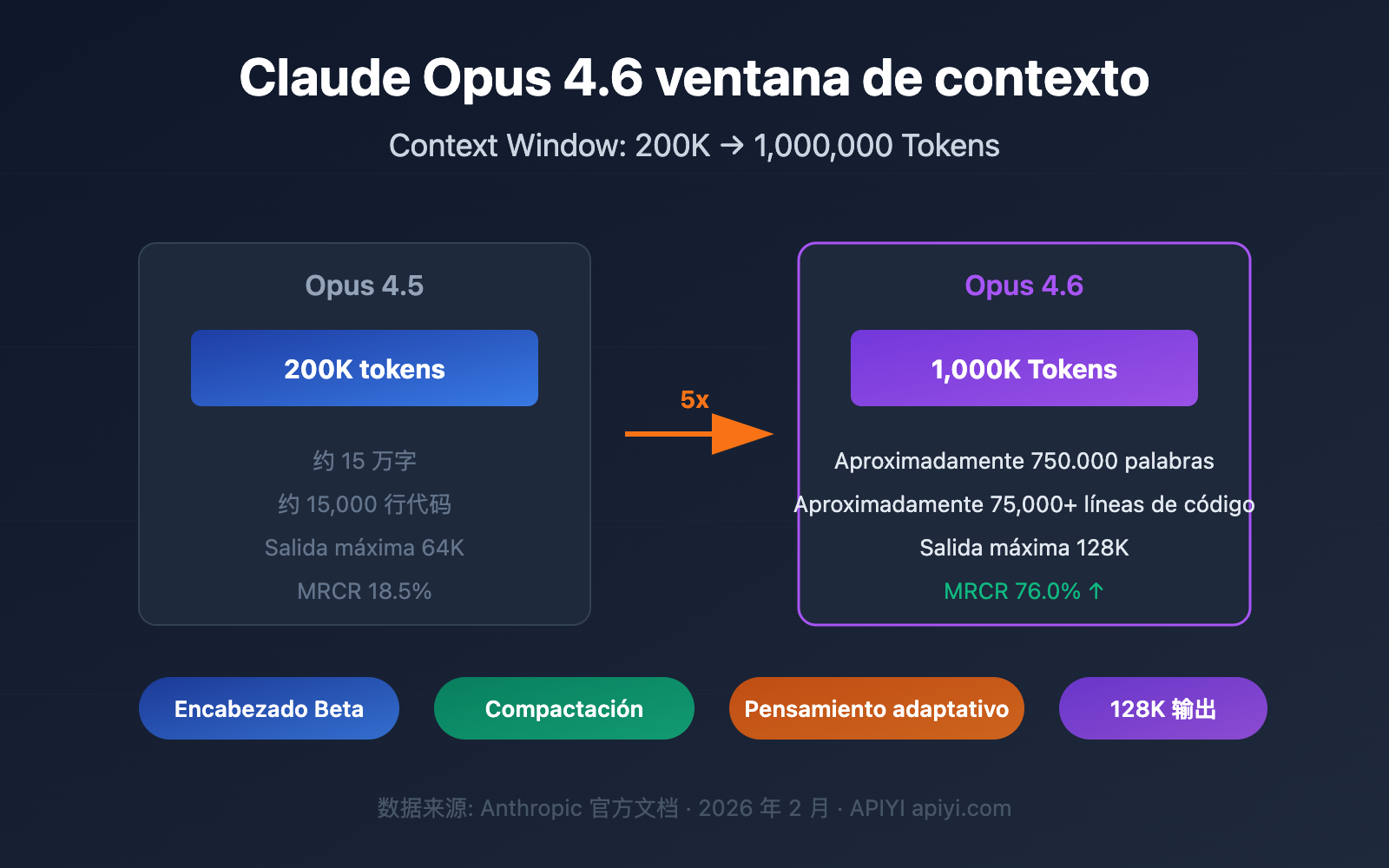

Claude Opus 4.6, lanzado el 5 de febrero de 2026, presenta como mejora más destacada la expansión masiva de su ventana de contexto. Estos son los parámetros principales:

| Parámetro | Claude Opus 4.6 | Generación anterior Opus 4.5 | Mejora |

|---|---|---|---|

| Ventana de contexto predeterminada | 200K Tokens | 200K Tokens | Igual |

| Ventana extendida Beta | 1,000K (1M) Tokens | No soportado | Soportado por primera vez |

| Máximo de tokens de salida | 128K Tokens | 64K Tokens | Incremento de 2x |

| Benchmark MRCR v2 (1M) | 76.0% | 18.5% | Incremento de aprox. 4x |

| Benchmark MRCR v2 (256K) | 93.0% | — | Precisión extremadamente alta |

| Modo de pensamiento recomendado | Adaptive Thinking | — | Nueva característica |

🎯 Información clave: La ventana de contexto de 1M de Claude Opus 4.6 se encuentra actualmente en fase Beta y requiere activarse mediante un encabezado (header) de API específico. Por defecto, se sigue utilizando la ventana de 200K. A través de la plataforma APIYI (apiyi.com), puedes probar rápidamente el rendimiento del modelo con diferentes longitudes de contexto.

3 avances clave en la ventana de contexto de Claude 4.6

Avance 1: La serie Opus admite por primera vez 1M de contexto

Antes de Claude Opus 4.6, la ventana de contexto de 1 millón de tokens solo estaba disponible para los modelos de la serie Sonnet (Sonnet 4 y Sonnet 4.5). Opus 4.6 es el primer modelo insignia de la serie Opus en admitir un contexto de 1M, lo que significa que ahora puedes combinar la potente capacidad de razonamiento de Opus con una ventana de contexto masiva.

Para que te hagas una idea, 1M de tokens equivale aproximadamente a:

| Tipo de contenido | Capacidad | Escenario típico |

|---|---|---|

| Texto plano | Aprox. 750,000 palabras | Biblioteca completa de documentación técnica |

| Código | Aprox. 75,000+ líneas | Repositorio de código completo |

| Documentos PDF | Decenas de artículos de investigación | Revisión bibliográfica masiva |

| Historial de chat | Cientos de turnos de conversación | Mantenimiento de sesiones ultra largas |

Avance 2: La precisión de recuperación en contextos largos se dispara

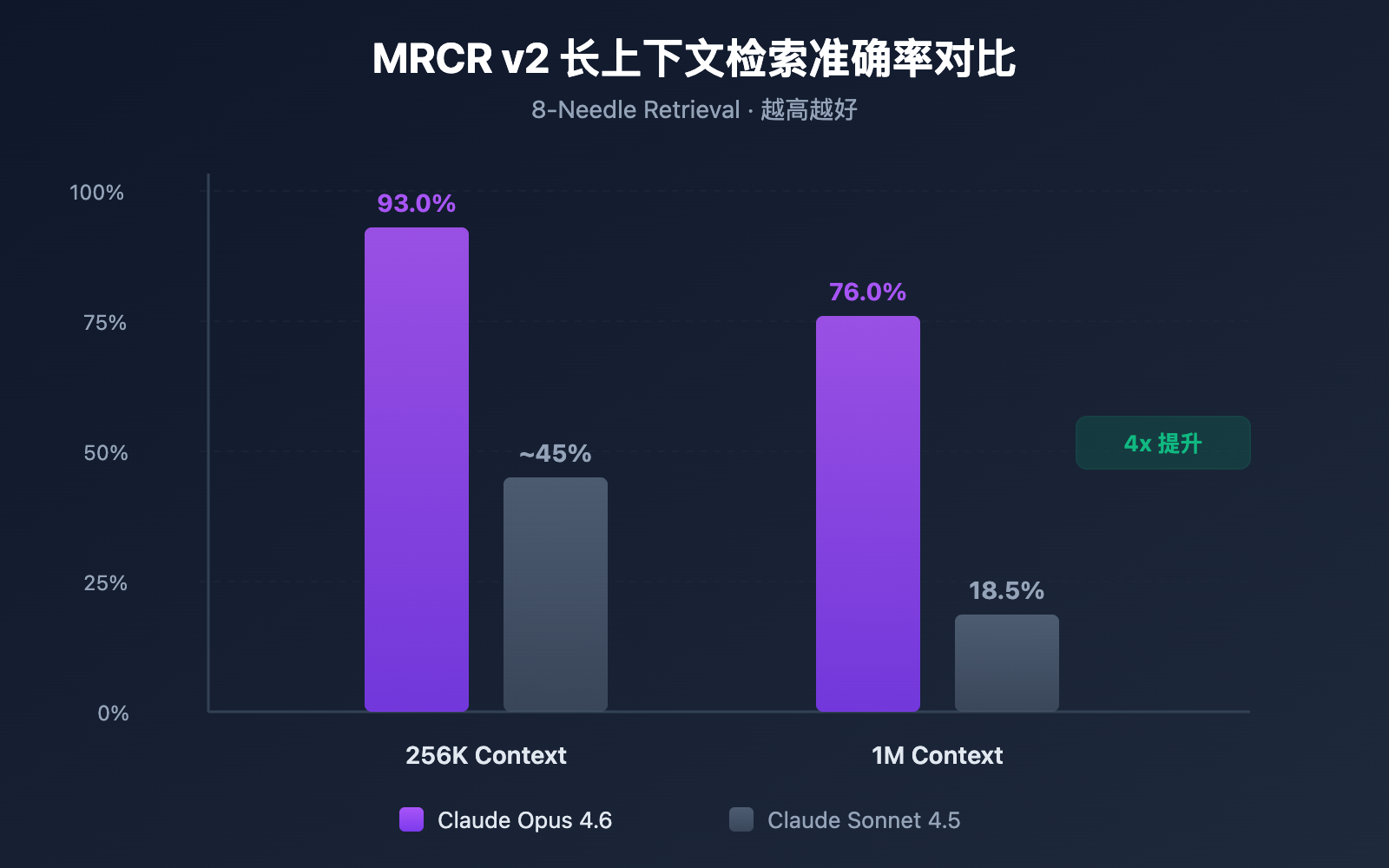

Una cosa es tener una ventana de contexto grande y otra muy distinta es poder encontrar información con precisión dentro de ella. Claude Opus 4.6 ha demostrado un rendimiento asombroso en el benchmark MRCR v2 (Multi-needle Retrieval with Contextual Reasoning):

- Contexto de 256K tokens: Precisión del 93.0%

- Contexto de 1M tokens (8 agujas): Precisión del 76.0%

MRCR v2 es una prueba tipo "aguja en un pajar", donde se esconden 8 piezas clave de información en un texto de 1 millón de tokens y se le pide al modelo que las encuentre todas. La precisión del 76% de Claude Opus 4.6 representa un salto cualitativo frente al 18.5% de Sonnet 4.5, mejorando la fiabilidad entre 4 y 9 veces.

Avance 3: El mecanismo de Compaction permite conversaciones infinitas

Claude Opus 4.6 introduce Compaction (compresión de contexto), una función de resumen automático de contexto en el lado del servidor:

- Cuando la conversación se acerca al límite de la ventana de contexto, la API resume automáticamente el contenido más antiguo.

- No es necesario gestionar el contexto manualmente, ni usar ventanas deslizantes o estrategias de truncado.

- Teóricamente, permite conversaciones de longitud infinita.

Esto es especialmente valioso para los flujos de trabajo de Agentes: en escenarios que implican múltiples llamadas a herramientas y cadenas de razonamiento largas, Compaction puede reducir significativamente la carga de mantenimiento del estado de la conversación.

Cómo activar la ventana de contexto de Claude 4.6

Paso 1: Confirmar elegibilidad de la cuenta

La ventana de contexto de 1M de tokens es actualmente una función Beta, disponible solo para:

- Organizaciones en el Usage Tier 4 o superior.

- Organizaciones con límites de velocidad personalizados.

Puedes consultar tu nivel de Usage Tier actual en la Anthropic Console.

Paso 2: Añadir el Beta Header

Para habilitar la ventana de contexto de 1M, debes añadir un encabezado Beta específico en tu solicitud a la API:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Llamada a través de la interfaz unificada de APIYI

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "Analiza el siguiente repositorio de código completo..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

Si utilizas directamente el SDK de Anthropic, la solicitud curl correspondiente sería:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "Tu contenido de texto ultra largo..."}

]

}'

🚀 Inicio rápido: Te recomendamos usar la plataforma APIYI (apiyi.com) para probar rápidamente las capacidades de contexto largo de Claude Opus 4.6. La plataforma ofrece una interfaz de API unificada, eliminando la necesidad de conectar con múltiples proveedores por separado, y permite completar la integración en solo 5 minutos.

Paso 3: Verificar la ventana de contexto

Tras enviar la solicitud, puedes confirmar la cantidad de tokens utilizados mediante el campo usage en la respuesta:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

Si input_tokens supera los 200,000 y la solicitud tiene éxito, significa que la ventana de contexto de 1M se ha habilitado correctamente.

Ver ejemplo completo de código en Python (con estadísticas de tokens)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

# Leer un archivo de repositorio de código grande

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"Longitud del contenido de entrada: {len(codebase_content)} caracteres")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "Eres un experto senior en revisión de código, por favor analiza todo el repositorio."

},

{

"role": "user",

"content": f"Por favor, analiza el diseño de la arquitectura y los problemas potenciales del siguiente repositorio:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"Tokens de entrada: {response.usage.prompt_tokens}")

print(f"Tokens de salida: {response.usage.completion_tokens}")

print(f"\nResultado del análisis:\n{response.choices[0].message.content}")

Detalles de precios de la ventana de contexto de Claude 4.6

El uso de la ventana de contexto de 1M implica un mecanismo de precios escalonado. Cuando la solicitud supera los 200K tokens, se cambia automáticamente al precio de contexto largo:

| Nivel de precio | Precio de entrada (por millón de tokens) | Precio de salida (por millón de tokens) | Ámbito de aplicación |

|---|---|---|---|

| Precio estándar | $5.00 | $25.00 | ≤ 200K tokens |

| Precio de contexto largo | $10.00 | $37.50 | > 200K tokens |

| Multiplicador de precio | 2x | 1.5x | Aplicación automática |

Ejemplo de cálculo de precios

Supongamos que envías una solicitud de análisis de texto largo de 500K tokens, con una salida de 4,000 tokens:

- Costo de entrada: 500K × ($10.00 / 1M) = $5.00

- Costo de salida: 4K × ($37.50 / 1M) = $0.15

- Costo total por solicitud: $5.15

💰 Sugerencia de optimización de costos: Para proyectos que requieren el uso frecuente de contextos largos, puedes llamar a la API de Claude Opus 4.6 a través de la plataforma APIYI (apiyi.com). La plataforma ofrece métodos de facturación flexibles y precios más competitivos, ayudando a equipos pequeños y medianos a controlar los costos de manera efectiva.

Aprovecha el Context Caching para reducir costos

Si tu caso de uso implica consultas repetidas sobre el mismo conjunto de documentos (como aplicaciones de "chat con documentos"), puedes utilizar la función de Context Caching:

- La primera carga del documento se factura al precio estándar.

- Las consultas posteriores basadas en el contenido en caché disfrutan de un precio con descuento.

- Ideal para escenarios de alta frecuencia como análisis de documentos por lotes y preguntas y respuestas en bases de conocimientos.

Mejores prácticas de control de costos para la ventana de contexto de Claude 4.6

| Estrategia de optimización | Descripción | Ahorro estimado |

|---|---|---|

| Usar 1M bajo demanda | Activar el Beta Header solo cuando realmente se necesite un contexto extralargo | Evita el recargo de 2x en la entrada |

| Context Caching | Usar caché para documentos consultados repetidamente | 40-60% del costo de entrada |

| Prefiltrar la entrada | Eliminar contenido irrelevante (comentarios, líneas vacías, etc.) antes de subir | 10-30% del consumo de tokens |

| Estrategia por niveles | Usar Sonnet para tareas simples y Opus para tareas complejas | Reducción del costo total de más del 50% |

| Control de longitud de salida | Configurar un max_tokens razonable para evitar salidas redundantes |

Reduce los gastos de salida |

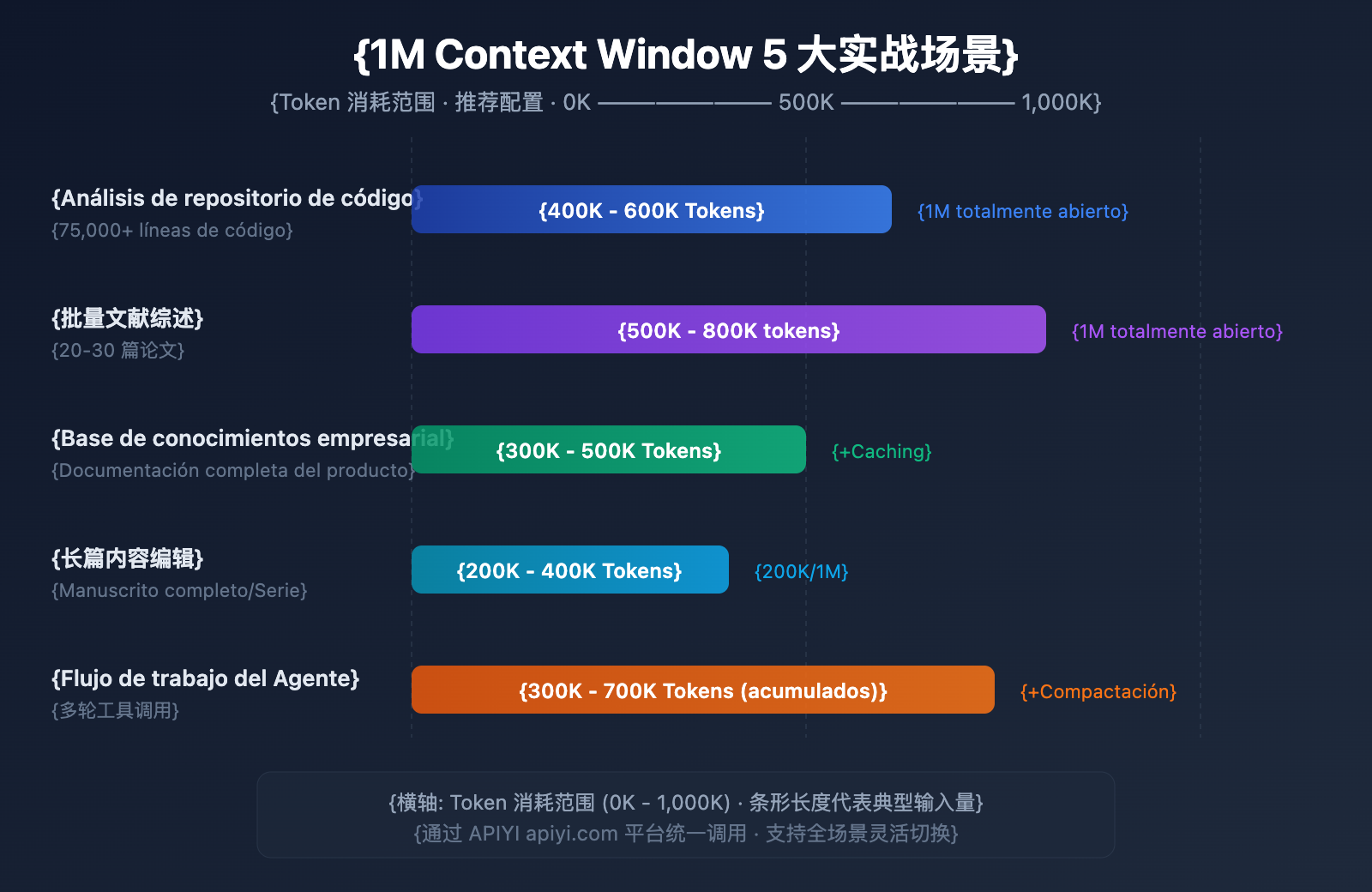

5 escenarios reales para la ventana de contexto de Claude 4.6

Escenario 1: Análisis de repositorio de código completo

Escala de entrada: 50,000-75,000 líneas de código (aprox. 400K-600K tokens)

Este es el escenario que más se beneficia directamente de la ventana de contexto de 1M. Al enviar todo el código fuente de un proyecto a Claude Opus 4.6 de una sola vez, puedes lograr:

- Revisión de arquitectura global: Identificar problemas de diseño que afectan a varios módulos.

- Análisis de dependencias: Encontrar dependencias circulares y acoplamiento excesivo.

- Escaneo de vulnerabilidades de seguridad: Descubrir riesgos de seguridad entre archivos dentro de un contexto completo.

- Sugerencias de refactorización: Ofrecer planes de refactorización basados en una comprensión global del sistema.

Antes, al trabajar con grandes repositorios de código, los desarrolladores tenían que dividir el código en fragmentos para analizarlo paso a paso, lo que impedía que el modelo entendiera las dependencias entre archivos. Ahora, puedes enviar directamente el código principal de un monorepo y dejar que Claude actúe como un arquitecto que realmente entiende todo el sistema.

Escenario 2: Revisión bibliográfica por lotes

Escala de entrada: 20-30 artículos académicos (aprox. 500K-800K tokens)

Los investigadores pueden introducir decenas de artículos relacionados a la vez para que Claude realice:

- Análisis de referencias cruzadas: Identificar relaciones de citas y conflictos de opinión entre artículos.

- Resumen de tendencias de investigación: Extraer la evolución de las metodologías a partir de una gran cantidad de literatura.

- Análisis de brechas (Gap Analysis): Descubrir áreas vacías en la investigación actual.

- Asistencia en metanálisis: Comparar horizontalmente el diseño experimental y los resultados de diferentes estudios.

Para los investigadores, leer manualmente 30 artículos puede llevar semanas. Con la ventana de contexto de 1M, el filtrado inicial y la extracción de información clave se pueden completar en minutos, acelerando enormemente la eficiencia de la investigación bibliográfica.

Escenario 3: Preguntas y respuestas en bases de conocimientos empresariales

Escala de entrada: Biblioteca completa de documentación de producto (aprox. 300K-500K tokens)

Cargar todos los documentos internos de la empresa en el contexto permite:

- Respuestas precisas: Ofrecer respuestas exactas basadas en la biblioteca completa de documentos.

- Relación entre documentos: Descubrir conexiones de información entre diferentes archivos.

- Actualización en tiempo real: Sin necesidad de preprocesamiento de vectorización, utiliza directamente los documentos más recientes.

- Razonamiento multidocumento: Responder preguntas complejas integrando múltiples documentos técnicos.

En comparación con las soluciones tradicionales de RAG (Generación Aumentada por Recuperación), la solución de contexto completo ahorra los costos de ingeniería de vectorización, construcción de índices y optimización de búsqueda. Para bases de conocimientos pequeñas y medianas con un volumen de documentos inferior a 1M de tokens, usar directamente el contexto largo es una opción más sencilla y eficiente.

Escenario 4: Creación y edición de contenido extenso

Escala de entrada: Manuscritos completos o series de artículos (aprox. 200K-400K tokens)

- Revisión de consistencia: Asegurar que la lógica del contenido extenso sea coherente de principio a fin.

- Unificación de estilo: Mantener un estilo lingüístico constante en todo el contexto.

- Optimización de estructura: Sugerir ajustes de capítulos basados en la comprensión de todo el texto.

- Estandarización de términos: Unificar el uso de términos profesionales en todo el libro.

Por ejemplo, un libro técnico de 200,000 palabras equivale a unos 300K tokens; es totalmente posible pedirle a Claude que revise todo el manuscrito en una sola solicitud y señale las contradicciones.

Escenario 5: Flujos de trabajo de agentes complejos

Escala de entrada: Registros de múltiples llamadas a herramientas (acumulados 300K-700K tokens)

En combinación con la función Agent Teams de Claude 4.6:

- Razonamiento de cadena larga: Mantener una cadena de razonamiento completa en tareas complejas de varios pasos.

- Memoria de llamadas a herramientas: Recordar todos los resultados históricos de las llamadas a herramientas.

- Combinación con Compaction: Comprimir automáticamente el contexto en flujos de trabajo extralargos.

- Colaboración multi-agente: Compartir información de contexto dentro de los Agent Teams.

Los flujos de trabajo de agentes son uno de los escenarios de uso principales de Claude Opus 4.6. Al ejecutar tareas complejas (como revisión de código automatizada o pipelines de análisis de datos), un agente puede necesitar llamar a herramientas decenas de veces, y la entrada y salida de cada llamada se acumulan en el contexto. La ventana de 1M asegura que, incluso en tareas de larga duración, el agente no "olvide" la información clave inicial.

🎯 Sugerencia práctica: Los 5 escenarios anteriores se pueden validar rápidamente en la plataforma APIYI (apiyi.com). La plataforma admite varios modelos principales, incluido Claude Opus 4.6, ofreciendo una experiencia de llamada a la API unificada para facilitar el cambio flexible entre diferentes escenarios.

Ventana de contexto de Claude 4.6 y comparativa con la competencia

Conocer la competitividad de Claude Opus 4.6 en el ámbito del contexto largo te ayudará a tomar decisiones técnicas más fundamentadas:

| Modelo | Ventana de contexto | Salida máxima | Rendimiento de recuperación en contexto largo | Precio (Entrada/Salida) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

Como se puede observar, Claude Opus 4.6 tiene una ventaja clara en la precisión de recuperación en contextos largos. Aunque el precio es más elevado, su fiabilidad supera con creces a la competencia en escenarios que requieren una recuperación precisa y un razonamiento complejo.

💡 Sugerencia de selección: La elección del modelo depende principalmente de las necesidades específicas de tu escenario. Si priorizas la calidad del razonamiento en contextos largos, Claude Opus 4.6 es actualmente la mejor opción. Recomendamos realizar pruebas comparativas reales a través de la plataforma APIYI (apiyi.com), que admite llamadas a interfaces unificadas para varios de los modelos principales mencionados, facilitando el cambio y la evaluación rápida.

Configuración de Compaction en la ventana de contexto de Claude 4.6

Compaction es una nueva función de compresión de contexto en el lado del servidor de Claude Opus 4.6, que permite que las conversaciones continúen, en teoría, de forma infinita.

Cómo funciona

- La API monitorea el uso de tokens en cada ronda de conversación.

- Cuando los tokens de entrada superan el umbral establecido, se activa automáticamente el resumen.

- El modelo genera un resumen de la conversación envuelto en etiquetas

<summary>. - El resumen reemplaza el contenido inicial de la conversación, liberando espacio en el contexto.

Método de configuración

Añade el parámetro compaction_control en la solicitud de la API:

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # Umbral de activación

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Estrategias de combinación entre Compaction y el contexto de 1M

| Estrategia | Ventana de contexto | Compaction | Escenario de aplicación |

|---|---|---|---|

| Análisis único masivo | 1M (Totalmente abierto) | Desactivado | Revisión de código, revisión de literatura |

| Conversación a largo plazo | 200K (Predeterminado) | Activado | Atención al cliente, asistentes, Agentes |

| Modo mixto | 1M + Compaction | Activado | Flujos de trabajo de Agentes ultra complejos |

Preguntas frecuentes

Q1: ¿La ventana de contexto de Claude 4.6 es de 1M por defecto?

No. La ventana de contexto predeterminada de Claude Opus 4.6 sigue siendo de 200K tokens, igual que la generación anterior Opus 4.5. Para utilizar la ventana de contexto de 1M de tokens, es necesario añadir el encabezado anthropic-beta: context-1m-2025-08-07 en la solicitud de la API. Además, tu organización debe alcanzar el Nivel de Uso 4 (Usage Tier 4) o contar con límites de velocidad personalizados. Al realizar llamadas a través de la plataforma APIYI (apiyi.com), puedes añadir este encabezado fácilmente en tus solicitudes.

Q2: ¿Tiene un coste adicional usar la ventana de contexto de 1M?

Sí, existe una tarificación por niveles. Cuando la solicitud supera los 200K tokens, el precio de entrada sube de 5 $/M a 10 $/M (el doble), y el precio de salida aumenta de 25 $/M a 37,50 $/M (1,5 veces). Para proyectos con presupuestos ajustados, se recomienda utilizar la plataforma APIYI (apiyi.com) para obtener planes de precios más competitivos.

Q3: ¿Se puede encontrar información específica con precisión en un contexto de 1M?

Claude Opus 4.6 ha demostrado un rendimiento excelente en el benchmark MRCR v2. En escenarios de prueba donde se ocultan 8 piezas clave de información dentro de un contexto de 1M de tokens, la precisión alcanza el 76%, lo que es aproximadamente 4 veces superior a la de Sonnet 4.5 (18,5%). En un contexto de 256K, la precisión llega incluso al 93%. Esto convierte a Claude Opus 4.6 en uno de los modelos más fiables actualmente para la recuperación de información en contextos largos.

Q4: ¿Afecta la «Compaction» a la calidad de las respuestas?

La función Compaction (compactación) utiliza resúmenes inteligentes para comprimir el contenido inicial de la conversación y, en la mayoría de los casos, no afecta significativamente a la calidad de las respuestas. Sin embargo, para escenarios que requieren citas exactas de detalles previos de la conversación, se recomienda desactivar la compactación y utilizar directamente la ventana de contexto de 1M. En flujos de trabajo de agentes (Agents), la compactación puede mejorar notablemente la eficiencia, por lo que se recomienda activarla.

Q5: ¿Qué modelos de Claude admiten el contexto de 1M?

Actualmente, hay 3 modelos de Claude que admiten la ventana de contexto de 1M de tokens: Claude Opus 4.6, Claude Sonnet 4.5 y Claude Sonnet 4. De estos, la precisión de recuperación en contextos largos de Opus 4.6 es muy superior a la de la serie Sonnet. Otros modelos, como la serie Claude Haiku, no admiten por el momento el contexto de 1M.

Resumen

La ventana de contexto de 1M de tokens de Claude Opus 4.6 representa una actualización de capacidades fundamental. Combina la potente capacidad de razonamiento del modelo insignia Opus con un contexto masivo, abriendo la puerta a aplicaciones de alto valor como el análisis de repositorios de código completos, revisiones bibliográficas masivas y sistemas de preguntas y respuestas sobre bases de conocimiento corporativas.

Repaso de los puntos clave:

- 200K por defecto, ampliable a 1M en Beta: Requiere añadir el encabezado

anthropic-beta: context-1m-2025-08-07. - Precisión líder en recuperación de contexto largo: 76% en el benchmark MRCR v2 (1M) / 93% (256K).

- Tarificación por niveles: La parte que exceda los 200K tiene un coste de entrada de 2x y de salida de 1,5x.

- Soporte de Compaction para conversaciones infinitas: Compresión automática del contexto en el lado del servidor, ideal para flujos de trabajo de agentes.

- 3 modelos compatibles: Opus 4.6, Sonnet 4.5 y Sonnet 4.

Te recomendamos probar las capacidades de contexto largo de Claude Opus 4.6 a través de APIYI (apiyi.com). La plataforma permite invocar múltiples modelos de IA líderes mediante una interfaz unificada, ayudando a los desarrolladores a completar validaciones técnicas e integraciones de productos de manera eficiente.

Este artículo ha sido escrito por el equipo de APIYI, enfocado en compartir tecnología de Modelos de Lenguaje Grande de IA. Para más tutoriales y guías de uso de la API, visita el centro de ayuda de APIYI: help.apiyi.com

Referencias

-

Blog oficial de Anthropic – Introducing Claude Opus 4.6

- Enlace:

anthropic.com/news/claude-opus-4-6 - Descripción: Anuncio del lanzamiento de Claude Opus 4.6 e introducción a sus características principales.

- Enlace:

-

Documentación de la API de Claude – Context Windows

- Enlace:

platform.claude.com/docs/en/build-with-claude/context-windows - Descripción: Guía de configuración y uso de las ventanas de contexto.

- Enlace:

-

Documentación de la API de Claude – Compaction

- Enlace:

platform.claude.com/docs/en/build-with-claude/compaction - Descripción: Explicación detallada de la función de compresión de contexto (Compaction).

- Enlace:

-

Documentación de la API de Claude – Pricing

- Enlace:

platform.claude.com/docs/en/about-claude/pricing - Descripción: Detalles sobre los precios del modelo y del contexto largo.

- Enlace: