전체 코드 저장소를 한 번에 분석하거나 수백 페이지의 기술 문서를 처리하고 싶은데, 항상 컨텍스트 창 제한 때문에 막히셨나요? Claude Opus 4.6이 100만 토큰의 초대형 컨텍스트 창을 선보였습니다. 이는 Opus 시리즈 모델 최초의 돌파구로, 한 번에 약 75만 자의 텍스트 내용을 처리할 수 있는 수준이에요.

핵심 가치: 이 글을 읽고 나면 Claude 4.6의 1M 토큰 컨텍스트 창을 활성화하는 방법, 긴 컨텍스트 요금 정책을 이해하고, 5가지 고부가가치 실전 활용 사례를 마스터할 수 있습니다.

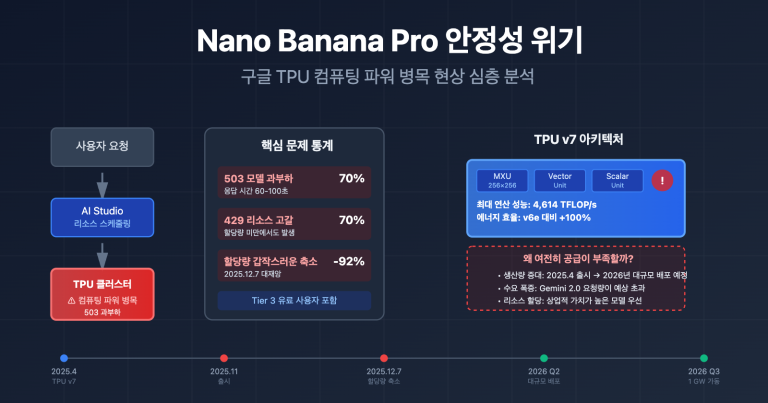

Claude 4.6 컨텍스트 창 핵심 파라미터 한눈에 보기

Claude Opus 4.6은 2026년 2월 5일에 출시되었으며, 가장 눈에 띄는 업그레이드는 바로 컨텍스트 창의 대폭적인 확장입니다. 주요 파라미터는 다음과 같습니다.

| 파라미터 항목 | Claude Opus 4.6 | 이전 세대 Opus 4.5 | 향상 폭 |

|---|---|---|---|

| 기본 컨텍스트 창 | 200K 토큰 | 200K 토큰 | 동일 |

| Beta 확장 창 | 1,000K (1M) 토큰 | 미지원 | 최초 지원 |

| 최대 출력 토큰 | 128K 토큰 | 64K 토큰 | 2배 향상 |

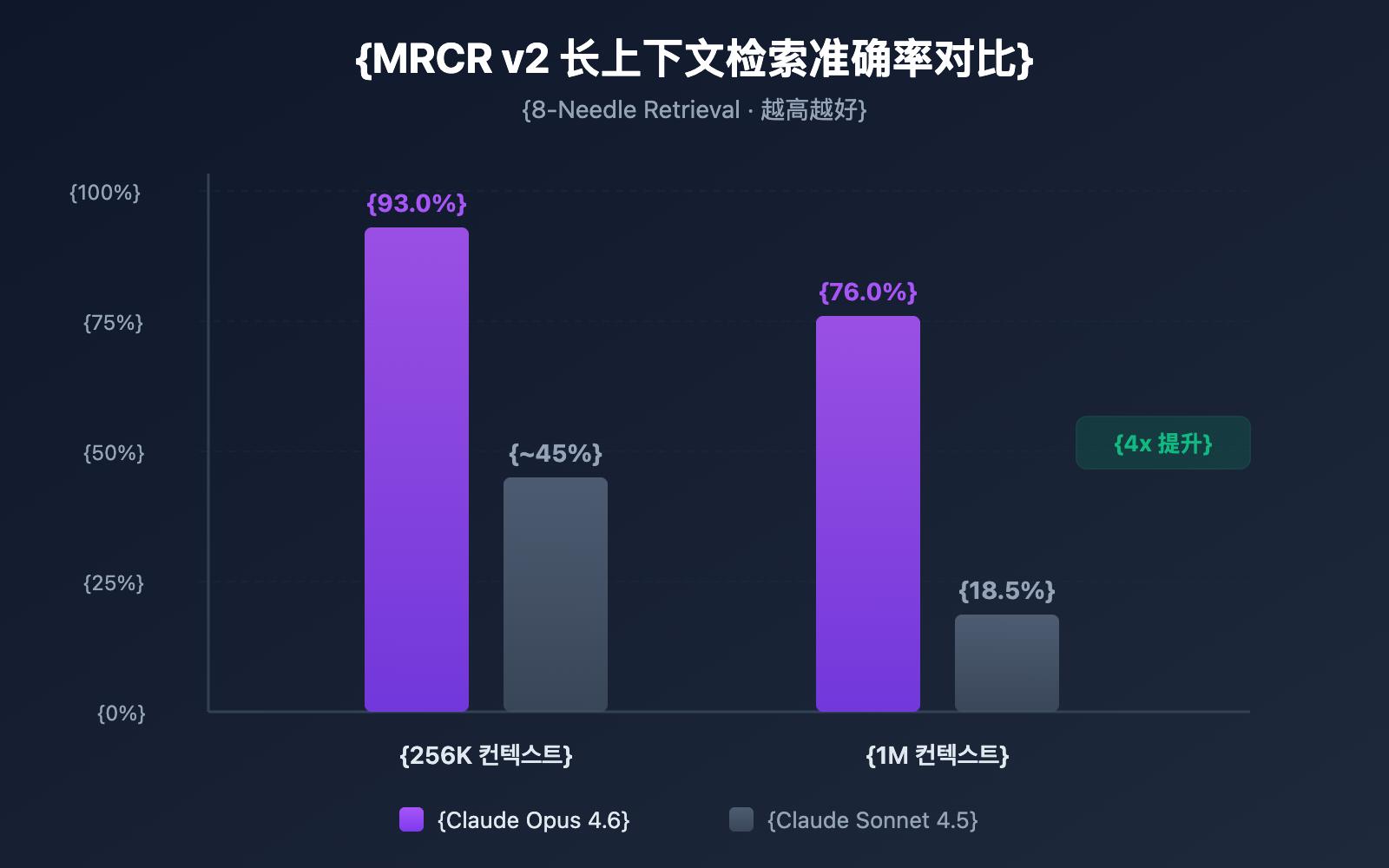

| MRCR v2 벤치마크 (1M) | 76.0% | 18.5% | 약 4배 향상 |

| MRCR v2 벤치마크 (256K) | 93.0% | — | 매우 높은 정확도 |

| 권장 사고 모드 | Adaptive Thinking | — | 신규 기능 |

🎯 핵심 정보: Claude Opus 4.6의 1M 컨텍스트 창은 현재 베타 단계이며, 특정 API 헤더를 통해 활성화해야 합니다. 기본적으로는 여전히 200K 컨텍스트 창을 사용해요. APIYI(apiyi.com) 플랫폼을 통해 다양한 컨텍스트 길이에서 모델의 성능을 빠르게 테스트해 볼 수 있습니다.

Claude 4.6 컨텍스트 윈도우의 3가지 핵심 돌파구

돌파구 1: Opus 시리즈 최초 1M 컨텍스트 지원

Claude Opus 4.6 이전에는 100만 토큰 컨텍스트 윈도우가 Sonnet 시리즈 모델(Sonnet 4 및 Sonnet 4.5)에만 개방되어 있었습니다. Opus 4.6은 1M 컨텍스트를 지원하는 최초의 Opus 플래그십 모델로, 이제 Opus의 강력한 추론 능력을 초대형 컨텍스트와 결합하여 사용할 수 있게 되었습니다.

구체적으로 1M 토큰은 대략 다음과 같은 양입니다:

| 콘텐츠 유형 | 수용 가능량 | 전형적인 시나리오 |

|---|---|---|

| 순수 텍스트 | 약 75만 자 | 전체 기술 문서 라이브러리 |

| 코드 | 약 75,000+ 라인 | 전체 코드 저장소 |

| PDF 문서 | 수십 편의 연구 논문 | 대량의 문헌 검토 |

| 대화 기록 | 수백 회의 대화 | 초장기 세션 유지 |

돌파구 2: 긴 컨텍스트 검색 정확도 급상승

컨텍스트 윈도우가 큰 것과 그 넓은 범위 내에서 정보를 정확하게 찾는 것은 별개의 문제입니다. Claude Opus 4.6은 MRCR v2(Multi-needle Retrieval with Contextual Reasoning) 벤치마크 테스트에서 놀라운 성능을 보여주었습니다:

- 256K 토큰 컨텍스트: 정확도 93.0% 달성

- 1M 토큰 컨텍스트 (8개 바늘): 정확도 76.0% 달성

MRCR v2는 일종의 '바늘 찾기' 테스트로, 100만 토큰의 텍스트 속에 숨겨진 8개의 핵심 정보를 모델이 모두 찾아내도록 요구합니다. Claude Opus 4.6의 76% 정확도는 Sonnet 4.5의 18.5%와 비교했을 때 질적으로 큰 도약을 이룬 것이며, 신뢰성이 약 4~9배 향상되었습니다.

돌파구 3: Compaction 메커니즘으로 구현된 무한 대화

Claude Opus 4.6은 서버 측 자동 컨텍스트 요약 기능인 Compaction(컨텍스트 압축) 메커니즘을 도입했습니다:

- 대화가 컨텍스트 윈도우 상한에 도달하면 API가 자동으로 이전 대화 내용을 요약합니다.

- 수동으로 컨텍스트를 관리하거나 슬라이딩 윈도우 또는 절단 전략을 사용할 필요가 없습니다.

- 이론적으로 무한한 길이의 대화를 지원합니다.

이는 에이전트(Agent) 워크플로우에서 특히 가치가 높습니다. 수많은 도구 호출과 긴 추론 체인이 포함된 시나리오에서 Compaction은 대화 상태 유지에 드는 비용을 획기적으로 줄여줍니다.

Claude 4.6 컨텍스트 윈도우 활성화 방법

1단계: 계정 자격 확인

1M 토큰 컨텍스트 윈도우는 현재 베타 기능으로, 다음 사용자에게만 개방되어 있습니다:

- Usage Tier 4 이상의 조직

- **커스텀 속도 제한(Custom Rate Limits)**을 보유한 조직

Anthropic Console에서 현재의 Usage Tier 등급을 확인할 수 있습니다.

2단계: Beta Header 추가

1M 컨텍스트 윈도우를 활성화하려면 API 요청 시 특정 Beta Header를 추가해야 합니다:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 통합 인터페이스를 통해 호출

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "다음 전체 코드 저장소를 분석해 주세요..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

Anthropic SDK를 직접 사용하는 경우, 해당 curl 요청은 다음과 같습니다:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "매우 긴 텍스트 내용..."}

]

}'

🚀 빠른 시작: Claude Opus 4.6의 긴 컨텍스트 능력을 빠르게 테스트하려면 APIYI(apiyi.com) 플랫폼을 추천합니다. 플랫폼에서 제공하는 통합 API 인터페이스를 통해 여러 서비스 제공업체를 일일이 연동할 필요 없이 5분 만에 통합을 완료할 수 있습니다.

3단계: 컨텍스트 윈도우 검증

요청을 보낸 후 반환되는 usage 필드를 통해 실제 사용된 토큰 수를 확인할 수 있습니다:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

input_tokens가 200,000을 초과했는데도 요청이 성공했다면, 1M 컨텍스트 윈도우가 올바르게 활성화된 것입니다.

전체 Python 코드 예시 보기 (토큰 통계 포함)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 통합 인터페이스

)

# 대규모 코드 저장소 파일 읽기

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"입력 내용 길이: {len(codebase_content)} 자")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "당신은 시니어 코드 리뷰 전문가입니다. 전체 코드 저장소를 분석해 주세요."

},

{

"role": "user",

"content": f"다음 코드 저장소의 아키텍처 설계와 잠재적인 문제를 분석해 주세요:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"입력 토큰: {response.usage.prompt_tokens}")

print(f"출력 토큰: {response.usage.completion_tokens}")

print(f"\n분석 결과:\n{response.choices[0].message.content}")

Claude 4.6 컨텍스트 윈도우 요금 체계 상세 안내

1M 컨텍스트 윈도우를 사용할 때는 계층별 요금 체계가 적용됩니다. 요청 토큰이 200K를 초과하면 자동으로 롱 컨텍스트(Long Context) 요금으로 전환돼요.

| 요금 계층 | 입력 비용 (100만 토큰당) | 출력 비용 (100만 토큰당) | 적용 범위 |

|---|---|---|---|

| 표준 요금 | $5.00 | $25.00 | ≤ 200K 토큰 |

| 롱 컨텍스트 요금 | $10.00 | $37.50 | > 200K 토큰 |

| 가격 배수 | 2배 | 1.5배 | 자동 적용 |

요금 계산 예시

500K 토큰의 긴 텍스트 분석 요청을 보내고, 4,000 토큰을 출력한다고 가정해 보겠습니다.

- 입력 비용: 500K × ($10.00 / 1M) = $5.00

- 출력 비용: 4K × ($37.50 / 1M) = $0.15

- 1회 요청 총 비용: $5.15

💰 비용 최적화 팁: 롱 컨텍스트를 빈번하게 사용해야 하는 프로젝트라면, APIYI apiyi.com 플랫폼을 통해 Claude Opus 4.6 API를 호출해 보세요. 유연한 과금 방식과 더 저렴한 가격을 제공하여 중소 규모 팀이 비용을 효율적으로 관리할 수 있도록 도와줍니다.

Context Caching을 활용한 비용 절감

동일한 문서 세트를 반복해서 쿼리해야 하는 경우(예: '문서와 대화하기' 앱), Context Caching 기능을 활용하면 좋습니다.

- 첫 문서 업로드 시에는 표준 요금이 적용됩니다.

- 이후 캐시된 내용을 기반으로 한 쿼리는 할인된 가격으로 이용할 수 있어요.

- 대량의 문서 분석, 지식 베이스 Q&A 등 사용 빈도가 높은 시나리오에 적합합니다.

Claude 4.6 컨텍스트 윈도우 비용 관리 베스트 프랙티스

| 최적화 전략 | 설명 | 예상 절감액 |

|---|---|---|

| 필요할 때만 1M 사용 | 초장문 컨텍스트가 정말 필요한 경우에만 Beta Header 활성화 | 입력 비용 2배 할증 방지 |

| Context Caching | 반복 쿼리되는 문서에 캐시 사용 | 입력 비용의 40~60% |

| 입력 데이터 사전 필터링 | 업로드 전 불필요한 내용(주석, 공백 등) 제거 | 토큰 소모량 10~30% |

| 계층화 전략 | 단순 작업은 Sonnet, 복잡한 작업은 Opus 사용 | 전체 비용 50% 이상 절감 |

| 출력 길이 제어 | 적절한 max_tokens 설정으로 불필요한 출력 방지 | 출력 비용 감소 |

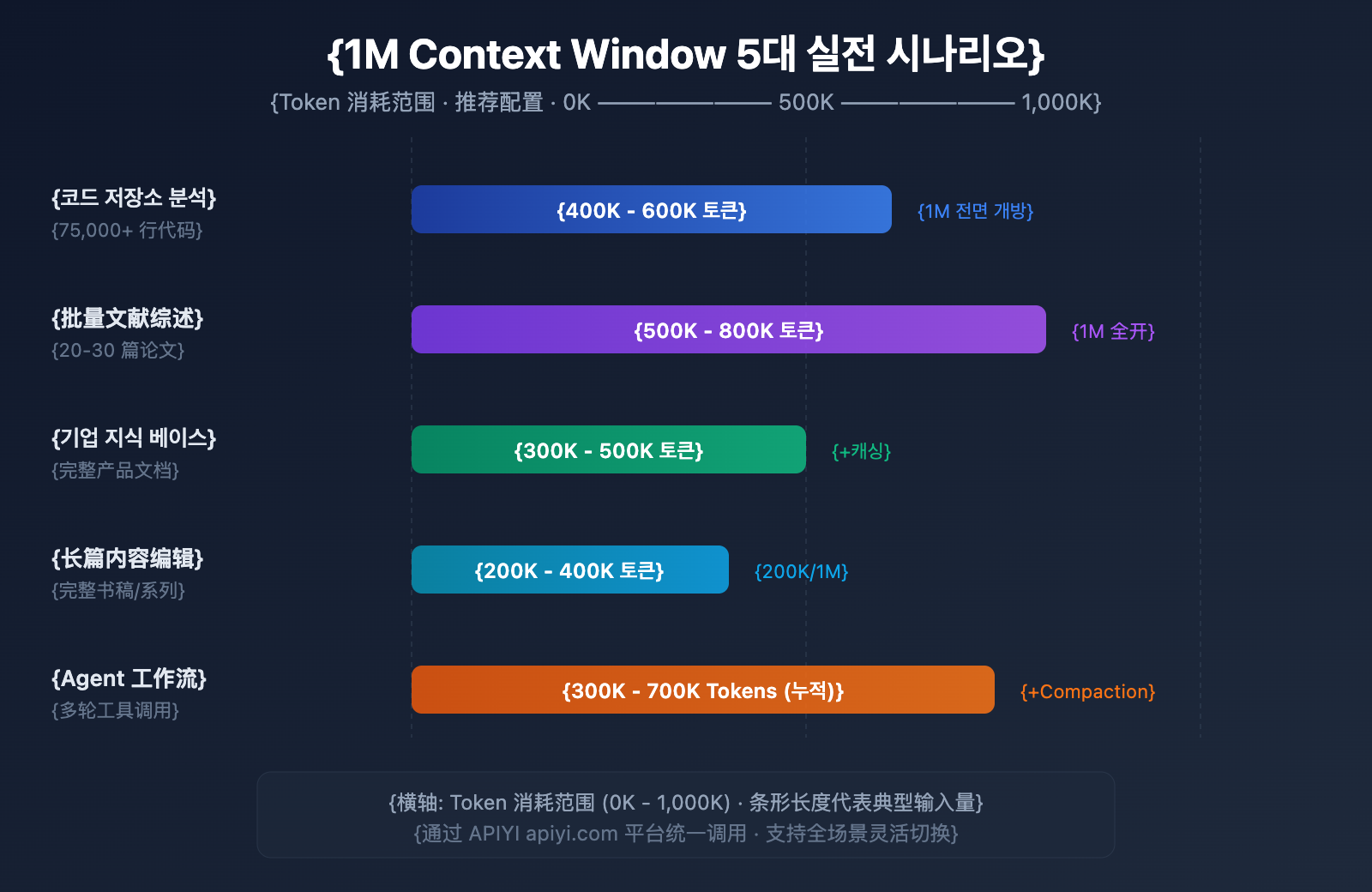

Claude 4.6 컨텍스트 윈도우 5대 실전 활용 사례

사례 1: 전체 코드 저장소 분석

입력 규모: 코드 57.5만 줄 (약 400K600K 토큰)

1M 컨텍스트 윈도우의 혜택을 가장 직접적으로 누릴 수 있는 시나리오입니다. 프로젝트 전체 소스 코드를 한 번에 Claude Opus 4.6에 제출하여 다음과 같은 작업을 수행할 수 있습니다.

- 전역 아키텍처 검토: 모듈 간의 설계 문제를 식별합니다.

- 의존성 분석: 순환 참조나 과도한 결합을 찾아냅니다.

- 보안 취약점 스캔: 전체 컨텍스트 내에서 파일 간에 얽힌 보안 리스크를 발견합니다.

- 리팩토링 제안: 전역적인 이해를 바탕으로 리팩토링 방안을 제시합니다.

기존에는 대규모 코드 저장소를 처리할 때 코드를 여러 조각으로 나누어 분석해야 했기 때문에, 모델이 파일 간의 의존성을 이해하지 못하는 경우가 많았습니다. 이제는 모노레포(monorepo)의 핵심 코드를 통째로 제출하여, Claude가 전체를 꿰뚫어 보는 아키텍트처럼 조언하도록 만들 수 있습니다.

사례 2: 대량의 문헌 검토

입력 규모: 논문 2030편 (약 500K800K 토큰)

연구자들은 수십 편의 관련 논문을 한 번에 입력하여 다음과 같은 작업을 맡길 수 있습니다.

- 교차 참조 분석: 논문 간의 인용 관계와 관점의 충돌을 식별합니다.

- 연구 트렌드 요약: 방대한 문헌에서 방법론의 진화 과정을 추출합니다.

- 갭(Gap) 분석: 기존 연구에서 다루지 않은 공백 영역을 발견합니다.

- 메타 분석 보조: 여러 연구의 실험 설계와 결과를 횡적으로 비교합니다.

연구자가 논문 30편을 직접 읽으려면 몇 주가 걸릴 수도 있습니다. 1M 컨텍스트 윈도우를 활용하면 단 몇 분 만에 1차 스크리닝과 핵심 정보 추출을 완료하여 문헌 조사 효율을 극대화할 수 있습니다.

사례 3: 기업 지식 베이스 Q&A

입력 규모: 전체 제품 문서 라이브러리 (약 300K~500K 토큰)

기업 내부 문서를 컨텍스트에 통째로 로드하여 다음을 구현합니다.

- 정확한 답변: 전체 문서 라이브러리를 기반으로 정확한 답을 제시합니다.

- 문서 간 연관성 발견: 서로 다른 문서에 흩어진 정보 간의 연결 고리를 찾습니다.

- 실시간 업데이트: 별도의 벡터화 전처리 없이 최신 문서를 즉시 사용합니다.

- 다중 문서 추론: 여러 기술 문서를 종합하여 복잡한 질문에 답변합니다.

기존의 RAG(검색 증강 생성) 방식과 비교했을 때, 전체 컨텍스트 방식은 벡터화, 인덱스 구축, 검색 최적화 등의 엔지니어링 비용을 줄여줍니다. 문서량이 1M 토큰 이내인 중소규모 지식 베이스라면 롱 컨텍스트를 직접 사용하는 것이 훨씬 간단하고 효율적인 해결책이 될 수 있습니다.

사례 4: 장문 콘텐츠 창작 및 편집

입력 규모: 전체 원고 또는 시리즈 기사 (약 200K~400K 토큰)

- 일관성 검토: 장문 콘텐츠의 앞뒤 논리가 일치하는지 확인합니다.

- 스타일 통일: 전체 컨텍스트 내에서 문체와 톤앤매너를 유지합니다.

- 구조 최적화: 전체 내용에 대한 이해를 바탕으로 장(Chapter) 조정 제안을 합니다.

- 용어 표준화: 책 전체 범위에서 전문 용어 사용을 통일합니다.

예를 들어, 20만 자 정도의 기술 서적은 약 300K 토큰을 차지하는데, 단 한 번의 요청으로 Claude가 원고 전체를 검토하고 앞뒤 모순되는 부분을 지적하게 할 수 있습니다.

사례 5: 복잡한 에이전트 워크플로우

입력 규모: 다회차 도구 호출 기록 (누적 300K~700K 토큰)

Claude 4.6의 에이전트 팀(Agent Teams) 기능과 결합하면 더욱 강력해집니다.

- 긴 체인 추론: 복잡한 다단계 작업에서 전체 추론 체인을 유지합니다.

- 도구 호출 기억: 모든 과거 도구 호출 결과를 기억합니다.

- 압축(Compaction) 결합: 초장기 워크플로우에서 컨텍스트를 자동으로 압축합니다.

- 다중 에이전트 협업: 에이전트 팀 내에서 컨텍스트 정보를 공유합니다.

에이전트 워크플로우는 Claude Opus 4.6의 핵심 활용 시나리오 중 하나입니다. 자동화된 코드 리뷰나 데이터 분석 파이프라인 같은 복잡한 작업을 수행할 때, 에이전트는 수십 번의 도구 호출을 할 수 있으며 각 호출의 입출력은 컨텍스트에 누적됩니다. 1M 윈도우는 장시간 실행되는 작업에서도 에이전트가 초기의 핵심 정보를 '망각'하지 않도록 보장합니다.

🎯 실전 제안: 위의 5대 시나리오는 모두 APIYI apiyi.com 플랫폼에서 빠르게 효과를 검증해 볼 수 있습니다. 이 플랫폼은 Claude Opus 4.6을 포함한 다양한 대규모 언어 모델을 지원하며, 통일된 인터페이스를 제공하여 여러 시나리오 간의 유연한 전환이 가능합니다.

Claude 4.6 컨텍스트 윈도우 및 경쟁 모델 비교

Claude Opus 4.6가 롱 컨텍스트(Long Context) 분야에서 어느 정도의 경쟁력을 갖추고 있는지 파악하면, 더욱 합리적인 기술 선택을 내리는 데 도움이 됩니다.

| 모델 | 컨텍스트 윈도우 | 최대 출력 | 롱 컨텍스트 검색 성능 | 가격 (입력/출력) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

표에서 알 수 있듯이, Claude Opus 4.6는 롱 컨텍스트 검색 정확도 면에서 확실한 우위를 점하고 있습니다. 가격은 다소 높은 편이지만, 정확한 검색과 복잡한 추론이 필요한 시나리오에서는 경쟁 모델을 압도하는 신뢰성을 보여줍니다.

💡 선택 가이드: 어떤 모델을 선택할지는 구체적인 요구 사항에 따라 달라집니다. 만약 롱 컨텍스트 환경에서의 추론 품질을 최우선으로 고려한다면, Claude Opus 4.6가 현재로서는 최선의 선택입니다. 여러 주요 모델의 통합 인터페이스를 지원하는 APIYI(apiyi.com) 플랫폼을 통해 직접 테스트하고 비교해 보시는 것을 추천합니다. 모델 간 빠른 전환과 평가가 훨씬 수월해집니다.

Claude 4.6 컨텍스트 윈도우 Compaction 설정

Compaction은 Claude Opus 4.6에 새롭게 추가된 서버 측 컨텍스트 압축 기능으로, 대화를 이론적으로 무한히 이어갈 수 있게 해줍니다.

작동 원리

- API가 매 대화의 토큰 사용량을 모니터링합니다.

- 입력 토큰이 설정된 임계값을 초과하면 자동으로 요약(Summary)을 실행합니다.

- 모델이

<summary>태그로 감싸진 대화 요약을 생성합니다. - 요약본이 이전 대화 내용을 대체하여 컨텍스트 공간을 확보합니다.

설정 방법

API 요청 시 compaction_control 파라미터를 추가하여 설정할 수 있습니다.

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # 트리거 임계값

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Compaction과 1M 컨텍스트 활용 전략

| 전략 | 컨텍스트 윈도우 | Compaction | 적용 사례 |

|---|---|---|---|

| 초대형 단일 분석 | 1M (전체 활성화) | 비활성 | 코드 리뷰, 문헌 검토 |

| 장기 대화 | 200K (기본값) | 활성 | 고객 응대, 어시스턴트, 에이전트 |

| 하이브리드 모드 | 1M + Compaction | 활성 | 초복잡 에이전트 워크플로우 |

자주 묻는 질문

Q1: Claude 4.6의 컨텍스트 창은 기본적으로 1M인가요?

아니요. Claude Opus 4.6의 기본 컨텍스트 창은 이전 세대인 Opus 4.5와 동일한 200K 토큰입니다. 1M 토큰 컨텍스트 창을 사용하려면 API 요청 시 anthropic-beta: context-1m-2025-08-07 헤더를 추가해야 해요. 또한, 조직이 Usage Tier 4에 도달했거나 별도의 속도 제한(Rate Limit) 설정을 가지고 있어야 합니다. APIYI(apiyi.com) 플랫폼을 통해 호출하면 요청 시 이 헤더를 간편하게 추가할 수 있습니다.

Q2: 1M 컨텍스트 창을 사용하면 추가 비용이 발생하나요?

네, 계층별 요금제가 적용됩니다. 요청이 200K 토큰을 초과할 경우, 입력 가격은 $5/M에서 $10/M(2배)으로, 출력 가격은 $25/M에서 $37.50/M(1.5배)으로 인상됩니다. 예산에 민감한 프로젝트라면 APIYI(apiyi.com) 플랫폼을 통해 더 경제적인 요금 플랜을 확인해 보시는 것을 추천드려요.

Q3: 1M 컨텍스트 내에서 특정 정보를 정확하게 찾을 수 있나요?

Claude Opus 4.6은 MRCR v2 벤치마크에서 뛰어난 성능을 보여주었습니다. 1M 토큰 컨텍스트 내에 8개의 핵심 정보를 숨겨둔 테스트 시나리오에서 76%의 정확도를 기록했는데, 이는 Sonnet 4.5(18.5%)보다 약 4배 높은 수치입니다. 256K 컨텍스트에서는 정확도가 무려 93%에 달하죠. 이는 Claude Opus 4.6이 현재 긴 컨텍스트 검색에서 가장 신뢰할 수 있는 모델 중 하나임을 의미합니다.

Q4: Compaction(압축) 기능이 답변 품질에 영향을 주나요?

Compaction은 지능형 요약을 통해 이전 대화 내용을 압축하며, 대부분의 상황에서 답변 품질에 큰 영향을 미치지 않습니다. 하지만 이전 대화의 세부 사항을 정확하게 인용해야 하는 경우에는 Compaction을 끄고 1M 컨텍스트 창을 직접 사용하는 것이 좋습니다. 에이전트(Agent) 워크플로우에서는 Compaction이 효율성을 크게 높여주므로 활성화하는 것을 추천해요.

Q5: 어떤 Claude 모델이 1M 컨텍스트를 지원하나요?

현재 1M 토큰 컨텍스트 창을 지원하는 Claude 모델은 Claude Opus 4.6, Claude Sonnet 4.5, Claude Sonnet 4 등 총 3개입니다. 그중에서도 Opus 4.6의 긴 컨텍스트 검색 정확도는 Sonnet 시리즈보다 훨씬 높습니다. Claude Haiku 시리즈와 같은 다른 모델들은 현재 1M 컨텍스트를 지원하지 않습니다.

요약

Claude Opus 4.6의 1M 토큰 컨텍스트 창은 매우 중요한 성능 업그레이드입니다. Opus 플래그십 모델의 강력한 추론 능력과 초대형 컨텍스트가 결합되어, 전체 코드 저장소 분석, 대량의 문헌 검토, 기업용 지식 베이스 질의응답 등 고부가가치 응용 분야의 길을 열었습니다.

핵심 요점 정리:

- 기본 200K, Beta를 통해 1M로 확장:

anthropic-beta: context-1m-2025-08-07헤더 추가 필요 - 업계 최고 수준의 긴 컨텍스트 검색 정확도: MRCR v2 벤치마크 76%(1M) / 93%(256K)

- 계층별 요금제: 200K 초과 부분에 대해 입력 2배, 출력 1.5배 가격 적용

- 무한 대화를 지원하는 Compaction: 서버 측 자동 컨텍스트 압축으로 에이전트 워크플로우에 최적화

- 3종 모델 지원: Opus 4.6, Sonnet 4.5, Sonnet 4

APIYI(apiyi.com)를 통해 Claude Opus 4.6의 긴 컨텍스트 능력을 빠르게 경험해 보세요. 플랫폼에서 제공하는 통합 인터페이스로 다양한 주요 AI 모델을 호출할 수 있어, 개발자가 기술 검증과 제품 통합을 효율적으로 완료할 수 있도록 돕습니다.

본 콘텐츠는 AI 대규모 언어 모델 기술 공유에 집중하는 APIYI 팀에서 작성했습니다. 더 많은 튜토리얼과 API 사용 가이드는 APIYI 도움말 센터(help.apiyi.com)를 방문해 주세요.

참고 자료

-

Anthropic 공식 블로그 – Introducing Claude Opus 4.6

- 링크:

anthropic.com/news/claude-opus-4-6 - 설명: Claude Opus 4.6 출시 공지 및 핵심 기능 소개

- 링크:

-

Claude API 문서 – Context Windows

- 링크:

platform.claude.com/docs/en/build-with-claude/context-windows - 설명: 컨텍스트 윈도우 설정 및 사용 가이드

- 링크:

-

Claude API 문서 – Compaction

- 링크:

platform.claude.com/docs/en/build-with-claude/compaction - 설명: Compaction 컨텍스트 압축 기능 상세 설명

- 링크:

-

Claude API 문서 – Pricing

- 링크:

platform.claude.com/docs/en/about-claude/pricing - 설명: 모델 요금 및 긴 컨텍스트 요금 안내

- 링크: