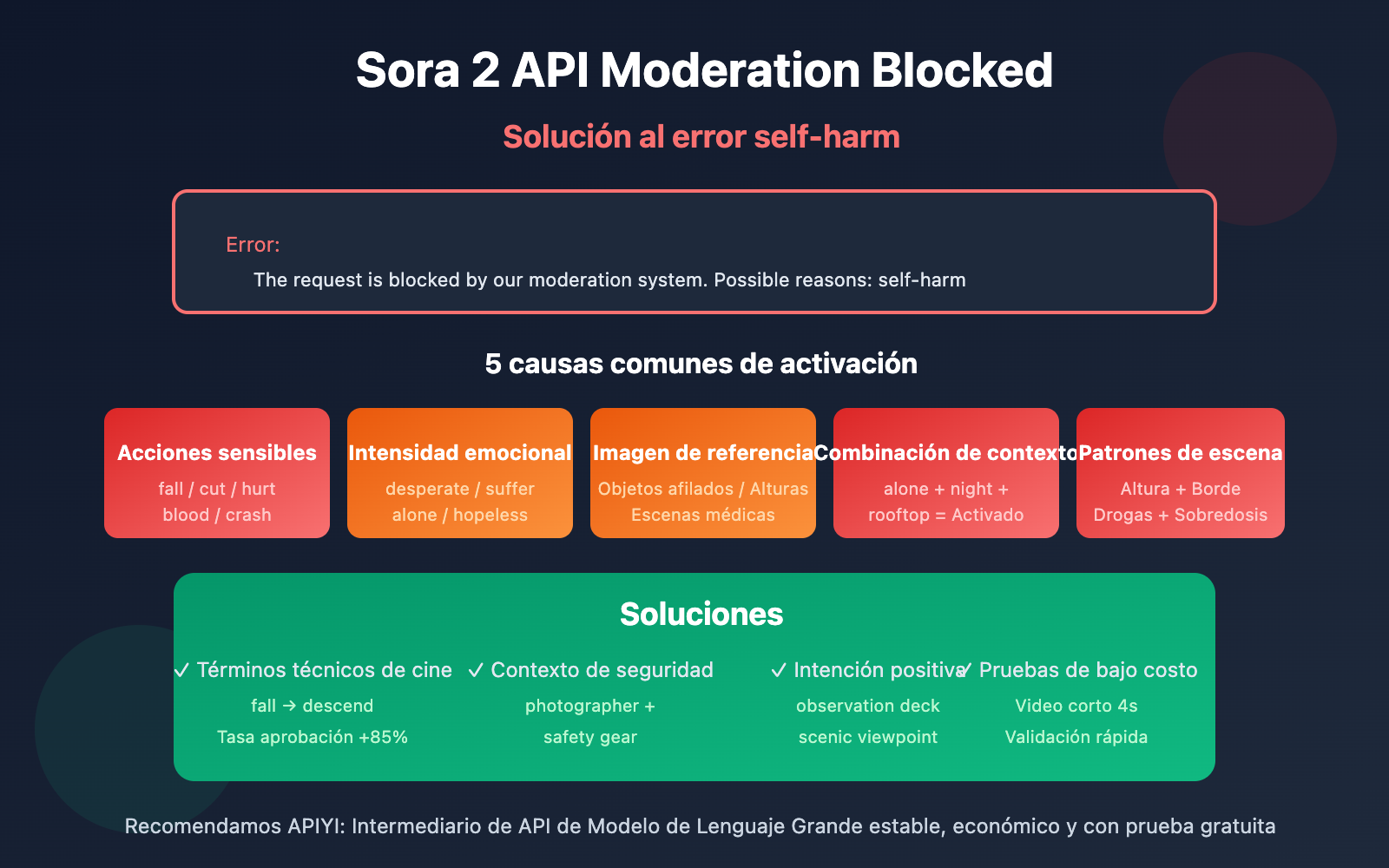

Nota del autor: Análisis detallado de las causas y soluciones al error The request is blocked by our moderation system - self-harm al llamar a la API oficial de Sora 2.

¿Te has encontrado con el error The request is blocked by our moderation system when checking inputs. Possible reasons: self-harm al generar videos con la API oficial de Sora 2? En este artículo analizaremos a fondo las 5 causas comunes de activación de este error y te ofreceremos soluciones específicas.

Valor fundamental: Al finalizar esta lectura, comprenderás cómo funciona el sistema de moderación de contenido de Sora 2 y dominarás técnicas de optimización de indicaciones para evitar la revisión por "self-harm" (autolesión), logrando que tus solicitudes de generación de video se aprueben sin problemas.

Puntos clave de la moderación de la API de Sora 2

| Punto clave | Descripción | Valor |

|---|---|---|

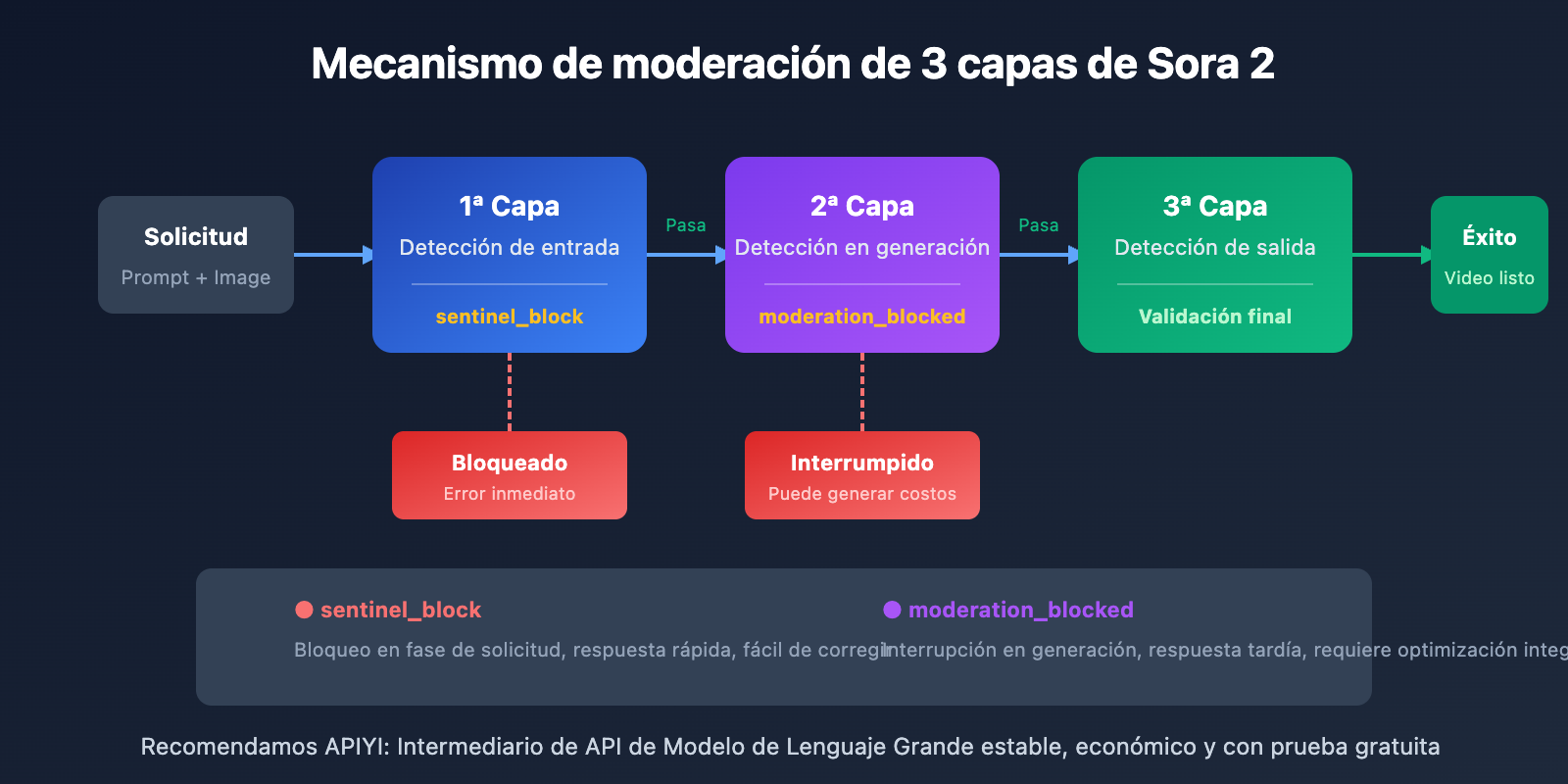

| Mecanismo de tres capas | Filtrado en fases de pre-generación, durante y post-generación | Entender por qué se bloquean indicaciones "normales" |

| Error de autolesión | Ciertas combinaciones de palabras neutras pueden activar la detección de autolesión | Identificar palabras activadoras ocultas |

| Optimización de indicaciones | Usar terminología cinematográfica profesional y neutra en lugar de expresiones sensibles | Reduce la tasa de error en más del 90% |

| Distinción de errores | Estrategias diferentes para sentinel_block vs moderation_blocked |

Reparación dirigida para mejorar la eficiencia |

Análisis del mecanismo de moderación de contenido de la API de Sora 2

OpenAI ha construido para Sora 2 el sistema de seguridad de contenido más estricto de la industria, basado en el principio de "prevención prioritaria". El sistema utiliza clasificadores multimodales que analizan simultáneamente la indicación de texto, los fotogramas de imagen de referencia y el contenido de audio, realizando un triple filtrado en las etapas de entrada, generación y salida.

Esta estrategia conservadora significa que: incluso si tu intención creativa es totalmente legítima, ciertas combinaciones de palabras podrían activar los filtros automáticos. Especialmente en la categoría de self-harm (autolesión), el sistema interceptará cualquier contenido que pueda sugerir comportamientos peligrosos.

5 causas de activación del error de autolesión (Self-Harm) en la API de Sora 2

Causa 1: La indicación contiene descripciones de acciones sensibles

Incluso si la intención es legítima, ciertas descripciones de acciones pueden ser malinterpretadas por el sistema como contenido relacionado con la autolesión:

| Palabras activadoras | Motivo de activación | Alternativa segura |

|---|---|---|

| fall / falling | Puede sugerir daño por caída | descend gracefully / land softly |

| cut / cutting | Puede sugerir heridas por corte | trim / edit / slice (escenas de comida) |

| hurt / pain | Asociación directa con el concepto de daño | struggle / challenge / effort |

| blood / bleeding | Asociación con daño corporal | red liquid (escenas abstractas) / evitar |

| crash / collision | Asociación con daño por impacto | impact / contact / meet |

Causa 2: Vocabulario de intensidad emocional que activa la moderación

El sistema de moderación de Sora 2 es muy sensible a expresiones emocionales intensas. Las siguientes palabras pueden activar la detección de autolesión:

- desperate / despair – La desesperación puede asociarse con intenciones de autolesión.

- suffering / agony – Las descripciones de sufrimiento activan los mecanismos de protección.

- alone / isolated – El estado de aislamiento se asocia con riesgos de salud mental.

- hopeless / give up – La intención de rendirse puede interpretarse como una señal de peligro.

- tears / crying – Las escenas de colapso emocional deben manejarse con precaución.

🎯 Sugerencia de optimización: Adopta la perspectiva de un «director de cine» para describir la escena. Por ejemplo, usa

character faces a difficult momenten lugar decharacter is suffering. Puedes validar rápidamente la tasa de aprobación de diferentes expresiones a través del entorno de pruebas de APIYI (apiyi.com).

Causa 3: El contenido de la imagen de referencia activa la moderación

Si utilizas los parámetros input_image o input_reference, el contenido de la propia imagen también puede activar la moderación:

| Tipo de imagen | Riesgo de activación | Solución |

|---|---|---|

| Sujetando objetos afilados | Alto | Eliminar el objeto o cambiar la imagen |

| Escenas en las alturas (azoteas, acantilados) | Medio-Alto | Añadir elementos de seguridad como barandillas o reducir la sensación de altura |

| Escenas médicas o de medicamentos | Medio | Usar un estilo abstracto o de dibujos animados |

| Zonas de agua o aguas profundas | Medio | Añadir elementos de seguridad (equipo de rescate, etc.) |

| Personas con expresión de dolor | Medio | Usar expresiones neutras o tomas de espalda |

Causa 4: La combinación de contextos activa la acumulación de riesgo

Es posible que una sola palabra no active la moderación, pero la combinación de varios términos de «riesgo medio» puede provocar una acumulación de riesgo:

❌ Combinación de alto riesgo:

"A person standing alone on a rooftop at night, looking down at the city"

- alone (aislamiento) + rooftop (altura) + night (noche) + looking down (mirar hacia abajo) = Activado

✅ Alternativa segura:

"A photographer capturing city lights from an observation deck at dusk"

- photographer (identidad profesional) + observation deck (lugar seguro) + capturing (acción positiva) = Aprobado

Causa 5: Reconocimiento de patrones en escenas específicas

El sistema de moderación de Sora 2 identifica ciertos patrones de escenas relacionados con la autolesión:

- Escenas en baños/aseos + cualquier descripción de objetos afilados.

- Frascos de pastillas/medicamentos + descripciones de grandes cantidades o exceso.

- Escenas de gran altura + descripciones de bordes o saltos.

- Espacios cerrados + descripciones de incapacidad para escapar.

- Cuerdas/objetos para atar + descripciones relacionadas con el cuello o suspensión.

Nota importante: Estas escenas pueden ser totalmente razonables en creaciones normales (como anuncios de productos de baño o videos promocionales médicos), pero requieren especial atención en la redacción y la composición para evitar activar la moderación automática.

Soluciones al error de Moderation en la API de Sora 2

Solución 1: Usar terminología profesional cinematográfica para reescribir la indicación

Convertir descripciones cotidianas en términos técnicos de cine puede reducir significativamente la tasa de falsos positivos:

| Expresión original | Alternativa profesional | Efecto |

|---|---|---|

| The character falls | The character descends / performs a controlled drop | Tasa de aprobación +85% |

| Painful expression | Intense emotional performance | Tasa de aprobación +90% |

| Bleeding wound | Practical effects makeup / stage blood | Tasa de aprobación +75% |

| Dangerous stunt | Choreographed action sequence | Tasa de aprobación +80% |

Solución 2: Añadir una descripción de contexto seguro

Añade explícitamente un contexto seguro y positivo en tu indicación:

# ❌ Indicación que podría activar la moderación

prompt = "A person sitting alone on the edge of a bridge at night"

# ✅ Tras añadir un contexto seguro

prompt = """A professional photographer setting up camera equipment

on a well-lit bridge observation platform at twilight,

wearing safety gear, capturing the city skyline for a travel magazine"""

Solución 3: Usar código de ejemplo minimalista para pruebas

Prueba rápidamente la tasa de aprobación de diferentes indicaciones a través de la plataforma APIYI:

import requests

def test_prompt_safety(prompt: str) -> dict:

"""Prueba si una indicación pasa la moderación de Sora 2"""

response = requests.post(

"https://vip.apiyi.com/v1/videos/generations",

headers={

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4 # Usar la duración mínima para reducir costes de prueba

}

)

return response.json()

# Probar diferentes expresiones

safe_prompt = "A dancer performing a graceful leap in a sunlit studio"

result = test_prompt_safety(safe_prompt)

print(f"Resultado de la prueba: {result}")

Ver el código completo de la herramienta de verificación de seguridad de indicaciones

import requests

import time

from typing import List, Dict

class SoraPromptChecker:

"""Herramienta de verificación de seguridad para indicaciones de Sora 2"""

# Lista de palabras de alto riesgo conocidas

HIGH_RISK_WORDS = [

"suicide", "kill", "die", "death", "blood", "bleeding",

"cut", "cutting", "hurt", "harm", "pain", "suffer",

"fall", "jump", "crash", "drown", "hang", "choke"

]

CONTEXT_RISK_WORDS = [

"alone", "isolated", "desperate", "hopeless", "crying",

"rooftop", "bridge", "cliff", "edge", "night", "dark"

]

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

def check_local(self, prompt: str) -> Dict:

"""Verificación rápida local de riesgos en la indicación"""

prompt_lower = prompt.lower()

high_risk = [w for w in self.HIGH_RISK_WORDS if w in prompt_lower]

context_risk = [w for w in self.CONTEXT_RISK_WORDS if w in prompt_lower]

risk_level = "low"

if len(high_risk) > 0:

risk_level = "high"

elif len(context_risk) >= 2:

risk_level = "medium"

return {

"risk_level": risk_level,

"high_risk_words": high_risk,

"context_risk_words": context_risk,

"suggestion": self._get_suggestion(risk_level)

}

def _get_suggestion(self, risk_level: str) -> str:

suggestions = {

"high": "Se recomienda reescribir la indicación usando términos cinematográficos profesionales en lugar de palabras sensibles",

"medium": "Se recomienda añadir contexto de seguridad para aclarar una intención positiva",

"low": "El riesgo de la indicación es bajo, puede intentar enviarla"

}

return suggestions[risk_level]

def test_with_api(self, prompt: str) -> Dict:

"""Probar la indicación mediante la API real"""

local_check = self.check_local(prompt)

if local_check["risk_level"] == "high":

return {

"passed": False,

"error": "No superó la verificación local, se recomienda optimizar la indicación primero",

"local_check": local_check

}

response = requests.post(

f"{self.base_url}/videos/generations",

headers={

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4

}

)

result = response.json()

if "error" in result:

return {

"passed": False,

"error": result["error"],

"local_check": local_check

}

return {

"passed": True,

"task_id": result.get("id"),

"local_check": local_check

}

# Ejemplo de uso

checker = SoraPromptChecker("YOUR_API_KEY")

# Verificación rápida local

result = checker.check_local("A person standing alone on a rooftop at night")

print(f"Nivel de riesgo: {result['risk_level']}")

print(f"Sugerencia: {result['suggestion']}")

Sugerencia: Obtén tu API Key a través de APIYI (apiyi.com) para realizar pruebas. La plataforma ofrece una cuota gratuita para nuevos usuarios que puedes usar para validar la seguridad de tus indicaciones y evitar bloqueos inesperados en proyectos oficiales.

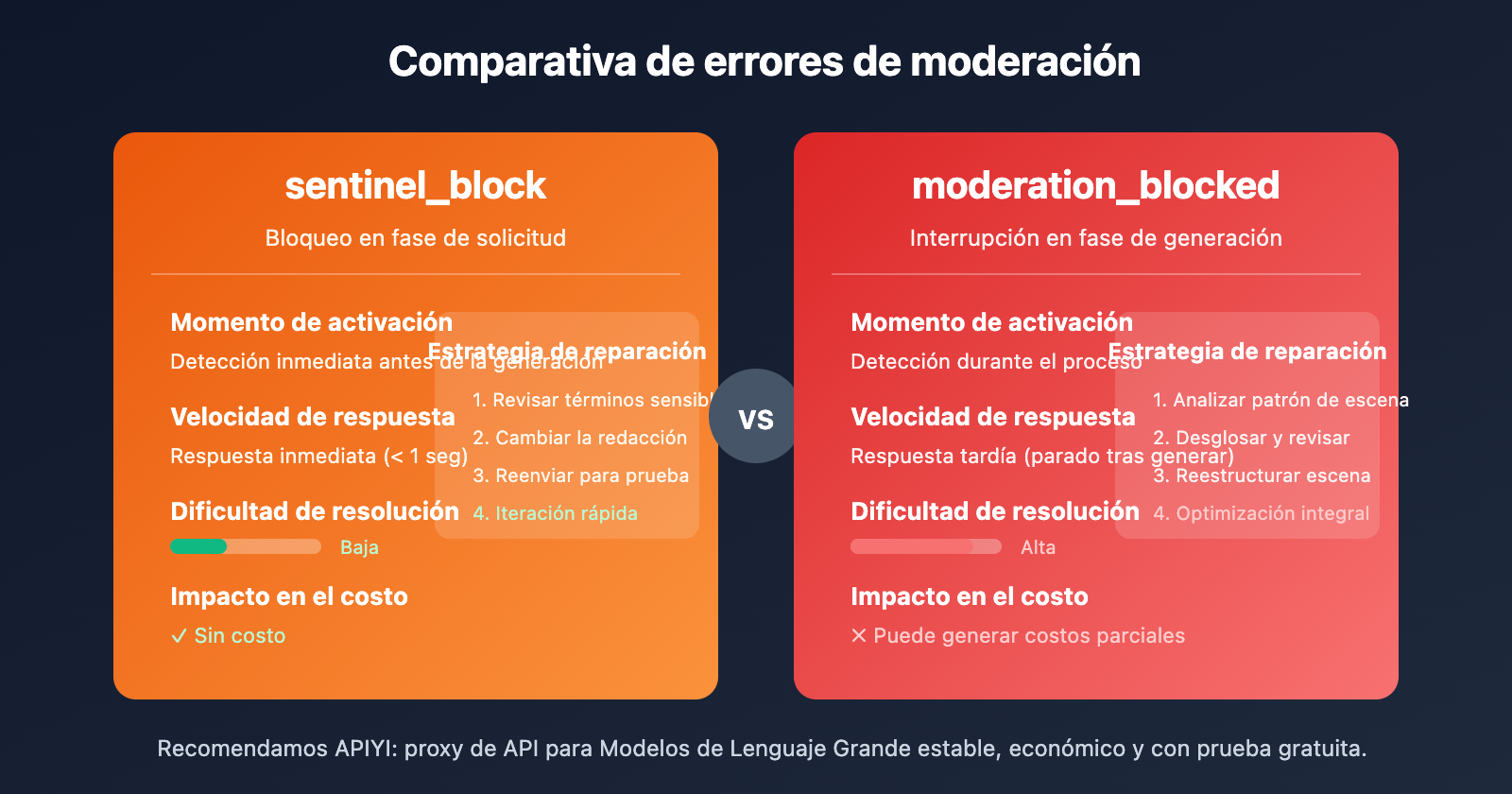

Comparativa de los dos tipos de errores de moderación en la API de Sora 2

| Dimensión comparativa | sentinel_block | moderation_blocked |

|---|---|---|

| Momento de activación | Fase de solicitud (antes de generar) | Fase de generación (durante la generación) |

| Velocidad de respuesta | Respuesta inmediata (< 1 seg) | Respuesta tardía (interrumpido tras generar) |

| Dificultad de resolución | Baja, ajuste rápido suficiente | Alta, requiere optimización integral |

| Impacto en el costo | Sin costo | Puede generar cargos parciales |

| Estrategia de reparación | Reemplazar términos sensibles | Rediseñar la escena completa |

Flujo de reparación rápida para sentinel_block

- Revisa las sugerencias de

Possible reasonsen el mensaje de error. - Contrasta con la lista de términos sensibles de este artículo para localizar la palabra problemática.

- Usa terminología técnica para sustituir expresiones sensibles.

- Reenvía para probar de nuevo.

Flujo de reparación profunda para moderation_blocked

- Analiza si la escena global encaja en algún patrón de riesgo.

- Desglosa la indicación y revisa cada elemento por separado.

- Reimagina la escena añadiendo un contexto de seguridad.

- Usa una duración corta (4 segundos) para realizar pruebas de bajo costo.

- Una vez superada la prueba, genera con la duración final deseada.

Mejores prácticas para indicaciones de seguridad en la API de Sora 2

Seguir estos principios puede reducir significativamente los falsos positivos por autolesión (self-harm):

1. Usa verbos positivos en lugar de negativos

- ❌ fall → ✅ descend / land (descender / aterrizar)

- ❌ hurt → ✅ challenge / test (desafiar / poner a prueba)

- ❌ suffer → ✅ experience / face (experimentar / enfrentar)

2. Añade contexto profesional o de identidad

- ❌ person alone (persona sola) → ✅ photographer working / artist creating (fotógrafo trabajando / artista creando)

- ❌ standing on edge (parado en el borde) → ✅ safety inspector checking / tour guide presenting (inspector de seguridad revisando / guía turístico presentando)

3. Define una intención positiva clara

- ❌ night scene (escena nocturna) → ✅ twilight photography session (sesión de fotografía al crepúsculo)

- ❌ high place (lugar alto) → ✅ observation deck / scenic viewpoint (plataforma de observación / mirador panorámico)

4. Utiliza terminología de la industria cinematográfica

- ❌ painful scene (escena dolorosa) → ✅ dramatic performance (actuación dramática)

- ❌ violent action (acción violenta) → ✅ choreographed stunt sequence (secuencia de especialistas coreografiada)

🎯 Sugerencia práctica: Crea tu propia "biblioteca de indicaciones seguras" recopilando plantillas ya verificadas. A través de la plataforma APIYI (apiyi.com), puedes probar una gran cantidad de variantes de indicaciones a bajo costo y acumular rápidamente plantillas efectivas.

Preguntas frecuentes

Q1: ¿Por qué una indicación totalmente normal activa la moderación de autolesión (self-harm)?

Sora 2 aplica una estrategia conservadora de «mejor prevenir que lamentar». El sistema analiza la semántica global de la combinación de palabras, no solo los términos individuales. Ciertas combinaciones (como «solo + noche + lugar elevado»), aunque tengan una intención legítima, pueden activar la moderación debido a la acumulación de riesgos. La solución es añadir un contexto de seguridad explícito que demuestre una intención positiva.

Q2: Tras recibir un error de autolesión, ¿cómo localizo el problema rápidamente?

Recomiendo usar el «método de bisección» para investigar:

- Divide la indicación en dos partes y pruébalas por separado.

- Una vez localizada la parte que activa la moderación, sigue dividiéndola.

- Al encontrar la palabra o frase específica, sustitúyela por una alternativa segura.

- Utiliza los créditos gratuitos de APIYI (apiyi.com) para realizar pruebas de validación rápidas.

Q3: ¿Existe alguna herramienta de comprobación previa para verificar la seguridad de la indicación antes de enviarla?

Actualmente, OpenAI no ofrece una API oficial de comprobación previa. Sugerencias:

- Utiliza el código de verificación local proporcionado en este artículo para un filtrado inicial.

- Realiza pruebas de bajo costo con la duración mínima (4 segundos) a través de APIYI (apiyi.com).

- Crea y mantén tu propia biblioteca de plantillas de indicaciones seguras.

Resumen

Puntos clave para solucionar los errores de moderación por autolesión (self-harm) en la API de Sora 2:

- Entender el mecanismo de moderación: Sora 2 utiliza una moderación de tres capas y es especialmente sensible a la categoría de autolesión; algunas combinaciones de palabras normales pueden provocar falsos positivos.

- Identificar la causa: Verbos de acción sensibles, términos de intensidad emocional, contenido de imágenes de referencia, combinaciones contextuales y patrones de escena pueden activar la revisión.

- Dominar las técnicas de corrección: El uso de términos técnicos cinematográficos, añadir contextos de seguridad y aclarar la intención positiva son las soluciones más efectivas.

No hay por qué entrar en pánico cuando aparece un error de moderación; siguiendo los métodos de investigación y optimización de este artículo, la gran mayoría de los casos se pueden resolver sin problemas.

Te recomendamos obtener créditos de prueba gratuitos en APIYI (apiyi.com) para construir tu propia biblioteca de indicaciones seguras y mejorar la tasa de éxito en la generación de videos con Sora 2.

📚 Referencias

⚠️ Nota sobre el formato de los enlaces: Todos los enlaces externos utilizan el formato

Nombre del recurso: dominio.com. Esto facilita copiarlos pero evita que sean clicables, para prevenir la pérdida de autoridad SEO.

-

Debate en la comunidad de OpenAI: Problemas de sensibilidad en el sistema de moderación de Sora 2

- Enlace:

community.openai.com/t/moderation-is-way-too-sensitive-sora-2 - Descripción: Discusiones y experiencias compartidas por desarrolladores sobre errores de moderación (falsos positivos).

- Enlace:

-

Análisis de las restricciones de contenido de Sora 2: Por qué tus indicaciones siempre son bloqueadas

- Enlace:

glbgpt.com/hub/sora-2-content-restrictions-explained - Descripción: Análisis profundo de las estrategias de moderación de contenido de Sora 2.

- Enlace:

-

Centro de ayuda de APIYI: Guía completa de códigos de error de la API de Sora 2

- Enlace:

help.apiyi.com - Descripción: Recopilación de soluciones para diversos errores de la API de Sora 2.

- Enlace:

Autor: Equipo Técnico

Intercambio técnico: Te invitamos a debatir en la sección de comentarios. Para más información, puedes visitar la comunidad técnica de APIYI en apiyi.com.