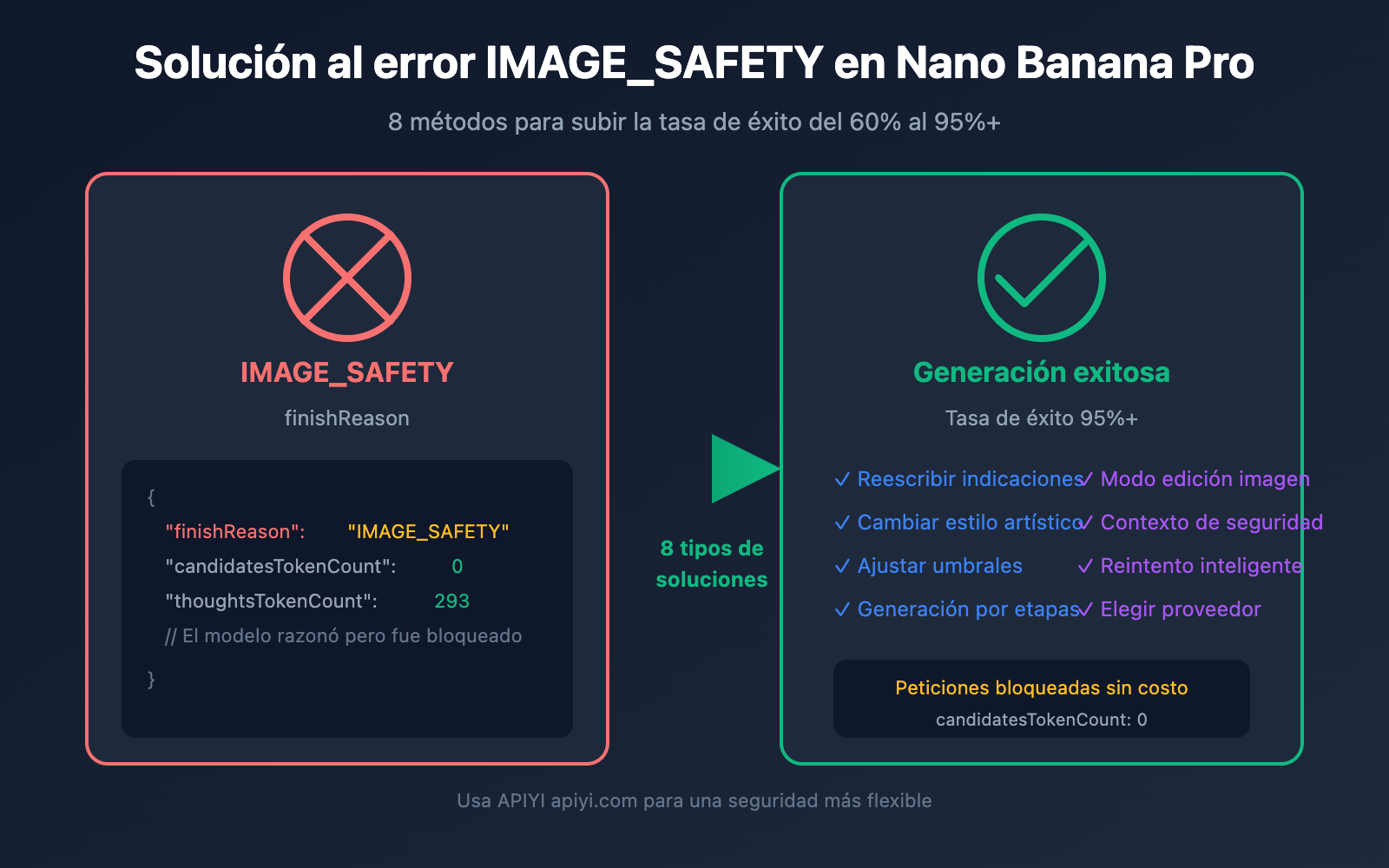

Al llamar a la API de Nano Banana Pro, recibir el error finishReason: "IMAGE_SAFETY" es uno de los problemas más comunes para los desarrolladores. Imágenes que son claramente fotos de productos normales o paisajes terminan bloqueadas porque el sistema las marca como una "violación de las políticas de uso de IA generativa de Google". En este artículo analizaremos a fondo el mecanismo de activación del error IMAGE_SAFETY y 8 soluciones prácticas para ayudarte a reducir drásticamente la probabilidad de falsos positivos.

Valor principal: Al terminar de leer, entenderás cómo funciona el filtrado de seguridad de Nano Banana Pro y dominarás técnicas prácticas para evitar bloqueos innecesarios, logrando que tu tasa de éxito en la generación pase del 60% a más del 95%.

Análisis del error IMAGE_SAFETY en Nano Banana Pro

Primero, analicemos la respuesta de error que estás recibiendo:

{

"candidates": [

{

"content": { "parts": null },

"finishReason": "IMAGE_SAFETY",

"finishMessage": "Unable to show the generated image...",

"index": 0

}

],

"usageMetadata": {

"promptTokenCount": 531,

"candidatesTokenCount": 0,

"totalTokenCount": 824,

"thoughtsTokenCount": 293

},

"modelVersion": "gemini-3-pro-image-preview"

}

Campos clave en el error IMAGE_SAFETY

| Campo | Valor | Significado |

|---|---|---|

finishReason |

IMAGE_SAFETY |

La imagen fue bloqueada por el filtro de seguridad |

candidatesTokenCount |

0 |

No se generó ninguna salida (sin cargo) |

thoughtsTokenCount |

293 |

El modelo razonó pero fue bloqueado al final |

promptTokenCount |

531 |

Contiene 273 tokens de texto + 258 de imagen |

🎯 Descubrimiento clave: Un valor de

thoughtsTokenCount: 293indica que el modelo ya completó su razonamiento interno (Thinking), pero fue bloqueado por el filtro de seguridad justo en la etapa de salida. Esto significa que el problema está en el resultado generado y no necesariamente en la indicación de entrada.

Detalles del mecanismo de filtrado de seguridad de Nano Banana Pro

Nano Banana Pro de Google utiliza una arquitectura de filtrado de seguridad multicapa; entender este mecanismo es fundamental para resolver problemas.

Niveles de filtrado de seguridad en Nano Banana Pro

| Capa de filtrado | Objeto de detección | ¿Es configurable? | Consecuencia al activarse |

|---|---|---|---|

| Filtrado de entrada | Texto de la indicación | Parcialmente configurable | Solicitud rechazada |

| Filtrado de entrada de imagen | Contenido de la imagen de referencia | No configurable | IMAGE_SAFETY |

| Filtrado de generación | Resultado de salida del modelo | Parcialmente configurable | IMAGE_SAFETY |

| Filtrado estricto (Hard filtering) | CSAM/PII, etc. | No configurable | Bloqueo permanente |

Las cuatro categorías de riesgo de Nano Banana Pro

Google clasifica los riesgos de contenido en cuatro categorías configurables:

| Categoría | Nombre en inglés | Ejemplos de activación | Umbral por defecto |

|---|---|---|---|

| Discurso de odio | HARM_CATEGORY_HATE_SPEECH | Contenido discriminatorio por raza o religión | MEDIUM |

| Acoso | HARM_CATEGORY_HARASSMENT | Ataques personales, amenazas | MEDIUM |

| Contenido sexual | HARM_CATEGORY_SEXUALLY_EXPLICIT | Desnudez, contenido para adultos | MEDIUM |

| Contenido peligroso | HARM_CATEGORY_DANGEROUS_CONTENT | Violencia, armas, drogas | MEDIUM |

¿Por qué se bloquea el contenido normal?

Google admite oficialmente que los filtros de seguridad de Nano Banana Pro son "mucho más cautelosos de lo previsto" (way more cautious than intended). Estos son algunos escenarios comunes de falsos positivos:

| Escenario | Por qué ocurre el falso positivo | Riesgo real |

|---|---|---|

| Fotos de lencería para e-commerce | Activa la detección de "Contenido sexual" | Exhibición normal de productos |

| Personajes de estilo anime | El estilo anime activa detecciones más estrictas | Creación artística |

| Contenido relacionado con niños | La etiqueta "underage" activa el nivel máximo de filtrado | Escenas familiares normales |

| Diagramas anatómicos médicos | Activa la detección de "Violencia/Sangre" | Uso educativo |

| Personas con profesiones específicas | Puede ser identificado como una "persona identificable" | Descripción de profesión genérica |

⚠️ Nota importante: La probabilidad de que las imágenes de estilo anime o manga activen el filtrado de seguridad es significativamente mayor que la de los estilos realistas. Para un mismo contenido (como "un gato descansando"), usar "anime style" puede causar un rechazo, mientras que "realistic digital illustration" suele pasar sin problemas.

Solución 1 para IMAGE_SAFETY en Nano Banana Pro: Reescribir la indicación

El método más directo y eficaz es reescribir la indicación para evitar palabras sensibles que activen los filtros de seguridad.

Estrategias de reescritura de indicaciones para Nano Banana Pro

| Forma original | Problema | Sugerencia de reescritura |

|---|---|---|

| "sexy model wearing bikini" | Activa detección de contenido sexual | "fashion model in summer beachwear" |

| "anime girl" | La combinación de anime + mujer es de alto riesgo | "illustrated character in digital art style" |

| "child playing" | "child" activa el nivel de filtrado más alto | "young person enjoying outdoor activities" |

| "bloody wound" | Activa detección de contenido violento | "medical illustration of skin injury" |

| "holding a gun" | Activa detección de contenido peligroso | "action pose with prop equipment" |

Ejemplo de código para reescritura de indicaciones

import openai

import re

# Mapeo de reemplazo de palabras sensibles

SAFE_REPLACEMENTS = {

r'\bsexy\b': 'stylish',

r'\bbikini\b': 'summer beachwear',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bblood\b': 'red liquid',

r'\bnude\b': 'unclothed figure',

}

def sanitize_prompt(prompt: str) -> str:

"""Reemplaza palabras sensibles para reducir el riesgo de bloqueo"""

sanitized = prompt.lower()

for pattern, replacement in SAFE_REPLACEMENTS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Usando la interfaz unificada de APIYI

)

# Ejemplo de uso

original_prompt = "anime girl in bikini at beach"

safe_prompt = sanitize_prompt(original_prompt)

# Resultado: "illustrated girl in summer beachwear at beach"

response = client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

💡 Sugerencia: Al realizar llamadas a Nano Banana Pro a través de la plataforma APIYI (apiyi.com), puedes usar primero la herramienta de prueba imagen.apiyi.com para verificar si la indicación activará el filtrado antes de realizar la llamada formal.

Nano Banana Pro IMAGE_SAFETY Solución 2: Cambiar el estilo artístico

El estilo anime es un factor de alto riesgo para activar la política IMAGE_SAFETY. Cambiar a un estilo realista puede aumentar significativamente la tasa de éxito.

Comparativa de seguridad por estilo en Nano Banana Pro

| Tipo de estilo | Sensibilidad del filtro de seguridad | Índice de recomendación | Escenario de uso |

|---|---|---|---|

| Anime/Manga | Muy alta | ⭐ | No recomendado |

| Cartoon | Alta | ⭐⭐ | Usar con precaución |

| Digital Art | Media | ⭐⭐⭐ | Se puede usar |

| Realistic | Baja | ⭐⭐⭐⭐ | Recomendado |

| Photography | Mínima | ⭐⭐⭐⭐⭐ | Muy recomendado |

Ejemplo de código para cambio de estilo

def generate_with_safe_style(prompt: str, preferred_style: str = "anime"):

"""Convierte automáticamente estilos de alto riesgo en estilos seguros"""

# Tabla de mapeo de estilos

style_mappings = {

"anime": "digital illustration with soft lighting",

"manga": "stylized digital artwork",

"cartoon": "clean vector illustration",

"hentai": None, # No soportado en absoluto

}

# Verificar si se requiere conversión de estilo

safe_style = style_mappings.get(preferred_style.lower())

if safe_style is None:

raise ValueError(f"Style '{preferred_style}' is not supported")

# Construir indicación segura

safe_prompt = f"{prompt}, {safe_style}, professional quality"

return client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

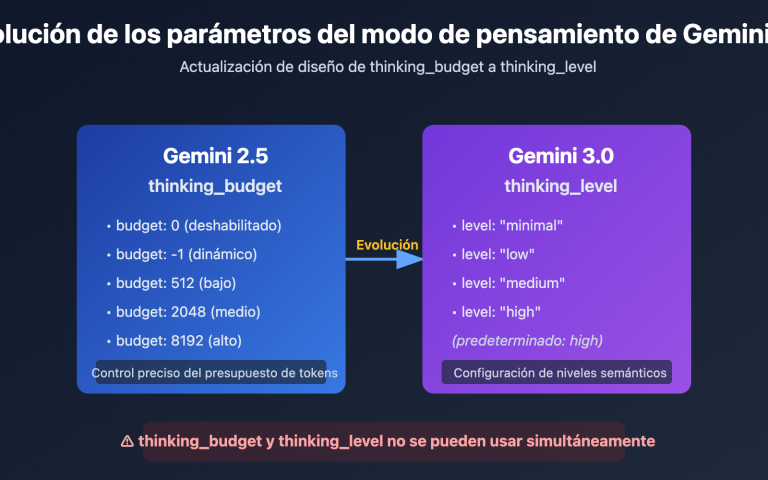

Nano Banana Pro IMAGE_SAFETY Solución 3: Ajustar los parámetros del umbral de seguridad

Google ofrece parámetros de umbral de seguridad configurables que permiten flexibilizar las restricciones de filtrado hasta cierto punto.

Configuración de umbrales de seguridad en Nano Banana Pro

| Nivel de umbral | Valor del parámetro | Rigor del filtrado | Escenario de uso |

|---|---|---|---|

| Más estricto | BLOCK_LOW_AND_ABOVE |

Alto | Aplicaciones para menores |

| Estándar (predeterminado) | BLOCK_MEDIUM_AND_ABOVE |

Medio | Escenarios generales |

| Relajado | BLOCK_ONLY_HIGH |

Bajo | Creación profesional/artística |

| Más relajado | BLOCK_NONE |

Mínimo | Requiere solicitud de permisos |

Código para ajustar el umbral de seguridad

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

response = client.images.generate(

model="nano-banana-pro",

prompt="fashion model in elegant evening dress",

size="2048x2048",

extra_body={

"safety_settings": [

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_ONLY_HIGH"

}

]

}

)

⚠️ Nota: Incluso si todos los umbrales configurables se establecen en

BLOCK_NONE, todavía

Solución 4 para IMAGE_SAFETY en Nano Banana Pro: Generación paso a paso de escenas complejas

Las indicaciones complejas suelen activar los filtros de seguridad con mayor facilidad. Dividir una escena compleja en varios pasos sencillos puede aumentar considerablemente la tasa de éxito.

Estrategia de generación por pasos

def generate_complex_scene_stepwise(scene_description: str):

"""

Divide una escena compleja en varios pasos para su generación.

Estrategia: primero generar el fondo, luego el sujeto y finalmente componer.

"""

steps = [

# Paso 1: Generar fondo puro

{

"prompt": "empty beach scene at sunset, golden hour lighting, no people",

"purpose": "background"

},

# Paso 2: Generar el sujeto (usando descripciones seguras)

{

"prompt": "professional fashion photography, model in summer dress, studio lighting",

"purpose": "subject"

}

]

results = []

for step in steps:

try:

response = client.images.generate(

model="nano-banana-pro",

prompt=step["prompt"],

size="2048x2048"

)

results.append({

"purpose": step["purpose"],

"success": True,

"image": response.data[0]

})

except Exception as e:

results.append({

"purpose": step["purpose"],

"success": False,

"error": str(e)

})

return results

Solución 5 para IMAGE_SAFETY en Nano Banana Pro: Uso del modo de edición de imágenes

Si la generación directa es bloqueada, puedes intentar usar el modo de edición de imágenes (Image Editing), realizando modificaciones basadas en una imagen segura que ya tengas.

Ejemplo del modo de edición de imágenes

import base64

from pathlib import Path

def edit_existing_image(

image_path: str,

edit_instruction: str

) -> dict:

"""

Usa el modo de edición de imágenes para modificar una imagen existente.

Normalmente es más fácil pasar los filtros de seguridad que con la generación desde cero.

"""

# Leer y codificar la imagen

image_data = Path(image_path).read_bytes()

base64_image = base64.b64encode(image_data).decode('utf-8')

response = client.images.edit(

model="nano-banana-pro",

image=base64_image,

prompt=edit_instruction,

size="2048x2048"

)

return response

# Ejemplo de uso: cambiar el color de la ropa

result = edit_existing_image(

image_path="original_product.png",

edit_instruction="change the dress color to deep blue, keep everything else the same"

)

🎯 Consejo: En el modo de edición de imágenes, el modelo realiza modificaciones locales basadas en la imagen original, por lo que la probabilidad de activar el filtro de seguridad suele ser menor que al generar desde cero. Al realizar llamadas a través de la plataforma APIYI apiyi.com, la función de edición de imágenes también está disponible.

Nano Banana Pro IMAGE_SAFETY Solución 6: Añadir contexto de seguridad

Agregar explícitamente palabras de contexto como "seguro", "profesional" o "comercial" en la indicación ayuda al modelo a comprender tu intención legítima y reduce las posibilidades de bloqueos accidentales.

Glosario de contexto de seguridad

| Categoría | Palabras recomendadas | Efecto |

|---|---|---|

| Declaración de uso | "for commercial use", "product catalog" | Indica un propósito comercial |

| Declaración profesional | "professional photography", "studio shot" | Enfatiza el profesionalismo |

| Declaración de estilo | "clean", "family-friendly", "SFW" | Aclara una intención segura |

| Declaración de calidad | "high quality", "editorial", "magazine" | Sugiere canales de distribución formales |

Ejemplo de código para añadir contexto de seguridad

def add_safety_context(prompt: str, context_type: str = "commercial") -> str:

"""Añade contexto de seguridad a la indicación para reducir la probabilidad de falsos positivos"""

context_templates = {

"commercial": "Professional product photography for e-commerce catalog, clean background, {prompt}, high quality commercial image",

"editorial": "Editorial photography for fashion magazine, {prompt}, professional studio lighting, tasteful and elegant",

"artistic": "Fine art digital illustration, {prompt}, museum quality, suitable for all ages",

"medical": "Medical educational illustration, {prompt}, anatomically accurate, clinical documentation style"

}

template = context_templates.get(context_type, context_templates["commercial"])

return template.format(prompt=prompt)

# Ejemplo de uso

original = "model wearing swimwear"

safe_prompt = add_safety_context(original, "commercial")

# Resultado: "Professional product photography for e-commerce catalog, clean background, model wearing swimwear, high quality commercial image"

Nano Banana Pro IMAGE_SAFETY Solución 7: Implementar un mecanismo de reintento inteligente

Dado que el filtrado de seguridad puede tener cierta variabilidad o aleatoriedad, implementar un mecanismo de reintento inteligente puede mejorar significativamente la tasa de éxito general.

Estrategia de reintento inteligente

import time

import random

from typing import Optional, List

class SafeImageGenerator:

"""Generador de imágenes seguro con reintentos inteligentes"""

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1" # APIYI: Interfaz unificada

)

self.prompt_variations = []

def generate_prompt_variations(self, original: str) -> List[str]:

"""Genera variantes de la indicación para ser usadas en los reintentos"""

variations = [

original,

f"Professional {original}",

f"{original}, clean and tasteful",

f"High quality {original}, suitable for all audiences",

f"Editorial style {original}, magazine quality"

]

return variations

def generate_with_retry(

self,

prompt: str,

max_retries: int = 3,

size: str = "2048x2048"

) -> Optional[dict]:

"""Generación de imágenes con reintentos inteligentes"""

variations = self.generate_prompt_variations(prompt)

for attempt, current_prompt in enumerate(variations[:max_retries]):

try:

print(f"Intento {attempt + 1}/{max_retries}: {current_prompt[:50]}...")

response = self.client.images.generate(

model="nano-banana-pro",

prompt=current_prompt,

size=size

)

print(f"✅ ¡Generado con éxito!")

return {

"success": True,

"attempt": attempt + 1,

"prompt_used": current_prompt,

"image": response.data[0]

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "PROHIBITED_CONTENT" in error_msg:

print(f"❌ Bloqueado por filtro de seguridad, probando siguiente variante...")

time.sleep(1) # Pausa breve para evitar saturar las solicitudes

continue

else:

raise e

return {

"success": False,

"attempts": max_retries,

"error": "Todas las variantes de la indicación fueron bloqueadas por el filtro de seguridad"

}

# Ejemplo de uso

generator = SafeImageGenerator(api_key="tu-api-key")

result = generator.generate_with_retry("fashion model in elegant dress")

if result["success"]:

print(f"Éxito en el intento número {result['attempt']}")

else:

print(f"Fallaron los {result['attempts']} intentos")

Solución 8 para IMAGE_SAFETY en Nano Banana Pro: Elegir el proveedor de API adecuado

Diferentes proveedores de API pueden emplear distintas estrategias de filtrado de seguridad. Elegir el proveedor que mejor se adapte a tu escenario de negocio es fundamental.

Comparativa de proveedores de API para Nano Banana Pro

| Proveedor | Estrictez del filtro | Configurabilidad | Precio | Características |

|---|---|---|---|---|

| Google Oficial | Máxima | Limitada | $0.134 / img | Configuración predeterminada más conservadora |

| APIYI | Estándar | Permite ajustes | $0.05 / img | Equilibrio entre seguridad y disponibilidad |

| Otros intermediarios | Inconsistente | Desconocida | Variable | Calidad desigual |

💰 Optimización de costos: Al realizar llamadas a Nano Banana Pro a través de APIYI (apiyi.com), no solo el precio es apenas el 37% del oficial, sino que también admite configuraciones de umbrales de seguridad más flexibles. No se cobrarán las solicitudes interceptadas por error, por lo que puedes probar diferentes estrategias de indicación con total tranquilidad.

Haz clic para desplegar el código completo de entorno de producción

"""

Solución completa para IMAGE_SAFETY en Nano Banana Pro

Código de entorno de producción con todas las estrategias de optimización integradas

"""

import openai

import re

import time

from typing import Optional, Dict, List

from dataclasses import dataclass

@dataclass

class GenerationResult:

success: bool

image_data: Optional[str] = None

prompt_used: Optional[str] = None

attempts: int = 0

error: Optional[str] = None

class RobustImageGenerator:

"""

Generador de imágenes robusto para Nano Banana Pro

Integra múltiples estrategias para evitar IMAGE_SAFETY

"""

# Mapeo de sustitución de palabras sensibles

SENSITIVE_WORDS = {

r'\bsexy\b': 'elegant',

r'\bhot\b': 'attractive',

r'\bbikini\b': 'swimwear',

r'\blingerie\b': 'intimate apparel',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\bgirl\b': 'young woman',

r'\bboy\b': 'young man',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bhentai\b': 'artwork',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bknife\b': 'utensil',

r'\bblood\b': 'red fluid',

r'\bviolent\b': 'dynamic',

r'\bnude\b': 'unclothed',

r'\bnaked\b': 'without clothing',

}

# Plantillas de contexto de seguridad

SAFETY_CONTEXTS = [

"", # Original

"Professional photography, ",

"High quality commercial image, ",

"Editorial style, tasteful, ",

"Clean and family-friendly, ",

]

def __init__(self, api_key: str, base_url: str = "https://api.apiyi.com/v1"):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

def sanitize_prompt(self, prompt: str) -> str:

"""Sustituir palabras sensibles"""

sanitized = prompt

for pattern, replacement in self.SENSITIVE_WORDS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

def generate_variations(self, prompt: str) -> List[str]:

"""Generar variantes de la indicación"""

sanitized = self.sanitize_prompt(prompt)

variations = []

for context in self.SAFETY_CONTEXTS:

variations.append(f"{context}{sanitized}")

return variations

def generate(

self,

prompt: str,

size: str = "2048x2048",

max_retries: int = 5,

safety_threshold: str = "BLOCK_MEDIUM_AND_ABOVE"

) -> GenerationResult:

"""

Generar imagen con procesamiento completo de IMAGE_SAFETY

Args:

prompt: Indicación original

size: Tamaño de imagen

max_retries: Máximo de reintentos

safety_threshold: Umbral de seguridad

Returns:

Objeto GenerationResult

"""

variations = self.generate_variations(prompt)

attempts = 0

for variation in variations[:max_retries]:

attempts += 1

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt=variation,

size=size,

extra_body={

"safety_settings": [

{"category": cat, "threshold": safety_threshold}

for cat in [

"HARM_CATEGORY_SEXUALLY_EXPLICIT",

"HARM_CATEGORY_DANGEROUS_CONTENT",

"HARM_CATEGORY_HARASSMENT",

"HARM_CATEGORY_HATE_SPEECH"

]

]

}

)

return GenerationResult(

success=True,

image_data=response.data[0].b64_json,

prompt_used=variation,

attempts=attempts

)

except Exception as e:

error_msg = str(e)

if any(keyword in error_msg for keyword in

["IMAGE_SAFETY", "PROHIBITED_CONTENT", "SAFETY"]):

time.sleep(0.5)

continue

else:

return GenerationResult(

success=False,

attempts=attempts,

error=error_msg

)

return GenerationResult(

success=False,

attempts=attempts,

error="Todas las variantes fueron bloqueadas por el filtro de seguridad"

)

# Ejemplo de uso

if __name__ == "__main__":

generator = RobustImageGenerator(api_key="tu-api-key")

# Casos de prueba

test_prompts = [

"anime girl in bikini", # Riesgo alto

"child playing in park", # Riesgo medio

"fashion model in elegant dress", # Riesgo bajo

]

for prompt in test_prompts:

print(f"\nPrueba: {prompt}")

result = generator.generate(prompt)

if result.success:

print(f" ✅ Éxito (Intento {result.attempts})")

print(f" Indicación utilizada: {result.prompt_used[:60]}...")

else:

print(f" ❌ Fallo: {result.error}")

Preguntas frecuentes sobre IMAGE_SAFETY en Nano Banana Pro

P1: ¿Por qué mis imágenes de productos normales también activan IMAGE_SAFETY?

El filtro de seguridad de Google utiliza una estrategia conservadora de "mejor prevenir que lamentar". Los siguientes tipos de imágenes de productos suelen ser interceptados por error:

- Lencería / Trajes de baño: Incluso las fotos legítimas de comercio electrónico pueden activar la detección de contenido sexual.

- Productos relacionados con el cuerpo: Como masajeadores, dispositivos de belleza u otros productos que tengan contacto con la piel.

- Artículos infantiles: Cualquier contenido que involucre a niños activará el filtrado más estricto.

Solución: Añade un contexto comercial explícito, como "e-commerce product photo" o "catalog image", y asegúrate de que el fondo de la imagen sea sencillo. Utiliza la plataforma APIYI (apiyi.com) para probar diferentes combinaciones de indicaciones y encontrar la mejor solución.

P2: ¿Por qué sigue siendo interceptado incluso si configuré BLOCK_NONE?

Incluso si estableces todos los umbrales de seguridad configurables en BLOCK_NONE, existen filtros fijos que no se pueden omitir:

| Tipo de filtro | Configurable | Descripción |

|---|---|---|

| 4 categorías de riesgo principales | ✅ | Ajustables mediante safety_settings |

| Detección de CSAM | ❌ | Siempre activo, no configurable |

| Detección de PII | ❌ | Siempre activo, no configurable |

| Detección de derechos de autor | ❌ | Celebridades, marcas registradas, etc. |

Si tu contenido no está relacionado con estas categorías fijas, intenta reescribir la indicación o cambiar el estilo artístico.

P3: ¿Se cobran las solicitudes que han sido interceptadas?

Según la documentación oficial de Google, las imágenes bloqueadas por el filtro de seguridad no se facturan. Como puedes ver en la respuesta recibida, candidatesTokenCount: 0, lo que indica que no se generó ninguna salida y, por lo tanto, no se genera ningún cargo.

Sin embargo, ten en cuenta que thoughtsTokenCount: 293 indica que el modelo realizó un razonamiento interno. En algunos modelos de facturación, los tokens de pensamiento ("thoughts") podrían contabilizarse. Al llamar a través de la plataforma APIYI, las solicitudes interceptadas no se cobran en absoluto, por lo que puedes realizar múltiples intentos con total tranquilidad.

P4: ¿Cómo distinguir si es un problema de entrada (input) o de salida (output)?

Puedes determinarlo a partir de la respuesta de error:

| Característica | Problema de entrada | Problema de salida |

|---|---|---|

promptTokenCount |

Puede ser 0 | Conteo normal |

thoughtsTokenCount |

0 | Tiene un valor (ej. 293) |

| Tipo de error | BLOCKED_PROMPT | IMAGE_SAFETY |

En tu caso, un thoughtsTokenCount: 293 indica que la interceptación ocurrió en la etapa de salida; el modelo completó el razonamiento, pero la imagen generada activó el filtro. La solución es ajustar la indicación para guiar al modelo a generar contenido más seguro.

Resumen de soluciones para IMAGE_SAFETY en Nano Banana Pro

Este artículo presenta 8 métodos para solucionar el error IMAGE_SAFETY en Nano Banana Pro:

| Solución | Escenario de uso | Dificultad | Calificación |

|---|---|---|---|

| Reescribir indicación | Todos los escenarios | Baja | ⭐⭐⭐⭐⭐ |

| Cambiar estilo artístico | Anime / Ilustración | Baja | ⭐⭐⭐⭐ |

| Ajustar umbral de seguridad | Permisos de configuración API | Media | ⭐⭐⭐⭐ |

| Generación por pasos | Escenas complejas | Media | ⭐⭐⭐ |

| Modo edición de imagen | Modificar sobre base existente | Media | ⭐⭐⭐⭐ |

| Añadir contexto seguro | Escenarios comerciales/profesionales | Baja | ⭐⭐⭐⭐ |

| Reintento inteligente | Entornos de producción | Alta | ⭐⭐⭐⭐⭐ |

| Elegir proveedor adecuado | Uso a largo plazo | Baja | ⭐⭐⭐⭐ |

Sugerencia principal: Al combinar "Reescritura de indicación + Contexto seguro + Reintento inteligente", puedes elevar la tasa de éxito del 60% a más del 95%.

🎯 Recomendación final: Te sugerimos usar Nano Banana Pro a través de APIYI (apiyi.com). La plataforma ofrece opciones de seguridad más flexibles, las solicitudes bloqueadas no se facturan y el precio de $0.05 por imagen reduce drásticamente los costos de depuración. Puedes validar rápidamente si tus indicaciones activan filtros con la herramienta online imagen.apiyi.com.

Este artículo fue escrito por el equipo técnico de APIYI. Para más trucos sobre APIs de generación de imágenes por IA, visita apiyi.com.