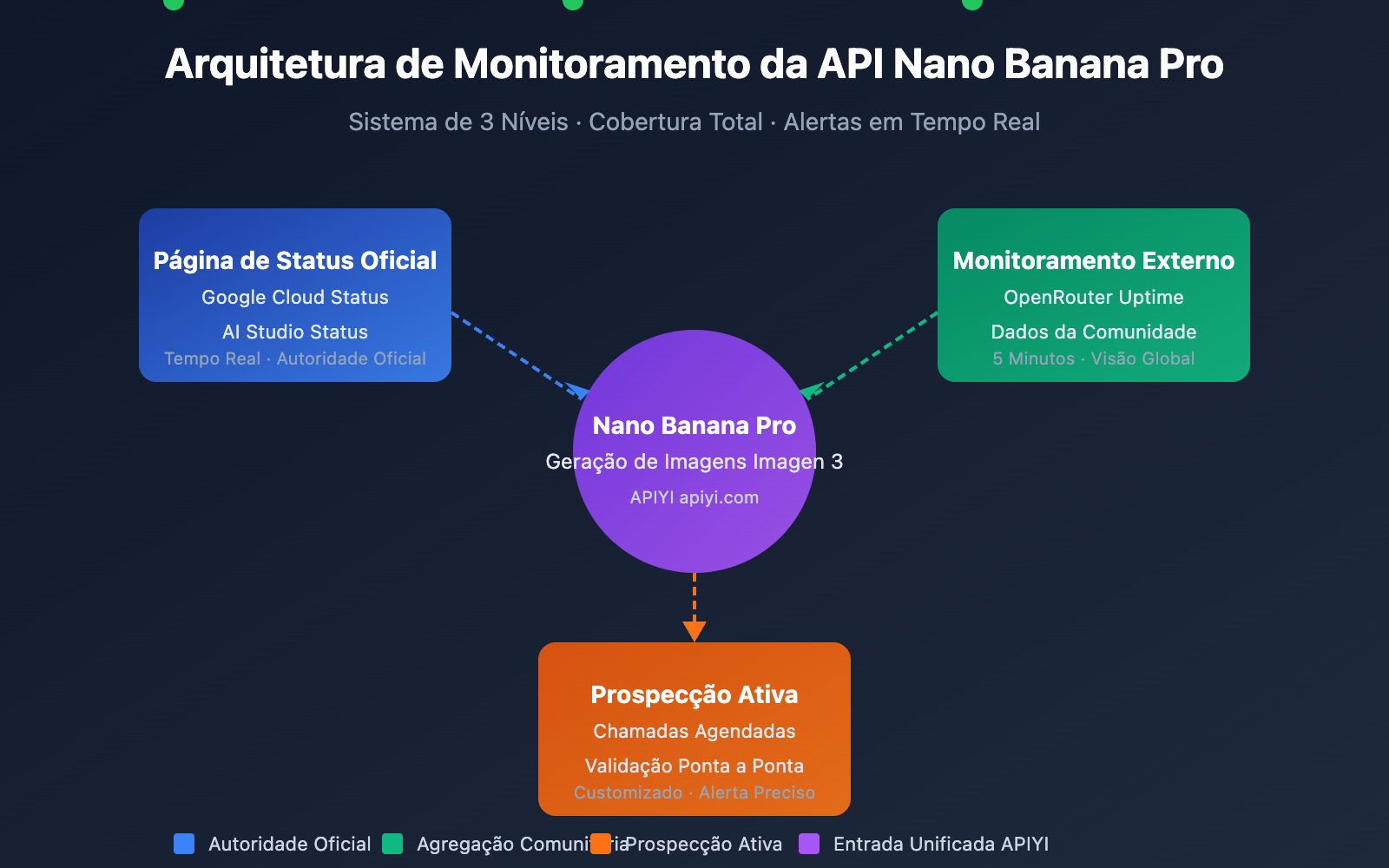

Monitorar a disponibilidade da API do Nano Banana Pro é uma necessidade crítica para desenvolvedores que desejam garantir a operação estável de seus serviços de geração de imagens. Este artigo apresentará 3 métodos práticos de monitoramento da API do Nano Banana Pro para ajudá-lo a acompanhar o status do serviço em tempo real e responder rapidamente a falhas.

Valor central: Ao ler este artigo, você aprenderá a usar as páginas de status oficiais do Google e ferramentas de monitoramento de terceiros, como o OpenRouter, para estabelecer um sistema completo de monitoramento de disponibilidade para a API do Nano Banana Pro.

Pontos-chave do monitoramento da API do Nano Banana Pro

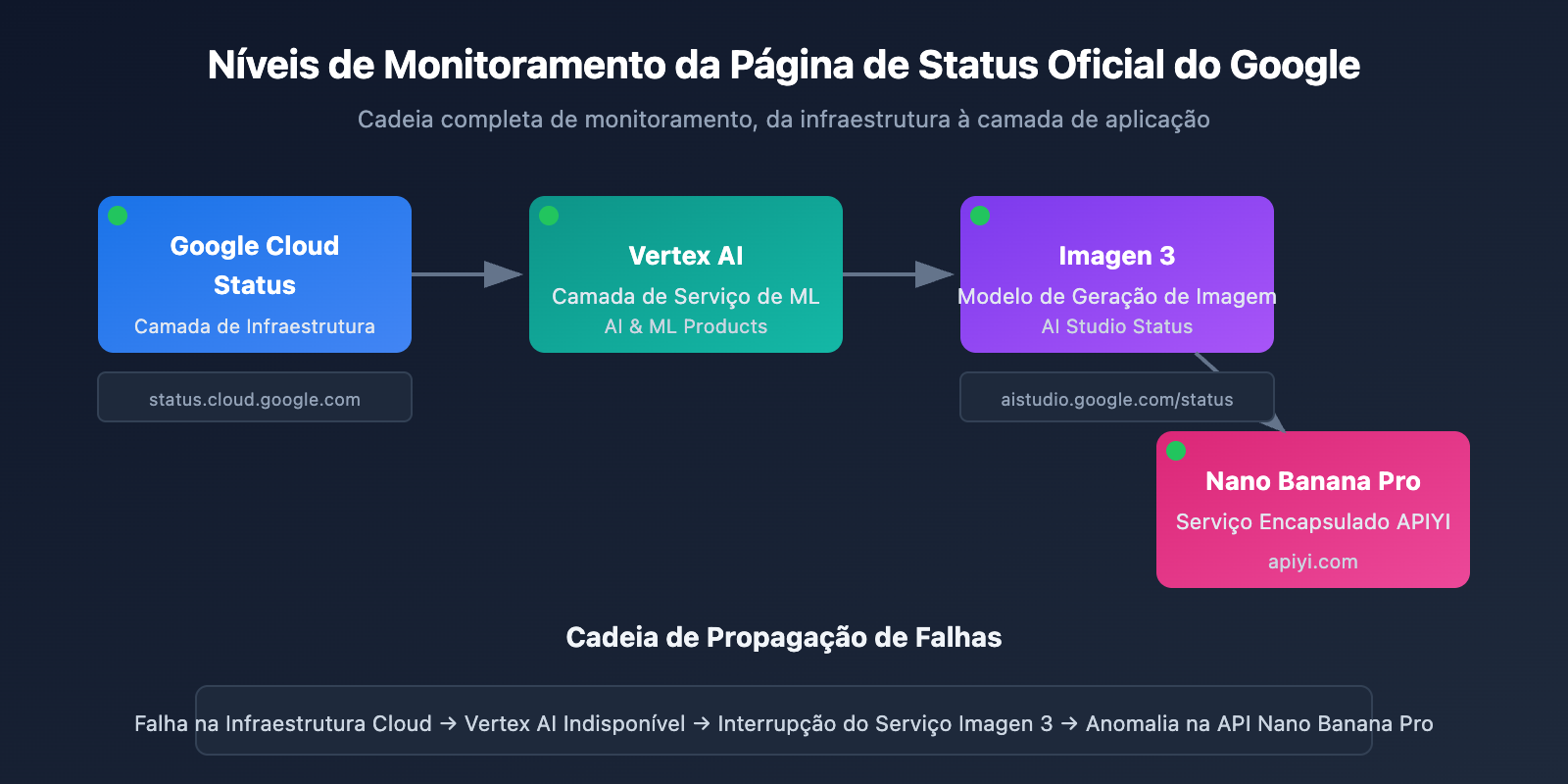

O Nano Banana Pro (baseado no Google Imagen 3) é um dos modelos de geração de imagens por IA mais poderosos da atualidade. Como sua base depende da infraestrutura do Google Cloud, a estratégia de monitoramento precisa cobrir vários níveis.

| Nível de Monitoramento | Fonte de Monitoramento | Conteúdo do Monitoramento | Frequência de Atualização |

|---|---|---|---|

| Camada de Infraestrutura | Google Cloud Status | Serviços de computação, rede e armazenamento | Tempo real |

| Camada de Serviço de IA | AI Studio Status | Serviços dos modelos Gemini e Imagen | Tempo real |

| Agregação de Terceiros | OpenRouter Uptime | Taxa de resposta da API, estatísticas de latência | 5 minutos |

| Prospecção Ativa | Scripts de monitoramento próprios | Testes de disponibilidade ponta a ponta | Personalizado |

Principais indicadores de monitoramento da API do Nano Banana Pro

Ao monitorar a API do Nano Banana Pro, você deve focar nos seguintes indicadores principais:

| Nome do Indicador | Faixa Normal | Limiar de Alerta | Descrição |

|---|---|---|---|

| Disponibilidade da API | ≥ 99.5% | < 99% | Disponibilidade geral do serviço |

| Latência de Resposta | 5-15 segundos | > 30 segundos | Tempo gasto na geração da imagem |

| Taxa de Erro | < 1% | > 5% | Proporção de falhas nas requisições |

| Gatilhos de Limitação | 0 vezes/hora | > 10 vezes/hora | Hit no Rate Limit |

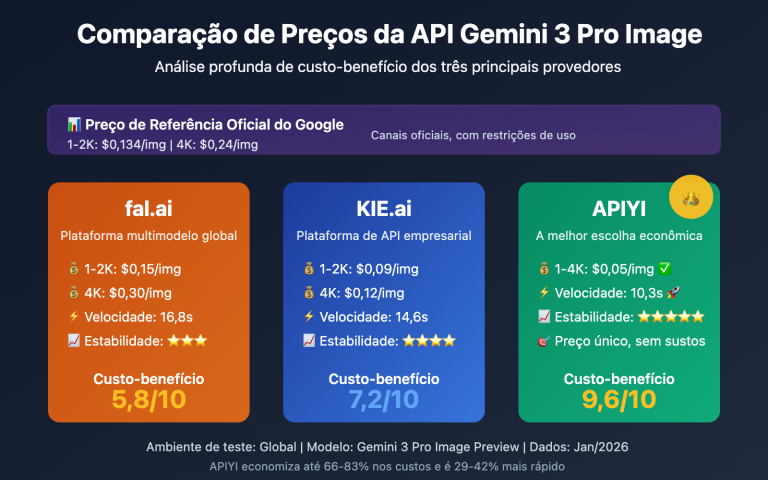

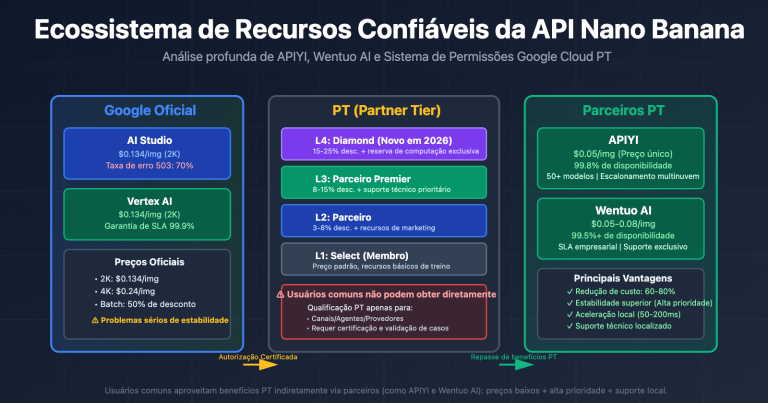

🎯 Dica técnica: No desenvolvimento real, recomendamos realizar as chamadas da API do Nano Banana Pro através da plataforma APIYI (apiyi.com). Esta plataforma oferece monitoramento de status e serviços de alerta unificados, reduzindo os custos de criar seu próprio sistema de monitoramento.

Método de Monitoramento 1 da API Nano Banana Pro: Página de Status Oficial do Google

Monitoramento do Google Cloud Status

A página Google Cloud Status fornece informações em tempo real sobre a infraestrutura do Google, sendo a principal fonte para monitorar os serviços subjacentes do Nano Banana Pro.

Endereço da página de status oficial: status.cloud.google.com

Serviços Críticos de Monitoramento

| Nome do Serviço | Localização na Página de Status | Escopo de Impacto |

|---|---|---|

| Vertex AI | AI & Machine Learning | Afeta diretamente o Imagen 3 |

| Cloud Storage | Storage | Afeta o armazenamento e retorno de imagens |

| Cloud Run | Compute | Afeta o serviço de gateway da API |

| Cloud Load Balancing | Networking | Afeta o roteamento de solicitações |

Configurações de Assinatura de Status

O Google Cloud Status suporta vários métodos de assinatura:

# Exemplo: Usando a API do Google Cloud Status para obter o status

import requests

def check_google_cloud_status():

"""

Verifica o status dos serviços do Google Cloud

Chamada via interface unificada da APIYI apiyi.com

"""

# Google Cloud Status RSS Feed

status_url = "https://status.cloud.google.com/incidents.json"

try:

response = requests.get(status_url, timeout=10)

incidents = response.json()

# Filtrar eventos relacionados ao Vertex AI

vertex_incidents = [

inc for inc in incidents

if 'Vertex AI' in str(inc.get('affected_products', []))

]

return {

'status': 'healthy' if not vertex_incidents else 'degraded',

'incidents': vertex_incidents

}

except Exception as e:

return {'status': 'unknown', 'error': str(e)}

# Executar verificação

result = check_google_cloud_status()

print(f"Status do Vertex AI: {result['status']}")

Monitoramento do Status do AI Studio

O Google AI Studio oferece uma página de status exclusiva para os modelos Gemini e Imagen.

Endereço da página de status do AI Studio: aistudio.google.com/status

| Item de Monitoramento | Descrição | Frequência de Verificação |

|---|---|---|

| Gemini Models | Status do modelo de geração de texto | Tempo real |

| Imagen Models | Status do modelo de geração de imagem | Tempo real |

| API Quota | Uso de cota | Por hora |

| Regional Status | Status do serviço por região | Tempo real |

Ver código completo de monitoramento de status do AI Studio

import requests

from datetime import datetime, timedelta

import json

class AIStudioMonitor:

"""

Classe de monitoramento de status do AI Studio

Adequado para monitorar o status do serviço Nano Banana Pro (Imagen 3)

"""

def __init__(self, api_key: str):

self.api_key = api_key

# Usa a interface unificada da APIYI

self.base_url = "https://api.apiyi.com/v1"

self.status_history = []

def check_imagen_health(self) -> dict:

"""

Detecta o estado de saúde do serviço Imagen 3 através de chamadas de API reais

"""

try:

headers = {

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

}

# Envia uma solicitação de teste leve

test_payload = {

"model": "nano-banana-pro",

"prompt": "health check test",

"n": 1,

"size": "256x256" # Tamanho mínimo para reduzir custos

}

start_time = datetime.now()

response = requests.post(

f"{self.base_url}/images/generations",

headers=headers,

json=test_payload,

timeout=60

)

latency = (datetime.now() - start_time).total_seconds()

if response.status_code == 200:

return {

'status': 'healthy',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

elif response.status_code == 429:

return {

'status': 'rate_limited',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

else:

return {

'status': 'degraded',

'error_code': response.status_code,

'timestamp': datetime.now().isoformat()

}

except requests.Timeout:

return {

'status': 'timeout',

'timestamp': datetime.now().isoformat()

}

except Exception as e:

return {

'status': 'error',

'error': str(e),

'timestamp': datetime.now().isoformat()

}

def get_uptime_stats(self, hours: int = 24) -> dict:

"""

Calcula estatísticas de disponibilidade para as últimas N horas

"""

cutoff = datetime.now() - timedelta(hours=hours)

recent_checks = [

s for s in self.status_history

if datetime.fromisoformat(s['timestamp']) > cutoff

]

if not recent_checks:

return {'uptime': 'N/A', 'sample_count': 0}

healthy_count = sum(1 for s in recent_checks if s['status'] == 'healthy')

uptime_pct = (healthy_count / len(recent_checks)) * 100

return {

'uptime': f"{uptime_pct:.2f}%",

'sample_count': len(recent_checks),

'healthy_count': healthy_count,

'period_hours': hours

}

# Exemplo de uso

monitor = AIStudioMonitor(api_key="seu-token-apiyi")

health = monitor.check_imagen_health()

print(f"Estado de saúde do Nano Banana Pro: {health}")

💡 Sugestão de Escolha: A escolha da solução de monitoramento depende das suas necessidades específicas. Recomendamos realizar testes de chamada de API através da plataforma APIYI apiyi.com, que oferece um painel de monitoramento de status integrado para visualizar rapidamente a disponibilidade do serviço.

Método de Monitoramento 2 da API Nano Banana Pro: Monitoramento de Terceiros via OpenRouter

O OpenRouter oferece serviços profissionais de monitoramento de modelos de IA de terceiros, sendo um complemento importante para monitorar a disponibilidade da API Nano Banana Pro.

Página de Monitoramento de Uptime do OpenRouter

Endereço de monitoramento do Nano Banana Pro: openrouter.ai/google/gemini-3-pro-image-preview/uptime

Interpretando os Dados de Monitoramento do OpenRouter

| Métrica | Significado | Valor de Referência |

|---|---|---|

| Uptime % | Disponibilidade nos últimos 30 dias | ≥ 99% é excelente |

| Avg Latency | Latência média de resposta | 10-20s é normal para geração de imagens |

| P95 Latency | Latência de 95% das requisições | < 30s é normal |

| Error Rate | Taxa de erro de requisição | < 2% é saudável |

| Throughput | Vazão de requisições | Reflete a popularidade do modelo |

Script para Obter Dados de Monitoramento

import requests

from bs4 import BeautifulSoup

import json

def get_openrouter_uptime(model_id: str = "google/gemini-3-pro-image-preview"):

"""

Obtém dados de disponibilidade de modelos do OpenRouter

Aplicável ao monitoramento do Nano Banana Pro (Imagen 3)

"""

uptime_url = f"https://openrouter.ai/{model_id}/uptime"

# Nota: O OpenRouter pode exigir chamadas de API para obter dados detalhados

# Aqui mostramos a lógica básica de verificação de disponibilidade

try:

# Obtém informações do modelo via API do OpenRouter

api_url = "https://openrouter.ai/api/v1/models"

response = requests.get(api_url, timeout=10)

models = response.json().get('data', [])

# Procura o modelo alvo

target_model = next(

(m for m in models if m.get('id') == model_id),

None

)

if target_model:

return {

'model_id': model_id,

'status': 'available' if target_model else 'unknown',

'pricing': target_model.get('pricing', {}),

'context_length': target_model.get('context_length'),

'uptime_url': uptime_url

}

else:

return {

'model_id': model_id,

'status': 'not_found',

'uptime_url': uptime_url

}

except Exception as e:

return {

'model_id': model_id,

'status': 'error',

'error': str(e)

}

# Verifica o status do Nano Banana Pro

nano_status = get_openrouter_uptime()

print(json.dumps(nano_status, indent=2))

Monitoramento Comparativo de Múltiplos Modelos

Através do OpenRouter, você pode monitorar simultaneamente o status de vários modelos de geração de imagem:

| Modelo | OpenRouter ID | Valor do Monitoramento |

|---|---|---|

| Nano Banana Pro | google/gemini-3-pro-image-preview | Alvo principal de monitoramento |

| DALL-E 3 | openai/dall-e-3 | Status da alternativa |

| Stable Diffusion 3 | stabilityai/stable-diffusion-3 | Status da alternativa |

| Midjourney | – | API ainda não suportada |

🚀 Começo Rápido: Recomendamos usar a plataforma APIYI (apiyi.com) para criar protótipos de geração de imagem rapidamente. A plataforma oferece alternância de modelos pronta para uso, mudando automaticamente para um modelo reserva se o principal estiver indisponível.

Método de monitoramento 3 da API Nano Banana Pro: Detecção Ativa

Além de assinar passivamente as páginas de status, a detecção ativa é uma ferramenta fundamental para garantir a estabilidade do seu negócio.

Script de detecção agendada

import openai

import time

import json

from datetime import datetime

import schedule

# Usando a interface unificada da APIYI

client = openai.OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1"

)

class NanoBananaProMonitor:

"""

Monitoramento por detecção ativa da API Nano Banana Pro

"""

def __init__(self):

self.check_results = []

self.alert_threshold = 3 # Dispara alerta após 3 falhas consecutivas

self.consecutive_failures = 0

def health_check(self) -> dict:

"""

Executa uma verificação de integridade (health check)

"""

start_time = time.time()

try:

response = client.images.generate(

model="nano-banana-pro",

prompt="A simple red circle on white background",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = {

'timestamp': datetime.now().isoformat(),

'status': 'success',

'latency': round(latency, 2),

'model': 'nano-banana-pro'

}

self.consecutive_failures = 0

except openai.RateLimitError:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'rate_limited',

'latency': time.time() - start_time,

'model': 'nano-banana-pro'

}

# O limite de taxa (rate limit) não é contado como falha

except openai.APIError as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'api_error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

except Exception as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

self.check_results.append(result)

# Verifica se é necessário disparar um alerta

if self.consecutive_failures >= self.alert_threshold:

self.send_alert(result)

return result

def send_alert(self, result: dict):

"""

Envia notificações de alerta.

Pode ser integrado ao: WeChat Work, DingTalk, Feishu, Slack, e-mail, etc.

"""

alert_message = f"""

🚨 Alerta da API Nano Banana Pro

Status: {result.get('status')}

Horário: {result.get('timestamp')}

Erro: {result.get('error', 'N/A')}

Falhas consecutivas: {self.consecutive_failures} vezes

"""

print(alert_message)

# No projeto real, conecte aos seus canais de notificação

# self.send_wechat(alert_message)

# self.send_feishu(alert_message)

def get_statistics(self, hours: int = 24) -> dict:

"""

Obtém dados estatísticos de monitoramento

"""

from datetime import timedelta

cutoff = datetime.now() - timedelta(hours=hours)

recent = [

r for r in self.check_results

if datetime.fromisoformat(r['timestamp']) > cutoff

]

if not recent:

return {'message': 'Nenhum dado disponível'}

success_count = sum(1 for r in recent if r['status'] == 'success')

total_count = len(recent)

latencies = [r['latency'] for r in recent if 'latency' in r and r['status'] == 'success']

avg_latency = sum(latencies) / len(latencies) if latencies else 0

return {

'period_hours': hours,

'total_checks': total_count,

'success_count': success_count,

'uptime_percentage': round((success_count / total_count) * 100, 2),

'avg_latency': round(avg_latency, 2),

'last_check': recent[-1] if recent else None

}

# Cria a instância de monitoramento

monitor = NanoBananaProMonitor()

# Configura a tarefa agendada: verifica a cada 5 minutos

schedule.every(5).minutes.do(monitor.health_check)

# Executa o monitoramento (usar em ambiente de produção)

# while True:

# schedule.run_pending()

# time.sleep(1)

# Exemplo de verificação única

result = monitor.health_check()

print(json.dumps(result, indent=2, ensure_ascii=False))

Veja o código completo do sistema de monitoramento (incluindo integrações de alerta)

import openai

import requests

import time

import json

import schedule

import threading

from datetime import datetime, timedelta

from typing import Optional, List, Dict

from dataclasses import dataclass, asdict

from enum import Enum

class AlertChannel(Enum):

FEISHU = "feishu"

WECHAT = "wechat"

DINGTALK = "dingtalk"

SLACK = "slack"

EMAIL = "email"

@dataclass

class CheckResult:

timestamp: str

status: str

latency: Optional[float] = None

error: Optional[str] = None

model: str = "nano-banana-pro"

@dataclass

class AlertConfig:

enabled: bool = True

channels: List[AlertChannel] = None

threshold: int = 3

cooldown_minutes: int = 30

webhook_urls: Dict[str, str] = None

class EnterpriseMonitor:

"""

Sistema de monitoramento empresarial da API Nano Banana Pro.

Suporta alertas multicanal, persistência de dados e painel de monitoramento.

"""

def __init__(

self,

api_key: str,

base_url: str = "https://api.apiyi.com/v1",

alert_config: Optional[AlertConfig] = None

):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

self.alert_config = alert_config or AlertConfig()

self.check_results: List[CheckResult] = []

self.consecutive_failures = 0

self.last_alert_time: Optional[datetime] = None

self._lock = threading.Lock()

def health_check(self) -> CheckResult:

"""

Executa a verificação de integridade (health check)

"""

start_time = time.time()

try:

# Usando um comando simples para teste

response = self.client.images.generate(

model="nano-banana-pro",

prompt="health check: simple geometric shape",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="success",

latency=round(latency, 2)

)

with self._lock:

self.consecutive_failures = 0

except openai.RateLimitError:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="rate_limited",

latency=round(time.time() - start_time, 2)

)

except openai.APIError as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="api_error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

except Exception as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

with self._lock:

self.check_results.append(result)

# Mantém os últimos 1000 registros

if len(self.check_results) > 1000:

self.check_results = self.check_results[-1000:]

# Verifica condições de alerta

self._check_alert(result)

return result

def _check_alert(self, result: CheckResult):

"""

Verifica se é necessário enviar um alerta

"""

if not self.alert_config.enabled:

return

if self.consecutive_failures < self.alert_config.threshold:

return

# Verifica o intervalo de "resfriamento" (cooldown) do alerta

if self.last_alert_time:

cooldown = timedelta(minutes=self.alert_config.cooldown_minutes)

if datetime.now() - self.last_alert_time < cooldown:

return

self._send_alerts(result)

self.last_alert_time = datetime.now()

def _send_alerts(self, result: CheckResult):

"""

Envia alertas por múltiplos canais

"""

message = self._format_alert_message(result)

if not self.alert_config.webhook_urls:

print(f"[ALERT] {message}")

return

for channel, webhook_url in self.alert_config.webhook_urls.items():

try:

if channel == "feishu":

self._send_feishu_alert(webhook_url, message)

elif channel == "wechat":

self._send_wechat_alert(webhook_url, message)

elif channel == "dingtalk":

self._send_dingtalk_alert(webhook_url, message)

elif channel == "slack":

self._send_slack_alert(webhook_url, message)

except Exception as e:

print(f"Failed to send {channel} alert: {e}")

def _format_alert_message(self, result: CheckResult) -> str:

"""

Formata a mensagem de alerta

"""

return f"""

🚨 Alerta de Anomalia na API Nano Banana Pro

📊 Detalhes do Status:

• Status: {result.status}

• Horário: {result.timestamp}

• Erro: {result.error or 'N/A'}

• Falhas consecutivas: {self.consecutive_failures} vezes

🔗 Fonte de monitoramento:

• Google Cloud Status: status.cloud.google.com

• OpenRouter Uptime: openrouter.ai/google/gemini-3-pro-image-preview/uptime

• Monitoramento APIYI: apiyi.com

⚡ Ações Sugeridas:

1. Verifique a página de status do Google Cloud

2. Valide se a chave da API é válida

3. Verifique o status da conexão de rede

4. Entre em contato com o suporte técnico da APIYI

""".strip()

def _send_feishu_alert(self, webhook_url: str, message: str):

"""Alerta via bot do Feishu"""

payload = {

"msg_type": "text",

"content": {"text": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_wechat_alert(self, webhook_url: str, message: str):

"""Alerta via bot do WeChat Work (Enterprise WeChat)"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_dingtalk_alert(self, webhook_url: str, message: str):

"""Alerta via bot do DingTalk"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_slack_alert(self, webhook_url: str, message: str):

"""Alerta via bot do Slack"""

payload = {"text": message}

requests.post(webhook_url, json=payload, timeout=10)

def get_dashboard_data(self) -> dict:

"""

Obtém dados para o painel de monitoramento

"""

now = datetime.now()

# Calcula estatísticas para diferentes períodos

periods = {

'1h': timedelta(hours=1),

'6h': timedelta(hours=6),

'24h': timedelta(hours=24),

'7d': timedelta(days=7)

}

stats = {}

for period_name, delta in periods.items():

cutoff = now - delta

recent = [

r for r in self.check_results

if datetime.fromisoformat(r.timestamp) > cutoff

]

if recent:

success = sum(1 for r in recent if r.status == 'success')

latencies = [r.latency for r in recent if r.latency]

stats[period_name] = {

'total': len(recent),

'success': success,

'uptime': round((success / len(recent)) * 100, 2),

'avg_latency': round(sum(latencies) / len(latencies), 2) if latencies else None

}

else:

stats[period_name] = None

return {

'model': 'nano-banana-pro',

'current_status': self.check_results[-1].status if self.check_results else 'unknown',

'consecutive_failures': self.consecutive_failures,

'statistics': stats,

'last_update': now.isoformat()

}

# Exemplo de uso

if __name__ == "__main__":

# Configuração de alertas

alert_config = AlertConfig(

enabled=True,

threshold=3,

cooldown_minutes=30,

webhook_urls={

"feishu": "https://open.feishu.cn/open-apis/bot/v2/hook/xxx",

# "wechat": "https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=xxx",

}

)

# Cria instância de monitoramento

monitor = EnterpriseMonitor(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1",

alert_config=alert_config

)

# Executa a verificação

result = monitor.health_check()

print("Resultado da verificação:", asdict(result))

# Obtém dados do painel

dashboard = monitor.get_dashboard_data()

print("Dados do painel:", json.dumps(dashboard, indent=2, ensure_ascii=False))

Configuração de Monitoramento e Alertas da API Nano Banana Pro

Integração de Canais de Alerta

| Canal | Formato do Webhook | Cenário de Uso |

|---|---|---|

| Feishu | open.feishu.cn/open-apis/bot/v2/hook/xxx | Primeira escolha para empresas na China |

| WeCom | qyapi.weixin.qq.com/cgi-bin/webhook/send | Usuários do ecossistema WeChat |

| DingTalk | oapi.dingtalk.com/robot/send | Empresas do grupo Alibaba |

| Slack | hooks.slack.com/services/xxx | Times internacionais |

| Configuração SMTP | Registros formais |

Definição de Níveis de Alerta

# Configuração de níveis de alerta

ALERT_LEVELS = {

'info': {

'triggers': ['rate_limited'],

'channels': ['log'],

'color': '#36a64f'

},

'warning': {

'triggers': ['timeout', 'degraded'],

'channels': ['feishu', 'slack'],

'color': '#ff9800'

},

'critical': {

'triggers': ['api_error', 'error'],

'channels': ['feishu', 'wechat', 'slack', 'email'],

'color': '#f44336'

}

}

💰 Otimização de Custos: Para projetos sensíveis ao orçamento, considere chamar a API Nano Banana Pro através da plataforma APIYI (apiyi.com). A plataforma oferece métodos de faturamento flexíveis e funções de monitoramento integradas, reduzindo o custo de construir seu próprio sistema de monitoramento.

Melhores Práticas de Monitoramento da API Nano Banana Pro

Combinação de Estratégias de Monitoramento

Escolha a combinação ideal de estratégias de monitoramento de acordo com a criticidade do seu negócio:

| Nível de Negócio | Página de Status Oficial | Monitoramento de Terceiros | Sondagem Ativa | Canais de Alerta |

|---|---|---|---|---|

| Core Business | ✅ Assinar | ✅ OpenRouter | ✅ 1 minuto | Múltiplos canais |

| Negócio Importante | ✅ Assinar | ✅ OpenRouter | ✅ 5 minutos | Feishu + E-mail |

| Negócio Comum | ✅ Assinar | Opcional | ✅ 15 minutos | Feishu |

| Ambiente de Teste | Opcional | – | ✅ 30 minutos | Logs |

Fluxo de Resposta a Falhas

Anomalia detectada

↓

Confirmar escopo do impacto (Produção/Teste)

↓

Verificar página de status oficial

↓

├── Falha oficial confirmada → Aguardar recuperação + Notificar usuários

├── Status oficial normal → Verificar configuração própria

│ ├── Validade da API Key

│ ├── Uso de cota (Quota)

│ ├── Status da conexão de rede

│ └── Conformidade dos parâmetros da requisição

└── Indeterminado → Contatar suporte técnico

Análise de Dados de Monitoramento

import pandas as pd

from datetime import datetime, timedelta

def analyze_monitoring_data(check_results: list) -> dict:

"""

Analisa os dados de monitoramento e gera um relatório

"""

df = pd.DataFrame(check_results)

df['timestamp'] = pd.to_datetime(df['timestamp'])

# Estatísticas por hora

df['hour'] = df['timestamp'].dt.floor('H')

hourly_stats = df.groupby('hour').agg({

'status': lambda x: (x == 'success').mean() * 100,

'latency': 'mean'

}).rename(columns={

'status': 'uptime_pct',

'latency': 'avg_latency'

})

# Identificar períodos de anomalia

anomalies = hourly_stats[hourly_stats['uptime_pct'] < 99]

# Tendência de latência diária

df['date'] = df['timestamp'].dt.date

daily_latency = df.groupby('date')['latency'].mean()

return {

'hourly_stats': hourly_stats.to_dict(),

'anomaly_periods': anomalies.index.tolist(),

'daily_latency_trend': daily_latency.to_dict(),

'overall_uptime': df[df['status'] == 'success'].shape[0] / len(df) * 100

}

Perguntas Frequentes

Q1: Qual a frequência ideal de monitoramento da API Nano Banana Pro?

A frequência de monitoramento depende da importância do seu negócio:

- Ambientes de produção críticos: Recomendamos verificar a cada 1-2 minutos.

- Negócios importantes: Verificar a cada 5 minutos.

- Negócios comuns: Verificar a cada 10-15 minutos.

Através da plataforma APIYI (apiyi.com), você pode obter créditos de teste gratuitos para validar rapidamente a viabilidade do seu plano de monitoramento. Lembre-se de equilibrar o custo do monitoramento com a velocidade de resposta necessária.

Q2: Como diferenciar oscilações temporárias de falhas reais no Nano Banana Pro?

Sugerimos adotar as seguintes estratégias:

- Limite de falhas consecutivas: Configure o alerta para disparar apenas após 3 ou mais falhas seguidas.

- Janela deslizante: Considere uma falha real apenas se a taxa de erro for superior a 50% em um intervalo de 5 minutos.

- Validação multi-fonte: Verifique simultaneamente a página de status oficial para confirmar se é um problema global.

- Descartar Rate Limit: Limitação de taxa (muitas requisições) não é o mesmo que uma falha no sistema.

Pelo painel de monitoramento da APIYI (apiyi.com), você consegue visualizar intuitivamente as tendências históricas de disponibilidade, facilitando o julgamento de falhas sistêmicas.

Q3: Os dados de monitoramento de terceiros do OpenRouter são confiáveis?

Como uma plataforma agregadora de modelos de IA bem conhecida, os dados do OpenRouter têm alto valor de referência:

- Vantagem: Agregam dados de requisições de usuários globais, oferecendo uma grande base de amostras.

- Limitação: Os dados podem incluir problemas na própria infraestrutura de rede do OpenRouter.

- Sugestão: Combine as informações da página de status oficial com seu próprio monitoramento para uma análise mais precisa.

Q4: O que fazer se o excesso de alertas de monitoramento causar fadiga?

A fadiga de alertas é um problema comum. Recomendamos:

- Definir níveis de alerta: Diferencie entre Informação, Aviso (Warning) e Crítico.

- Configurar tempo de espera (Cooldown): Configure para que o mesmo problema gere apenas um alerta a cada 30 minutos.

- Agrupar alertas: Combine problemas semelhantes em uma única notificação.

- Supressão de alertas: Desative temporariamente os alertas durante períodos de manutenção programada.

- Otimização contínua: Revise regularmente os falsos positivos e ajuste os limites de disparo.

Resumo

O monitoramento de disponibilidade da API Nano Banana Pro é fundamental para garantir a estabilidade de operações de geração de imagens. Este artigo apresentou 3 métodos práticos de monitoramento:

- Página de Status oficial do Google: Monitore o Cloud Status e o AI Studio Status para obter informações oficiais de primeira mão.

- Monitoramento de terceiros (OpenRouter): Utilize a página de Uptime do openrouter.ai para obter dados de disponibilidade da comunidade.

- Sondagem ativa: Implemente chamadas de API periódicas para realizar uma verificação de disponibilidade de ponta a ponta.

Recomendamos utilizar a APIYI (apiyi.com) para validar rapidamente a eficácia da sua estratégia de monitoramento. A plataforma oferece uma interface de API unificada e painéis de monitoramento integrados, ajudando desenvolvedores a reduzir custos operacionais.

Autor: Equipe Técnica APIYI

Troca de experiências técnicas: Visite APIYI (apiyi.com) para mais dicas e melhores práticas sobre o uso de APIs de IA.

Data de atualização: 28 de janeiro de 2026

Recursos Relacionados

| Tipo de Recurso | Descrição |

|---|---|

| Google Cloud Status | status.cloud.google.com |

| AI Studio Status | aistudio.google.com/status |

| OpenRouter Uptime | openrouter.ai/google/gemini-3-pro-image-preview/uptime |

| Site Oficial da APIYI | apiyi.com |