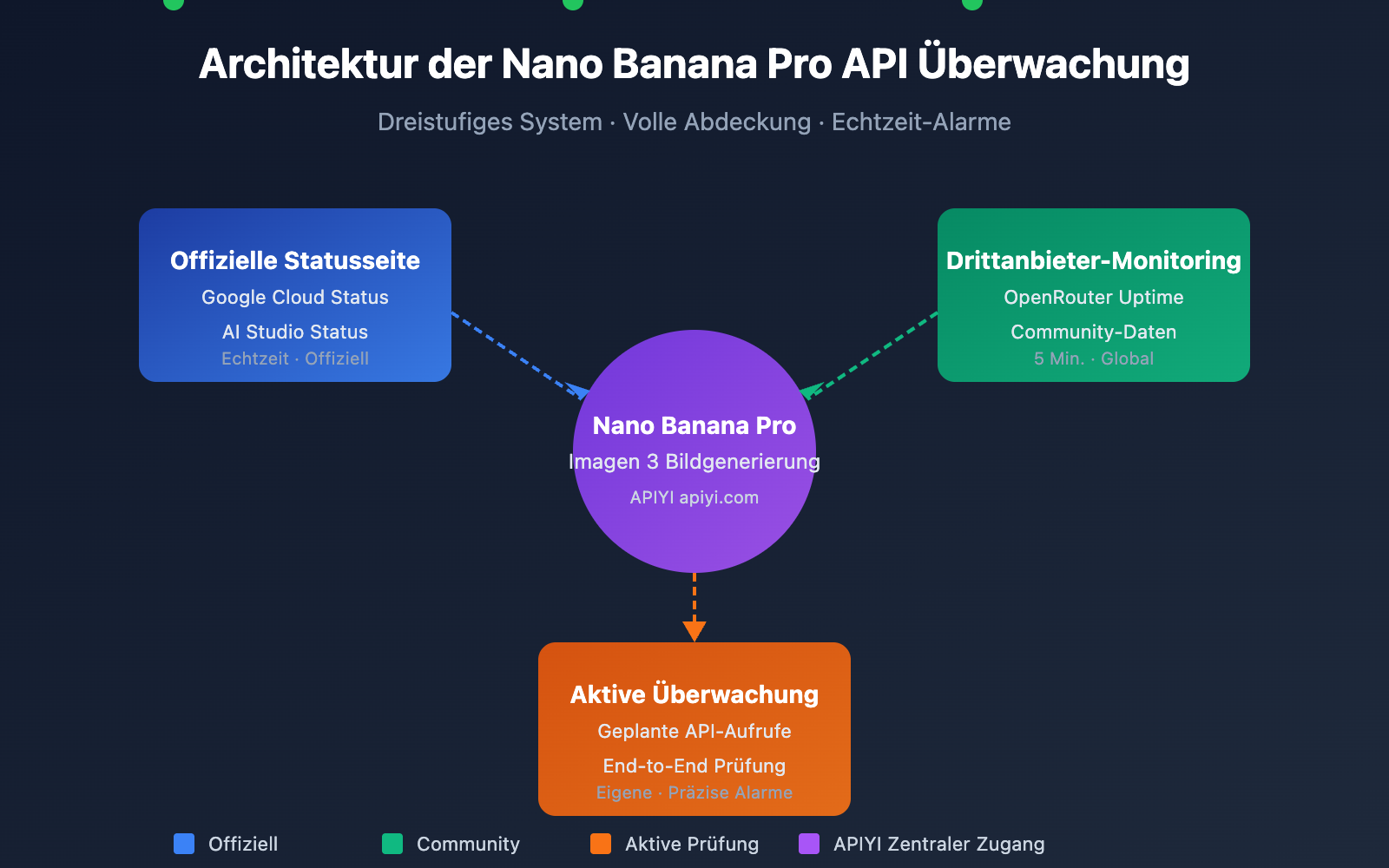

Die Überwachung der Verfügbarkeit der Nano Banana Pro API ist eine entscheidende Anforderung für Entwickler, um den stabilen Betrieb von Bildgenerierungsdiensten zu gewährleisten. In diesem Artikel stellen wir 3 praktische Methoden zur Überwachung der Nano Banana Pro API vor, mit denen Sie den Dienststatus in Echtzeit im Blick behalten und schnell auf Störungen reagieren können.

Kernvorteil: Nach der Lektüre dieses Artikels werden Sie wissen, wie Sie die offizielle Google-Statusseite und Drittanbieter-Monitoring-Tools wie OpenRouter nutzen, um ein umfassendes Überwachungssystem für die Verfügbarkeit der Nano Banana Pro API aufzubauen.

Nano Banana Pro API Monitoring: Die wichtigsten Punkte

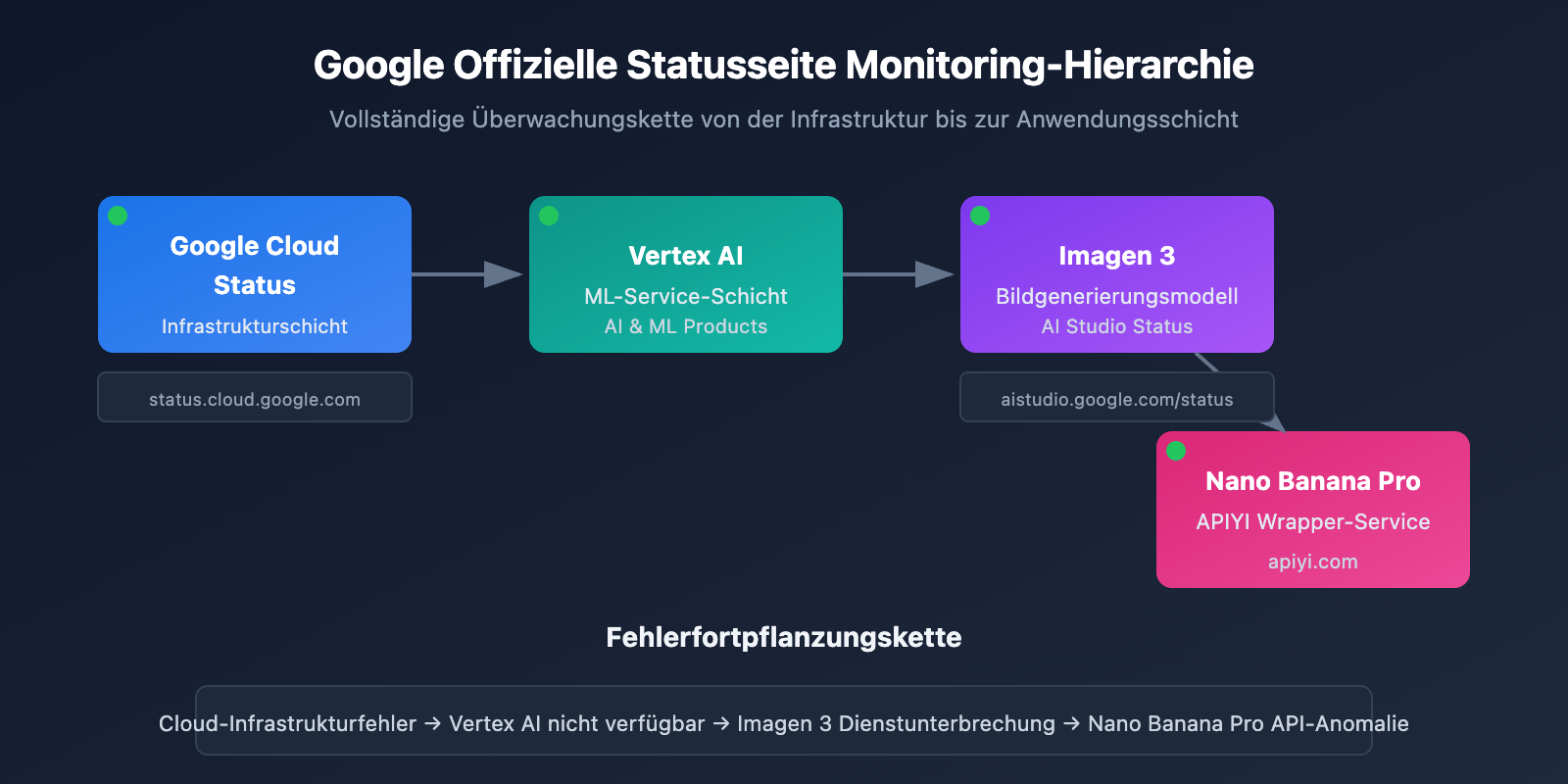

Nano Banana Pro (basierend auf Google Imagen 3) ist eines der derzeit leistungsstärksten KI-Bildgenerierungsmodelle. Da es auf der Google Cloud-Infrastruktur aufbaut, muss die Monitoring-Strategie mehrere Ebenen abdecken.

| Monitoring-Ebene | Monitoring-Quelle | Überwachte Inhalte | Aktualisierungsfrequenz |

|---|---|---|---|

| Infrastruktur | Google Cloud Status | Rechen-, Netzwerk-, Speicherdienste | Echtzeit |

| KI-Dienste | AI Studio Status | Gemini, Imagen Modell-Services | Echtzeit |

| Drittanbieter-Aggregation | OpenRouter Uptime | API-Antwortrate, Latenzstatistiken | 5 Minuten |

| Aktive Probenahme | Eigene Monitoring-Skripte | End-to-End Verfügbarkeitstests | Benutzerdefiniert |

Kennzahlen für die Überwachung der Nano Banana Pro API

Bei der Überwachung der Nano Banana Pro API sollten Sie sich auf die folgenden Kernindikatoren konzentrieren:

| Kennzahl | Normalbereich | Alarmschwelle | Beschreibung |

|---|---|---|---|

| API-Verfügbarkeit | ≥ 99,5% | < 99% | Gesamte Verfügbarkeit des Dienstes |

| Antwort-Latenz | 5-15 Sek. | > 30 Sek. | Dauer der Bildgenerierung |

| Fehlerrate | < 1% | > 5% | Anteil fehlgeschlagener Anfragen |

| Rate-Limit-Ereignisse | 0 Mal/Std. | > 10 Mal/Std. | Auslösen der Ratenbegrenzung |

🎯 Technischer Tipp: Für die Praxis empfehlen wir, Nano Banana Pro API-Aufrufe über die Plattform APIYI (apiyi.com) abzuwickeln. Diese bietet ein zentrales Status-Monitoring und Alarmdienste, was die Kosten für eine eigene Überwachungsinfrastruktur erheblich senkt.

Nano Banana Pro API Monitoring-Methode 1: Offizielle Google-Statusseite

Google Cloud Status Monitoring

Die Google Cloud Status-Seite bietet Echtzeit-Informationen zum Status der Google-Infrastruktur und ist die bevorzugte Quelle für die Überwachung der zugrunde liegenden Dienste von Nano Banana Pro.

Adresse der offiziellen Statusseite: status.cloud.google.com

Wichtige Überwachungsdienste

| Dienstname | Position auf der Statusseite | Auswirkungsbereich |

|---|---|---|

| Vertex AI | AI & Machine Learning | Direkte Auswirkung auf Imagen 3 |

| Cloud Storage | Storage | Beeinflusst Bildspeicherung und Rückgabe |

| Cloud Run | Compute | Beeinflusst API-Gateway-Dienste |

| Cloud Load Balancing | Networking | Beeinflusst das Request-Routing |

Einstellungen für Status-Abonnements

Google Cloud Status unterstützt verschiedene Abonnement-Methoden:

# Beispiel: Status über die Google Cloud Status API abrufen

import requests

def check_google_cloud_status():

"""

Überprüft den Status der Google Cloud-Dienste

Aufruf über die einheitliche Schnittstelle von APIYI apiyi.com

"""

# Google Cloud Status RSS Feed

status_url = "https://status.cloud.google.com/incidents.json"

try:

response = requests.get(status_url, timeout=10)

incidents = response.json()

# Filtert nach Vertex AI-bezogenen Ereignissen

vertex_incidents = [

inc for inc in incidents

if 'Vertex AI' in str(inc.get('affected_products', []))

]

return {

'status': 'healthy' if not vertex_incidents else 'degraded',

'incidents': vertex_incidents

}

except Exception as e:

return {'status': 'unknown', 'error': str(e)}

# Prüfung ausführen

result = check_google_cloud_status()

print(f"Vertex AI Status: {result['status']}")

AI Studio Status Monitoring

Google AI Studio bietet eine dedizierte Statusseite für Gemini- und Imagen-Modelle.

Adresse der AI Studio Statusseite: aistudio.google.com/status

| Überwachungspunkt | Beschreibung | Prüfintervall |

|---|---|---|

| Gemini Models | Status der Textgenerierungsmodelle | Echtzeit |

| Imagen Models | Status der Bildgenerierungsmodelle | Echtzeit |

| API Quota | Kontingentnutzung | Stündlich |

| Regional Status | Status der regionalen Dienste | Echtzeit |

Vollständigen Code für AI Studio Status-Monitoring anzeigen

import requests

from datetime import datetime, timedelta

import json

class AIStudioMonitor:

"""

AI Studio Status-Monitoring-Klasse

Geeignet zur Überwachung des Nano Banana Pro (Imagen 3) Dienststatus

"""

def __init__(self, api_key: str):

self.api_key = api_key

# Nutzt die einheitliche Schnittstelle von APIYI

self.base_url = "https://api.apiyi.com/v1"

self.status_history = []

def check_imagen_health(self) -> dict:

"""

Überprüft den Gesundheitszustand des Imagen 3 Dienstes durch tatsächliche API-Aufrufe

"""

try:

headers = {

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

}

# Sendet eine leichtgewichtige Testanfrage

test_payload = {

"model": "nano-banana-pro",

"prompt": "health check test",

"n": 1,

"size": "256x256" # Minimale Größe zur Kostensenkung

}

start_time = datetime.now()

response = requests.post(

f"{self.base_url}/images/generations",

headers=headers,

json=test_payload,

timeout=60

)

latency = (datetime.now() - start_time).total_seconds()

if response.status_code == 200:

return {

'status': 'healthy',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

elif response.status_code == 429:

return {

'status': 'rate_limited',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

else:

return {

'status': 'degraded',

'error_code': response.status_code,

'timestamp': datetime.now().isoformat()

}

except requests.Timeout:

return {

'status': 'timeout',

'timestamp': datetime.now().isoformat()

}

except Exception as e:

return {

'status': 'error',

'error': str(e),

'timestamp': datetime.now().isoformat()

}

def get_uptime_stats(self, hours: int = 24) -> dict:

"""

Berechnet die Verfügbarkeitsstatistik für die letzten N Stunden

"""

cutoff = datetime.now() - timedelta(hours=hours)

recent_checks = [

s for s in self.status_history

if datetime.fromisoformat(s['timestamp']) > cutoff

]

if not recent_checks:

return {'uptime': 'N/A', 'sample_count': 0}

healthy_count = sum(1 for s in recent_checks if s['status'] == 'healthy')

uptime_pct = (healthy_count / len(recent_checks)) * 100

return {

'uptime': f"{uptime_pct:.2f}%",

'sample_count': len(recent_checks),

'healthy_count': healthy_count,

'period_hours': hours

}

# Anwendungsbeispiel

monitor = AIStudioMonitor(api_key="your-apiyi-key")

health = monitor.check_imagen_health()

print(f"Nano Banana Pro Gesundheitsstatus: {health}")

💡 Empfehlung: Die Wahl der Monitoring-Lösung hängt primär von Ihren spezifischen Anforderungen ab. Wir empfehlen API-Aufruftests über die Plattform APIYI apiyi.com, da diese ein integriertes Status-Dashboard bietet, um die Dienstverfügbarkeit schnell einzusehen.

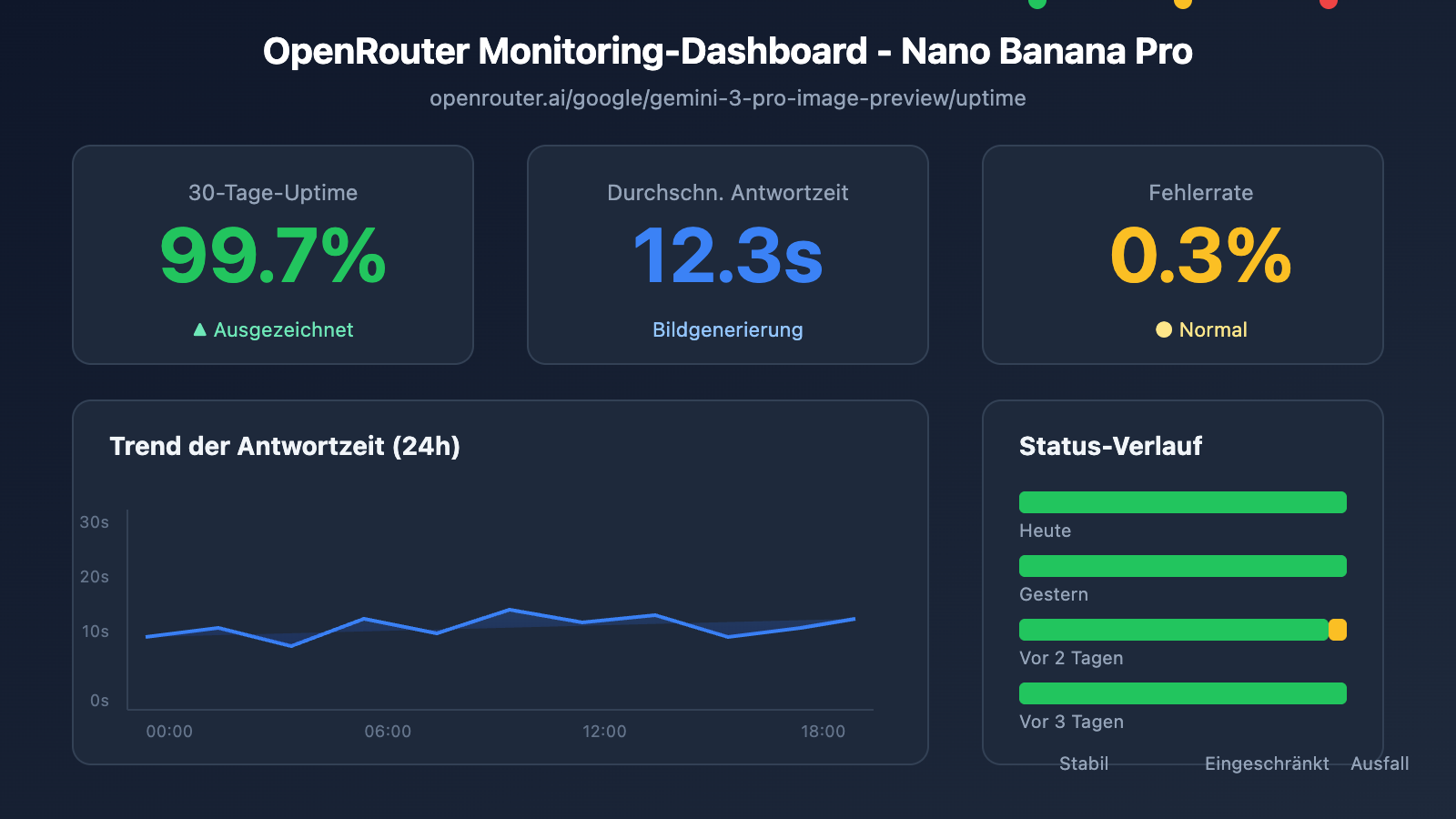

Nano Banana Pro API Monitoring Methode 2: Drittanbieter-Monitoring via OpenRouter

OpenRouter bietet professionelle Monitoring-Dienste für KI-Modelle von Drittanbietern an und stellt eine wichtige Ergänzung zur Überwachung der Verfügbarkeit der Nano Banana Pro API dar.

OpenRouter Uptime Monitoring-Seite

Nano Banana Pro Monitoring-Adresse: openrouter.ai/google/gemini-3-pro-image-preview/uptime

Interpretation der OpenRouter-Monitoring-Daten

| Metrik | Bedeutung | Referenzwert |

|---|---|---|

| Uptime % | Verfügbarkeit in den letzten 30 Tagen | ≥ 99% ist exzellent |

| Avg Latency | Durchschnittliche Antwortverzögerung | 10-20s sind bei Bildgenerierung normal |

| P95 Latency | Latenz von 95% der Anfragen | < 30s ist normal |

| Error Rate | Fehlerrate der Anfragen | < 2% ist gesund |

| Throughput | Anfragedurchsatz | Spiegelt die Beliebtheit des Modells wider |

Skript zum Abrufen der Monitoring-Daten

import requests

from bs4 import BeautifulSoup

import json

def get_openrouter_uptime(model_id: str = "google/gemini-3-pro-image-preview"):

"""

Ruft die Verfügbarkeitsdaten des OpenRouter-Modells ab.

Geeignet für das Nano Banana Pro (Imagen 3) Monitoring.

"""

uptime_url = f"https://openrouter.ai/{model_id}/uptime"

# Hinweis: OpenRouter erfordert möglicherweise API-Aufrufe für detaillierte Daten.

# Hier wird der grundlegende Ansatz zur Verfügbarkeitsprüfung gezeigt.

try:

# Modellinformationen über die OpenRouter API abrufen

api_url = "https://openrouter.ai/api/v1/models"

response = requests.get(api_url, timeout=10)

models = response.json().get('data', [])

# Zielmodell suchen

target_model = next(

(m for m in models if m.get('id') == model_id),

None

)

if target_model:

return {

'model_id': model_id,

'status': 'available' if target_model else 'unknown',

'pricing': target_model.get('pricing', {}),

'context_length': target_model.get('context_length'),

'uptime_url': uptime_url

}

else:

return {

'model_id': model_id,

'status': 'not_found',

'uptime_url': uptime_url

}

except Exception as e:

return {

'model_id': model_id,

'status': 'error',

'error': str(e)

}

# Status von Nano Banana Pro prüfen

nano_status = get_openrouter_uptime()

print(json.dumps(nano_status, indent=2))

Multi-Modell-Vergleichsmonitoring

Über OpenRouter können Sie den Status mehrerer Bildgenerierungsmodelle gleichzeitig überwachen:

| Modell | OpenRouter ID | Monitoring-Relevanz |

|---|---|---|

| Nano Banana Pro | google/gemini-3-pro-image-preview | Haupt-Monitoring-Ziel |

| DALL-E 3 | openai/dall-e-3 | Status der Alternative |

| Stable Diffusion 3 | stabilityai/stable-diffusion-3 | Status der Alternative |

| Midjourney | – | Aktuell keine API-Unterstützung |

🚀 Schnellstart: Wir empfehlen die Plattform APIYI (apiyi.com) für den schnellen Aufbau von Prototypen zur Bildgenerierung. Die Plattform bietet Out-of-the-Box-Funktionen für den Wechsel zwischen mehreren Modellen, sodass bei einem Ausfall des Hauptmodells automatisch auf ein Ersatzmodell umgeschaltet werden kann.

Nano Banana Pro API Überwachungsmethode 3: Aktives Probing

Neben dem passiven Abonnieren von Statusseiten ist das aktive Probing (aktive Überprüfung) ein entscheidendes Mittel, um die Stabilität Ihrer Geschäftsprozesse zu gewährleisten.

Skript für geplantes Probing

import openai

import time

import json

from datetime import datetime

import schedule

# Verwendung der einheitlichen APIYI-Schnittstelle

client = openai.OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1"

)

class NanoBananaProMonitor:

"""

Aktive Probing-Überwachung für die Nano Banana Pro API

"""

def __init__(self):

self.check_results = []

self.alert_threshold = 3 # Alarm wird nach 3 aufeinanderfolgenden Fehlschlägen ausgelöst

self.consecutive_failures = 0

def health_check(self) -> dict:

"""

Führt einen Health Check durch

"""

start_time = time.time()

try:

response = client.images.generate(

model="nano-banana-pro",

prompt="A simple red circle on white background",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = {

'timestamp': datetime.now().isoformat(),

'status': 'success',

'latency': round(latency, 2),

'model': 'nano-banana-pro'

}

self.consecutive_failures = 0

except openai.RateLimitError:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'rate_limited',

'latency': time.time() - start_time,

'model': 'nano-banana-pro'

}

# Rate Limit wird nicht als Fehler gezählt

except openai.APIError as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'api_error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

except Exception as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

self.check_results.append(result)

# Überprüfen, ob ein Alarm gesendet werden muss

if self.consecutive_failures >= self.alert_threshold:

self.send_alert(result)

return result

def send_alert(self, result: dict):

"""

Sendet Alarmbenachrichtigungen

Anbindungen möglich an: WeChat Work, DingTalk, Feishu, Slack, E-Mail etc.

"""

alert_message = f"""

🚨 Nano Banana Pro API Alarm

Status: {result.get('status')}

Zeit: {result.get('timestamp')}

Fehler: {result.get('error', 'N/A')}

Aufeinanderfolgende Fehler: {self.consecutive_failures} Mal

"""

print(alert_message)

# In realen Projekten an Benachrichtigungskanäle anbinden

# self.send_wechat(alert_message)

# self.send_feishu(alert_message)

def get_statistics(self, hours: int = 24) -> dict:

"""

Erfasst Überwachungsstatistiken

"""

from datetime import timedelta

cutoff = datetime.now() - timedelta(hours=hours)

recent = [

r for r in self.check_results

if datetime.fromisoformat(r['timestamp']) > cutoff

]

if not recent:

return {'message': 'No data available'}

success_count = sum(1 for r in recent if r['status'] == 'success')

total_count = len(recent)

latencies = [r['latency'] for r in recent if 'latency' in r and r['status'] == 'success']

avg_latency = sum(latencies) / len(latencies) if latencies else 0

return {

'period_hours': hours,

'total_checks': total_count,

'success_count': success_count,

'uptime_percentage': round((success_count / total_count) * 100, 2),

'avg_latency': round(avg_latency, 2),

'last_check': recent[-1] if recent else None

}

# Monitoring-Instanz erstellen

monitor = NanoBananaProMonitor()

# Geplante Aufgabe einrichten: Alle 5 Minuten prüfen

schedule.every(5).minutes.do(monitor.health_check)

# Überwachung ausführen (für Produktionsumgebungen)

# while True:

# schedule.run_pending()

# time.sleep(1)

# Beispiel für einen Einzelcheck

result = monitor.health_check()

print(json.dumps(result, indent=2, ensure_ascii=False))

Vollständigen Code des Überwachungssystems anzeigen (einschließlich Alarmanbindung)

import openai

import requests

import time

import json

import schedule

import threading

from datetime import datetime, timedelta

from typing import Optional, List, Dict

from dataclasses import dataclass, asdict

from enum import Enum

class AlertChannel(Enum):

FEISHU = "feishu"

WECHAT = "wechat"

DINGTALK = "dingtalk"

SLACK = "slack"

EMAIL = "email"

@dataclass

class CheckResult:

timestamp: str

status: str

latency: Optional[float] = None

error: Optional[str] = None

model: str = "nano-banana-pro"

@dataclass

class AlertConfig:

enabled: bool = True

channels: List[AlertChannel] = None

threshold: int = 3

cooldown_minutes: int = 30

webhook_urls: Dict[str, str] = None

class EnterpriseMonitor:

"""

Enterprise-Level Nano Banana Pro API Überwachungssystem

Unterstützt Multi-Channel-Alarme, Datenpersistenz und Monitoring-Dashboard

"""

def __init__(

self,

api_key: str,

base_url: str = "https://api.apiyi.com/v1",

alert_config: Optional[AlertConfig] = None

):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

self.alert_config = alert_config or AlertConfig()

self.check_results: List[CheckResult] = []

self.consecutive_failures = 0

self.last_alert_time: Optional[datetime] = None

self._lock = threading.Lock()

def health_check(self) -> CheckResult:

"""

Health Check ausführen

"""

start_time = time.time()

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt="health check: simple geometric shape",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="success",

latency=round(latency, 2)

)

with self._lock:

self.consecutive_failures = 0

except openai.RateLimitError:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="rate_limited",

latency=round(time.time() - start_time, 2)

)

except openai.APIError as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="api_error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

except Exception as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

with self._lock:

self.check_results.append(result)

# Die letzten 1000 Datensätze behalten

if len(self.check_results) > 1000:

self.check_results = self.check_results[-1000:]

# Alarmbedingungen prüfen

self._check_alert(result)

return result

def _check_alert(self, result: CheckResult):

"""

Prüfen, ob ein Alarm gesendet werden muss

"""

if not self.alert_config.enabled:

return

if self.consecutive_failures < self.alert_config.threshold:

return

# Alarm-Cooldown prüfen

if self.last_alert_time:

cooldown = timedelta(minutes=self.alert_config.cooldown_minutes)

if datetime.now() - self.last_alert_time < cooldown:

return

self._send_alerts(result)

self.last_alert_time = datetime.now()

def _send_alerts(self, result: CheckResult):

"""

Multi-Channel-Alarme senden

"""

message = self._format_alert_message(result)

if not self.alert_config.webhook_urls:

print(f"[ALERT] {message}")

return

for channel, webhook_url in self.alert_config.webhook_urls.items():

try:

if channel == "feishu":

self._send_feishu_alert(webhook_url, message)

elif channel == "wechat":

self._send_wechat_alert(webhook_url, message)

elif channel == "dingtalk":

self._send_dingtalk_alert(webhook_url, message)

elif channel == "slack":

self._send_slack_alert(webhook_url, message)

except Exception as e:

print(f"Failed to send {channel} alert: {e}")

def _format_alert_message(self, result: CheckResult) -> str:

"""

Alarmmeldung formatieren

"""

return f"""

🚨 Nano Banana Pro API Anomalie-Alarm

📊 Status-Details:

• Status: {result.status}

• Zeit: {result.timestamp}

• Fehler: {result.error or 'N/A'}

• Aufeinanderfolgende Fehler: {self.consecutive_failures} Mal

🔗 Monitoring-Quellen:

• Google Cloud Status: status.cloud.google.com

• OpenRouter Uptime: openrouter.ai/google/gemini-3-pro-image-preview/uptime

• APIYI Monitoring: apiyi.com

⚡ Empfohlene Maßnahmen:

1. Google Cloud Statusseite prüfen

2. Gültigkeit des API-Keys überprüfen

3. Netzwerkverbindung prüfen

4. Technischen Support von APIYI kontaktieren

""".strip()

def _send_feishu_alert(self, webhook_url: str, message: str):

"""Feishu-Bot-Alarm"""

payload = {

"msg_type": "text",

"content": {"text": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_wechat_alert(self, webhook_url: str, message: str):

"""WeChat-Work-Bot-Alarm"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_dingtalk_alert(self, webhook_url: str, message: str):

"""DingTalk-Bot-Alarm"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_slack_alert(self, webhook_url: str, message: str):

"""Slack-Bot-Alarm"""

payload = {"text": message}

requests.post(webhook_url, json=payload, timeout=10)

def get_dashboard_data(self) -> dict:

"""

Dashboard-Daten abrufen

"""

now = datetime.now()

# Statistiken für verschiedene Zeiträume berechnen

periods = {

'1h': timedelta(hours=1),

'6h': timedelta(hours=6),

'24h': timedelta(hours=24),

'7d': timedelta(days=7)

}

stats = {}

for period_name, delta in periods.items():

cutoff = now - delta

recent = [

r for r in self.check_results

if datetime.fromisoformat(r.timestamp) > cutoff

]

if recent:

success = sum(1 for r in recent if r.status == 'success')

latencies = [r.latency for r in recent if r.latency]

stats[period_name] = {

'total': len(recent),

'success': success,

'uptime': round((success / len(recent)) * 100, 2),

'avg_latency': round(sum(latencies) / len(latencies), 2) if latencies else None

}

else:

stats[period_name] = None

return {

'model': 'nano-banana-pro',

'current_status': self.check_results[-1].status if self.check_results else 'unknown',

'consecutive_failures': self.consecutive_failures,

'statistics': stats,

'last_update': now.isoformat()

}

# Anwendungsbeispiel

if __name__ == "__main__":

# Alarm konfigurieren

alert_config = AlertConfig(

enabled=True,

threshold=3,

cooldown_minutes=30,

webhook_urls={

"feishu": "https://open.feishu.cn/open-apis/bot/v2/hook/xxx",

# "wechat": "https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=xxx",

}

)

# Monitoring-Instanz erstellen

monitor = EnterpriseMonitor(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1",

alert_config=alert_config

)

# Check ausführen

result = monitor.health_check()

print("Check-Ergebnis:", asdict(result))

# Dashboard-Daten abrufen

dashboard = monitor.get_dashboard_data()

print("Dashboard-Daten:", json.dumps(dashboard, indent=2, ensure_ascii=False))

Konfiguration der Monitoring-Alarme für die Nano Banana Pro API

Anbindung der Alarmkanäle

| Kanal | Webhook-Format | Anwendungsszenario |

|---|---|---|

| Feishu | open.feishu.cn/open-apis/bot/v2/hook/xxx | Erste Wahl für Unternehmen im chinesischen Markt |

| WeCom | qyapi.weixin.qq.com/cgi-bin/webhook/send | Nutzer des WeChat-Ökosystems |

| DingTalk | oapi.dingtalk.com/robot/send | Unternehmen im Alibaba-Ökosystem |

| Slack | hooks.slack.com/services/xxx | Internationale Teams |

| SMTP-Konfiguration | Formelle Dokumentation |

Definition der Alarmstufen

# 告警级别配置

ALERT_LEVELS = {

'info': {

'triggers': ['rate_limited'],

'channels': ['log'],

'color': '#36a64f'

},

'warning': {

'triggers': ['timeout', 'degraded'],

'channels': ['feishu', 'slack'],

'color': '#ff9800'

},

'critical': {

'triggers': ['api_error', 'error'],

'channels': ['feishu', 'wechat', 'slack', 'email'],

'color': '#f44336'

}

}

💰 Kostenoptimierung: Für budgetsensitive Projekte können Sie die Nano Banana Pro API über die Plattform APIYI (apiyi.com) aufrufen. Diese Plattform bietet flexible Abrechnungsmodelle und integrierte Überwachungsfunktionen, wodurch die Kosten für eine selbstgebaute Infrastruktur gesenkt werden.

Best Practices für das Monitoring der Nano Banana Pro API

Kombination von Überwachungsstrategien

Wählen Sie je nach geschäftlicher Relevanz die passende Kombination von Überwachungsstrategien:

| Geschäftspriorität | Offizielle Statusseite | Drittanbieter-Monitoring | Aktives Probing | Alarmkanäle |

|---|---|---|---|---|

| Kritisch | ✅ Abonnieren | ✅ OpenRouter | ✅ 1 Min. | Mehrere Kanäle |

| Wichtig | ✅ Abonnieren | ✅ OpenRouter | ✅ 5 Min. | Feishu + E-Mail |

| Standard | ✅ Abonnieren | Optional | ✅ 15 Min. | Feishu |

| Testumgebung | Optional | – | ✅ 30 Min. | Logs |

Prozess der Störungsbehebung

Anomalie erkannt

↓

Auswirkungsbereich bestätigen (Produktion/Test)

↓

Offizielle Statusseite prüfen

↓

├── Offizielle Bestätigung der Störung → Auf Wiederherstellung warten + Benutzer informieren

├── Status offiziell normal → Eigene Konfiguration prüfen

│ ├── Gültigkeit des API-Keys

│ ├── Kontingentverbrauch (Quota)

│ ├── Netzwerkverbindungsstatus

│ └── Konformität der Anfrageparameter

└── Unklarheit besteht → Technischen Support kontaktieren

Analyse der Monitoring-Daten

import pandas as pd

from datetime import datetime, timedelta

def analyze_monitoring_data(check_results: list) -> dict:

"""

分析监控数据,生成报告

"""

df = pd.DataFrame(check_results)

df['timestamp'] = pd.to_datetime(df['timestamp'])

# 按小时统计

df['hour'] = df['timestamp'].dt.floor('H')

hourly_stats = df.groupby('hour').agg({

'status': lambda x: (x == 'success').mean() * 100,

'latency': 'mean'

}).rename(columns={

'status': 'uptime_pct',

'latency': 'avg_latency'

})

# 识别异常时段

anomalies = hourly_stats[hourly_stats['uptime_pct'] < 99]

# 延迟趋势

df['date'] = df['timestamp'].dt.date

daily_latency = df.groupby('date')['latency'].mean()

return {

'hourly_stats': hourly_stats.to_dict(),

'anomaly_periods': anomalies.index.tolist(),

'daily_latency_trend': daily_latency.to_dict(),

'overall_uptime': df[df['status'] == 'success'].shape[0] / len(df) * 100

}

Häufig gestellte Fragen (FAQ)

Q1: Welche Monitoring-Frequenz ist für die Nano Banana Pro API angemessen?

Die Überwachungsfrequenz hängt von der geschäftlichen Relevanz ab:

- Kern-Produktionsumgebungen: Empfohlen wird eine Überprüfung alle 1-2 Minuten.

- Wichtige Geschäftsbereiche: Überprüfung alle 5 Minuten.

- Einfache Anwendungen: Überprüfung alle 10-15 Minuten.

Über die Plattform APIYI (apiyi.com) können Sie kostenloses Testguthaben erhalten, um die Machbarkeit Ihrer Monitoring-Lösung schnell zu validieren. Achten Sie dabei auf das Gleichgewicht zwischen Monitoring-Kosten und Reaktionsgeschwindigkeit.

Q2: Wie unterscheidet man zwischen temporären Schwankungen und echten Ausfällen bei Nano Banana Pro?

Wir empfehlen die folgenden Strategien:

- Schwellenwert für aufeinanderfolgende Fehler: Lösen Sie Alarme erst nach mindestens 3 aufeinanderfolgenden Fehlern aus.

- Gleitendes Zeitfenster: Ein Ausfall wird erst definiert, wenn die Fehlerrate innerhalb von 5 Minuten über 50 % liegt.

- Validierung aus mehreren Quellen: Prüfen Sie gleichzeitig die offizielle Statusseite, um zu bestätigen, ob es sich um ein offizielles Problem handelt.

- Rate Limits ausschließen: Eine Drosselung (Rate Limiting) ist nicht gleichbedeutend mit einem Systemausfall.

Über das Monitoring-Dashboard der APIYI-Plattform (apiyi.com) können Sie historische Verfügbarkeitstrends visuell analysieren und schnell beurteilen, ob ein systemischer Fehler vorliegt.

Q3: Sind die Monitoring-Daten von Drittanbietern wie OpenRouter zuverlässig?

OpenRouter ist als bekannte Aggregationsplattform für KI-Modelle eine wertvolle Referenzquelle:

- Vorteile: Aggregiert Anfragedaten von Nutzern weltweit, was eine große Stichprobenmenge bietet.

- Einschränkungen: Die Daten können auch Probleme enthalten, die in der Infrastruktur von OpenRouter selbst liegen.

- Empfehlung: Nutzen Sie eine Kombination aus der offiziellen Statusseite und eigenem Monitoring für eine fundierte Gesamtbeurteilung.

Q4: Was kann man gegen Alarm-Müdigkeit (Alert Fatigue) tun?

Alarm-Müdigkeit ist ein häufiges Problem. Folgendes wird empfohlen:

- Alarmstufen festlegen: Unterscheiden Sie zwischen Info, Warning und Critical.

- Abkühlzeit (Cooldown) konfigurieren: Senden Sie für das gleiche Problem nur einen Alarm innerhalb von 30 Minuten.

- Alarme aggregieren: Fassen Sie ähnliche Probleme in einer einzigen Meldung zusammen.

- Alarm-Unterdrückung: Schalten Sie Alarme während geplanter Wartungsarbeiten vorübergehend stumm.

- Kontinuierliche Optimierung: Überprüfen Sie regelmäßig Fehlalarme und passen Sie die Schwellenwerte an.

Fazit

Das Monitoring der Verfügbarkeit der Nano Banana Pro API ist ein entscheidender Faktor für die Stabilität von Bildgenerierungs-Services. In diesem Artikel wurden drei praktische Methoden vorgestellt:

- Offizielle Google-Statusseite: Überwachen Sie den Cloud-Status und AI Studio-Status für offizielle Informationen aus erster Hand.

- Drittanbieter-Monitoring via OpenRouter: Nutzen Sie die Uptime-Seite von openrouter.ai für Verfügbarkeitsdaten auf Community-Ebene.

- Aktives Probe-Monitoring: Implementieren Sie eine End-to-End-Verfügbarkeitsprüfung durch regelmäßige API-Aufrufe.

Wir empfehlen die Nutzung von APIYI (apiyi.com), um die Wirksamkeit Ihrer Monitoring-Lösungen schnell zu testen. Die Plattform bietet eine einheitliche API-Schnittstelle und integrierte Monitoring-Dashboards, die Entwicklern helfen, den Wartungsaufwand zu reduzieren.

Autor: APIYI Technik-Team

Technischer Austausch: Besuchen Sie APIYI (apiyi.com) für weitere Tipps und Best Practices zur Nutzung von KI-APIs.

Aktualisierungsdatum: 28.01.2026

Relevante Ressourcen

| Ressourcentyp | Beschreibung |

|---|---|

| Google Cloud Status | status.cloud.google.com |

| AI Studio Status | aistudio.google.com/status |

| OpenRouter Uptime | openrouter.ai/google/gemini-3-pro-image-preview/uptime |

| APIYI Offizielle Webseite | apiyi.com |