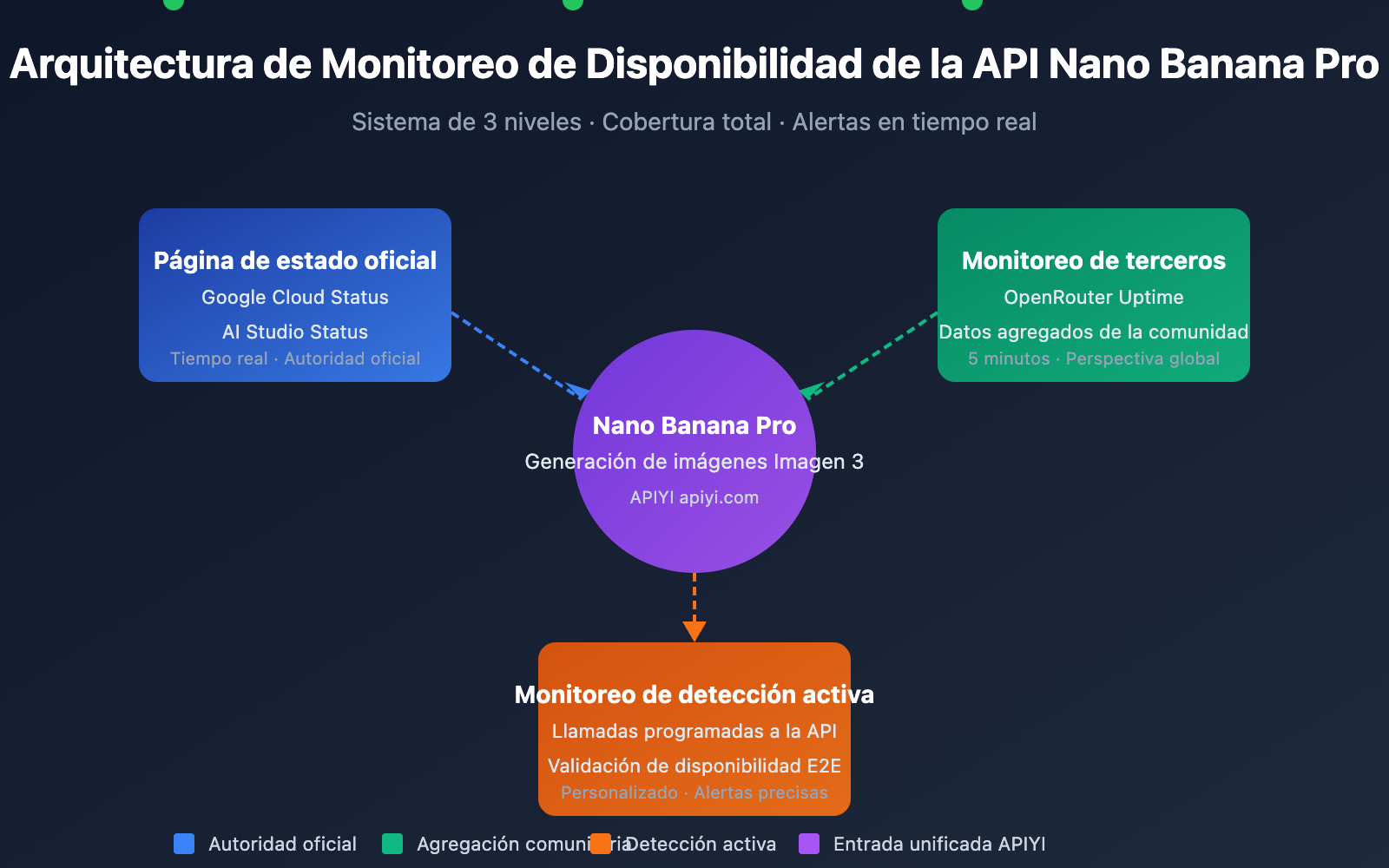

Monitorear la disponibilidad de la API de Nano Banana Pro es un requisito crítico para que los desarrolladores aseguren el funcionamiento estable de sus servicios de generación de imágenes. En este artículo, presentaremos 3 métodos prácticos para monitorear la API de Nano Banana Pro, ayudándote a conocer el estado del servicio en tiempo real y a responder rápidamente ante fallos.

Valor principal: Al terminar de leer, habrás aprendido a usar las páginas de estado oficiales de Google y las herramientas de monitoreo de terceros como OpenRouter para establecer un sistema completo de monitoreo de disponibilidad de la API de Nano Banana Pro.

Puntos clave del monitoreo de la API de Nano Banana Pro

Nano Banana Pro (basado en Google Imagen 3) es uno de los modelos de generación de imágenes por IA más potentes actualmente. Debido a que su infraestructura subyacente depende de Google Cloud, la estrategia de monitoreo debe cubrir múltiples niveles.

| Nivel de monitoreo | Fuente de monitoreo | Contenido del monitoreo | Frecuencia de actualización |

|---|---|---|---|

| Nivel de infraestructura | Google Cloud Status | Servicios de cómputo, red y almacenamiento | Tiempo real |

| Nivel de servicio de IA | AI Studio Status | Servicios de modelos Gemini e Imagen | Tiempo real |

| Agregación de terceros | OpenRouter Uptime | Tasa de respuesta de la API y estadísticas de latencia | 5 minutos |

| Detección activa | Scripts de monitoreo propios | Pruebas de disponibilidad de extremo a extremo | Personalizado |

Métricas clave para el monitoreo de la API de Nano Banana Pro

Al monitorear la API de Nano Banana Pro, es necesario prestar atención a las siguientes métricas principales:

| Nombre de la métrica | Rango normal | Umbral de alerta | Descripción |

|---|---|---|---|

| Tasa de disponibilidad | ≥ 99.5% | < 99% | Disponibilidad general del servicio |

| Latencia de respuesta | 5-15 segundos | > 30 segundos | Tiempo consumido en la generación de imágenes |

| Tasa de errores | < 1% | > 5% | Proporción de solicitudes fallidas |

| Límites de tasa | 0 veces/hora | > 10 veces/hora | Activación de Rate Limits |

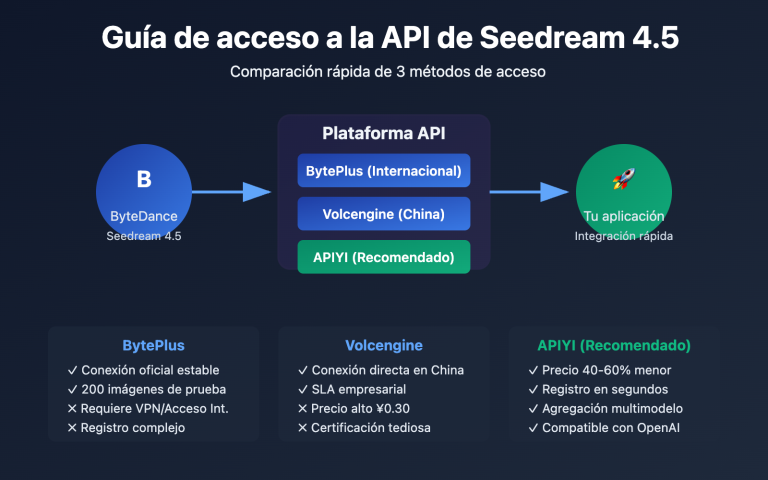

🎯 Sugerencia técnica: En el desarrollo real, recomendamos realizar las llamadas a la API de Nano Banana Pro a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece monitoreo de estado unificado y servicios de alerta, reduciendo los costos de construir un sistema de monitoreo propio.

Método de monitoreo 1 para la API de Nano Banana Pro: Página de estado oficial de Google

Monitoreo de Google Cloud Status

La página de Google Cloud Status ofrece información en tiempo real sobre el estado de la infraestructura de Google, siendo la fuente principal para monitorear los servicios subyacentes de Nano Banana Pro.

Dirección de la página oficial de estado: status.cloud.google.com

Servicios de monitoreo clave

| Nombre del servicio | Ubicación en la página de estado | Alcance del impacto |

|---|---|---|

| Vertex AI | AI & Machine Learning | Impacto directo en Imagen 3 |

| Cloud Storage | Storage | Afecta el almacenamiento y retorno de imágenes |

| Cloud Run | Compute | Afecta el servicio de puerta de enlace API |

| Cloud Load Balancing | Networking | Afecta el enrutamiento de peticiones |

Configuración de suscripción de estado

Google Cloud Status admite varios métodos de suscripción:

# Ejemplo: Uso de la API de Google Cloud Status para obtener el estado

import requests

def check_google_cloud_status():

"""

Verifica el estado del servicio de Google Cloud

Llamada a través de la interfaz unificada de APIYI (apiyi.com)

"""

# Google Cloud Status RSS Feed

status_url = "https://status.cloud.google.com/incidents.json"

try:

response = requests.get(status_url, timeout=10)

incidents = response.json()

# Filtrar eventos relacionados con Vertex AI

vertex_incidents = [

inc for inc in incidents

if 'Vertex AI' in str(inc.get('affected_products', []))

]

return {

'status': 'healthy' if not vertex_incidents else 'degraded',

'incidents': vertex_incidents

}

except Exception as e:

return {'status': 'unknown', 'error': str(e)}

# Ejecutar verificación

result = check_google_cloud_status()

print(f"Estado de Vertex AI: {result['status']}")

Monitoreo de AI Studio Status

Google AI Studio ofrece una página de estado exclusiva para los modelos Gemini e Imagen.

Dirección de la página de estado de AI Studio: aistudio.google.com/status

| Ítem de monitoreo | Descripción | Frecuencia de verificación |

|---|---|---|

| Gemini Models | Estado de los modelos de generación de texto | Tiempo real |

| Imagen Models | Estado de los modelos de generación de imágenes | Tiempo real |

| API Quota | Uso de cuotas | Cada hora |

| Regional Status | Estado del servicio por región | Tiempo real |

Ver el código completo de monitoreo de estado de AI Studio

import requests

from datetime import datetime, timedelta

import json

class AIStudioMonitor:

"""

Clase de monitoreo de estado de AI Studio

Adecuado para monitorear el estado del servicio Nano Banana Pro (Imagen 3)

"""

def __init__(self, api_key: str):

self.api_key = api_key

# Usar la interfaz unificada de APIYI

self.base_url = "https://api.apiyi.com/v1"

self.status_history = []

def check_imagen_health(self) -> dict:

"""

Detectar el estado de salud del servicio Imagen 3 mediante una llamada API real

"""

try:

headers = {

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

}

# Enviar una petición de prueba ligera

test_payload = {

"model": "nano-banana-pro",

"prompt": "health check test",

"n": 1,

"size": "256x256" # Tamaño mínimo para reducir costos

}

start_time = datetime.now()

response = requests.post(

f"{self.base_url}/images/generations",

headers=headers,

json=test_payload,

timeout=60

)

latency = (datetime.now() - start_time).total_seconds()

if response.status_code == 200:

return {

'status': 'healthy',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

elif response.status_code == 429:

return {

'status': 'rate_limited',

'latency': latency,

'timestamp': datetime.now().isoformat()

}

else:

return {

'status': 'degraded',

'error_code': response.status_code,

'timestamp': datetime.now().isoformat()

}

except requests.Timeout:

return {

'status': 'timeout',

'timestamp': datetime.now().isoformat()

}

except Exception as e:

return {

'status': 'error',

'error': str(e),

'timestamp': datetime.now().isoformat()

}

def get_uptime_stats(self, hours: int = 24) -> dict:

"""

Calcular estadísticas de disponibilidad de las últimas N horas

"""

cutoff = datetime.now() - timedelta(hours=hours)

recent_checks = [

s for s in self.status_history

if datetime.fromisoformat(s['timestamp']) > cutoff

]

if not recent_checks:

return {'uptime': 'N/A', 'sample_count': 0}

healthy_count = sum(1 for s in recent_checks if s['status'] == 'healthy')

uptime_pct = (healthy_count / len(recent_checks)) * 100

return {

'uptime': f"{uptime_pct:.2f}%",

'sample_count': len(recent_checks),

'healthy_count': healthy_count,

'period_hours': hours

}

# Ejemplo de uso

monitor = AIStudioMonitor(api_key="your-apiyi-key")

health = monitor.check_imagen_health()

print(f"Estado de salud de Nano Banana Pro: {health}")

💡 Sugerencia de elección: La elección del plan de monitoreo depende principalmente de sus necesidades específicas. Recomendamos realizar pruebas de llamadas API a través de la plataforma APIYI (apiyi.com), que ofrece un panel de monitoreo de estado integrado para visualizar rápidamente la disponibilidad del servicio.

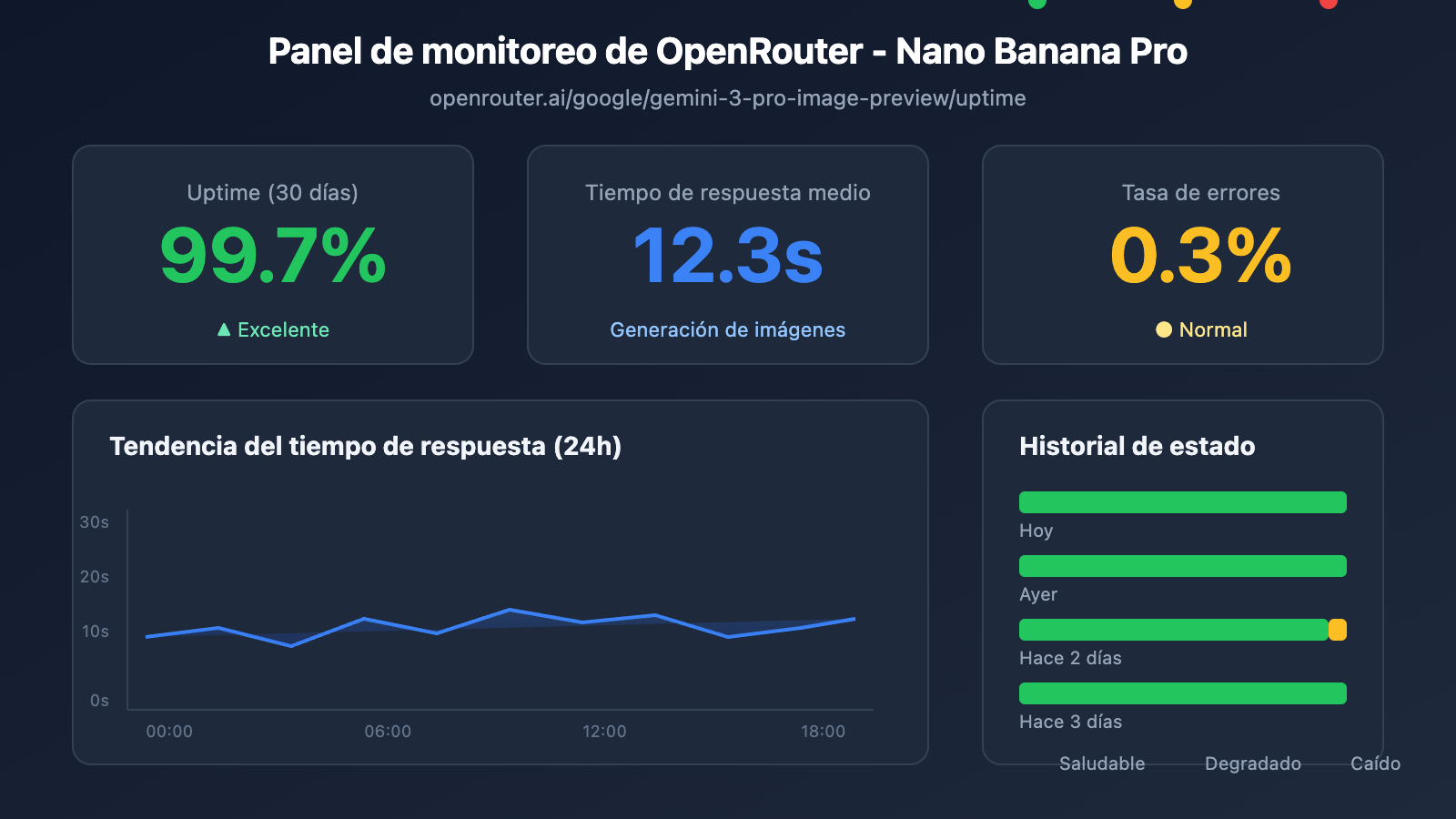

Método 2 de monitoreo de la API de Nano Banana Pro: Monitoreo de terceros con OpenRouter

OpenRouter ofrece servicios profesionales de monitoreo de modelos de IA de terceros, lo cual es un complemento importante para supervisar la disponibilidad de la API de Nano Banana Pro.

Página de monitoreo de Uptime en OpenRouter

Dirección de monitoreo de Nano Banana Pro: openrouter.ai/google/gemini-3-pro-image-preview/uptime

Interpretación de los datos de monitoreo de OpenRouter

| Métrica | Significado | Valor de referencia |

|---|---|---|

| Uptime % | Disponibilidad en los últimos 30 días | Excelente si es ≥ 99% |

| Avg Latency | Latencia de respuesta promedio | 10-20s es normal para generación de imágenes |

| P95 Latency | Latencia del 95% de las solicitudes | Normal si es < 30s |

| Error Rate | Tasa de errores de solicitud | Saludable si es < 2% |

| Throughput | Rendimiento (Throughput) | Refleja la popularidad del modelo |

Script para obtener datos de monitoreo

import requests

from bs4 import BeautifulSoup

import json

def get_openrouter_uptime(model_id: str = "google/gemini-3-pro-image-preview"):

"""

Obtener datos de disponibilidad del modelo de OpenRouter

Aplicable al monitoreo de Nano Banana Pro (Imagen 3)

"""

uptime_url = f"https://openrouter.ai/{model_id}/uptime"

# Nota: OpenRouter podría requerir llamadas a la API para obtener datos detallados

# Aquí se muestra la lógica básica de verificación de disponibilidad

try:

# Obtener información del modelo a través de la API de OpenRouter

api_url = "https://openrouter.ai/api/v1/models"

response = requests.get(api_url, timeout=10)

models = response.json().get('data', [])

# Buscar el modelo de destino

target_model = next(

(m for m in models if m.get('id') == model_id),

None

)

if target_model:

return {

'model_id': model_id,

'status': 'available' if target_model else 'unknown',

'pricing': target_model.get('pricing', {}),

'context_length': target_model.get('context_length'),

'uptime_url': uptime_url

}

else:

return {

'model_id': model_id,

'status': 'not_found',

'uptime_url': uptime_url

}

except Exception as e:

return {

'model_id': model_id,

'status': 'error',

'error': str(e)

}

# Comprobar el estado de Nano Banana Pro

nano_status = get_openrouter_uptime()

print(json.dumps(nano_status, indent=2))

Monitoreo comparativo multimodelo

A través de OpenRouter puedes monitorear simultáneamente el estado de varios modelos de generación de imágenes:

| Modelo | ID de OpenRouter | Valor de monitoreo |

|---|---|---|

| Nano Banana Pro | google/gemini-3-pro-image-preview | Objetivo principal de monitoreo |

| DALL-E 3 | openai/dall-e-3 | Estado de la alternativa |

| Stable Diffusion 3 | stabilityai/stable-diffusion-3 | Estado de la alternativa |

| Midjourney | – | API no soportada por el momento |

🚀 Inicio rápido: Recomendamos usar la plataforma APIYI (apiyi.com) para prototipar rápidamente la generación de imágenes. Esta plataforma ofrece la capacidad de cambiar entre múltiples modelos de forma inmediata; si el modelo principal no está disponible, puede cambiar automáticamente a un modelo de respaldo.

Método 3 de monitoreo de la API de Nano Banana Pro: Monitoreo por detección activa

Además de suscribirse pasivamente a las páginas de estado, la detección activa es un medio clave para garantizar la estabilidad del negocio.

Script de detección programada

import openai

import time

import json

from datetime import datetime

import schedule

# Usando la interfaz unificada de APIYI

client = openai.OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1"

)

class NanoBananaProMonitor:

"""

Monitoreo por detección activa de la API de Nano Banana Pro

"""

def __init__(self):

self.check_results = []

self.alert_threshold = 3 # Se activa la alerta tras 3 fallos consecutivos

self.consecutive_failures = 0

def health_check(self) -> dict:

"""

Realiza una verificación de estado (health check)

"""

start_time = time.time()

try:

response = client.images.generate(

model="nano-banana-pro",

prompt="A simple red circle on white background",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = {

'timestamp': datetime.now().isoformat(),

'status': 'success',

'latency': round(latency, 2),

'model': 'nano-banana-pro'

}

self.consecutive_failures = 0

except openai.RateLimitError:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'rate_limited',

'latency': time.time() - start_time,

'model': 'nano-banana-pro'

}

# El límite de tasa (Rate limit) no se cuenta como fallo

except openai.APIError as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'api_error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

except Exception as e:

result = {

'timestamp': datetime.now().isoformat(),

'status': 'error',

'error': str(e),

'model': 'nano-banana-pro'

}

self.consecutive_failures += 1

self.check_results.append(result)

# Comprobar si es necesario emitir una alerta

if self.consecutive_failures >= self.alert_threshold:

self.send_alert(result)

return result

def send_alert(self, result: dict):

"""

Envía notificaciones de alerta.

Compatible con: WeChat Enterprise, DingTalk, Feishu, Slack, correo electrónico, etc.

"""

alert_message = f"""

🚨 Alerta de la API de Nano Banana Pro

Estado: {result.get('status')}

Hora: {result.get('timestamp')}

Error: {result.get('error', 'N/A')}

Fallos consecutivos: {self.consecutive_failures} veces

"""

print(alert_message)

# En proyectos reales, conectar con canales de notificación

# self.send_wechat(alert_message)

# self.send_feishu(alert_message)

def get_statistics(self, hours: int = 24) -> dict:

"""

Obtiene datos estadísticos del monitoreo

"""

from datetime import timedelta

cutoff = datetime.now() - timedelta(hours=hours)

recent = [

r for r in self.check_results

if datetime.fromisoformat(r['timestamp']) > cutoff

]

if not recent:

return {'message': 'No data available'}

success_count = sum(1 for r in recent if r['status'] == 'success')

total_count = len(recent)

latencies = [r['latency'] for r in recent if 'latency' in r and r['status'] == 'success']

avg_latency = sum(latencies) / len(latencies) if latencies else 0

return {

'period_hours': hours,

'total_checks': total_count,

'success_count': success_count,

'uptime_percentage': round((success_count / total_count) * 100, 2),

'avg_latency': round(avg_latency, 2),

'last_check': recent[-1] if recent else None

}

# Crear instancia de monitoreo

monitor = NanoBananaProMonitor()

# Configurar tarea programada: verificar cada 5 minutos

schedule.every(5).minutes.do(monitor.health_check)

# Ejecutar monitoreo (uso en entorno de producción)

# while True:

# schedule.run_pending()

# time.sleep(1)

# Ejemplo de verificación única

result = monitor.health_check()

print(json.dumps(result, indent=2, ensure_ascii=False))

Ver el código completo del sistema de monitoreo (incluyendo integración de alertas)

import openai

import requests

import time

import json

import schedule

import threading

from datetime import datetime, timedelta

from typing import Optional, List, Dict

from dataclasses import dataclass, asdict

from enum import Enum

class AlertChannel(Enum):

FEISHU = "feishu"

WECHAT = "wechat"

DINGTALK = "dingtalk"

SLACK = "slack"

EMAIL = "email"

@dataclass

class CheckResult:

timestamp: str

status: str

latency: Optional[float] = None

error: Optional[str] = None

model: str = "nano-banana-pro"

@dataclass

class AlertConfig:

enabled: bool = True

channels: List[AlertChannel] = None

threshold: int = 3

cooldown_minutes: int = 30

webhook_urls: Dict[str, str] = None

class EnterpriseMonitor:

"""

Sistema de monitoreo de API Nano Banana Pro de nivel empresarial

Soporta alertas multicanal, persistencia de datos y panel de monitoreo

"""

def __init__(

self,

api_key: str,

base_url: str = "https://api.apiyi.com/v1",

alert_config: Optional[AlertConfig] = None

):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

self.alert_config = alert_config or AlertConfig()

self.check_results: List[CheckResult] = []

self.consecutive_failures = 0

self.last_alert_time: Optional[datetime] = None

self._lock = threading.Lock()

def health_check(self) -> CheckResult:

"""

Ejecuta una verificación de estado

"""

start_time = time.time()

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt="health check: simple geometric shape",

n=1,

size="256x256"

)

latency = time.time() - start_time

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="success",

latency=round(latency, 2)

)

with self._lock:

self.consecutive_failures = 0

except openai.RateLimitError:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="rate_limited",

latency=round(time.time() - start_time, 2)

)

except openai.APIError as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="api_error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

except Exception as e:

result = CheckResult(

timestamp=datetime.now().isoformat(),

status="error",

error=str(e)

)

with self._lock:

self.consecutive_failures += 1

with self._lock:

self.check_results.append(result)

# Mantener los últimos 1000 registros

if len(self.check_results) > 1000:

self.check_results = self.check_results[-1000:]

# Comprobar condiciones de alerta

self._check_alert(result)

return result

def _check_alert(self, result: CheckResult):

"""

Comprobar si es necesario enviar una alerta

"""

if not self.alert_config.enabled:

return

if self.consecutive_failures < self.alert_config.threshold:

return

# Comprobar enfriamiento (cooldown) de la alerta

if self.last_alert_time:

cooldown = timedelta(minutes=self.alert_config.cooldown_minutes)

if datetime.now() - self.last_alert_time < cooldown:

return

self._send_alerts(result)

self.last_alert_time = datetime.now()

def _send_alerts(self, result: CheckResult):

"""

Enviar alertas multicanal

"""

message = self._format_alert_message(result)

if not self.alert_config.webhook_urls:

print(f"[ALERT] {message}")

return

for channel, webhook_url in self.alert_config.webhook_urls.items():

try:

if channel == "feishu":

self._send_feishu_alert(webhook_url, message)

elif channel == "wechat":

self._send_wechat_alert(webhook_url, message)

elif channel == "dingtalk":

self._send_dingtalk_alert(webhook_url, message)

elif channel == "slack":

self._send_slack_alert(webhook_url, message)

except Exception as e:

print(f"Failed to send {channel} alert: {e}")

def _format_alert_message(self, result: CheckResult) -> str:

"""

Formatear mensaje de alerta

"""

return f"""

🚨 Alerta de anomalía en la API de Nano Banana Pro

📊 Detalles del estado:

• Estado: {result.status}

• Hora: {result.timestamp}

• Error: {result.error or 'N/A'}

• Fallos consecutivos: {self.consecutive_failures} veces

🔗 Fuentes de monitoreo:

• Google Cloud Status: status.cloud.google.com

• OpenRouter Uptime: openrouter.ai/google/gemini-3-pro-image-preview/uptime

• Monitoreo de APIYI: apiyi.com

⚡ Acciones recomendadas:

1. Revisar la página de estado de Google Cloud

2. Verificar si la clave API es válida

3. Comprobar el estado de la conexión de red

4. Contactar al soporte técnico de APIYI

""".strip()

def _send_feishu_alert(self, webhook_url: str, message: str):

"""Alerta de bot de Feishu"""

payload = {

"msg_type": "text",

"content": {"text": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_wechat_alert(self, webhook_url: str, message: str):

"""Alerta de bot de WeChat Enterprise"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_dingtalk_alert(self, webhook_url: str, message: str):

"""Alerta de bot de DingTalk"""

payload = {

"msgtype": "text",

"text": {"content": message}

}

requests.post(webhook_url, json=payload, timeout=10)

def _send_slack_alert(self, webhook_url: str, message: str):

"""Alerta de bot de Slack"""

payload = {"text": message}

requests.post(webhook_url, json=payload, timeout=10)

def get_dashboard_data(self) -> dict:

"""

Obtiene datos del panel de monitoreo

"""

now = datetime.now()

# Calcular estadísticas para diferentes periodos de tiempo

periods = {

'1h': timedelta(hours=1),

'6h': timedelta(hours=6),

'24h': timedelta(hours=24),

'7d': timedelta(days=7)

}

stats = {}

for period_name, delta in periods.items():

cutoff = now - delta

recent = [

r for r in self.check_results

if datetime.fromisoformat(r.timestamp) > cutoff

]

if recent:

success = sum(1 for r in recent if r.status == 'success')

latencies = [r.latency for r in recent if r.latency]

stats[period_name] = {

'total': len(recent),

'success': success,

'uptime': round((success / len(recent)) * 100, 2),

'avg_latency': round(sum(latencies) / len(latencies), 2) if latencies else None

}

else:

stats[period_name] = None

return {

'model': 'nano-banana-pro',

'current_status': self.check_results[-1].status if self.check_results else 'unknown',

'consecutive_failures': self.consecutive_failures,

'statistics': stats,

'last_update': now.isoformat()

}

# Ejemplo de uso

if __name__ == "__main__":

# Configurar alertas

alert_config = AlertConfig(

enabled=True,

threshold=3,

cooldown_minutes=30,

webhook_urls={

"feishu": "https://open.feishu.cn/open-apis/bot/v2/hook/xxx",

# "wechat": "https://qyapi.weixin.qq.com/cgi-bin/webhook/send?key=xxx",

}

)

# Crear instancia de monitoreo

monitor = EnterpriseMonitor(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1",

alert_config=alert_config

)

# Ejecutar verificación

result = monitor.health_check()

print("Resultado de la verificación:", asdict(result))

# Obtener datos del panel

dashboard = monitor.get_dashboard_data()

print("Datos del panel:", json.dumps(dashboard, indent=2, ensure_ascii=False))

Configuración de alertas y monitoreo de la API de Nano Banana Pro

Integración de canales de alerta

| Canal | Formato del Webhook | Escenario de uso |

|---|---|---|

| Feishu (Lark) | open.feishu.cn/open-apis/bot/v2/hook/xxx | Preferido para empresas en China |

| WeCom (WeChat Enterprise) | qyapi.weixin.qq.com/cgi-bin/webhook/send | Usuarios del ecosistema WeChat |

| DingTalk | oapi.dingtalk.com/robot/send | Empresas del ecosistema Alibaba |

| Slack | hooks.slack.com/services/xxx | Equipos internacionales |

| Correo electrónico | Configuración SMTP | Registros formales |

Definición de niveles de alerta

# 告警级别配置

ALERT_LEVELS = {

'info': {

'triggers': ['rate_limited'],

'channels': ['log'],

'color': '#36a64f'

},

'warning': {

'triggers': ['timeout', 'degraded'],

'channels': ['feishu', 'slack'],

'color': '#ff9800'

},

'critical': {

'triggers': ['api_error', 'error'],

'channels': ['feishu', 'wechat', 'slack', 'email'],

'color': '#f44336'

}

}

💰 Optimización de costos: Para proyectos con presupuestos ajustados, puedes considerar el uso de la API de Nano Banana Pro a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece modelos de facturación flexibles y funciones de monitoreo integradas, lo que ayuda a reducir los costos de implementar un sistema de monitoreo propio.

Mejores prácticas de monitoreo para la API de Nano Banana Pro

Combinación de estrategias de monitoreo

Dependiendo de la criticidad de tu operación, puedes elegir la combinación de estrategias más adecuada:

| Nivel de negocio | Página de estado oficial | Monitoreo de terceros | Sondeo activo | Canales de alerta |

|---|---|---|---|---|

| Misión crítica | ✅ Suscrito | ✅ OpenRouter | ✅ Cada 1 min | Multicanal |

| Negocio importante | ✅ Suscrito | ✅ OpenRouter | ✅ Cada 5 min | Feishu + Email |

| Negocio estándar | ✅ Suscrito | Opcional | ✅ Cada 15 min | Feishu |

| Entorno de pruebas | Opcional | – | ✅ Cada 30 min | Registros (Logs) |

Flujo de respuesta ante fallos

Anomalía detectada

↓

Confirmar alcance del impacto (Producción/Pruebas)

↓

Revisar la página de estado oficial

↓

├── Fallo confirmado oficialmente → Esperar recuperación + Notificar a usuarios

├── Estado oficial normal → Revisar configuración propia

│ ├── Validez de la API Key

│ ├── Uso de la cuota (quota)

│ ├── Estado de la conexión de red

│ └── Cumplimiento de los parámetros de la solicitud

└── No se puede determinar → Contactar a soporte técnico

Análisis de datos de monitoreo

import pandas as pd

from datetime import datetime, timedelta

def analyze_monitoring_data(check_results: list) -> dict:

"""

分析监控数据,生成报告

"""

df = pd.DataFrame(check_results)

df['timestamp'] = pd.to_datetime(df['timestamp'])

# 按小时统计

df['hour'] = df['timestamp'].dt.floor('H')

hourly_stats = df.groupby('hour').agg({

'status': lambda x: (x == 'success').mean() * 100,

'latency': 'mean'

}).rename(columns={

'status': 'uptime_pct',

'latency': 'avg_latency'

})

# 识别异常时段

anomalies = hourly_stats[hourly_stats['uptime_pct'] < 99]

# 延迟趋势

df['date'] = df['timestamp'].dt.date

daily_latency = df.groupby('date')['latency'].mean()

return {

'hourly_stats': hourly_stats.to_dict(),

'anomaly_periods': anomalies.index.tolist(),

'daily_latency_trend': daily_latency.to_dict(),

'overall_uptime': df[df['status'] == 'success'].shape[0] / len(df) * 100

}

Preguntas frecuentes

Q1: ¿Qué frecuencia de monitoreo es adecuada para la API de Nano Banana Pro?

La frecuencia de monitoreo depende de la criticidad de tu negocio:

- Entorno de producción principal: Se recomienda realizar una comprobación cada 1-2 minutos.

- Operaciones importantes: Una comprobación cada 5 minutos.

- Operaciones estándar: Una comprobación cada 10-15 minutos.

A través de la plataforma APIYI (apiyi.com) puedes obtener cuotas de prueba gratuitas para validar rápidamente la viabilidad de tu plan de monitoreo. No olvides equilibrar los costes de monitoreo con la velocidad de respuesta.

Q2: ¿Cómo distinguir entre una fluctuación temporal de Nano Banana Pro y un fallo real?

Te sugerimos adoptar las siguientes estrategias:

- Umbral de fallos consecutivos: Configura las alertas para que se activen solo después de 3 o más fallos seguidos.

- Ventana deslizante: Considera que hay un fallo solo si la tasa de error supera el 50% en un periodo de 5 minutos.

- Verificación de múltiples fuentes: Consulta simultáneamente la página de estado oficial para confirmar si se trata de un problema global.

- Excluir Rate Limit: Ten en cuenta que una limitación de frecuencia (rate limit) no es lo mismo que un fallo del sistema.

Con el panel de control de APIYI (apiyi.com), puedes visualizar de forma intuitiva las tendencias históricas de disponibilidad para determinar rápidamente si se trata de un fallo sistémico.

Q3: ¿Son fiables los datos de monitoreo de terceros como OpenRouter?

Como plataforma agregadora de modelos de IA muy conocida, los datos de OpenRouter tienen un gran valor de referencia:

- Ventajas: Agrega datos de peticiones de usuarios de todo el mundo, lo que ofrece una muestra de gran tamaño.

- Limitaciones: Los fallos reportados podrían deberse a problemas en la propia infraestructura de OpenRouter.

- Recomendación: Lo ideal es combinar la información de la página de estado oficial con tu propio monitoreo para un diagnóstico preciso.

Q4: ¿Qué hacer si el exceso de alertas causa fatiga?

La fatiga por alertas es un problema común. Te recomendamos:

- Establecer niveles de alerta: Diferencia entre Info, Warning y Critical.

- Configurar un tiempo de enfriamiento (cooldown): No enviar más de una alerta por el mismo problema en un intervalo de, por ejemplo, 30 minutos.

- Agregación de alertas: Agrupar problemas similares en una sola notificación.

- Supresión de alertas: Desactivar temporalmente las notificaciones durante periodos de mantenimiento programado.

- Optimización continua: Revisar periódicamente los falsos positivos y ajustar los umbrales.

Resumen

El monitoreo de disponibilidad de la API de Nano Banana Pro es fundamental para garantizar la estabilidad de los servicios de generación de imágenes. En este artículo, hemos visto 3 métodos prácticos:

- Página de estado oficial de Google: Monitorear Cloud Status y AI Studio Status para obtener información oficial de primera mano.

- Monitoreo de terceros (OpenRouter): Utilizar la página de Uptime de openrouter.ai para obtener datos de disponibilidad a nivel de comunidad.

- Monitoreo por detección activa: Implementar validaciones de disponibilidad de extremo a extremo (end-to-end) mediante llamadas programadas a la API.

Te recomendamos utilizar APIYI (apiyi.com) para validar rápidamente la eficacia de tu estrategia de monitoreo. Esta plataforma ofrece una interfaz de API unificada y un panel de monitoreo integrado que ayuda a los desarrolladores a reducir los costes de operación y mantenimiento.

Autor: Equipo técnico de APIYI

Comunidad técnica: Visita APIYI (apiyi.com) para obtener más trucos y mejores prácticas sobre el uso de APIs de IA.

Fecha de actualización: 28 de enero de 2026

Recursos relacionados

| Tipo de recurso | Descripción |

|---|---|

| Google Cloud Status | status.cloud.google.com |

| AI Studio Status | aistudio.google.com/status |

| OpenRouter Uptime | openrouter.ai/google/gemini-3-pro-image-preview/uptime |

| Sitio oficial de APIYI | apiyi.com |