作者注:深度解析 Nano Banana Pro 不支持 seed 參數的技術原因,以及當你滿意某次生成效果想批量復現時,有哪些切實可行的替代方案。

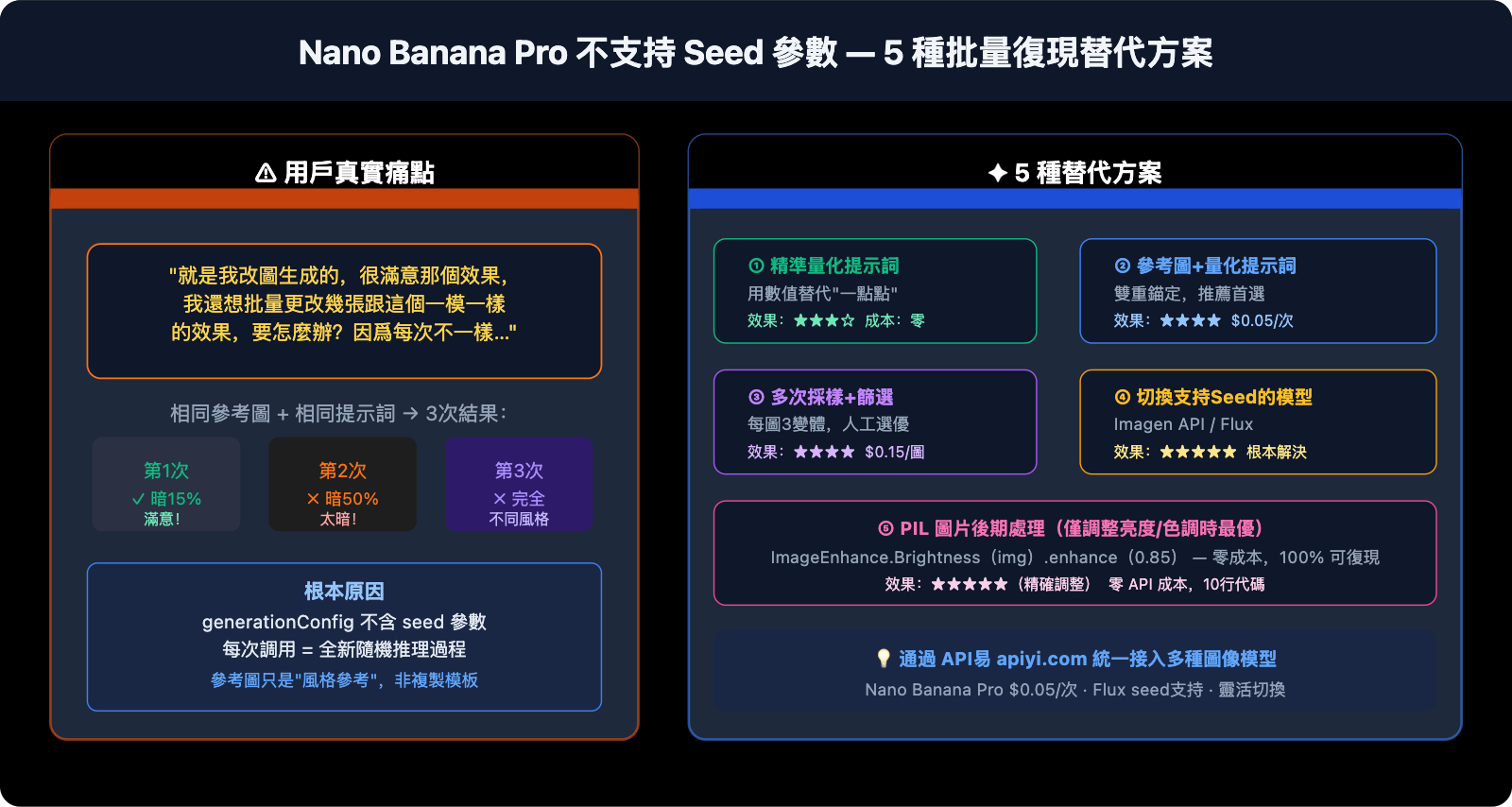

一個真實的用戶反饋:"就是我改圖生成的,很滿意那個效果,我還想批量地更改幾張跟這個一模一樣的效果,要怎麼辦呢?因爲它每次生成都不太一樣。"這是使用 Nano Banana Pro 做批量圖生圖時的典型痛點。把滿意的圖當做參考圖放進去,效果還是不一致——原因很簡單:Nano Banana Pro 官方不支持 seed 參數,每次生成都是全新的隨機推理過程。

核心價值:本文不繞彎子,先解釋清楚爲什麼沒有 seed、參考圖爲什麼不夠用,然後給出 5 個切實有效的替代方案,幫你在沒有 seed 的情況下儘可能復現滿意的效果。

先搞清楚:Nano Banana Pro 爲什麼沒有 Seed?

官方參數一覽

Nano Banana Pro(gemini-3-pro-image-preview)的 generationConfig 支持以下參數:

| 參數名 | 作用 | 示例值 |

|---|---|---|

responseModalities |

指定輸出類型 | ["IMAGE"] |

resolution |

圖像分辨率 | "1K" / "2K" / "4K" |

aspectRatio |

寬高比 | "16:9" / "1:1" / "2:3" |

candidateCount |

同時生成候選數量 | 1(圖像生成固定爲 1) |

temperature |

文本部分隨機性(不影響圖像) | 1.0(推薦默認) |

seed 參數:不在列表中,官方不支持。

嘗試在代碼中傳入 seed 會直接報錯:

# ❌ 這樣會報錯:Unknown field 'seed' in GenerationConfig

response = model.generate_content(

prompt,

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

seed=42 # ← 報錯!官方不支持此參數

)

)

Gemini Image API vs Imagen API:兩套不同的服務

很多人搜到 Google 官方文檔裏確實有 seed 參數,但那是 Imagen API(Vertex AI 上的圖像生成服務),不是 Nano Banana Pro:

| 對比項 | Nano Banana Pro | Imagen API(Vertex AI) |

|---|---|---|

| 模型 ID | gemini-3-pro-image-preview |

imagen-3.0-generate-002 |

| Seed 支持 | ❌ 不支持 | ✅ 支持(seed 參數) |

| API 端點 | Google Generative AI | Vertex AI |

| 調用 SDK | google-generativeai |

google-cloud-aiplatform |

| 圖像質量 | 頂級寫實,文字渲染強 | 高質量,風格多樣 |

| 價格(APIYI) | $0.05/張 | 另行定價 |

結論:如果你一定需要 seed 可復現性,應切換到 Imagen API,而不是在 Nano Banana Pro 上折騰不存在的參數,APIYI 等第三方中轉站不支持 Imagen API,這個 API 只能用官網的 KEY。

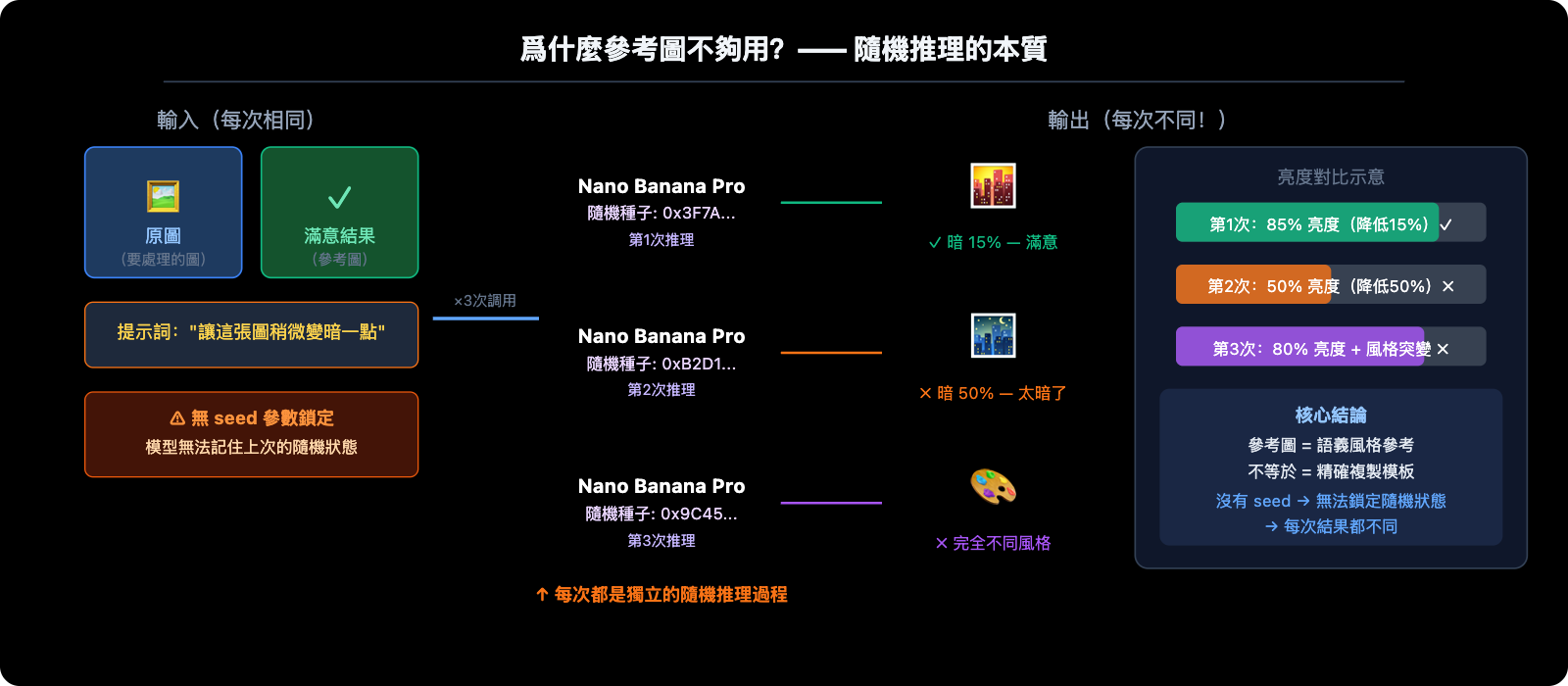

爲什麼參考圖也不夠用?

把滿意的生成結果作爲參考圖再次輸入,是最直覺的想法,但實際效果"一般"。根本原因是:

Nano Banana Pro 把參考圖理解爲"風格參考"而非"複製模板"。當你上傳一張參考圖並說"讓這張圖變黑一點",模型會:

- 分析參考圖的整體風格、構成和內容

- 重新理解"變黑一點"這個指令

- 從頭生成一張符合指令的新圖

這個過程每次都有隨機性,所以"變黑一點點"可能第一次恰好是你滿意的 15% 亮度降低,第二次變成了 50%,第三次又完全不同風格。

5 種替代方案:從最直接到最徹底

方案一:精準量化提示詞(效果最立竿見影)

問題場景:"讓圖變黑一點點"→ 結果有時太黑有時太淺

根本原因是"一點點"太模糊。Nano Banana Pro 無法保證每次對"一點點"的理解一致。解決方法是用數值替代模糊描述:

❌ 模糊提示詞:

"Make this image slightly darker"

"讓圖暗一點點"

✅ 量化提示詞:

"Apply a subtle darkening effect equivalent to reducing brightness by

approximately 15-20%. The image should feel slightly moodier but all

details must remain clearly visible. Do NOT go dark. The result should

be close to: brightness 85% of original, contrast unchanged."

針對常見調整的量化寫法:

亮度調整:

"brightness at 85% of original" (降低 15%)

"increase brightness by 10%, keep contrast" (提亮 10%)

色調調整:

"add a very subtle warm orange tint, color shift about 10%"

"slight cool blue cast, saturation unchanged"

風格強度:

"apply film grain texture at 20% opacity, barely noticeable"

"add very subtle vignette at corners, 15% strength"

💡 關鍵技巧:在提示詞裏用"approximately X%"、"not exceeding Y%"、"subtle/barely noticeable"等程度限定詞,明確告訴模型變化的幅度邊界。

方案二:滿意結果 + 精準提示詞組合(推薦首選)

單純上傳參考圖效果不穩定,但參考圖 + 量化提示詞組合效果會好很多:

import google.generativeai as genai

import base64

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # API易 $0.05/次

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

def apply_consistent_effect(

source_image_path: str, # 要處理的新圖

approved_result_path: str, # 第一次滿意的結果(作爲風格參考)

effect_description: str, # 精準量化的效果描述

output_path: str

) -> str:

"""

將滿意的效果復現到新圖上

使用參考圖 + 精準量化提示詞雙重錨定

"""

# 讀取兩張圖

with open(source_image_path, "rb") as f:

source_data = base64.b64encode(f.read()).decode()

with open(approved_result_path, "rb") as f:

approved_data = base64.b64encode(f.read()).decode()

prompt = f"""

I have two reference images:

- Image 1 (source): The new image I want to process

- Image 2 (approved result): A previous edit I was very happy with

Please apply the SAME effect from Image 2 to Image 1.

The effect is: {effect_description}

Critical instructions:

- The degree of change should match Image 2 EXACTLY

- Do not over-apply the effect

- Keep all other image properties unchanged

- If unsure about intensity, err on the side of LESS change

"""

response = model.generate_content(

[

{"inline_data": {"mime_type": "image/jpeg", "data": source_data}},

{"inline_data": {"mime_type": "image/jpeg", "data": approved_data}},

prompt

],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K",

aspect_ratio="1:1"

)

)

for part in response.candidates[0].content.parts:

if part.inline_data and part.inline_data.mime_type.startswith("image/"):

with open(output_path, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output_path

return None

# 使用示例

result = apply_consistent_effect(

source_image_path="new_product_photo.jpg",

approved_result_path="approved_dark_edit.jpg",

effect_description="subtle darkening, brightness reduced by approximately 15-20%, "

"image should be slightly moodier but all details clearly visible",

output_path="output_consistent.png"

)

# 每次 $0.05(API易 apiyi.com)

🚀 實測建議:這個方法將一致性從"完全隨機"提升到"大概率符合預期",但仍不是 100%。建議每批同時生成 2-3 個變體(用

candidateCount會報錯,需多次調用),人工選最接近的,API易 $0.05/次的低成本讓多次採樣可行。

方案三:多次採樣 + 批量篩選(適合批量場景)

當前景下最務實的方案:對每張新圖生成 3-5 個變體,人工或程序篩選最接近的。

import asyncio

import base64

import os

import google.generativeai as genai

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # API易 $0.05/次

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

EFFECT_PROMPT = """

Apply subtle darkening effect:

- Brightness: approximately 85% of original (reduce by ~15%)

- Mood: slightly darker, more atmospheric

- Details: all elements must remain clearly visible

- Do NOT: make it too dark, change colors dramatically, lose details

This is a subtle, refined adjustment - less is more.

"""

async def generate_variants(image_path: str, n_variants: int = 3) -> list:

"""對同一張圖生成 n 個變體,供篩選"""

with open(image_path, "rb") as f:

img_data = base64.b64encode(f.read()).decode()

async def one_call(i: int) -> str:

output = image_path.replace(".jpg", f"_v{i+1}.png")

loop = asyncio.get_event_loop()

try:

response = await loop.run_in_executor(None, lambda: model.generate_content(

[{"inline_data": {"mime_type": "image/jpeg", "data": img_data}},

EFFECT_PROMPT],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K"

)

))

for part in response.candidates[0].content.parts:

if part.inline_data:

with open(output, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output

except Exception as e:

print(f" 變體 {i+1} 失敗: {e}")

return None

# 併發生成多個變體

results = await asyncio.gather(*[one_call(i) for i in range(n_variants)])

return [r for r in results if r]

async def batch_process(image_list: list, n_variants: int = 3):

"""批量處理多張圖,每張生成多個變體"""

for img_path in image_list:

print(f"\n處理: {img_path}")

variants = await generate_variants(img_path, n_variants)

cost = len(variants) * 0.05

print(f" 生成 {len(variants)} 個變體,成本 ${cost:.2f}(API易)")

print(f" 文件: {variants}")

print(f" → 請人工選出最滿意的變體")

# 示例:處理 5 張圖,每張生成 3 個變體

images = ["photo_01.jpg", "photo_02.jpg", "photo_03.jpg", "photo_04.jpg", "photo_05.jpg"]

asyncio.run(batch_process(images, n_variants=3))

# 5張圖 × 3個變體 = 15次調用,API易總成本 $0.75

成本估算:

| 規模 | 變體數 | 總調用次數 | API易 成本 |

|---|---|---|---|

| 10 張圖 | 每張 3 個 | 30 次 | $1.50 |

| 50 張圖 | 每張 3 個 | 150 次 | $7.50 |

| 100 張圖 | 每張 2 個 | 200 次 | $10.00 |

方案四:切換到支持 Seed 的模型(根本解決)

如果業務確實需要精確可復現性,最徹底的方案是換用原生支持 seed 的模型:

Imagen API(Vertex AI)——同爲 Google 旗下,支持 seed:

from google.cloud import aiplatform

from vertexai.preview.vision_models import ImageGenerationModel

# Imagen API 支持 seed 參數

model = ImageGenerationModel.from_pretrained("imagen-3.0-generate-002")

response = model.generate_images(

prompt="your prompt here",

seed=42, # ✅ 官方支持!

number_of_images=1,

add_watermark=False # 使用 seed 時必須關閉水印

)

# 相同 seed + 相同 prompt → 相同結果(高可復現)

Stable Diffusion / Flux——完整 seed 生態:

# 通過 API易 apiyi.com 接入 Flux,支持 seed

import requests

response = requests.post(

"https://vip.apiyi.com/v1/images/generations",

headers={"Authorization": "Bearer YOUR_APIYI_KEY"},

json={

"model": "flux-dev", # 或 flux-schnell

"prompt": "your prompt",

"seed": 12345, # ✅ 完整 seed 支持

"width": 1024,

"height": 1024

}

)

# 鎖定 seed → 批量生成完全一致的基礎圖

方案五:圖片後期處理(精度最高,最穩定)

如果你的需求是批量對圖像做固定的亮度/色調調整(如統一加深 15%),這類操作用 AI 生成本來就不是最優選——圖片後期處理纔是正確工具:

from PIL import Image, ImageEnhance

import os

def batch_darken(input_dir: str, output_dir: str, brightness_factor: float = 0.85):

"""

精確批量調整亮度

brightness_factor: 0.85 = 降低15%,完全可復現,零隨機性

"""

os.makedirs(output_dir, exist_ok=True)

files = [f for f in os.listdir(input_dir) if f.lower().endswith(('.jpg', '.png', '.webp'))]

for filename in files:

img = Image.open(os.path.join(input_dir, filename))

enhancer = ImageEnhance.Brightness(img)

# 精確控制亮度,每次結果完全一致

darkened = enhancer.enhance(brightness_factor)

darkened.save(os.path.join(output_dir, filename))

print(f"✓ {filename} → 亮度 {brightness_factor*100:.0f}%")

# 批量處理,零 API 成本,100% 可復現

batch_darken("input_images/", "darkened_output/", brightness_factor=0.85)

適用場景對比:

| 調整類型 | 推薦工具 | 原因 |

|---|---|---|

| 統一亮度/對比度/飽和度 | PIL / Photoshop 批處理 | 精確、可復現、零成本 |

| 統一色調濾鏡(暖/冷) | PIL / LUT 濾鏡 | 100% 一致性 |

| 複雜風格遷移(換背景/換主體) | Nano Banana Pro | AI 的真正價值所在 |

| 需精確復現且含創意變化 | Imagen API(含 seed) | 兼顧質量和一致性 |

🎯 最誠實的建議:如果你只是想批量"把圖變暗 15%",請用 PIL 的

ImageEnhance.Brightness,零成本、100% 一致、一行代碼搞定。AI 圖像生成的價值在於複雜的內容理解和創意生成,不在於精確的參數化調整。

主流 AI 圖像模型 Seed 支持對比

| 模型 | Seed 支持 | 復現穩定性 | 備註 |

|---|---|---|---|

| Nano Banana Pro | ❌ 不支持 | 低,每次隨機 | 參考圖+提示詞可部分改善 |

| Imagen API | ✅ 官方支持 | 高 | 同 seed 同 prompt 可復現 |

| Stable Diffusion | ✅ 完整支持 | 非常高 | 開源生態,自部署或雲端 |

| Flux Dev/Pro | ✅ 支持 | 高 | 寫實感強,API 可接入 |

| Midjourney | ✅ --seed 參數 |

中(參考級別) | 相同 seed 風格近似但不完全一致 |

| DALL-E 3 | ❌ 不支持 | 低 | 與 Nano Banana Pro 同類侷限 |

💡 平臺建議:通過 API易 apiyi.com 可以統一接入 Nano Banana Pro、Flux、Stable Diffusion 等多個圖像模型,用同一套 API Key 在不同模型間切換,方便在有無 seed 需求間靈活選擇。

常見問題

Q1:有沒有辦法在 Nano Banana Pro 上”破解”出 seed 效果?

沒有真正意義上的破解方法。一些第三方平臺(如 fal.ai)在其 API 包裝層加了 seed 參數,但這只是控制其平臺層的隨機性,並不等同於 Google 原生 Gemini 圖像生成的 seed——實際上對最終圖像的可復現性影響非常有限。

最接近"seed 效果"的組合是:精準量化提示詞 + 滿意結果作爲參考圖 + 多次採樣篩選。這三者結合能將一致性從完全隨機提升到約 60-70% 的概率命中,但永遠不會是 100%。

如果你的工作流程對可復現性有硬性要求,推薦切換到 Imagen API,通過 API易 apiyi.com 可以同時接入多個服務做對比測試。

Q2:我想批量復現”稍微變暗”的效果,最快的方法是什麼?

取決於"暗"的性質:

- 如果只是亮度/曝光調整:直接用 Python PIL

ImageEnhance.Brightness(img).enhance(0.85)批處理,10 行代碼,零成本,100% 一致。 - 如果涉及風格、氛圍、AI 內容生成(比如"暗色調同時讓背景更有電影質感"):用方案二(參考圖 + 量化提示詞),通過 API易 apiyi.com 批量調用,每張 $0.05,生成 2-3 個變體後人工選最接近的。

Q3:Nano Banana Pro 會不會以後支持 seed 參數?

目前沒有官方公告。從 Google 的產品路線看,Imagen API 是專門用於精確可控圖像生成的服務(含 seed),而 Gemini 圖像生成則更偏向於"高質量創意生成"——兩者定位不同,未來 Nano Banana Pro 加入 seed 的可能性存在但不確定。

可以關注 Google AI 官方博客(blog.google/technology/google-deepmind)和 Gemini API changelog(ai.google.dev/gemini-api/docs/changelog)獲取最新動態。如有更新,我們會第一時間在 API易 apiyi.com 發佈相關使用指南。

總結

Nano Banana Pro 不支持 seed 參數這個事實需要正視,5 種替代方案按場景選擇:

- 精準量化提示詞:用數值替代"一點點"這類模糊描述,立竿見影

- 參考圖 + 量化提示詞:兩張圖輸入(源圖 + 滿意結果),精準描述要復現的效果程度

- 多次採樣篩選:每張生成 2-3 個變體,API易 $0.05/次成本低,人工選最接近的

- 切換 Imagen API / Flux:業務有硬性可復現要求,換用原生支持 seed 的模型

- PIL 後期處理:如果只是亮度/色調固定調整,AI 不是最優工具,用 PIL 更準確

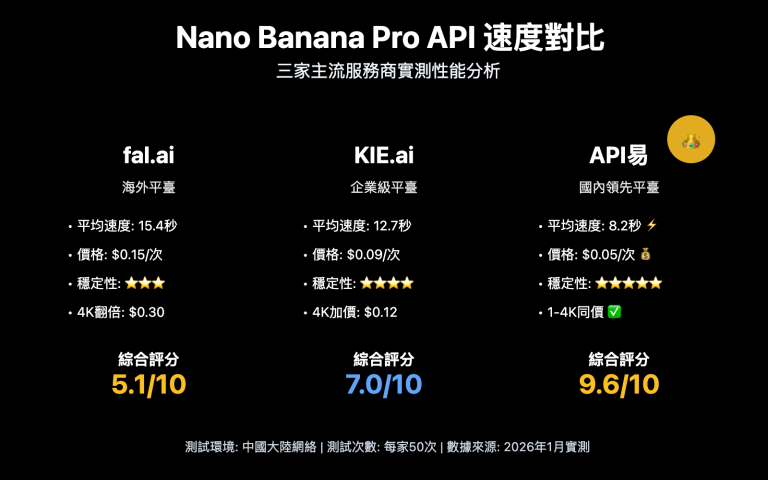

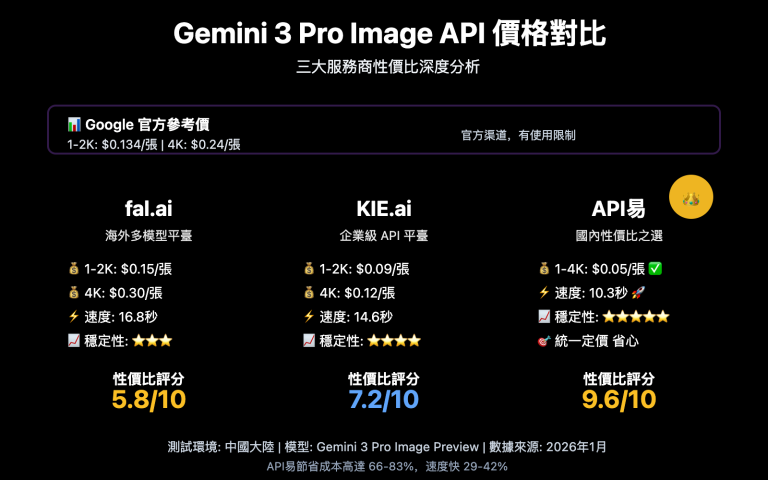

沒有銀彈,選最適合當前場景的方案。多次採樣的低成本($0.05/次)讓"試錯篩選"策略在 API易 apiyi.com 平臺上完全可行,這在官網價格($0.24/次)下則要貴 5 倍。

參考資料

-

Google Gemini API 圖像生成參數文檔

- 鏈接:

ai.google.dev/gemini-api/docs/image-generation - 說明:generationConfig 官方支持參數列表,確認無 seed 字段

- 鏈接:

-

Vertex AI Imagen API 文檔(含 seed 支持)

- 鏈接:

cloud.google.com/vertex-ai/generative-ai/docs/image/generate-images - 說明:Imagen API seed 參數使用方法和限制

- 鏈接:

-

Gemini Python SDK GitHub Issue #536

- 鏈接:

github.com/google-gemini/deprecated-generative-ai-python/issues/536 - 說明:社區確認 seed 參數在 Gemini 圖像生成中不支持的討論

- 鏈接:

-

API易平臺多模型接入

- 鏈接:

docs.apiyi.com - 說明:Nano Banana Pro / Imagen / Flux 統一接入說明

- 鏈接:

作者:技術團隊

技術交流:遇到類似的批量生成一致性問題?歡迎在評論區討論,更多 AI 圖像生成實戰經驗可訪問 API易 apiyi.com 技術社區