Anmerkung des Autors: Eine tiefgehende Analyse der technischen Gründe, warum Nano Banana Pro den seed-Parameter nicht unterstützt, und welche praktikablen Alternativen es gibt, wenn Sie mit einem Ergebnis zufrieden sind und dieses im Batch-Verfahren reproduzieren möchten.

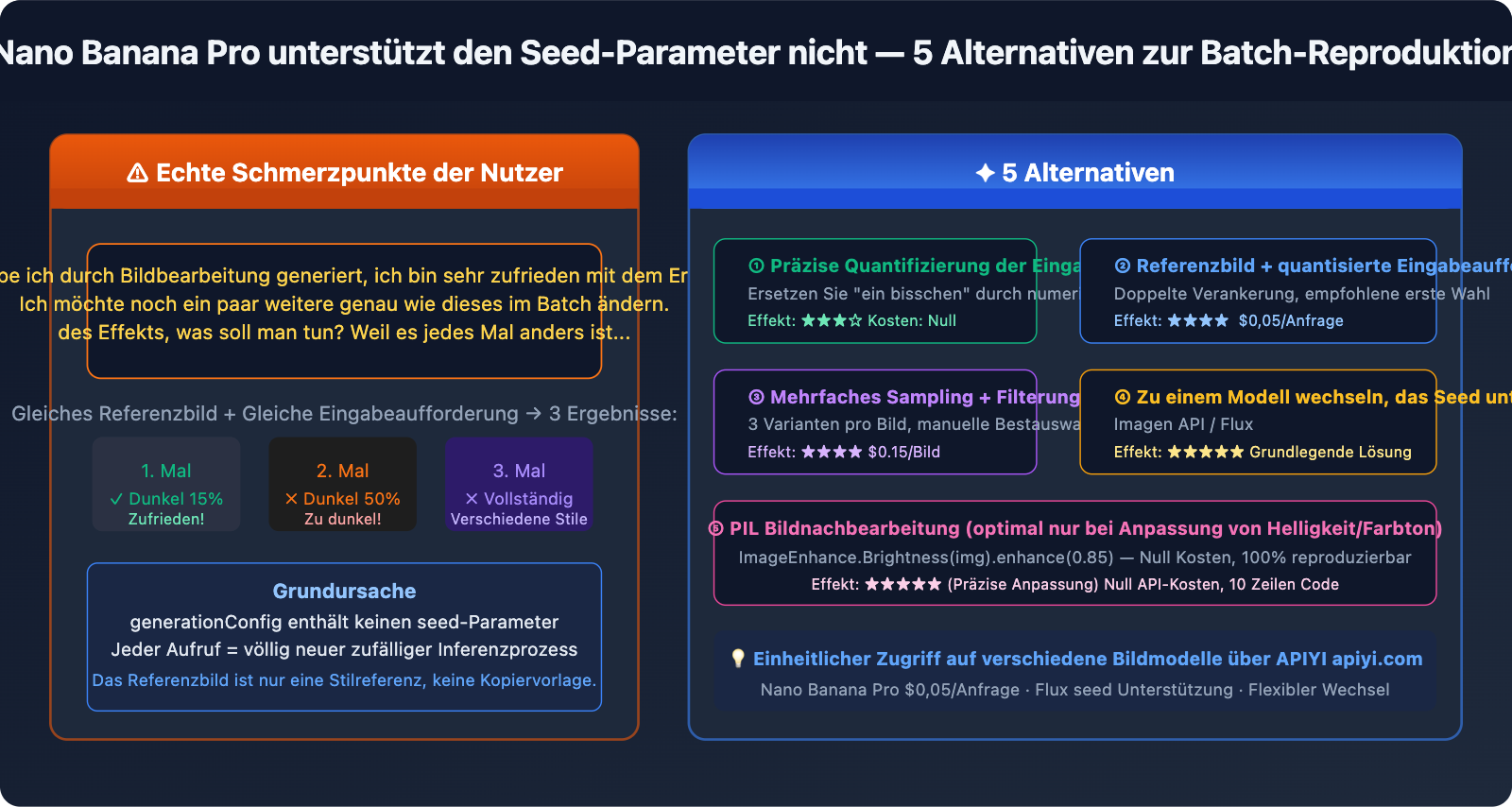

Ein echtes Nutzerfeedback: „Ich habe ein Bild durch Bearbeitung generiert und bin mit dem Ergebnis sehr zufrieden. Jetzt möchte ich mehrere Bilder mit genau demselben Effekt im Batch-Verfahren erstellen – wie mache ich das? Jedes Mal, wenn ich es neu generiere, sieht es anders aus.“ Dies ist ein typisches Problem bei der Batch-Bild-zu-Bild-Generierung mit Nano Banana Pro. Selbst wenn man das zufriedenstellende Bild als Referenzbild einfügt, bleibt das Ergebnis inkonsistent – der Grund ist einfach: Nano Banana Pro unterstützt offiziell keinen seed-Parameter. Jede Generierung ist ein völlig neuer, zufälliger Inferenzprozess.

Kernbotschaft: Dieser Artikel kommt ohne Umschweife direkt zum Punkt. Zuerst klären wir, warum es keinen Seed gibt und warum Referenzbilder allein nicht ausreichen. Dann stellen wir 5 effektive Alternativen vor, mit denen Sie trotz fehlendem Seed möglichst konsistente Ergebnisse erzielen.

Zuerst klären: Warum hat Nano Banana Pro keinen Seed?

Offizielle Parameter im Überblick

Die generationConfig von Nano Banana Pro (gemini-3-pro-image-preview) unterstützt folgende Parameter:

| Parametername | Funktion | Beispielwert |

|---|---|---|

responseModalities |

Gibt den Ausgabetyp an | ["IMAGE"] |

resolution |

Bildauflösung | "1K" / "2K" / "4K" |

aspectRatio |

Seitenverhältnis | "16:9" / "1:1" / "2:3" |

candidateCount |

Anzahl der gleichzeitig generierten Kandidaten | 1 (Bei der Bilderzeugung fest auf 1 eingestellt) |

temperature |

Zufälligkeit des Textteils (beeinflusst das Bild nicht) | 1.0 (Standardempfehlung) |

seed-Parameter: Nicht in der Liste, offiziell nicht unterstützt.

Ein Versuch, seed im Code zu übergeben, führt direkt zu einem Fehler:

# ❌ Dies führt zu einem Fehler: Unknown field 'seed' in GenerationConfig

response = model.generate_content(

prompt,

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

seed=42 # ← Fehler! Dieser Parameter wird offiziell nicht unterstützt

)

)

Gemini Image API vs. Imagen API: Zwei verschiedene Dienste

Viele finden in der offiziellen Google-Dokumentation tatsächlich einen Seed-Parameter, dieser bezieht sich jedoch auf die Imagen API (der Bildgenerierungsdienst auf Vertex AI) und nicht auf Nano Banana Pro:

| Vergleichspunkt | Nano Banana Pro | Imagen API (Vertex AI) |

|---|---|---|

| Modell-ID | gemini-3-pro-image-preview |

imagen-3.0-generate-002 |

| Seed-Unterstützung | ❌ Nicht unterstützt | ✅ Unterstützt (seed-Parameter) |

| API-Endpunkt | Google Generative AI | Vertex AI |

| SDK-Aufruf | google-generativeai |

google-cloud-aiplatform |

| Bildqualität | Erstklassiger Fotorealismus, starkes Text-Rendering | Hohe Qualität, vielfältige Stile |

| Preis (APIYI) | $0.05 pro Bild | Separate Preisgestaltung |

Fazit: Wenn Sie unbedingt Seed-Reproduzierbarkeit benötigen, sollten Sie zur Imagen API wechseln, anstatt zu versuchen, nicht existierende Parameter in Nano Banana Pro zu erzwingen. Drittanbieter-Gateways wie APIYI unterstützen die Imagen API nicht; diese API kann nur mit einem offiziellen API-Key genutzt werden.

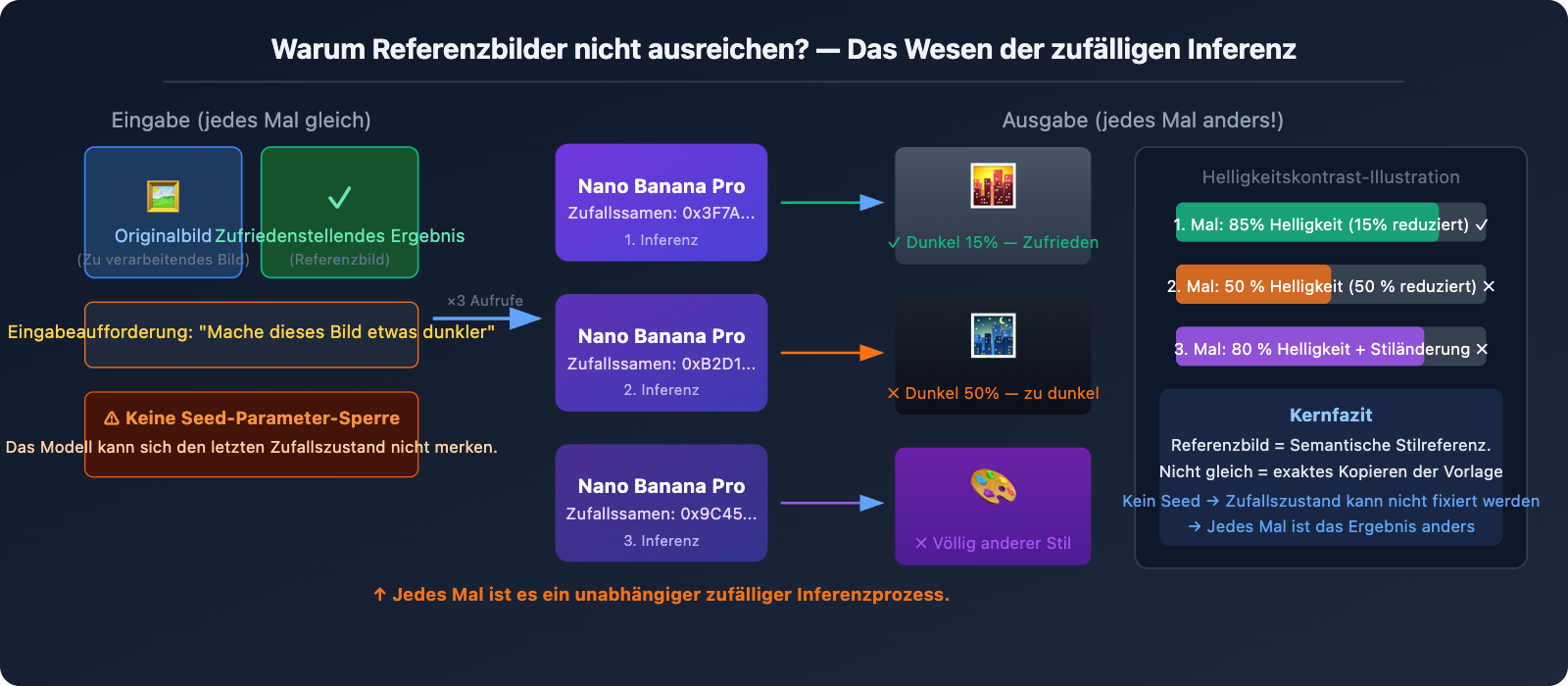

Warum reicht auch ein Referenzbild nicht aus?

Ein zufriedenstellendes Ergebnis als Referenzbild für die nächste Eingabe zu verwenden, ist der intuitivste Ansatz, aber der tatsächliche Effekt ist eher „durchwachsen“. Der Hauptgrund ist:

Nano Banana Pro interpretiert das Referenzbild als „Stilreferenz“ und nicht als „Kopiervorlage“. Wenn Sie ein Referenzbild hochladen und sagen „mach dieses Bild etwas dunkler“, wird das Modell:

- Den allgemeinen Stil, die Komposition und den Inhalt des Referenzbildes analysieren.

- Die Anweisung „etwas dunkler“ neu interpretieren.

- Von Grund auf ein neues Bild generieren, das der Anweisung entspricht.

Dieser Prozess ist jedes Mal mit Zufälligkeit behaftet. Daher könnte „ein bisschen dunkler“ beim ersten Mal genau die von Ihnen gewünschte Helligkeitsreduzierung von 15 % treffen, beim zweiten Mal sind es 50 % und beim dritten Mal ein völlig anderer Stil.

5 Alternativen: Vom direkten Weg bis zur radikalen Lösung

Lösung 1: Präzise quantitative Eingabeaufforderungen (Sofortige Wirkung)

Problemszenario: "Mach das Bild ein bisschen dunkler" → Das Ergebnis ist mal zu dunkel, mal zu hell.

Die Ursache liegt darin, dass "ein bisschen" zu vage ist. Nano Banana Pro kann nicht garantieren, dass das Verständnis von "ein bisschen" jedes Mal konsistent ist. Die Lösung besteht darin, vage Beschreibungen durch numerische Werte zu ersetzen:

❌ Vage Eingabeaufforderung:

"Make this image slightly darker"

"Mach das Bild ein bisschen dunkler"

✅ Quantitative Eingabeaufforderung:

"Apply a subtle darkening effect equivalent to reducing brightness by

approximately 15-20%. The image should feel slightly moodier but all

details must remain clearly visible. Do NOT go dark. The result should

be close to: brightness 85% of original, contrast unchanged."

Quantitative Formulierungen für gängige Anpassungen:

Helligkeitsanpassung:

"brightness at 85% of original" (15 % Reduzierung)

"increase brightness by 10%, keep contrast" (10 % Aufhellung)

Farbtonanpassung:

"add a very subtle warm orange tint, color shift about 10%"

"slight cool blue cast, saturation unchanged"

Stilintensität:

"apply film grain texture at 20% opacity, barely noticeable"

"add very subtle vignette at corners, 15% strength"

💡 Wichtiger Tipp: Verwenden Sie in der Eingabeaufforderung Begriffe wie "approximately X%", "not exceeding Y%", "subtle/barely noticeable", um dem Modell klare Grenzen für den Umfang der Änderung zu setzen.

Lösung 2: Kombination aus Referenzbild + präzisem Prompt (Empfohlene Wahl)

Das bloße Hochladen eines Referenzbildes führt oft zu instabilen Ergebnissen. Die Kombination aus Referenzbild + quantitativer Eingabeaufforderung ist jedoch deutlich effektiver:

import google.generativeai as genai

import base64

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # APIYI $0,05/Aufruf

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

def apply_consistent_effect(

source_image_path: str, # Das neue zu bearbeitende Bild

approved_result_path: str, # Das erste zufriedenstellende Ergebnis (als Stilreferenz)

effect_description: str, # Präzise quantitative Effektbeschreibung

output_path: str

) -> str:

"""

Reproduziert einen gewünschten Effekt auf einem neuen Bild.

Nutzt Referenzbild + präzise quantitative Eingabeaufforderung als doppelte Verankerung.

"""

# Zwei Bilder einlesen

with open(source_image_path, "rb") as f:

source_data = base64.b64encode(f.read()).decode()

with open(approved_result_path, "rb") as f:

approved_data = base64.b64encode(f.read()).decode()

prompt = f"""

I have two reference images:

- Image 1 (source): The new image I want to process

- Image 2 (approved result): A previous edit I was very happy with

Please apply the SAME effect from Image 2 to Image 1.

The effect is: {effect_description}

Critical instructions:

- The degree of change should match Image 2 EXACTLY

- Do not over-apply the effect

- Keep all other image properties unchanged

- If unsure about intensity, err on the side of LESS change

"""

response = model.generate_content(

[

{"inline_data": {"mime_type": "image/jpeg", "data": source_data}},

{"inline_data": {"mime_type": "image/jpeg", "data": approved_data}},

prompt

],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K",

aspect_ratio="1:1"

)

)

for part in response.candidates[0].content.parts:

if part.inline_data and part.inline_data.mime_type.startswith("image/"):

with open(output_path, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output_path

return None

# Anwendungsbeispiel

result = apply_consistent_effect(

source_image_path="new_product_photo.jpg",

approved_result_path="approved_dark_edit.jpg",

effect_description="subtle darkening, brightness reduced by approximately 15-20%, "

"image should be slightly moodier but all details clearly visible",

output_path="output_consistent.png"

)

# $0,05 pro Aufruf (APIYI apiyi.com)

🚀 Praxistipp: Diese Methode verbessert die Konsistenz von "völlig zufällig" auf "mit hoher Wahrscheinlichkeit wie erwartet", ist aber immer noch nicht zu 100 % garantiert. Es empfiehlt sich, pro Batch 2-3 Varianten zu generieren (da

candidateCountoft Fehler wirft, sind mehrere Aufrufe nötig) und manuell die beste auszuwählen. Die niedrigen Kosten von $0,05 bei APIYI machen dieses mehrfache Sampling wirtschaftlich sinnvoll.

Lösung 3: Mehrfaches Sampling + Batch-Filterung (Ideal für Massenverarbeitung)

Die pragmatischste Lösung für aktuelle Szenarien: Generieren Sie für jedes neue Bild 3-5 Varianten und filtern Sie die beste manuell oder programmgesteuert heraus.

import asyncio

import base64

import os

import google.generativeai as genai

genai.configure(

api_key="YOUR_APIYI_KEY",

client_options={"api_endpoint": "vip.apiyi.com"} # APIYI $0,05/Aufruf

)

model = genai.GenerativeModel("gemini-3-pro-image-preview")

EFFECT_PROMPT = """

Apply subtle darkening effect:

- Brightness: approximately 85% of original (reduce by ~15%)

- Mood: slightly darker, more atmospheric

- Details: all elements must remain clearly visible

- Do NOT: make it too dark, change colors dramatically, lose details

This is a subtle, refined adjustment - less is more.

"""

async def generate_variants(image_path: str, n_variants: int = 3) -> list:

"""Generiert n Varianten desselben Bildes zur Auswahl"""

with open(image_path, "rb") as f:

img_data = base64.b64encode(f.read()).decode()

async def one_call(i: int) -> str:

output = image_path.replace(".jpg", f"_v{i+1}.png")

loop = asyncio.get_event_loop()

try:

response = await loop.run_in_executor(None, lambda: model.generate_content(

[{"inline_data": {"mime_type": "image/jpeg", "data": img_data}},

EFFECT_PROMPT],

generation_config=genai.GenerationConfig(

response_modalities=["IMAGE"],

resolution="4K"

)

))

for part in response.candidates[0].content.parts:

if part.inline_data:

with open(output, "wb") as f:

f.write(base64.b64decode(part.inline_data.data))

return output

except Exception as e:

print(f" Variante {i+1} fehlgeschlagen: {e}")

return None

# Mehrere Varianten gleichzeitig generieren

results = await asyncio.gather(*[one_call(i) for i in range(n_variants)])

return [r for r in results if r]

async def batch_process(image_list: list, n_variants: int = 3):

"""Verarbeitet mehrere Bilder im Batch und generiert pro Bild mehrere Varianten"""

for img_path in image_list:

print(f"\nVerarbeitung: {img_path}")

variants = await generate_variants(img_path, n_variants)

cost = len(variants) * 0.05

print(f" {len(variants)} Varianten generiert, Kosten ${cost:.2f} (APIYI)")

print(f" Dateien: {variants}")

print(f" → Bitte wählen Sie die beste Variante manuell aus")

# Beispiel: 5 Bilder verarbeiten, jeweils 3 Varianten generieren

images = ["photo_01.jpg", "photo_02.jpg", "photo_03.jpg", "photo_04.jpg", "photo_05.jpg"]

asyncio.run(batch_process(images, n_variants=3))

# 5 Bilder × 3 Varianten = 15 Aufrufe, Gesamtkosten bei APIYI: $0,75

Kostenschätzung:

| Umfang | Anzahl Varianten | Gesamtzahl Aufrufe | Kosten (APIYI) |

|---|---|---|---|

| 10 Bilder | 3 pro Bild | 30 Aufrufe | $1,50 |

| 50 Bilder | 3 pro Bild | 150 Aufrufe | $7,50 |

| 100 Bilder | 2 pro Bild | 200 Aufrufe | $10,00 |

Lösung 4: Wechsel zu Modellen mit Seed-Unterstützung (Die fundamentale Lösung)

Wenn Ihr Geschäft eine exakte Reproduzierbarkeit erfordert, ist der konsequenteste Weg der Wechsel zu einem Modell, das Seeds nativ unterstützt:

Imagen API (Vertex AI) – ebenfalls von Google, unterstützt Seeds:

from google.cloud import aiplatform

from vertexai.preview.vision_models import ImageGenerationModel

# Imagen API unterstützt den Parameter 'seed'

model = ImageGenerationModel.from_pretrained("imagen-3.0-generate-002")

response = model.generate_images(

prompt="your prompt here",

seed=42, # ✅ Offiziell unterstützt!

number_of_images=1,

add_watermark=False # Bei Verwendung eines Seeds muss das Wasserzeichen deaktiviert werden

)

# Gleicher Seed + gleiche Eingabeaufforderung → Gleiches Ergebnis (hohe Reproduzierbarkeit)

Stable Diffusion / Flux – vollständiges Seed-Ökosystem:

# Zugriff auf Flux über APIYI (apiyi.com), unterstützt Seeds

import requests

response = requests.post(

"https://vip.apiyi.com/v1/images/generations",

headers={"Authorization": "Bearer YOUR_APIYI_KEY"},

json={

"model": "flux-dev", # oder flux-schnell

"prompt": "your prompt",

"seed": 12345, # ✅ Volle Seed-Unterstützung

"width": 1024,

"height": 1024

}

)

# Seed fixieren → Konsistente Basisbilder im Batch generieren

Lösung 5: Bild-Nachbearbeitung (Höchste Präzision, maximale Stabilität)

Wenn Ihre Anforderung darin besteht, im Batch eine feste Helligkeits- oder Farbanpassung vorzunehmen (z. B. alle Bilder einheitlich um 15 % abzudunkeln), ist die KI-Generierung eigentlich nicht die beste Wahl – klassische Bild-Nachbearbeitung ist hier das richtige Werkzeug:

from PIL import Image, ImageEnhance

import os

def batch_darken(input_dir: str, output_dir: str, brightness_factor: float = 0.85):

"""

Präzise Batch-Anpassung der Helligkeit

brightness_factor: 0.85 = 15 % Reduzierung, 100 % reproduzierbar, null Zufall

"""

os.makedirs(output_dir, exist_ok=True)

files = [f for f in os.listdir(input_dir) if f.lower().endswith(('.jpg', '.png', '.webp'))]

for filename in files:

img = Image.open(os.path.join(input_dir, filename))

enhancer = ImageEnhance.Brightness(img)

# Präzise Steuerung der Helligkeit, jedes Ergebnis ist identisch

darkened = enhancer.enhance(brightness_factor)

darkened.save(os.path.join(output_dir, filename))

print(f"✓ {filename} → Helligkeit {brightness_factor*100:.0f}%")

# Batch-Verarbeitung, null API-Kosten, 100 % reproduzierbar

batch_darken("input_images/", "darkened_output/", brightness_factor=0.85)

Vergleich der Einsatzszenarien:

| Anpassungstyp | Empfohlenes Tool | Grund |

|---|---|---|

| Einheitliche Helligkeit/Kontrast/Sättigung | PIL / Photoshop Batch | Präzise, reproduzierbar, kostenlos |

| Einheitliche Farbfilter (Warm/Kalt) | PIL / LUT-Filter | 100 % Konsistenz |

| Komplexe Stilübertragung (Hintergrund/Objekt tauschen) | Nano Banana Pro | Hier liegt der wahre Wert der KI |

| Präzise Reproduktion mit kreativen Variationen | Imagen API (mit Seed) | Balance zwischen Qualität und Konsistenz |

🎯 Ehrlicher Rat: Wenn Sie nur "Bilder um 15 % dunkler machen" wollen, nutzen Sie

ImageEnhance.Brightnessvon PIL. Es kostet nichts, ist zu 100 % konsistent und mit einer Zeile Code erledigt. Der Wert von KI-Bildgenerierung liegt im komplexen Inhaltsverständnis und der kreativen Erzeugung, nicht in präzisen parametrischen Anpassungen.

Vergleich der Seed-Unterstützung gängiger AI-Bildmodelle

| Modell | Seed-Unterstützung | Reproduzierbarkeit | Anmerkungen |

|---|---|---|---|

| Nano Banana Pro | ❌ Nicht unterstützt | Niedrig, jedes Mal zufällig | Referenzbilder + Eingabeaufforderungen können dies teilweise verbessern |

| Imagen API | ✅ Offiziell unterstützt | Hoch | Reproduzierbar mit gleichem Seed und derselben Eingabeaufforderung |

| Stable Diffusion | ✅ Vollständige Unterstützung | Sehr hoch | Open-Source-Ökosystem, lokal oder in der Cloud |

| Flux Dev/Pro | ✅ Unterstützt | Hoch | Starker Realismus, API-Zugang möglich |

| Midjourney | ✅ --seed Parameter |

Mittel (Referenz-Niveau) | Ähnlicher Stil bei gleichem Seed, aber nicht exakt identisch |

| DALL-E 3 | ❌ Nicht unterstützt | Niedrig | Ähnliche Einschränkungen wie bei Nano Banana Pro |

💡 Plattform-Empfehlung: Über APIYI (apiyi.com) können Sie zentral auf mehrere Bildmodelle wie Nano Banana Pro, Flux und Stable Diffusion zugreifen. Mit einem einzigen API-Key wechseln Sie flexibel zwischen den Modellen, je nachdem, ob Sie eine Seed-Unterstützung benötigen oder nicht.

Häufig gestellte Fragen

F1: Gibt es eine Möglichkeit, den „Seed-Effekt“ auf Nano Banana Pro zu „erzwingen“?

Es gibt keinen echten „Hack“ im eigentlichen Sinne. Einige Drittanbieter-Plattformen (wie fal.ai) fügen einen Seed-Parameter in ihrer API-Wrapper-Ebene hinzu, aber dies steuert lediglich die Zufälligkeit auf ihrer Plattformebene. Das ist nicht gleichbedeutend mit dem nativen Seed der Google Gemini-Bilderzeugung – tatsächlich ist der Einfluss auf die Reproduzierbarkeit des endgültigen Bildes sehr begrenzt.

Die Kombination, die dem „Seed-Effekt“ am nächsten kommt, ist: Präzise quantitative Eingabeaufforderungen + ein zufriedenstellendes Ergebnis als Referenzbild + mehrfaches Sampling und Filtern. Diese drei Faktoren zusammen können die Konsistenz von völliger Zufälligkeit auf eine Trefferwahrscheinlichkeit von etwa 60-70 % steigern, aber sie wird niemals 100 % erreichen.

Wenn Ihr Workflow zwingende Anforderungen an die Reproduzierbarkeit stellt, empfehlen wir den Wechsel zur Imagen API. Über APIYI (apiyi.com) können Sie gleichzeitig auf mehrere Dienste zugreifen, um Vergleichstests durchzuführen.

F2: Ich möchte den Effekt „etwas dunkler“ im Batch-Verfahren reproduzieren. Was ist der schnellste Weg?

Das hängt von der Art der „Dunkelheit“ ab:

- Wenn es nur um Helligkeits-/Belichtungsanpassungen geht: Nutzen Sie direkt Python PIL

ImageEnhance.Brightness(img).enhance(0.85)für die Stapelverarbeitung. 10 Zeilen Code, null Kosten, 100 % konsistent. - Wenn es um Stil, Atmosphäre oder KI-Inhaltsgenerierung geht (z. B. „dunkler Farbton bei gleichzeitig filmischerem Hintergrund“): Nutzen Sie Option 2 (Referenzbild + quantitative Eingabeaufforderung). Über APIYI (apiyi.com) können Sie Batch-Aufrufe für ca. 0,05 $ pro Bild tätigen, 2-3 Varianten generieren und manuell die beste auswählen.

F3: Wird Nano Banana Pro in Zukunft Seed-Parameter unterstützen?

Derzeit gibt es keine offizielle Ankündigung. Aus der Produkt-Roadmap von Google geht hervor, dass die Imagen API speziell für die präzise steuerbare Bilderzeugung (einschließlich Seed) konzipiert ist, während die Gemini-Bilderzeugung eher auf „hochwertige kreative Generierung“ ausgerichtet ist. Beide haben unterschiedliche Positionierungen; die Möglichkeit, dass Nano Banana Pro in Zukunft Seed-Parameter erhält, besteht, ist aber ungewiss.

Sie können den offiziellen Google AI Blog (blog.google/technology/google-deepmind) und das Gemini API Changelog (ai.google.dev/gemini-api/docs/changelog) verfolgen, um die neuesten Updates zu erhalten. Sobald es Neuerungen gibt, werden wir umgehend entsprechende Anleitungen auf APIYI (apiyi.com) veröffentlichen.

Fazit

Man muss der Tatsache ins Auge sehen, dass Nano Banana Pro keine Seed-Parameter unterstützt. Hier sind 5 Alternativen, die je nach Szenario gewählt werden können:

- Präzise quantitative Eingabeaufforderungen: Ersetzen Sie vage Beschreibungen wie „ein bisschen“ durch numerische Werte – das zeigt sofort Wirkung.

- Referenzbild + quantitative Eingabeaufforderungen: Eingabe von zwei Bildern (Quellbild + zufriedenstellendes Ergebnis), um den Grad des zu reproduzierenden Effekts präzise zu beschreiben.

- Mehrfaches Sampling und Filtern: Generieren Sie 2-3 Varianten pro Bild. Dank der niedrigen Kosten von 0,05 $/Aufruf bei APIYI ist diese Strategie absolut machbar; bei den Originalpreisen (0,24 $/Aufruf) wäre dies fünfmal so teuer.

- Wechsel zur Imagen API / Flux: Wenn Ihr Business harte Anforderungen an die Reproduzierbarkeit stellt, wechseln Sie zu Modellen mit nativem Seed-Support.

- PIL-Nachbearbeitung: Wenn es nur um feste Anpassungen von Helligkeit oder Farbton geht, ist KI nicht das optimale Werkzeug – PIL ist hier genauer.

Es gibt keine eierlegende Wollmilchsau; wählen Sie die Lösung, die am besten zu Ihrem aktuellen Szenario passt. Die geringen Kosten für mehrfaches Sampling (0,05 $/Aufruf) machen die „Trial-and-Error“-Strategie auf der APIYI-Plattform (apiyi.com) wirtschaftlich sinnvoll.

Referenzen

-

Google Gemini API Dokumentation für Bildgenerierungsparameter

- Link:

ai.google.dev/gemini-api/docs/image-generation - Beschreibung: Offizielle Liste der unterstützten Parameter in

generationConfig, Bestätigung, dass keinseed-Feld vorhanden ist.

- Link:

-

Vertex AI Imagen API Dokumentation (mit Seed-Unterstützung)

- Link:

cloud.google.com/vertex-ai/generative-ai/docs/image/generate-images - Beschreibung: Verwendung und Einschränkungen des

seed-Parameters in der Imagen API.

- Link:

-

Gemini Python SDK GitHub Issue #536

- Link:

github.com/google-gemini/deprecated-generative-ai-python/issues/536 - Beschreibung: Community-Diskussion zur Bestätigung, dass der

seed-Parameter in der Gemini-Bildgenerierung nicht unterstützt wird.

- Link:

-

APIYI-Plattform Multi-Modell-Integration

- Link:

docs.apiyi.com - Beschreibung: Einheitliche Integrationsanleitung für Nano Banana Pro / Imagen / Flux.

- Link:

Autor: Technik-Team

Technischer Austausch: Haben Sie ähnliche Probleme mit der Konsistenz bei der Stapelgenerierung? Diskutieren Sie gerne im Kommentarbereich mit uns. Weitere Praxiserfahrungen zur KI-Bildgenerierung finden Sie in der APIYI-Tech-Community unter apiyi.com.