Sora 2とVeo 3の画像から動画生成機能を徹底比較:参照画像1枚 vs 最初と最後のフレーム2枚制御、開発者に最適なAPIの選び方

AI動画生成の分野において、画像から動画生成(Image-to-Video)は最も注目される機能の一つです。しかし、多くの開発者がSora 2とVeo 3の画像アップロード機能について誤解しています。Sora 2は本当に画像を最初のフレームとしてしか使えないのでしょうか?Veo 3の2枚の画像はどのように機能するのでしょうか?本記事では、2つの主要モデルの核心的な違いを詳しく解説します。

この記事の価値:この記事を読むことで、Sora 2の参照画像とVeo 3の最初と最後のフレームの本質的な違いを理解し、制作ニーズに応じて最適なAPIを選択する方法を習得できます。

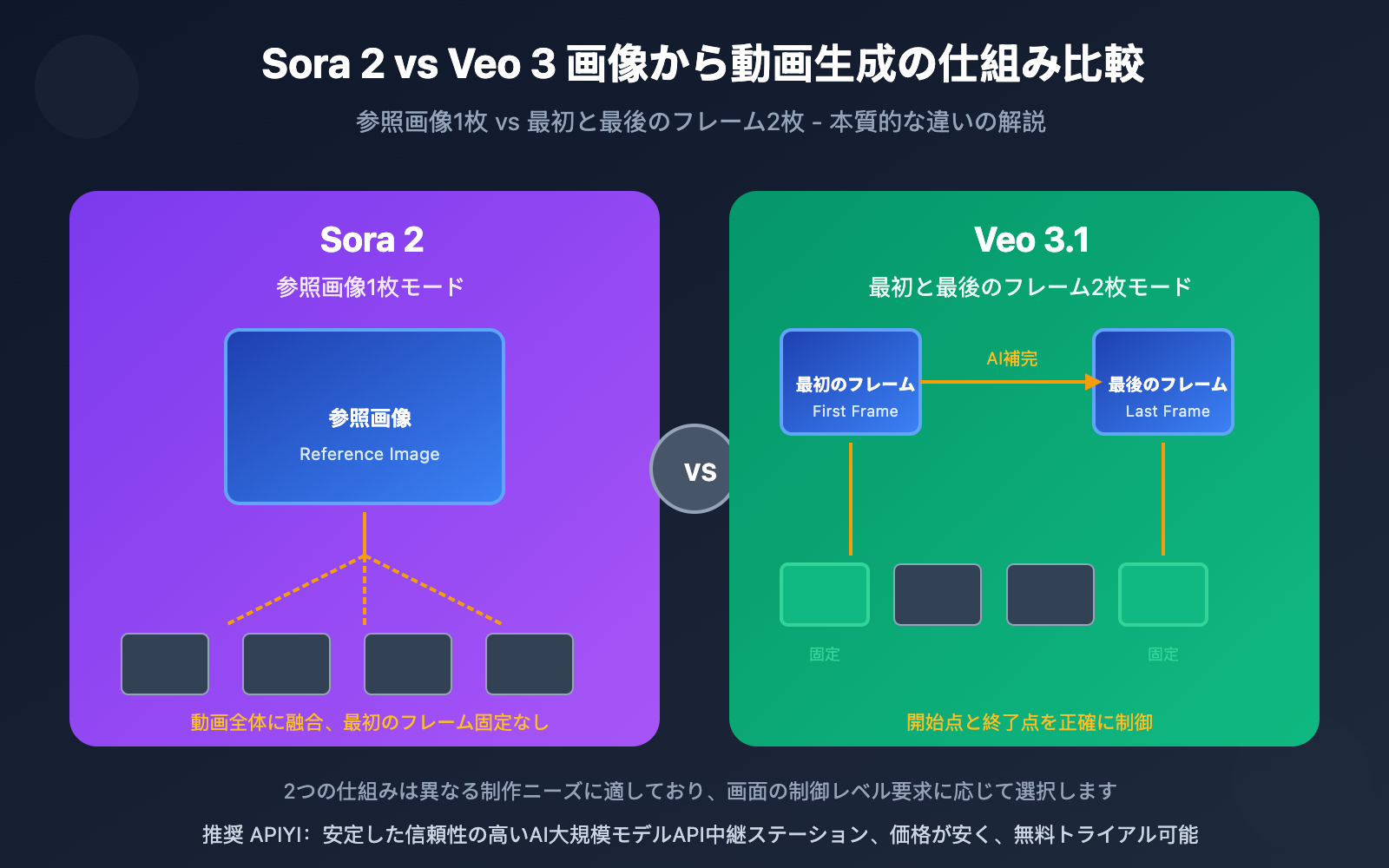

Sora 2 vs Veo 3 画像から動画生成の核心的な違い

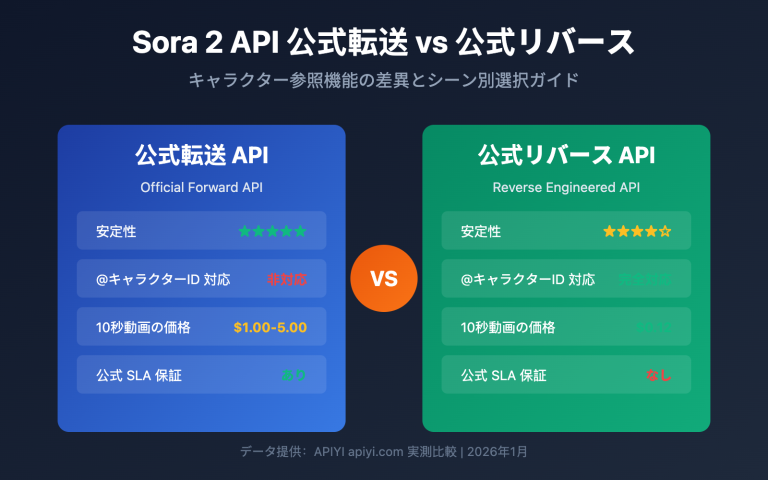

| 比較項目 | Sora 2 | Veo 3.1 |

|---|---|---|

| 画像枚数 | 1枚 | 2枚 |

| 画像の役割 | 参照画像(動画スタイルに融合) | 最初のフレーム画像 + 最後のフレーム画像 |

| 最初のフレーム固定 | 不要、任意の位置に融合可能 | 必須、最初と最後を厳密に制御 |

| 創造的自由度 | 高い(AIが融合方法を決定) | 中程度(明確な開始点と終了点) |

| 適用シーン | スタイル参照、キャラクター一貫性 | トランジションアニメーション、精密制御 |

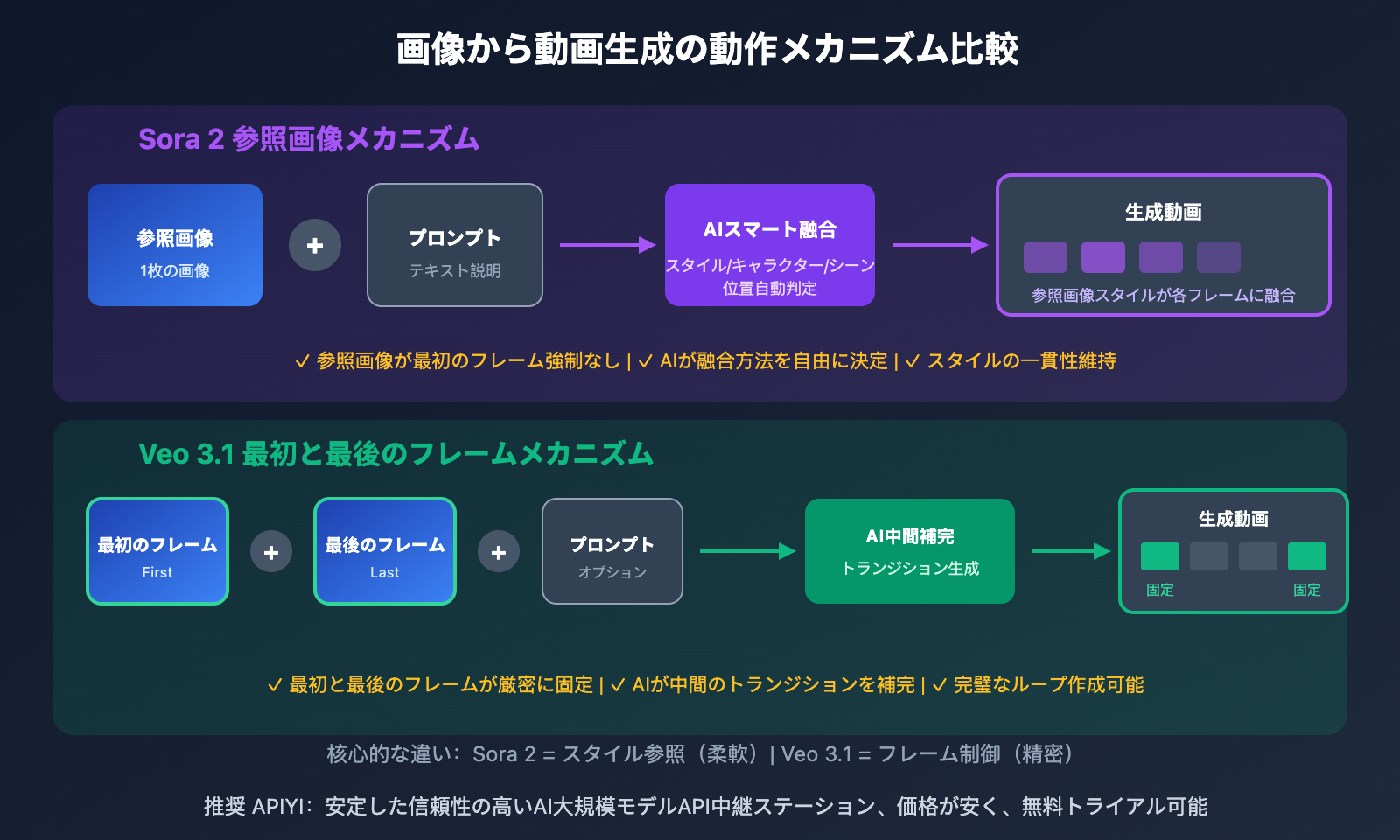

Sora 2の画像から動画生成:参照画像1枚の真実

多くの人がSora 2の画像入力を「最初のフレーム画像」だと誤解していますが、これはよくある誤解です。実際には、Sora 2の画像は「参照画像」(Reference Image)であり、その役割は動画に視覚的スタイル、キャラクターデザイン、シーン参照を提供することで、動画の最初のフレームとして強制的に固定するものではありません。

参照画像の動作原理:

- スタイルの融合:参照画像の色調、光と影、アートスタイルが動画全体に影響します

- キャラクターの一貫性:キャラクター画像をアップロードすることで、動画内でキャラクターの外観を一貫させることができます

- シーン参照:環境画像を提供することで、AIが求める雰囲気を理解します

- 最初のフレーム固定なし:AIはプロンプトに基づいて、参照画像をどのように融合するかを決定します

もちろん、プロンプトで「この画像から始める」と明確に要求すれば、Sora 2もそれを最初のフレームとして処理します。しかし、これはプロンプト制御の結果であり、画像アップロードの固有の制限ではありません。

Sora 2 画像から動画生成 API 呼び出し詳解

Sora 2 画像から動画生成の基本例

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Sora 2 画像から動画生成 - 参照画像モード

response = client.videos.create(

model="sora-2",

prompt="一匹の茶トラ猫が日光の下でのんびりと体を伸ばし、カメラがゆっくりと近づく",

input_reference=open("cat_reference.jpg", "rb"), # 参照画像

size="1280x720",

seconds=8

)

Sora 2 完全な呼び出し例を見る(結果取得のポーリング含む)

import openai

import time

def generate_video_with_reference(

prompt: str,

reference_image_path: str,

model: str = "sora-2",

size: str = "1280x720",

seconds: int = 8

) -> dict:

"""

Sora 2 参照画像を使用して動画を生成

Args:

prompt: 動画の説明

reference_image_path: 参照画像のパス

model: sora-2 または sora-2-pro

size: 動画のサイズ

seconds: 動画の長さ (4/8/12)

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# 動画生成タスクを作成

with open(reference_image_path, "rb") as img_file:

response = client.videos.create(

model=model,

prompt=prompt,

input_reference=img_file,

size=size,

seconds=seconds

)

video_id = response.id

print(f"動画生成タスクが作成されました: {video_id}")

# 完了まで待機(ポーリング)

while True:

status = client.videos.retrieve(video_id)

if status.status == "completed":

return {

"success": True,

"video_url": status.video_url,

"duration": seconds

}

elif status.status == "failed":

return {"success": False, "error": status.error}

print(f"生成中... ステータス: {status.status}")

time.sleep(5)

# 使用例

result = generate_video_with_reference(

prompt="キャラクターが街の通りを歩く、温かな日差し、映画のような質感",

reference_image_path="character.jpg"

)

おすすめ: APIYI apiyi.com を通じて Sora 2 API を利用すると、安定したインターフェースサービスと無料のテスト枠が提供され、画像から動画生成の効果を素早く検証できます。

Veo 3.1 始点・終点フレーム制御:2枚の画像の活用法

Sora 2 の参照画像モードとは異なり、Veo 3.1 は2枚の画像をアップロードして、それぞれ動画の始点フレームと終点フレームとして使用できます。AIが自動的に中間の遷移アニメーションを生成し、AからBへのスムーズな変換を実現します。

Veo 3.1 始点・終点フレームの主要な利点

| 機能 | 説明 | 適用シーン |

|---|---|---|

| 正確な制御 | 動画の開始点と終了点を明確に設定 | 製品展示、シーン転換 |

| トランジション効果 | AIが自動的に中間アニメーションを補完 | クリエイティブな切り替え、変形アニメーション |

| ループ動画 | 始点と終点が同じで完璧なループを作成 | 背景アニメーション、ローディングエフェクト |

| 物語の制御 | A状態からB状態への変化 | ストーリーテリング、感情表現 |

Veo 3.1 始点・終点フレーム API 呼び出し例

import google.generativeai as genai

from google.genai import types

# API設定(APIYI経由)

genai.configure(api_key="YOUR_API_KEY")

# 始点フレームと終点フレームの画像を読み込む

first_frame = genai.upload_file("start_scene.jpg")

last_frame = genai.upload_file("end_scene.jpg")

# Veo 3.1 始点・終点フレーム生成

response = genai.models.generate_videos(

model="veo-3.1",

prompt="スムーズなシーン遷移、映画レベルの画質",

image=first_frame,

config=types.GenerateVideosConfig(

last_frame=last_frame,

duration_seconds=8

)

)

Veo 3.1 特別機能: 始点・終点フレーム制御に加えて、Veo 3.1 は最大4枚の参照画像をビジュアルガイドとして使用でき、キャラクターとスタイルの一貫性を保つことができます。この機能はVeo 3.1標準版でのみ利用可能で、Fast版ではサポートされていません。

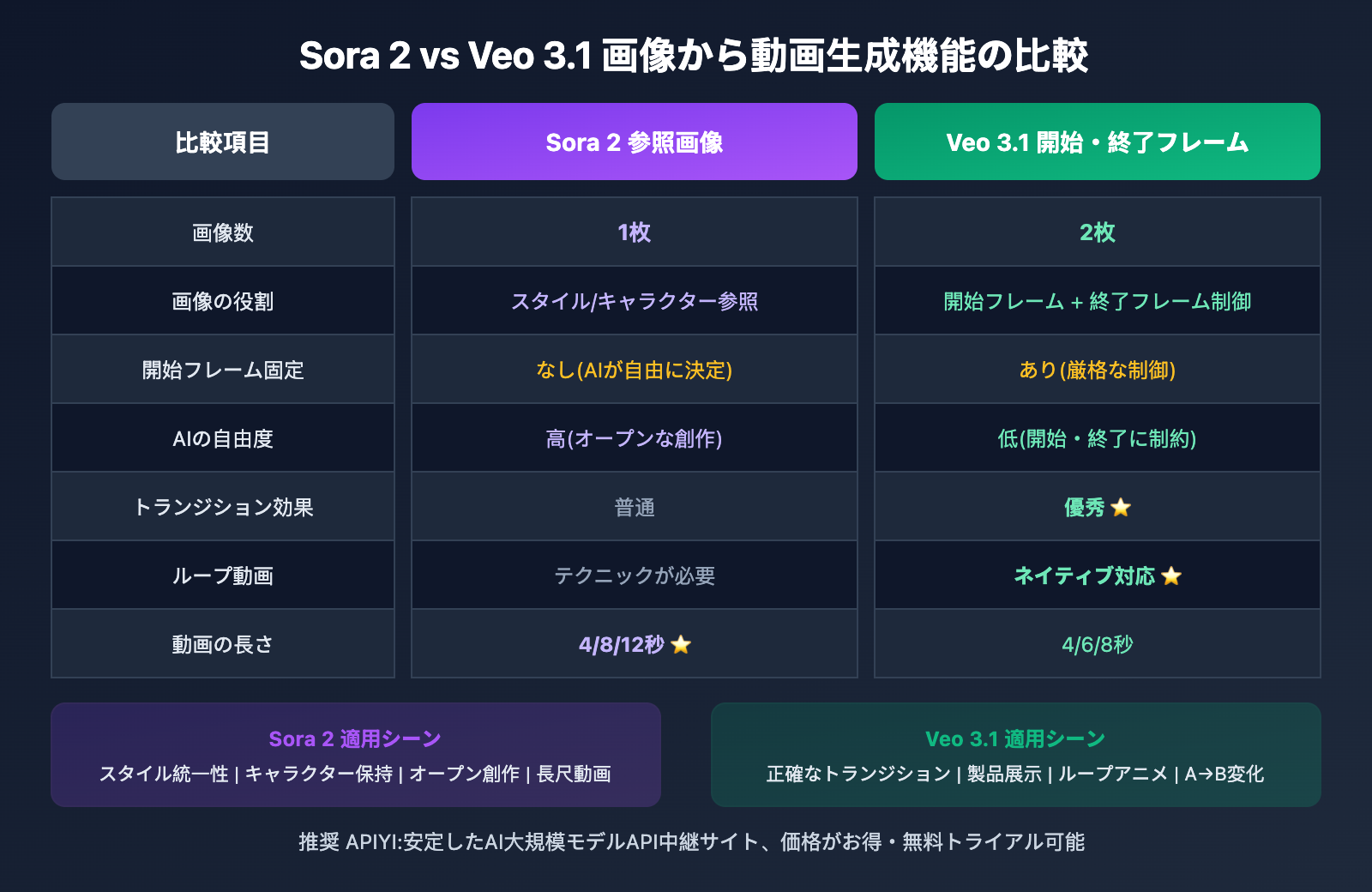

| 比較項目 | Sora 2 参照画像モード | Veo 3.1 開始・終了フレームモード |

|---|---|---|

| 画像数 | 1枚 | 2枚(開始 + 終了) |

| 画像の役割 | スタイル/キャラクター参照 | 正確なフレーム制御 |

| AIの自由度 | 高 | 低(開始・終了に制約) |

| 創作の方向性 | オープンな探索 | 明確な目標 |

| トランジション能力 | 普通 | 優秀 |

| ループ動画 | テクニックが必要 | ネイティブ対応 |

| 動画の長さ | 4/8/12秒 | 4/6/8秒 |

| 解像度 | 720p/1080p | 720p以上 |

どちらを選ぶべき?シーン別の選択ガイド

Sora 2を選ぶ場合:

- キャラクターやシーンの参照画像が1枚あり、AIに自由な創造性を発揮させたい

- ブランドの視覚的スタイルの一貫性を保つ必要がある

- AIに最適な画面構成や動きの軌跡を決定させたい

- 12秒の動画コンテンツを制作する

Veo 3.1を選ぶ場合:

- 動画の開始と終了の画面が明確に決まっている

- 製品AからBへの変化を見せる必要がある

- 完璧にループする背景アニメーションを作りたい

- シーン転換や変形エフェクトを制作する

よくある質問

Q1: Sora 2の参照画像は必ず最初のフレームに表示されますか?

必ずしもそうではありません。Sora 2の参照画像は「ビジュアルリファレンス」であり、「最初のフレーム固定」ではありません。AIはプロンプトに基づいて、参照画像の要素をどのように動画に組み込むかを判断します。参照画像を最初のフレームとして使用したい場合は、プロンプトで明確に指定してください:「この画像を開始画面として使用する」。

Q2: Veo 3.1の2枚の画像は全く異なる内容でも構いませんか?

可能ですが、ある程度のビジュアル的な関連性を持たせることをおすすめします。Veo 3.1は2枚の画像間でスムーズなトランジションを作成しようとしますが、内容の差が大きすぎると、トランジション効果が不自然になる可能性があります。ベストプラクティスは、最初と最後の画像が構図、色調、または主要要素において一定の連続性を持つことです。

Q3: どちらのモデルの画像から動画への品質が優れていますか?

それぞれに優れた点があります:Sora 2 Proは画質と自然な動きにおいて優れており、映画レベルのコンテンツ制作に適しています。一方、Veo 3.1は精密な制御とトランジション効果において一歩リードしています。APIYI apiyi.comを通じて両モデルをテストし、実際の結果に基づいて選択することをおすすめします。

まとめ

Sora 2とVeo 3の画像から動画への変換における主な違い:

- 画像枚数の違い: Sora 2は1枚の参照画像をサポート、Veo 3.1は最初と最後のフレームとして2枚をサポート

- 画像の役割の違い: Sora 2の参照画像は動画のスタイルに融合、Veo 3.1の最初と最後のフレームは開始と終了を正確に制御

- 適用シーンの違い: Sora 2はオープンエンドな創作に適し、Veo 3.1は明確な目標を持つトランジション効果に適しています

この2つのメカニズムの本質的な違いを理解することで、具体的なニーズに応じて最適なAPIを選択し、より良い創作効果を実現できます。

APIYI apiyi.comを通じてSora 2とVeo 3のAPIを同時に利用することをおすすめします。プラットフォームは統一されたインターフェースと無料テスト枠を提供しており、比較テストや柔軟な切り替えが簡単に行えます。

📚 参考資料

⚠️ リンク形式について: すべての外部リンクは

資料名: domain.comの形式で記載しています。コピーは簡単ですが、クリックでの遷移はできません。SEO評価の流出を避けるための措置です。

-

OpenAI Sora API 公式ドキュメント: Sora 動画生成完全ガイド

- リンク:

platform.openai.com/docs/guides/video-generation - 説明: Sora 2 の画像から動画への変換における公式パラメータと使い方を理解できます

- リンク:

-

Google Veo 3.1 始終フレームドキュメント: Vertex AI 動画生成ガイド

- リンク:

docs.cloud.google.com/vertex-ai/generative-ai/docs/video/generate-videos-from-first-and-last-frames - 説明: Veo 3.1 の始終フレーム機能の詳細な使い方を学べます

- リンク:

-

Sora 2 Prompting Guide: OpenAI 公式プロンプトガイド

- リンク:

cookbook.openai.com/examples/sora/sora2_prompting_guide - 説明: 高品質な Sora 2 動画プロンプトの書き方を習得できます

- リンク:

-

Google Veo 3.1 機能解説: 始終フレームと参照画像機能の詳細

- リンク:

getimg.ai/blog/google-veo-3-1-review - 説明: Veo 3.1 の新機能と活用テクニックを深く理解できます

- リンク:

著者: 技術チーム

技術交流: コメント欄でのディスカッションを歓迎します。その他の資料は APIYI apiyi.com 技術コミュニティでご覧いただけます