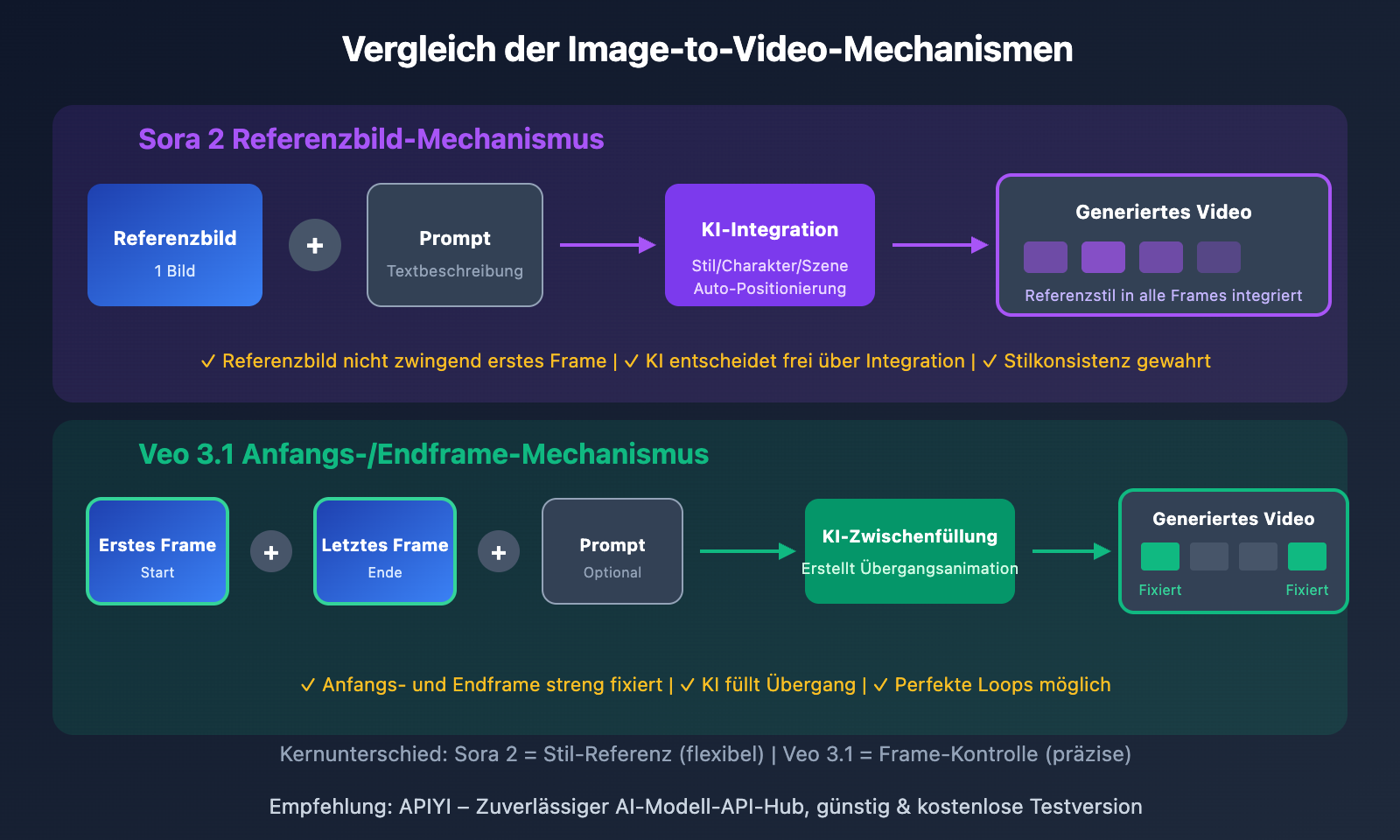

Sora 2 vs Veo 3 Image-to-Video: Kernunterschiede

| Vergleichsdimension | Sora 2 | Veo 3.1 |

|---|---|---|

| Anzahl Bilder | 1 Bild | 2 Bilder |

| Funktion der Bilder | Referenzbild (fügt sich in Videostil ein) | Erstes Frame + Letztes Frame |

| Muss erstes Frame sein | Nein, kann an beliebiger Stelle eingefügt werden | Ja, strenge Kontrolle von Anfang und Ende |

| Kreative Freiheit | Hoch (KI entscheidet über Einbindung) | Mittel (klare Start- und Endpunkte) |

| Anwendungsfälle | Stil-Referenz, Charakter-Konsistenz | Übergänge, präzise Kontrolle |

Sora 2 Image-to-Video: Die Wahrheit über das eine Referenzbild

Viele glauben fälschlicherweise, dass das Eingabebild bei Sora 2 einfach das "erste Frame" ist. Das ist ein weit verbreitetes Missverständnis. Tatsächlich ist das Bild bei Sora 2 ein "Referenzbild" (Reference Image). Seine Aufgabe ist es, dem Video einen visuellen Stil, ein Charakter-Design oder eine Szenenreferenz zu geben – nicht, zwingend als erstes Bild des Videos festgelegt zu werden.

So funktioniert das Referenzbild:

- Stil-Integration: Farbgebung, Licht, Schatten und künstlerischer Stil des Referenzbildes beeinflussen das gesamte Video

- Charakter-Konsistenz: Durch Hochladen eines Charakterbildes bleibt das Aussehen der Figur im Video einheitlich

- Szenen-Referenz: Ein Umgebungsbild hilft der KI, die gewünschte Szenenatmosphäre zu verstehen

- Nicht zwingend erstes Frame: Die KI entscheidet basierend auf dem Prompt, wie das Referenzbild ins Video eingebunden wird

Natürlich wird Sora 2 das Bild als erstes Frame verwenden, wenn dein Prompt explizit fordert "beginne mit diesem Bild". Aber das ist ein Ergebnis der Prompt-Steuerung, keine inhärente Einschränkung des Bild-Uploads.

Sora 2 Bild-zu-Video API Aufruf im Detail

Sora 2 Bild-zu-Video Grundbeispiel

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Sora 2 Bild-zu-Video - Referenzbild-Modus

response = client.videos.create(

model="sora-2",

prompt="Eine orangefarbene Katze streckt sich faul im Sonnenlicht, die Kamera fährt langsam heran",

input_reference=open("cat_reference.jpg", "rb"), # Referenzbild

size="1280x720",

seconds=8

)

Vollständiges Sora 2 Aufrufbeispiel ansehen (mit Polling für Ergebnisse)

import openai

import time

def generate_video_with_reference(

prompt: str,

reference_image_path: str,

model: str = "sora-2",

size: str = "1280x720",

seconds: int = 8

) -> dict:

"""

Video mit Sora 2 Referenzbild generieren

Args:

prompt: Video-Beschreibung

reference_image_path: Pfad zum Referenzbild

model: sora-2 oder sora-2-pro

size: Video-Auflösung

seconds: Video-Dauer (4/8/12)

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Video-Generierungsaufgabe erstellen

with open(reference_image_path, "rb") as img_file:

response = client.videos.create(

model=model,

prompt=prompt,

input_reference=img_file,

size=size,

seconds=seconds

)

video_id = response.id

print(f"Video-Generierungsaufgabe erstellt: {video_id}")

# Polling bis zur Fertigstellung

while True:

status = client.videos.retrieve(video_id)

if status.status == "completed":

return {

"success": True,

"video_url": status.video_url,

"duration": seconds

}

elif status.status == "failed":

return {"success": False, "error": status.error}

print(f"Generierung läuft... Status: {status.status}")

time.sleep(5)

# Verwendungsbeispiel

result = generate_video_with_reference(

prompt="Charakter läuft durch Stadtstraßen, warmes Sonnenlicht, filmische Qualität",

reference_image_path="character.jpg"

)

Tipp: Nutzen Sie die Sora 2 API über APIYI apiyi.com – die Plattform bietet stabile Interface-Services und kostenloses Testguthaben, ideal um schnell Bild-zu-Video-Effekte zu testen.

Veo 3.1 Erstes-und-Letztes-Frame-Kontrolle: Das 2-Bilder-Verfahren

Im Gegensatz zum Referenzbild-Modus von Sora 2 unterstützt Veo 3.1 das Hochladen von 2 Bildern als erstes und letztes Frame des Videos. Die KI generiert automatisch die Übergangsanimation dazwischen und sorgt für eine flüssige Transformation von A nach B.

Kernvorteile von Veo 3.1 Erstes-und-Letztes-Frame

| Funktion | Beschreibung | Anwendungsfall |

|---|---|---|

| Präzise Kontrolle | Klare Definition von Start- und Endpunkt des Videos | Produktpräsentationen, Szenenwechsel |

| Übergangseffekte | KI füllt automatisch die Zwischenanimation | Kreative Übergänge, Morphing-Animationen |

| Loop-Videos | Identische Start- und Endframes ermöglichen perfekte Loops | Hintergrundanimationen, Loading-Effekte |

| Narrative Steuerung | Veränderung von Zustand A zu Zustand B | Storytelling, emotionaler Ausdruck |

Veo 3.1 Erstes-und-Letztes-Frame API Aufrufbeispiel

import google.generativeai as genai

from google.genai import types

# API konfigurieren (über APIYI Relay)

genai.configure(api_key="YOUR_API_KEY")

# Erstes und letztes Frame laden

first_frame = genai.upload_file("start_scene.jpg")

last_frame = genai.upload_file("end_scene.jpg")

# Veo 3.1 Erstes-und-Letztes-Frame-Generierung

response = genai.models.generate_videos(

model="veo-3.1",

prompt="Flüssiger Szenenwechsel, filmische Bildqualität",

image=first_frame,

config=types.GenerateVideosConfig(

last_frame=last_frame,

duration_seconds=8

)

)

Veo 3.1 Spezialfunktion: Neben der Erstes-und-Letztes-Frame-Kontrolle unterstützt Veo 3.1 auch bis zu 4 Referenzbilder als visuelle Leitlinien, um Charaktere und Stile konsistent zu halten. Diese Funktion ist nur in der Veo 3.1 Standardversion verfügbar, die Fast-Version unterstützt sie nicht.

Sora 2 vs Veo 3 Bild-zu-Video-Vergleich

| Vergleichspunkt | Sora 2 Referenzbild-Modus | Veo 3.1 Anfangs-/Endframe-Modus |

|---|---|---|

| Bildanzahl | 1 Bild | 2 Bilder (Anfang + Ende) |

| Bildrolle | Stil-/Charakterreferenz | Präzise Frame-Kontrolle |

| KI-Freiheitsgrad | Hoch | Niedrig (durch Anfangs-/Endframe beschränkt) |

| Kreativrichtung | Offene Erkundung | Klares Ziel |

| Übergangsfähigkeit | Durchschnittlich | Hervorragend |

| Loop-Videos | Erfordert Tricks | Native Unterstützung |

| Videolänge | 4/8/12 Sek. | 4/6/8 Sek. |

| Auflösung | 720p/1080p | ab 720p |

Wie wählst du? Szenario-Entscheidungsleitfaden

Wähle Sora 2, wenn:

- Du ein Charakter-/Szenen-Referenzbild hast und die KI kreativ experimentieren lassen möchtest

- Du die visuelle Konsistenz einer Marke beibehalten musst

- Du willst, dass die KI die optimale Bildkomposition und Bewegungsbahn bestimmt

- Du Videoinhalte mit einer Länge von 12 Sekunden erstellst

Wähle Veo 3.1, wenn:

- Du genau weißt, wie das Start- und Endbild des Videos aussehen soll

- Du eine A→B-Transformation eines Produkts zeigen möchtest

- Du perfekt geloopte Hintergrundanimationen erstellen willst

- Du Szenenübergänge oder Morphing-Effekte produzierst

Häufig gestellte Fragen

Q1: Erscheint das Referenzbild von Sora 2 immer im ersten Frame?

Nicht unbedingt. Das Referenzbild von Sora 2 dient als "visuelle Referenz" und nicht als "festgelegter erster Frame". Die KI entscheidet basierend auf Ihrem Prompt, wie Elemente des Referenzbildes ins Video integriert werden. Wenn Sie das Referenzbild als ersten Frame benötigen, können Sie dies im Prompt explizit angeben: "Beginne mit diesem Bild als Startframe".

Q2: Können die zwei Bilder von Veo 3.1 völlig unterschiedliche Inhalte zeigen?

Ja, aber wir empfehlen einen gewissen visuellen Zusammenhang. Veo 3.1 versucht, einen fließenden Übergang zwischen den beiden Bildern zu erstellen. Wenn die Inhalte zu unterschiedlich sind, kann der Übergang unnatürlich wirken. Die Best Practice ist, dass Anfangs- und Endbild eine gewisse Kontinuität in Komposition, Farbgebung oder Hauptmotiv aufweisen.

Q3: Welches Modell liefert bessere Bild-zu-Video-Qualität?

Beide haben ihre Stärken: Sora 2 Pro glänzt bei Bildqualität und natürlichen Bewegungen – ideal für filmische Inhalte. Veo 3.1 punktet bei präziser Kontrolle und Übergangseffekten. Wir empfehlen, beide Modelle über APIYI apiyi.com zu testen und basierend auf den tatsächlichen Ergebnissen zu wählen.

Zusammenfassung

Die wesentlichen Unterschiede zwischen Sora 2 und Veo 3 bei der Bild-zu-Video-Generierung:

- Unterschiedliche Bildanzahl: Sora 2 unterstützt 1 Referenzbild, Veo 3.1 unterstützt 2 Anfangs- und Endframes

- Unterschiedliche Bildfunktion: Das Referenzbild von Sora 2 wird in den Videostil integriert, die Anfangs- und Endframes von Veo 3.1 steuern Start und Ende präzise

- Unterschiedliche Anwendungsszenarien: Sora 2 eignet sich für offene kreative Projekte, Veo 3.1 für zielgerichtete Übergangseffekte

Wenn Sie die grundlegenden Unterschiede zwischen diesen beiden Mechanismen verstehen, können Sie je nach konkretem Bedarf die passende API auswählen und bessere kreative Ergebnisse erzielen.

Wir empfehlen, sowohl die Sora 2 als auch die Veo 3 API über APIYI apiyi.com zu nutzen. Die Plattform bietet eine einheitliche Schnittstelle und kostenloses Testguthaben – ideal zum Vergleichstest und flexiblen Wechsel zwischen den Modellen.

📚 Referenzmaterialien

⚠️ Hinweis zum Linkformat: Alle externen Links verwenden das Format

Ressourcenname: domain.com, um einfaches Kopieren zu ermöglichen, ohne dass direkt geklickt werden kann. Dies vermeidet SEO-Gewichtsverluste.

-

OpenAI Sora API Offizielle Dokumentation: Vollständiger Leitfaden zur Sora-Videogenerierung

- Link:

platform.openai.com/docs/guides/video-generation - Beschreibung: Erfahren Sie mehr über die offiziellen Parameter und Verwendung von Sora 2 für Bild-zu-Video

- Link:

-

Google Veo 3.1 First-Last-Frame-Dokumentation: Vertex AI Videogenerierungs-Leitfaden

- Link:

docs.cloud.google.com/vertex-ai/generative-ai/docs/video/generate-videos-from-first-and-last-frames - Beschreibung: Lernen Sie die detaillierte Verwendung der First-Last-Frame-Funktion von Veo 3.1 kennen

- Link:

-

Sora 2 Prompting Guide: OpenAI offizieller Prompt-Leitfaden

- Link:

cookbook.openai.com/examples/sora/sora2_prompting_guide - Beschreibung: Lernen Sie, wie man hochwertige Video-Prompts für Sora 2 schreibt

- Link:

-

Google Veo 3.1 Funktionsübersicht: Detaillierte Erklärung der First-Last-Frame- und Referenzbild-Funktionen

- Link:

getimg.ai/blog/google-veo-3-1-review - Beschreibung: Vertiefen Sie Ihr Verständnis der neuen Funktionen und Anwendungstipps von Veo 3.1

- Link:

Autor: Technisches Team

Technischer Austausch: Diskutieren Sie gerne in den Kommentaren. Weitere Ressourcen finden Sie in der APIYI apiyi.com Tech-Community