Nota del autor: Kimi K2.5 ya es totalmente de código abierto. Este artículo detalla la licencia de código abierto, la descarga del modelo, los métodos de acceso a la API y proporciona un ejemplo de código completo para llamar rápidamente a Kimi K2.5 a través de APIYI.

¿Es Kimi K2.5 de código abierto? Esta es la pregunta que más preocupa a muchos desarrolladores últimamente. La buena noticia es que Moonshot AI lanzó oficialmente y liberó completamente el código de Kimi K2.5 el 26 de enero de 2026, incluyendo el código y los pesos del modelo bajo la licencia Modified MIT License.

Valor principal: Al leer este artículo, conocerás los detalles del código abierto de Kimi K2.5 y dominarás tres formas de acceso: autodespliegue, API oficial y plataformas de terceros (como APIYI apiyi.com), para usar rápidamente este Modelo de Lenguaje Grande multimodal tipo Agent de un billón de parámetros en tus proyectos.

Puntos clave del código abierto de Kimi K2.5

| Punto clave | Descripción | Beneficio para el desarrollador |

|---|---|---|

| Totalmente abierto | Código + pesos abiertos, Modified MIT License | Uso comercial, despliegue local, fine-tuning |

| MoE de un billón | 1T parámetros totales, 32B activados | Rendimiento de modelo cerrado a menor costo |

| Multimodal nativo | Soporta imágenes, video y documentos | Un solo modelo para diversos tipos de entrada |

| Agent Swarm | Hasta 100 sub-agentes en paralelo | Eficiencia en tareas complejas 4.5 veces mayor |

| Compatible OpenAI | Formato de API idéntico a OpenAI | Migración de código existente casi sin costo |

Detalles de la licencia de código abierto de Kimi K2.5

Kimi K2.5 utiliza la licencia Modified MIT License, lo que significa:

- Uso comercial: Se permite su uso en productos comerciales sin pagar tarifas de licencia.

- Modificación y distribución: Puedes modificar el modelo y volver a distribuirlo.

- Despliegue local: Soporta totalmente el despliegue privado, manteniendo los datos localmente.

- Entrenamiento y ajuste fino: Puedes realizar ajustes finos (fine-tuning) específicos de dominio basados en los pesos abiertos.

A diferencia de las licencias restrictivas de la serie LLaMA, el acuerdo de código abierto de Kimi K2.5 es mucho más amigable para los desarrolladores, siendo ideal para escenarios de aplicaciones empresariales.

Obtención de recursos de código abierto de Kimi K2.5

Los pesos y el código del modelo se pueden obtener a través de los siguientes canales:

| Recurso | Dirección | Descripción |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

Pesos oficiales, compatible con transformers 4.57.1+ |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

Imagen de despliegue optimizada |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

Espejo en China para descargas más rápidas |

| Ollama | ollama.com/library/kimi-k2.5 |

Ejecución local con un solo clic |

Guía rápida de acceso a Kimi K2.5

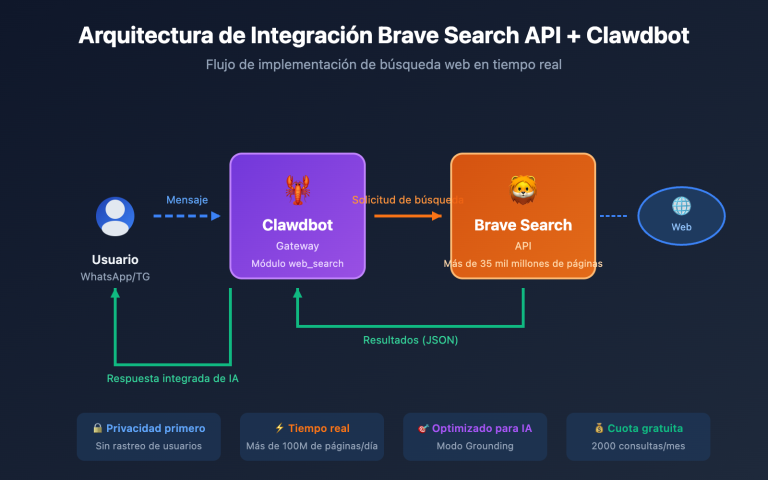

Existen principalmente tres formas de acceder a Kimi K2.5: auto-despliegue, API oficial y plataformas de terceros. Para la mayoría de los desarrolladores, recomendamos el acceso vía API, ya que permite validar los resultados rápidamente sin necesidad de recursos de GPU.

Ejemplo minimalista

A continuación se muestra el código más sencillo para llamar a Kimi K2.5 a través de la plataforma APIYI; puede ejecutarse en solo 10 líneas:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # En apiyi.com 获取

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "解释量子计算的基本原理"}]

)

print(response.choices[0].message.content)

Ver el código completo del modo Thinking de Kimi K2.5

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

调用 Kimi K2.5 API

Args:

prompt: 用户输入

thinking_mode: 是否启用思维模式(深度推理)

system_prompt: 系统提示词

max_tokens: 最大输出 token 数

Returns:

包含推理过程和最终答案的字典

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# 配置推理模式

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# 使用示例 - Thinking 模式

result = call_kimi_k25(

prompt="9.11 和 9.9 哪个更大?请仔细思考",

thinking_mode=True

)

print(f"推理过程: {result['reasoning']}")

print(f"最终答案: {result['content']}")

Sugerencia: Obtén una cuota de prueba gratuita en APIYI (apiyi.com) para verificar rápidamente la capacidad de razonamiento de Kimi K2.5. La plataforma ya tiene disponible Kimi K2.5, con soporte para los modos Thinking e Instant.

Comparativa de soluciones de acceso a Kimi K2.5

| Solución | Características principales | Casos de uso | Consideraciones de coste |

|---|---|---|---|

| Auto-despliegue | Datos localizados, control total | Empresas con datos sensibles | Requiere 48GB+ de VRAM (INT4) |

| API Oficial | Rendimiento estable, funciones completas | Desarrollo y pruebas estándar | $0.60/M entrada, $3/M salida |

| APIYI | Interfaz unificada, cambio de modelos | Validación rápida, sensibilidad al coste | Pago por uso, crédito gratis inicial |

Detalle de las tres formas de acceso a Kimi K2.5

Opción 1: Auto-despliegue local

Ideal para empresas que cuentan con recursos de GPU y tienen requisitos estrictos de privacidad de datos. Se recomienda utilizar vLLM o SGLang para el despliegue:

# 使用 Ollama 一键部署 (需 48GB+ 显存)

ollama run kimi-k2.5

Opción 2: API Oficial

Acceso a través de la plataforma oficial de Moonshot para obtener el soporte de las funciones más recientes:

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

Opción 3: Acceso mediante la plataforma APIYI (Recomendado)

Kimi K2.5 ya está disponible en APIYI (apiyi.com), ofreciendo las siguientes ventajas:

- Interfaz unificada en formato OpenAI, sin curva de aprendizaje.

- Soporte para cambiar y comparar rápidamente con modelos como GPT-4o o Claude.

- Crédito de prueba gratuito para nuevos usuarios.

- Acceso estable y directo, sin necesidad de proxys.

Recomendación de acceso: Se sugiere realizar primero la validación de funciones y la evaluación de resultados a través de APIYI (apiyi.com). Una vez confirmada la idoneidad para el escenario de negocio, se puede considerar la opción de auto-despliegue.

Comparativa de costos de API: Kimi K2.5 vs. Competencia

| Modelo | Precio de entrada | Precio de salida | Costo por solicitud (5K salida) | Comparativa |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | Referencia |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | 38% más caro |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | 444% más caro |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | 81% más caro |

Kimi K2.5 ofrece un rendimiento cercano o incluso superior al de algunos modelos de código cerrado, mientras que su costo es solo aproximadamente 1/5 del de Claude Opus 4.5. Esto lo convierte en uno de los modelos de billones de parámetros con mejor relación calidad-precio en la actualidad.

Preguntas frecuentes

Q1: ¿Es Kimi K2.5 de código abierto? ¿Se puede usar para fines comerciales?

Sí, Kimi K2.5 pasó a ser completamente de código abierto el 26 de enero de 2026, bajo la licencia Modified MIT License. Tanto el código como los pesos del modelo están disponibles de forma gratuita, y se permite su uso comercial, modificación y distribución.

Q2: ¿Cuál es la diferencia entre el modo Thinking y el modo Instant de Kimi K2.5?

El modo Thinking devuelve un proceso de razonamiento detallado (reasoning_content), lo que lo hace ideal para problemas complejos. Por otro lado, el modo Instant ofrece respuestas directas y tiene un tiempo de respuesta más rápido. Se recomienda usar el modo Thinking para problemas matemáticos o de lógica, y el modo Instant para conversaciones cotidianas.

Q3: ¿Cómo puedo probar rápidamente la integración de Kimi K2.5?

Te recomendamos utilizar una plataforma de agregación de API que admita múltiples modelos para realizar tus pruebas:

- Visita APIYI (apiyi.com) y regístrate para obtener una cuenta.

- Consigue tu API Key y aprovecha la cuota gratuita.

- Utiliza los ejemplos de código de este artículo, configurando el

base_urlcomohttps://vip.apiyi.com/v1. - Simplemente introduce

kimi-k2.5como nombre del modelo para realizar la llamada.

Resumen

Puntos clave del acceso de código abierto a Kimi K2.5:

- Totalmente de código abierto: Kimi K2.5 utiliza la Licencia MIT modificada; tanto el código como los pesos son aptos para uso comercial.

- Múltiples formas de acceso: Soporta autodespliegue, API oficial y plataformas de terceros; elige la opción que mejor se adapte a tus necesidades.

- Relación calidad-precio excepcional: Un Modelo de Lenguaje Grande de un billón de parámetros con un coste que es solo 1/5 del de Claude Opus 4.5.

Kimi K2.5 ya está disponible en APIYI (apiyi.com). Los nuevos usuarios pueden obtener créditos gratuitos; se recomienda usar la plataforma para validar rápidamente el rendimiento del modelo y evaluar si se adapta a tu escenario de negocio.

Referencias

⚠️ Nota sobre el formato de los enlaces: Todos los enlaces externos utilizan el formato

Nombre del recurso: domain.com, para facilitar la copia sin permitir el clic directo, evitando así la pérdida de autoridad SEO.

-

Tarjeta de modelo de Kimi K2.5 en HuggingFace: Pesos oficiales del modelo y documentación técnica.

- Enlace:

huggingface.co/moonshotai/Kimi-K2.5 - Descripción: Obtén los pesos del modelo, guías de despliegue y ejemplos de uso de la API.

- Enlace:

-

Informe técnico de Kimi K2.5: Arquitectura detallada del modelo y métodos de entrenamiento.

- Enlace:

kimi.com/blog/kimi-k2-5.html - Descripción: Conoce detalles técnicos fundamentales como Agent Swarm, la arquitectura MoE (Mezcla de Expertos), entre otros.

- Enlace:

-

Plataforma abierta de Moonshot: Documentación oficial de la API y SDK.

- Enlace:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - Descripción: Guía oficial de acceso que incluye información sobre precios y límites de velocidad.

- Enlace:

-

Ollama Kimi K2.5: Solución de despliegue local en un solo clic.

- Enlace:

ollama.com/library/kimi-k2.5 - Descripción: Ideal para pruebas locales y escenarios de despliegue a pequeña escala.

- Enlace:

Autor: Equipo Técnico

Intercambio técnico: Te invitamos a comentar tu experiencia de uso con Kimi K2.5 en la sección de comentarios. Para más comparativas de modelos y tutoriales, visita la comunidad técnica de APIYI (apiyi.com).