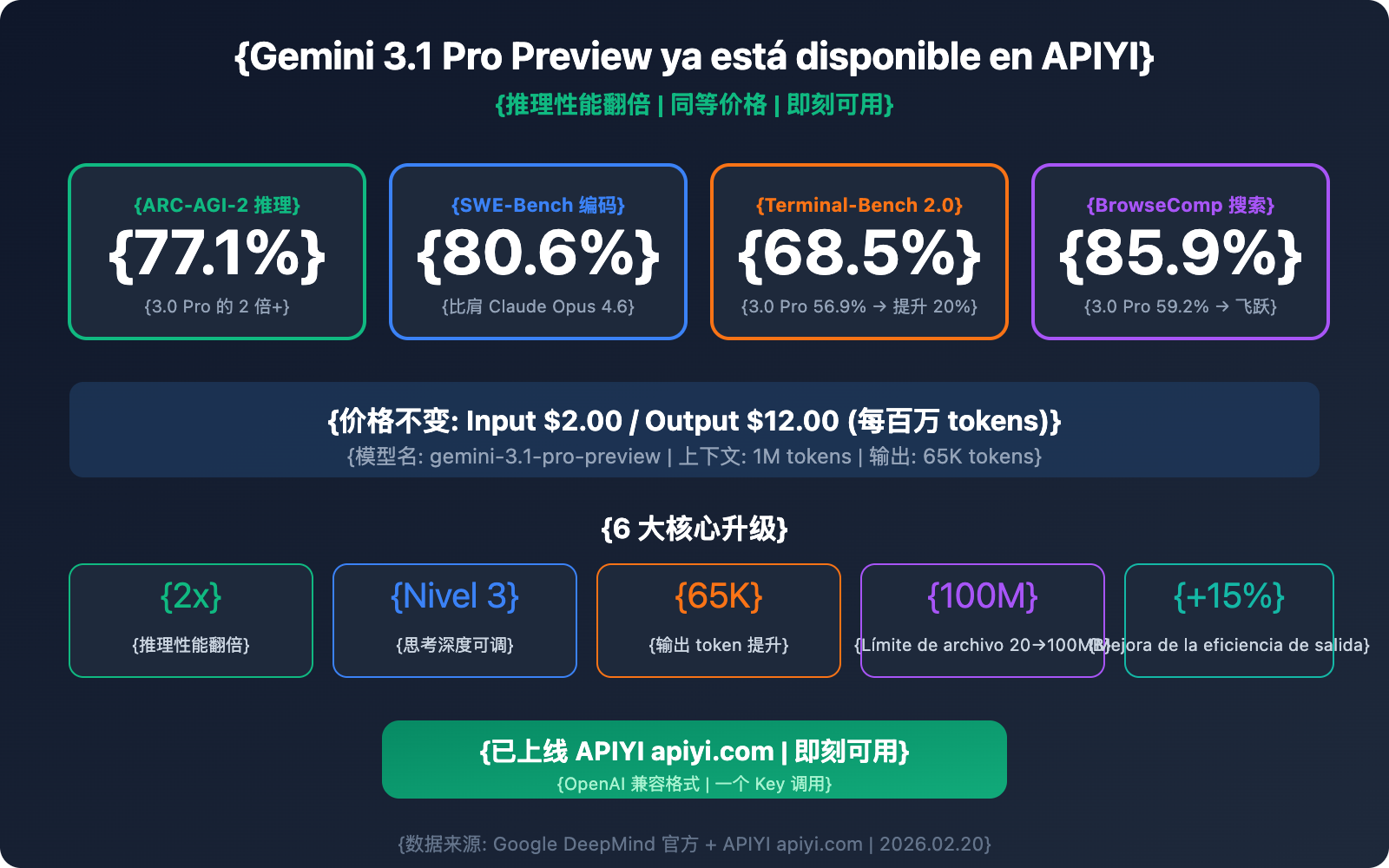

Buenas noticias: Gemini 3.1 Pro Preview ya está disponible en APIYI y ya puedes llamarlo a través de la API. El nombre del modelo es gemini-3.1-pro-preview, con un precio de indicación de $2.00/1M de tokens y un precio de completado de $12.00/1M de tokens, exactamente el mismo precio que Gemini 3.0 Pro Preview.

Sin embargo, sus capacidades están en un nivel completamente distinto: Gemini 3.1 Pro alcanza un 77.1% en la referencia de razonamiento ARC-AGI-2, más del doble que el 3.0 Pro; su puntuación de codificación en SWE-Bench Verified es del 80.6%, superando por primera vez el 80.9% de Claude Opus 4.6 para competir de tú a tú; y la eficiencia de salida ha mejorado en un 15%, obteniendo resultados más fiables con menos tokens.

Valor principal: Este artículo detallará las 6 actualizaciones principales de Gemini 3.1 Pro Preview, los métodos de llamada a la API, una comparativa detallada con sus competidores y las mejores prácticas para diferentes escenarios.

Resumen de parámetros clave de Gemini 3.1 Pro Preview

| Parámetro | Detalle |

|---|---|

| Nombre del modelo | gemini-3.1-pro-preview |

| Fecha de lanzamiento | 19 de febrero de 2026 |

| Precio de indicación (≤200K tokens) | $2.00 / millón de tokens |

| Precio de completado (≤200K tokens) | $12.00 / millón de tokens |

| Precio de indicación (>200K tokens) | $4.00 / millón de tokens |

| Precio de completado (>200K tokens) | $18.00 / millón de tokens |

| Ventana de contexto | 1,000,000 tokens (1M) |

| Salida máxima | 65,000 tokens (65K) |

| Límite de subida de archivos | 100MB (antes 20MB) |

| Fecha de corte de conocimiento | Enero de 2025 |

| Estado de disponibilidad en APIYI | ✅ Ya disponible |

🚀 Pruébalo ahora: Gemini 3.1 Pro Preview ya está disponible en APIYI (apiyi.com). Puedes llamarlo a través del formato compatible con OpenAI, sin necesidad de registrar una cuenta de Google, y completar la integración en solo 5 minutos.

Las 6 mejoras principales de Gemini 3.1 Pro Preview

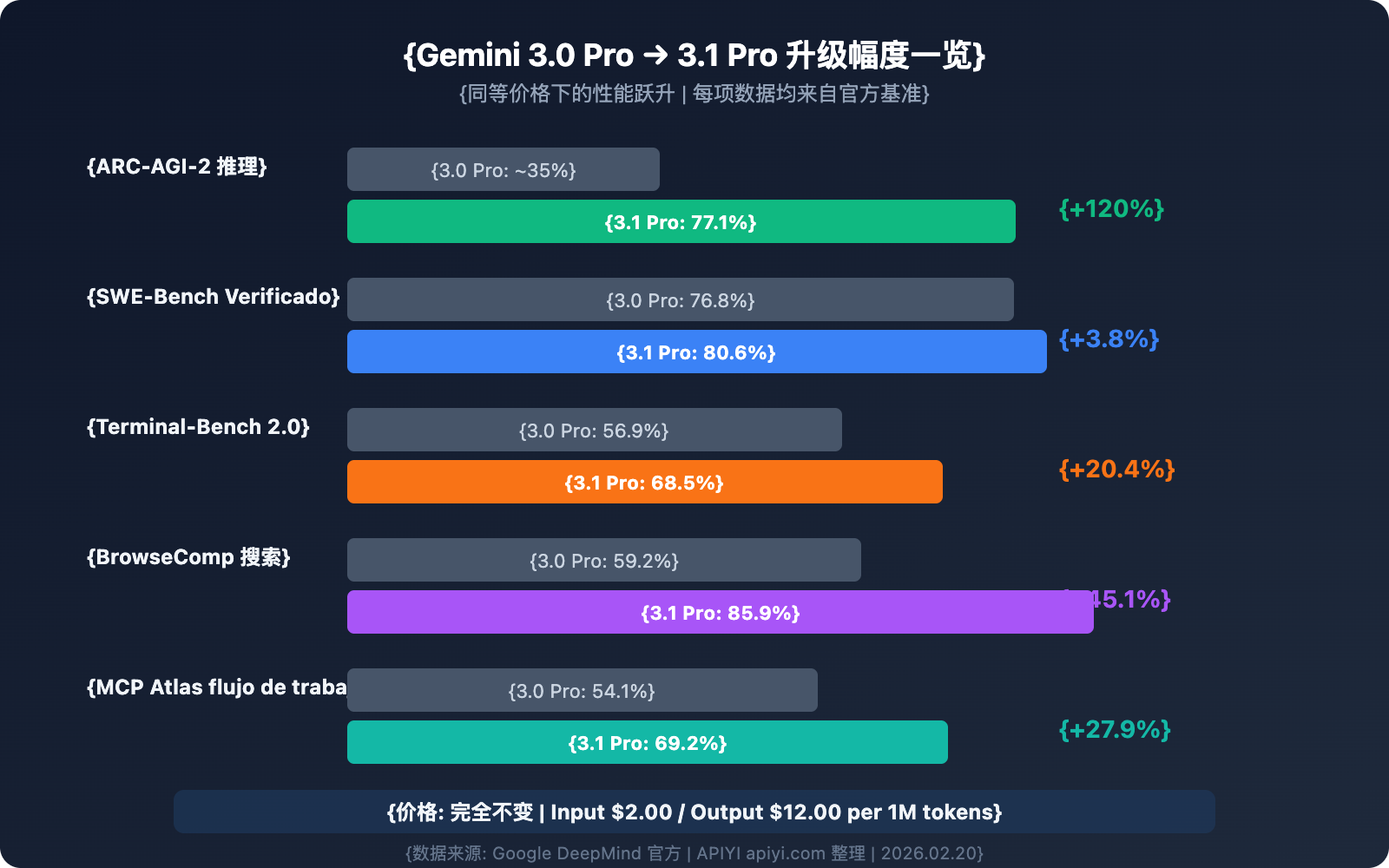

Mejora 1: Rendimiento de razonamiento duplicado — ARC-AGI-2 alcanza el 77.1%

Esta es la actualización más impresionante. En el benchmark ARC-AGI-2 (que evalúa la capacidad del modelo para resolver patrones lógicos completamente nuevos), Gemini 3.1 Pro alcanzó un 77.1%, lo que representa más del doble que Gemini 3.0 Pro.

Al mismo tiempo, en el benchmark MCP Atlas (que mide la capacidad de flujos de trabajo de varios pasos utilizando el Model Context Protocol), el 3.1 Pro alcanzó un 69.2%, un aumento de 15 puntos porcentuales frente al 54.1% del 3.0 Pro.

Esto significa que en escenarios de razonamiento complejo, cadenas lógicas de múltiples pasos y flujos de trabajo de Agentes, Gemini 3.1 Pro ha dado un salto cualitativo.

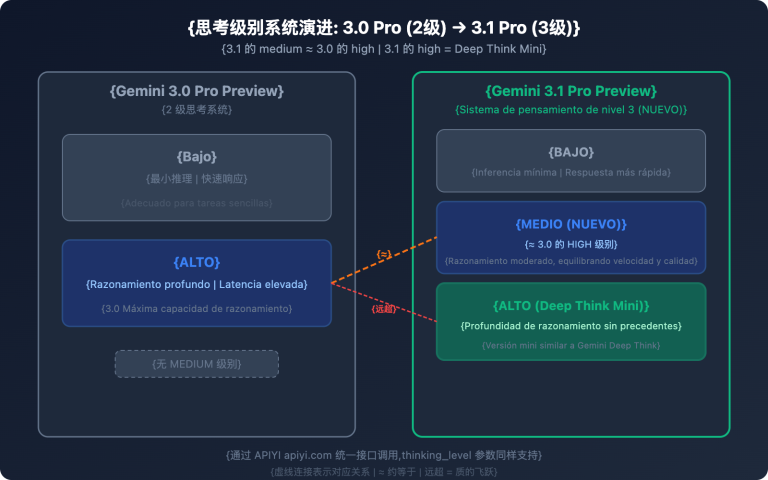

Mejora 2: Sistema de profundidad de pensamiento de tres niveles — Deep Think Mini

Gemini 3.1 Pro introduce un nuevo sistema de profundidad de pensamiento de tres niveles, permitiendo a los desarrolladores ajustar de manera flexible el "presupuesto de razonamiento" según la complejidad de la tarea:

| Nivel de pensamiento | Características de comportamiento | Escenarios de uso | Impacto en la latencia |

|---|---|---|---|

| high | Versión mini similar a Gemini Deep Think, razonamiento profundo | Demostraciones matemáticas, depuración compleja, planificación estratégica | Alta |

| medium | Equivalente al nivel "high" de 3.0 Pro | Revisión de código, análisis técnico, diseño de arquitectura | Moderada |

| low | Respuesta rápida, gasto mínimo de razonamiento | Extracción de datos, conversión de formatos, preguntas y respuestas simples | Mínima |

Punto clave: El nivel high de 3.1 Pro redefine su significado; ahora es una versión "mini" de Gemini Deep Think, con una profundidad de razonamiento que supera con creces al nivel high de 3.0 Pro. Por otro lado, el medium de 3.1 es aproximadamente igual al high de 3.0, lo que significa que incluso con el nivel medium se obtiene la calidad de razonamiento que antes era el máximo nivel.

Mejora 3: Capacidad de programación entre las mejores — SWE-Bench 80.6%

El desempeño de Gemini 3.1 Pro en el ámbito de la programación es un verdadero salto adelante:

| Benchmark de programación | Gemini 3.0 Pro | Gemini 3.1 Pro | Incremento |

|---|---|---|---|

| SWE-Bench Verified | 76.8% | 80.6% | +3.8% |

| Terminal-Bench 2.0 | 56.9% | 68.5% | +11.6% |

| LiveCodeBench Pro | — | Elo 2887 | Nuevo benchmark |

El resultado de 80.6% en SWE-Bench Verified significa que Gemini 3.1 Pro ya está prácticamente a la par de Claude Opus 4.6 (80.9%) en tareas de ingeniería de software, con una diferencia de apenas 0.3 puntos porcentuales.

Terminal-Bench 2.0 evalúa la capacidad de programación en terminal de los Agentes; el incremento del 56.9% al 68.5% demuestra que la fiabilidad de 3.1 Pro en escenarios "agentic" se ha fortalecido considerablemente.

Mejora 4: Mejora integral en la capacidad de salida y eficiencia

| Ítem de capacidad | Gemini 3.0 Pro | Gemini 3.1 Pro | Mejora |

|---|---|---|---|

| Máximo de tokens de salida | Desconocido | 65,000 (65K) | Gran aumento |

| Límite de subida de archivos | 20MB | 100MB | 5 veces más |

| Soporte para URL de YouTube | ❌ | ✅ | Novedad |

| Eficiencia de salida | Base | +15% | Menos tokens, resultados más fiables |

El límite de salida de 65K significa que el modelo puede generar documentos largos completos, grandes bloques de código o informes de análisis detallados de una sola vez, sin necesidad de concatenar múltiples solicitudes.

La expansión de la subida de archivos de 20MB a 100MB, combinada con el contexto de 1M de tokens, permite analizar directamente repositorios de código grandes, videos largos o grandes volúmenes de documentos.

La entrada directa de URL de YouTube es una nueva funcionalidad muy práctica: los desarrolladores pueden pasar un enlace de YouTube directamente en la indicación y el modelo analizará automáticamente el contenido del video, sin necesidad de descargarlo y subirlo manualmente.

Mejora 5: Endpoint dedicado customtools — Herramienta clave para el desarrollo de Agentes

Google también ha lanzado simultáneamente el endpoint dedicado gemini-3.1-pro-preview-customtools, una versión optimizada específicamente para escenarios de desarrollo de Agentes:

- Optimización de la prioridad en la llamada a herramientas: Se ha ajustado específicamente la prioridad de llamada para herramientas comunes de desarrolladores como

view_fileysearch_code. - Mezcla de Bash + funciones personalizadas: Ideal para flujos de trabajo de Agentes que necesitan alternar entre comandos de bash y funciones personalizadas.

- Estabilidad en escenarios Agentic: Mayor fiabilidad en tareas de Agentes de múltiples pasos en comparación con la versión general.

Esto significa que si estás construyendo asistentes de programación con IA, bots de revisión de código o agentes de operaciones automatizadas (AIOps), el endpoint customtools es la mejor opción.

Mejora 6: Salto cualitativo en la capacidad de búsqueda web — BrowseComp 85.9%

El benchmark BrowseComp evalúa la capacidad de búsqueda web de los Agentes del modelo. Gemini 3.1 Pro alcanzó un 85.9%, mientras que el 3.0 Pro solo llegaba al 59.2%, un incremento de 26.7 puntos porcentuales.

Esta capacidad es de gran importancia para aplicaciones que requieren recuperación de información en tiempo real, como asistentes de investigación, análisis de la competencia o resúmenes de noticias.

💡 Perspectiva técnica: Gemini 3.1 Pro también ha lanzado el endpoint específico

gemini-3.1-pro-preview-customtools, optimizado para desarrolladores que mezclan comandos bash y funciones personalizadas, ajustando especialmente la prioridad de herramientas comoview_fileysearch_code. Puedes llamar directamente a este endpoint dedicado a través de APIYI (apiyi.com).

Guía práctica de llamadas a la API de Gemini 3.1 Pro Preview

Ejemplo de llamada minimalista (Python)

import openai

client = openai.OpenAI(

api_key="TU_API_KEY",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "user", "content": "Analiza la complejidad temporal de este código y ofrece sugerencias de optimización:\n\ndef two_sum(nums, target):\n for i in range(len(nums)):\n for j in range(i+1, len(nums)):\n if nums[i] + nums[j] == target:\n return [i, j]"}

]

)

print(response.choices[0].message.content)

Ver ejemplo de llamada completo (incluye control de profundidad de pensamiento y multimodalidad)

import openai

import base64

client = openai.OpenAI(

api_key="TU_API_KEY",

base_url="https://api.apiyi.com/v1" # Interfaz unificada de APIYI

)

# Ejemplo 1: Alta profundidad de razonamiento - Razonamiento matemático complejo

response_math = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": "Demuestra: Para todo número entero positivo n, n^3 - n es necesariamente divisible por 6. Por favor, proporciona una demostración matemática rigurosa."

}],

temperature=0.2,

max_tokens=4096

)

# Ejemplo 2: Análisis multimodal - Comprensión de imágenes

with open("architecture.png", "rb") as f:

img_data = base64.b64encode(f.read()).decode()

response_vision = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "Analiza detalladamente este diagrama de arquitectura de sistema, señala posibles cuellos de botella de rendimiento y sugerencias de mejora"},

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{img_data}"}}

]

}],

max_tokens=8192

)

# Ejemplo 3: Análisis de código de contexto largo

with open("large_codebase.txt", "r") as f:

code_content = f.read() # Puede ser de cientos de miles de tokens

response_code = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "system", "content": "Eres un arquitecto de software senior, por favor analiza cuidadosamente todo el repositorio de código."},

{"role": "user", "content": f"Aquí está el repositorio de código completo:\n\n{code_content}\n\nPor favor analiza:\n1. Diseño de la arquitectura general\n2. Bugs potenciales\n3. Sugerencias de optimización de rendimiento\n4. Plan de refactorización de código"}

],

max_tokens=16384 # Aprovechando la capacidad de salida de 65K

)

print(f"Razonamiento matemático: {response_math.choices[0].message.content[:200]}...")

print(f"Análisis visual: {response_vision.choices[0].message.content[:200]}...")

print(f"Análisis de código: {response_code.choices[0].message.content[:200]}...")

🎯 Consejo de integración: Al llamar a Gemini 3.1 Pro Preview a través de APIYI (apiyi.com), puedes usar el SDK estándar de OpenAI sin necesidad de instalar dependencias adicionales. Los proyectos que ya usan el formato de OpenAI solo necesitan modificar los parámetros

base_urlymodelpara cambiar de modelo.

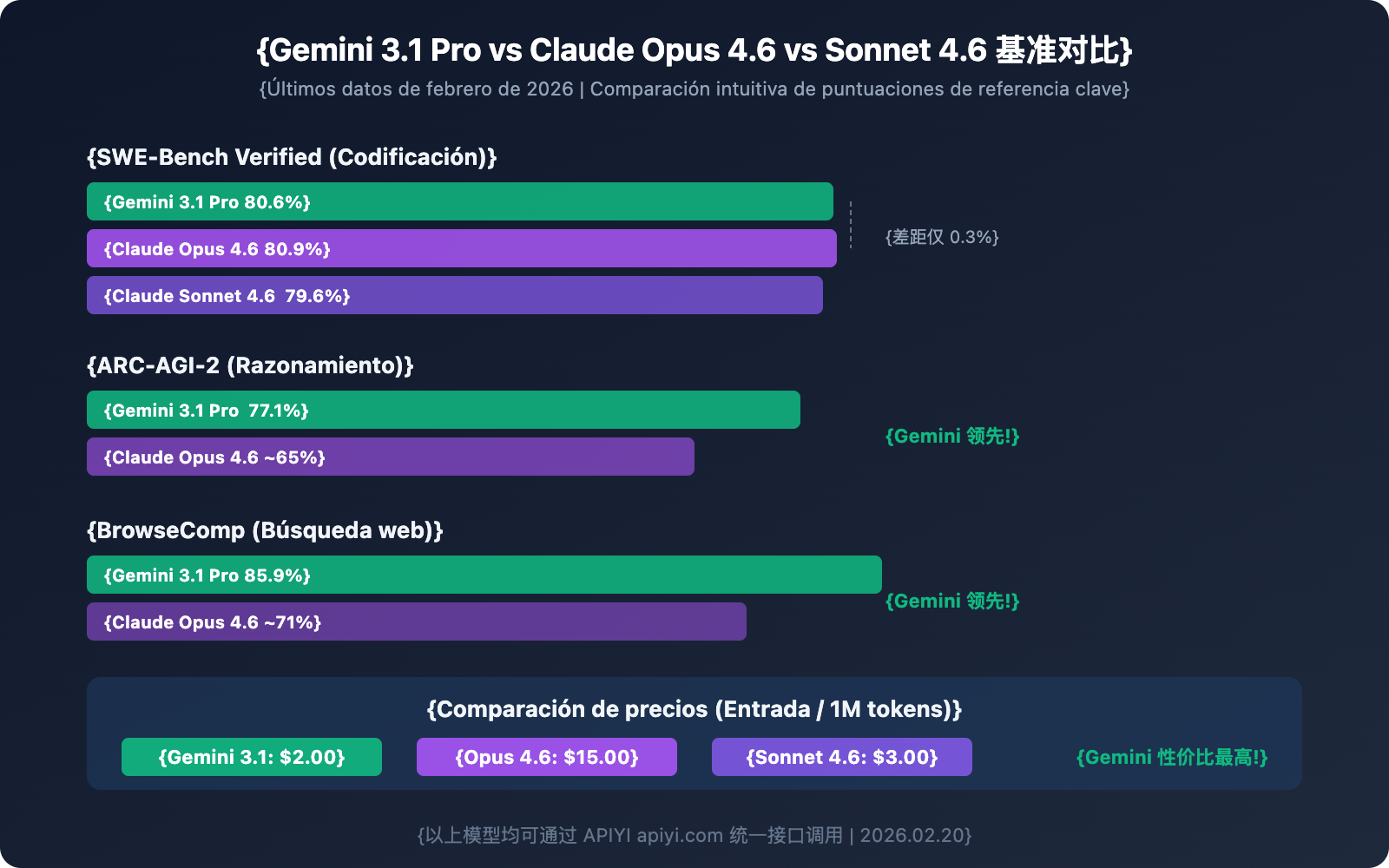

Gemini 3.1 Pro Preview frente a la competencia: Comparativa detallada

Tabla comparativa de benchmarks clave

| Benchmark | Gemini 3.1 Pro | Claude Opus 4.6 | Claude Sonnet 4.6 | Ganador |

|---|---|---|---|---|

| SWE-Bench Verified | 80.6% | 80.9% | 79.6% | Claude Opus (por poco) |

| ARC-AGI-2 | 77.1% | ~65% | — | Gemini 3.1 Pro |

| Terminal-Bench 2.0 | 68.5% | — | — | Gemini 3.1 Pro |

| BrowseComp | 85.9% | ~71% | — | Gemini 3.1 Pro |

| MCP Atlas | 69.2% | — | — | Gemini 3.1 Pro |

| Ventana de contexto | 1M tokens | 200K | 200K | Gemini 3.1 Pro |

| Salida máxima | 65K | — | — | Gemini 3.1 Pro |

| Precio de entrada (Input) | $2.00 | $15.00 | $3.00 | Gemini 3.1 Pro |

| Plataformas disponibles | APIYI apiyi.com, etc. | APIYI apiyi.com, etc. | APIYI apiyi.com, etc. | — |

Sugerencias de uso para cada modelo

| Escenario de uso | Modelo recomendado | Razón principal |

|---|---|---|

| Razonamiento complejo y matemáticas | Gemini 3.1 Pro Preview | ARC-AGI-2 77.1%, razonamiento duplicado |

| Análisis de documentos extensos/repositorios de código | Gemini 3.1 Pro Preview | Ventana de 1M de tokens, único en su clase |

| Programación agéntica | Claude Opus 4.6 / Gemini 3.1 Pro | SWE-Bench prácticamente igualado |

| Flujos de búsqueda de agentes | Gemini 3.1 Pro Preview | BrowseComp 85.9%, liderazgo sustancial |

| Programación diaria de complejidad media | Claude Sonnet 4.6 | Alta relación calidad-precio, 79.6% en codificación |

| Necesidades de gama alta con presupuesto ajustado | Gemini 3.1 Pro Preview | $2/$12, el precio más bajo para un modelo insignia |

| Análisis multimodal de video/audio | Gemini 3.1 Pro Preview | Multimodal nativo, soporte para URLs de YouTube |

💰 Comparativa de costos: Con capacidades de nivel insignia similares, el precio de entrada (Input) de Gemini 3.1 Pro ($2.00) es solo el 13% del de Claude Opus 4.6 ($15.00). Para escenarios de razonamiento y multimodales, la ventaja en relación calidad-precio es extremadamente evidente. A través de la plataforma APIYI apiyi.com, puedes alternar rápidamente entre ellos usando la misma interfaz.

Mejores prácticas para Gemini 3.1 Pro Preview

Aprovecha los tres niveles de profundidad de pensamiento

# Usa 'high' para razonamiento complejo (modo Deep Think Mini)

# Usa 'medium' para tareas cotidianas (equivalente al 'high' de la versión anterior)

# Usa 'low' para tareas sencillas (respuesta más rápida)

# Al llamar a través de APIYI, pasa el nivel de pensamiento mediante extra_body

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{"role": "user", "content": "Tu pregunta aquí"}],

extra_body={"thinking_level": "high"} # high/medium/low

)

Saca el máximo partido a la ventana de contexto de 1M de tokens

La ventana de contexto de 1M de tokens de Gemini 3.1 Pro Preview es la más grande entre todos los modelos insignia actuales. Aquí tienes algunos escenarios de alto valor:

Análisis global de repositorios de código: Envía decenas de archivos a la vez para que el modelo comprenda la arquitectura completa antes de dar sugerencias de refactorización. Esto permite detectar problemas de acoplamiento entre módulos y oportunidades de optimización global mejor que el análisis archivo por archivo.

Comprensión profunda de documentos extensos: Contratos legales, especificaciones técnicas, colecciones de artículos académicos… 1M de tokens puede albergar un libro entero. Combinado con la profundidad de razonamiento mejorada de la versión 3.1 Pro, se pueden identificar relaciones implícitas incluso en documentos larguísimos.

Análisis de videos de YouTube (Nueva función): Envía directamente la URL de YouTube en la indicación, sin necesidad de descargar ni subir el archivo de video. El modelo analizará automáticamente el contenido, ideal para auditoría de contenidos, análisis de la competencia o resúmenes de tutoriales.

Memoria a largo plazo en diálogos extensos: Una ventana de 1M de tokens significa que el modelo puede "recordar" historiales de conversación larguísimos, lo que supone una ventaja clara en escenarios de atención al cliente, consultoría o enseñanza que requieren mucho contexto.

Atención al umbral de precio de 200K: Cuando la entrada supera los 200K tokens, el precio se duplica de $2/$12 a $4/$18. Se recomienda evaluar el número real de tokens al usar contextos largos; para escenarios entre 200K y 300K, considera simplificar la entrada para mantenerla por debajo de 200K y ahorrar la mitad del costo.

Cómo usar el endpoint customtools

Si estás construyendo aplicaciones de agentes, vale la pena priorizar el endpoint gemini-3.1-pro-preview-customtools:

# Endpoint especializado para desarrollo de agentes

response = client.chat.completions.create(

model="gemini-3.1-pro-preview-customtools", # Versión optimizada para agentes

messages=[{"role": "user", "content": "Busca todas las excepciones no controladas en el proyecto y sugiere reparaciones"}],

tools=[

{"type": "function", "function": {"name": "search_code", "description": "Buscar código"}},

{"type": "function", "function": {"name": "view_file", "description": "Ver archivo"}},

]

)

Este endpoint supera a la versión genérica en precisión y fiabilidad de las llamadas a herramientas, siendo especialmente adecuado para escenarios que mezclan comandos bash con funciones personalizadas.

Estrategias de optimización de costos

| Estrategia | Método | Ahorro esperado |

|---|---|---|

| Cambio de nivel de pensamiento según necesidad | Usa 'low' para tareas simples y 'high' solo para las complejas | 30-50% |

| Uso de contexto largo para reducir peticiones | Agrupa varias preguntas relacionadas en una sola petición | 20-40% |

| Atención a escenarios de >200K tokens | El precio se duplica al superar los 200K; controla la longitud de entrada | Evita el recargo del 2x |

| Control de tokens de salida | Configura un max_tokens razonable para evitar salidas redundantes | 10-20% |

| Elección del modelo Gemini adecuado | Usa Flash para tareas simples y 3.1 Pro solo para las complejas | 60-80% |

Pasos para migrar de Gemini 3.0 Pro a 3.1 Pro

El proceso de migración es sumamente sencillo:

Paso 1: Modifica el parámetro model

# Versión antigua

model="gemini-3-pro-preview"

# Versión nueva

model="gemini-3.1-pro-preview"

Paso 2: Prueba las funciones principales: ejecuta algunos casos típicos de tus escenarios de uso habituales para confirmar que la calidad de salida cumple con las expectativas.

Paso 3: Explora las nuevas capacidades: prueba el razonamiento profundo con el nivel 'high', la subida de archivos de hasta 100MB, el análisis de URLs de YouTube y otras funciones nuevas de la 3.1.

Paso 4: Optimiza costos: configura el nivel de pensamiento adecuado para cada tarea. Usar 'medium' en lugar de 'high' para tareas diarias puede reducir la latencia y el consumo de tokens manteniendo la calidad.

🎯 Sugerencia de migración: En la plataforma APIYI apiyi.com, la migración solo requiere cambiar un parámetro. Se recomienda mantener la llamada al modelo antiguo como respaldo (fallback) y realizar el cambio total una vez confirmada la estabilidad de la 3.1.

Preguntas frecuentes

Q1: ¿Es la forma de llamar a Gemini 3.1 Pro Preview en APIYI igual que con los modelos Gemini anteriores?

Exactamente igual. En la plataforma APIYI (apiyi.com), Gemini 3.1 Pro Preview utiliza el formato estándar compatible con OpenAI; solo tienes que introducir gemini-3.1-pro-preview en el parámetro model. Si ya estás usando Gemini 3.0 Pro, solo necesitas cambiar el nombre del modelo, no hace falta modificar nada más en tu código.

Q2: 3.1 Pro y 3.0 Pro tienen el mismo precio, ¿realmente vale la pena cambiar?

Es muy recomendable hacer el cambio. El precio es idéntico ($2/$12), pero la capacidad de razonamiento se ha duplicado, la puntuación en programación ha subido del 76.8% al 80.6% y la eficiencia de salida ha mejorado un 15%. Es, básicamente, una actualización gratuita; no hay razón para no hacerlo. A través de APIYI (apiyi.com), el cambio se completa modificando un solo parámetro.

Q3: ¿Cómo elijo entre los tres niveles de profundidad de pensamiento? ¿Afecta al precio?

La profundidad de pensamiento afecta principalmente a la latencia y al consumo de tokens. El nivel high ofrece un razonamiento más profundo pero consume más tiempo y tokens de salida; el nivel low es el más rápido pero con un razonamiento más superficial. Se recomienda usar medium para el día a día (equivale a la calidad del antiguo nivel high) y reservar high solo para escenarios de razonamiento complejo. El precio se factura según el consumo real de tokens; el nivel de pensamiento en sí no tiene un coste adicional.

Q4: ¿Cuál debería elegir: Gemini 3.1 Pro Preview o Claude Opus 4.6?

Depende del escenario y del presupuesto: si necesitas un contexto ultra largo (1M vs 200K), análisis multimodal (vídeo/YouTube) o eres sensible al precio ($2 vs $15), elige Gemini 3.1 Pro. Si buscas la máxima precisión en programación (80.9% vs 80.6%) y un ecosistema de Agents más maduro, elige Claude Opus 4.6. Ambos están disponibles en APIYI (apiyi.com) bajo la misma interfaz, lo que facilita mucho las pruebas A/B.

Guía de selección del panorama de modelos Gemini serie 3

La serie Gemini 3 cuenta actualmente con varios modelos disponibles, y cada uno se adapta a diferentes necesidades:

| Modelo | Posicionamiento | Ventajas clave | Escenarios de uso | Precio en APIYI |

|---|---|---|---|---|

| gemini-3.1-pro-preview | Flagship de razonamiento (NUEVO) | Razonamiento duplicado, programación de élite | Razonamiento complejo, generación de código, Agents | $2/$12 |

| gemini-3-pro-preview | Flagship de propósito general | Programación agéntica, multimodal | Tareas generales (se recomienda subir a 3.1) | $2/$12 |

| gemini-3-flash-preview | Alta velocidad y ligero | Respuesta ultrarrápida, coste mínimo | Chat en tiempo real, procesamiento por lotes, llamadas frecuentes | Aún más bajo |

| gemini-3-pro-image-preview | Generación de imágenes | Texto a imagen con IA, edición de imágenes | Diseño creativo, creación de contenido | Por imagen |

Árbol de decisión:

- ¿Necesitas el razonamiento y la programación más potentes? →

gemini-3.1-pro-preview - ¿Necesitas la mayor velocidad y el menor coste? →

gemini-3-flash-preview - ¿Necesitas generar imágenes? →

gemini-3-pro-image-preview - ¿Ya usas 3.0 Pro? → Actualiza directamente a

gemini-3.1-pro-preview

En qué escenarios NO es recomendable usar Gemini 3.1 Pro Preview

Aunque el 3.1 Pro destaca en la mayoría de los casos, existen situaciones donde otras opciones podrían ser mejores:

- Necesidad de precisión extrema en código: El 80.9% de Claude Opus 4.6 en SWE-Bench sigue siendo ligeramente superior al 80.6% de 3.1 Pro. Aunque la diferencia es mínima, puede ser relevante en requisitos de precisión extrema.

- Aplicaciones en tiempo real con latencia ultra baja: El modo de pensamiento

highde 3.1 Pro tiene una latencia elevada. En estos casos, Gemini 3 Flash o Claude Sonnet 4.6 son mejores opciones. - Necesidad de garantías de SLA estables: Los modelos Preview no ofrecen compromisos formales de SLA. Para entornos de producción con requisitos de disponibilidad críticos, es necesario evaluar este riesgo.

- Uso excesivo en tareas simples: Si la complejidad de la tarea es baja, usar 3.1 Pro puede ser un desperdicio de presupuesto; la serie Flash es mucho más rentable.

Resumen de las ventajas competitivas de Gemini 3.1 Pro Preview

En el panorama de los Modelos de Lenguaje Grande de febrero de 2026, las ventajas competitivas de Gemini 3.1 Pro Preview se resumen en tres "máximos":

- Máximo contexto: 1M de tokens, que es 5 veces más que Claude Opus 4.6 (200K).

- Precio flagship más bajo: $2.00 por entrada, lo que representa solo el 13% del coste de Claude Opus 4.6 ($15.00).

- Mayor salto en razonamiento: Su puntuación en ARC-AGI-2 se duplicó hasta el 77.1%, liderando la dimensión de razonamiento frente a todos sus competidores.

Sus desventajas relativas se encuentran principalmente en escenarios de programación pura (80.6% en SWE-Bench vs 80.9% de Claude Opus, una brecha mínima) y en la madurez del ecosistema de Agents.

💡 Consejo general: Para la mayoría de los desarrolladores, la relación calidad-precio de Gemini 3.1 Pro Preview es la mejor entre los modelos insignia actuales. A través de APIYI (apiyi.com), puedes comparar y probar Gemini, Claude, GPT y otros modelos principales en una misma plataforma para encontrar la opción que mejor se adapte a tu caso de uso.

Resumen: El doble de potencia al mismo precio, vale la pena cambiarse ya a Gemini 3.1 Pro Preview

Gemini 3.1 Pro Preview representa una actualización de gran impacto: mismo precio, el doble de capacidad.

- Razonamiento duplicado: ARC-AGI-2 pasó de ~35% a 77.1%, lo que supone más del doble que la versión 3.0.

- Codificación al nivel de los mejores: SWE-Bench 80.6%, situándose a tan solo un 0.3% de Claude Opus 4.6.

- Salto cualitativo en capacidades de Agente: Terminal-Bench +20%, BrowseComp +45%, MCP Atlas +28%.

- Mejora integral de la eficiencia: Salida de 65K tokens, límite de archivos de 100MB y un 15% más de eficiencia.

- Sistema de pensamiento de tres niveles: El modo "high" equivale a Deep Think Mini, permitiendo ajustar el presupuesto de razonamiento según sea necesario.

Pruébalo ahora a través de APIYI (apiyi.com): interfaz unificada y disponibilidad inmediata. Solo tienes que cambiar el parámetro del modelo a gemini-3.1-pro-preview para completar la actualización.

Referencias

-

Blog oficial de Google: Anuncio del lanzamiento de Gemini 3.1 Pro

- Enlace:

blog.google/innovation-and-ai/models-and-research/gemini-models/gemini-3-1-pro - Descripción: Presentación oficial de funciones y resultados de benchmarks.

- Enlace:

-

Model Card de Google DeepMind: Detalles técnicos de Gemini 3.1 Pro

- Enlace:

deepmind.google/models/model-cards/gemini-3-1-pro - Descripción: Evaluaciones de seguridad y parámetros detallados.

- Enlace:

-

Documentación oficial de la API de Gemini: Lista de modelos y métodos de llamada

- Enlace:

ai.google.dev/gemini-api/docs/models/gemini-3.1-pro-preview - Descripción: Parámetros de la API, precios y guía de uso.

- Enlace:

-

Reportaje de VentureBeat: Primeras impresiones de Gemini 3.1 Pro

- Enlace:

venturebeat.com/technology/google-gemini-3-1-pro-first-impressions - Descripción: Características de Deep Think Mini y experiencia real de uso.

- Enlace:

-

Análisis de MarkTechPost: Interpretación técnica de Gemini 3.1 Pro

- Enlace:

marktechpost.com/2026/02/19/google-ai-releases-gemini-3-1-pro - Descripción: Datos de pruebas de rendimiento e impacto en la industria.

- Enlace:

📝 Autor: Equipo de APIYI | Para consultas técnicas, visita APIYI (apiyi.com)

📅 Fecha de actualización: 20 de febrero de 2026

🏷️ Palabras clave: Gemini 3.1 Pro Preview API, Lanzamiento en APIYI, Razonamiento duplicado, SWE-Bench 80.6%, ARC-AGI-2 77.1%