Anmerkung des Autors: Kimi K2.5 ist jetzt vollständig Open Source. Dieser Artikel erläutert die Open-Source-Lizenz, den Download des Modells sowie die API-Anbindung und bietet ein vollständiges Code-Beispiel für den schnellen Aufruf von Kimi K2.5 über APIYI.

Ist Kimi K2.5 Open Source? Das ist die Frage, die viele Entwickler derzeit am meisten beschäftigt. Die gute Nachricht: Moonshot AI hat am 26. Januar 2026 Kimi K2.5 offiziell als vollständiges Open-Source-Projekt veröffentlicht. Dies umfasst sowohl den Code als auch die Modellgewichte unter der Modified MIT License.

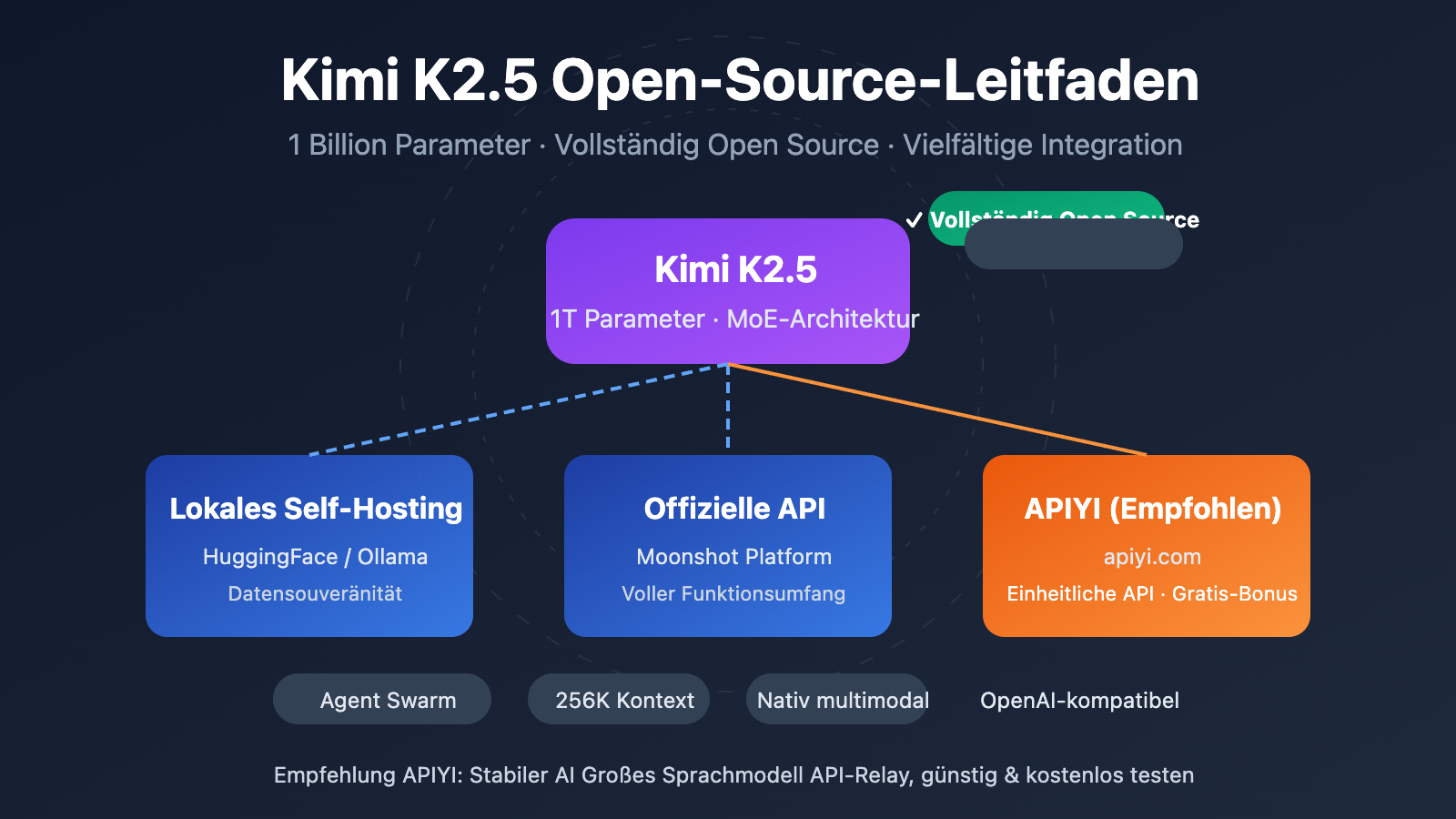

Kernbotschaft: Nach der Lektüre dieses Artikels kennen Sie die Details der Open-Source-Veröffentlichung von Kimi K2.5 und beherrschen drei Wege der Einbindung – Self-Hosting, offizielle API und Drittanbieter-Plattformen (wie APIYI apiyi.com) –, um dieses multimodale Agent-Modell mit einer Billion Parametern schnell in Ihren Projekten einzusetzen.

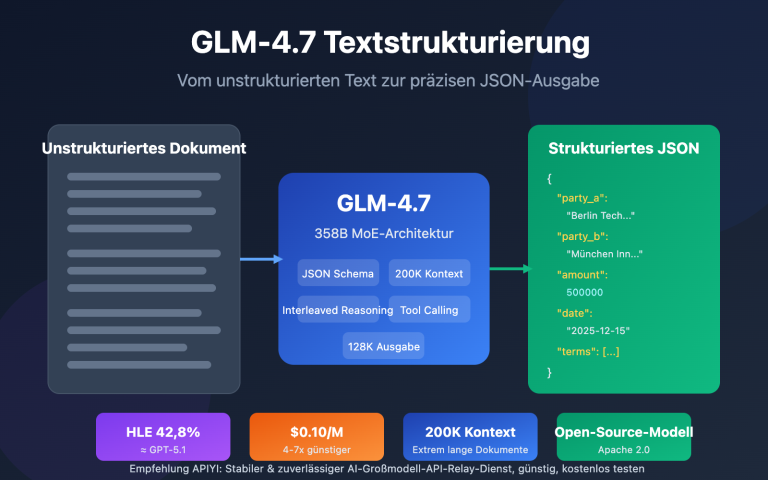

Kimi K2.5 Open Source: Die wichtigsten Fakten

| Punkt | Beschreibung | Vorteil für Entwickler |

|---|---|---|

| Vollständig Open Source | Code + Gewichte offen, Modified MIT License | Kommerziell nutzbar, lokal bereitstellbar, Fine-Tuning möglich |

| Billionen-Parameter MoE | 1T Gesamtparameter, 32B aktive Parameter | Leistung auf Niveau geschlossener Modelle bei geringeren Kosten |

| Nativ Multimodal | Unterstützt Bild-, Video- und Dokumentenverständnis | Ein Modell für verschiedenste Eingabetypen |

| Agent Swarm | Bis zu 100 parallele Sub-Agents | Effizienzsteigerung bei komplexen Aufgaben um das 4,5-fache |

| OpenAI-kompatibel | API-Format vollständig kompatibel mit OpenAI | Nahezu kein Aufwand bei der Migration bestehender Codes |

Details zur Kimi K2.5 Open-Source-Lizenz

Kimi K2.5 nutzt die Modified MIT License. Das bedeutet:

- Kommerzielle Nutzung: Erlaubt in kommerziellen Produkten ohne Lizenzgebühren.

- Modifikation und Weitergabe: Das Modell darf verändert und neu verbreitet werden.

- Lokale Bereitstellung: Volle Unterstützung für privates Deployment, Daten bleiben lokal.

- Fine-Tuning: Domänenspezifisches Training basierend auf den Open-Source-Gewichten ist möglich.

Im Gegensatz zu den restriktiven Lizenzen der LLaMA-Serie ist die Lizenz von Kimi K2.5 entwicklerfreundlicher und besonders für Unternehmensanwendungen geeignet.

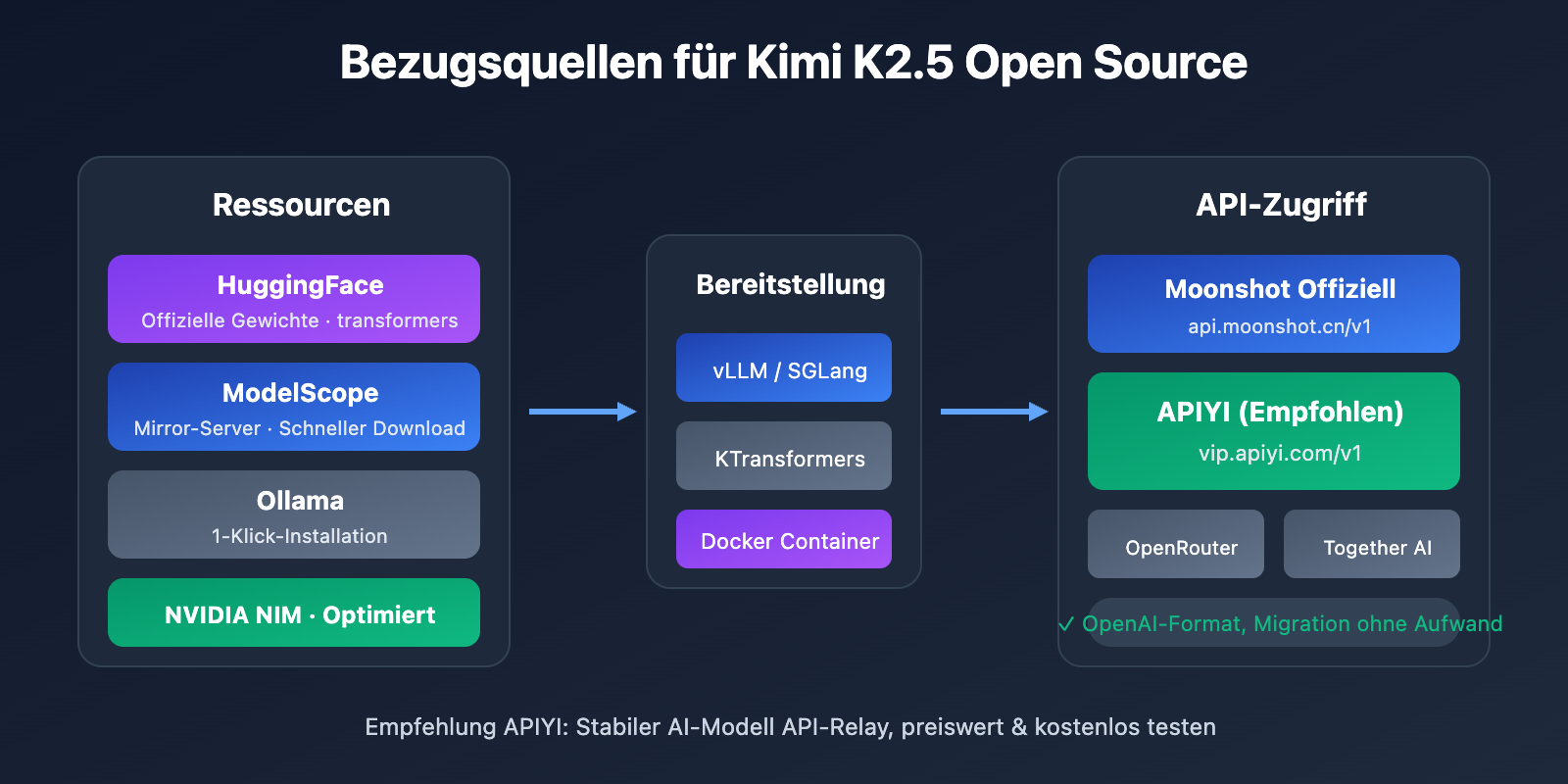

Bezugsquellen für Kimi K2.5 Open-Source-Ressourcen

Modellgewichte und Code sind über folgende Kanäle verfügbar:

| Ressource | Adresse | Beschreibung |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

Offizielle Gewichte, unterstützt transformers 4.57.1+ |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

Optimiertes Deployment-Image |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

Mirror-Server für schnellen Download |

| Ollama | ollama.com/library/kimi-k2.5 |

Lokale Ausführung mit einem Klick |

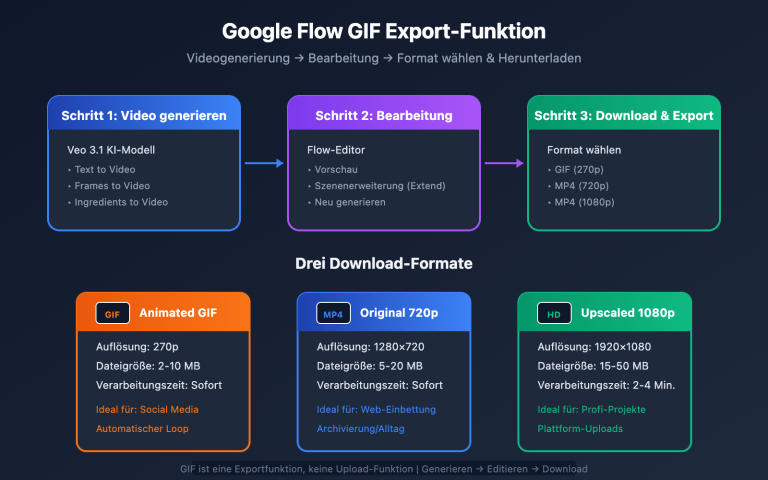

Es gibt drei Hauptwege für die Integration von Kimi K2.5: Selbsthosting, die offizielle API und Drittanbieter-Plattformen. Für die meisten Entwickler empfehlen wir die Integration per API, da sie eine schnelle Validierung der Ergebnisse ohne eigene GPU-Ressourcen ermöglicht.

Minimalbeispiel

Hier ist der einfachste Code zum Aufrufen von Kimi K2.5 über die APIYI-Plattform – in nur 10 Zeilen einsatzbereit:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # Erhältlich auf apiyi.com

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "Erkläre die Grundprinzipien des Quantencomputings"}]

)

print(response.choices[0].message.content)

Vollständigen Code für den Kimi K2.5 Thinking-Modus ansehen

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

Kimi K2.5 API aufrufen

Args:

prompt: Benutzereingabe

thinking_mode: Ob der Thinking-Modus (Deep Reasoning) aktiviert werden soll

system_prompt: System-Eingabeaufforderung

max_tokens: Maximale Anzahl der Output-Tokens

Returns:

Dictionary mit Reasoning-Prozess und endgültiger Antwort

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# Reasoning-Modus konfigurieren

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# Anwendungsbeispiel - Thinking-Modus

result = call_kimi_k25(

prompt="Was ist größer: 9.11 oder 9.9? Bitte überlege genau.",

thinking_mode=True

)

print(f"Reasoning-Prozess: {result['reasoning']}")

print(f"Endgültige Antwort: {result['content']}")

Empfehlung: Sichern Sie sich kostenloses Testguthaben über APIYI (apiyi.com), um die Reasoning-Fähigkeiten von Kimi K2.5 schnell zu testen. Die Plattform hat Kimi K2.5 bereits online geschaltet und unterstützt sowohl den Thinking- als auch den Instant-Modus.

Vergleich der Integrationsoptionen für Kimi K2.5

| Option | Kernmerkmale | Anwendungsbereiche | Kostenüberlegungen |

|---|---|---|---|

| Selbsthosting | Datenlokalisierung, volle Kontrolle | Datensensible Unternehmensszenarien | Benötigt 48GB+ VRAM (INT4) |

| Offizielle API | Stabile Leistung, volle Funktionalität | Standard Entwicklungs- & Testszenarien | $0.60/M Input, $3/M Output |

| APIYI | Einheitliche Schnittstelle, Modellwechsel | Schnelle Validierung, kostensensibel | Pay-as-you-go, Gratis-Guthaben |

Detaillierte Erläuterung der drei Integrationswege

Option 1: Lokales Selbsthosting

Geeignet für Unternehmen mit eigenen GPU-Ressourcen und extrem hohen Anforderungen an den Datenschutz. Wir empfehlen die Bereitstellung mittels vLLM oder SGLang:

# Ein-Klick-Bereitstellung mit Ollama (benötigt 48GB+ VRAM)

ollama run kimi-k2.5

Option 2: Offizielle API

Integration direkt über die Moonshot-Plattform, um stets Zugriff auf die neuesten Funktionen zu haben:

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

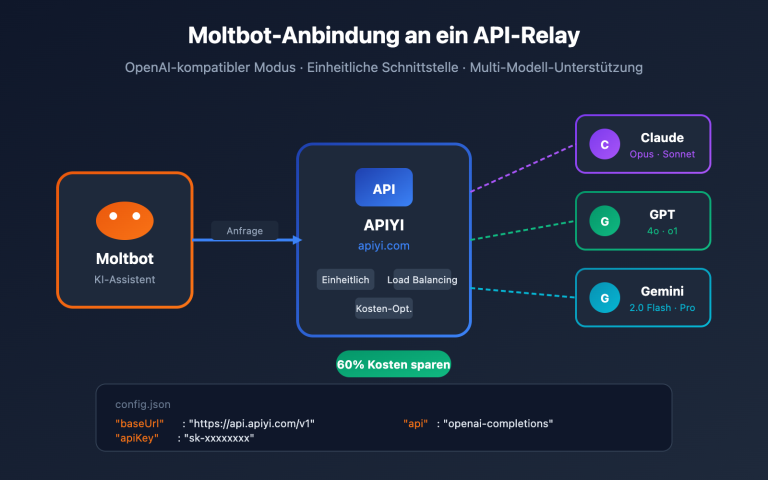

Option 3: APIYI-Plattform (Empfohlen)

Kimi K2.5 ist bereits auf APIYI (apiyi.com) verfügbar und bietet folgende Vorteile:

- Einheitliche Schnittstelle im OpenAI-Format, kein Lernaufwand.

- Unterstützt den schnellen Wechsel und Vergleich mit Modellen wie GPT-4o und Claude.

- Kostenloses Testguthaben für neue Benutzer.

- Stabiler Zugriff ohne Proxy-Bedarf.

Integrations-Tipp: Wir empfehlen, zunächst eine Funktionsprüfung und Ergebnisevaluierung über APIYI (apiyi.com) durchzuführen. Erst wenn feststeht, dass das Modell optimal zu Ihrem Szenario passt, sollte über eine Selbsthosting-Lösung nachgedacht werden.

Kimi K2.5 Kostenvergleich mit Wettbewerbern

| Modell | Eingabepreis | Ausgabepreis | Kosten pro Anfrage (5K Ausgabetoken) | Vergleich |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | Referenz |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | 38 % teurer |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | 444 % teurer |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | 81 % teurer |

Während die Leistung von Kimi K2.5 nah an einige Closed-Source-Modelle heranreicht oder diese sogar übertrifft, betragen die Kosten nur etwa 1/5 von Claude Opus 4.5. Damit ist es eines der Großen Sprachmodelle mit Billionen-Parametern mit dem derzeit besten Preis-Leistungs-Verhältnis.

Häufig gestellte Fragen (FAQ)

Q1: Ist Kimi K2.5 Open Source? Ist eine kommerzielle Nutzung erlaubt?

Ja, Kimi K2.5 wurde am 26. Januar 2026 vollständig unter der Modified MIT License quelloffen zur Verfügung gestellt. Sowohl der Code als auch die Modellgewichte sind frei zugänglich und unterstützen die kommerzielle Nutzung, Modifikation und Weitergabe.

Q2: Was ist der Unterschied zwischen dem „Thinking“-Modus und dem „Instant“-Modus von Kimi K2.5?

Der Thinking-Modus liefert einen detaillierten Denkprozess (reasoning_content) zurück und eignet sich hervorragend für komplexe Aufgaben. Der Instant-Modus liefert direkt die Antwort und bietet eine schnellere Reaktionszeit. Wir empfehlen, für mathematische und logische Probleme den Thinking-Modus und für alltägliche Unterhaltungen den Instant-Modus zu nutzen.

Q3: Wie kann ich die Integration von Kimi K2.5 schnell testen?

Wir empfehlen für den Test die Nutzung einer API-Aggregationsplattform, die mehrere Modelle unterstützt:

- Besuchen Sie APIYI (apiyi.com) und registrieren Sie ein Konto.

- Holen Sie sich Ihren API-Key und das kostenlose Testguthaben.

- Verwenden Sie die Code-Beispiele aus diesem Artikel und setzen Sie die

base_urlaufhttps://vip.apiyi.com/v1. - Geben Sie als Modellnamen einfach

kimi-k2.5an, um den Aufruf zu starten.

Zusammenfassung

Kernpunkte der Open-Source-Integration von Kimi K2.5:

- Vollständig Open Source: Kimi K2.5 nutzt die Modified MIT License; sowohl der Code als auch die Gewichte sind für die kommerzielle Nutzung freigegeben.

- Vielfältige Integrationsmöglichkeiten: Unterstützung für Selbst-Hosting, offizielle API und Drittanbieter-Plattformen – wählbar je nach Bedarf.

- Herausragendes Preis-Leistungs-Verhältnis: Ein Modell mit Billionen von Parametern zu nur 1/5 der Kosten von Claude Opus 4.5.

Kimi K2.5 ist jetzt auf APIYI (apiyi.com) verfügbar. Neue Nutzer können sich ein kostenloses Kontingent sichern. Wir empfehlen, die Modellleistung über die Plattform schnell zu validieren, um zu prüfen, ob sie für Ihr Geschäftsszenario geeignet ist.

Referenzen

⚠️ Hinweis zum Linkformat: Alle externen Links verwenden das Format

Name: domain.com. Dies ermöglicht ein einfaches Kopieren, verhindert jedoch anklickbare Sprünge, um den SEO-Wert zu erhalten.

-

Kimi K2.5 HuggingFace Model Card: Offizielle Modellgewichte und technische Dokumentation

- Link:

huggingface.co/moonshotai/Kimi-K2.5 - Beschreibung: Zugriff auf Modellgewichte, Bereitstellungsleitfäden und API-Anwendungsbeispiele.

- Link:

-

Kimi K2.5 Technischer Bericht: Detaillierte Modellarchitektur und Trainingsmethoden

- Link:

kimi.com/blog/kimi-k2-5.html - Beschreibung: Erfahren Sie mehr über technische Kerndetails wie Agent Swarm, MoE-Architektur usw.

- Link:

-

Moonshot Open Platform: Offizielle API-Dokumentation und SDK

- Link:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - Beschreibung: Offizieller Integrationsleitfaden inklusive Preisgestaltung und Informationen zu Rate Limits.

- Link:

-

Ollama Kimi K2.5: Lokale Ein-Klick-Bereitstellungslösung

- Link:

ollama.com/library/kimi-k2.5 - Beschreibung: Ideal für lokale Tests und Bereitstellungsszenarien in kleinem Umfang.

- Link:

Autor: Technik-Team

Technischer Austausch: Diskutieren Sie gerne Ihre Erfahrungen mit Kimi K2.5 im Kommentarbereich. Weitere Modellvergleiche und Tutorials finden Sie in der APIYI (apiyi.com) Technik-Community.