Anmerkung des Autors: Tiefgehende Analyse der Anwendung von Sora 2 in der AI-Comic-Drama-Branche, einschließlich der Aufrechterhaltung der Charakterkonsistenz, API-Batch-Generierungs-Workflows sowie technischer Einschränkungen und Best Practices bei der Produktion.

AI-Comic-Dramen (AI Comic Drama) entwickeln sich derzeit zu einem aufstrebenden Trend in der Content-Erstellung. Die Nutzung der Sora 2 Charakter-Funktion (Character Cameo) zur Gewährleistung der Charakterkonsistenz sowie die Batch-Generierung von Szenen über API-Schnittstellen sind die derzeit wichtigsten technischen Herausforderungen für Ersteller.

Kernvorteile: Nach der Lektüre dieses Artikels wissen Sie, wie Sie die Charakter-Funktion von Sora 2 nutzen, um wiederverwendbare Charaktere zu erstellen, Szenen via API in Serie zu generieren und die technischen Grenzen sowie Optimierungsstrategien der AI-Comic-Produktion zu verstehen.

Kernpunkte der Sora 2 Comic-Produktion

| Punkt | Erklärung | Nutzen |

|---|---|---|

| Charakter-Funktion (Character Cameo) | Erstellung wiederverwendbarer Charaktere mit eindeutiger Character ID | Gewährleistet ein konsistentes Aussehen über mehrere Videos hinweg |

| API-Batch-Generierung | Aufruf der Sora 2 API über eine einheitliche Schnittstelle | Ermöglicht die automatisierte Massenproduktion von Szenen |

| 95%+ Charakterkonsistenz | Fortschrittliche Diffusionsmodelle sichern Konsistenz über Schnitte hinweg | Reduziert Flackern und morphologische Veränderungen der Charaktere |

| Multi-Charakter-Support | Unterstützt bis zu 2 Charaktere gleichzeitig in einem Video | Ideal für Dialog- und Interaktionsszenen |

| Berechtigungssystem | Charaktere können auf privat/nur Freunde/öffentlich gesetzt werden | Schützt die IP-Rechte an originellen Charakteren |

Details zur Produktion von Sora 2 AI-Comic-Dramen

Was ist ein AI-Comic-Drama?

Ein AI-Comic-Drama bezieht sich auf Kurzvideo-Serien, die mit AI-Videogenerierungsmodellen (wie Sora 2) erstellt wurden. Diese nutzen oft einen visuellen Comic-Stil, kombiniert mit Untertiteln und Voiceover, um eine Geschichte zu erzählen. Die traditionelle Comic-Produktion umfasst Phasen wie Story-Planung, Skripting, Charakterdesign, Storyboarding, Lineart, Kolorierung, Effekte und Lettering – ein Zyklus, der pro Episode Tage bis Wochen dauern kann.

Mit Generierungsmodellen wie Sora 2 kann dieser Prozess auf wenige Stunden komprimiert werden. Ersteller müssen lediglich das Skript vorbereiten, das Charakterdesign festlegen und dann mittels Prompts und der Charakter-Funktion Szenen in Serie generieren. Zum Schluss folgen nur noch einfacher Schnitt und Vertonung.

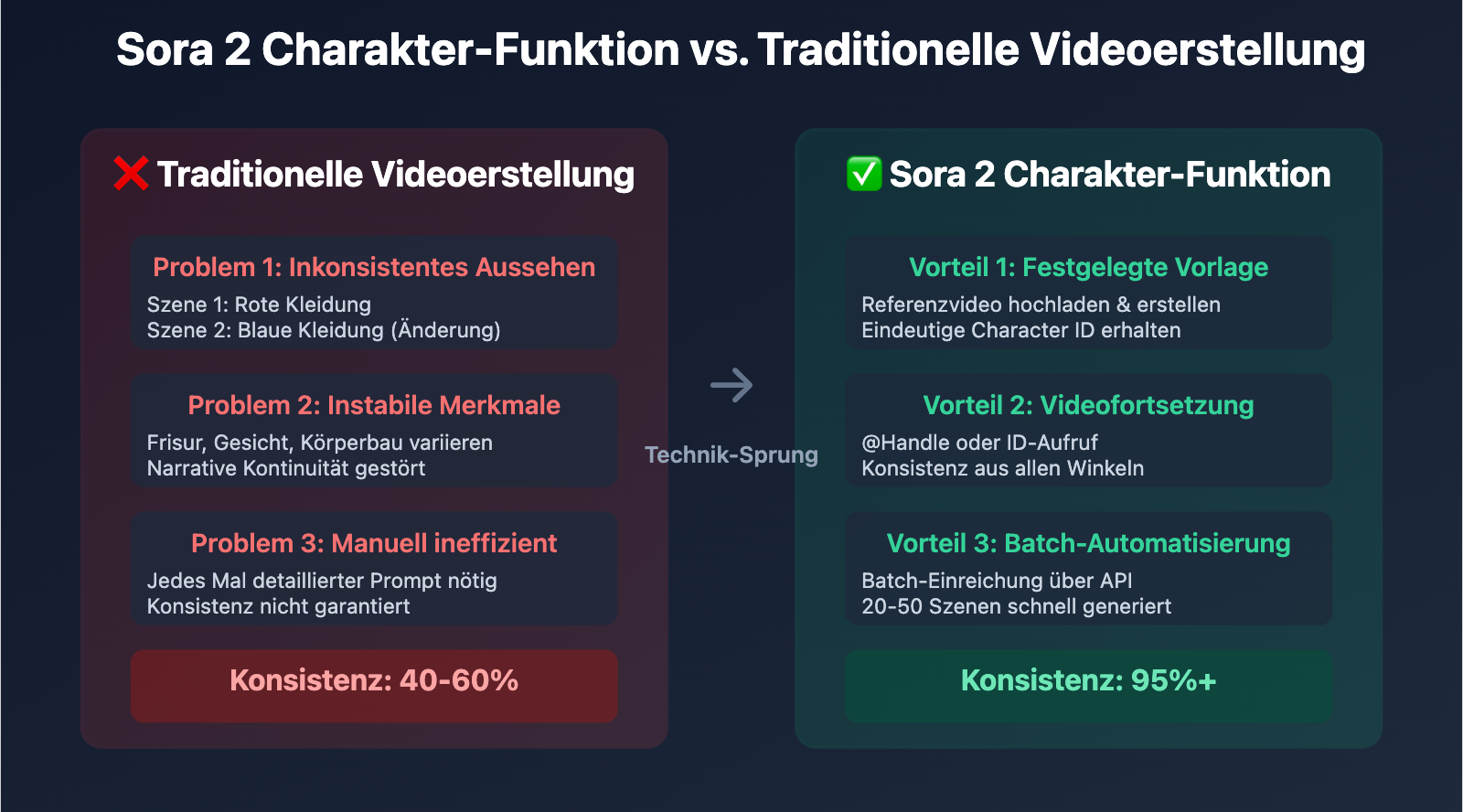

Warum ist Charakterkonsistenz das Hauptproblem?

Bei der herkömmlichen AI-Videogenerierung war der größte Schmerzpunkt die Inkonsistenz der Charaktere in verschiedenen Szenen. Beispielsweise trägt ein Charakter in der ersten Einstellung rote Kleidung, während sie in der zweiten blau sein könnte; auch Frisur, Gesichtszüge und Körperbau konnten variieren. Diese Inkonsistenz stört den Erzählfluss massiv.

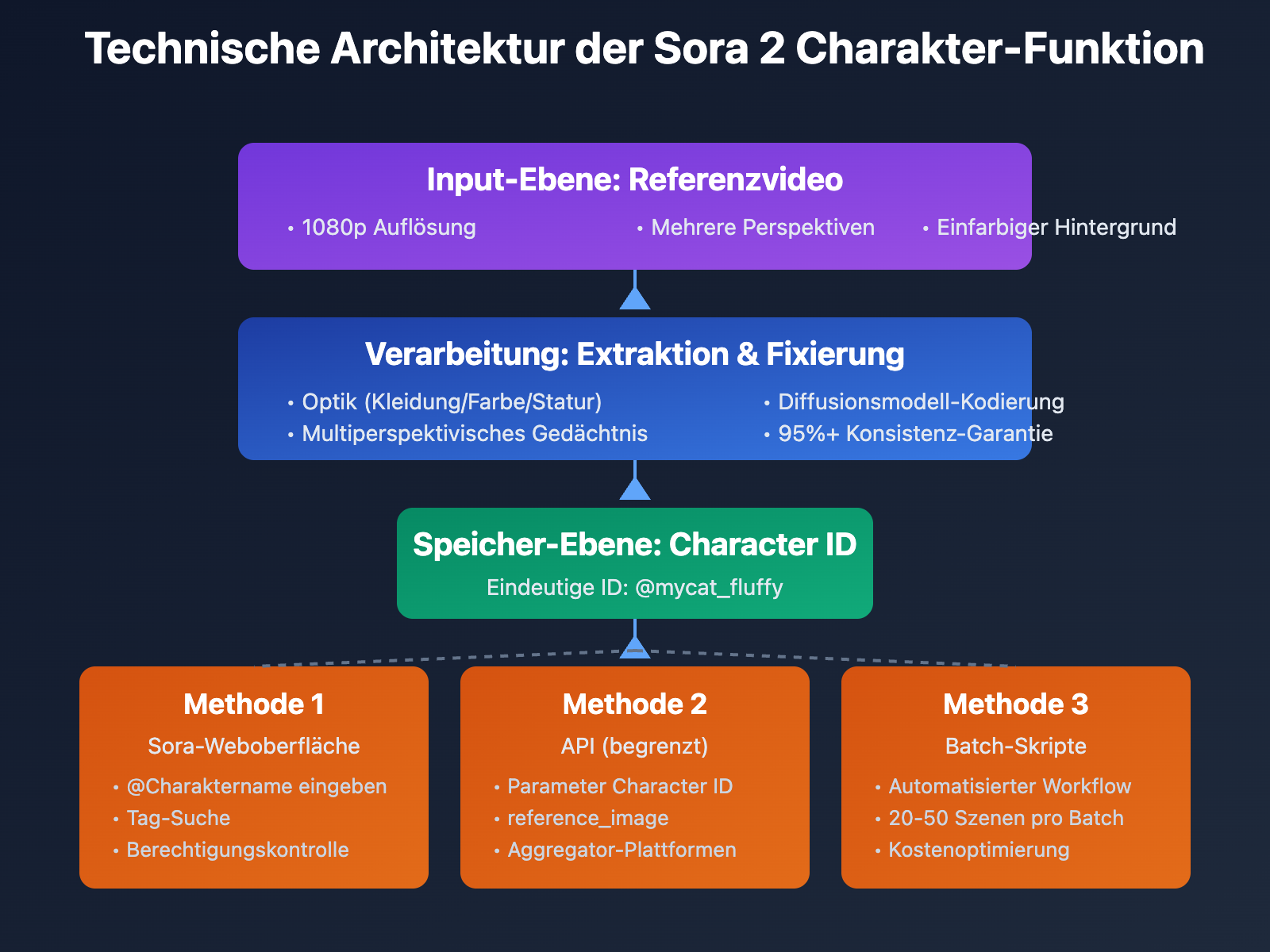

Die Character-Cameo-Funktion von Sora 2 löst dies durch folgende Mechanismen:

- Charakter-Template-Lock: Durch Hochladen eines Referenzvideos wird ein Template erstellt. Das System extrahiert visuelle Merkmale (Aussehen, Kleidung, Statur) und speichert diese als Character ID.

- Videoübergreifende Wiederverwendung: Bei neuen Videoanfragen kann das Template über

@Charakternameoder das Character-ID-Tag aufgerufen werden. - Perspektivische Beständigkeit: Das System "merkt" sich das Aussehen des Charakters aus verschiedenen Kameraperspektiven und hält eine Konsistenz von über 95 % ein.

- Konsistenz über mehrere Schnitte: Unterstützt den Aufbau von Sequenzen mit mehreren Einstellungen, wobei der Übergang des Charakters zwischen den Schnitten fließend bleibt.

Die Rolle der API in der Comic-Produktion

Für eine minutenlange Comic-Episode müssen oft 20 bis 50 Szenen generiert werden. Die manuelle Erstellung über ChatGPT Plus oder die Sora-Weboberfläche ist extrem ineffizient. Durch API-Aufrufe können Ersteller:

- Batch-Anfragen senden: Mehrere Generierungsaufgaben für Szenen gleichzeitig übermitteln.

- Automatisierte Workflows: Skriptanalyse, Prompt-Generierung, API-Aufrufe und Video-Downloads in einem automatisierten Skript bündeln.

- Kostenoptimierung: API-Preise sind oft günstiger als Abomodelle, da nach tatsächlichem Bedarf abgerechnet wird.

- Plattformübergreifender Vergleich: Über API-Aggregationsplattformen können die Ergebnisse verschiedener Modelle schnell verglichen werden.

Sora 2 Charakter-Funktionen: Schnelleinstieg

Erstellen wiederverwendbarer Charaktere (Character Cameo)

Sora 2 ermöglicht es Ihnen, Charakter-Vorlagen aus Videos zu erstellen. Hier ist der vollständige Prozess:

Schritt 1: Referenzvideo vorbereiten

- Sie können von Sora generierte Videos verwenden oder eigene Aufnahmen aus Ihrer Galerie hochladen.

- Das Video sollte das äußere Erscheinungsbild des Charakters (Ganzkörper oder Oberkörper) deutlich zeigen.

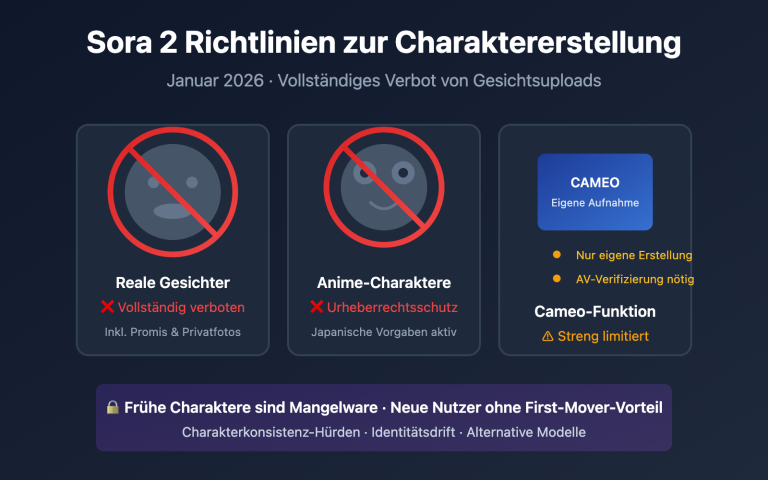

- Unterstützte Charaktertypen: Haustiere, Spielzeuge, handgezeichnete Charaktere, Avatare (nicht autorisierte reale Personen sind untersagt).

Schritt 2: Charakter erstellen

In der Sora-App:

- Klicken Sie auf die Schaltfläche

⋯oben rechts im Video oder Entwurf. - Wählen Sie

Create character(Charakter erstellen). - Geben Sie den Anzeigenamen (Display Name) und den Benutzernamen (Handle) des Charakters ein.

- Berechtigungen festlegen:

Only me– Nur für mich selbst verfügbar.People I approve– Nur für von mir genehmigte Benutzer verfügbar.Mutuals– Für Benutzer verfügbar, denen ich folge und die mir folgen.Everyone– Für alle verfügbar.

Schritt 3: Charakter in neuen Videos aufrufen

Verwenden Sie in Ihrer Eingabeaufforderung eine der folgenden Methoden, um den Charakter zu referenzieren:

@Charakter-Handle(z. B.:@mycat_fluffy)- Oder geben Sie direkt den Anzeigenamen des Charakters ein (z. B.:

Fluffy the cat)

Einschränkungen:

- Maximal 2 Charaktere können gleichzeitig in einem Video vorkommen.

- Charaktere müssen nicht-menschliche Objekte sein (Haustiere, Spielzeuge, Zeichnungen usw.).

- Für reale Personen muss der separate „Personal Character“-Prozess genutzt und eine Genehmigung der Person eingeholt werden.

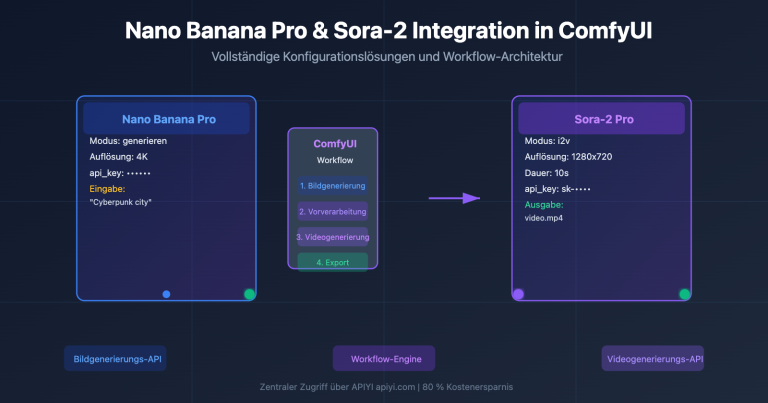

Sora 2 API: Praxisleitfaden zur Batch-Generierung von Video-Serien

Einfaches Beispiel: Generierung einer einzelnen Szene

Hier ist der minimalste Code zum Aufruf der Sora 2 API über das offizielle OpenAI SDK:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Einzelne Szene für eine Video-Serie generieren

response = client.videos.generate(

model="sora-2-1080p",

prompt="A cartoon cat wearing a red scarf walks into a cozy living room, animated style",

duration=5

)

print(f"Video-Generierungsaufgabe eingereicht: {response.id}")

Vollständigen Batch-Generierungscode anzeigen

import openai

import time

from typing import List, Dict

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

def batch_generate_scenes(

scenes: List[Dict[str, str]],

model: str = "sora-2-1080p",

character_id: str = None

) -> List[str]:

"""

Szenen für eine Video-Serie in Serie generieren.

Args:

scenes: Liste der Szenen, jede enthält prompt und duration

model: Modellname

character_id: Optionale Charakter-ID

Returns:

Liste der Video-Task-IDs

"""

task_ids = []

for i, scene in enumerate(scenes):

prompt = scene["prompt"]

# Falls eine Charakter-ID bereitgestellt wurde, in der Eingabeaufforderung referenzieren

if character_id:

prompt = f"{prompt} @{character_id}"

try:

response = client.videos.generate(

model=model,

prompt=prompt,

duration=scene.get("duration", 5)

)

task_ids.append(response.id)

print(f"✅ Szene {i+1} erfolgreich eingereicht: {response.id}")

# Kurze Pause, um Rate Limits zu vermeiden

time.sleep(1)

except Exception as e:

print(f"❌ Szene {i+1} fehlgeschlagen: {str(e)}")

return task_ids

# Anwendungsbeispiel: Szenen einer animierten Kurzserie definieren

scenes = [

{

"prompt": "A cartoon cat with red scarf enters a living room, excited expression",

"duration": 5

},

{

"prompt": "The cat discovers a mysterious gift box on the table, curious",

"duration": 5

},

{

"prompt": "The cat opens the box, surprised expression, sparkles emerge",

"duration": 6

}

]

# Batch-Generierung (vorausgesetzt, die Charakter-ID wurde bereits erstellt)

task_ids = batch_generate_scenes(

scenes=scenes,

model="sora-2-1080p",

character_id="mycat_fluffy"

)

print(f"\nInsgesamt {len(task_ids)} Generierungsaufgaben eingereicht")

Technischer Rat: Für die tatsächliche Produktion von animierten Kurzserien empfiehlt es sich, Tests über die Plattform APIYI (apiyi.com) durchzuführen. Die Plattform bietet eine einheitliche API-Schnittstelle, die Sora 2 und weitere führende Video-Modelle unterstützt, was hilft, die technische Machbarkeit und Kosteneffizienz Ihrer Lösungen schnell zu validieren.

Technische Einschränkungen und Optimierung bei der Sora 2 Videoproduktion

Kernbeschränkungen

| Art der Einschränkung | Details | Auswirkung | Lösungsstrategie |

|---|---|---|---|

| Anzahl der Charaktere | Maximal 2 Charaktere pro Video | Szenen mit vielen Personen können nicht generiert werden | Szenen-Splitting, nach mehrfacher Generierung zusammenschneiden |

| Charaktertyp | Unterstützt nur nicht-reale Objekte | Reale Personen können nicht direkt verwendet werden | Verwendung von virtuellen Avataren im Comic-Stil |

| Generierungsdauer | 5-20 Sekunden pro Generierung | Lange Einstellungen müssen in Abschnitten erstellt werden | Verwendung der Stitch-Funktion zum Zusammenfügen |

| API-Verfügbarkeit | Character-Cameo-Funktion in der API eventuell eingeschränkt | Erfordert die Verwendung von reference_image als Ersatz |

Test der Verfügbarkeit über Aggregationsplattformen |

| Inhaltsmoderation | Bilder realer Personen werden vom System blockiert | Reale Referenzbilder können nicht verwendet werden | Nur Illustrationen oder 3D-Charaktere verwenden |

Tipps zur Optimierung der Charakterkonsistenz

1. Optimierung der Referenzvideo-Qualität

Bei der Erstellung von Charaktervorlagen beeinflusst die Qualität des Referenzvideos direkt die Konsistenz der späteren Generierung:

- Klarheit: Verwenden Sie Videos mit einer Auflösung von 1080p oder höher.

- Vielfalt der Blickwinkel: Stellen Sie Referenzen aus verschiedenen Winkeln bereit – Vorderseite, Seite, Rückseite (es können 3–5 Referenzvideos erstellt werden).

- Stabile Beleuchtung: Vermeiden Sie starke Hell-Dunkel-Kontraste oder komplexe Licht- und Schatteneffekte.

- Einfacher Hintergrund: Ein einfarbiger oder schlichter Hintergrund hilft dem System, Charaktermerkmale präziser zu extrahieren.

2. Strategien zur Optimierung der Eingabeaufforderung (Prompt)

Beim Aufrufen eines Charakters beeinflusst die Formulierung der Eingabeaufforderung die Wiedergabetreue des Charakters:

- Eindeutige Referenz: Verwenden Sie immer

@Charakternamefür eine klare Referenz, anstatt nur das Aussehen zu beschreiben. - Detaillierte Aktionen: Beschreiben Sie Bewegungen und Mimik detailliert; zum Beispiel ist

walks slowly(geht langsam) präziser alsmoves(bewegt sich). - Stil-Fixierung: Betonen Sie den Stil in der Eingabeaufforderung wiederholt, z. B.

cartoon style, 2D animation. - Konflikte vermeiden: Beschreiben Sie in der Eingabeaufforderung keine Merkmale (wie Farben oder Kleidung), die im Widerspruch zur Charaktervorlage stehen.

3. Umgang mit Szenen mit mehreren Charakteren

Da ein einzelnes Video maximal 2 Charaktere unterstützt, erfordern Szenen mit vielen Personen eine spezielle Behandlung:

- Szenen aufteilen: Zerlegen Sie Gruppenszenen in mehrere Einzel- oder Doppel-Einstellungen.

- Cross-Cutting: Nutzen Sie den Filmschnitt, um die Anwesenheit mehrerer Personen zu simulieren.

- Hintergrund-Overlay: Verwenden Sie Videobearbeitungssoftware, um mehrfach generierte Charaktere über denselben Hintergrund zu legen.

Vergleich der Sora 2 API-Schnittstellenlösungen

| Lösung | Hauptmerkmale | Anwendungsfall | Unterstützung von Charakterfunktionen |

|---|---|---|---|

| Offizielle OpenAI API | Offizielle Schnittstelle, hohe Stabilität | Anwendungen auf Unternehmensebene, ausreichendes Budget | Vollständige Unterstützung (Plus-Abonnement erforderlich) |

| API-Aggregationsplattform | Einheitliche Schnittstelle, Vergleich mehrerer Modelle | Kleine und mittlere Teams, flexibler Modellwechsel erforderlich | Teilweise Unterstützung, abhängig von der Implementierung der Plattform |

| Mirror-API von Drittanbietern | Günstige Preise, Pay-as-you-go | Einzelne Ersteller, kostensensibel | Eingeschränkte Unterstützung, oft nur reference_image |

Vergleichshinweis: Die oben genannten Lösungen haben jeweils Vor- und Nachteile. Wir empfehlen, zunächst Praxistests über die Plattform APIYI (apiyi.com) durchzuführen. Diese Plattform unterstützt den einheitlichen API-Aufruf für Sora 2 und verschiedene andere Video-Generierungsmodelle, was den schnellen Vergleich von Ergebnissen und Kosten erleichtert.

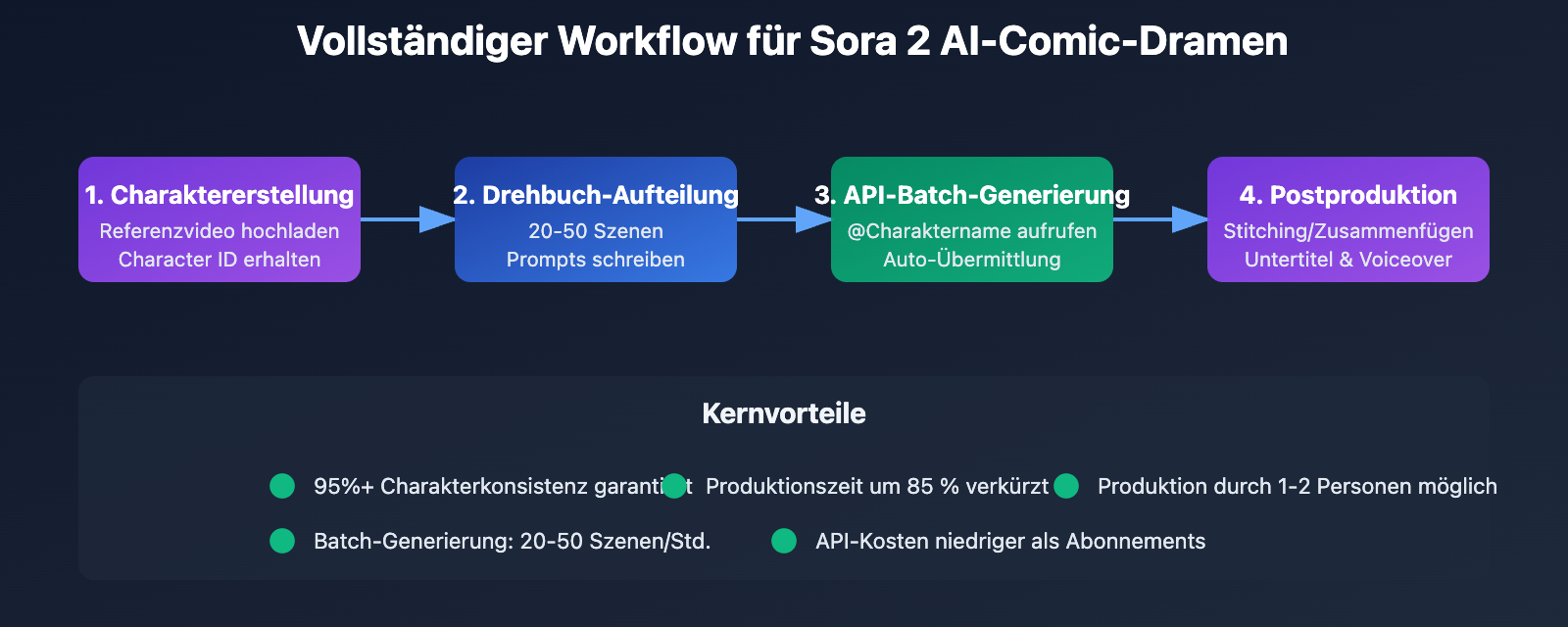

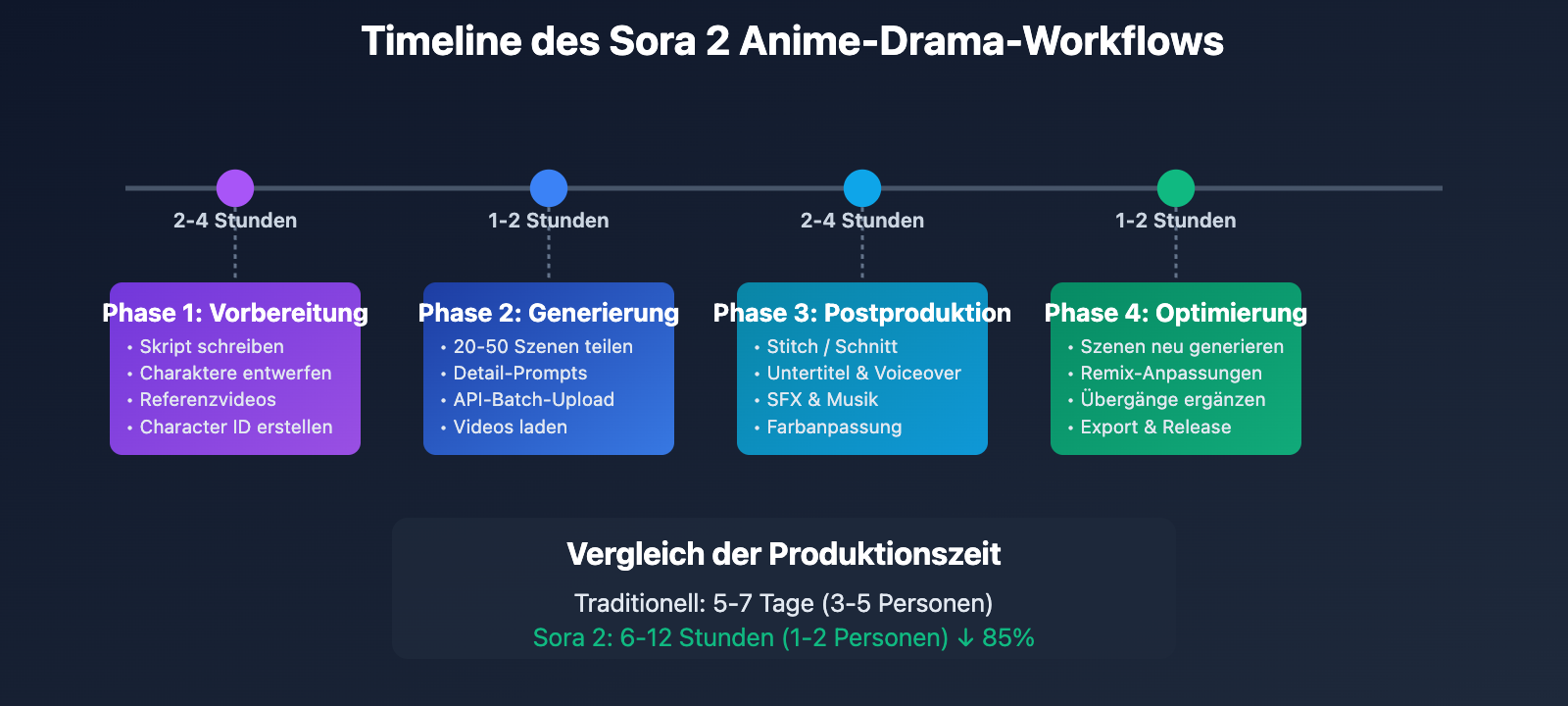

Vollständiger Workflow für die Sora 2 Anime-Drama-Produktion

Phasen des Workflows

Phase 1: Vorbereitung (Pre-Production)

- Erstellen eines vollständigen Skripts inklusive Dialogen, Szenenbeschreibungen und Charakteraktionen.

- Entwurf des Charakterdesigns sowie Zeichnen oder Generieren von Charakter-Referenzbildern.

- Nutzung von Sora 2 zur Generierung von Charakter-Referenzvideos (3–5 verschiedene Blickwinkel).

- Erstellen eines Character Cameo, um eine Character ID zu erhalten.

Phase 2: Szenengenerierung

- Aufteilung des Skripts in kurze Szenen von 5–10 Sekunden.

- Schreiben detaillierter Eingabeaufforderungen (Prompts) für jede Szene (einschließlich Charakterreferenz, Aktionen, Mimik und Kameraführung).

- Batch-Übermittlung der Generierungsaufgaben über die API.

- Herunterladen der generierten Videoclips.

Phase 3: Postproduktion

- Verwendung der Stitch-Funktion von Sora oder einer Videoschnittsoftware zum Zusammenfügen der Szenen.

- Hinzufügen von Untertiteln und Voiceover.

- Anpassung von Soundeffekten und Hintergrundmusik.

- Farbkorrektur (Color Grading) und Optimierung von Spezialeffekten.

Phase 4: Iteration & Optimierung

- Erneute Generierung unbefriedigender Szenen (Anpassung der Eingabeaufforderung oder Nutzung der Remix-Funktion).

- Ergänzung von Übergangsszenen.

- Finaler Export und Veröffentlichung.

Kosten- und Effizienzschätzung

| Metrik | Traditionelle Produktion | Sora 2 Produktion | Verbesserung |

|---|---|---|---|

| Charakterdesign | 1–3 Tage | 2–4 Stunden | 80% ↓ |

| Produktion pro Folge | 5–7 Tage | 6–12 Stunden | 85% ↓ |

| Personalkosten | Team von 3–5 Personen | 1–2 Personen | 60% ↓ |

| Tool-Kosten | Software + Hardware | Sora Abo + API | Vergleichbar |

| Qualitätskonsistenz | Stark abhängig von Handarbeit | 95%+ algorithmisch gesichert | Konsistenz-Plus |

Kostenoptimierung: Für budgetbewusste Einzel-Creator empfiehlt es sich, die Sora 2 API über die Plattform APIYI (apiyi.com) aufzurufen. Diese Plattform bietet flexible Pay-as-you-go-Modelle an, sodass kein ChatGPT Plus Abo erforderlich ist – ideal für kleinere Tests und Produktionen.

Häufig gestellte Fragen (FAQ)

Q1: Unterstützt die Charakter-Funktion von Sora 2 auch reale Personen?

Die Character-Cameo-Funktion von Sora 2 ist ausschließlich für nicht-reale Objekte gedacht, darunter Haustiere, Spielzeuge, handgezeichnete Charaktere oder virtuelle 3D-Avatare. Für reale Personen muss der separate „Personal Character“-Workflow genutzt werden, wofür zwingend die Erlaubnis der betreffenden Person vorliegen muss. Versuche, reale Referenzbilder über die API zu nutzen, werden vom Moderationssystem blockiert.

Lösung: Für die Produktion von Anime-Dramen wird empfohlen, Illustrationsstile oder virtuelle 3D-Charaktere zu verwenden. Dies umgeht Moderationsprobleme und passt perfekt zum visuellen Stil des Genres.

Q2: Wie geht man mit der Beschränkung von maximal 2 Charakteren pro Video um?

Dies ist eine aktuelle technische Einschränkung von Sora 2. Für Szenen, in denen mehr Personen anwesend sein müssen, können folgende Strategien angewendet werden:

- Szenentrennung: Zerlegen Sie Gruppenszenen in mehrere Dialogszenen zwischen zwei Personen und verknüpfen Sie diese im Schnitt.

- Wechsel der Einstellungsgrößen: Nutzen Sie Nahaufnahmen, die jeweils nur einen Teil der Charaktere zeigen.

- Post-Composition: Legen Sie in einer Videobearbeitungssoftware mehrfach generierte Charaktere über denselben Hintergrund.

Diese Einschränkung motiviert Creator oft dazu, cineastischere Erzähltechniken anzuwenden, indem sie durch gezielte Schnitte statt durch statische Totalen Dynamik erzeugen.

Q3: Wie nutzt man die Charakter-Funktion in API-Aufrufen?

Der offizielle Support von OpenAI für die Character-Cameo-Funktion via API ist derzeit noch nicht vollständig dokumentiert. Einige Berichte deuten darauf hin, dass die API primär die Parameter reference_image und reference_video unterstützt, wobei reale Personenbilder blockiert werden.

Empfohlenes Vorgehen:

- Registrieren Sie ein Konto auf APIYI (apiyi.com) und rufen Sie Ihren API-Key ab.

- Testen Sie, ob die Plattform die Übergabe der

character_idunterstützt. - Falls nicht, nutzen Sie den Parameter

reference_image, um statische Referenzbilder des Charakters zu übermitteln. - Beschreiben Sie das äußere Erscheinungsbild des Charakters in der Eingabeaufforderung (Prompt) so detailliert wie möglich, um die Konsistenz zu erhöhen.

Zusammenfassung

Die Kernpunkte der Produktion von KI-Dramen mit Sora 2:

- Die Charakter-Funktion ist das Herzstück: Die „Character Cameo“-Funktion ermöglicht durch wiederverwendbare Charaktervorlagen eine Konsistenz von über 95 % über verschiedene Videos hinweg. Damit wird die größte Hürde bei der Erstellung von KI-generierten Animes und Dramen überwunden.

- Effizienzsteigerung durch API-Stapelverarbeitung: Durch das Schreiben automatisierter Skripte lässt sich die Generierungszeit für 20 bis 50 Szenen einer einzelnen Episode von mehreren Stunden auf unter eine Stunde komprimieren.

- Technische Einschränkungen verstehen: Limitierungen wie maximal zwei Charaktere pro Video, die Beschränkung auf nicht-menschliche Objekte oder die begrenzte API-Verfügbarkeit müssen durch kreative Kniffe und geschickte Postproduktion umgangen werden.

- Workflow-Optimierung: Ein standardisierter Prozess – vom Skript über das Charakterdesign und die Stapelgenerierung bis hin zur Postproduktion – kann den Produktionszyklus einer Episode von 5–7 Tagen auf 6–12 Stunden verkürzen.

KI-generierte Dramen sind ein wichtiges Anwendungsfeld für Video-KI-Technologien. Mit der zunehmenden Reife der Charakter-Funktionen in Sora 2 und der Verbesserung der API-Schnittstellen wird dieser Bereich ein explosives Wachstum erleben. Wir empfehlen APIYI (apiyi.com), um Ihre Projektideen schnell zu validieren. Die Plattform bietet kostenloses Guthaben sowie eine einheitliche Schnittstelle für führende Videomodelle wie Sora 2, Kling und Runway.

📚 Referenzen

⚠️ Hinweis zum Linkformat: Alle externen Links verwenden das Format

Name: domain.com. Sie lassen sich so leicht kopieren, sind aber nicht direkt anklickbar, um den SEO-Wert der Seite zu erhalten.

-

Offizielle OpenAI Sora Dokumentation: Leitfaden zur Charakter-Funktion

- Link:

help.openai.com/en/articles/12435986-generating-content-with-characters - Beschreibung: Offizielle Einführung in den Erstellungsprozess, die Berechtigungseinstellungen und die Nutzungsbeschränkungen der Character Cameo-Funktion.

- Link:

-

Sora Release Notes: Protokoll der Funktions-Updates

- Link:

help.openai.com/en/articles/12593142-sora-release-notes - Beschreibung: Dokumentation der Funktions-Updates von Sora 2, einschließlich der Veröffentlichungstermine für Character Cameo und die Stitch-Funktion.

- Link:

-

AI Manga Maker Branchenbericht: Wie KI die Manga-Produktion revolutioniert

- Link:

aimangamaker.com/blog/how-ai-revolutionizes-manga-manhwa-production-in-2025 - Beschreibung: Tiefgehende Analyse des Einsatzes von KI-Tools bei der Erstellung von Mangas und KI-Dramen, inklusive Daten zu Effizienzsteigerung und Kosteneinsparungen.

- Link:

-

Tooning AI Plattform: Lösungen für Charakter-Konsistenz in Mangas

- Link:

skywork.ai/skypage/en/Tooning-Your-AI-Co-Pilot-for-Creating-Webtoons-and-Comics - Beschreibung: Ein alternativer Ansatz zur Erzielung von Charakter-Konsistenz durch 3D-Modellierung, ideal für vergleichende Studien.

- Link:

Autor: Technik-Team

Technischer Austausch: Wir freuen uns auf Diskussionen über Erfahrungen bei der Erstellung von KI-Dramen in den Kommentaren. Weitere technische Ressourcen zu Sora 2 finden Sie in der APIYI (apiyi.com) Tech-Community.