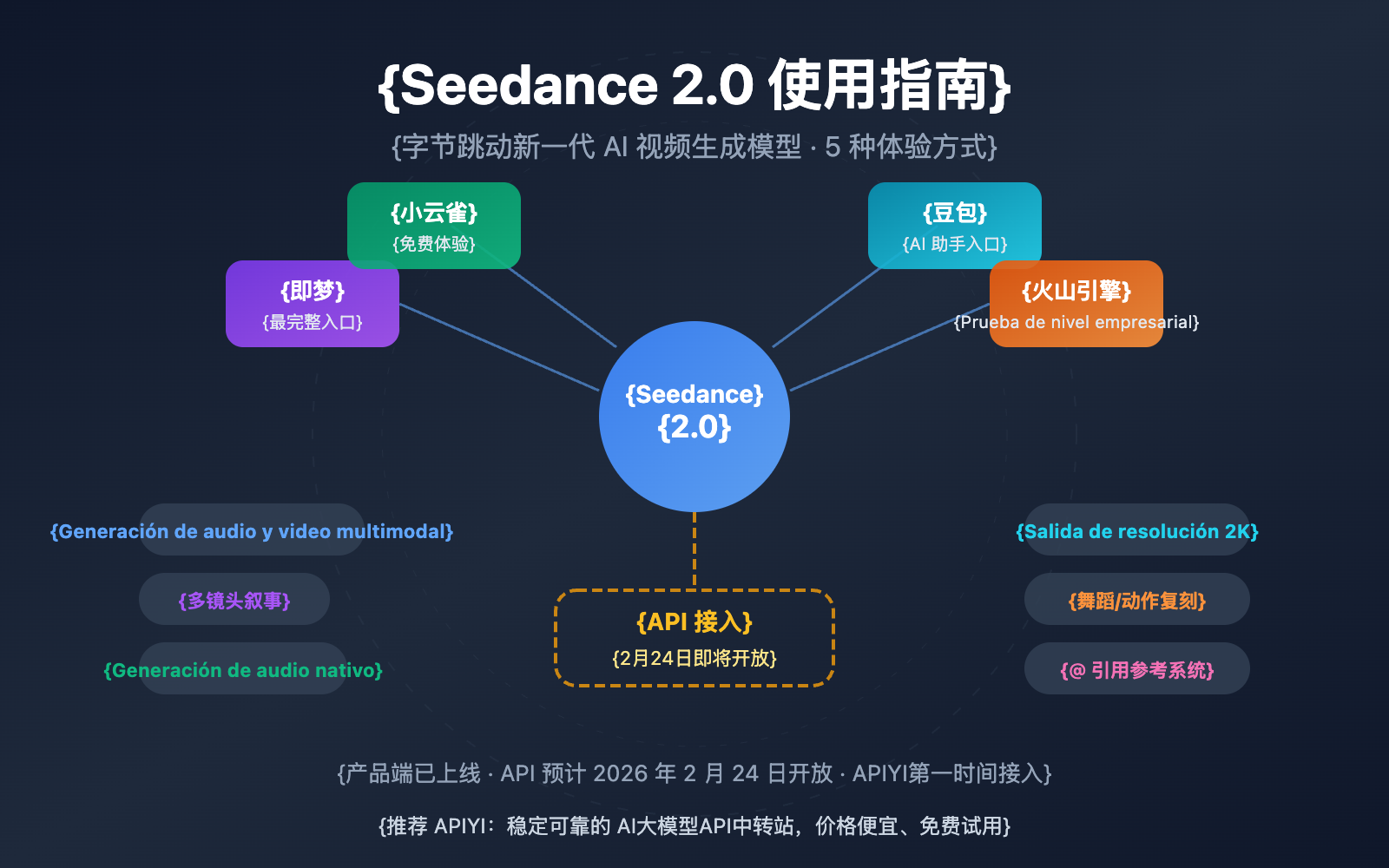

Nota del autor: Guía detallada sobre cómo usar Seedance 2.0, que abarca los puntos de acceso como Jimeng, Xiaoyunque, Doubao y Volcengine, así como estimaciones de tiempo y precio para el acceso a la API. Te ayudamos a ser de los primeros en utilizar el modelo de video por IA más potente de ByteDance.

¿Cómo usar Seedance 2.0? Esta es la pregunta que más personas se hacen ahora mismo. ByteDance lanzó oficialmente el 12 de febrero de 2026 el modelo de generación de video por IA Seedance 2.0. Gracias a su arquitectura de generación conjunta de audio y video multimodal y su capacidad narrativa multicámara, se ha convertido rápidamente en tendencia en las redes sociales de todo el mundo. En este artículo, detallaremos todas las formas de utilizar Seedance 2.0 para que puedas empezar a usarlo cuanto antes.

Valor principal: Al terminar de leer este artículo, dominarás los 5 puntos de acceso a Seedance 2.0, sus características principales, así como la información más reciente sobre los plazos de conexión a la API y sus precios.

Resumen de las funciones principales de Seedance 2.0

Antes de profundizar en cómo usar Seedance 2.0, echemos un vistazo rápido a sus capacidades principales:

| Característica | Descripción detallada | Mejora respecto a la generación anterior |

|---|---|---|

| Entrada multimodal | Soporta 4 tipos de entrada: texto, imagen, audio y video | Nueva entrada de audio |

| Narrativa multicámara | Genera videos coherentes con múltiples escenas en una sola toma, manteniendo consistencia en personajes y estilo | Nueva capacidad |

| Generación de audio nativa | Genera automáticamente efectos de sonido y música de fondo sincronizados con la imagen | Nueva capacidad |

| Salida en resolución 2K | Soporta salida de nivel de producción hasta 1080p | Resolución duplicada |

| Replicación de danza/movimiento | Sube un video de referencia para copiar con precisión los movimientos de cámara y la coreografía | Mejora significativa en la precisión |

Análisis de la arquitectura técnica de Seedance 2.0

Seedance 2.0 utiliza una arquitectura Dual-Branch Diffusion Transformer (Transformer de Difusión de Doble Rama), que es la clave para lograr su generación conjunta multimodal. Esta arquitectura procesa de manera unificada señales de texto, imagen, audio y video, permitiendo que el modelo genere audio perfectamente sincronizado con la imagen al mismo tiempo que crea el video.

En cuanto a la calidad de video, la velocidad de generación de Seedance 2.0 es aproximadamente un 30% más rápida que la de competidores similares (como Kling AI). Soporta duraciones de video de 4 a 15 segundos y es compatible con múltiples relaciones de aspecto como 16:9, 9:16, 4:3, 3:4, 21:9 y 1:1. La consistencia en rostros de personajes, vestimenta, texto y escenarios ha mejorado notablemente respecto a la generación anterior, solucionando eficazmente problemas comunes en videos de IA como la deriva del personaje y los saltos de estilo.

Actualmente, Seedance 2.0 ya está disponible oficialmente, pero la API aún no se ha abierto. Aquí tienes todas las formas actuales de usar Seedance 2.0:

Forma 1: Jimeng (即梦) — La puerta de entrada más completa

Jimeng es la plataforma de creación con IA de ByteDance y el primer lugar donde se puede experimentar Seedance 2.0 con todas sus funciones.

Pasos para usarlo:

- Visita la plataforma Jimeng:

jimeng.jianying.com - Inicia sesión con tu cuenta de Douyin (TikTok China).

- Entra en la sección "Generar" (生成) y selecciona "Generación de vídeo" (视频生成).

- En las opciones de modelo, selecciona Seedance 2.0.

- Introduce tu indicación de texto o sube materiales de referencia para comenzar la generación.

Información de costes: Jimeng ofrece un sistema de suscripción para miembros; los nuevos usuarios pueden probarlo por 1 yuan durante 7 días. Seedance 2.0 es una función exclusiva para miembros de pago.

🎯 Sugerencia de uso: Jimeng es actualmente la plataforma más completa para probar Seedance 2.0, por lo que es la opción recomendada. Si más adelante necesitas realizar llamadas masivas mediante API, puedes estar atento a los avisos de lanzamiento de APIYI (apiyi.com); lo integraremos tan pronto como la API esté disponible.

Forma 2: Xiao Yunque (小云雀) — Acceso para prueba gratuita

Xiao Yunque es otra aplicación de IA de ByteDance que ofrece oportunidades para probar Seedance 2.0 de forma gratuita.

Pasos para usarlo:

- Descarga la App Xiao Yunque.

- Al iniciar sesión, obtendrás 3 oportunidades gratuitas para generar vídeos con Seedance 2.0.

- Además, se regalan 120 puntos diarios para seguir experimentando.

Público ideal: Usuarios que quieran probar Seedance 2.0 gratis, especialmente para conocer los resultados iniciales.

Forma 3: Doubao (豆包) — Acceso a través del asistente de IA integral

Doubao es la aplicación de asistencia de IA integral de ByteDance, que también ha integrado las capacidades de generación de vídeo de Seedance 2.0.

Pasos para usarlo:

- Descarga la App Doubao o accede a la versión web.

- Selecciona la función de generación de vídeo en el chat.

- Elige el modelo Seedance 2.0 para crear.

Forma 4: Volcengine — Prueba de nivel empresarial

Volcengine (火山引擎) es la plataforma de servicios en la nube de ByteDance, que ofrece una consola de trabajo para que las empresas prueben Seedance 2.0.

| Plataforma | Forma de acceso | Características | ¿Ofrece API? |

|---|---|---|---|

| Volcengine | Consola en volcengine.com |

Orientado a empresas en China | Aún no abierta, prevista para el 24 de febrero |

| BytePlus | Consola en byteplus.com |

Orientado a empresas internacionales | Aún no abierta, prevista para el 24 de febrero |

Nota: Actualmente, Volcengine y BytePlus solo ofrecen la interfaz de la consola de trabajo para pruebas y aún no han abierto los endpoints de la API.

Forma 5: Acceso vía API — La opción preferida para desarrolladores (Próximamente)

Para los desarrolladores y usuarios empresariales que necesitan realizar llamadas programáticas a Seedance 2.0, la API es el método de acceso más importante.

Calendario de lanzamiento de la API:

| Hito temporal | Evento | Descripción |

|---|---|---|

| 12 de febrero de 2026 | Lanzamiento oficial de Seedance 2.0 | Disponible en productos finales |

| 24 de febrero de 2026 | Apertura prevista de la API oficial | A través de Volcengine/BytePlus |

| Inmediatamente tras la apertura | Lanzamiento simultáneo en APIYI | Precio aprox. 10% más barato que el oficial |

🎯 Sugerencia para desarrolladores: Se espera que la API de Seedance 2.0 se abra oficialmente el 24 de febrero de 2026. La plataforma APIYI (apiyi.com) lanzará el servicio de acceso a la API de Seedance 2.0 de inmediato, con un precio aproximado del 90% del coste oficial y ofreciendo una interfaz unificada compatible con el formato de OpenAI para facilitar una integración rápida. ¡Mantente atento!

Consejos y mejores prácticas para Seedance 2.0

Dominar estos trucos de uso de Seedance 2.0 puede mejorar significativamente los resultados de generación:

Consejos para redactar la indicación en Seedance 2.0

Sugerencias para indicaciones de Texto a Vídeo (Text-to-Video):

- Describe la escena visual de forma específica, incluyendo personajes, acciones, entorno e iluminación.

- Especifica el movimiento de cámara (zoom, panorámica, inclinación, seguimiento, etc.).

- Indica el estilo visual (calidad cinematográfica, estilo documental, estilo anime, etc.).

- Señala el tiempo y el ritmo (por ejemplo, "avance lento", "cambio rápido").

Ejemplo de indicación:

Una mujer joven con un vestido blanco baila bajo los cerezos en flor,

la cámara se acerca lentamente desde un plano general a un plano medio,

luz natural suave iluminando desde la izquierda, pétalos cayendo con el viento,

imagen de calidad cinematográfica, profundidad de campo reducida, calidad 4K.

Consejos para usar vídeos de referencia en Seedance 2.0

El sistema de referencias con "@" de Seedance 2.0 es su ventaja única; puedes subir un vídeo de referencia para controlar:

- Referencia de cámara: Sube un vídeo con el movimiento de cámara que te guste y el modelo lo replicará con precisión.

- Coreografía de baile: Sube un vídeo de referencia de baile y el modelo podrá generar contenido coreográfico sincronizado con el ritmo.

- Referencia de estilo: Sube una imagen o vídeo de referencia para mantener un estilo visual coherente.

🎯 Sugerencia avanzada: En escenarios de entrada multimodal, asignar roles claros a cada material de referencia mediante el uso de @ (como @referencia_camara, @referencia_personaje) permite obtener un control más preciso. Una vez que la API esté abierta, APIYI (apiyi.com) también admitirá capacidades completas de entrada multimodal.

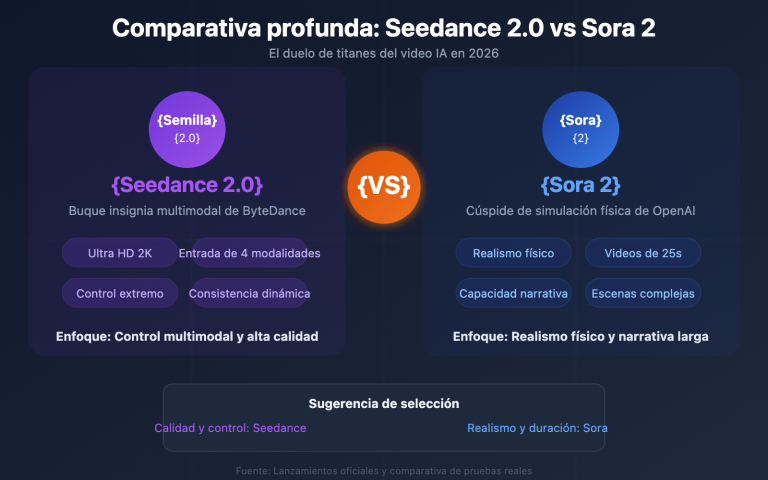

Seedance 2.0 vs. Competencia

| Dimensión de Comparativa | Seedance 2.0 | Sora 2 | Kling 3.0 |

|---|---|---|---|

| Desarrollador | ByteDance | OpenAI | Kuaishou |

| Resolución Máxima | 2K (1080p) | 1080p | 4K/60fps |

| Duración del Video | 4-15 segundos | Hasta 25 segundos | 5-10 segundos |

| Audio Nativo | ✅ Soportado | ❌ No soportado | ❌ No soportado |

| Narrativa Multicámara | ✅ Soportado | ✅ Storyboard | ❌ No soportado |

| Entrada de Video de Referencia | ✅ Multimodal @ Referencia | ❌ Limitada | ✅ Soportado |

| Simulación Física | Buena | Excelente | Buena |

| Movimiento Humano | Sobresaliente | Bueno | Excelente |

| Precio Estimado de API | $0.10-0.80/minuto | Alto | Medio |

Nota comparativa: Cada modelo tiene sus fortalezas. Seedance 2.0 lidera en audio nativo y referencias multimodales; Sora 2 es el más fuerte en simulación física y videos largos; Kling 3.0 destaca en resolución y movimiento humano. Se recomienda elegir según el escenario específico. A través de APIYI (apiyi.com), puedes comparar y probar fácilmente varios modelos de generación de video.

Preguntas frecuentes

Q1: ¿Dónde se puede usar Seedance 2.0? ¿Cuáles son los puntos de acceso actuales?

Actualmente, puedes experimentar Seedance 2.0 a través de los siguientes canales: las aplicaciones oficiales de ByteDance como Jimeng (即梦), Xiaoyunque (小云雀) y Doubao (豆包). Los usuarios empresariales también pueden probarlo a través de las consolas de Volcengine (火山引擎) y BytePlus. Se espera que la API esté disponible el 24 de febrero de 2026.

Q2: ¿Cuándo se lanza la API de Seedance 2.0 y cuánto costará?

Está previsto que la API de Seedance 2.0 se lance oficialmente el 24 de febrero de 2026 a través de Volcengine y BytePlus. El precio oficial estimado oscila entre $0.10 y $0.80 por minuto (dependiendo de la resolución). APIYI (apiyi.com) la integrará de inmediato, con un precio aproximado de un 10% de descuento respecto al sitio oficial.

Q3: ¿Es Seedance 2.0 gratuito?

Seedance 2.0 no es completamente gratuito. En la plataforma Jimeng, se requiere una suscripción de pago (los nuevos usuarios pueden probarla por 1 yuan durante 7 días); Xiaoyunque ofrece 3 oportunidades de prueba gratuitas y 120 puntos diarios. El acceso vía API se cobrará según el uso.

Q4: ¿Cómo usar la versión internacional de Seedance 2.0? ¿Cómo pueden probarlo los usuarios fuera de China?

Por ahora, Seedance 2.0 ofrece su experiencia completa principalmente a través de la plataforma Jimeng en China continental. Las versiones internacionales como Dreamina (dreamina.capcut.com) y Pippit aún no han implementado Seedance 2.0. Los usuarios en el extranjero pueden seguir las actualizaciones en la plataforma BytePlus o esperar a que la API esté abierta para acceder a través de APIYI (apiyi.com).

Notas importantes sobre el uso de Seedance 2.0

Al utilizar Seedance 2.0, ten en cuenta los siguientes puntos:

- Función de clonación de voz pausada: La función de "generar voz a partir de una foto" que venía con el lanzamiento de Seedance 2.0 ha sido suspendida por ByteDance en menos de 48 horas debido a controversias sobre deepfakes. Se espera que vuelva a estar disponible tras implementar mecanismos de verificación de identidad.

- Cumplimiento de contenido: El contenido generado debe cumplir con las leyes y normativas pertinentes, evitando la creación de material que infrinja derechos de autor o genere dilemas éticos.

- Requisitos de cuenta: La plataforma Jimeng requiere iniciar sesión con una cuenta de Douyin, lo que implica una verificación con un número de teléfono de China continental.

Resumen

Puntos clave sobre cómo usar Seedance 2.0:

- Pruébalo ahora: Puedes usar Seedance 2.0 a través de las aplicaciones oficiales de ByteDance como Jimeng, Xiaoyunque y Doubao.

- Prueba para empresas: Volcán Engine y BytePlus ofrecen una interfaz de consola para pruebas, aunque la API aún no está abierta.

- Acceso vía API: Se prevé su apertura para el 24 de febrero de 2026, momento en el cual se podrá invocar de forma programática.

- Ventajas principales: Generación de audio nativa + narrativa multicámara + referencias @ multimodales; tres capacidades diferenciadoras que lo sitúan por delante de la competencia.

Se recomienda seguir a APIYI (apiyi.com) para recibir notificaciones sobre el lanzamiento de la API de Seedance 2.0. La plataforma ofrecerá el servicio de acceso con un descuento aproximado del 10% respecto al precio oficial, mediante una interfaz unificada compatible con el formato de OpenAI, facilitando una integración rápida para los desarrolladores.

📚 Referencias

-

Página oficial de presentación de Seedance 2.0: Detalles del modelo publicados por el equipo Seed de ByteDance.

- Enlace:

seed.bytedance.com/en/seedance2_0 - Descripción: Incluye especificaciones técnicas completas y descripción de funciones.

- Enlace:

-

Plataforma de creación Jimeng AI: Punto de acceso principal para probar Seedance 2.0.

- Enlace:

jimeng.jianying.com - Descripción: Actualmente es la plataforma con las funciones más completas para utilizar Seedance 2.0.

- Enlace:

-

Blog oficial de lanzamiento de Seedance 2.0: Anuncio de lanzamiento del equipo Seed de ByteDance.

- Enlace:

seed.bytedance.com/en/blog/official-launch-of-seedance-2-0 - Descripción: Contiene información oficial como la fecha de lanzamiento y los aspectos más destacados de sus funciones.

- Enlace:

Autor: Equipo Técnico

Comunidad: Te invitamos a debatir tu experiencia con Seedance 2.0 en la sección de comentarios. Para más noticias sobre modelos de generación de video con IA, visita la comunidad técnica de APIYI (apiyi.com).