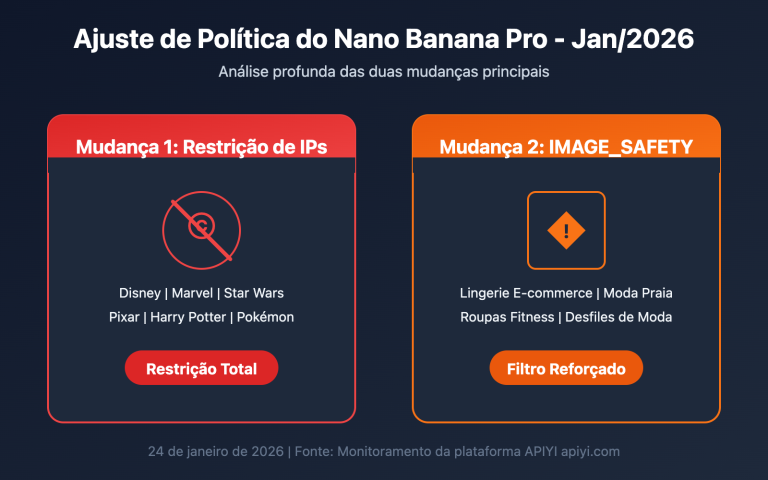

Receber o erro finishReason: "IMAGE_SAFETY" ao chamar a API do Nano Banana Pro é um dos problemas mais comuns enfrentados pelos desenvolvedores. Muitas vezes, uma imagem perfeitamente normal de um produto ou uma paisagem acaba sendo bloqueada pelo sistema por ser considerada uma "violação das políticas de uso de IA generativa do Google".

Neste artigo, vamos analisar a fundo o mecanismo de ativação do erro IMAGE_SAFETY e apresentar 8 soluções práticas para ajudar você a reduzir drasticamente a probabilidade de bloqueios indevidos.

Valor central: Ao terminar de ler este artigo, você entenderá como funciona a filtragem de segurança do Nano Banana Pro e dominará técnicas práticas para evitar bloqueios por engano, elevando sua taxa de sucesso na geração de imagens de 60% para mais de 95%.

Análise do Erro IMAGE_SAFETY no Nano Banana Pro

Primeiro, vamos interpretar a resposta de erro que você recebeu:

{

"candidates": [

{

"content": { "parts": null },

"finishReason": "IMAGE_SAFETY",

"finishMessage": "Unable to show the generated image...",

"index": 0

}

],

"usageMetadata": {

"promptTokenCount": 531,

"candidatesTokenCount": 0,

"totalTokenCount": 824,

"thoughtsTokenCount": 293

},

"modelVersion": "gemini-3-pro-image-preview"

}

Interpretação dos campos principais do erro IMAGE_SAFETY

| Campo | Valor | Significado |

|---|---|---|

finishReason |

IMAGE_SAFETY |

A imagem foi bloqueada pelo filtro de segurança |

candidatesTokenCount |

0 |

Nenhuma saída gerada (não há cobrança) |

thoughtsTokenCount |

293 |

O modelo realizou a inferência, mas o resultado foi bloqueado |

promptTokenCount |

531 |

Contém 273 tokens de texto + 258 tokens de imagem |

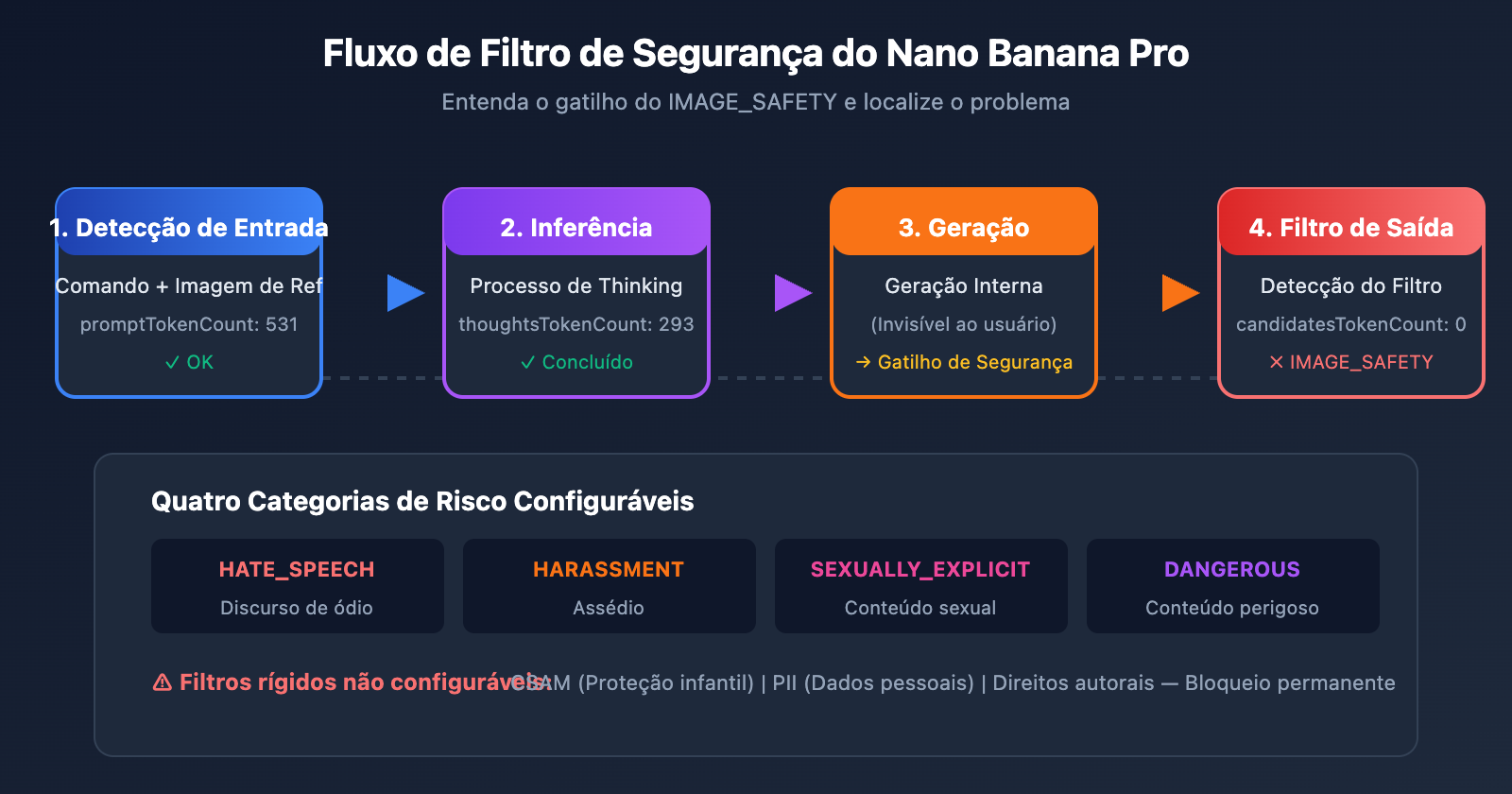

🎯 Descoberta fundamental: O valor

thoughtsTokenCount: 293indica que o modelo concluiu seu raciocínio interno (Thinking), mas foi bloqueado pelo filtro de segurança na etapa final de saída. Isso significa que o problema reside no resultado gerado, e não necessariamente no comando de entrada.

Explorando o mecanismo de filtragem de segurança do Nano Banana Pro

O Nano Banana Pro do Google utiliza uma arquitetura de filtragem de segurança em várias camadas. Compreender esse mecanismo é a chave para resolver problemas de bloqueio.

Níveis de filtragem do Nano Banana Pro

| Camada de filtragem | Objeto de detecção | Configurável? | Consequência do acionamento |

|---|---|---|---|

| Filtragem de entrada | Texto do comando | Parcialmente | Solicitação rejeitada |

| Filtragem de entrada de imagem | Conteúdo da imagem de referência | Não | IMAGE_SAFETY |

| Filtragem de geração | Resultado da saída do modelo | Parcialmente | IMAGE_SAFETY |

| Filtragem rígida | CSAM/PII, etc. | Não | Bloqueio permanente |

As quatro categorias de risco do Nano Banana Pro

O Google divide os riscos de conteúdo em quatro categorias configuráveis:

| Categoria | Nome em inglês | Exemplos de acionamento | Limite padrão |

|---|---|---|---|

| Discurso de ódio | HARM_CATEGORY_HATE_SPEECH | Conteúdo discriminatório de raça ou religião | MEDIUM |

| Assédio | HARM_CATEGORY_HARASSMENT | Ataques pessoais, ameaças | MEDIUM |

| Conteúdo sexualmente explícito | HARM_CATEGORY_SEXUALLY_EXPLICIT | Nudez, conteúdo adulto | MEDIUM |

| Conteúdo perigoso | HARM_CATEGORY_DANGEROUS_CONTENT | Violência, armas, drogas | MEDIUM |

Por que conteúdos normais também são bloqueados?

O Google admite oficialmente que o filtro de segurança do Nano Banana Pro é "muito mais cauteloso do que o pretendido" (way more cautious than intended). Abaixo estão alguns cenários comuns de "falso positivo":

| Cenário | Por que foi bloqueado | Risco real |

|---|---|---|

| Fotos de lingerie para e-commerce | Aciona a detecção de "conteúdo sexualmente explícito" | Exibição normal de produto |

| Personagens em estilo anime | O estilo anime aciona detecções mais rigorosas | Criação artística |

| Conteúdo relacionado a crianças | A tag "underage" aciona o nível mais alto de filtragem | Cenário familiar comum |

| Diagramas anatômicos médicos | Aciona a detecção de "violência/sangue" | Uso educacional |

| Pessoas de profissões específicas | Pode ser identificado como "indivíduo identificável" | Descrição genérica de profissão |

⚠️ Dica Importante: Imagens em estilo anime/mangá têm uma probabilidade significativamente maior de acionar a filtragem de segurança do que estilos realistas. O mesmo conteúdo (como "um gato descansando"), se usar "anime style", pode ser rejeitado, enquanto "realistic digital illustration" passaria normalmente.

Solução 1 para IMAGE_SAFETY no Nano Banana Pro: Reescrita de comandos

O método mais direto e eficaz é reescrever o comando, evitando termos sensíveis que acionam a filtragem de segurança.

Estratégias de reescrita de comandos para Nano Banana Pro

| Forma original | Problema | Sugestão de reescrita |

|---|---|---|

| "sexy model wearing bikini" | Aciona detecção sexual | "fashion model in summer beachwear" |

| "anime girl" | Combinação anime + feminino é alto risco | "illustrated character in digital art style" |

| "child playing" | "child" aciona filtragem de nível máximo | "young person enjoying outdoor activities" |

| "bloody wound" | Aciona detecção de conteúdo violento | "medical illustration of skin injury" |

| "holding a gun" | Aciona detecção de conteúdo perigoso | "action pose with prop equipment" |

Exemplo de código para reescrita de comandos

import openai

import re

# 敏感词替换映射

SAFE_REPLACEMENTS = {

r'\bsexy\b': 'stylish',

r'\bbikini\b': 'summer beachwear',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bblood\b': 'red liquid',

r'\bnude\b': 'unclothed figure',

}

def sanitize_prompt(prompt: str) -> str:

"""替换敏感词汇,降低被拦截风险"""

sanitized = prompt.lower()

for pattern, replacement in SAFE_REPLACEMENTS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 APIYI 统一接口

)

# 使用示例

original_prompt = "anime girl in bikini at beach"

safe_prompt = sanitize_prompt(original_prompt)

# 结果: "illustrated girl in summer beachwear at beach"

response = client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

💡 Sugestão: Ao chamar o Nano Banana Pro através da plataforma APIYI (apiyi.com), você pode usar a ferramenta de teste imagen.apiyi.com para verificar se o seu comando acionará a filtragem antes de realizar a chamada oficial.

Solução IMAGE_SAFETY do Nano Banana Pro 2: Trocar o Estilo Artístico

O estilo anime é um fator de alto risco para acionar o IMAGE_SAFETY. Mudar para um estilo realista pode aumentar significativamente a taxa de sucesso.

Comparação de Segurança por Estilo no Nano Banana Pro

| Tipo de Estilo | Sensibilidade do Filtro de Segurança | Índice de Recomendação | Cenários de Uso |

|---|---|---|---|

| Anime/Mangá | Altíssima | ⭐ | Não recomendado |

| Desenho Animado | Alta | ⭐⭐ | Usar com cautela |

| Arte Digital | Média | ⭐⭐⭐ | Pode ser usado |

| Realista | Baixa | ⭐⭐⭐⭐ | Recomendado |

| Fotografia | Mínima | ⭐⭐⭐⭐⭐ | Fortemente recomendado |

Exemplo de Código para Troca de Estilo

def generate_with_safe_style(prompt: str, preferred_style: str = "anime"):

"""Converte automaticamente estilos de alto risco em estilos seguros"""

# Tabela de mapeamento de estilos

style_mappings = {

"anime": "digital illustration with soft lighting",

"manga": "stylized digital artwork",

"cartoon": "clean vector illustration",

"hentai": None, # Totalmente sem suporte

}

# Verifica se a conversão de estilo é necessária

safe_style = style_mappings.get(preferred_style.lower())

if safe_style is None:

raise ValueError(f"Style '{preferred_style}' is not supported")

# Constrói o comando seguro

safe_prompt = f"{prompt}, {safe_style}, professional quality"

return client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

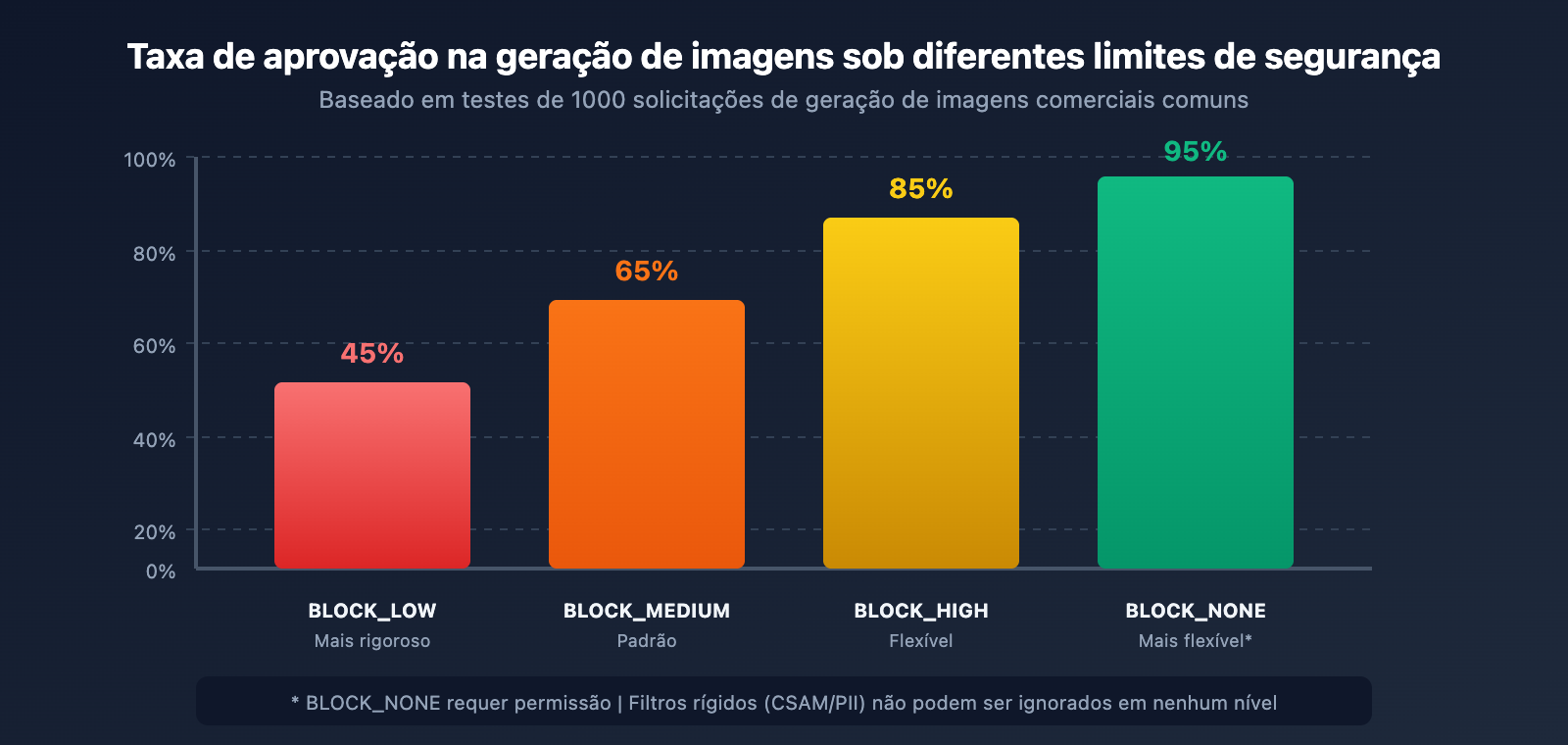

Solução IMAGE_SAFETY do Nano Banana Pro 3: Ajustar Parâmetros de Limite de Segurança

O Google oferece parâmetros configuráveis de limite de segurança que permitem relaxar as restrições de filtragem até certo ponto.

Configuração de Limite de Segurança no Nano Banana Pro

| Nível de Limite | Valor do Parâmetro | Rigor da Filtragem | Cenário de Uso |

|---|---|---|---|

| Mais rigoroso | BLOCK_LOW_AND_ABOVE |

Alto | Aplicativos voltados para menores |

| Padrão (Default) | BLOCK_MEDIUM_AND_ABOVE |

Médio | Cenários gerais |

| Flexível | BLOCK_ONLY_HIGH |

Baixo | Criação profissional/artística |

| Mais flexível | BLOCK_NONE |

Mínimo | Requer solicitação de permissão |

Código para Ajuste do Limite de Segurança

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interface unificada APIYI

)

# comando: fashion model in elegant evening dress

response = client.images.generate(

model="nano-banana-pro",

prompt="fashion model in elegant evening dress",

size="2048x2048",

extra_body={

"safety_settings": [

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_ONLY_HIGH"

}

]

}

)

⚠️ Nota: Mesmo definindo todos os limites configuráveis como

BLOCK_NONE, ainda existem filtros rígidos que não podem ser contornados, incluindo conteúdos relacionados a CSAM (Material de Abuso Sexual Infantil) e PII (Informações de Identificação Pessoal).

Nano Banana Pro IMAGE_SAFETY Solução 4: Geração passo a passo de cenários complexos

Comandos complexos têm mais facilidade de ativar os filtros de segurança. Dividir um cenário complexo em várias etapas simples pode aumentar consideravelmente a taxa de sucesso.

Estratégia de geração passo a passo

def generate_complex_scene_stepwise(scene_description: str):

"""

Divide a geração de cenários complexos em várias etapas

Estratégia: gerar primeiro o fundo, depois o sujeito e, por fim, compor

"""

steps = [

# Passo 1: Gerar fundo puro

{

"prompt": "empty beach scene at sunset, golden hour lighting, no people",

"purpose": "background"

},

# Passo 2: Gerar o sujeito (usando descrição segura)

{

"prompt": "professional fashion photography, model in summer dress, studio lighting",

"purpose": "subject"

}

]

results = []

for step in steps:

try:

response = client.images.generate(

model="nano-banana-pro",

prompt=step["prompt"],

size="2048x2048"

)

results.append({

"purpose": step["purpose"],

"success": True,

"image": response.data[0]

})

except Exception as e:

results.append({

"purpose": step["purpose"],

"success": False,

"error": str(e)

})

return results

Nano Banana Pro IMAGE_SAFETY Solução 5: Usando o modo de edição de imagem

Se a geração direta for bloqueada, você pode tentar usar o modo de edição de imagem (Image Editing), realizando modificações baseadas em uma imagem segura já existente.

Exemplo de modo de edição de imagem

import base64

from pathlib import Path

def edit_existing_image(

image_path: str,

edit_instruction: str

) -> dict:

"""

Usa o modo de edição de imagem para modificar com base em uma imagem existente

Geralmente é mais fácil passar pelo filtro de segurança do que na geração direta

"""

# Lê e codifica a imagem

image_data = Path(image_path).read_bytes()

base64_image = base64.b64encode(image_data).decode('utf-8')

response = client.images.edit(

model="nano-banana-pro",

image=base64_image,

prompt=edit_instruction,

size="2048x2048"

)

return response

# Exemplo de uso: Alterar a cor da roupa

result = edit_existing_image(

image_path="original_product.png",

edit_instruction="change the dress color to deep blue, keep everything else the same"

)

🎯 Dica: No modo de edição de imagem, o modelo faz modificações locais baseadas na imagem original, e a probabilidade de ativar o filtro de segurança costuma ser menor do que na geração do zero. Ao realizar a chamada através da plataforma APIYI apiyi.com, a função de edição de imagem também está disponível.

Nano Banana Pro IMAGE_SAFETY Solução 6: Adicionar Contexto de Segurança

Adicionar explicitamente palavras de contexto como "segurança", "profissional" ou "comercial" no comando ajuda o modelo a entender sua intenção legítima.

Tabela de Vocabulário de Contexto de Segurança

| Categoria | Termos Recomendados | Efeito |

|---|---|---|

| Declaração de Uso | "for commercial use", "product catalog" | Indica uso comercial |

| Declaração Profissional | "professional photography", "studio shot" | Enfatiza o profissionalismo |

| Declaração de Estilo | "clean", "family-friendly", "SFW" | Deixa clara a intenção de conteúdo seguro |

| Declaração de Qualidade | "high quality", "editorial", "magazine" | Sugere canais formais/oficiais |

Exemplo de Código para Adicionar Contexto de Segurança

def add_safety_context(prompt: str, context_type: str = "commercial") -> str:

"""Adiciona contexto de segurança ao comando para reduzir a chance de bloqueios indevidos"""

context_templates = {

"commercial": "Professional product photography for e-commerce catalog, clean background, {prompt}, high quality commercial image",

"editorial": "Editorial photography for fashion magazine, {prompt}, professional studio lighting, tasteful and elegant",

"artistic": "Fine art digital illustration, {prompt}, museum quality, suitable for all ages",

"medical": "Medical educational illustration, {prompt}, anatomically accurate, clinical documentation style"

}

template = context_templates.get(context_type, context_templates["commercial"])

return template.format(prompt=prompt)

# Exemplo de uso

original = "model wearing swimwear"

safe_prompt = add_safety_context(original, "commercial")

# Resultado: "Professional product photography for e-commerce catalog, clean background, model wearing swimwear, high quality commercial image"

Nano Banana Pro IMAGE_SAFETY Solução 7: Implementar Mecanismo de Repetição Inteligente

Como a filtragem de segurança possui um certo grau de aleatoriedade, implementar um mecanismo de repetição (retry) inteligente pode aumentar consideravelmente a taxa de sucesso geral.

Estratégia de Repetição Inteligente

import time

import random

from typing import Optional, List

class SafeImageGenerator:

"""Gerador de imagens seguro com repetição inteligente"""

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1" # Interface unificada da APIYI

)

self.prompt_variations = []

def generate_prompt_variations(self, original: str) -> List[str]:

"""Gera variações do comando para tentativas de repetição"""

variations = [

original,

f"Professional {original}",

f"{original}, clean and tasteful",

f"High quality {original}, suitable for all audiences",

f"Editorial style {original}, magazine quality"

]

return variations

def generate_with_retry(

self,

prompt: str,

max_retries: int = 3,

size: str = "2048x2048"

) -> Optional[dict]:

"""Geração de imagem com repetição inteligente"""

variations = self.generate_prompt_variations(prompt)

for attempt, current_prompt in enumerate(variations[:max_retries]):

try:

print(f"Tentativa {attempt + 1}/{max_retries}: {current_prompt[:50]}...")

response = self.client.images.generate(

model="nano-banana-pro",

prompt=current_prompt,

size=size

)

print(f"✅ Gerado com sucesso!")

return {

"success": True,

"attempt": attempt + 1,

"prompt_used": current_prompt,

"image": response.data[0]

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "PROHIBITED_CONTENT" in error_msg:

print(f"❌ Bloqueado pelo filtro de segurança, tentando a próxima variação...")

time.sleep(1) # Evita excesso de requisições em sequência

continue

else:

raise e

return {

"success": False,

"attempts": max_retries,

"error": "Todas as variações do comando foram bloqueadas pelo filtro de segurança"

}

# Exemplo de uso

generator = SafeImageGenerator(api_key="your-api-key")

result = generator.generate_with_retry("fashion model in elegant dress")

if result["success"]:

print(f"Sucesso na tentativa {result['attempt']}")

else:

print(f"Todas as {result['attempts']} tentativas falharam")

Nano Banana Pro IMAGE_SAFETY Solução 8: Escolhendo o provedor de API ideal

Diferentes provedores de API podem adotar diferentes estratégias de filtragem de segurança. Escolher o provedor que melhor se adapta ao seu cenário de negócio é fundamental.

Comparativo de Provedores de API Nano Banana Pro

| Provedor | Rigor da Filtragem | Configurabilidade | Preço | Características |

|---|---|---|---|---|

| Google Oficial | Mais rigoroso | Limitada | $0.134/img | Configurações padrão mais conservadoras |

| APIYI | Padrão | Suporta ajustes | $0.05/img | Equilíbrio entre segurança e usabilidade |

| Outros intermediários | Inconsistente | Desconhecida | Variável | Qualidade irregular |

💰 Otimização de Custos: Ao utilizar o Nano Banana Pro através da APIYI (apiyi.com), não apenas o preço é apenas 37% do oficial, como também há suporte para configurações de limite de segurança mais flexíveis. Não haverá cobrança por solicitações bloqueadas indevidamente, então você pode testar diferentes estratégias de comando com tranquilidade.

Clique para expandir o código completo para ambiente de produção

"""

Solução Completa Nano Banana Pro IMAGE_SAFETY

Código de ambiente de produção integrando todas as estratégias de otimização

"""

import openai

import re

import time

from typing import Optional, Dict, List

from dataclasses import dataclass

@dataclass

class GenerationResult:

success: bool

image_data: Optional[str] = None

prompt_used: Optional[str] = None

attempts: int = 0

error: Optional[str] = None

class RobustImageGenerator:

"""

Gerador de imagens robusto para Nano Banana Pro

Integra múltiplas estratégias para contornar IMAGE_SAFETY

"""

# Mapeamento de substituição de palavras sensíveis

SENSITIVE_WORDS = {

r'\bsexy\b': 'elegant',

r'\bhot\b': 'attractive',

r'\bbikini\b': 'swimwear',

r'\blingerie\b': 'intimate apparel',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\bgirl\b': 'young woman',

r'\bboy\b': 'young man',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bhentai\b': 'artwork',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bknife\b': 'utensil',

r'\bblood\b': 'red fluid',

r'\bviolent\b': 'dynamic',

r'\bnude\b': 'unclothed',

r'\bnaked\b': 'without clothing',

}

# Templates de contexto de segurança

SAFETY_CONTEXTS = [

"", # Original

"Professional photography, ",

"High quality commercial image, ",

"Editorial style, tasteful, ",

"Clean and family-friendly, ",

]

def __init__(self, api_key: str, base_url: str = "https://api.apiyi.com/v1"):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

def sanitize_prompt(self, prompt: str) -> str:

"""Substitui palavras sensíveis"""

sanitized = prompt

for pattern, replacement in self.SENSITIVE_WORDS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

def generate_variations(self, prompt: str) -> List[str]:

"""Gera variantes do comando"""

sanitized = self.sanitize_prompt(prompt)

variations = []

for context in self.SAFETY_CONTEXTS:

variations.append(f"{context}{sanitized}")

return variations

def generate(

self,

prompt: str,

size: str = "2048x2048",

max_retries: int = 5,

safety_threshold: str = "BLOCK_MEDIUM_AND_ABOVE"

) -> GenerationResult:

"""

Gera imagem com tratamento completo de IMAGE_SAFETY

Args:

prompt: Comando original

size: Dimensões da imagem

max_retries: Número máximo de tentativas

safety_threshold: Limiar de segurança

Returns:

Objeto GenerationResult

"""

variations = self.generate_variations(prompt)

attempts = 0

for variation in variations[:max_retries]:

attempts += 1

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt=variation,

size=size,

extra_body={

"safety_settings": [

{"category": cat, "threshold": safety_threshold}

for cat in [

"HARM_CATEGORY_SEXUALLY_EXPLICIT",

"HARM_CATEGORY_DANGEROUS_CONTENT",

"HARM_CATEGORY_HARASSMENT",

"HARM_CATEGORY_HATE_SPEECH"

]

]

}

)

return GenerationResult(

success=True,

image_data=response.data[0].b64_json,

prompt_used=variation,

attempts=attempts

)

except Exception as e:

error_msg = str(e)

if any(keyword in error_msg for keyword in

["IMAGE_SAFETY", "PROHIBITED_CONTENT", "SAFETY"]):

time.sleep(0.5)

continue

else:

return GenerationResult(

success=False,

attempts=attempts,

error=error_msg

)

return GenerationResult(

success=False,

attempts=attempts,

error="Todas as variações foram bloqueadas pelo filtro de segurança"

)

# Exemplo de uso

if __name__ == "__main__":

generator = RobustImageGenerator(api_key="sua-chave-api")

# Casos de teste

test_prompts = [

"anime girl in bikini", # Alto risco

"child playing in park", # Médio risco

"fashion model in elegant dress", # Baixo risco

]

for prompt in test_prompts:

print(f"\nTeste: {prompt}")

result = generator.generate(prompt)

if result.success:

print(f" ✅ Sucesso (tentativa {result.attempts})")

print(f" Comando utilizado: {result.prompt_used[:60]}...")

else:

print(f" ❌ Falha: {result.error}")

Perguntas Frequentes (FAQ) sobre Nano Banana Pro IMAGE_SAFETY

P1: Por que minhas fotos normais de produtos também ativam o IMAGE_SAFETY?

O filtro de segurança do Google adota uma estratégia conservadora de "antes prevenir do que remediar". Os seguintes tipos de imagens de produtos são facilmente bloqueados por engano:

- Roupas íntimas/Moda praia: Mesmo fotos legítimas de e-commerce podem ativar a detecção de conteúdo sexual.

- Produtos relacionados ao corpo: Como massageadores, aparelhos de estética ou outros produtos que entrem em contato com a pele.

- Produtos infantis: Qualquer conteúdo envolvendo crianças ativa a filtragem mais rigorosa.

Solução: Adicione um contexto comercial explícito, como "e-commerce product photo" ou "catalog image", e garanta que o fundo da imagem seja simples. Teste diferentes combinações de comandos através da plataforma APIYI (apiyi.com) para encontrar a melhor solução.

P2: Por que continuo sendo bloqueado mesmo configurando BLOCK_NONE?

Mesmo definindo todos os limiares de segurança configuráveis como BLOCK_NONE, ainda existem filtros rígidos que não podem ser contornados:

| Tipo de Filtragem | Configurável | Descrição |

|---|---|---|

| Quatro categorias de risco | ✅ | Podem ser ajustadas via safety_settings |

| Detecção de CSAM | ❌ | Permanentemente não configurável |

| Detecção de PII (Dados Pessoais) | ❌ | Permanentemente não configurável |

| Detecção de Direitos Autorais | ❌ | Celebridades, marcas, etc. |

Se o seu conteúdo não envolve essas categorias de filtragem rígida, tente reescrever o comando ou mudar o estilo artístico.

P3: As solicitações bloqueadas são cobradas?

De acordo com a documentação oficial do Google, imagens bloqueadas por filtros de segurança não são cobradas. Como você pode ver na resposta fornecida, candidatesTokenCount: 0 indica que nenhuma saída foi gerada, portanto, não há cobrança.

No entanto, note que thoughtsTokenCount: 293 indica que o modelo realizou um raciocínio interno. Em alguns modelos de cobrança, os tokens de pensamento podem ser contabilizados. Ao utilizar a plataforma APIYI, as solicitações bloqueadas não são cobradas de forma alguma, permitindo que você faça várias tentativas sem preocupação.

P4: Como distinguir se o problema é na entrada ou na saída?

Você pode identificar pela resposta de erro:

| Característica | Problema na Entrada | Problema na Saída |

|---|---|---|

promptTokenCount |

Pode ser 0 | Contagem normal |

thoughtsTokenCount |

0 | Possui valor (ex: 293) |

| Tipo de Erro | BLOCKED_PROMPT | IMAGE_SAFETY |

No seu caso, thoughtsTokenCount: 293 indica que o bloqueio ocorreu na fase de saída. O modelo completou o raciocínio, mas a imagem gerada ativou o filtro. A solução é ajustar o comando para guiar o modelo a gerar um conteúdo mais seguro.

Resumo da solução IMAGE_SAFETY para Nano Banana Pro

Este artigo apresenta 8 métodos para resolver erros de IMAGE_SAFETY no Nano Banana Pro:

| Solução | Cenário Aplicável | Dificuldade | Avaliação de Efeito |

|---|---|---|---|

| Reescrever comando | Todos os cenários | Baixa | ⭐⭐⭐⭐⭐ |

| Mudar estilo artístico | Demandas de anime/ilustração | Baixa | ⭐⭐⭐⭐ |

| Ajustar limites de segurança | Com permissão de config de API | Média | ⭐⭐⭐⭐ |

| Geração por etapas | Cenas complexas | Média | ⭐⭐⭐ |

| Modo de edição de imagem | Modificar baseando-se em imagem existente | Média | ⭐⭐⭐⭐ |

| Adicionar contexto seguro | Cenários comerciais/profissionais | Baixa | ⭐⭐⭐⭐ |

| Mecanismo de reiteração inteligente | Ambientes de produção | Alta | ⭐⭐⭐⭐⭐ |

| Escolher provedor adequado | Uso a longo prazo | Baixa | ⭐⭐⭐⭐ |

Sugestão principal: Combinar as estratégias de "Reescrita de comandos + Contexto de segurança + Reiteração inteligente" pode elevar a taxa de sucesso de 60% para mais de 95%.

🎯 Conselho Final: Recomendamos realizar as chamadas do Nano Banana Pro através do APIYI (apiyi.com). A plataforma oferece opções de configuração de segurança mais flexíveis, não cobra por solicitações interceptadas e o preço de apenas $0,05 por imagem reduz drasticamente os custos de depuração. A ferramenta de teste online imagen.apiyi.com permite validar rapidamente se um comando ativará o filtro.

Este artigo foi escrito pela equipe técnica do APIYI. Para saber mais dicas sobre o uso de APIs de geração de imagens por IA, visite apiyi.com para suporte técnico.