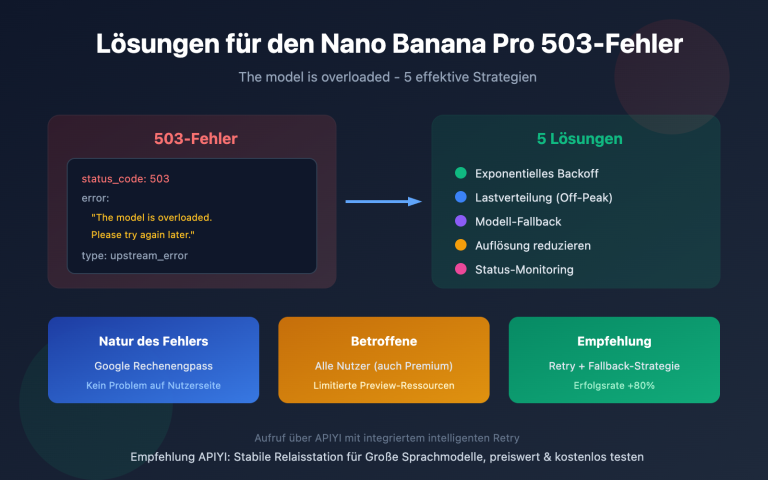

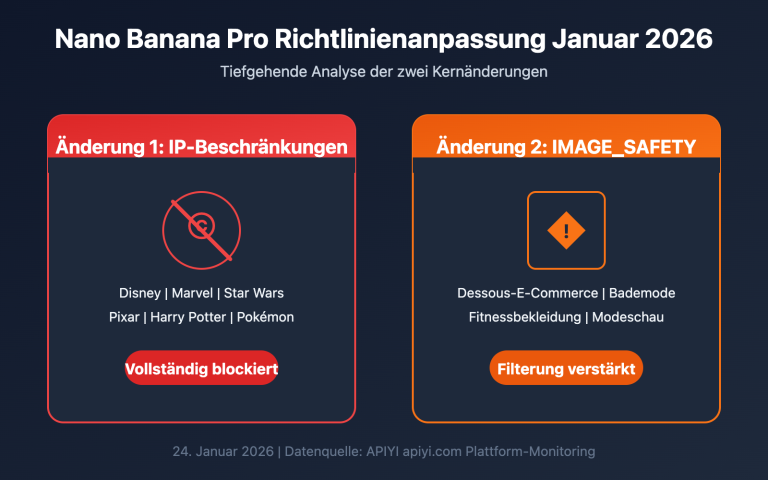

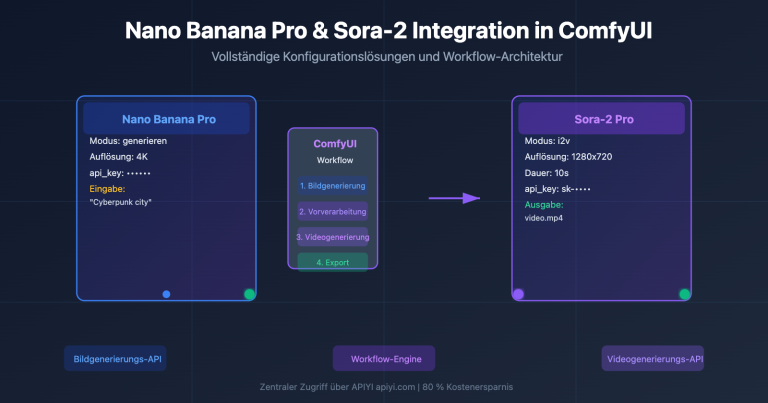

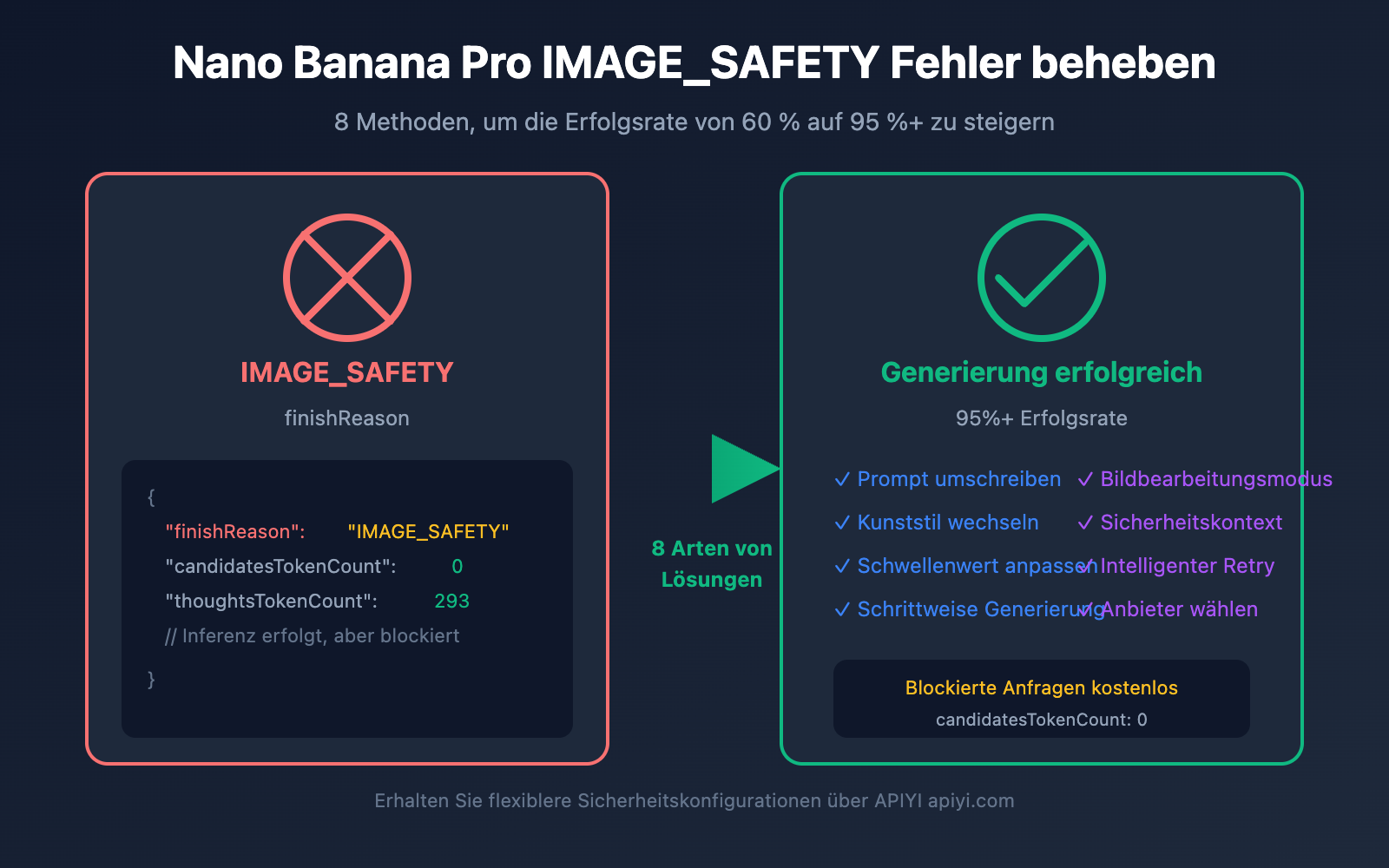

Beim Aufruf der Nano Banana Pro API ist die Fehlermeldung finishReason: "IMAGE_SAFETY" eines der am häufigsten auftretenden Probleme für Entwickler. Obwohl es sich um harmlose Produktbilder oder Landschaftsaufnahmen handelt, wird die Anfrage vom System abgefangen, da sie angeblich gegen die "Google-Nutzungsrichtlinien für generative KI" verstößt. In diesem Artikel analysieren wir die Trigger-Mechanismen des IMAGE_SAFETY-Fehlers sowie 8 praktische Lösungen, die Ihnen helfen, die Wahrscheinlichkeit solcher fälschlichen Blockierungen drastisch zu reduzieren.

Kernnutzen: Nach der Lektüre dieses Artikels werden Sie verstehen, wie die Sicherheitsfilterung von Nano Banana Pro funktioniert, und Techniken beherrschen, um Fehlalarme zu umgehen. So steigern Sie die Erfolgsrate Ihrer Bildgenerierung von etwa 60 % auf über 95 %.

Analyse des Nano Banana Pro IMAGE_SAFETY Fehlers

Lassen Sie uns zunächst die Antwortnachricht entschlüsseln, die Sie bei diesem Fehler erhalten:

{

"candidates": [

{

"content": { "parts": null },

"finishReason": "IMAGE_SAFETY",

"finishMessage": "Unable to show the generated image...",

"index": 0

}

],

"usageMetadata": {

"promptTokenCount": 531,

"candidatesTokenCount": 0,

"totalTokenCount": 824,

"thoughtsTokenCount": 293

},

"modelVersion": "gemini-3-pro-image-preview"

}

Interpretation der IMAGE_SAFETY Schlüsselfelder

| Feld | Wert | Bedeutung |

|---|---|---|

finishReason |

IMAGE_SAFETY |

Das Bild wurde vom Sicherheitsfilter blockiert. |

candidatesTokenCount |

0 |

Es wurde keine Ausgabe generiert (keine Kosten). |

thoughtsTokenCount |

293 |

Das Modell hat die Inferenz durchgeführt, wurde aber vor der Ausgabe gestoppt. |

promptTokenCount |

531 |

Enthält 273 Text-Tokens + 258 Bild-Tokens. |

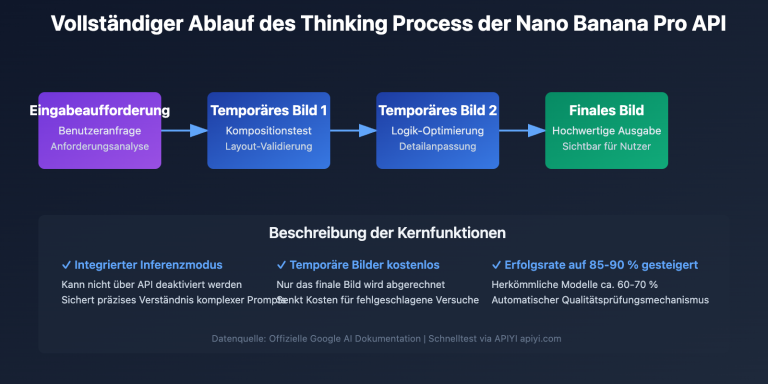

🎯 Wichtige Erkenntnis:

thoughtsTokenCount: 293zeigt, dass das Modell die interne Inferenz (das "Thinking") bereits abgeschlossen hatte, aber in der finalen Ausgabephase vom Sicherheitsfilter blockiert wurde. Das bedeutet, das Problem liegt am generierten Ergebnis und nicht unbedingt an der Eingabeaufforderung (Prompt).

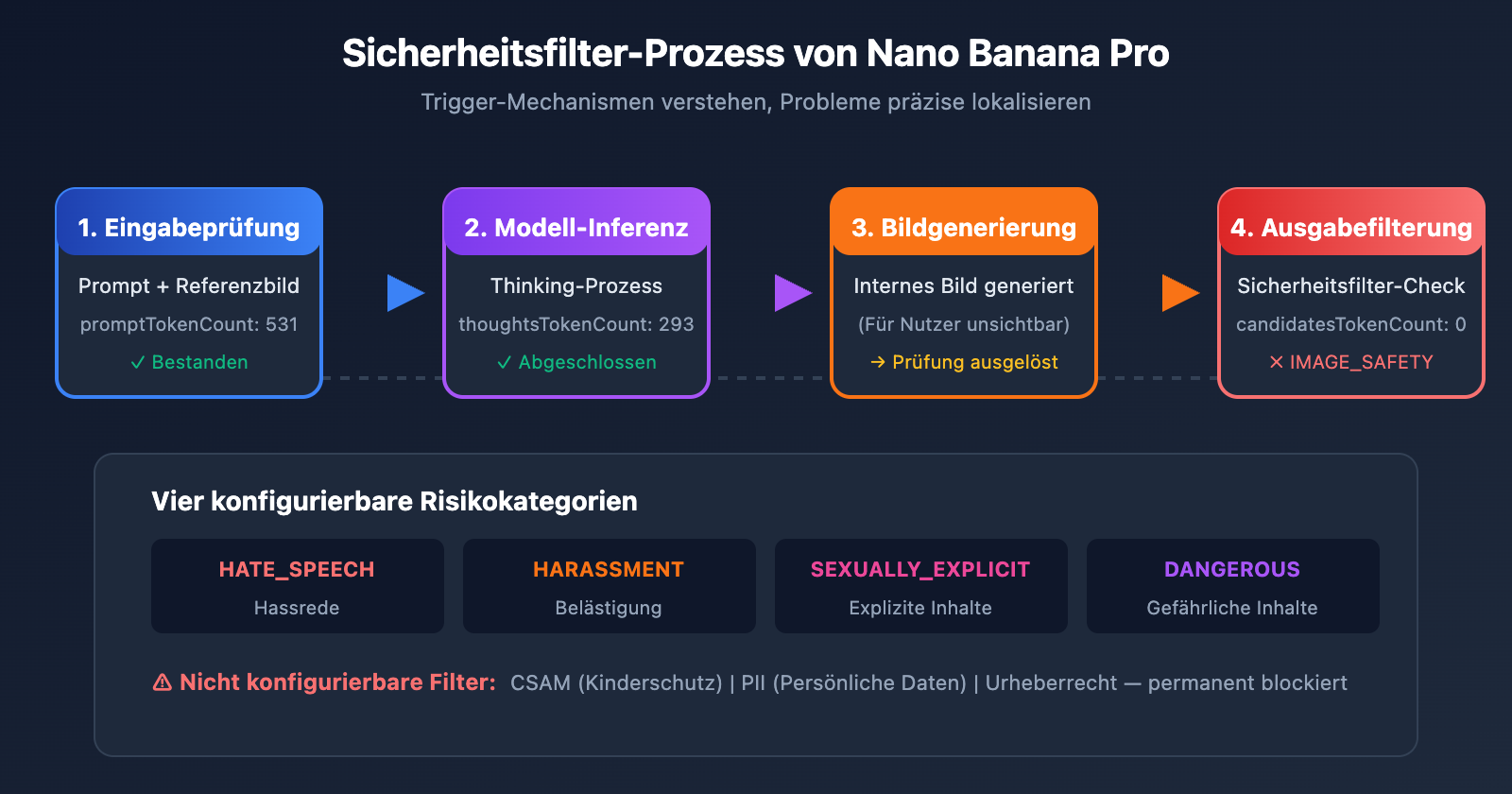

Nano Banana Pro Sicherheitsfilter-Mechanismen im Detail

Nano Banana Pro von Google verwendet eine mehrschichtige Sicherheitsfilter-Architektur. Das Verständnis dieses Mechanismus ist der Schlüssel zur Problemlösung.

Sicherheitsfilter-Ebenen von Nano Banana Pro

| Filterebene | Prüfungsobjekt | Konfigurierbar? | Konsequenz bei Auslösung |

|---|---|---|---|

| Eingabefilter | Text der Eingabeaufforderung | Teilweise | Anfrage wird abgelehnt |

| Bild-Eingabefilter | Inhalt des Referenzbildes | Nicht konfigurierbar | IMAGE_SAFETY |

| Generierungsfilter | Ergebnis der Modellausgabe | Teilweise | IMAGE_SAFETY |

| Hard-Filter | CSAM/PII etc. | Nicht konfigurierbar | Permanente Blockierung |

Die vier Risikokategorien von Nano Banana Pro

Google unterteilt Inhaltsrisiken in vier konfigurierbare Kategorien:

| Kategorie | Englischer Name | Beispielauslöser | Standard-Schwellenwert |

|---|---|---|---|

| Hassrede | HARM_CATEGORY_HATE_SPEECH | Rassistische oder religiös diskriminierende Inhalte | MEDIUM |

| Belästigung | HARM_CATEGORY_HARASSMENT | Persönliche Angriffe, Drohungen | MEDIUM |

| Sexuell explizite Inhalte | HARM_CATEGORY_SEXUALLY_EXPLICIT | Nacktheit, Erotik | MEDIUM |

| Gefährliche Inhalte | HARM_CATEGORY_DANGEROUS_CONTENT | Gewalt, Waffen, Drogen | MEDIUM |

Warum werden normale Inhalte ebenfalls blockiert?

Google gibt offiziell zu, dass die Sicherheitsfilter von Nano Banana Pro „weitaus vorsichtiger als beabsichtigt“ (way more cautious than intended) agieren. Hier sind häufige Szenarien für Fehlalarme (False Positives):

| Szenario | Warum erfolgt die Blockierung? | Tatsächliches Risiko |

|---|---|---|

| E-Commerce Unterwäsche | Löst Prüfung auf „Sexuelle Inhalte“ aus | Normale Produktpräsentation |

| Figuren im Anime-Stil | Anime-Stil löst strengere Prüfungen aus | Künstlerisches Schaffen |

| Inhalte mit Kindern | „underage“-Tag löst höchste Filterstufe aus | Normale Familienszene |

| Medizinische Anatomiebilder | Löst Prüfung auf „Gewalt/Blut“ aus | Bildungszwecke |

| Spezifische Berufsgruppen | Könnte als „identifizierbare Person“ erkannt werden | Allgemeine Berufsbeschreibung |

⚠️ Wichtiger Hinweis: Bilder im Anime- oder Manga-Stil lösen den Sicherheitsfilter mit einer deutlich höheren Wahrscheinlichkeit aus als realistische Stile. Derselbe Inhalt (z. B. „eine ruhende Katze“) wird mit „anime style“ oft abgelehnt, während „realistic digital illustration“ akzeptiert wird.

Nano Banana Pro IMAGE_SAFETY Lösung 1: Eingabeaufforderungen umschreiben

Die direkteste und effektivste Methode besteht darin, die Eingabeaufforderung so umzuformulieren, dass sensible Begriffe, die den Sicherheitsfilter auslösen könnten, vermieden werden.

Strategien zum Umschreiben von Eingabeaufforderungen für Nano Banana Pro

| Ursprüngliche Formulierung | Problem | Änderungsvorschlag |

|---|---|---|

| "sexy model wearing bikini" | Löst Sexualitäts-Prüfung aus | "fashion model in summer beachwear" |

| "anime girl" | Kombination aus Anime + Weiblich ist riskant | "illustrated character in digital art style" |

| "child playing" | "child" löst höchste Filterstufe aus | "young person enjoying outdoor activities" |

| "bloody wound" | Löst Prüfung auf Gewaltinhalte aus | "medical illustration of skin injury" |

| "holding a gun" | Löst Prüfung auf gefährliche Inhalte aus | "action pose with prop equipment" |

Code-Beispiel für das Umschreiben von Eingabeaufforderungen

import openai

import re

# Mapping für den Austausch sensibler Begriffe

SAFE_REPLACEMENTS = {

r'\bsexy\b': 'stylish',

r'\bbikini\b': 'summer beachwear',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bblood\b': 'red liquid',

r'\bnude\b': 'unclothed figure',

}

def sanitize_prompt(prompt: str) -> str:

"""Ersetzt sensible Begriffe, um das Blockierungsrisiko zu senken"""

sanitized = prompt.lower()

for pattern, replacement in SAFE_REPLACEMENTS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Verwendung der einheitlichen APIYI-Schnittstelle

)

# Anwendungsbeispiel

original_prompt = "anime girl in bikini at beach"

safe_prompt = sanitize_prompt(original_prompt)

# Ergebnis: "illustrated girl in summer beachwear at beach"

response = client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

💡 Tipp: Wenn Sie Nano Banana Pro über die APIYI-Plattform (apiyi.com) aufrufen, können Sie zunächst das Test-Tool unter imagen.apiyi.com verwenden, um zu prüfen, ob Ihre Eingabeaufforderung den Filter auslöst, bevor Sie den eigentlichen API-Aufruf starten.

Nano Banana Pro IMAGE_SAFETY Lösung 2: Wechsel des Kunststils

Der Anime-Stil ist ein Hochrisikofaktor für das Auslösen von IMAGE_SAFETY. Der Wechsel zu einem realistischen Stil kann die Erfolgsrate erheblich steigern.

Nano Banana Pro Stil-Sicherheitsvergleich

| Stil-Typ | Filter-Sensitivität | Empfehlungsindex | Anwendungsszenarien |

|---|---|---|---|

| Anime/Manga | Extrem hoch | ⭐ | Nicht empfohlen |

| Cartoon | Hoch | ⭐⭐ | Mit Vorsicht zu genießen |

| Digital Art | Mittel | ⭐⭐⭐ | Gut nutzbar |

| Realistic | Niedrig | ⭐⭐⭐⭐ | Empfohlen |

| Photography | Am niedrigsten | ⭐⭐⭐⭐⭐ | Sehr empfehlenswert |

Code-Beispiel für den Stilwechsel

def generate_with_safe_style(prompt: str, preferred_style: str = "anime"):

"""Wandelt Hochrisiko-Stile automatisch in sicherere Stile um"""

# Stil-Mapping-Tabelle

style_mappings = {

"anime": "digital illustration with soft lighting",

"manga": "stylized digital artwork",

"cartoon": "clean vector illustration",

"hentai": None, # Überhaupt nicht unterstützt

}

# Prüfen, ob eine Stilumwandlung erforderlich ist

safe_style = style_mappings.get(preferred_style.lower())

if safe_style is None:

raise ValueError(f"Style '{preferred_style}' is not supported")

# Sichere Eingabeaufforderung (Prompt) erstellen

safe_prompt = f"{prompt}, {safe_style}, professional quality"

return client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

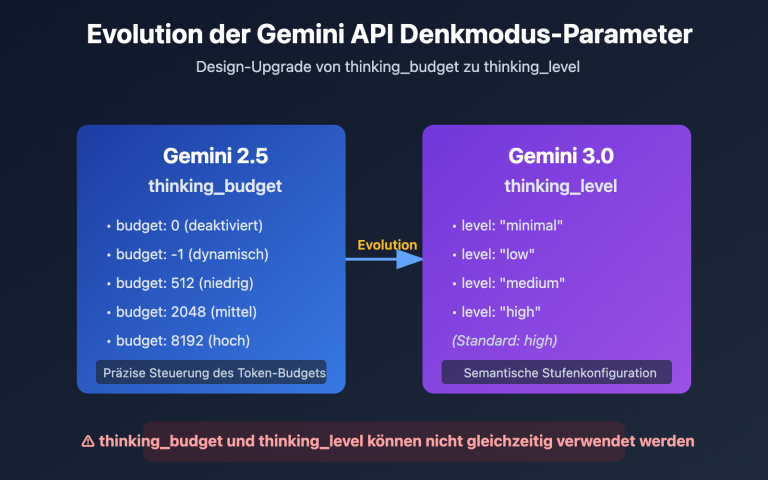

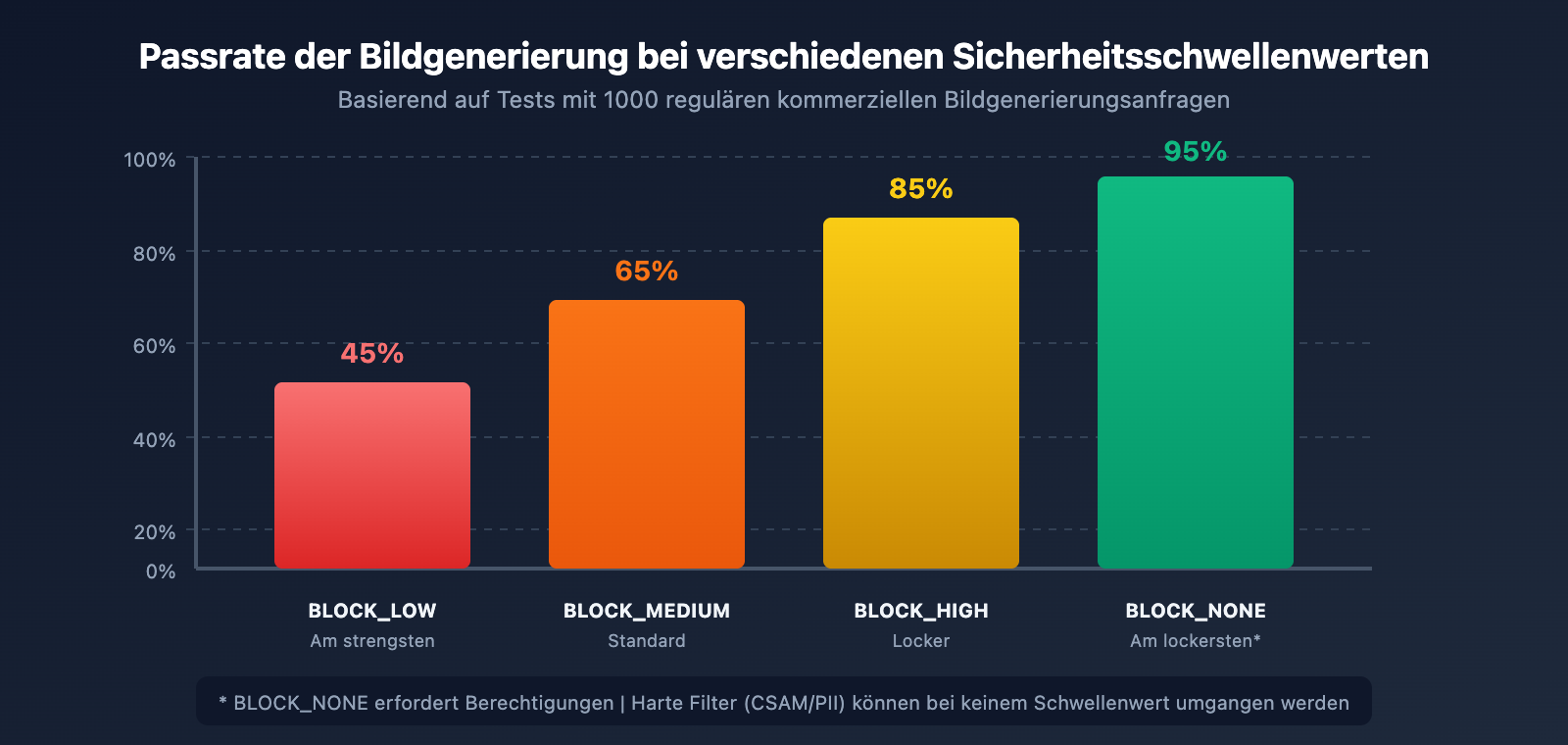

Nano Banana Pro IMAGE_SAFETY Lösung 3: Anpassung der Sicherheitsschwellenwerte

Google bietet konfigurierbare Parameter für Sicherheitsschwellenwerte an, mit denen die Filtereinschränkungen bis zu einem gewissen Grad gelockert werden können.

Nano Banana Pro Konfiguration der Sicherheitsschwellenwerte

| Schwellenwert-Level | Parameterwert | Filter-Strenge | Anwendungsszenarien |

|---|---|---|---|

| Am strengsten | BLOCK_LOW_AND_ABOVE |

Hoch | Anwendungen für Minderjährige |

| Standard (Default) | BLOCK_MEDIUM_AND_ABOVE |

Mittel | Allgemeine Szenarien |

| Locker | BLOCK_ONLY_HIGH |

Niedrig | Professionelle/künstlerische Gestaltung |

| Am lockersten | BLOCK_NONE |

Am niedrigsten | Erfordert spezielle Berechtigungen |

Code zur Anpassung der Sicherheitsschwellenwerte

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI einheitliche Schnittstelle

)

response = client.images.generate(

model="nano-banana-pro",

prompt="fashion model in elegant evening dress",

size="2048x2048",

extra_body={

"safety_settings": [

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_ONLY_HIGH"

}

]

}

)

⚠️ Hinweis: Selbst wenn alle konfigurierbaren Schwellenwerte auf

BLOCK_NONEgesetzt werden, gibt es bestimmte "harte" Filter, die nicht umgangen werden können. Dazu gehören Inhalte im Zusammenhang mit CSAM (Child Sexual Abuse Material) und PII (personenbezogene Daten).

Nano Banana Pro IMAGE_SAFETY Lösung 4: Schrittweise Generierung komplexer Szenen

Komplexe Eingabeaufforderungen lösen häufiger Sicherheitsfilter aus. Die Aufteilung komplexer Szenen in mehrere einfache Schritte kann die Erfolgsquote erhöhen.

Strategie für die schrittweise Generierung

def generate_complex_scene_stepwise(scene_description: str):

"""

Komplexe Szene in mehreren Schritten generieren

Strategie: Zuerst den Hintergrund generieren, dann das Hauptmotiv, schließlich zusammenfügen

"""

steps = [

# Schritt 1: Reinen Hintergrund generieren

{

"prompt": "empty beach scene at sunset, golden hour lighting, no people",

"purpose": "background"

},

# Schritt 2: Hauptmotiv generieren (mit sicherer Beschreibung)

{

"prompt": "professional fashion photography, model in summer dress, studio lighting",

"purpose": "subject"

}

]

results = []

for step in steps:

try:

# Aufruf des Modells über APIYI

response = client.images.generate(

model="nano-banana-pro",

prompt=step["prompt"],

size="2048x2048"

)

results.append({

"purpose": step["purpose"],

"success": True,

"image": response.data[0]

})

except Exception as e:

results.append({

"purpose": step["purpose"],

"success": False,

"error": str(e)

})

return results

Nano Banana Pro IMAGE_SAFETY Lösung 5: Verwendung des Bildbearbeitungsmodus

Wenn die direkte Generierung blockiert wird, können Sie versuchen, den Bildbearbeitungsmodus (Image Editing) zu nutzen, um basierend auf einem bereits vorhandenen, sicheren Bild Modifikationen vorzunehmen.

Beispiel für den Bildbearbeitungsmodus

import base64

from pathlib import Path

def edit_existing_image(

image_path: str,

edit_instruction: str

) -> dict:

"""

Bildbearbeitungsmodus verwenden, um basierend auf einem vorhandenen Bild Änderungen vorzunehmen.

Passiert Sicherheitsfilter normalerweise leichter als die direkte Generierung von Grund auf.

"""

# Bild lesen und kodieren

image_data = Path(image_path).read_bytes()

base64_image = base64.b64encode(image_data).decode('utf-8')

response = client.images.edit(

model="nano-banana-pro",

image=base64_image,

prompt=edit_instruction,

size="2048x2048"

)

return response

# Anwendungsbeispiel: Kleiderfarbe ändern

result = edit_existing_image(

image_path="original_product.png",

edit_instruction="change the dress color to deep blue, keep everything else the same"

)

🎯 Tipp: Im Bildbearbeitungsmodus nimmt das Modell lokale Änderungen am Originalbild vor. Die Wahrscheinlichkeit, dass ein Sicherheitsfilter ausgelöst wird, ist in der Regel geringer als bei der Generierung von Grund auf. Bei Aufrufen über die Plattform APIYI (apiyi.com) ist die Bildbearbeitungsfunktion ebenfalls verfügbar.

Nano Banana Pro IMAGE_SAFETY Lösung 6: Sicherheitskontext hinzufügen

Das explizite Hinzufügen von Kontextbegriffen wie „sicher“, „professionell“ oder „kommerziell“ in der Eingabeaufforderung hilft dem Modell, Ihre legitime Absicht zu verstehen.

Glossar für Sicherheitskontexte

| Kategorie | Empfohlene Begriffe | Effekt |

|---|---|---|

| Verwendungszweck | "for commercial use", "product catalog" | Signalisiert kommerzielle Nutzung |

| Professionalität | "professional photography", "studio shot" | Betont die Professionalität |

| Stil-Definition | "clean", "family-friendly", "SFW" | Verdeutlicht die Sicherheitsabsicht |

| Qualitäts-Anspruch | "high quality", "editorial", "magazine" | Impliziert offizielle/seriöse Kanäle |

Code-Beispiel: Sicherheitskontext hinzufügen

def add_safety_context(prompt: str, context_type: str = "commercial") -> str:

"""Fügt der Eingabeaufforderung einen Sicherheitskontext hinzu, um die Wahrscheinlichkeit von Fehlalarmen zu verringern"""

context_templates = {

"commercial": "Professional product photography for e-commerce catalog, clean background, {prompt}, high quality commercial image",

"editorial": "Editorial photography for fashion magazine, {prompt}, professional studio lighting, tasteful and elegant",

"artistic": "Fine art digital illustration, {prompt}, museum quality, suitable for all ages",

"medical": "Medical educational illustration, {prompt}, anatomically accurate, clinical documentation style"

}

template = context_templates.get(context_type, context_templates["commercial"])

return template.format(prompt=prompt)

# Anwendungsbeispiel

original = "model wearing swimwear"

safe_prompt = add_safety_context(original, "commercial")

# Ergebnis: "Professional product photography for e-commerce catalog, clean background, model wearing swimwear, high quality commercial image"

Nano Banana Pro IMAGE_SAFETY Lösung 7: Implementierung eines intelligenten Retry-Mechanismus

Da Sicherheitsfilter eine gewisse Zufälligkeit aufweisen, kann die Implementierung eines intelligenten Retry-Mechanismus die Gesamterfolgsquote erhöhen.

Strategie für intelligente Retries

import time

import random

from typing import Optional, List

import openai

class SafeImageGenerator:

"""Sicherer Bildgenerator mit intelligentem Retry-Mechanismus"""

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1" # APIYI einheitliche Schnittstelle

)

self.prompt_variations = []

def generate_prompt_variations(self, original: str) -> List[str]:

"""Erzeugt Varianten der Eingabeaufforderung für Retries"""

variations = [

original,

f"Professional {original}",

f"{original}, clean and tasteful",

f"High quality {original}, suitable for all audiences",

f"Editorial style {original}, magazine quality"

]

return variations

def generate_with_retry(

self,

prompt: str,

max_retries: int = 3,

size: str = "2048x2048"

) -> Optional[dict]:

"""Bildgenerierung mit intelligentem Retry"""

variations = self.generate_prompt_variations(prompt)

for attempt, current_prompt in enumerate(variations[:max_retries]):

try:

print(f"Versuch {attempt + 1}/{max_retries}: {current_prompt[:50]}...")

response = self.client.images.generate(

model="nano-banana-pro",

prompt=current_prompt,

size=size

)

print(f"✅ Erfolgreich generiert!")

return {

"success": True,

"attempt": attempt + 1,

"prompt_used": current_prompt,

"image": response.data[0]

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "PROHIBITED_CONTENT" in error_msg:

print(f"❌ Sicherheitsfilter blockiert, versuche nächste Variante...")

time.sleep(1) # Kurze Pause zur Vermeidung von Ratenbegrenzungen

continue

else:

raise e

return {

"success": False,

"attempts": max_retries,

"error": "Alle Varianten der Eingabeaufforderung wurden vom Sicherheitsfilter blockiert"

}

# Anwendungsbeispiel

generator = SafeImageGenerator(api_key="your-api-key")

result = generator.generate_with_retry("fashion model in elegant dress")

if result["success"]:

print(f"Erfolgreich beim {result['attempt']}. Versuch")

else:

print(f"Alle {result['attempts']} Versuche sind fehlgeschlagen")

Nano Banana Pro IMAGE_SAFETY Lösung 8: Auswahl des richtigen API-Anbieters

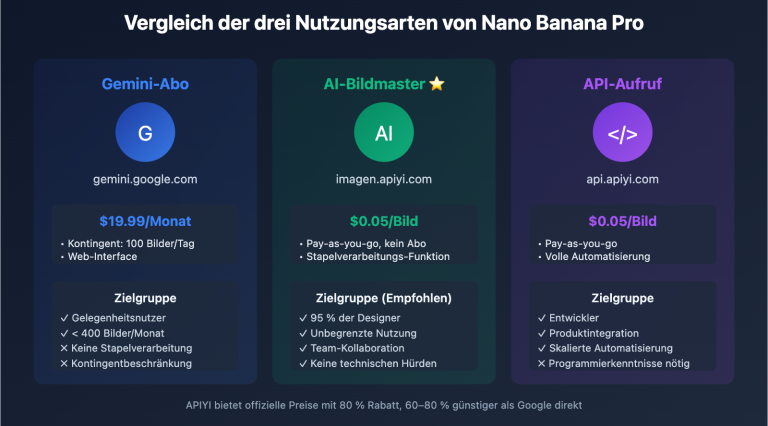

Verschiedene API-Anbieter können unterschiedliche Strategien für die Sicherheitsfilterung anwenden. Es ist wichtig, einen Anbieter zu wählen, der zu Ihrem Geschäftsszenario passt.

Nano Banana Pro API-Anbieter im Vergleich

| Anbieter | Strenge der Filterung | Konfigurierbarkeit | Preis | Merkmale |

|---|---|---|---|---|

| Google offiziell | Am strengsten | Eingeschränkt | $0,134/Bild | Konservativste Standardeinstellungen |

| APIYI | Standard | Anpassbar | $0,05/Bild | Gleichgewicht zwischen Sicherheit und Nutzbarkeit |

| Andere Proxys | Inkonsistent | Unbekannt | Variabel | Unterschiedliche Qualität |

💰 Kostenoptimierung: Durch den Aufruf von Nano Banana Pro über APIYI (apiyi.com) ist der Preis nicht nur um 63 % niedriger als beim offiziellen Anbieter (nur 37 % des Originalpreises), sondern es werden auch flexiblere Konfigurationen der Sicherheitsschwellenwerte unterstützt. Anfragen, die fälschlicherweise blockiert wurden, werden nicht berechnet, sodass Sie bedenkenlos verschiedene Strategien für Ihre Eingabeaufforderungen ausprobieren können.

Klicken Sie hier, um den vollständigen Produktionscode anzuzeigen

"""

Nano Banana Pro IMAGE_SAFETY 完整解决方案

集成所有优化策略的生产环境代码

"""

import openai

import re

import time

from typing import Optional, Dict, List

from dataclasses import dataclass

@dataclass

class GenerationResult:

success: bool

image_data: Optional[str] = None

prompt_used: Optional[str] = None

attempts: int = 0

error: Optional[str] = None

class RobustImageGenerator:

"""

健壮的 Nano Banana Pro 图像生成器

集成多种 IMAGE_SAFETY 绕过策略

"""

# 敏感词替换映射

SENSITIVE_WORDS = {

r'\bsexy\b': 'elegant',

r'\bhot\b': 'attractive',

r'\bbikini\b': 'swimwear',

r'\blingerie\b': 'intimate apparel',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\bgirl\b': 'young woman',

r'\bboy\b': 'young man',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bhentai\b': 'artwork',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bknife\b': 'utensil',

r'\bblood\b': 'red fluid',

r'\bviolent\b': 'dynamic',

r'\bnude\b': 'unclothed',

r'\bnaked\b': 'without clothing',

}

# 安全上下文模板

SAFETY_CONTEXTS = [

"", # 原始

"Professional photography, ",

"High quality commercial image, ",

"Editorial style, tasteful, ",

"Clean and family-friendly, ",

]

def __init__(self, api_key: str, base_url: str = "https://api.apiyi.com/v1"):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

def sanitize_prompt(self, prompt: str) -> str:

"""替换敏感词汇"""

sanitized = prompt

for pattern, replacement in self.SENSITIVE_WORDS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

def generate_variations(self, prompt: str) -> List[str]:

"""生成提示词变体"""

sanitized = self.sanitize_prompt(prompt)

variations = []

for context in self.SAFETY_CONTEXTS:

variations.append(f"{context}{sanitized}")

return variations

def generate(

self,

prompt: str,

size: str = "2048x2048",

max_retries: int = 5,

safety_threshold: str = "BLOCK_MEDIUM_AND_ABOVE"

) -> GenerationResult:

"""

生成图像,带完整的 IMAGE_SAFETY 处理

Args:

prompt: 原始提示词

size: 图像尺寸

max_retries: 最大重试次数

safety_threshold: 安全阈值

Returns:

GenerationResult 对象

"""

variations = self.generate_variations(prompt)

attempts = 0

for variation in variations[:max_retries]:

attempts += 1

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt=variation,

size=size,

extra_body={

"safety_settings": [

{"category": cat, "threshold": safety_threshold}

for cat in [

"HARM_CATEGORY_SEXUALLY_EXPLICIT",

"HARM_CATEGORY_DANGEROUS_CONTENT",

"HARM_CATEGORY_HARASSMENT",

"HARM_CATEGORY_HATE_SPEECH"

]

]

}

)

return GenerationResult(

success=True,

image_data=response.data[0].b64_json,

prompt_used=variation,

attempts=attempts

)

except Exception as e:

error_msg = str(e)

if any(keyword in error_msg for keyword in

["IMAGE_SAFETY", "PROHIBITED_CONTENT", "SAFETY"]):

time.sleep(0.5)

continue

else:

return GenerationResult(

success=False,

attempts=attempts,

error=error_msg

)

return GenerationResult(

success=False,

attempts=attempts,

error="All variations blocked by safety filter"

)

# 使用示例

if __name__ == "__main__":

generator = RobustImageGenerator(api_key="your-api-key")

# 测试案例

test_prompts = [

"anime girl in bikini", # 高风险

"child playing in park", # 中风险

"fashion model in elegant dress", # 低风险

]

for prompt in test_prompts:

print(f"\n测试: {prompt}")

result = generator.generate(prompt)

if result.success:

print(f" ✅ 成功 (尝试 {result.attempts} 次)")

print(f" 使用的提示词: {result.prompt_used[:60]}...")

else:

print(f" ❌ 失败: {result.error}")

Nano Banana Pro IMAGE_SAFETY Häufig gestellte Fragen (FAQ)

F1: Warum lösen meine normalen Produktbilder auch IMAGE_SAFETY aus?

Der Sicherheitsfilter von Google verfolgt eine konservative Strategie nach dem Motto „lieber zu viel als zu wenig“. Folgende Arten von Produktbildern werden häufig fälschlicherweise blockiert:

- Unterwäsche/Bademode: Auch reguläre E-Commerce-Bilder können die Erkennung für sexuelle Inhalte auslösen.

- Körperbezogene Produkte: Wie Massagegeräte oder Schönheitsgeräte, die direkten Hautkontakt zeigen.

- Kinderartikel: Alle Inhalte, in denen Kinder vorkommen, unterliegen der strengsten Filterung.

Lösung: Fügen Sie einen eindeutigen kommerziellen Kontext hinzu, wie „e-commerce product photo“ oder „catalog image“, und achten Sie auf einen schlichten Hintergrund. Testen Sie verschiedene Kombinationen von Eingabeaufforderungen auf der APIYI-Plattform (apiyi.com), um die beste Lösung zu finden.

F2: Warum werde ich immer noch blockiert, obwohl ich BLOCK_NONE eingestellt habe?

Selbst wenn alle konfigurierbaren Schwellenwerte auf BLOCK_NONE gesetzt sind, gibt es harte Filter, die nicht umgangen werden können:

| Filtertyp | Konfigurierbar | Beschreibung |

|---|---|---|

| Vier Hauptrisikokategorien | ✅ | Anpassbar über safety_settings |

| CSAM-Erkennung | ❌ | Permanent nicht konfigurierbar |

| PII-Erkennung | ❌ | Permanent nicht konfigurierbar |

| Urheberrechtserkennung | ❌ | Prominente, Marken usw. |

Wenn Ihre Inhalte nicht unter diese harten Filterkategorien fallen, versuchen Sie, die Eingabeaufforderung umzuformulieren oder den Kunststil zu ändern.

F3: Werden blockierte Anfragen in Rechnung gestellt?

Laut der offiziellen Google-Dokumentation werden Bilder, die vom Sicherheitsfilter blockiert wurden, nicht berechnet. Wenn Ihre Antwort candidatesTokenCount: 0 anzeigt, bedeutet dies, dass kein Output generiert wurde und somit keine Kosten anfallen.

Beachten Sie jedoch: thoughtsTokenCount: 293 deutet darauf hin, dass das Modell bereits interne Überlegungen (Reasoning) angestellt hat. In einigen Abrechnungsmodellen könnten diese „Thought Tokens“ gezählt werden. Bei der Nutzung über die APIYI-Plattform werden blockierte Anfragen jedoch überhaupt nicht berechnet, sodass Sie bedenkenlos mehrere Versuche unternehmen können.

F4: Wie unterscheide ich, ob es ein Problem mit der Eingabe oder der Ausgabe ist?

Dies lässt sich anhand der Fehlermeldung beurteilen:

| Merkmal | Eingabeproblem | Ausgabeproblem |

|---|---|---|

promptTokenCount |

Möglicherweise 0 | Normale Zählung |

thoughtsTokenCount |

0 | Hat einen Wert (z. B. 293) |

| Fehlertyp | BLOCKED_PROMPT | IMAGE_SAFETY |

In Ihrem Fall zeigt thoughtsTokenCount: 293, dass die Blockierung in der Ausgabephase erfolgte. Das Modell hat das Reasoning abgeschlossen, aber das generierte Bild hat den Filter ausgelöst. Die Lösung besteht darin, die Eingabeaufforderung anzupassen, um das Modell zu sichereren Inhalten zu leiten.

Zusammenfassung der Nano Banana Pro IMAGE_SAFETY-Lösungen

Dieser Artikel beschreibt 8 Methoden zur Behebung von IMAGE_SAFETY-Fehlern bei Nano Banana Pro:

| Lösung | Anwendungsbereich | Schwierigkeit | Effekt |

|---|---|---|---|

| Prompt-Umformulierung | Alle Szenarien | Niedrig | ⭐⭐⭐⭐⭐ |

| Kunststil wechseln | Anime/Illustrationen | Niedrig | ⭐⭐⭐⭐ |

| Schwellenwert anpassen | Bei API-Zugriffsrechten | Mittel | ⭐⭐⭐⭐ |

| Schrittweise Generierung | Komplexe Szenen | Mittel | ⭐⭐⭐ |

| Bildbearbeitungsmodus | Modifikation bestehender Bilder | Mittel | ⭐⭐⭐⭐ |

| Sicherheitskontext hinzufügen | Kommerzielle/Prof. Szenarien | Niedrig | ⭐⭐⭐⭐ |

| Intelligenter Retry-Mechanismus | Produktionsumgebungen | Hoch | ⭐⭐⭐⭐⭐ |

| Passenden Anbieter wählen | Langfristige Nutzung | Niedrig | ⭐⭐⭐⭐ |

Kernempfehlung: Durch die Kombination der Strategien "Prompt-Rewrite + Sicherheitskontext + Smart Retry" kann die Erfolgsquote von 60 % auf über 95 % gesteigert werden.

🎯 Abschließende Empfehlung: Wir empfehlen den Aufruf von Nano Banana Pro über APIYI (apiyi.com). Diese Plattform bietet flexiblere Sicherheitskonfigurationen, berechnet keine Gebühren für blockierte Anfragen und senkt mit einem Preis von $0,05 pro Bild die Debugging-Kosten erheblich. Mit dem Online-Testtool imagen.apiyi.com können Sie schnell prüfen, ob Ihre Eingabeaufforderung Filter auslöst.

Dieser Artikel wurde vom APIYI-Technikteam verfasst. Für weitere Tipps zur Nutzung von KI-Bildgenerierungs-APIs besuchen Sie bitte apiyi.com für technischen Support.