"Hallo, ich habe ein Konto bei Google AI Studio, aber mein kostenloses Kontingent wird als erschöpft angezeigt. Ich möchte AI Studio weiterhin zum Erstellen von Modellen verwenden, aber mein kostenloses Konto wird nicht aufgeladen. Wie kann ich mein Google-Konto aufladen oder gibt es eine andere Möglichkeit, es weiter zu nutzen?"

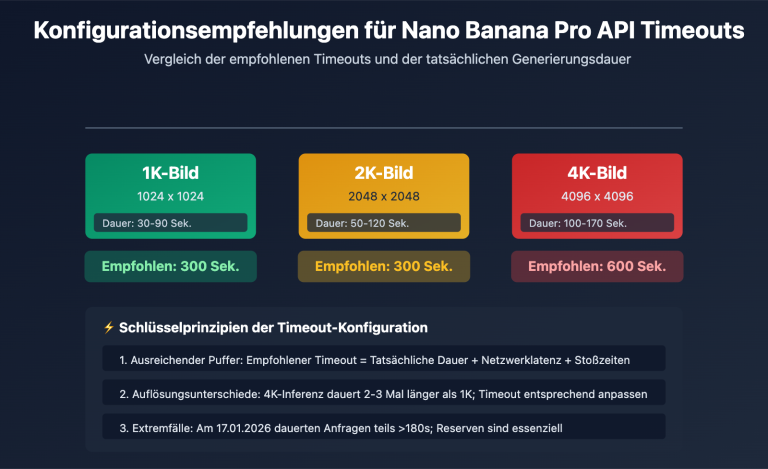

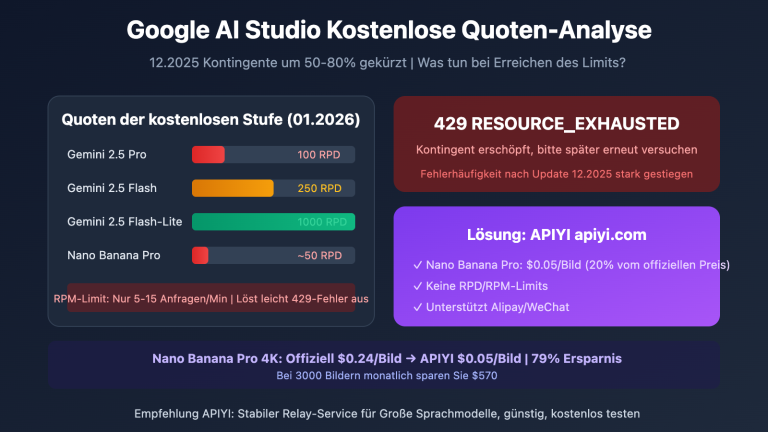

Das ist eine Anfrage, die wir täglich erhalten. Das kostenlose Kontingent von Google AI Studio ist in der Tat begrenzt, und im Dezember 2025 hat Google die Zuteilungen für die kostenlose Stufe sogar noch einmal drastisch gesenkt.

Die gute Nachricht ist: Sie müssen Ihr Google-Konto nicht aufladen, um die gesamte Gemini-Modellserie weiterhin nutzen zu können.

Die Kernidee ist einfach: Exportieren Sie Ihren Code und rufen Sie ihn lokal für Ihre Entwicklung auf.

In diesem Artikel stellen wir Ihnen 3 Lösungen im Detail vor, mit denen Sie Gemini nach Erschöpfung des kostenlosen Kontingents weiter nutzen können.

Die Kontingentbeschränkungen von AI Studio verstehen

Aktuelle Kontingente der kostenlosen Stufe (Stand 2026)

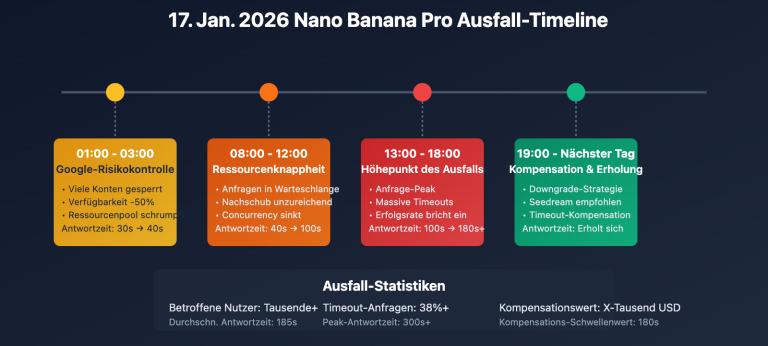

Am 7. Dezember 2025 hat Google die Kontingente für die Gemini Developer API massiv angepasst. Viele Entwickler erhielten plötzlich 429-Fehlermeldungen:

| Modell | Kostenlose Stufe RPM | Kostenlose Stufe RPD | Kostenpflichtige Stufe RPM |

|---|---|---|---|

| Gemini 2.5 Pro | 5 | 25 | 1.000 |

| Gemini 2.5 Flash | 15 | 500 | 2.000 |

| Gemini 2.0 Flash | 15 | 1.500 | 4.000 |

Hinweis: RPM = Anfragen pro Minute (Requests Per Minute), RPD = Anfragen pro Tag (Requests Per Day)

Warum das Kontingent plötzlich erschöpft ist

| Ursache | Erklärung |

|---|---|

| RPM-Limit überschritten | Zu viele Anfragen in einem kurzen Zeitraum |

| RPD-Limit überschritten | Die Gesamtzahl der täglichen Anfragen wurde erreicht |

| TPM-Limit überschritten | Ein langer Kontext verbraucht eine große Menge an Token |

| Kontingentsenkung | Strengere Beschränkungen nach der Google-Anpassung im Dez. 2025 |

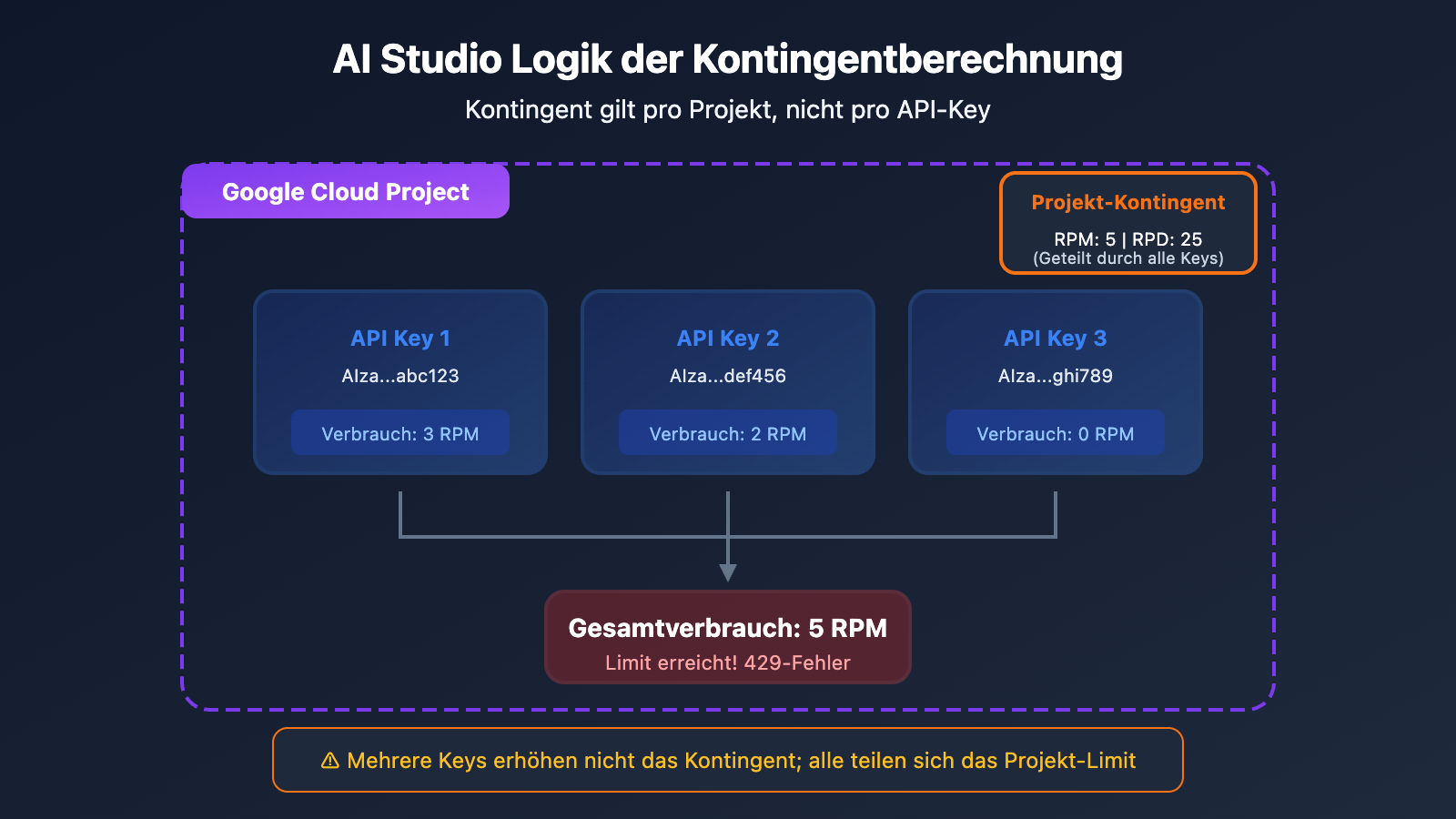

Wichtiger Hinweis: Mehrere API-Keys teilen sich das Kontingent

Viele Nutzer glauben fälschlicherweise, dass sie durch das Erstellen mehrerer API-Keys mehr Kontingent erhalten. Die Realität sieht jedoch so aus:

Das Kontingent wird pro Projekt (Project) berechnet, nicht pro API-Key. Das Erstellen mehrerer API-Keys innerhalb desselben Projekts erhöht das verfügbbare Kontingent nicht.

Lösung 1: Code-Export für die lokale Entwicklung (Empfohlen)

Kernidee

Das AI Studio ist im Kern ein visuelles Tool zum Debuggen von Eingabeaufforderungen. Die Modelle und die im AI Studio optimierten Eingabeaufforderungen können als Code exportiert und in Ihrer lokalen Umgebung mit Ihrem eigenen API-Key aufgerufen werden.

Schritt-für-Schritt-Anleitung

Step 1: Debugging der Eingabeaufforderung im AI Studio abschließen

Nutzen Sie das kostenlose Kontingent von AI Studio, um Ihre Eingabeaufforderung, Parameterkonfigurationen usw. optimal einzustellen.

Step 2: Code exportieren

AI Studio bietet verschiedene Exportmöglichkeiten:

- ZIP herunterladen: Exportiert das vollständige Codepaket lokal

- Zu GitHub pushen: Direkt in Ihr Code-Repository übertragen

- Codeschnipsel kopieren: Python-/JavaScript-/curl-Code kopieren

Step 3: Lokale Konfiguration des API-Keys

# Umgebungsvariable setzen (empfohlen)

export GEMINI_API_KEY="your-api-key-here"

# Oder

export GOOGLE_API_KEY="your-api-key-here"

Step 4: Lokal ausführen

import google.generativeai as genai

import os

# API-Key automatisch aus der Umgebungsvariable lesen

genai.configure(api_key=os.environ.get("GEMINI_API_KEY"))

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("你好,请介绍一下自己")

print(response.text)

Wichtige Hinweise

| Punkt | Beschreibung |

|---|---|

| API-Key-Sicherheit | Hardkodieren Sie den API-Key niemals im Client-Code |

| Umgebungsvariablen | Verwenden Sie GEMINI_API_KEY oder GOOGLE_API_KEY |

| Kontingente bleiben begrenzt | Lokale Aufrufe unterliegen weiterhin den Limits des kostenlosen Kontingents |

🎯 Technischer Rat: Wenn das kostenlose Kontingent nach dem Code-Export immer noch nicht ausreicht, sollten Sie die Nutzung von Drittanbietern wie APIYI (apiyi.com) in Erwägung ziehen. Diese Plattformen bieten höhere Kontingente und flexiblere Abrechnungsmodelle.

Lösung 2: Nutzung eines Drittanbieter-API-Proxys (Beste Lösung)

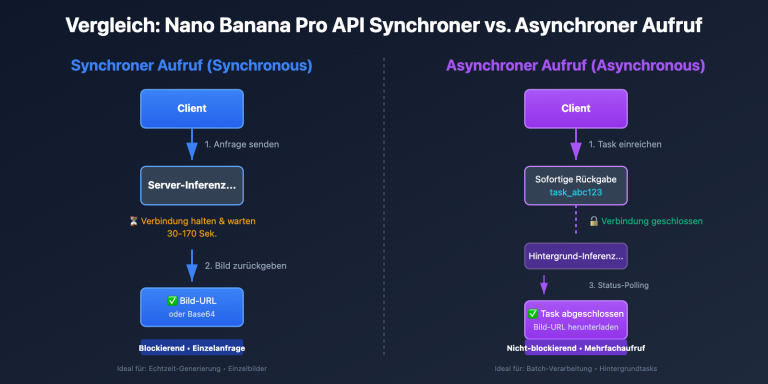

Was ist ein API-Proxy-Dienst?

Ein API-Proxy-Dienst aggregiert mehrere API-Keys und Account-Ressourcen, um eine einheitliche API-Schnittstelle bereitzustellen. Sie müssen lediglich:

- Sich auf der Proxy-Plattform registrieren, um einen API-Key zu erhalten

- Die API-Adresse in Ihrem Code auf die Proxy-Adresse ändern

- Den Dienst weiter nutzen, ohne sich um Kontingentprobleme kümmern zu müssen

Warum einen API-Proxy wählen?

| Vorteile | Beschreibung |

|---|---|

| Keine Sorgen um Kontingente | Der Proxy-Anbieter verwaltet die Limits, Sie nutzen den Dienst einfach |

| Unterstützung der gesamten Modellserie | Volle Abdeckung von Gemini Pro, Flash, Nano Banana usw. |

| OpenAI-kompatibles Format | Keine Änderung der bestehenden Codestruktur erforderlich |

| Pay-as-you-go | Verbrauchsbasierte Abrechnung ohne monatliche Grundgebühr |

| Höhere Stabilität | Lastverteilung über mehrere Knoten zur Vermeidung von Ratelimits |

Beispiel für die Codemigration

Vor der Migration (direkter Aufruf der Google API):

import google.generativeai as genai

genai.configure(api_key="YOUR_GOOGLE_API_KEY")

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Hello")

Nach der Migration (unter Verwendung eines API-Proxys):

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI

)

response = client.chat.completions.create(

model="gemini-2.0-flash",

messages=[{"role": "user", "content": "Hello"}]

)

print(response.choices[0].message.content)

Liste der unterstützten Modelle

| Modellserie | Konkretes Modell | Beschreibung |

|---|---|---|

| Gemini 2.5 | gemini-2.5-pro, gemini-2.5-flash | Neueste multimodale Modelle |

| Gemini 2.0 | gemini-2.0-flash, gemini-2.0-flash-thinking | Modelle für schnelles Reasoning |

| Gemini 3 | gemini-3-pro-image-preview | Bildgenerierungsmodelle |

| Nano Banana | nano-banana-pro | Native Bilderzeugung |

💡 Schnellstart: Wir empfehlen die Nutzung der Plattform APIYI (apiyi.com) für einen schnellen Einstieg. Die Plattform unterstützt die gesamte Gemini-Modellserie, bietet ein OpenAI-kompatibles Format und die Migration ist in nur 5 Minuten erledigt.

Option 3: Upgrade auf die Google-Zahlungsebene (Paid Tier)

Vergleich der Kontingente (Quotas) für Zahlungsebenen

Wenn Sie weiterhin die offiziellen Google-Dienste nutzen möchten, können Sie ein Upgrade auf eine kostenpflichtige Ebene in Betracht ziehen:

| Ebene | Voraussetzung | Gemini 2.5 Pro RPM | Gemini 2.5 Flash RPM |

|---|---|---|---|

| Free | Standard | 5 | 15 |

| Tier 1 | Abrechnung aktiviert | 150 | 1.000 |

| Tier 2 | Ausgaben $50+ | 500 | 2.000 |

| Tier 3 | Ausgaben $500+ | 1.000 | 4.000 |

Schritte für das Upgrade

- Melden Sie sich in der Google Cloud Console an.

- Erstellen oder wählen Sie ein Projekt aus.

- Aktivieren Sie die Abrechnung (Billing) durch Verknüpfung einer Kreditkarte.

- Überprüfen Sie die Änderung der Kontingente im AI Studio.

Probleme mit der Zahlungsebene

| Problem | Beschreibung |

|---|---|

| Internationale Kreditkarte erforderlich | Für Nutzer in bestimmten Regionen (z. B. China) oft schwierig zu beantragen. |

| Google Cloud-Konto erforderlich | Die Konfiguration ist vergleichsweise komplex. |

| Mindestumsatzschwelle | Für das Upgrade auf höhere Ebenen müssen entsprechende Ausgaben erreicht werden. |

| Weiterhin Kontingentobergrenzen | Das Limit wird lediglich erhöht, es ist nicht unbegrenzt. |

Vergleich der drei Optionen

| Vergleichsaspekt | Lokale Entwicklung (Export) | API-Proxy-Dienst | Upgrade Paid Tier |

|---|---|---|---|

| Konfigurationsaufwand | Mittel | Einfach | Komplex |

| Kontingentlimit | Weiterhin begrenzt | Unbegrenzt | Höhere Limits |

| Kosten | Kostenlos (begrenzt) | Pay-as-you-go | Pay-as-you-go |

| Kreditkarte nötig | Nein | Nein | Ja (internat. Karte) |

| Stabilität | Moderat | Hoch | Hoch |

| Anwendungsfall | Gelegenheitsnutzer | Empfohlen für die meisten | Enterprise-Bedarf |

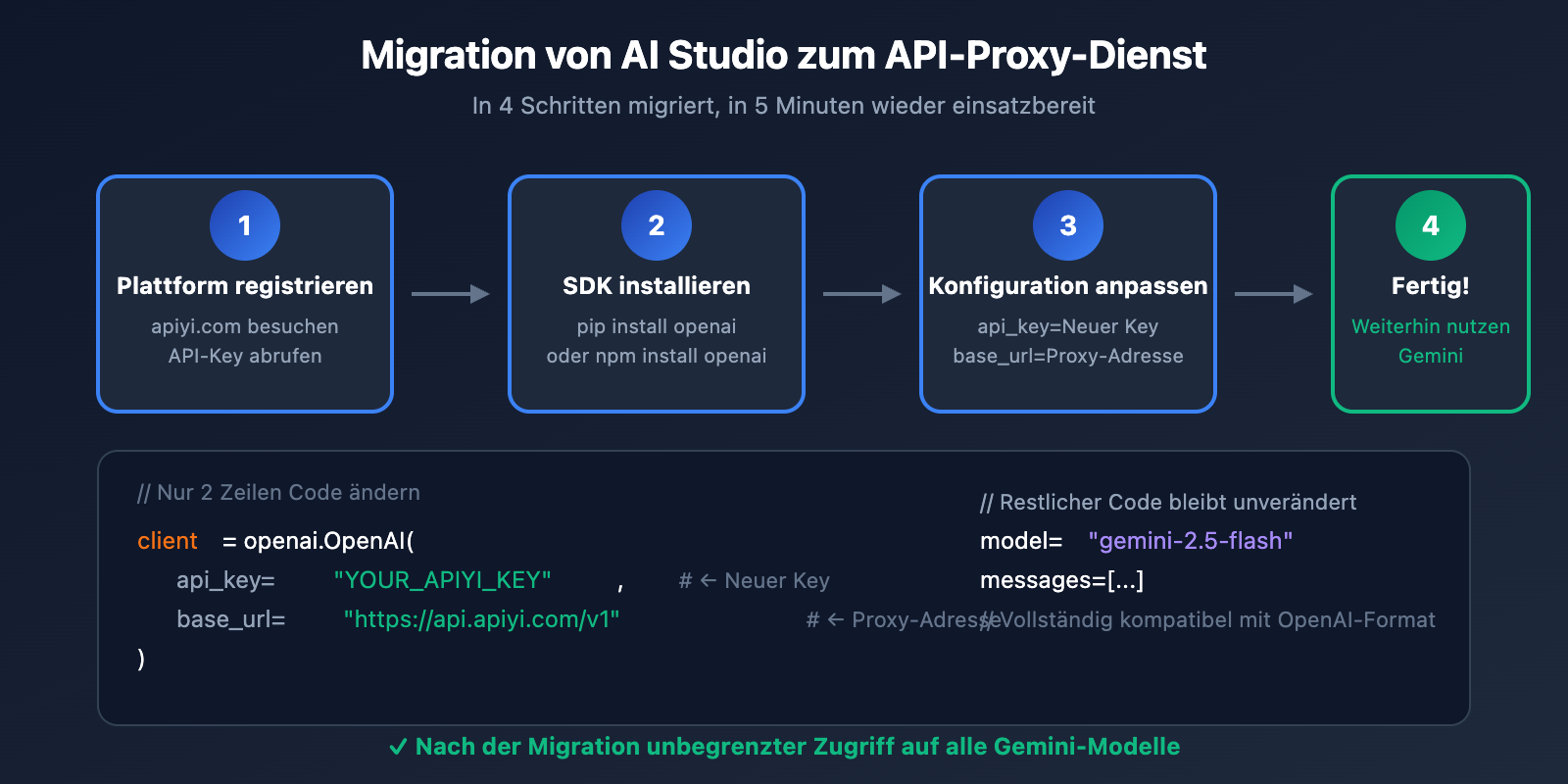

Detailliertes Tutorial: Migration von AI Studio zum API-Proxy

Schritt 1: Registrierung eines API-Proxy-Kontos

Besuchen Sie APIYI (apiyi.com), registrieren Sie ein Konto und rufen Sie Ihren API-Key ab.

Schritt 2: Installation des OpenAI SDKs

# Python

pip install openai

# Node.js

npm install openai

Schritt 3: Code-Konfiguration anpassen

Python-Beispiel:

import openai

# API-Proxy konfigurieren

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI

)

# Gemini-Modell aufrufen

def chat_with_gemini(prompt):

response = client.chat.completions.create(

model="gemini-2.5-flash", # Andere Gemini-Modelle optional verfügbar

messages=[

{"role": "user", "content": prompt}

],

temperature=0.7,

max_tokens=2048

)

return response.choices[0].message.content

# Anwendungsbeispiel

result = chat_with_gemini("Schreibe einen Quicksort-Algorithmus in Python")

print(result)

Node.js-Beispiel:

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: 'YOUR_APIYI_KEY',

baseURL: 'https://api.apiyi.com/v1'

});

async function chatWithGemini(prompt) {

const response = await client.chat.completions.create({

model: 'gemini-2.5-flash',

messages: [

{ role: 'user', content: prompt }

]

});

return response.choices[0].message.content;

}

// Anwendungsbeispiel

const result = await chatWithGemini('Erkläre, was maschinelles Lernen ist');

console.log(result);

Schritt 4: Test und Verifizierung

# Verbindung testen

try:

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": "Hallo, Verbindungstest"}],

max_tokens=50

)

print("Verbindung erfolgreich:", response.choices[0].message.content)

except Exception as e:

print("Verbindung fehlgeschlagen:", e)

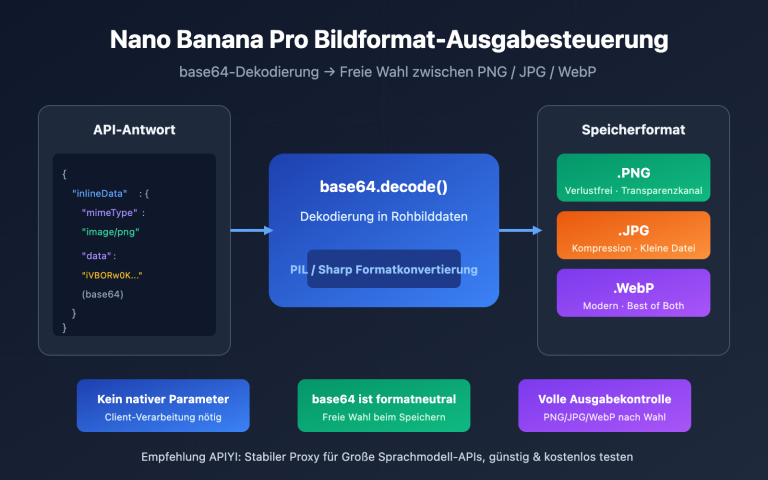

Migration von Bildgenerierungsmodellen

Bildgenerierung in AI Studio

Wenn Sie die Bildgenerierungsfunktionen von Gemini (Nano Banana Pro) in AI Studio nutzen, können Sie diese ebenfalls über den API-Proxy weiterhin verwenden:

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1"

)

# Bildgenerierung

response = client.images.generate(

model="nano-banana-pro",

prompt="Eine süße orangefarbene Katze, die in der Sonne ein Nickerchen macht, realistischer Fotografie-Stil",

size="1024x1024",

quality="hd"

)

image_url = response.data[0].url

print(f"Generiertes Bild: {image_url}")

Multimodaler Dialog (Text und Bild kombiniert)

import base64

def encode_image(image_path):

with open(image_path, "rb") as f:

return base64.b64encode(f.read()).decode()

image_base64 = encode_image("example.jpg")

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "Beschreibe den Inhalt dieses Bildes"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{image_base64}"

}

}

]

}

]

)

print(response.choices[0].message.content)

💰 Kostenoptimierung: Für Bildgenerierungsanforderungen bietet die Plattform APIYI (apiyi.com) flexible Abrechnungsmodelle und unterstützt verschiedene Modelle wie Nano Banana Pro, DALL-E und Stable Diffusion, sodass Sie je nach Bedarf die optimale Lösung wählen können.

Umgang mit häufigen Fehlern

Fehler 1: 429 Too Many Requests

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10))

def call_api_with_retry(prompt):

return client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": prompt}]

)

Fehler 2: Ungültiger API-Key

# API-Key-Konfiguration prüfen

import os

api_key = os.environ.get("APIYI_KEY")

if not api_key:

raise ValueError("Bitte legen Sie die Umgebungsvariable APIYI_KEY fest")

client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

Fehler 3: Modell existiert nicht

# Sicherstellen, dass der Modellname korrekt ist

SUPPORTED_MODELS = [

"gemini-2.5-pro",

"gemini-2.5-flash",

"gemini-2.0-flash",

"nano-banana-pro"

]

model_name = "gemini-2.5-flash"

if model_name not in SUPPORTED_MODELS:

print(f"Warnung: {model_name} ist möglicherweise nicht in der Liste der unterstützten Modelle enthalten")

Häufig gestellte Fragen FAQ

Q1: Wann wird das kostenlose Kontingent von AI Studio zurückgesetzt?

- RPM (Requests Per Minute): Rollierendes Fenster, wird jede Minute zurückgesetzt.

- RPD (Requests Per Day): Wird um Mitternacht Pazifischer Zeit (PT) zurückgesetzt.

- TPM (Tokens Per Minute): Rollierendes Fenster, wird jede Minute zurückgesetzt.

Wenn Sie den Dienst dringend benötigen, empfiehlt es sich, Aufrufe über die Plattform APIYI (apiyi.com) zu tätigen, um nicht auf die Zurücksetzung des Kontingents warten zu müssen.

Q2: Ist die Nutzung eines API-Proxys sicher?

Die Wahl eines seriösen API-Proxy-Anbieters ist sicher. Beachten Sie vor allem:

- Wählen Sie einen vertrauenswürdigen Anbieter.

- Vermeiden Sie das Hardcoding von API-Keys in Ihrem Code.

- Nutzen Sie Umgebungsvariablen zur Verwaltung Ihrer Schlüssel.

Q3: Wie hoch sind die Preise für API-Proxys?

Die meisten API-Proxy-Dienste nutzen ein Pay-as-you-go-Modell (Abrechnung nach Verbrauch), das oft günstiger als die offiziellen Preise ist. Die Plattform APIYI (apiyi.com) bietet eine transparente Preisgestaltung, die direkt auf der Website eingesehen werden kann.

Q4: Muss der Code nach der Migration stark angepasst werden?

Wenn Sie einen API-Proxy mit OpenAI-kompatiblem Format verwenden, sind die Änderungen am Code minimal:

- Sie müssen lediglich den

api_keyund diebase_urlanpassen. - Die Modellnamen müssen eventuell angepasst werden.

- Die restliche Codelogik bleibt unverändert.

Q5: Kann ich mehrere API-Dienste gleichzeitig nutzen?

Ja. Sie können je nach Szenario verschiedene Dienste wählen:

- Das kostenlose Kontingent von AI Studio für leichte Tests.

- API-Proxy-Dienste für die tägliche Entwicklung.

- Offizielle kostenpflichtige Dienste für spezielle Anforderungen.

Zusammenfassung

Wenn das kostenlose Kontingent von Google AI Studio erschöpft ist, haben Sie 3 Optionen:

| Option | Zielgruppe | Kernschritt |

|---|---|---|

| Export für lokale Entwicklung | Gelegenheitsnutzer | Code exportieren, lokal aufrufen |

| API-Proxy-Dienst | Die meisten Entwickler | base_url ändern, weiterarbeiten |

| Upgrade auf kostenpflichtige Stufe | Unternehmenseinsatz | Kreditkarte hinterlegen, Kontingent erhöhen |

Zentrale Empfehlungen:

- Laden Sie kein Guthaben auf Ihr Google-Konto auf (außer Sie besitzen eine internationale Kreditkarte und benötigen Enterprise-Services).

- Exportieren Sie Ihren Code in Ihre lokale Umgebung.

- Nutzen Sie einen API-Proxy-Dienst, um die Gemini-Modelle weiterhin aufzurufen.

- Zusammenfassung in einem Satz: Exportieren Sie Ihren Code und nutzen Sie ihn lokal für die Entwicklung.

Wir empfehlen APIYI (apiyi.com) zur schnellen Wiederherstellung des Gemini-Zugriffs. Die Plattform unterstützt die gesamte Gemini-Modellserie, bietet ein OpenAI-kompatibles Format und ermöglicht eine Migration mit minimalem Aufwand.

Weiterführende Informationen:

- Gemini API Rate Limits: ai.google.dev/gemini-api/docs/rate-limits

- AI Studio Build-Modus: ai.google.dev/gemini-api/docs/aistudio-build-mode

- API Key Leitfaden: ai.google.dev/gemini-api/docs/api-key

📝 Autor: APIYI Technik-Team | Fokus auf API-Integration und Optimierung für Große Sprachmodelle

🔗 Technischer Austausch: Besuchen Sie APIYI apiyi.com, um Unterstützung für die gesamte Gemini-Modellserie zu erhalten.