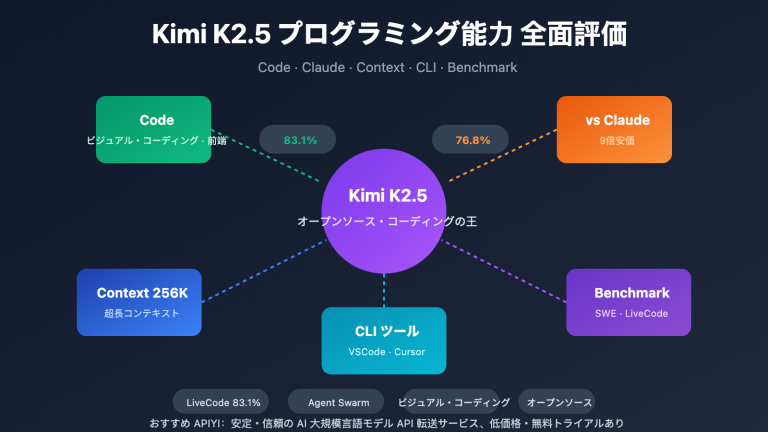

著者注:Kimi K2.5は完全にオープンソース化されました。この記事では、オープンソースライセンス、モデルのダウンロード、API連携方法について詳しく解説し、APIYIを通じてKimi K2.5を素早く呼び出すための完全なコード例を提供します。

Kimi K2.5はオープンソース化されましたか?これは、多くの開発者が最近最も関心を寄せている質問です。嬉しいことに、Moonshot AIは2026年1月26日に Kimi K2.5を完全にオープンソース化 しました。これにはコードとモデルウェイトが含まれており、Modified MIT Licenseが採用されています。

核心価値:この記事を読むことで、Kimi K2.5のオープンソースに関する詳細を理解し、セルフデプロイ、公式API、サードパーティプラットフォーム(APIYI apiyi.com など)の3つの連携方法を習得できます。これにより、1兆パラメータを持つこのマルチモーダルAgentモデルをプロジェクトですぐに活用できるようになります。

Kimi K2.5 オープンソースの主要ポイント

| 要点 | 説明 | 開発者のメリット |

|---|---|---|

| 完全オープンソース | コードとウェイトの両方を公開、Modified MIT License | 商用利用、ローカルデプロイ、ファインチューニングが可能 |

| 1兆パラメータ MoE | 総パラメータ 1T、アクティブパラメータ 32B | クローズドモデルに匹敵する性能を、より低コストで実現 |

| ネイティブ・マルチモーダル | 画像、動画、ドキュメントの理解をサポート | 1つのモデルで多様な入力タイプをカバー |

| Agent Swarm | 最大 100 個の並列子 Agent | 複雑なタスクの効率が 4.5 倍に向上 |

| OpenAI 互換 | API 形式が OpenAI と完全互換 | 既存コードをほぼゼロコストで移行可能 |

Kimi K2.5 オープンソースライセンスの詳細

Kimi K2.5 は Modified MIT License を採用しています。これは以下を意味します:

- 商用利用:商用製品での利用が可能で、ライセンス料を支払う必要はありません。

- 改変と配布:モデルを改変し、再配布することができます。

- ローカルデプロイ:プライベートデプロイを完全にサポートしており、データがローカルから出ることはありません。

- ファインチューニング:オープンソースのウェイトに基づいたドメイン固有のファインチューニングが可能です。

LLaMAシリーズの制限的なライセンスとは異なり、Kimi K2.5のライセンスは開発者にとって非常にフレンドリーで、特に企業レベルのアプリケーションシーンに適しています。

Kimi K2.5 オープンソースリソースの取得

モデルのウェイトとコードは以下のチャネルから取得できます:

| リソース | アドレス | 説明 |

|---|---|---|

| HuggingFace | huggingface.co/moonshotai/Kimi-K2.5 |

公式ウェイト、transformers 4.57.1+ をサポート |

| NVIDIA NIM | build.nvidia.com/moonshotai/kimi-k2.5 |

最適化されたデプロイ用イメージ |

| ModelScope | modelscope.cn/models/moonshotai/Kimi-K2.5 |

中国国内ミラー、ダウンロードが高速 |

| Ollama | ollama.com/library/kimi-k2.5 |

ワンクリックでローカル実行が可能 |

Kimi K2.5 導入クイックスタートガイド

Kimi K2.5の導入方法には、主に「セルフホスティング」「公式API」「サードパーティプラットフォーム」の3つがあります。ほとんどの開発者には、GPUリソースなしで迅速に効果を検証できるAPI接続方式がおすすめです。

シンプルな実装例

以下は、APIYIプラットフォームを通じてKimi K2.5を呼び出すための最もシンプルなコードです。わずか10行で実行可能です。

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY", # apiyi.com で取得

base_url="https://vip.apiyi.com/v1"

)

response = client.chat.completions.create(

model="kimi-k2.5",

messages=[{"role": "user", "content": "量子コンピューティングの基本原理を説明してください"}]

)

print(response.choices[0].message.content)

Kimi K2.5 Thinkingモードの完全なコードを表示

import openai

from typing import Optional

def call_kimi_k25(

prompt: str,

thinking_mode: bool = True,

system_prompt: Optional[str] = None,

max_tokens: int = 4096

) -> dict:

"""

Kimi K2.5 APIを呼び出す

引数:

prompt: ユーザー入力

thinking_mode: 思考モード(ディープリサーチ/推論)を有効にするかどうか

system_prompt: システムプロンプト

max_tokens: 最大出力トークン数

戻り値:

推論プロセスと最終回答を含む辞書

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": prompt})

# 推論モードの設定

extra_body = {}

if not thinking_mode:

extra_body = {"thinking": {"type": "disabled"}}

response = client.chat.completions.create(

model="kimi-k2.5",

messages=messages,

max_tokens=max_tokens,

temperature=1.0 if thinking_mode else 0.6,

top_p=0.95,

extra_body=extra_body if extra_body else None

)

result = {

"content": response.choices[0].message.content,

"reasoning": getattr(response.choices[0].message, "reasoning_content", None)

}

return result

# 使用例 - Thinkingモード

result = call_kimi_k25(

prompt="9.11と9.9はどちらが大きいですか?慎重に考えて答えてください",

thinking_mode=True

)

print(f"推論プロセス: {result['reasoning']}")

print(f"最終回答: {result['content']}")

アドバイス:APIYI(apiyi.com)で無料テストクレジットを取得し、Kimi K2.5の推論能力を素早く検証しましょう。プラットフォームではすでにKimi K2.5がリリースされており、ThinkingモードとInstantモードの両方をサポートしています。

Kimi K2.5 導入プラン比較

| プラン | 主な特徴 | 活用シーン | コストの考慮事項 |

|---|---|---|---|

| セルフホスティング | データのローカル化、完全な制御 | 機密性の高い企業内環境 | 48GB以上のVRAMが必要 (INT4) |

| 公式 API | 安定したパフォーマンス、完全な機能 | 標準的な開発・テストシーン | 入力 $0.60/1M、出力 $3/1M |

| APIYI | 統一インターフェース、複数モデル切替 | 迅速な検証、コスト重視 | 従量課金、新規無料クレジットあり |

Kimi K2.5 導入の3つの方法の詳細

方法1:ローカル・セルフホスティング

GPUリソースを保有し、データのプライバシー要件が厳しい企業に適しています。vLLMやSGLangを使用したデプロイが推奨されます。

# Ollamaを使用してワンクリックでデプロイ(48GB以上のVRAMが必要)

ollama run kimi-k2.5

方法2:公式 API

Moonshot公式プラットフォームを通じて導入し、最新機能のサポートを受けられます。

client = openai.OpenAI(

api_key="YOUR_MOONSHOT_KEY",

base_url="https://api.moonshot.cn/v1"

)

方法3:APIYIプラットフォームでの導入(推奨)

Kimi K2.5はすでに APIYI(apiyi.com)で利用可能であり、以下のメリットがあります。

- OpenAI形式の統一インターフェースにより、学習コスト・ゼロで導入可能

- GPT-4o、Claudeなどのモデルとの迅速な切り替え・比較をサポート

- 新規ユーザーに無料テストクレジットをプレゼント

- 国内からのアクセスが安定しており、プロキシ設定の手間が不要

導入のアドバイス:まずは APIYI(apiyi.com)を通じて機能検証と効果評価を行い、ビジネスシーンに適していることを確認してから、セルフホスティングなどの検討を進めることをお勧めします。

Kimi K2.5 と競合 API のコスト比較

| モデル | 入力料金 | 出力料金 | 1回あたりのリクエストコスト (5K 出力) | 比較 |

|---|---|---|---|---|

| Kimi K2.5 | $0.60/M | $3.00/M | ~$0.0138 | 基準 |

| GPT-5.2 | $0.90/M | $3.80/M | ~$0.0190 | 38% 高い |

| Claude Opus 4.5 | $5.00/M | $15.00/M | ~$0.0750 | 444% 高い |

| Gemini 3 Pro | $1.25/M | $5.00/M | ~$0.0250 | 81% 高い |

Kimi K2.5は、一部のクローズドソースモデルに近い、あるいはそれを凌駕する性能を持ちながら、コストはClaude Opus 4.5のわずか 5分の1 程度に抑えられています。現在、最もコストパフォーマンスの高い1兆パラメータ級の大規模言語モデルの一つです。

よくある質問 (FAQ)

Q1: Kimi K2.5はオープンソースですか?商用利用は可能ですか?

はい、Kimi K2.5は2026年1月26日に完全にオープンソース化され、Modified MIT Licenseが採用されています。コードとモデルの重み(Weights)はどちらも無料で入手可能で、商用利用、改変、および再配布がサポートされています。

Q2: Kimi K2.5のThinkingモードとInstantモードの違いは何ですか?

Thinkingモードは詳細な推論プロセス(reasoning_content)を返し、複雑な問題に適しています。一方、Instantモードは回答を直接提示するため、レスポンスがより高速です。数学や論理的な問題にはThinkingモード、日常的な対話にはInstantモードの使用をお勧めします。

Q3: Kimi K2.5の導入効果を素早くテストするにはどうすればよいですか?

マルチモデル対応のAPIアグリゲーター(統合プラットフォーム)を使用したテストをお勧めします:

- APIYI (apiyi.com) にアクセスしてアカウントを登録します。

- APIキーと無料クレジットを取得します。

- 本記事のコード例を使用し、

base_urlをhttps://vip.apiyi.com/v1に設定します。 - モデル名に

kimi-k2.5と入力するだけで、すぐに呼び出しが可能です。

まとめ

Kimi K2.5 オープンソース連携の核心となるポイント:

- 完全オープンソース:Kimi K2.5 は Modified MIT License を採用しており、コードと重みの両方が商用利用可能です。

- 多彩な連携方法:セルフホスティング、公式API、サードパーティプラットフォームの3つの方法に対応しており、ニーズに合わせて選択できます。

- 圧倒的なコストパフォーマンス:1兆パラメータ規模のモデルでありながら、コストは Claude Opus 4.5 のわずか5分の1です。

Kimi K2.5 は APIYI(apiyi.com)で提供を開始しています。新規ユーザーの方は無料クレジットを取得できますので、まずはプラットフォームを通じてモデルの効果を迅速に検証し、ご自身のビジネスシーンに適しているか評価することをお勧めします。

参考資料

⚠️ リンク形式の説明: すべての外部リンクは

資料名: domain.comの形式を使用しています。コピーには便利ですが、SEOの評価流出を防ぐためクリックによる遷移はできません。

-

Kimi K2.5 HuggingFace モデルカード: 公式のモデル重みと技術ドキュメント

- リンク:

huggingface.co/moonshotai/Kimi-K2.5 - 説明: モデルの重み、デプロイガイド、APIの使用例を取得できます。

- リンク:

-

Kimi K2.5 技術レポート: 詳細なモデルアーキテクチャとトレーニング手法

- リンク:

kimi.com/blog/kimi-k2-5.html - 説明: Agent Swarm、MoE アーキテクチャなどのコア技術の詳細を確認できます。

- リンク:

-

Moonshot オープンプラットフォーム: 公式APIドキュメントとSDK

- リンク:

platform.moonshot.ai/docs/guide/kimi-k2-5-quickstart - 説明: 価格設定やレート制限の説明を含む、公式の導入ガイドです。

- リンク:

-

Ollama Kimi K2.5: ローカルでのワンクリックデプロイソリューション

- リンク:

ollama.com/library/kimi-k2.5 - 説明: ローカル環境でのテストや小規模なデプロイシーンに適しています。

- リンク:

著者: 技術チーム

技術交流: コメント欄での Kimi K2.5 の使用体験に関するディスカッションを歓迎します。さらなるモデル比較やチュートリアルについては、APIYI(apiyi.com)技術コミュニティをご覧ください。