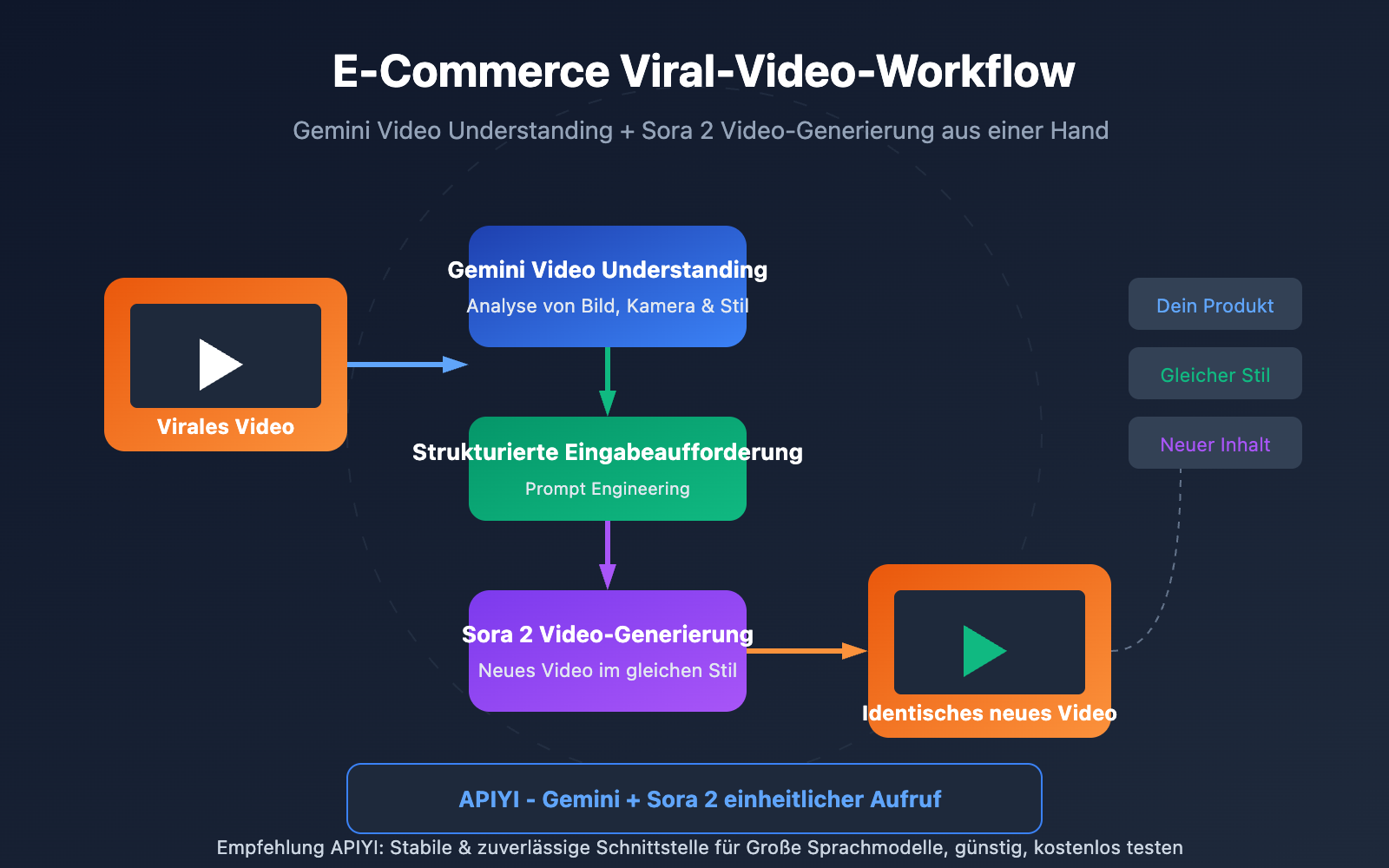

Anmerkung des Autors: Vollständiges Tutorial: Mit der Gemini Video Understanding API Eingabeaufforderungen für virale Videos extrahieren und mit Sora 2 neue Videos im gleichen Stil erstellen – ein One-Stop-Workflow für E-Commerce-Videokopien.

Virale Videos der Konkurrenz zu sehen, aber nicht zu wissen, wie man sie nachahmt, ist ein häufiges Problem im E-Commerce-Management. In diesem Artikel stellen wir den vollständigen Workflow aus Video Understanding + AI-Video-Generierung vor, mit dem Sie schnell die Techniken zur Reproduktion erfolgreicher Videos meistern.

Kernwert: Nach der Lektüre dieses Artikels werden Sie wissen, wie Sie Gemini Video Understanding nutzen, um Eingabeaufforderungen aus beliebigen Videos zu extrahieren und mit Sora 2 neue Videos im identischen Stil zu generieren.

Kernpunkte der Video-Reproduktion durch Video Understanding

| Punkt | Beschreibung | Wert |

|---|---|---|

| Video Understanding Reverse Engineering | KI-Analyse von Bild, Kameraführung, Stil und Rhythmus | Präzise Extraktion der Kernelemente erfolgreicher Videos |

| Eingabeaufforderung generieren | Automatische Erstellung strukturierter Prompts für die Video-Generierung | Kein manuelles Raten oder mühsames Debugging nötig |

| One-Click-Reproduktion | Prompts direkt in Sora 2 eingeben, um identische Stile zu erzeugen | Schnelle Produktion neuer Videos im gleichen Look |

| One-Stop-API | Einheitlicher Plattform-Aufruf für Gemini + Sora 2 | Vereinfacht den Workflow und senkt Integrationskosten |

Details zur Video-Reproduktion durch Video Understanding

Video Understanding ist eine der Kernkompetenzen multimodaler KI. Die Gemini-Modellreihe kann gleichzeitig Audiostreams und visuelle Frames von Videos verarbeiten, Bildinformationen mit einer Abtastrate von einem Frame pro Sekunde extrahieren und diese mit dem Audioinhalt kombinieren. Das bedeutet, die KI „sieht“ nicht nur, was im Video passiert, sondern versteht auch die Bildsprache, den Lichtstil, den Schnittrhythmus und andere professionelle Elemente.

Reverse Prompt Engineering ist die Schlüsseltechnologie, um Video-Verständnis für die Content-Erstellung zu nutzen. Durch sorgfältig konzipierte Analyse-Prompts kann die KI aus einem Video Informationen extrahieren wie: Bildkomposition, Kamerabewegung, Beleuchtungsstil, Farbtonalität, Bewegungen des Hauptdarstellers und Merkmale der Hintergrundmusik. Diese Elemente werden dann in einer strukturierten Eingabeaufforderung neu organisiert, die direkt für die Generierung mit Sora 2 verwendet werden kann.

Video-Verständnis: Virale Hits replizieren – Kompletter Workflow

Schritt 1: Virales Video hochladen

Es werden verschiedene Methoden zur Videoeingabe unterstützt:

| Eingabemethode | Anwendungsfall | Einschränkungen |

|---|---|---|

| Lokaler Upload | Bereits heruntergeladene Videodateien | Dateien < 100 MB können inline übertragen werden |

| File API | Große Dateien oder lange Videos | Unterstützt > 100 MB, wiederverwendbar |

| YouTube-URL | Direkte Analyse von Online-Videos | Nativ von Gemini unterstützt |

Schritt 2: Analyse durch Video-Verständnis

Verwenden Sie das Gemini-Modell für Video-Verständnis, um den Videoinhalt zu analysieren und wichtige kreative Elemente zu extrahieren:

import requests

import base64

# API-Konfiguration

api_key = "IHR_API_KEY"

base_url = "https://vip.apiyi.com/v1"

# Videodatei einlesen

with open("viral_video.mp4", "rb") as f:

video_base64 = base64.b64encode(f.read()).decode()

# Analyse durch Video-Verständnis

response = requests.post(

f"{base_url}/chat/completions",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "gemini-2.5-pro-preview",

"messages": [{

"role": "user",

"content": [

{"type": "video", "video": video_base64},

{"type": "text", "text": """Analysiere dieses Video und extrahiere die folgenden kreativen Elemente:

1. Kamerakomposition und Bildformat

2. Kamerabewegung (Zoom, Schwenk, Neigen, Fahrt, Fixiert etc.)

3. Beleuchtungsstil und Farbtonalität

4. Hauptaktion und Rhythmus

5. Beschreibung der Hintergrundumgebung

6. Schlüsselwörter für den visuellen Gesamtstil

Bitte bereite das Analyseergebnis als englische Eingabeaufforderung (Prompt) auf, die für Sora 2 verwendet werden kann."""}

]

}]

}

)

print(response.json()["choices"][0]["message"]["content"])

Schritt 3: Strukturierte Eingabeaufforderung generieren

Beispiel für ein Analyseergebnis des Video-Verständnisses:

Camera: Slow push-in, centered composition, shallow depth of field

Lighting: Soft diffused studio lighting, warm color temperature (3200K)

Subject: Premium leather handbag rotating on white marble pedestal

Movement: 360-degree rotation over 8 seconds, smooth and elegant

Style: Luxury commercial aesthetic, minimalist background

Color: Warm tones, high contrast, subtle vignette

Sora 2 Prompt:

"A premium leather handbag slowly rotating 360 degrees on a white marble

pedestal, soft diffused studio lighting with warm color temperature,

shallow depth of field, luxury commercial aesthetic, centered composition,

smooth cinematic movement, minimalist white background, high-end product

showcase style"

Schritt 4: Sora 2 generiert das Video im gleichen Stil

Geben Sie die extrahierte Eingabeaufforderung in Sora 2 ein, um ein neues Video zu erstellen:

# Neues Video mit der extrahierten Eingabeaufforderung generieren

sora_response = requests.post(

f"{base_url}/videos/generations",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "sora-2",

"prompt": extracted_prompt, # Die im vorherigen Schritt extrahierte Eingabeaufforderung

"aspect_ratio": "9:16",

"duration": 10

}

)

print(sora_response.json())

Empfehlung: Über APIYI (apiyi.com) können Sie gleichzeitig die APIs für Gemini Video-Verständnis und Sora 2 Videogenerierung aufrufen. So erledigen Sie den gesamten Workflow aus einer Hand, ohne mehrere Plattformen einzeln anbinden zu müssen.

Virale Hits replizieren – Schnelleinstieg

Minimalistisches Beispiel

Hier ist der vollständige Code zur Replikation eines viralen Videos, den Sie mit einem Klick ausführen können:

import requests

import base64

api_key = "IHR_API_KEY"

base_url = "https://vip.apiyi.com/v1"

def clone_viral_video(video_path: str) -> dict:

"""Virales Video mit einem Klick replizieren"""

# 1. Video einlesen

with open(video_path, "rb") as f:

video_b64 = base64.b64encode(f.read()).decode()

# 2. Gemini Video-Verständnis

analysis = requests.post(

f"{base_url}/chat/completions",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "gemini-2.5-pro-preview",

"messages": [{"role": "user", "content": [

{"type": "video", "video": video_b64},

{"type": "text", "text": "Analyze and generate Sora 2 prompt"}

]}]

}

).json()

prompt = analysis["choices"][0]["message"]["content"]

# 3. Sora 2 generiert ein neues Video

result = requests.post(

f"{base_url}/videos/generations",

headers={"Authorization": f"Bearer {api_key}"},

json={"model": "sora-2", "prompt": prompt}

).json()

return {"prompt": prompt, "video": result}

# Anwendung

result = clone_viral_video("competitor_video.mp4")

Vollständigen Implementierungscode anzeigen (inkl. Stapelverarbeitung und Fehlerbehandlung)

import requests

import base64

import time

from typing import Optional, List

from pathlib import Path

class ViralVideoCloner:

"""Tool-Klasse zur Replikation von viralen Videos"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.headers = {"Authorization": f"Bearer {api_key}"}

def analyze_video(self, video_path: str) -> str:

"""Verwendet Gemini zur Videoanalyse und Extraktion der Eingabeaufforderung"""

with open(video_path, "rb") as f:

video_b64 = base64.b64encode(f.read()).decode()

analysis_prompt = """Analyze this video and extract creative elements:

1. Camera movement and composition

2. Lighting style and color grading

3. Subject action and pacing

4. Background and environment

5. Overall visual style

Generate a detailed Sora 2 prompt in English that can recreate

a similar video with different products."""

response = requests.post(

f"{self.base_url}/chat/completions",

headers=self.headers,

json={

"model": "gemini-2.5-pro-preview",

"messages": [{

"role": "user",

"content": [

{"type": "video", "video": video_b64},

{"type": "text", "text": analysis_prompt}

]

}]

}

)

return response.json()["choices"][0]["message"]["content"]

def generate_video(

self,

prompt: str,

aspect_ratio: str = "9:16",

duration: int = 10

) -> dict:

"""Verwendet Sora 2 zur Generierung eines neuen Videos"""

response = requests.post(

f"{self.base_url}/videos/generations",

headers=self.headers,

json={

"model": "sora-2",

"prompt": prompt,

"aspect_ratio": aspect_ratio,

"duration": duration

}

)

return response.json()

def clone(

self,

video_path: str,

custom_subject: Optional[str] = None

) -> dict:

"""Vollständiger Workflow zur Video-Replikation"""

# Originalvideo analysieren

base_prompt = self.analyze_video(video_path)

# Falls ein benutzerdefiniertes Motiv angegeben wurde, Motivbeschreibung ersetzen

if custom_subject:

base_prompt = self._replace_subject(base_prompt, custom_subject)

# Neues Video generieren

result = self.generate_video(base_prompt)

return {

"original_video": video_path,

"extracted_prompt": base_prompt,

"generated_video": result

}

def batch_clone(self, video_paths: List[str]) -> List[dict]:

"""Mehrere Videos per Stapelverarbeitung replizieren"""

results = []

for path in video_paths:

result = self.clone(path)

results.append(result)

time.sleep(2) # Frequenzbegrenzung vermeiden

return results

def _replace_subject(self, prompt: str, new_subject: str) -> str:

"""Ersetzt das Hauptmotiv in der Eingabeaufforderung"""

# Vereinfachte Verarbeitung, in der Praxis können komplexere NLP-Methoden genutzt werden

return f"{new_subject}, {prompt}"

# Beispiel für die Nutzung

cloner = ViralVideoCloner("IHR_API_KEY")

result = cloner.clone(

"competitor_bestseller.mp4",

custom_subject="my product: wireless earbuds in charging case"

)

print(result["extracted_prompt"])

Empfehlung: Holen Sie sich über APIYI (apiyi.com) Ihr API-Guthaben für Gemini und Sora 2. Die Plattform ermöglicht eine zentrale Verwaltung von Aufrufen verschiedener Modelle und vereinfacht so Ihren Entwicklungsprozess.

Modellvergleich für die Videoverständnis-Analyse

| Modell | Videoverständnis | Max. Dauer | Anwendungsszenarien | Verfügbare Plattformen |

|---|---|---|---|---|

| Gemini 2.5 Pro | Visuelle + Audio-Dual-Stream-Analyse | ca. 6 Stunden | Deep Analysis von Langvideos | APIYI etc. |

| Gemini 2.5 Flash | Schnelle visuelle Analyse | ca. 1 Stunde | Schnelle Kurzvideo-Verarbeitung | APIYI etc. |

| GPT-4o | Visuelle Frame-Analyse | Kürzer | Einfaches Szenenverständnis | APIYI etc. |

Warum empfehlen wir Gemini für das Videoverständnis?

Die Gemini 2.5 Serie setzt in Benchmarks für Videoverständnis branchenweite Maßstäbe:

- Dual-Stream-Verarbeitung: Gleichzeitige Analyse von Video-Frames und Audiospuren für ein umfassenderes Verständnis.

- Extremer Kontext: Das Kontextfenster von 2 Millionen Token ermöglicht die Verarbeitung von bis zu 6 Stunden Videomaterial am Stück.

- Feingranulare Steuerung: Unterstützung für benutzerdefinierte Sampling-Raten und Auflösungsparameter.

- Zeitstempel-Lokalisierung: Präzise Referenzierung spezifischer Stellen im Video im MM:SS-Format.

Empfehlung: Wir raten zur Nutzung von Gemini 2.5 Pro für die detaillierte Videoanalyse. Der Zugriff erfolgt bequem und zentral über APIYI (apiyi.com).

Videoverständnis zur Replikation von Verkaufsschlagern – Anwendungsszenarien

Ideal für folgende E-Commerce-Szenarien:

- Wettbewerbsanalyse: Analysieren Sie die viralen Videos Ihrer Konkurrenten und extrahieren Sie die Erfolgsfaktoren.

- Style Transfer: Übertragen Sie Stile beliebter Videos auf Ihre eigenen Produkte.

- Massenproduktion: Erstellen Sie mithilfe einer Stilvorlage schnell mehrere Produktvideos.

- A/B-Tests: Generieren Sie verschiedene Stilvarianten für Anzeigentests.

| Szenario | Input | Output | Effizienzsteigerung |

|---|---|---|---|

| Wettbewerber-Replikation | Virales Video des Wettbewerbers | Eigenes Produktvideo im gleichen Stil | 10x |

| Style Transfer | Video mit beliebtm Stil | Stilisiertes Video des eigenen Produkts | 8x |

| Vorlagen-Batch | 1 Video-Template | N Produktvideos | 20x |

Häufig gestellte Fragen

Q1: Welche Formate und Längen werden für das Videoverständnis unterstützt?

Gemini unterstützt gängige Videoformate (MP4, MOV, AVI usw.). Dateien unter 100 MB können direkt inline übertragen werden, größere Dateien müssen über die File-API hochgeladen werden. Der Kontext von 2 Millionen Token in Gemini 1.5 Pro unterstützt theoretisch eine Videoanalyse von etwa 6 Stunden.

Q2: Müssen die extrahierten Eingabeaufforderungen manuell angepasst werden?

Die von der KI generierten Eingabeaufforderungen können normalerweise direkt verwendet werden. Es wird jedoch empfohlen, sie je nach Bedarf fein abzustimmen:

- Ersetzen Sie die Beschreibung des Hauptobjekts durch Ihr eigenes Produkt.

- Passen Sie Parameter für Dauer und Seitenverhältnis an.

- Fügen Sie markenrelevante Stil-Keywords hinzu.

Q3: Wie kann ich schnell mit dem Testen von Videoverständnis und Replikation beginnen?

Es wird empfohlen, eine API-Aggregationsplattform zu nutzen, die mehrere Modelle unterstützt:

- Besuchen Sie APIYI (apiyi.com) und registrieren Sie ein Konto.

- Erhalten Sie Ihren API-Key und kostenloses Guthaben.

- Verwenden Sie die Codebeispiele aus diesem Artikel für eine schnelle Validierung.

- Gemini Videoverständnis + Sora 2 Generierung – alles aus einer Hand.

Zusammenfassung

Die Kernpunkte für die Replikation von Video-Blockbustern:

- Video-Verständnis ist der Schlüssel: Die multimodalen Fähigkeiten von Gemini können die kreativen Elemente eines Videos präzise extrahieren.

- Automatisierung des Prompt-Engineerings: Die KI wandelt visuelle Analysen automatisch in nutzbare Eingabeaufforderungen für die Generierung um.

- One-Stop-Workflow: Eine einheitliche API-Anbindung für Gemini + Sora 2 vereinfacht den Entwicklungsprozess.

Mit diesem Workflow können E-Commerce-Betreiber die Stile erfolgreicher Branchen-Videos schnell replizieren und die Kosten für das Ausprobieren bei der Videoerstellung erheblich senken.

Wir empfehlen die schnelle Überprüfung der Ergebnisse über APIYI (apiyi.com). Die Plattform bietet sowohl die Video-Verständnis-API von Gemini als auch die Video-Generierungs-API von Sora 2 an, sodass der gesamte Replikationsprozess an einem Ort abgeschlossen werden kann.

📚 Referenzen

⚠️ Format-Hinweis für Links: Alle externen Links verwenden das Format

Name der Quelle: domain.com. Dies erleichtert das Kopieren, verhindert jedoch anklickbare Sprünge, um den Verlust von SEO-Autorität zu vermeiden.

-

Offizielle Dokumentation zum Gemini Video-Verständnis: Detaillierte API-Parameter und Verwendungsmethoden

- Link:

ai.google.dev/gemini-api/docs/video-understanding - Beschreibung: Offizielle maßgebliche Dokumentation, um den vollen Funktionsumfang des Video-Verständnisses zu verstehen.

- Link:

-

Sora 2 Leitfaden für Eingabeaufforderungen: Offizielle Best Practices für Eingabeaufforderungen von OpenAI

- Link:

cookbook.openai.com/examples/sora/sora2_prompting_guide - Beschreibung: Lernen Sie, wie man qualitativ hochwertige Eingabeaufforderungen für die Videogenerierung schreibt.

- Link:

-

Leitfaden für Reverse Prompt Engineering: Technische Details zu Video-to-Prompt

- Link:

skywork.ai/skypage/en/Video-to-Prompt-A-Hands-On-Guide - Beschreibung: Tiefgreifendes Verständnis der Funktionsweise von Video-to-Prompt.

- Link:

Autor: Technik-Team

Technischer Austausch: Willkommen zur Diskussion im Kommentarbereich. Weitere Informationen finden Sie in der Technik-Community von APIYI (apiyi.com).