想用 AI 批量生成带原生音频的 2K 高清视频,却发现 Seedance 2.0 API 还没正式开放?这是很多开发者和内容创作者当前面临的困境。本文将全面解析 Seedance 2.0 的 5 大核心能力,帮助你提前掌握这款字节跳动最新视频生成模型的技术架构和 API 接入方法。

核心价值: 读完本文,你将全面了解 Seedance 2.0 的技术能力、API 接入方式和最佳实践,在 API 正式开放后第一时间完成接入。

Seedance 2.0 API 核心信息速览

在深入技术细节之前,先快速了解 Seedance 2.0 的关键信息。

| 信息项 | 详情 |

|---|---|

| 模型名称 | Seedance 2.0(字节跳动 Seed 系列) |

| 发布方 | 字节跳动(ByteDance) |

| API 预计上线 | 2025 年 2 月 24 日(火山引擎/BytePlus) |

| 当前可用渠道 | 即梦(Dreamina)网站、火山引擎/BytePlus 后台在线调试 |

| 输出分辨率 | 最高 2K(支持 1080p 生产级输出) |

| 视频时长 | 4-15 秒 |

| 支持宽高比 | 16:9、9:16、4:3、3:4、21:9、1:1 |

| 输入模态 | 文本 + 图片(0-5张)+ 视频 + 音频 |

| 原生音频 | 支持对话、环境音、音效的同步生成 |

| 可用平台 | 即梦、火山引擎、APIYI apiyi.com(API 上线后同步支持) |

🎯 重要提示: Seedance 2.0 API 预计 2 月 24 日上线。届时开发者可以通过 APIYI apiyi.com 平台使用统一接口快速接入,无需单独对接火山引擎。

Die 5 Kernfunktionen der Seedance 2.0 API

Seedance 2.0 stellt im Vergleich zur Vorgängergeneration Seedance 1.5 Pro ein umfassendes Upgrade dar. Hier sind die 5 Kernfunktionen, die für Entwickler am wichtigsten sind.

Seedance 2.0 Kernfunktion 1: Text-zu-Video (Text-to-Video)

Die Text-zu-Video-Funktion von Seedance 2.0 ist die grundlegendste und zugleich leistungsstärkste Funktion. Sie müssen lediglich eine Textbeschreibung eingeben, und das Modell generiert hochwertige Videoinhalte.

Wichtige Verbesserungen gegenüber Version 1.5:

| Dimension der Verbesserung | Seedance 1.5 Pro | Seedance 2.0 | Ausmaß der Steigerung |

|---|---|---|---|

| Physikalische Realitätstreue | Basis-Physiksimulation | Präzise Schwerkraft, Impuls, Kausalität | Deutliche Steigerung |

| Bewegungsdynamik | Glatt, aber teils unnatürlich | Hochgradig natürliche Bewegungskontinuität | Deutliche Steigerung |

| Bildästhetik | HD-Qualität | Filmreife ästhetische Textur | Spürbare Steigerung |

| Bildauflösung | 1080p | Bis zu 2K | Verdoppelung der Auflösung |

| Szenengenerierung | Fokus auf Einzelszenen | Automatische Szenen-/Storyboard-Generierung | Neue Funktion |

| Generationsgeschwindigkeit | Standardgeschwindigkeit | Ca. 30 % schneller | Effizienzsteigerung |

Das Verständnis physikalischer Gesetze hat in Seedance 2.0 ein neues Niveau erreicht – in komplexen Bewegungsabläufen bleiben Schwerkraft, Impuls und Kausalität präzise erhalten. Das bedeutet, dass die Bewegungsbahnen von Objekten, Kollisionseffekte und Interaktionen mit der Umgebung in Ihren generierten Videos wesentlich realistischer und glaubwürdiger wirken.

Die automatische Storyboard-Funktion ist ein Highlight der Text-zu-Video-Funktion von Seedance 2.0. Das Modell kann einen narrativen Text automatisch in mehrere zusammenhängende Einstellungen zerlegen und dabei sicherstellen, dass das Aussehen der Charaktere, Umgebungsdetails und die erzählerische Kontinuität zwischen den verschiedenen Einstellungen konsistent bleiben.

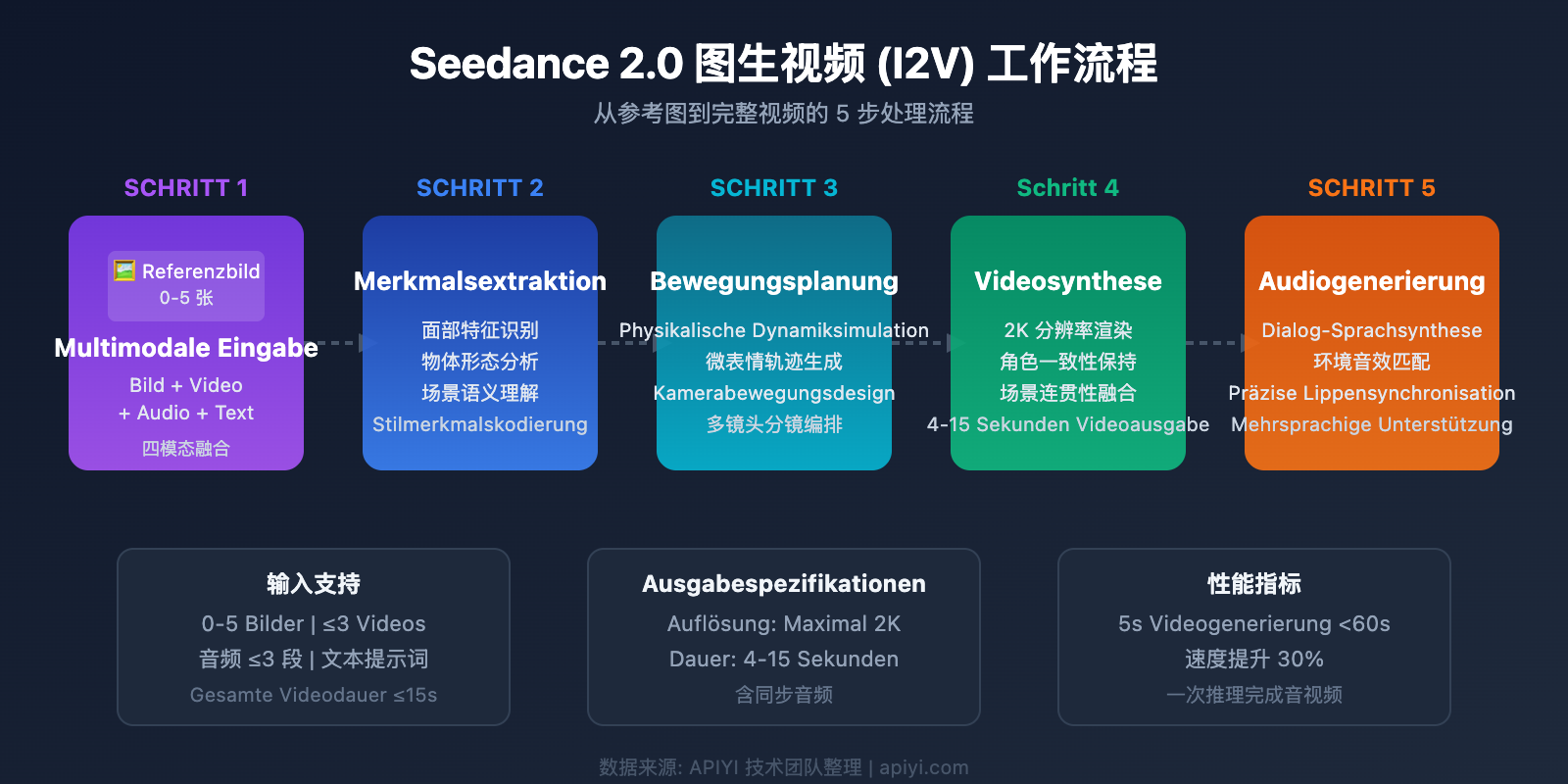

Seedance 2.0 Kernfunktion 2: Bild-zu-Video (Image-to-Video)

Bild-zu-Video ist die Fähigkeit, statische Referenzbilder in dynamische Videos zu verwandeln. Seedance 2.0 hat in diesem Bereich einen Quantensprung gemacht.

Zentrale Upgrade-Punkte:

- Optimierung von Mikroexpressionen: Die Mimik von Charakteren ist feiner und natürlicher; Übergänge beim Blinzeln, Lächeln oder Stirnrunzeln verlaufen flüssig.

- Bewegungskontinuität: Der Übergang vom statischen Bild zum dynamischen Video ist natürlicher, ohne Frame-Sprünge oder Ruckeln.

- Charakterkonsistenz: Gesichtszüge, Kleidung und Körperbau der Charaktere bleiben über verschiedene Winkel und Sequenzen hinweg konsistent.

- Objektkonsistenz: Form, Position sowie Licht- und Schattenverhältnisse von Objekten in der Szene bleiben stabil.

- Szenenkohärenz: Die Hintergrundumgebung weist während der Videowiedergabe keine abrupten Veränderungen auf.

- Produktdetaildarstellung: Die Fähigkeit, Texturen, Logos, Verpackungen und andere Details von Waren zu reproduzieren, wurde deutlich gestärkt.

🎯 Business-Tipp: Die verbesserte Darstellung von Produktdetails macht Seedance 2.0 besonders attraktiv für die Erstellung von E-Commerce-Produktvideos. Über APIYI (apiyi.com) können Sie die Seedance 2.0 API aufrufen, um Präsentationsvideos für Ihre Produkte in Serie zu generieren.

Seedance 2.0 Kernfunktion 3: Multi-Referenzbilder und multimodale Eingabe

Dies ist eine der am stärksten differenzierenden Fähigkeiten von Seedance 2.0. Das Modell unterstützt den gleichzeitigen Empfang verschiedener Eingabemodalitäten, um eine präzise kreative Steuerung zu ermöglichen.

Vier-Modalitäten-Eingabesystem:

| Eingabemodalität | Unterstützte Anzahl | Verwendungszweck |

|---|---|---|

| Bilder | 0-5 Stück (bis zu 9 möglich) | Charakter-Referenz, Szenen-Referenz, Stil-Referenz |

| Videos | Bis zu 3 Segmente (Gesamtdauer ≤15s) | Bewegungsreferenz, Kamerabewegungsreferenz |

| Audio | Bis zu 3 Segmente (MP3, Gesamtdauer ≤15s) | Rhythmusreferenz, Dialogreferenz, Umgebungsgeräuschreferenz |

| Text | Natürliche Sprachbeschreibung | Szenenbeschreibung, Bewegungsanweisungen, Stilvorgaben |

Die Suchfähigkeit für Multi-Referenzbilder ist ein einzigartiger Vorteil von Seedance 2.0. Sie können 0 bis 5 Referenzbilder bereitstellen, aus denen das Modell Schlüsselmerkmale extrahiert und in das generierte Video integriert. Zum Beispiel:

- 1 Gesichtsbild + 1 Bewegungsvideo + 1 Audiorhythmus → Generierung eines Videos, in dem ein bestimmter Charakter im Takt tanzt.

- 3 Produktbilder aus verschiedenen Winkeln → Generierung eines 360-Grad-Präsentationsvideos des Produkts.

- 1 Szenenbild + Textbeschreibung → Generierung eines Videos mit einer spezifischen Aktion in der vorgegebenen Szene.

Seedance 2.0 Kernfunktion 4: Native Audiogenerierung

Seedance 2.0 bietet die branchenweit erste native audio-visuelle Co-Generation. In einem einzigen Inferenzprozess werden Videobild und Audioinhalt synchron generiert.

Highlights der Audio-Fähigkeiten:

- Dialoggenerierung: Unterstützt Sprachgenerierung in Chinesisch, Englisch, Spanisch und weiteren Sprachen mit präziser Lippensynchronität.

- Umgebungsgeräusche: Automatische Generierung von zum Bild passenden Umgebungsgeräuschen (Wind, Wasser, Stadtlärm etc.).

- Sound-Synchronisation: Aktionsgeräusche sind präzise mit den Bewegungen im Bild synchronisiert (Schritte, Kollisionen etc.).

- Referenz-Echtstimmen: Unterstützt die Eingabe von realen Referenzstimmen für mehr als zwei Sprecher.

- Sprachgenauigkeit: Die Genauigkeit der Sprachgenerierung für Sprachen wie Chinesisch, Englisch und Spanisch wurde deutlich verbessert.

- Keine Nachbearbeitung nötig: Während herkömmliche Workflows das separate Hinzufügen von Soundeffekten und Synchronisation erfordern, erledigt Seedance 2.0 dies in einem Schritt.

Das bedeutet für Entwickler, dass sie mit einem einzigen API-Aufruf direkt eine Videodatei mit vollständigem Audio erhalten, was den Produktionsprozess erheblich vereinfacht.

Seedance 2.0 Kernfunktion 5: Videobearbeitung und -fortsetzung

Neben der Generierung von Videos aus dem Nichts unterstützt Seedance 2.0 auch die Bearbeitung und Fortsetzung bestehender Videos.

| Bearbeitungsfunktion | Beschreibung | Einschränkungen |

|---|---|---|

| Videofortsetzung | Natürliche Erweiterung von Bild und Handlung basierend auf einem vorhandenen Video | Eingabevideo ≤15s |

| Video-Vervollständigung | Intelligente Ergänzung fehlender Teile in einem Video | Eingabevideo ≤15s |

| Eingeschränkte Bearbeitung | Anpassung von Stil, Farbton etc. bei Kurzvideos | Eingabevideo <15s |

| Gleichzeitige Eingabe | Unterstützt die gleichzeitige Eingabe von Bildern und Videos als Referenz | Gesamtmenge Bild + Video begrenzt |

Seedance 2.0 API Integrations-Tutorial

Aktueller Status der Seedance 2.0 API

Stand der Veröffentlichung dieses Artikels (Februar 2025) ist der Status der Seedance 2.0 API wie folgt:

- Volcengine (火山引擎): Noch nicht offiziell gestartet, Online-Debugging im Backend verfügbar.

- BytePlus (internationale Version): Noch nicht offiziell gestartet, Online-Debugging im Backend verfügbar.

- Jimeng (Dreamina): Über die Website-Oberfläche erlebbar.

- Offizieller API-Launch: Voraussichtlich am 24. Februar 2025.

Für Entwickler, die bereits die Seedance 1.5 Pro oder Seedream 4.5 API nutzen, gibt es gute Nachrichten: Die API-Schnittstelle von Seedance 2.0 ist hochgradig kompatibel, sodass der Migrationsaufwand extrem gering ist.

Seedance 2.0 API Quick Start Code

Hier ist ein einfaches Code-Beispiel für den Aufruf der Seedance 2.0 API (basierend auf dem Volcengine API-Stil, nach dem offiziellen Launch direkt verwendbar):

Text-zu-Video (T2V) Minimalbeispiel

import requests

import json

# Aufruf der Seedance 2.0 API über APIYI

API_BASE = "https://api.apiyi.com/v1"

API_KEY = "your-api-key"

def text_to_video(prompt, aspect_ratio="16:9", duration=5):

"""Seedance 2.0 Text-zu-Video-Aufruf"""

response = requests.post(

f"{API_BASE}/video/generations",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

},

json={

"model": "seedance-2.0",

"prompt": prompt,

"aspect_ratio": aspect_ratio,

"duration": duration,

"audio": True # Native Audiogenerierung aktivieren

}

)

return response.json()

# Ein Video mit Audio generieren

result = text_to_video(

prompt="Ein Golden Retriever rennt am Strand entlang, Sonnenlicht glitzert auf dem Meer, Wellen schlagen gegen das Ufer",

aspect_ratio="16:9",

duration=8

)

print(f"Video-URL: {result['data']['url']}")

print(f"Audio synchron generiert: {result['data']['has_audio']}")

Vollständigen Code für Bild-zu-Video (I2V) anzeigen

import requests

import json

import base64

from pathlib import Path

API_BASE = "https://api.apiyi.com/v1"

API_KEY = "your-api-key"

def image_to_video(image_paths, prompt, aspect_ratio="16:9", duration=5):

"""

Seedance 2.0 Bild-zu-Video-Aufruf

Unterstützt die Eingabe von 0-5 Referenzbildern

"""

# Referenzbilder kodieren

images = []

for path in image_paths:

with open(path, "rb") as f:

img_data = base64.b64encode(f.read()).decode()

images.append({

"type": "image",

"data": img_data

})

response = requests.post(

f"{API_BASE}/video/generations",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

},

json={

"model": "seedance-2.0",

"prompt": prompt,

"references": images,

"aspect_ratio": aspect_ratio,

"duration": duration,

"audio": True,

"resolution": "2k" # 2K-Auflösung verwenden

}

)

result = response.json()

if result.get("status") == "processing":

task_id = result["data"]["task_id"]

print(f"Task übermittelt, ID: {task_id}")

# Asynchrone Tasks erfordern Polling für das Ergebnis

return poll_result(task_id)

return result

def poll_result(task_id, max_wait=300):

"""Polling für Video-Generierungsergebnisse"""

import time

for _ in range(max_wait // 5):

time.sleep(5)

resp = requests.get(

f"{API_BASE}/video/generations/{task_id}",

headers={"Authorization": f"Bearer {API_KEY}"}

)

data = resp.json()

if data["data"]["status"] == "completed":

return data

elif data["data"]["status"] == "failed":

raise Exception(f"Generierung fehlgeschlagen: {data['data']['error']}")

raise TimeoutError("Zeitüberschreitung beim Warten")

# Beispiel: Produktvideo aus Fotos erstellen

result = image_to_video(

image_paths=["product_front.jpg", "product_side.jpg"],

prompt="360-Grad-Produktpräsentation, weiche Beleuchtung, weißer Hintergrund",

aspect_ratio="1:1",

duration=6

)

print(f"Video generiert: {result['data']['url']}")

🚀 Schnellstart: Wir empfehlen den Zugriff auf die Seedance 2.0 API über die Plattform APIYI (apiyi.com). Diese bietet eine einheitliche, mit Volcengine kompatible Schnittstelle. Sie müssen keinen separaten Volcengine-Account registrieren und können die Integration in nur 5 Minuten abschließen.

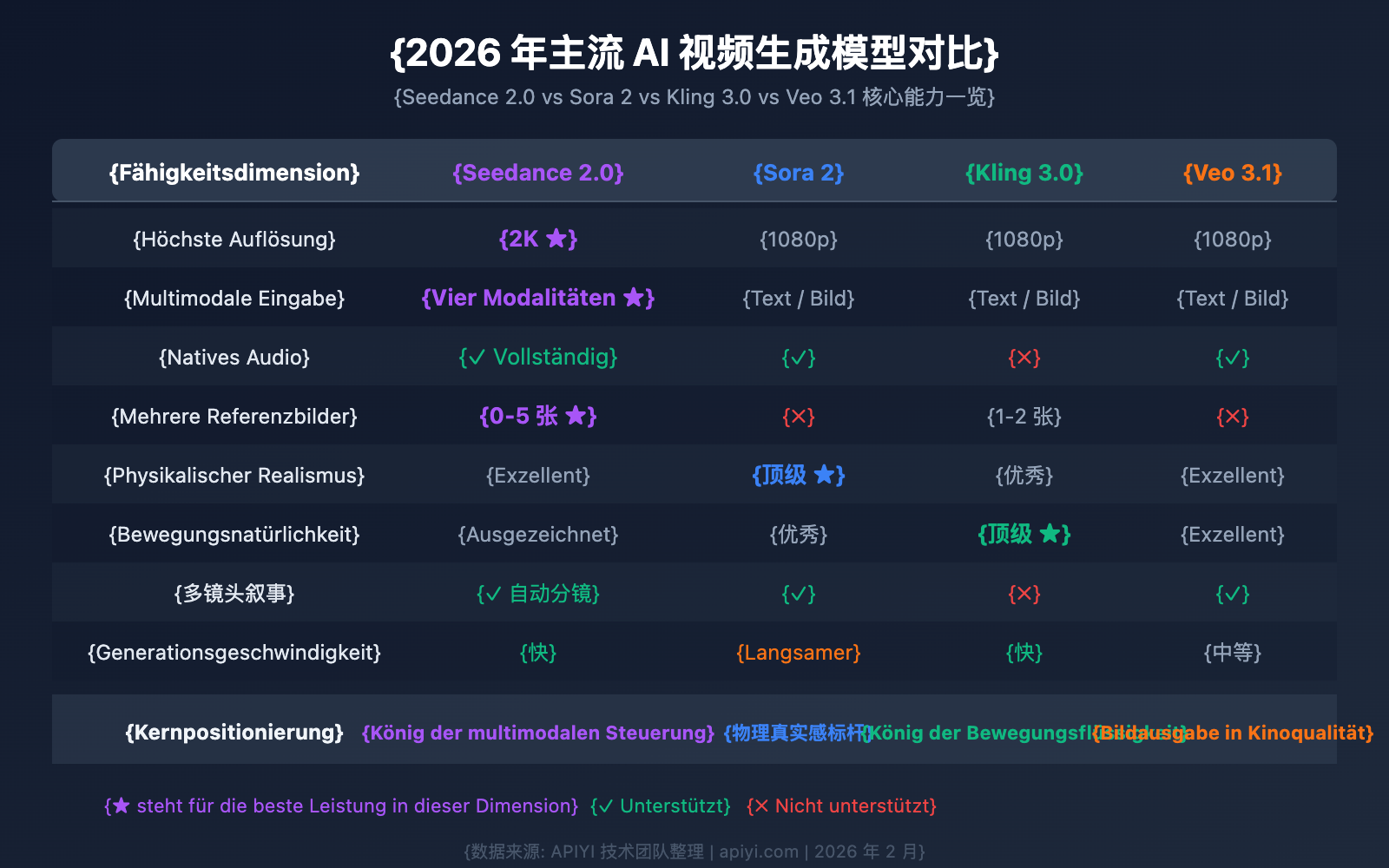

Seedance 2.0 im Vergleich zu führenden AI-Videomodellen

Die Einordnung von Seedance 2.0 im aktuellen Bereich der KI-Videogenerierung hilft Ihnen dabei, die richtige technologische Wahl zu treffen.

| Vergleichsdimension | Seedance 2.0 | Sora 2 | Kling 3.0 | Veo 3.1 |

|---|---|---|---|---|

| Höchste Auflösung | 2K | 1080p | 1080p | 1080p |

| Videodauer | 4-15s | 5-20s | 5-10s | 5-8s |

| Natives Audio | ✅ Volle Unterstützung | ✅ Unterstützung | ❌ Nicht unterstützt | ✅ Unterstützung |

| Mehrere Referenzbilder | ✅ 0-5 Bilder | ❌ Nicht unterstützt | ✅ 1-2 Bilder | ❌ Nicht unterstützt |

| Multimodaler Input | Vier Modalitäten (Text/Bild/Video/Audio) | Text/Bild | Text/Bild | Text/Bild |

| Physikalische Realität | Exzellent | Spitzenklasse | Exzellent | Exzellent |

| Natürlichkeit der Bewegung | Exzellent | Exzellent | Spitzenklasse | Exzellent |

| Multi-Shot-Narrativ | ✅ Auto-Storyboard | ✅ Unterstützung | ❌ Nicht unterstützt | ✅ Unterstützung |

| Videobearbeitung | ✅ Eingeschränkt | ✅ Unterstützung | ❌ Nicht unterstützt | ❌ Nicht unterstützt |

| Generierungsgeschwindigkeit | Schnell (5s Video < 60s) | Etwas langsamer | Schnell | Mittel |

| API-Verfügbarkeit | Launch am 24. Feb | Verfügbar | Verfügbar | Verfügbar |

| Verfügbare Plattformen | Volcengine, APIYI apiyi.com | OpenAI | Kuaishou |

Die einzigartigen Vorteile von Seedance 2.0

Seedance 2.0 bietet in den folgenden drei Bereichen deutliche Differenzierungsvorteile:

- Vier-Modalitäten-Input-System: Aktuell das einzige Videomodell, das die gleichzeitige Eingabe von Text, Bild, Video und Audio unterstützt. Die Präzision der kreativen Steuerung übertrifft vergleichbare Produkte bei weitem.

- Suche über mehrere Referenzbilder: Unterstützt die Merkmalsextraktion und Fusion von 0 bis 5 Referenzbildern. Dies eignet sich besonders für kommerzielle Anwendungen, die eine präzise Kontrolle über Charaktere und Szenen erfordern.

- Native 2K-Auflösung: Die derzeit höchste Ausgabeauflösung unter vergleichbaren Modellen, was den Anforderungen professioneller Content-Produktion gerecht wird.

💡 Empfehlung zur Auswahl: Welches Videomodell Sie wählen sollten, hängt von Ihrem spezifischen Anwendungsfall ab. Wenn Sie präzise multimodale Steuerung und 2K-Auflösung benötigen, ist Seedance 2.0 die beste Wahl. Wir empfehlen, über die Plattform APIYI (apiyi.com) mehrere Modelle gleichzeitig zu testen. Die Plattform unterstützt eine einheitliche Schnittstelle für Seedance 2.0, Sora 2 und andere führende Videomodelle, was einen schnellen Ergebnisvergleich ermöglicht.

Typische Anwendungsszenarien der Seedance 2.0 API

Die multimodalen Fähigkeiten von Seedance 2.0 machen es ideal für eine Vielzahl von geschäftlichen und kreativen Szenarien.

E-Commerce-Produktvideos

Dank der Image-to-Video-Funktion und der Unterstützung mehrerer Referenzbilder können Händler aus nur wenigen Produktfotos schnell hochwertige Präsentationsvideos erstellen. Besonders die verbesserte Detaildarstellung von Seedance 2.0 ermöglicht eine präzise Wiedergabe von Texturen, Logos und Verpackungen.

Erstellung von Kurzvideo-Inhalten

Die automatische Storyboard-Funktion von Text-to-Video und die native Audiogenerierung ermöglichen es Creatorn, aus einer einfachen Textbeschreibung direkt Kurzvideos mit vollständiger Vertonung und Soundeffekten zu erstellen. Dies senkt die Hürden für die Content-Produktion erheblich.

Digitale Menschen und virtuelle Moderatoren

Die Optimierung von Mikroexpressionen und die mehrsprachige Sprachgenerierung (unterstützt Chinesisch, Englisch, Spanisch usw.) ermöglichen in Kombination mit Referenz-Audioeingaben die Erstellung von Videos mit ausdrucksstarken digitalen Charakteren und präziser Lippensynchronisation.

Batch-Erstellung von Werbematerialien

Durch die Kombination von Multi-Referenzbild-Eingaben und Videobearbeitungsfunktionen können Werbeteams basierend auf demselben Ausgangsmaterial schnell mehrere Versionen von Werbevideos für A/B-Tests erstellen.

Seedance 2.0 API – Häufig gestellte Fragen (FAQ)

Q1: Wann kann die Seedance 2.0 API offiziell genutzt werden?

Laut internen Informationen wird die Seedance 2.0 API voraussichtlich am 24. Februar 2025 offiziell an den Start gehen. Die API-Dienste werden dann über Volcano Engine (Volcano Ark) und BytePlus bereitgestellt. Wenn Sie die API so früh wie möglich nutzen möchten, empfehlen wir Ihnen, die Plattform APIYI (apiyi.com) im Auge zu behalten. Diese Plattform wird nach dem Launch der API zeitnah einen einheitlichen Schnittstellenzugang für Seedance 2.0 anbieten.

Q2: Ist der Aufwand für die Migration von Seedance 1.5 Pro auf 2.0 hoch?

Die Migrationskosten sind extrem niedrig. Die API-Schnittstelle von Seedance 2.0 ist hochgradig kompatibel mit der Version 1.5 Pro. Die wichtigsten Änderungen betreffen neue Parameter wie die Unterstützung mehrerer Referenzbilder und Audio-Eingaben. Bestehender Code für Text-to-Video- und Image-to-Video-Aufrufe kann im Grunde ohne Änderungen unter Version 2.0 weiterbetrieben werden.

Q3: Wie hoch sind die Gebühren für die Nutzung der Seedance 2.0 API?

Die offiziellen Preise für Seedance 2.0 wurden noch nicht bekannt gegeben. Basierend auf dem Preismodell von Seedance 1.5 Pro ist jedoch davon auszugehen, dass die Abrechnung nach Videolänge und Auflösung erfolgt. Wir empfehlen, die Plattform APIYI (apiyi.com) für aktuelle Preisinformationen zu besuchen, da diese oft flexiblere Abrechnungsmodelle anbietet.

Q4: Gibt es derzeit eine Möglichkeit, Seedance 2.0 vorab zu testen?

Sie können Seedance 2.0 über die folgenden Wege ausprobieren:

- Dreamina-Website: Besuchen Sie die offizielle Website

jimeng.jianying.com, um Seedance 2.0 direkt online zu nutzen. - Volcano Engine Backend: Melden Sie sich in der Volcano Engine Konsole an; im Bereich "Modell-Debugging" können Online-Tests durchgeführt werden.

- BytePlus Backend: Internationale Nutzer können Seedance 2.0 über die BytePlus-Konsole testen.

Q5: Welche Sprachen werden bei der Audiogenerierung von Seedance 2.0 unterstützt?

Die native Audiogenerierung von Seedance 2.0 unterstützt eine Vielzahl von Sprachen, darunter Chinesisch, Englisch, Spanisch und weitere. In Bezug auf die Genauigkeit der Sprachausgabe gab es signifikante Verbesserungen, insbesondere bei der Präzision der Lippensynchronisation und der Natürlichkeit der Intonation.

Zusammenfassung der Seedance 2.0 API-Integration

Seedance 2.0, die neueste Generation des Videogenerierungsmodells von ByteDance, hat signifikante Durchbrüche in den Bereichen multimodaler Input, natives Audio und 2K-Auflösung erzielt. Besonders das Vier-Modalitäten-Input-System und die Suchfunktion für mehrere Referenzbilder bieten Entwicklern eine beispiellose Präzision bei der kreativen Steuerung.

Kernpunkte im Überblick:

- Unterstützt Vier-Modalitäten-Input: Text + Bild (0-5 Bilder) + Video + Audio.

- Native 2K-Auflösung bei einer um 30 % gesteigerten Generierungsgeschwindigkeit.

- Branchenweit erste synchrone Co-Generierung von Audio und Video – ein einziger Aufruf liefert ein vollständiges Video.

- Automatisches Storytelling mit mehreren Kameraeinstellungen (Multi-Shot) bei hoher Konsistenz von Charakteren und Szenen.

- API-Start voraussichtlich am 24. Februar, mit hoher Kompatibilität zur 1.5 Pro-Schnittstelle.

Wir empfehlen den schnellen Zugriff auf die Seedance 2.0 API über APIYI (apiyi.com). Die Plattform ermöglicht den Aufruf verschiedener gängiger Videogenerierungsmodelle über eine einheitliche Schnittstelle, was den Qualitätsvergleich und die Auswahl der passenden Lösung erleichtert.

Dieser Artikel wurde vom APIYI-Technikteam verfasst, das die neuesten Trends im Bereich der KI-Videogenerierung verfolgt. Weitere Tutorials zur Nutzung von KI-Modellen finden Sie im Hilfe-Center von APIYI unter apiyi.com.

Referenzen

-

Offizielle Seedance-Vorstellung: Dokumentation der Seed-Modellserie von ByteDance

- Link:

byteplus.com/en/product/seedance

- Link:

-

Dreamina-Plattform (Jimeng): Online-Zugang zum Ausprobieren von Seedance 2.0

- Link:

jimeng.jianying.com

- Link:

-

Volcengine ModelArk: Aufzeichnungen zur Modellveröffentlichung

- Link:

docs.byteplus.com/en/docs/ModelArk/1159178

- Link: