Примечание автора: Раскрываем истинные причины частых перегрузок API Nano Banana Pro — от архитектуры собственных чипов TPU до различий между AI Studio и Vertex AI. Поможем разобраться в технической подоплеке дефицита мощностей.

С момента запуска Nano Banana Pro в ноябре 2025 года разработчики столкнулись с загадочным явлением: несмотря на то, что у Google есть собственные чипы TPU, этот API для генерации изображений постоянно выдает ошибку «Model overloaded» (модель перегружена). Почему свои чипы не решают проблему нехватки вычислительных мощностей? В чем принципиальная разница между платформами AI Studio и Vertex AI? В этой статье мы заглянем в «подкапот» вычислительной архитектуры Google, чтобы понять техническую правду.

Ключевая ценность: На основе реальных данных и анализа архитектуры мы поможем вам понять причины нестабильности Nano Banana Pro и выбрать наиболее надежный способ интеграции API.

Ключевые проблемы стабильности Nano Banana Pro API

С момента запуска в ноябре 2025 года Nano Banana Pro (gemini-2.0-flash-preview-image-generation) постоянно сталкивается с кризисом стабильности. Ниже приведены данные по основным проблемам, о которых сообщает сообщество разработчиков:

| Тип проблемы | Частота | Типичные проявления | Кто затронут |

|---|---|---|---|

| 503 Перегрузка модели | Высокая (70%+ всех ошибок) | Время отклика резко возрастает с 30 до 60–100 секунд | Все уровни пользователей (включая платный Tier 3) |

| 429 Ресурс исчерпан | Около 70% ошибок API | Срабатывает, даже если нагрузка значительно ниже лимитов квоты | Бесплатный уровень и платный Tier 1 |

| Внезапное сокращение квот | 7 декабря 2025 г. | Лимит бесплатного уровня снижен с 3 до 2 изображений в день, 2.5 Pro удалена из бесплатного доступа | Все пользователи бесплатного уровня по всему миру |

| Сервис недоступен | Эпизодически | Вчера генерация летала, сегодня сервис полностью недоступен | Разработчики приложений, зависящие от бесплатного уровня |

Первопричина проблем со стабильностью Nano Banana Pro

Корень этих проблем кроется не в дефектах кода, а в нехватке вычислительных мощностей на стороне серверов Google. Тот факт, что даже пользователи платного уровня Tier 3 (с максимальными квотами) сталкиваются с ошибками перегрузки при низкой частоте запросов, говорит о проблемах на уровне инфраструктуры, а не управления пользовательскими лимитами.

Согласно официальным ответам Google на форумах разработчиков, вычислительные ресурсы сейчас перераспределяются в пользу новых моделей серии Gemini 2.0. Это ограничивает доступные мощности для моделей генерации изображений, таких как Nano Banana Pro. Такая стратегия распределения ресурсов напрямую приводит к нестабильности сервиса.

🎯 Технический совет: При использовании Nano Banana Pro в продакшене рекомендуем подключаться через платформу APIYI (apiyi.com). Она предлагает механизмы интеллектуальной балансировки нагрузки и автоматического переключения при сбоях (failover), что позволяет значительно повысить процент успешных вызовов и общую стабильность работы.

Вся правда об архитектуре чипов Google TPU

Многие думают, что наличие у Google собственных чипов TPU (Tensor Processing Unit) должно легко закрывать все потребности в вычислительных мощностях для ИИ-моделей. Но на деле всё гораздо сложнее.

Новейшая архитектура TPU v7 (Ironwood)

В апреле 2025 года на конференции Cloud Next Google представила седьмое поколение своих процессоров — Ironwood. На сегодняшний день это самая мощная версия:

| Параметры архитектуры | TPU v7 (Ironwood) | TPU v6e (Trillium) | Прирост |

|---|---|---|---|

| Пиковая производительность | 4 614 TFLOP/s | ~2 300 TFLOP/s | ~100% |

| Энергоэффективность | Базис | Эталон | +100% производительности на ватт |

| Конфигурация кластера | 256 чипов / 9 216 чипов | Одна конфигурация | Гибкое масштабирование |

| Матричные блоки | 256×256 MXU (systolic array) | 128×128 MXU | 4-кратная плотность вычислений |

| Сценарии использования | Приоритет инференса (Inference-first) | Смешанный (обучение + инференс) | Оптимизировано под инференс |

Основные компоненты архитектуры TPU

Каждый чип TPU содержит одно или несколько ядер TensorCore, каждое из которых состоит из:

- Блок матричного умножения (MXU): В версиях TPU v6e и v7x используется массив умножителей-сумматоров 256×256 (в ранних версиях было 128×128).

- Векторный юнит: Отвечает за нематричные вычисления.

- Скалярный юнит: Управляет логикой исполнения.

Такая архитектура «систолической матрицы» (systolic array) идеально подходит для инференса нейросетей, но у неё есть свои ограничения.

Почему свои чипы не решают проблему дефицита мощностей?

Несмотря на мощь TPU v7, проблемы со стабильностью Nano Banana Pro никуда не делись. И на это есть три причины:

1. Цикл наращивания производства

TPU v7 анонсировали в апреле 2025 года, но массовое развёртывание требует времени. В конце 2025-го Google объявила о партнерстве с Anthropic на 10 миллиардов долларов, планируя запустить более 1 ГВт мощностей для ИИ к 2026 году. Это значит, что период с ноября 2025 по начало 2026 года — это переходный этап, когда старая и новая архитектуры сменяют друг друга, создавая дефицит ресурсов.

2. Взрывной рост спроса

После выхода линейки Gemini 2.0 в конце 2025 года объем API-запросов превысил все прогнозы Google. Наплыв бесплатных пользователей (особенно для генерации изображений в Nano Banana Pro) начал напрямую «съедать» ресурсы, зарезервированные для платных клиентов.

3. Приоритеты распределения ресурсов

Google приходится балансировать между разными продуктами: Gemini 2.5 Pro (текст), Gemini 2.0 Flash (мультимодальность), Nano Banana Pro (изображения) и другими. Когда мощностей не хватает, приоритет отдается моделям с более высокой коммерческой ценностью, что и приводит к ограничениям (capacity limits) для Nano Banana Pro.

🎯 Инсайд: Наличие собственных чипов TPU не означает бесконечные ресурсы. Мощности заводов, темпы строительства дата-центров и энергоснабжение — всё это сдерживающие факторы. Мы рекомендуем корпоративным пользователям использовать платформу APIYI (apiyi.com) для мультиоблачного управления ресурсами, чтобы избежать рисков, связанных с лимитами одного поставщика.

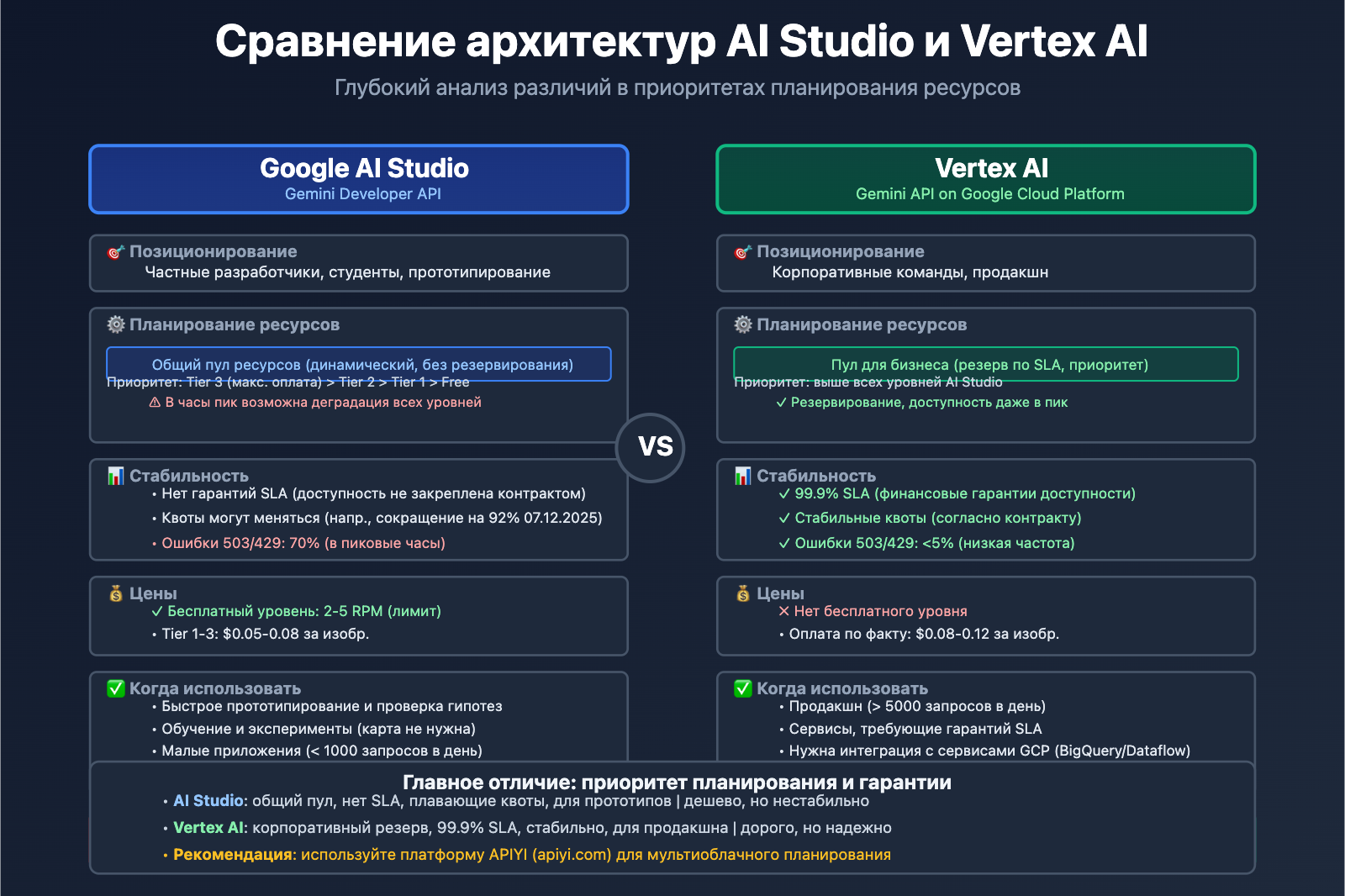

AI Studio vs Vertex AI: в чем реальная разница?

Многие разработчики недоумевают: и Gemini AI Studio, и Vertex AI позволяют работать с моделями Gemini, но почему стабильность и квоты так сильно отличаются? Ответ кроется в разном позиционировании этих платформ.

Сравнение платформ

| Критерий | Google AI Studio (Gemini Developer API) | Vertex AI (Gemini API на GCP) |

|---|---|---|

| Целевая аудитория | Частные разработчики, студенты, стартапы | Корпорации, продакшн-системы |

| Порог вхождения | Достаточно API-ключа, запуск за пару минут | Нужен аккаунт Google Cloud и настройка биллинга |

| Модель оплаты | Бесплатный уровень (с лимитами) + Tier 1/2/3 | Оплата по факту (без бесплатного уровня), интеграция с GCP |

| Гарантии SLA | Отсутствуют | Корпоративный SLA, доступность 99.9% |

| Функционал | Только API + визуальный инструмент промптов | Полный цикл ML (разметка, обучение, тюнинг, мониторинг) |

| Стабильность квот | Зависит от общей нагрузки, квоты могут меняться | Резервирование квот под клиента, приоритет в ресурсах |

Плюсы и минусы AI Studio

Плюсы:

- Быстрый старт: Получил ключ и работаешь, никакой возни с облачными сервисами.

- Визуальный промпт-инструмент: Удобный интерфейс для тестов и итераций.

- Дружелюбность к бесплатному уровню: Идеально для учебы и мелких пет-проектов.

Минусы:

- Никаких гарантий SLA: Google не несет юридической ответственности за доступность сервиса.

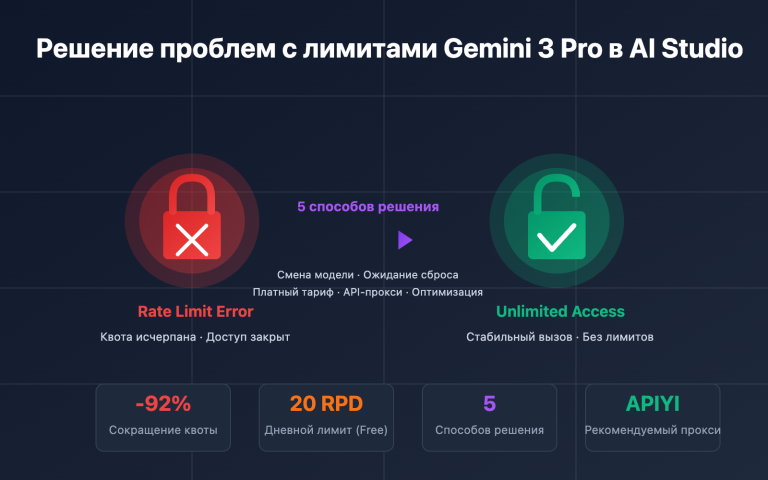

- Нестабильные квоты: Как случилось 7 декабря 2025 года, когда Gemini 2.5 Pro убрали из бесплатного доступа, а лимит на 2.5 Flash срезали с 250 до 20 запросов в день (на 92%!).

- Нет интеграции с корпоративными сервисами: Нельзя просто так подключить BigQuery или Dataflow.

Возможности Vertex AI для бизнеса

Главные преимущества:

- Приоритет ресурсов: Запросы платных клиентов имеют наивысший приоритет во внутренней системе Google.

- MLOps «из коробки»: Поддержка версионности моделей, A/B тестов и мониторинга аномалий.

- Суверенитет данных: Можно выбрать регион хранения данных для соответствия законам (вроде GDPR).

- Поддержка: Доступ к техподдержке Google и архитектурным консультациям.

Когда переходить:

- Если у вас более 10 000 запросов в день в продакшне.

- Если нужно дообучать (fine-tune) модели на своих данных.

- Если вашему бизнесу критически важны время отклика и гарантии доступности.

🎯 Совет: Если ваш проект вырос из стадии прототипа и вы делаете более 5 000 запросов в день, пора переезжать на Vertex AI или подключаться через единую платформу вроде APIYI (apiyi.com). Такие платформы агрегируют мощности разных облаков, позволяя переключаться между ними через один интерфейс — вы получаете простоту AI Studio вместе с надежностью корпоративного уровня.

Глубинные причины дефицита Nano Banana Pro

Основываясь на предыдущем анализе, причины постоянного дефицита Nano Banana Pro можно свести к трем основным уровням:

1. Технический уровень: дисбаланс мощностей чипов и спроса

- Наращивание мощностей TPU v7: чипы были анонсированы в апреле 2025 года, но их масштабное развертывание завершится только к 2026 году.

- Приоритет обучения над инференсом: задачи по обучению моделей серии Gemini 3.0 поглощают огромное количество ресурсов TPU v6e и v7.

- Вычислительная сложность генерации изображений: инференс диффузионных моделей (Diffusion Model), используемых в Nano Banana Pro, требует в 5–10 раз больше вычислительных мощностей, чем текстовые модели.

2. Коммерческий уровень: корректировка стратегии бесплатного уровня

| Временной отрезок | Изменения в политике | Причина |

|---|---|---|

| Ноябрь 2025 | Запуск Nano Banana Pro, лимит 3 изображения в день | Быстрый сбор отзывов пользователей, закрепление на рынке |

| 7 декабря 2025 | Снижение лимита до 2 изображений в день, Gemini 2.5 Pro исключена из бесплатного уровня | Затраты на вычисления превысили бюджет, необходимость контроля роста бесплатных пользователей |

| Январь 2026 | Лимит RPM снижен с 10 до 5 | Резервирование ресурсов для корпоративных клиентов Gemini 2.0 Flash |

Google на официальном форуме прямо заявила, что эти корректировки внесены для «обеспечения устойчивого качества обслуживания». На деле же взрывной рост числа бесплатных пользователей (особенно за счет инструментов автоматизации и массовых вызовов) привел к потере контроля над расходами, что вынудило компанию ужесточить политику.

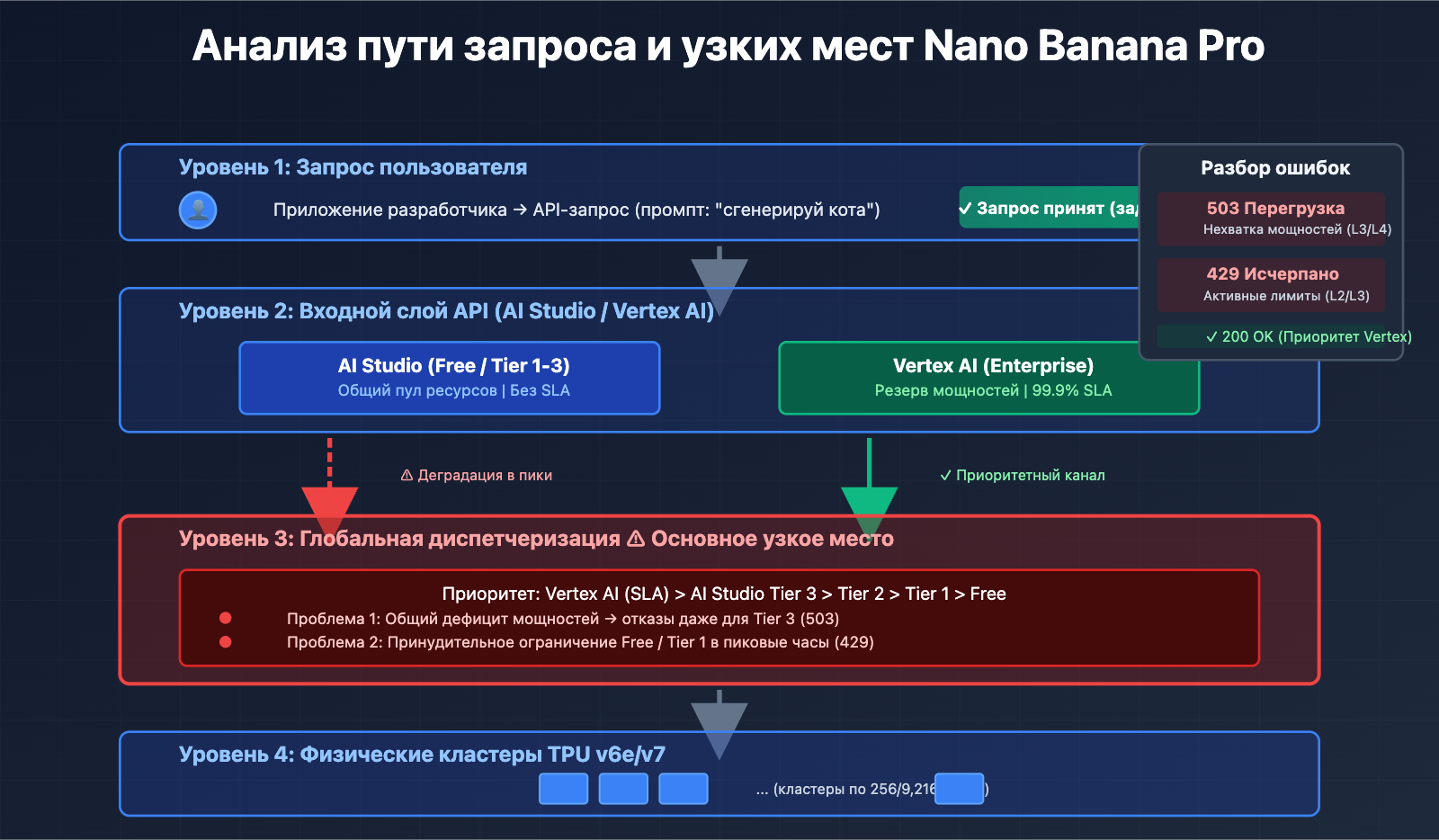

3. Архитектурный уровень: изоляция ресурсов AI Studio и Vertex AI

Хотя обе платформы используют одни и те же базовые модели, приоритеты распределения ресурсов внутри Google различаются:

- Vertex AI: напрямую подключается к пулу мощностей GCP корпоративного уровня, имеет зарезервированные ресурсы с гарантированным SLA.

- AI Studio: использует общий глобальный пул ресурсов, который в часы пик подвергается деградации (снижению приоритета).

Такой дизайн архитектуры приводит к тому, что пользователи бесплатного уровня и Tier 1 в AI Studio чаще сталкиваются с ошибками 429/503, в то время как платные пользователи Vertex AI страдают гораздо меньше.

4. Стратегия продукта: от «захвата рынка» к «оптимизации прибыли»

На начальном этапе запуска Nano Banana Pro Google придерживалась агрессивной стратегии бесплатного доступа, чтобы конкурировать с DALL-E 3 и Midjourney. Однако с взрывным ростом базы пользователей компания осознала, что такая бизнес-модель неустойчива, и начала перераспределять ресурсы в пользу «высокоценных платных пользователей».

Знаковым событием этого перехода стало сокращение квот в декабре 2025 года и удаление 2.5 Pro из бесплатного доступа, которое в сообществе разработчиков прозвали «Free Tier Fiasco» (Фиаско бесплатного уровня).

🎯 Стратегия реагирования: Для рабочих приложений, зависящих от Nano Banana Pro, рекомендуем использовать мультиоблачную стратегию резервного копирования. Через платформу APIYI apiyi.com вы можете настроить правила автоматического переключения между Nano Banana Pro, DALL-E 3, Stable Diffusion и другими моделями в рамках единого интерфейса. Когда один сервис перегружен, система автоматически переключится на альтернативный вариант, обеспечивая непрерывность вашего бизнеса.

Как разработчикам справиться с нестабильностью Nano Banana Pro

Опираясь на приведенный анализ, предлагаем четыре проверенных технических решения:

Решение 1: Внедрение механизма повторных попыток с экспоненциальной задержкой

import time

import random

def call_nano_banana_with_retry(prompt, max_retries=5):

"""使用指数退避策略调用 Nano Banana Pro API"""

for attempt in range(max_retries):

try:

response = call_api(prompt) # 你的实际 API 调用函数

return response

except Exception as e:

if "503" in str(e) or "429" in str(e):

wait_time = (2 ** attempt) + random.uniform(0, 1)

print(f"遇到过载错误,等待 {wait_time:.2f} 秒后重试...")

time.sleep(wait_time)

else:

raise e

raise Exception("达到最大重试次数")

Основная идея: При возникновении ошибок 503/429 время ожидания растет экспоненциально (1с → 2с → 4с → 8с), что позволяет избежать эффекта «лавины».

Полная реализация промышленного уровня (нажмите, чтобы развернуть)

import time

import random

import logging

from typing import Optional, Dict, Any

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

class NanoBananaClient:

def __init__(self, api_key: str, base_delay: float = 1.0, max_retries: int = 5):

self.api_key = api_key

self.base_delay = base_delay

self.max_retries = max_retries

def generate_image(self, prompt: str, **kwargs) -> Optional[Dict[str, Any]]:

"""生产级图像生成方法,包含完整的错误处理和监控"""

for attempt in range(self.max_retries):

try:

# 实际 API 调用逻辑

response = self._call_api(prompt, **kwargs)

logger.info(f"请求成功 (尝试 {attempt + 1}/{self.max_retries})")

return response

except Exception as e:

error_code = self._parse_error_code(e)

if error_code in [429, 503]:

if attempt < self.max_retries - 1:

wait_time = self._calculate_backoff(attempt)

logger.warning(

f"错误 {error_code}: {str(e)[:100]} | "

f"等待 {wait_time:.2f}s (尝试 {attempt + 1}/{self.max_retries})"

)

time.sleep(wait_time)

else:

logger.error(f"达到最大重试次数,最终失败: {str(e)}")

raise

else:

logger.error(f"不可重试的错误: {str(e)}")

raise

return None

def _calculate_backoff(self, attempt: int) -> float:

"""计算指数退避时间,加入抖动避免同步重试"""

exponential_delay = self.base_delay * (2 ** attempt)

jitter = random.uniform(0, self.base_delay)

return min(exponential_delay + jitter, 60.0) # 最大等待 60 秒

def _parse_error_code(self, error: Exception) -> int:

"""从异常中提取 HTTP 状态码"""

error_str = str(error)

if "429" in error_str or "RESOURCE_EXHAUSTED" in error_str:

return 429

elif "503" in error_str or "overloaded" in error_str:

return 503

return 500

def _call_api(self, prompt: str, **kwargs) -> Dict[str, Any]:

"""实际的 API 调用逻辑 (需替换为真实实现)"""

# 这里放置你的实际 API 调用代码

pass

# 使用示例

client = NanoBananaClient(api_key="your_api_key")

result = client.generate_image("a cute cat playing piano")

Решение 2: Контроль интервалов между запросами

Согласно отзывам сообщества разработчиков, добавление фиксированной задержки в 5–10 секунд между запросами может значительно снизить частоту ошибок 503:

import time

def batch_generate_images(prompts):

"""批量生成图像,严格控制请求频率"""

results = []

for i, prompt in enumerate(prompts):

result = call_api(prompt)

results.append(result)

if i < len(prompts) - 1: # 最后一个请求不需要等待

time.sleep(7) # 固定 7 秒间隔

return results

Где применять: В приложениях, работающих не в реальном времени, таких как пакетная генерация контента или оффлайн-обработка данных.

Решение 3: Мультиоблачная стратегия резервирования

Реализация автоматического переключения при сбое через унифицированную API-платформу:

| Шаг | Техническая реализация | Ожидаемый эффект |

|---|---|---|

| 1. Настройка моделей | Nano Banana Pro (основная) + DALL-E 3 (резервная) | Отказоустойчивость при единичном сбое |

| 2. Правила переключения | 3 ошибки 503 подряд → автопереключение на резерв | Снижение заметной для пользователя задержки |

| 3. Мониторинг восстановления | Проверка состояния основного сервиса каждые 5 минут | Автоматический возврат к основной модели |

🎯 Рекомендуемая реализация: Платформа APIYI apiyi.com нативно поддерживает такие стратегии мультиоблачной диспетчеризации. Вам нужно лишь настроить правила переключения в консоли управления, и система сама возьмет на себя обнаружение сбоев, перенаправление трафика и оптимизацию затрат без изменения кода вашего приложения.

Решение 4: Переход на Vertex AI или платформу корпоративного уровня

Если ваше приложение соответствует любому из следующих условий, рекомендуем рассмотреть возможность апгрейда:

- Среднесуточное количество вызовов API > 5 000.

- Строгие требования к SLA по времени отклика (например, 95-й перцентиль < 10 секунд).

- Недопустимость перебоев в обслуживании (например, генерация изображений для e-commerce, модерация контента в реальном времени).

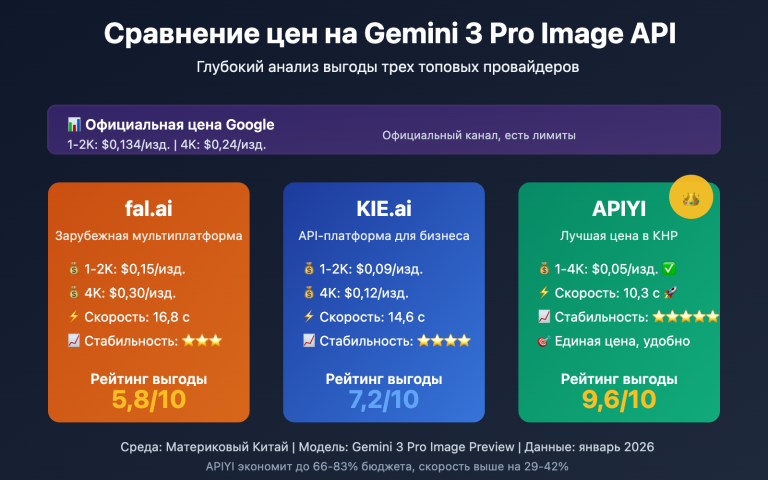

Сравнение стоимости:

AI Studio Tier 1: $0.05/фото (но часто перегружен)

Vertex AI: $0.08/фото (стабильно, есть SLA)

Платформа APIYI: $0.06/фото (мультиоблачность, автоотказоустойчивость)

Хотя цена за единицу в Vertex AI выше, с учетом затрат на повторные попытки, времени разработки и бизнес-потерь, фактическая TCO (общая стоимость владения) может оказаться ниже.

Часто задаваемые вопросы (FAQ)

Q1: Почему даже платные пользователи сталкиваются с ошибкой «Модель перегружена»?

О: Узкое место в пропускной способности Nano Banana Pro находится на уровне глобального планировщика вычислительных мощностей Google, а не на уровне квот конкретного пользователя. Даже если вы — платный пользователь уровня Tier 3, вы все равно можете получить ошибку 503, когда общий пул вычислительных ресурсов заполнен. Это отличается от классической ошибки 429, связанной с превышением лимитов.

В чем разница:

- Ошибка 429: Ваша личная квота исчерпана (например, ограничение RPM).

- Ошибка 503: У серверов Google не хватает мощностей в данный момент, это никак не связано с вашими лимитами.

Q2: Используют ли AI Studio и Vertex AI одну и ту же модель?

О: Да, базовая Большая языковая модель Nano Banana Pro (gemini-2.0-flash-preview-image-generation), к которой они обращаются, абсолютно идентична. Однако у них разные приоритеты планирования ресурсов:

- Vertex AI: Гарантии SLA корпоративного уровня, приоритетное выделение мощностей.

- AI Studio: Общий пул ресурсов, в пиковые часы обслуживание может быть замедлено или ограничено.

Это похоже на разницу между облачными серверами с «оплатой по факту» и «зарезервированными инстансами».

Q3: Будет ли Google и дальше урезать квоты бесплатного уровня?

О: Судя по историческим трендам, Google, скорее всего, продолжит корректировать политику бесплатного доступа:

- Ноябрь 2025: Бесплатный уровень — 3 изображения в день.

- 7 декабря 2025: Снижение до 2 изображений в день, удаление версии 2.5 Pro.

- Январь 2026: Снижение RPM с 10 до 5.

Официальная формулировка Google — «обеспечение устойчивого качества обслуживания», но на деле это поиск баланса между контролем расходов и ростом пользовательской базы. Мы рекомендуем не полагаться на бесплатный уровень в реальных проектах, а заранее планировать переход на платные тарифы или использовать мультиоблачное резервирование.

Q4: Когда стабильность Nano Banana Pro улучшится?

О: Согласно открытым данным Google, ключевой временной рубеж — середина 2026 года:

- 2-й квартал 2026: Завершение масштабного развертывания TPU v7 (Ironwood).

- 3-й квартал 2026: Ввод в эксплуатацию мощностей на 1 ГВт совместно с Anthropic.

К этому моменту предложение вычислительных ресурсов значительно вырастет, хотя и спрос может увеличиться пропорционально. По консервативным оценкам, стабильность заметно улучшится во второй половине 2026 года.

Q5: Как выбрать способ подключения к Nano Banana Pro?

О: Выбирайте исходя из стадии вашего проекта:

| Стадия | Рекомендуемое решение | Причина |

|---|---|---|

| Разработка прототипа | Бесплатный уровень AI Studio | Минимальные затраты, быстрая проверка идей |

| Малый запуск | AI Studio Tier 1 + механизмы повторных попыток | Баланс между стоимостью и стабильностью |

| Продакшн | Vertex AI или платформа APIYI | Гарантии SLA, поддержка корпоративного уровня |

| Критически важный бизнес | Мультиоблачная стратегия (например, через APIYI) | Максимальная доступность, автоматическое переключение при сбоях |

🎯 Совет по выбору: Если вы не уверены, что именно вам подходит, попробуйте провести A/B тестирование через платформу APIYI (apiyi.com). Она позволяет сравнивать реальную работу Nano Banana Pro (AI Studio), Nano Banana Pro (Vertex AI), DALL-E 3 и других моделей на одних и тех же запросах, чтобы вы могли принять решение на основе реальных данных.

Итог: Трезвый взгляд на дефицит мощностей Nano Banana Pro

Проблемы со стабильностью Nano Banana Pro — это не случайный сбой, а отражение противоречия между спросом и предложением ресурсов, с которым столкнулась вся AI-индустрия:

Суть конфликта:

- Сторона спроса: Взрывной рост приложений на базе генеративного ИИ, особенно в сфере генерации изображений.

- Сторона предложения: Медленное наращивание производства чипов, длительные циклы строительства дата-центров (12–18 месяцев).

- Экономическая модель: Стратегия бесплатных уровней убыточна в долгосроке, а конверсия в платных пользователей остается низкой.

Три технических факта:

-

Собственные TPU ≠ бесконечные ресурсы: Хотя у Google есть такие продвинутые чипы, как TPU v7, для наращивания производства, обеспечения энергией и постройки дата-центров нужно время. 2026 год станет поворотным моментом.

-

Суть AI Studio vs Vertex AI: Это не просто «бесплатная» и «платная» версии, а разные приоритеты распределения ресурсов. За корпоративным SLA в Vertex AI стоит отдельный механизм резервирования мощностей.

-

Дефицит — это надолго: С выходом новых моделей вроде Gemini 3.0 или GPT-5 потребность в ресурсах будет только расти. В краткосрочной перспективе (2026–2027 гг.) напряженность с поставками мощностей вряд ли исчезнет полностью.

Практические рекомендации:

- В краткосрочной перспективе: Используйте программные методы смягчения проблем — повторные попытки (retries), контроль интервалов между запросами.

- В среднесрочной перспективе: Оцените ROI перехода на Vertex AI или мультиоблачные платформы.

- В долгосрочной перспективе: Следите за расширением мощностей Google в середине 2026 года и вовремя корректируйте свою стратегию.

Для корпоративных приложений мы настоятельно рекомендуем использовать мультиоблачную стратегию, чтобы не зависеть от мощностей одного поставщика. С помощью единых платформ вроде APIYI (apiyi.com) вы сможете получить доступ к разным облакам, автоматическое переключение при сбоях и оптимизацию затрат без усложнения кода.

В заключение: Ситуация с Nano Banana Pro напоминает нам, что стабильность AI-сервиса зависит не только от способностей модели, но и от зрелости базовой инфраструктуры. В эпоху, когда вычислительные мощности решают всё, надежность архитектуры и диверсификация поставщиков становятся ключевыми факторами конкурентоспособности продукта.

Что еще почитать:

- Руководство по использованию Nano Banana Pro API

- Глубокий разбор архитектуры Google TPU v7

- Как выбрать API для генерации изображений: Nano Banana Pro vs DALL-E 3 vs Stable Diffusion

- 10 лучших практик вызова AI API в продакшн-среде