コードリポジトリ全体を一度に分析したり、数百ページに及ぶ技術文書を処理したりしたいのに、コンテキストウィンドウの制限に阻まれていませんか?Claude Opus 4.6は、100万トークンの超巨大コンテキストウィンドウを搭載しました。これはOpusシリーズ初の快挙であり、一度に約75万文字のテキスト内容を処理できることに相当します。

コアバリュー: この記事を読めば、Claude 4.6の1Mトークンコンテキストウィンドウの有効化方法、長いコンテキストの料金体系、そして5つの価値ある実践的な活用シーンをマスターできます。

Claude 4.6 コンテキストウィンドウの主要パラメータ一覧

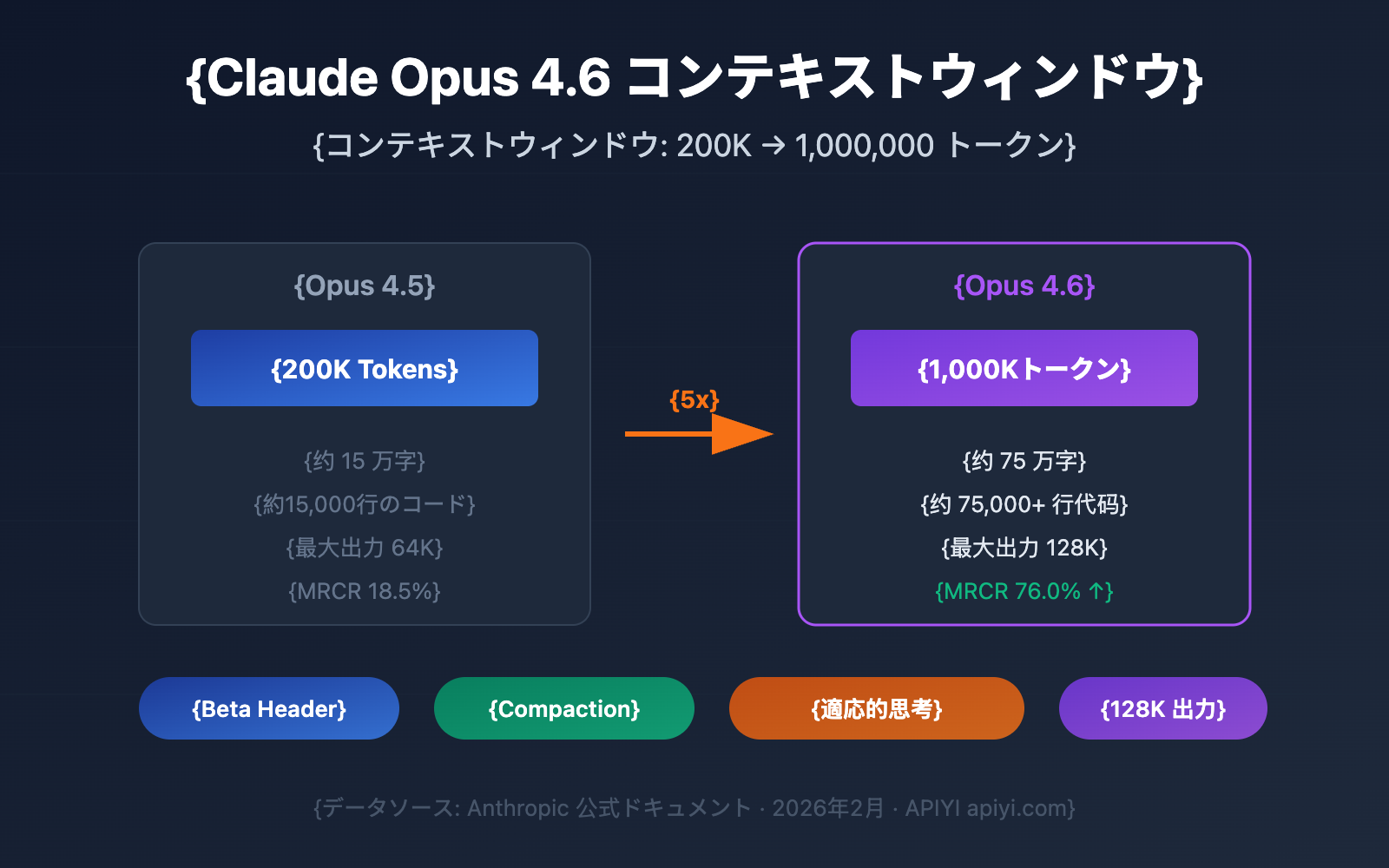

Claude Opus 4.6は2026年2月5日にリリースされ、最も注目すべきアップグレードはコンテキストウィンドウの大幅な拡張です。主要なパラメータは以下の通りです:

| 項目 | Claude Opus 4.6 | 前世代 Opus 4.5 | 向上率 |

|---|---|---|---|

| デフォルトコンテキストウィンドウ | 200K Token | 200K Token | 維持 |

| Beta拡張ウィンドウ | 1,000K (1M) Token | 非対応 | 初対応 |

| 最大出力トークン | 128K Token | 64K Token | 2倍向上 |

| MRCR v2 ベンチマーク (1M) | 76.0% | 18.5% | 約4倍向上 |

| MRCR v2 ベンチマーク (256K) | 93.0% | — | 非常に高い正確性 |

| 推奨思考モード | Adaptive Thinking | — | 新機能 |

🎯 キーポイント: Claude Opus 4.6の1Mコンテキストウィンドウは現在Beta版であり、特定のAPIヘッダーを使用して有効にする必要があります。デフォルトでは引き続き200Kコンテキストウィンドウが使用されます。APIYI (apiyi.com) プラットフォームを通じて、異なるコンテキスト長でのモデルのパフォーマンスを素早くテストすることが可能です。

Claude 4.6 コンテキストウィンドウにおける3つの重要な突破口

突破口1:Opusシリーズ初の1Mコンテキスト対応

Claude Opus 4.6以前、100万トークンのコンテキストウィンドウはSonnetシリーズ(Sonnet 4およびSonnet 4.5)のみに開放されていました。Opus 4.6は、1Mコンテキストをサポートする初のOpusフラッグシップモデルであり、これによりOpusの強力な推論能力と超巨大なコンテキストを組み合わせて活用できるようになりました。

具体的に、1Mトークンは以下の量に相当します:

| コンテンツの種類 | 収容量 | 代表的なユースケース |

|---|---|---|

| プレーンテキスト | 約75万文字 | 技術ドキュメント一式 |

| コード | 約75,000行以上 | コードリポジトリ全体 |

| PDFドキュメント | 数十本の研究論文 | 大量の文献レビュー |

| 対話ログ | 数百ターンの会話 | 超長期のセッション維持 |

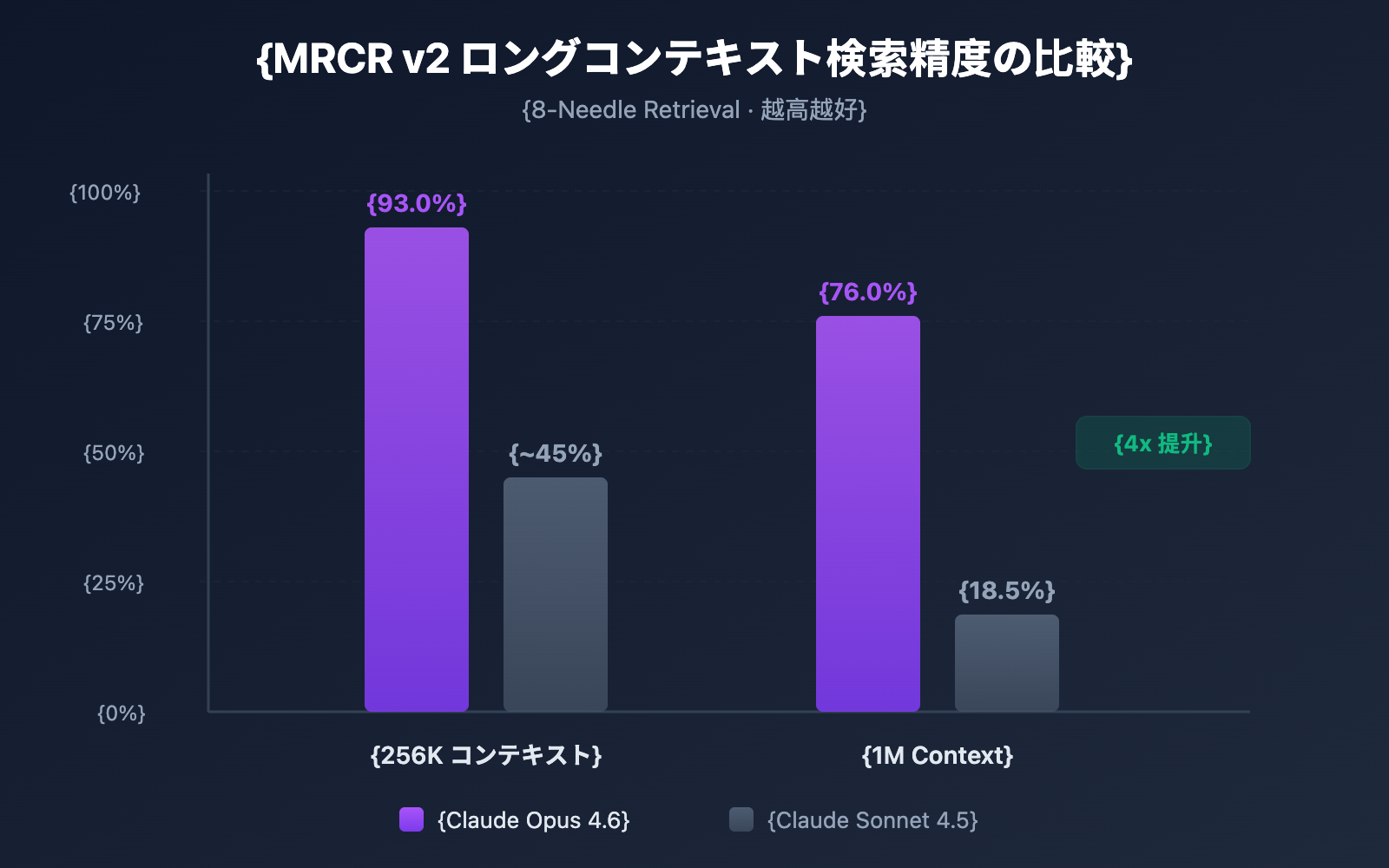

突破口2:長いコンテキストにおける検索精度の飛躍的向上

コンテキストウィンドウが大きいことと、その膨大な情報の中から正確に情報を探し出せるかは別問題です。Claude Opus 4.6は、MRCR v2(Multi-needle Retrieval with Contextual Reasoning)ベンチマークにおいて驚異的なパフォーマンスを示しました。

- 256Kトークンコンテキスト: 正確性 93.0%

- 1Mトークンコンテキスト (8本): 正確性 76.0%

MRCR v2は「Needle In A Haystack(干し草の山から針を探す)」式のテストで、100万トークンのテキストの中に隠された8つの重要な情報をすべて見つけ出すようモデルに要求します。Claude Opus 4.6の76%という正確性は、Sonnet 4.5の18.5%と比較して劇的な進化を遂げており、信頼性は約4〜9倍向上しています。

突破口3:Compactionメカニズムによる無限の対話の実現

Claude Opus 4.6では、サーバー側での自動コンテキスト要約機能である「Compaction(コンテキスト圧縮)」メカニズムが導入されました。

- 対話がコンテキストウィンドウの上限に近づくと、APIが自動的に以前の対話内容を要約します。

- 手動でのコンテキスト管理や、スライディングウィンドウ、切り捨て戦略などは不要になります。

- 理論上、無限の長さの対話が可能になります。

これは、大量のツール呼び出しや長い推論チェーンを伴うエージェント(Agent)のワークフローにおいて特に価値があります。Compactionにより、対話状態を維持するためのコストを大幅に削減できます。

Claude 4.6 コンテキストウィンドウの有効化方法

ステップ1:アカウント権限の確認

1Mトークンのコンテキストウィンドウは現在ベータ機能であり、以下のユーザーのみに開放されています:

- Usage Tier 4 以上の組織

- カスタムレート制限を適用している組織

現在のUsage Tierレベルは、Anthropic Consoleで確認できます。

ステップ2:Betaヘッダーの追加

1Mコンテキストウィンドウを有効にするには、APIリクエストに特定のBetaヘッダーを追加する必要があります:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェース経由で呼び出し

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "以下のコードリポジトリ全体を分析してください..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

Anthropic SDKを直接使用する場合、対応するcurlリクエストは以下の通りです:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "あなたの超長文コンテンツ..."}

]

}'

🚀 クイックスタート: Claude Opus 4.6の長いコンテキスト能力を素早くテストするには、APIYI(apiyi.com)プラットフォームの使用をお勧めします。プラットフォームは統合されたAPIインターフェースを提供しており、複数のプロバイダーと個別に契約することなく、5分で統合が完了します。

ステップ3:コンテキストウィンドウの検証

リクエスト送信後、返却される usage フィールドを通じて実際に使用されたトークン数を確認できます:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

input_tokens が200,000を超えてリクエストが成功していれば、1Mコンテキストウィンドウが正しく有効化されています。

Pythonコードの完全な例を表示(トークン統計を含む)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェース

)

# 大規模なコードリポジトリファイルを読み込む

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"入力内容の長さ: {len(codebase_content)} 文字")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "あなたはシニアコードレビューエキスパートです。コードリポジトリ全体を分析してください。"

},

{

"role": "user",

"content": f"以下のコードリポジトリのアーキテクチャ設計と潜在的な問題を分析してください:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"入力トークン: {response.usage.prompt_tokens}")

print(f"出力トークン: {response.usage.completion_tokens}")

print(f"\n分析結果:\n{response.choices[0].message.content}")

Claude 4.6 上下文窗口定价详解

使用 1M 上下文窗口涉及分层定价机制。当请求 Token 超过 200K 时,自动切换到长上下文定价:

| 定价层级 | 输入价格 (每百万 Token) | 输出价格 (每百万 Token) | 适用范围 |

|---|---|---|---|

| 标准定价 | $5.00 | $25.00 | ≤ 200K Token |

| 长上下文定价 | $10.00 | $37.50 | > 200K Token |

| 价格倍率 | 2x | 1.5x | 自动应用 |

定价计算示例

假设你发送了一个 500K Token 的长文本分析请求,输出 4,000 Token:

- 输入费用: 500K × ($10.00 / 1M) = $5.00

- 输出费用: 4K × ($37.50 / 1M) = $0.15

- 单次请求总费用: $5.15

💰 成本优化建议: 对于需要频繁使用长上下文的项目,可以通过 APIYI apiyi.com 平台调用 Claude Opus 4.6 API。平台提供灵活的计费方式和更优惠的价格,帮助中小团队有效控制成本。

善用 Context Caching 降低成本

如果你的应用场景涉及重复查询同一批文档(如"与文档对话"类应用),可以利用 Context Caching 功能:

- 首次上传文档按标准价格计费

- 后续基于缓存内容的查询享受折扣价

- 适合批量文档分析、知识库问答等高频场景

Claude 4.6 上下文窗口成本控制最佳实践

| 优化策略 | 说明 | 预计节省 |

|---|---|---|

| 按需使用 1M | 仅在确实需要超长上下文时启用 Beta Header | 避免 2x 输入溢价 |

| Context Caching | 对重复查询的文档使用缓存 | 40-60% 输入成本 |

| 预过滤输入 | 上传前去除无关内容(注释、空行等) | 10-30% Token 消耗 |

| 分层策略 | 简单任务用 Sonnet,复杂任务用 Opus | 整体成本降低 50%+ |

| 输出长度控制 | 设置合理的 max_tokens 避免冗余输出 | 减少输出费用 |

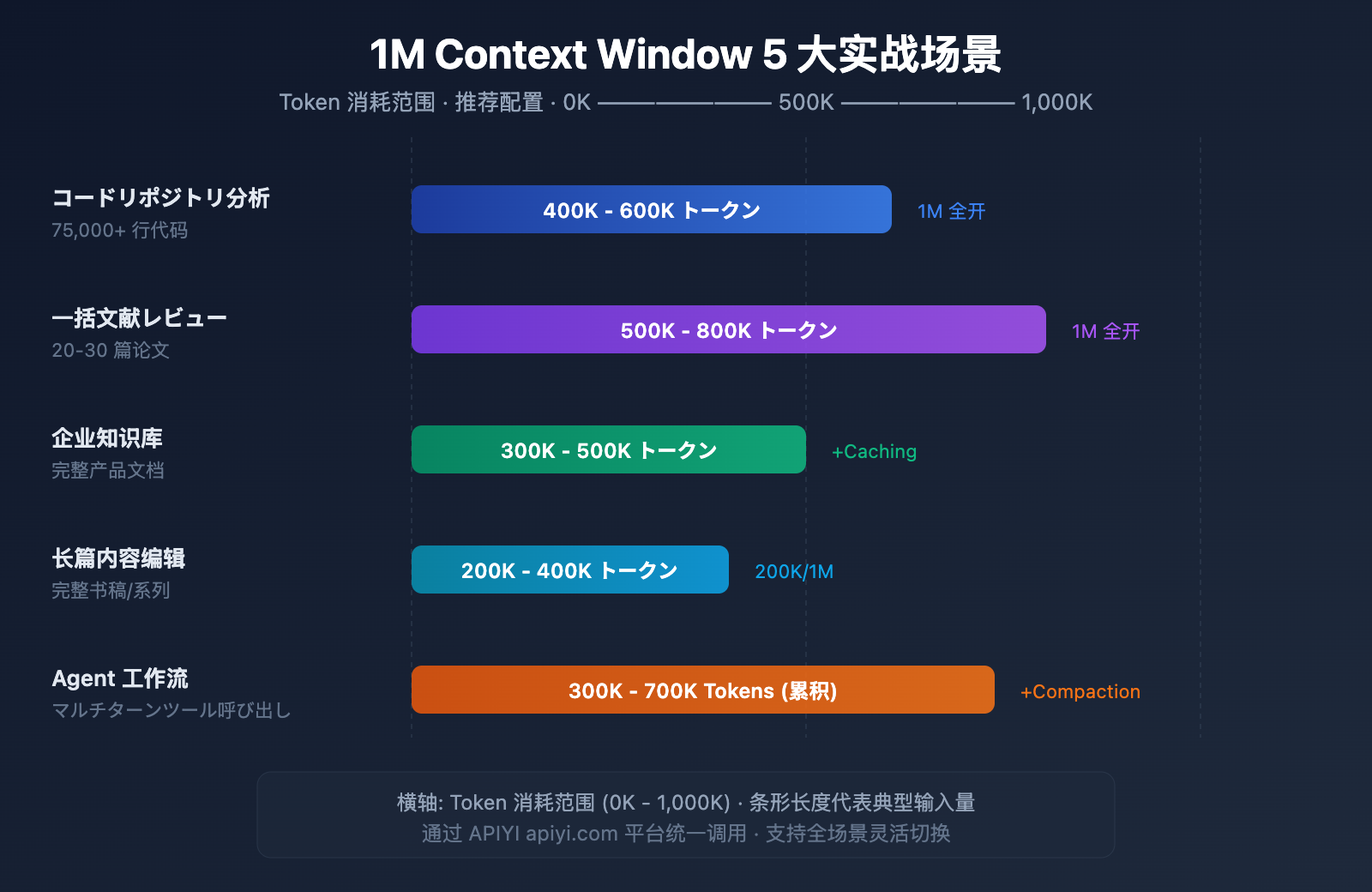

Claude 4.6 上下文窗口 5 大实战场景

场景一:全代码仓库分析

输入规模: 5-7.5 万行代码 (约 400K-600K Token)

这是 1M 上下文窗口最直接的受益场景。将整个项目的源代码一次性提交给 Claude Opus 4.6,可以实现:

- 全局架构审查:识别跨模块的设计问题

- 依赖关系分析:找出循环依赖和过度耦合

- 安全漏洞扫描:在完整上下文中发现跨文件的安全风险

- 重构建议:基于全局理解给出重构方案

过去处理大型代码仓库时,开发者不得不将代码分成多个片段逐步分析,导致模型无法理解跨文件的依赖关系。现在,你可以直接将整个 monorepo 的核心代码一次性提交,让 Claude 像一个真正理解全局的架构师一样给出建议。

场景二:批量文献综述

输入规模: 20-30 篇论文 (约 500K-800K Token)

研究人员可以一次性输入数十篇相关论文,让 Claude 进行:

- 交叉引用分析:识别论文间的引用关系和观点冲突

- 研究趋势总结:从大量文献中提取方法论演进

- Gap 分析:发现现有研究的空白领域

- 元分析辅助:横向对比不同研究的实验设计和结果

对于科研工作者来说,手动阅读 30 篇论文可能需要数周时间。借助 1M 上下文窗口,可以在几分钟内完成初步筛选和关键信息提取,极大加速文献调研效率。

场景三:企业知识库问答

输入规模: 完整产品文档库 (约 300K-500K Token)

将企业内部文档全量载入上下文,实现:

- 精确回答:基于完整文档库给出准确答案

- 跨文档关联:发现不同文档间的信息关联

- 实时更新:无需预处理向量化,直接使用最新文档

- 多文档推理:综合多份技术文档回答复杂问题

相比传统的 RAG(检索增强生成)方案,全量上下文方案省去了向量化、索引构建和检索调优的工程开销。对于文档量在 1M Token 以内的中小型知识库,直接使用长上下文是更简单高效的方案。

场景四:长篇内容创作与编辑

输入规模: 完整书稿或系列文章 (约 200K-400K Token)

- 一致性审查:确保长篇内容前后逻辑一致

- 风格统一:在完整上下文中保持语言风格一致

- 结构优化:基于全文理解提出章节调整建议

- 术语规范:在全书范围内统一专业术语的使用

例如,一本 20 万字的技术书籍约占 300K Token,完全可以在一次请求中让 Claude 审阅全稿并指出前后矛盾的地方。

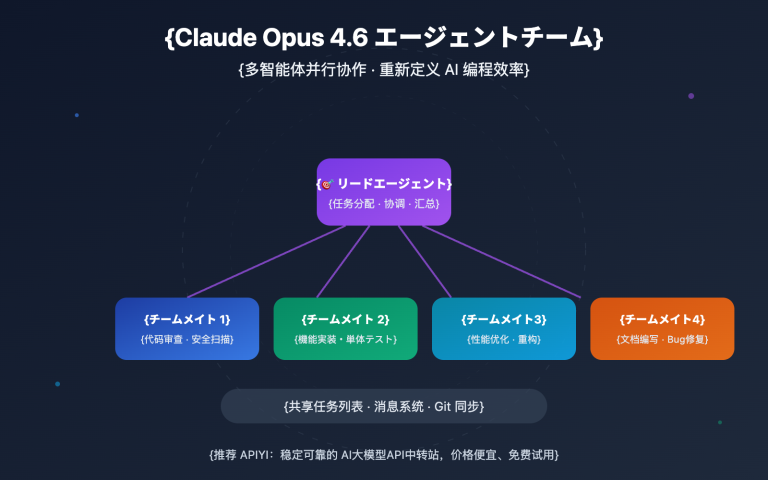

场景五:复杂 Agent 工作流

输入规模: 多轮工具调用记录 (累积 300K-700K Token)

配合 Claude 4.6 的 Agent Teams 功能:

- 长链推理:在复杂多步任务中保持完整推理链

- 工具调用记忆:记住所有历史工具调用结果

- 结合 Compaction:超长工作流自动压缩上下文

- 多 Agent 协作:在 Agent Teams 中共享上下文信息

Agent 工作流是 Claude Opus 4.6 的核心使用场景之一。在执行复杂任务时(如自动化代码审查、数据分析流水线),Agent 可能需要调用数十次工具,每次调用的输入和输出都会累积在上下文中。1M 窗口确保了即使在长时间运行的任务中,Agent 也不会"遗忘"早期的关键信息。

🎯 实战建议: 以上 5 大场景均可通过 APIYI apiyi.com 平台快速验证效果。平台支持 Claude Opus 4.6 在内的多种主流模型,提供统一的接口调用体验,便于在不同场景间灵活切换。

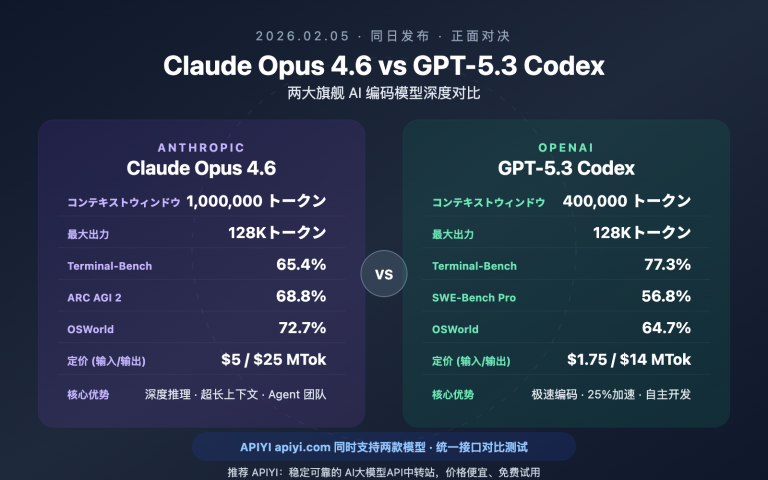

Claude 4.6 コンテキストウィンドウと競合比較

Claude Opus 4.6 が長文コンテキスト領域でどの程度の競争力を持っているかを知ることは、より適切な技術選定を行うのに役立ちます。

| モデル | コンテキストウィンドウ | 最大出力 | 長文コンテキスト検索パフォーマンス | 料金 (入力/出力) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

表からわかるように、Claude Opus 4.6 は長文コンテキストにおける検索精度において明らかな優位性を持っています。料金設定は高めですが、正確な検索と複雑な推論が必要なシーンでは、その信頼性は競合モデルを大きく上回ります。

💡 選択のアドバイス: どのモデルを選択するかは、具体的なユースケースのニーズによって決まります。長文コンテキスト下での推論品質を優先する場合、Claude Opus 4.6 は現在の最適な選択肢です。APIYI(apiyi.com)プラットフォームを通じて実際のテストと比較を行うことをお勧めします。このプラットフォームは、上記のような複数の主要モデルの統一インターフェース呼び出しに対応しており、迅速な切り替えと評価が容易です。

Claude 4.6 コンテキストウィンドウ Compaction 設定

Compaction は、Claude Opus 4.6 で新たに追加されたサーバー側のコンテキスト圧縮機能であり、対話を理論上無限に継続させることができます。

仕組み

- API が各対話のトークン使用量を監視します。

- 入力トークンが設定された閾値を超えると、自動的に要約(サマリー)が実行されます。

- モデルが

<summary>タグで囲まれた対話の要約を生成します。 - 要約が初期の対話内容を置き換え、コンテキスト空間を解放します。

設定方法

API リクエストに compaction_control パラメータを追加します。

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # 実行の閾値

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Compaction と 1M コンテキストの組み合わせ戦略

| 戦略 | コンテキストウィンドウ | Compaction | 適用シーン |

|---|---|---|---|

| 超大規模な単発分析 | 1M (全開放) | オフ | コードレビュー、文献レビュー |

| 長期的な対話 | 200K (デフォルト) | オン | カスタマーサポート、アシスタント、エージェント |

| 混合モード | 1M + Compaction | オン | 超複雑なエージェントワークフロー |

よくある質問

Q1: Claude 4.6 のコンテキストウィンドウはデフォルトで 1M なのですか?

いいえ。Claude Opus 4.6 のデフォルトのコンテキストウィンドウは依然として 200K トークンであり、前世代の Opus 4.5 と同じです。1M トークンのコンテキストウィンドウを使用するには、API リクエストに anthropic-beta: context-1m-2025-08-07 ヘッダーを追加する必要があります。また、組織が Usage Tier 4 に達しているか、カスタムレート制限を持っている必要があります。APIYI(apiyi.com)プラットフォーム経由で呼び出す場合、リクエストにこのヘッダーを簡単に追加できます。

Q2: 1M コンテキストウィンドウを使用すると追加料金が発生しますか?

はい、段階的な料金体系が適用されます。リクエストが 200K トークンを超えると、入力価格は $5/M から $10/M(2倍)に、出力価格は $25/M から $37.50/M(1.5倍)に上昇します。予算を重視するプロジェクトの場合は、APIYI(apiyi.com)プラットフォームを通じて、よりお得な料金プランを利用することをお勧めします。

Q3: 1M のコンテキスト内で特定の情報を正確に見つけることができますか?

Claude Opus 4.6 は MRCR v2 ベンチマークで優れたパフォーマンスを発揮しています。1M トークンのコンテキスト内に 8 つの重要な情報を隠したテストシナリオにおいて、正解率は 76% に達し、これは Sonnet 4.5(18.5%)の約 4 倍です。256K のコンテキストでは、正解率は 93% と非常に高くなっています。これは、Claude Opus 4.6 が現在、長いコンテキストの検索において最も信頼性の高いモデルの一つであることを意味します。

Q4: Compaction(圧縮)は回答の質に影響しますか?

Compaction はインテリジェントな要約によって以前の会話内容を圧縮する機能で、ほとんどのシナリオで回答の質に大きな影響を与えることはありません。ただし、以前の会話の詳細を正確に引用する必要があるシナリオでは、Compaction をオフにして 1M コンテキストウィンドウを直接使用することをお勧めします。エージェントのワークフローでは、Compaction によって効率が大幅に向上するため、有効にすることをお勧めします。

Q5: どの Claude モデルが 1M コンテキストをサポートしていますか?

現在、1M トークンのコンテキストウィンドウをサポートしている Claude モデルは、Claude Opus 4.6、Claude Sonnet 4.5、Claude Sonnet 4 の 3 つです。その中でも Opus 4.6 の長文コンテキスト検索の精度は、Sonnet シリーズを大きく上回っています。Claude Haiku シリーズなどの他のモデルは、現時点では 1M コンテキストをサポートしていません。

まとめ

Claude Opus 4.6 の 1M トークンコンテキストウィンドウは重要な機能アップグレードであり、Opus フラッグシップモデルの強力な推論能力と超大規模なコンテキストを組み合わせることで、コードベース全体の分析、大量の文献レビュー、企業ナレッジベースの Q&A など、価値の高い活用シーンを切り拓きます。

コアポイントの振り返り:

- デフォルトは 200K、Beta 版で 1M に拡張:

anthropic-beta: context-1m-2025-08-07ヘッダーが必要 - 長文コンテキスト検索の精度で業界をリード: MRCR v2 ベンチマークで 76% (1M) / 93% (256K)

- 段階的料金体系: 200K を超える部分の入力価格は 2 倍、出力価格は 1.5 倍

- Compaction が無限の会話をサポート: サーバー側での自動コンテキスト圧縮、エージェントワークフローに最適

- 3 つのモデルがサポート: Opus 4.6、Sonnet 4.5、Sonnet 4

APIYI(apiyi.com)を通じて、Claude Opus 4.6 の長文コンテキスト機能をぜひ体験してください。プラットフォームは複数の主要な AI モデルの統合呼び出しをサポートしており、開発者の技術検証や製品統合を効率的に支援します。

この記事は APIYI チームによって執筆されました。AI 大規模言語モデルの技術共有に注力しています。さらなるチュートリアルや API 使用ガイドについては、APIYI ヘルプセンター(help.apiyi.com)をご覧ください。

参考資料

-

Anthropic 公式ブログ – Introducing Claude Opus 4.6

- リンク:

anthropic.com/news/claude-opus-4-6 - 説明: Claude Opus 4.6 のリリース告知と主要機能の紹介

- リンク:

-

Claude API ドキュメント – Context Windows

- リンク:

platform.claude.com/docs/en/build-with-claude/context-windows - 説明: コンテキストウィンドウの設定と使用ガイド

- リンク:

-

Claude API ドキュメント – Compaction

- リンク:

platform.claude.com/docs/en/build-with-claude/compaction - 説明: Compaction(コンテキスト圧縮)機能の詳細解説

- リンク:

-

Claude API ドキュメント – Pricing

- リンク:

platform.claude.com/docs/en/about-claude/pricing - 説明: モデルの価格設定および長いコンテキストの料金体系に関する説明

- リンク: