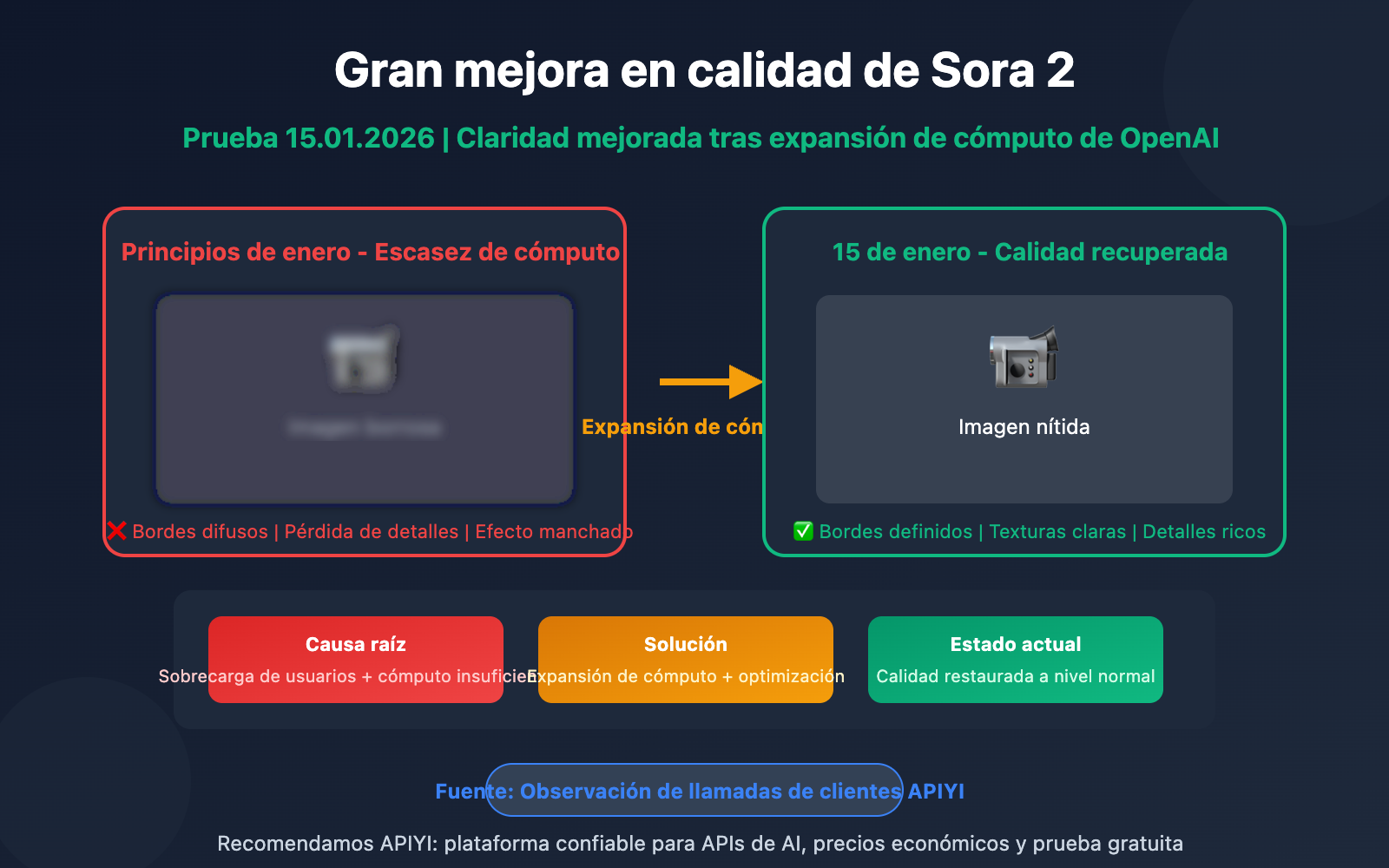

Sora 2 calidad de video mejorada significativamente

El 15 de enero de 2026, a través de la observación de datos de llamadas de clientes de la plataforma APIYI, descubrimos que la claridad de video de Sora 2 muestra un aumento notable. El problema de "baja definición" que afectó a los usuarios durante varias semanas parece estar resuelto, OpenAI posiblemente ha completado silenciosamente la expansión de capacidad de cómputo u optimización de asignación.

Valor esencial: En 3 minutos, comprende el contexto del cambio de calidad de Sora 2, análisis de las razones técnicas y cómo obtener los mejores resultados de generación de video a través de API.

Puntos clave sobre el cambio de calidad en Sora 2

| Fecha | Estado | Comentarios de usuarios |

|---|---|---|

| Diciembre 2025 | Normal | Claridad de video cumple expectativas |

| Principios enero 2026 | Bajada | Muchos usuarios reportan imágenes borrosas |

| 10 enero 2026 | Punto bajo | Carga alta incluso tras limitar usuarios gratuitos |

| 15 enero 2026 | Recuperación | Mejora notable observada en llamadas API |

Contexto de la recuperación de calidad en Sora 2

Esta mejora de calidad no es por una nueva versión de OpenAI, sino por mejoras a nivel de infraestructura. Para entender esto, primero hay que conocer el "blur-gate" que sufrió Sora 2.

Entre finales de 2025 y principios de enero de 2026, muchos usuarios en comunidades internacionales reportaron una "caída abrupta" en la claridad de videos generados por Sora 2. En el subreddit de OpenAI aparecieron numerosos posts quejándose de que "la calidad cayó de la noche a la mañana" (plummeted overnight).

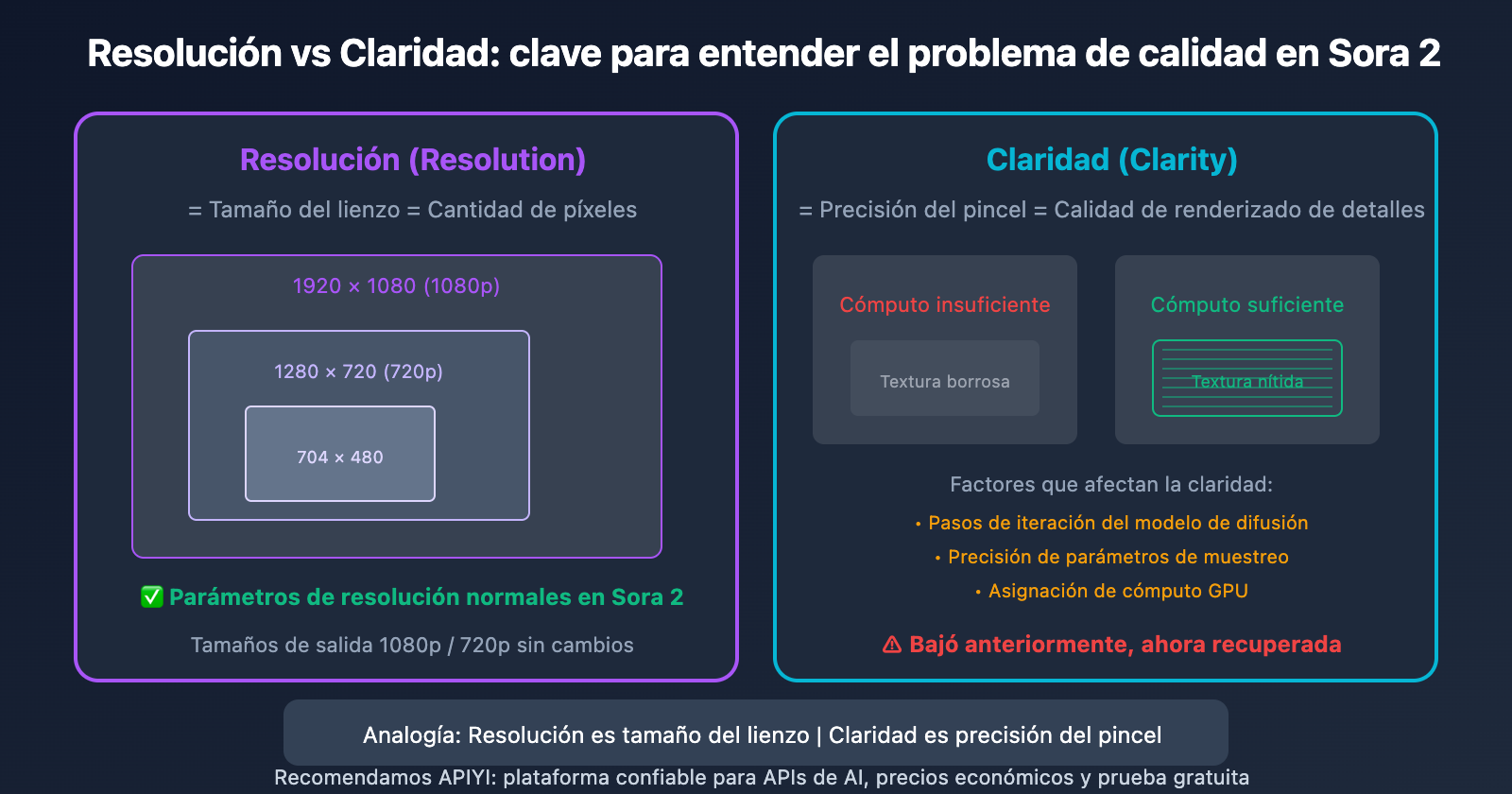

El punto clave: Los parámetros de resolución no cambiaron, pero la claridad de la imagen sí bajó. Esto indica que el problema está en la calidad de generación, no en las especificaciones de salida.

Razones técnicas del problema de calidad en Sora 2

Diferencia entre resolución y nitidez

Muchos usuarios confunden dos conceptos:

| Concepto | Definición | Situación de Sora 2 |

|---|---|---|

| Resolución | Tamaño en píxeles (ej. 704×1280, 1920×1080) | Parámetros normales, sin cambios |

| Nitidez | Capacidad de renderizado de detalles, definición de texturas | Previamente descendió, ahora ha mejorado |

Para entenderlo mejor: la resolución es el tamaño del lienzo, la nitidez es la finura del pincel. Con el mismo lienzo de 1080p, cuando hay recursos suficientes puedes pintar texturas detalladas, pero con recursos limitados solo logras contornos borrosos.

¿Cómo afecta la escasez de recursos a la calidad?

La generación de video de Sora 2 requiere una cantidad extrema de recursos computacionales. Según estimaciones de OpenAI:

- Generar 1 video de 10 segundos = consumo equivalente a miles de conversaciones de ChatGPT en recursos GPU

- El costo directo de recursos por video es aproximadamente $0.50 – $2.00

Cuando la carga de la plataforma es excesiva, OpenAI probablemente implementó las siguientes medidas para mantener la disponibilidad del servicio:

- Reducir precisión de generación: Disminuir los pasos de iteración del modelo de difusión

- Ajustar parámetros de muestreo: Sacrificar detalles por velocidad

- Balanceo de carga: Asignar tareas a nodos con recursos no óptimos

Estas medidas garantizaron que el servicio "funcionara", pero sacrificaron que funcionara "bien".

Pico de demanda en enero de 2026

El problema de calidad alcanzó su punto máximo a principios de enero, por las siguientes razones:

- Cambio de políticas: A partir del 10 de enero, usuarios gratuitos no pueden generar videos, muchos se apresuraron a usar el servicio antes del límite

- Efecto festivo: Aumento en la demanda de creación de contenido durante las festividades de Año Nuevo

- Difusión viral: La popularidad continua de Sora 2 atrajo una oleada de nuevos usuarios

Observación práctica: A través del monitoreo de datos de llamadas de APIYI apiyi.com, observamos que los videos generados después del 15 de enero muestran texturas de detalles notablemente más nítidas y mejor definición de bordes, lo que indica que el suministro de recursos de OpenAI ha mejorado.

Contexto técnico de la expansión de recursos de OpenAI

Proyecto de colaboración de 10GW con Broadcom

OpenAI firmó previamente un acuerdo de colaboración a gran escala con Broadcom, planeando construir chips y sistemas de IA personalizados de 10 gigavatios (GW). Esta cifra equivale a:

- El consumo eléctrico de 8 millones de hogares estadounidenses

- El consumo energético de una gran ciudad

Este proyecto está previsto para comenzar su implementación en la segunda mitad de 2026, resolviendo fundamentalmente los cuellos de botella de aplicaciones de alto consumo computacional como Sora 2.

Medidas de optimización a corto plazo (estimadas)

Antes de que la infraestructura a gran escala esté lista, OpenAI probablemente adoptó las siguientes medidas a corto plazo:

| Dirección de optimización | Posible medida | Efecto |

|---|---|---|

| Gestión de recursos | Optimizar asignación de tareas en clúster GPU | Reducir desperdicio de recursos |

| Distribución de usuarios | Limitar usuarios gratuitos | Liberar recursos para usuarios Pro |

| Expansión regional | Activar más centros de datos | Distribuir carga pico |

| Optimización del modelo | Ajustar parámetros de eficiencia de inferencia | Mayor calidad con mismos recursos |

Mejores prácticas para llamar a la API de Sora 2

Resoluciones actualmente disponibles

| Resolución | Píxeles | Casos de uso | Parámetro API |

|---|---|---|---|

| 1080p | 1920×1080 | Producción comercial, YouTube | resolution: "1080p" |

| 720p | 1280×720 | Vista previa rápida, redes sociales | resolution: "720p" |

Consejos para obtener la mejor nitidez

from openai import OpenAI

# Obtén una experiencia estable de llamadas API a través de APIYI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# Técnicas de Prompt para optimizar la nitidez

response = client.videos.generate(

model="sora-2",

prompt="""

A young woman walking through Tokyo's Shibuya crossing at night,

neon lights reflecting on wet pavement,

cinematic lighting, sharp focus, highly detailed,

in 4K resolution, professional cinematography

""",

resolution="1080p",

duration=10,

fps=30 # 30fps es más fluido que 24fps

)

Palabras clave en prompts para mejorar la nitidez en Sora 2

Añadir las siguientes palabras clave en tu prompt puede guiar al modelo para generar videos más nítidos:

sharp focus– enfoque nítidohighly detailed– altamente detallado4K resolution– resolución 4K (incluso si la salida es 1080p, mejora los detalles)professional cinematography– cinematografía profesionalcrisp textures– texturas nítidascinematic quality– calidad cinematográfica

Ejemplo de prompt:

A golden retriever running on a beach at sunset,

waves splashing, fur details visible,

sharp focus, highly detailed, cinematic lighting,

professional 4K cinematography

Recomendación: Llama a la API de Sora 2 a través de APIYI apiyi.com, una plataforma que ofrece servicios de acceso estables y créditos de prueba gratuitos para que valides rápidamente los resultados generados.

Comparativa de calidad de Sora 2: antes vs. después de la mejora

| Dimensión de comparación | Principios de enero (período de alta demanda) | 15 de enero (después de la mejora) |

|---|---|---|

| Nitidez de bordes | Borroso, con halos | Nítido y definido |

| Detalles de textura | Pérdida de detalles, efecto de difuminado | Texturas preservadas, capas bien definidas |

| Nitidez dinámica | Desenfoque de movimiento notable | Trayectorias de movimiento claras |

| Reproducción de color | Grisáceo, baja saturación | Colores vívidos, alto contraste |

| Detalles faciales | Rasgos difusos | Características faciales nítidas |

¿A qué deberían prestar atención los usuarios?

- Horarios de generación: Durante las madrugadas en Norteamérica (tardes en horario de Beijing) la carga es menor y la calidad podría ser mejor

- Estrategia de reintentos: Si los resultados no son ideales, puedes regenerar; la calidad puede variar según el momento

- Optimización de prompts: Añadir palabras clave relacionadas con nitidez realmente funciona

- Elegir el modo Pro: El modelo sora-2-pro siempre proporciona resultados de alta calidad más estables

Preguntas Frecuentes

P1: ¿La mejora en la calidad de imagen es permanente o temporal?

Según el plan de expansión de capacidad de cómputo de OpenAI, la calidad mejorará continuamente a largo plazo. Sin embargo, a corto plazo todavía puede verse afectada por fluctuaciones en la carga. Se recomienda usar el modelo sora-2-pro en proyectos importantes, ya que tiene mayor prioridad en la asignación de recursos y calidad más estable. APIYI apiyi.com soporta tanto la versión estándar como la Pro.

P2: ¿Por qué la calidad mediante API es más estable que en la versión web?

Las llamadas por API generalmente utilizan canales de servicio independientes, separados de los usuarios web. Especialmente al conectarse a través de plataformas profesionales como APIYI, puede haber optimizaciones adicionales de caché y programación. Los clientes empresariales de API suelen tener cuotas de cómputo dedicadas, sin verse afectados por la carga pública.

P3: ¿Cómo puedo saber el estado actual de la capacidad de cómputo?

Actualmente no existe una página oficial de estado de capacidad, pero puedes evaluarlo indirectamente de estas formas:

- Tiempo de generación: normalmente un video de 10 segundos tarda 3-5 minutos; si supera los 10 minutos indica alta carga

- Calidad de generación: compara rápidamente resultados del mismo prompt en diferentes momentos

- Feedback de la comunidad: sigue las discusiones en Reddit r/OpenAI y Twitter

Resumen

Puntos clave sobre la recuperación de calidad en Sora 2:

- Causa raíz: La caída previa en la calidad se debió a la escasez de capacidad de cómputo, no a problemas con la versión del modelo

- Estado actual: Desde el 15 de enero de 2026 hay mejoras notables en la calidad; OpenAI aparentemente completó la expansión

- Perspectiva a largo plazo: El proyecto de colaboración de 10GW con Broadcom resolverá el cuello de botella de capacidad desde la raíz

- Mejores prácticas: Usar palabras clave de claridad, elegir horarios de baja carga, priorizar el modelo Pro

Para usuarios que necesitan resultados estables y de alta calidad, se recomienda acceder a Sora 2 API a través de APIYI apiyi.com, que ofrece garantías profesionales de calidad de servicio y créditos gratuitos de prueba.

📚 Material de Referencia

⚠️ Nota sobre formato de enlaces: Todos los enlaces externos usan el formato

Nombre del recurso: domain.com, fácil de copiar pero sin redirección directa, evitando pérdida de autoridad SEO.

-

Documentación oficial de OpenAI – Modelo Sora 2: Especificaciones de interfaz API y descripción de parámetros

- Enlace:

platform.openai.com/docs/models/sora-2 - Descripción: Conoce las especificaciones técnicas oficiales de Sora 2

- Enlace:

-

Anuncio de lanzamiento de OpenAI Sora 2: Introducción a capacidades y funcionalidades del modelo

- Enlace:

openai.com/index/sora-2/ - Descripción: Información oficial del lanzamiento de Sora 2

- Enlace:

-

Reporte de CNN – Colaboración en capacidad de cómputo OpenAI Broadcom: Detalles del proyecto de infraestructura de 10GW

- Enlace:

cnn.com/2025/10/13/tech/openai-broadcom-power - Descripción: Entiende la estrategia de expansión de capacidad de cómputo de OpenAI

- Enlace:

-

Skywork AI – Guía de mejores prácticas para Sora 2: Técnicas de prompts y optimización de parámetros

- Enlace:

skywork.ai/blog/sora-2-guide-tested-settings-prompts-for-pro-level-quality/ - Descripción: Técnicas profesionales para usar Sora 2

- Enlace:

Autor: Equipo Técnico

Intercambio técnico: Te invitamos a participar en la sección de comentarios. Para más recursos, visita la comunidad técnica APIYI apiyi.com