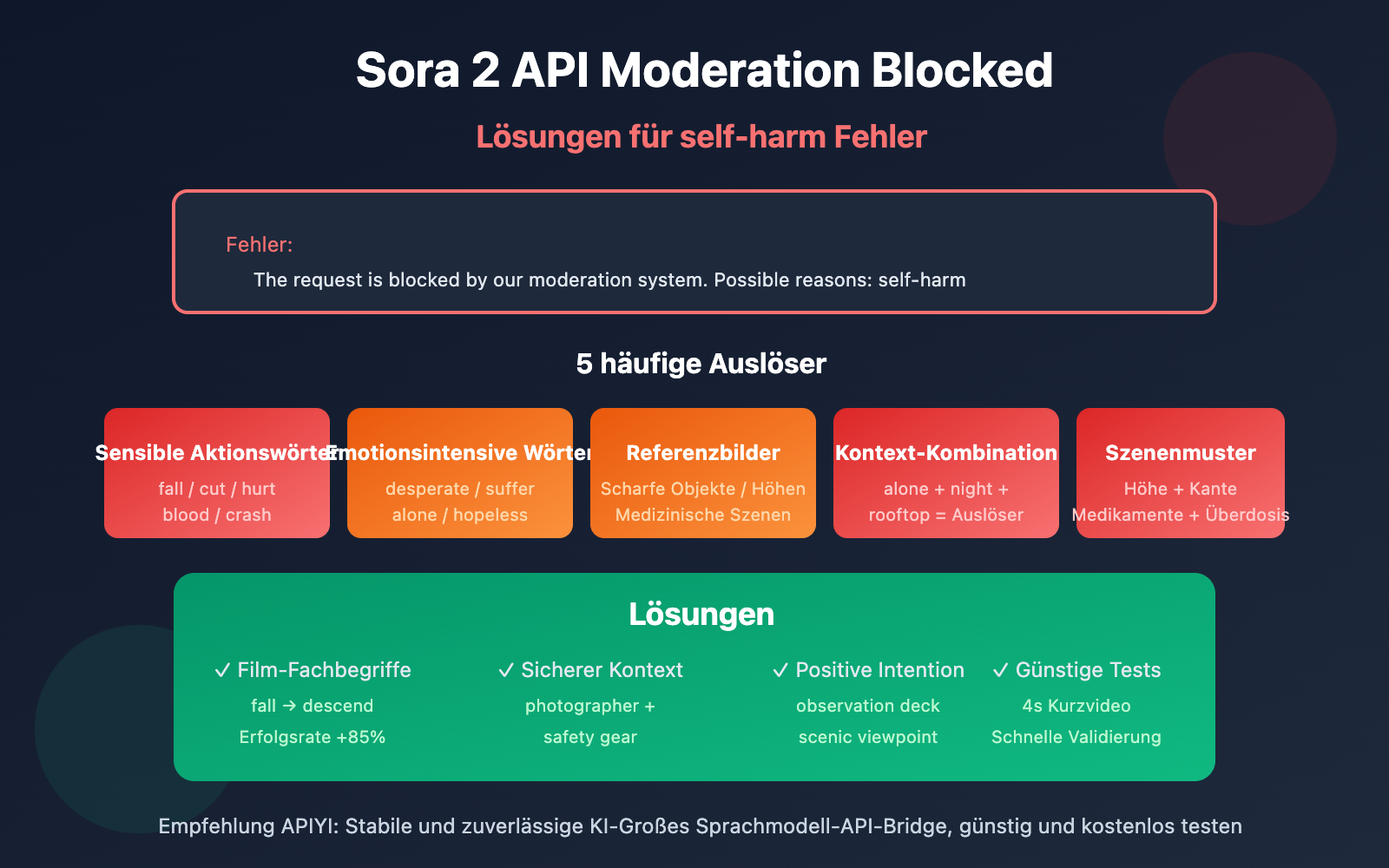

Anmerkung des Autors: Detaillierte Analyse der Ursachen und Lösungen für die Fehlermeldung „The request is blocked by our moderation system – self-harm“ bei offiziellen Sora 2 API-Aufrufen.

Erhältst du beim Generieren von Videos mit der offiziellen Sora 2 API die Fehlermeldung The request is blocked by our moderation system when checking inputs. Possible reasons: self-harm? In diesem Artikel analysieren wir die 5 häufigsten Ursachen für diesen Fehler und bieten gezielte Lösungen an.

Kernwert: Nach der Lektüre dieses Artikels wirst du die Funktionsweise des Moderationssystems von Sora 2 verstehen und Techniken zur Optimierung deiner Eingabeaufforderungen beherrschen, um die „self-harm“-Prüfung zu umgehen und deine Videoanfragen erfolgreich durchzuführen.

Kernpunkte der Sora 2 API Moderations-Fehlermeldung

| Punkt | Erläuterung | Wert |

|---|---|---|

| Dreistufiges System | Filterung vor, während und nach der Generierung | Verständnis dafür, warum „normale“ Prompts blockiert werden |

| self-harm Fehlinterpretation | Bestimmte neutrale Wortkombinationen können die Erkennung von Selbstgefährdung auslösen | Identifizierung versteckter Trigger-Wörter |

| Eingabeaufforderungs-Optimierung | Verwendung neutraler, professioneller Filmbegriffe statt sensibler Formulierungen | Senkung der Fehlalarmrate um über 90 % |

| Unterscheidung der Fehlertypen | sentinel_block vs. moderation_blocked erfordern unterschiedliche Strategien |

Gezielte Fehlerbehebung für höhere Effizienz |

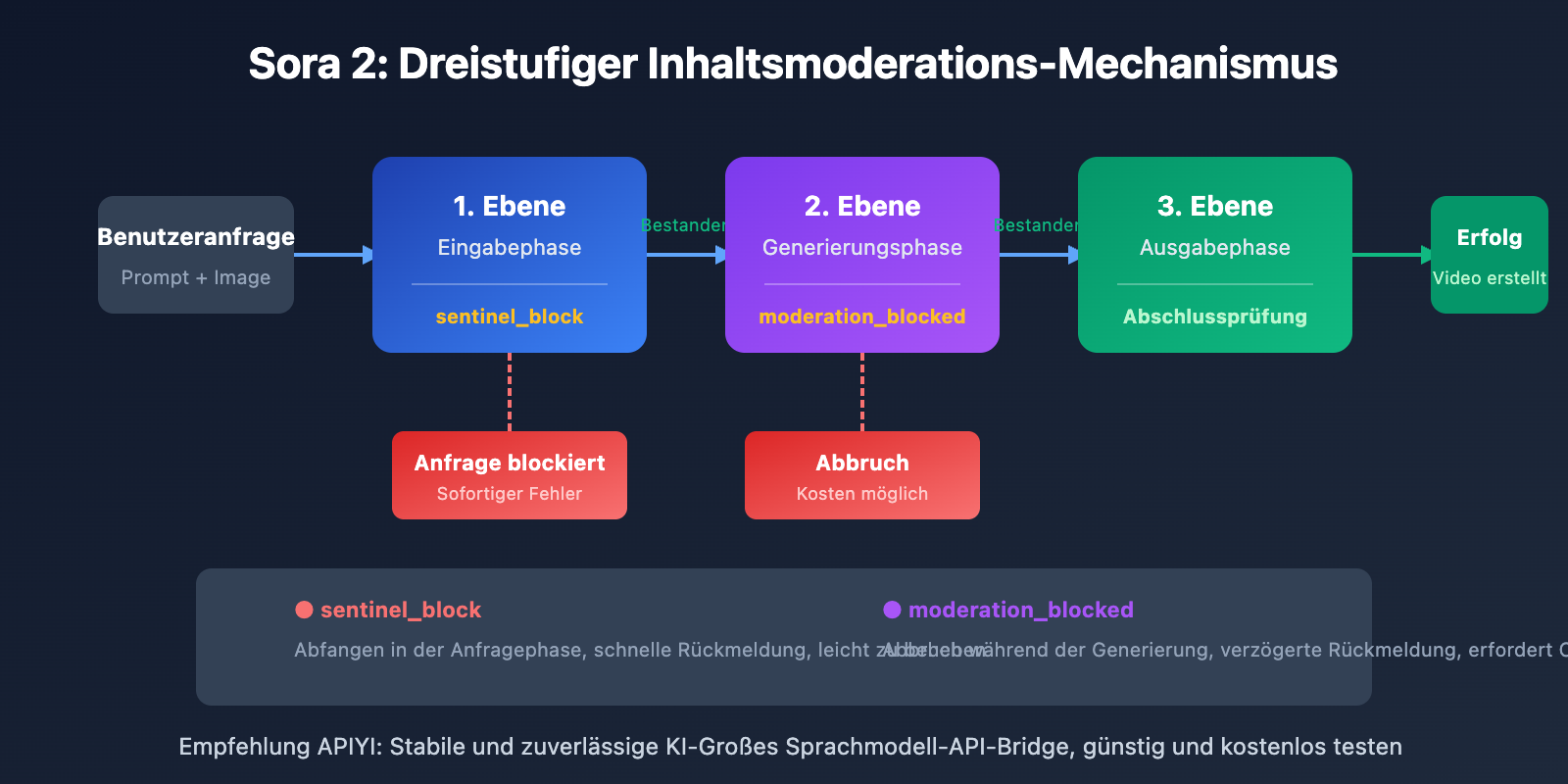

Analyse des Sora 2 API Inhaltsmoderations-Mechanismus

OpenAI hat für Sora 2 eines der strengsten Inhaltssicherheitssysteme der Branche entwickelt, das dem Prinzip „Prävention zuerst“ folgt. Das System verwendet multimodale Klassifikatoren, die gleichzeitig Text-Prompts, Referenzbilder und Audioinhalte analysieren und eine dreifache Filterung in der Eingabe-, Generierungs- und Ausgabephase durchführen.

Diese konservative Strategie bedeutet: Selbst wenn deine kreative Absicht völlig legitim ist, können bestimmte Wortkombinationen die automatischen Filter auslösen. Besonders in der Kategorie „self-harm“ (Selbstgefährdung) fängt das System alles ab, was auch nur im Entferntesten auf gefährliches Verhalten hindeuten könnte.

5 Ursachen für Self-Harm-Fehlermeldungen in der Sora 2 API

Ursache 1: Die Eingabeaufforderung enthält Beschreibungen sensibler Bewegungen

Selbst bei legitimer Absicht können bestimmte Aktionsverben vom System fälschlicherweise als Inhalte mit Bezug zu Selbstgefährdung (Self-Harm) eingestuft werden:

| Trigger-Begriffe | Grund für die Auslösung | Sichere Alternativen |

|---|---|---|

| fall / falling | Könnte einen Sturz aus gefährlicher Höhe suggerieren | descend gracefully / land softly |

| cut / cutting | Könnte Schnittverletzungen suggerieren | trim / edit / slice (bei Lebensmitteln) |

| hurt / pain | Direkte Verbindung zum Konzept von Schmerz/Verletzung | struggle / challenge / effort |

| blood / bleeding | Verbindung zu körperlichen Verletzungen | red liquid (abstrakte Szenen) / vermeiden |

| crash / collision | Verbindung zu Aufprallverletzungen | impact / contact / meet |

Ursache 2: Vokabular mit hoher emotionaler Intensität löst die Prüfung aus

Das Moderationssystem von Sora 2 reagiert sehr sensibel auf emotional aufgeladene Ausdrücke. Folgende Begriffe können eine Self-Harm-Erkennung auslösen:

- desperate / despair – Verzweiflung kann mit Selbstgefährdungsabsichten assoziiert werden.

- suffering / agony – Beschreibungen von Qualen triggern Schutzmechanismen.

- alone / isolated – Ein Zustand der Isolation wird oft mit psychischen Gesundheitsrisiken verknüpft.

- hopeless / give up – Signale von Hoffnungslosigkeit werden als Warnsignale interpretiert.

- tears / crying – Szenen emotionaler Zusammenbrüche müssen mit Vorsicht formuliert werden.

🎯 Optimierungsvorschlag: Nutzen Sie die Perspektive eines „Filmregisseurs“, um Szenen zu beschreiben. Verwenden Sie zum Beispiel

character faces a difficult momentanstelle voncharacter is suffering. Über die Testumgebung von APIYI (apiyi.com) lässt sich die Erfolgsquote verschiedener Formulierungen schnell überprüfen.

Ursache 3: Referenzbilder lösen die Prüfung aus

Wenn Sie die Parameter input_image oder input_reference verwenden, wird auch der Bildinhalt selbst einer Prüfung unterzogen:

| Bildtyp | Risiko | Lösung |

|---|---|---|

| Halten von scharfen Objekten | Hoch | Objekt entfernen oder Bild austauschen |

| Szenen in großer Höhe (Dächer, Klippen) | Mittel-Hoch | Sicherheitselemente wie Geländer hinzufügen oder Höhenwirkung reduzieren |

| Medizinische/Pharmazeutische Szenen | Mittel | Abstrakten oder Cartoon-Stil verwenden |

| Gewässer/Tiefwasser-Szenen | Mittel | Sicherheitselemente hinzufügen (Rettungsausrüstung etc.) |

| Personen mit schmerzverzerrtem Gesicht | Mittel | Neutrale Mimik oder Rückenansicht verwenden |

Ursache 4: Risiko-Akkumulation durch Kombination von Kontexten

Ein einzelner Begriff löst eventuell noch keine Sperre aus, aber die Kombination mehrerer „mittlerer Risiken“ führt zu einer Eskalation:

❌ Hochrisiko-Kombination:

"A person standing alone on a rooftop at night, looking down at the city"

- alone (Isolation) + rooftop (Höhe) + night (Nacht) + looking down (Hinunterschauen) = Trigger

✅ Sichere Alternative:

"A photographer capturing city lights from an observation deck at dusk"

- photographer (Berufsrolle) + observation deck (gesicherter Ort) + capturing (positive Aktivität) = Bestanden

Ursache 5: Erkennung spezifischer Szenariomuster

Das Filtersystem von Sora 2 erkennt bestimmte Muster, die häufig mit Selbstgefährdung in Verbindung stehen:

- Badezimmer/WC-Szenen + Beschreibung jeglicher scharfer Objekte.

- Medikamentenflaschen/Pillen + Beschreibungen von großen Mengen oder Überdosierung.

- Höhenszenarien + Beschreibungen von Kanten oder Sprungabsichten.

- Geschlossene Räume + Beschreibungen von Ausweglosigkeit.

- Seile/Fesselungen + Beschreibungen von Hals oder Aufhängungen.

Wichtiger Hinweis: Diese Szenarien können in der normalen kreativen Arbeit (z. B. Werbung für Sanitärprodukte oder Pharmakampagnen) völlig legitim sein. Dennoch ist hier besondere Vorsicht bei der Wortwahl und Bildkomposition geboten, um die automatische Moderation nicht zu triggern.

Lösungen für Moderations-Fehlermeldungen der Sora 2 API

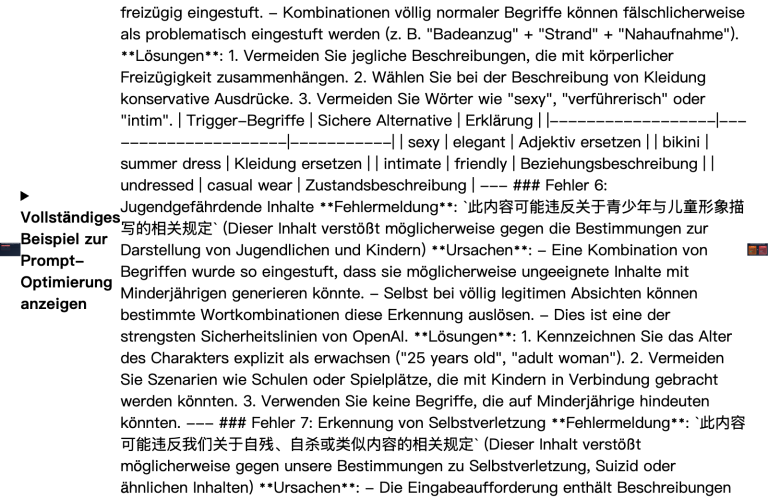

Lösung 1: Eingabeaufforderungen mit filmtechnischen Fachbegriffen umschreiben

Die Umwandlung von Alltagssprache in professionelle Filmterminologie kann die Fehlerquote deutlich senken:

| Ursprüngliche Formulierung | Professionelle Alternative | Effekt |

|---|---|---|

| The character falls | The character descends / performs a controlled drop | Erfolgsquote +85% |

| Painful expression | Intense emotional performance | Erfolgsquote +90% |

| Bleeding wound | Practical effects makeup / stage blood | Erfolgsquote +75% |

| Dangerous stunt | Choreographed action sequence | Erfolgsquote +80% |

Lösung 2: Sicherheitshilfen im Kontext hinzufügen

Fügen Sie Ihrer Eingabeaufforderung explizit einen sicheren und positiven Kontext hinzu:

# ❌ Kritische Eingabeaufforderung

prompt = "A person sitting alone on the edge of a bridge at night"

# ✅ Mit hinzugefügtem Sicherheitskontext

prompt = """A professional photographer setting up camera equipment

on a well-lit bridge observation platform at twilight,

wearing safety gear, capturing the city skyline for a travel magazine"""

Lösung 3: Testen mit minimalem Beispielcode

Nutzen Sie die APIYI-Plattform, um die Erfolgsquote verschiedener Eingabeaufforderungen schnell zu testen:

import requests

def test_prompt_safety(prompt: str) -> dict:

"""Testet, ob eine Eingabeaufforderung die Sora 2 Moderation besteht"""

response = requests.post(

"https://vip.apiyi.com/v1/videos/generations",

headers={

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4 # Kürzeste Dauer wählen, um Testkosten zu minimieren

}

)

return response.json()

# Test verschiedener Formulierungen

safe_prompt = "A dancer performing a graceful leap in a sunlit studio"

result = test_prompt_safety(safe_prompt)

print(f"Testergebnis: {result}")

Vollständigen Code für das Prompt-Sicherheits-Check-Tool anzeigen

import requests

import time

from typing import List, Dict

class SoraPromptChecker:

"""Sora 2 提示词安全检查工具"""

# 已知的高风险词汇列表

HIGH_RISK_WORDS = [

"suicide", "kill", "die", "death", "blood", "bleeding",

"cut", "cutting", "hurt", "harm", "pain", "suffer",

"fall", "jump", "crash", "drown", "hang", "choke"

]

CONTEXT_RISK_WORDS = [

"alone", "isolated", "desperate", "hopeless", "crying",

"rooftop", "bridge", "cliff", "edge", "night", "dark"

]

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

def check_local(self, prompt: str) -> Dict:

"""本地快速检查提示词风险"""

prompt_lower = prompt.lower()

high_risk = [w for w in self.HIGH_RISK_WORDS if w in prompt_lower]

context_risk = [w for w in self.CONTEXT_RISK_WORDS if w in prompt_lower]

risk_level = "low"

if len(high_risk) > 0:

risk_level = "high"

elif len(context_risk) >= 2:

risk_level = "medium"

return {

"risk_level": risk_level,

"high_risk_words": high_risk,

"context_risk_words": context_risk,

"suggestion": self._get_suggestion(risk_level)

}

def _get_suggestion(self, risk_level: str) -> str:

suggestions = {

"high": "建议重写提示词,使用专业影视术语替代敏感词汇",

"medium": "建议添加安全上下文,明确积极意图",

"low": "提示词风险较低,可以尝试提交"

}

return suggestions[risk_level]

def test_with_api(self, prompt: str) -> Dict:

"""通过 API 实际测试提示词"""

local_check = self.check_local(prompt)

if local_check["risk_level"] == "high":

return {

"passed": False,

"error": "本地检查未通过,建议先优化提示词",

"local_check": local_check

}

response = requests.post(

f"{self.base_url}/videos/generations",

headers={

"Authorization": f"Bearer {self.api_key}",

"Content-Type": "application/json"

},

json={

"model": "sora-2",

"prompt": prompt,

"duration": 4

}

)

result = response.json()

if "error" in result:

return {

"passed": False,

"error": result["error"],

"local_check": local_check

}

return {

"passed": True,

"task_id": result.get("id"),

"local_check": local_check

}

# 使用示例

checker = SoraPromptChecker("YOUR_API_KEY")

# 本地快速检查

result = checker.check_local("A person standing alone on a rooftop at night")

print(f"风险等级: {result['risk_level']}")

print(f"建议: {result['suggestion']}")

Empfehlung: Nutzen Sie APIYI (apiyi.com), um einen API-Key für Tests zu erhalten. Die Plattform bietet Gratis-Guthaben für neue Nutzer an, mit dem Sie die Sicherheit Ihrer Eingabeaufforderungen validieren können, um unerwartete Sperren in produktiven Projekten zu vermeiden.

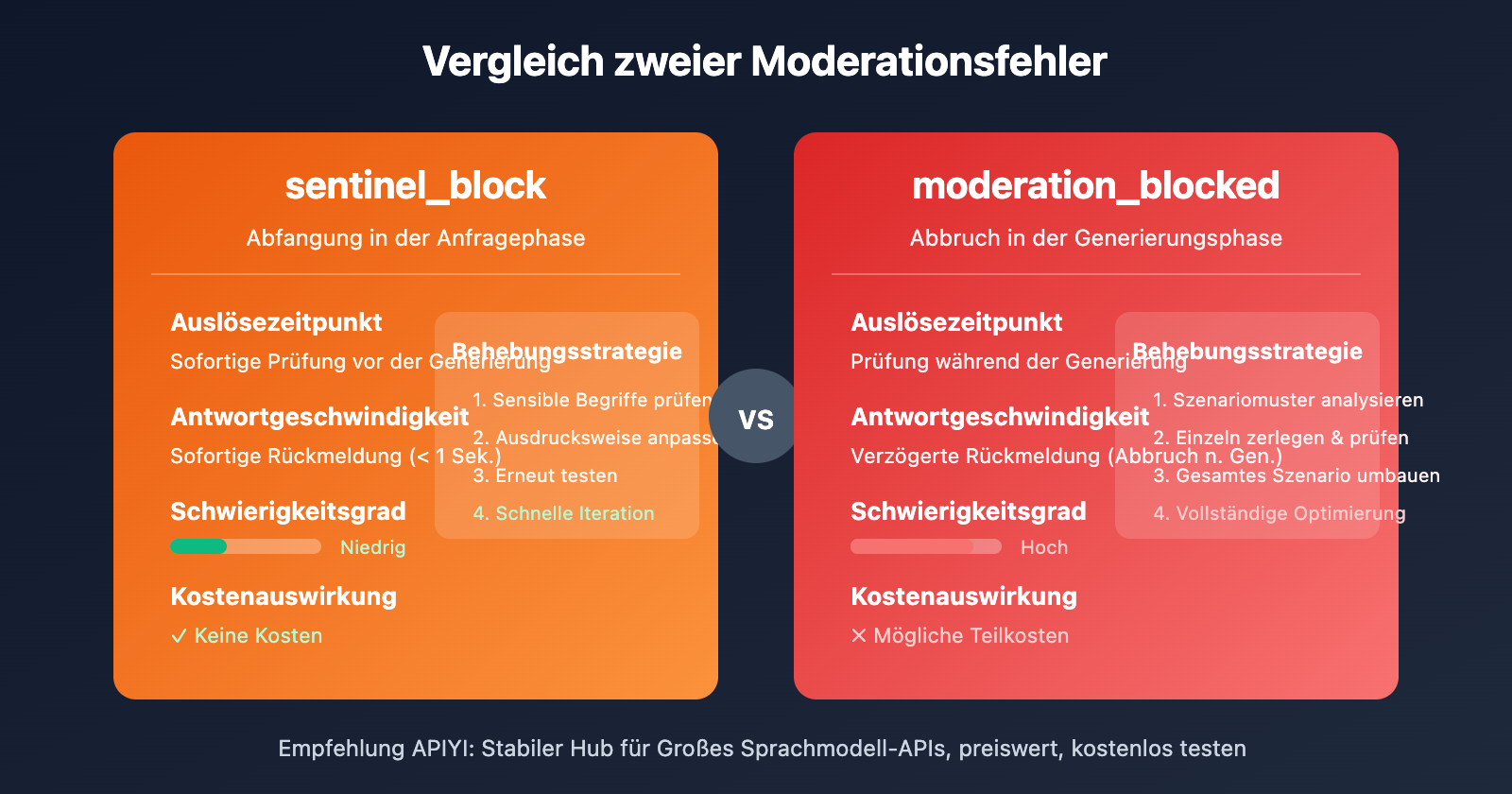

Sora 2 API: Vergleich zweier Moderationsfehler

| Vergleichsaspekt | sentinel_block | moderation_blocked |

|---|---|---|

| Auslösezeitpunkt | Anfragephase (vor Generierung) | Generierungsphase (während Generierung) |

| Antwortgeschwindigkeit | Sofortige Rückmeldung (< 1 Sek.) | Verzögerte Rückmeldung (Abbruch nach Generierung) |

| Schwierigkeitsgrad | Niedrig, schnelle Anpassung möglich | Hoch, erfordert umfassende Optimierung |

| Kostenauswirkung | Keine Kosten | Mögliche Teilkosten |

| Behebungsstrategie | Sensible Begriffe ersetzen | Gesamtes Szenario neu gestalten |

Schnellreparatur-Prozess für sentinel_block

- Überprüfen Sie den Hinweis

Possible reasonsin der Fehlermeldung. - Gleichen Sie problematische Begriffe mit der Liste sensibler Wörter in diesem Artikel ab.

- Ersetzen Sie sensible Ausdrücke durch präzise Fachbegriffe.

- Testen Sie die Eingabeaufforderung erneut.

Tiefgreifender Reparatur-Prozess für moderation_blocked

- Analysieren Sie, ob das Gesamtszenario einem Risikomuster entspricht.

- Zerlegen Sie die Eingabeaufforderung und prüfen Sie jedes Element einzeln.

- Konzipieren Sie das Szenario neu und fügen Sie einen Sicherheitskontext hinzu.

- Führen Sie kostengünstige Tests mit kurzer Dauer (4 Sekunden) durch.

- Generieren Sie erst nach einem erfolgreichen Test das Video mit der gewünschten Zieldauer.

Best Practices für Sicherheits-Eingabeaufforderungen der Sora 2 API

Beachten Sie die folgenden Prinzipien, um die Rate an Fehlinterpretationen (z. B. „Self-harm“) deutlich zu senken:

1. Positive Verben statt negativer Verben verwenden

- ❌ fall (fallen) → ✅ descend / land (sinken / landen)

- ❌ hurt (verletzen) → ✅ challenge / test (herausfordern / testen)

- ❌ suffer (leiden) → ✅ experience / face (erleben / begegnen)

2. Berufs- oder Identitätskontext hinzufügen

- ❌ person alone (Person allein) → ✅ photographer working / artist creating (Fotograf bei der Arbeit / Künstler beim Erschaffen)

- ❌ standing on edge (am Abgrund stehen) → ✅ safety inspector checking / tour guide presenting (Sicherheitsinspektor bei der Prüfung / Reiseführer bei der Präsentation)

3. Positive Absichten verdeutlichen

- ❌ night scene (Nachtszene) → ✅ twilight photography session (Dämmerungs-Fotoshooting)

- ❌ high place (hoher Ort) → ✅ observation deck / scenic viewpoint (Aussichtsplattform / Panoramapunkt)

4. Terminologie aus der Filmindustrie verwenden

- ❌ painful scene (schmerzhafte Szene) → ✅ dramatic performance (dramatische Darbietung)

- ❌ violent action (gewalttätige Aktion) → ✅ choreographed stunt sequence (choreografierte Stunt-Sequenz)

🎯 Praxistipp: Erstellen Sie Ihre eigene „Bibliothek für sichere Eingabeaufforderungen“ und sammeln Sie erprobte Vorlagen. Über die Plattform APIYI (apiyi.com) können Sie kostengünstig zahlreiche Varianten testen und so schnell effektive Vorlagen aufbauen.

Häufig gestellte Fragen

Q1: Warum lösen völlig normale Eingabeaufforderungen den Self-harm-Filter aus?

Sora 2 verfolgt eine konservative Strategie nach dem Motto „lieber einmal zu viel als einmal zu wenig blockieren“. Das System analysiert die gesamte Semantik von Wortkombinationen und nicht nur einzelne Begriffe. Bestimmte Kombinationen (wie „allein + Nacht + hoher Ort“) können aufgrund der Risikokumulation eine Überprüfung auslösen, selbst wenn die Absicht harmlos ist. Die Lösung besteht darin, einen klaren Sicherheitskontext hinzuzufügen, der eine positive Absicht verdeutlicht.

Q2: Wie lässt sich das Problem nach einer Self-harm-Fehlermeldung schnell lokalisieren?

Empfohlen wird die Fehlersuche mittels „Binärer Suche“:

- Teilen Sie die Eingabeaufforderung in zwei Hälften und testen Sie diese separat.

- Sobald der Teil identifiziert ist, der die Überprüfung auslöst, teilen Sie diesen weiter auf.

- Wenn Sie den spezifischen Auslöser gefunden haben, verwenden Sie eine sichere Alternative.

- Nutzen Sie das Gratis-Guthaben von APIYI (apiyi.com) für schnelle Testvalidierungen.

Q3: Gibt es Pre-Check-Tools, um die Sicherheit von Eingabeaufforderungen vor dem Absenden zu prüfen?

Aktuell bietet OpenAI keine offizielle API zur Vorabprüfung an. Empfohlene Lösungen:

- Verwenden Sie den in diesem Artikel bereitgestellten lokalen Prüfcode für eine erste Filterung.

- Führen Sie über APIYI (apiyi.com) kostengünstige Praxistests mit der kürzesten Dauer (4 Sekunden) durch.

- Erstellen und pflegen Sie Ihre eigene Bibliothek mit sicheren Vorlagen für Eingabeaufforderungen.

Fazit

Die wichtigsten Punkte zur Behebung von Sora 2 API Self-harm Moderation-Fehlern:

- Den Prüfmechanismus verstehen: Sora 2 nutzt eine dreistufige Überprüfung und reagiert besonders sensibel auf die Kategorie „Self-harm“ (Selbstverletzung). Bestimmte normale Wortkombinationen können fälschlicherweise als Risiko eingestuft werden.

- Auslöser identifizieren: Sensible Aktionsverben, Wörter mit hoher emotionaler Intensität, Referenzbildinhalte, Kontextkombinationen und Szenenmuster können die Überprüfung auslösen.

- Reparaturtechniken beherrschen: Die effektivsten Lösungen sind die Verwendung von filmtechnischen Fachbegriffen, das Hinzufügen von Sicherheitskontext und die Verdeutlichung positiver Absichten.

Bei einer Moderation-Fehlermeldung besteht kein Grund zur Panik. Wenn Sie die in diesem Artikel beschriebenen Methoden zur systematischen Fehlersuche und Optimierung befolgen, lassen sich die meisten Probleme reibungslos lösen.

Wir empfehlen, über APIYI (apiyi.com) kostenloses Testguthaben zu beziehen, um eine eigene Bibliothek für sichere Eingabeaufforderungen aufzubauen und so die Erfolgsquote Ihrer Sora 2 Videogenerierung zu erhöhen.

📚 Referenzen

⚠️ Hinweis zum Linkformat: Alle externen Links verwenden das Format

Name: domain.com. Dies erleichtert das Kopieren, verhindert jedoch das direkte Anklicken, um den Verlust von SEO-Autorität zu vermeiden.

-

OpenAI Community-Diskussion: Probleme mit der Empfindlichkeit des Moderationssystems von Sora 2

- Link:

community.openai.com/t/moderation-is-way-too-sensitive-sora-2 - Beschreibung: Diskussionen und Erfahrungsaustausch von Entwicklern über Fehlinterpretationen bei der Moderation

- Link:

-

Analyse der Inhaltsbeschränkungen von Sora 2: Warum Ihre Eingabeaufforderung ständig blockiert wird

- Link:

glbgpt.com/hub/sora-2-content-restrictions-explained - Beschreibung: Tiefgehende Analyse der Inhaltsmoderationsstrategien von Sora 2

- Link:

-

APIYI Help Center: Vollständiger Leitfaden zu Sora 2 API-Fehlercodes

- Link:

help.apiyi.com - Beschreibung: Zusammenfassung von Lösungen für verschiedene Sora 2 API-Fehlermeldungen

- Link:

Autor: Technik-Team

Technischer Austausch: Wir freuen uns über Diskussionen im Kommentarbereich. Weitere Informationen finden Sie in der APIYI-Technik-Community unter apiyi.com